Apps & Mobile Entwicklung

10.000 Blackwell-GPUs: Nvidia baut deutsche KI-Fabrik mit der Telekom

Die für Deutschland von Nvidia geplante KI-Fabrik mit 10.000 GPUs wird in Kooperation mit der Deutschen Telekom aufgebaut. Das haben beide Unternehmen heute bekannt gegeben, nachdem Nvidia das Projekt am Mittwoch noch ohne Nennung der Telekom kurz zur GTC angekündigt hatte. Im Verlauf 2026 soll das Projekt einsatzbereit sein.

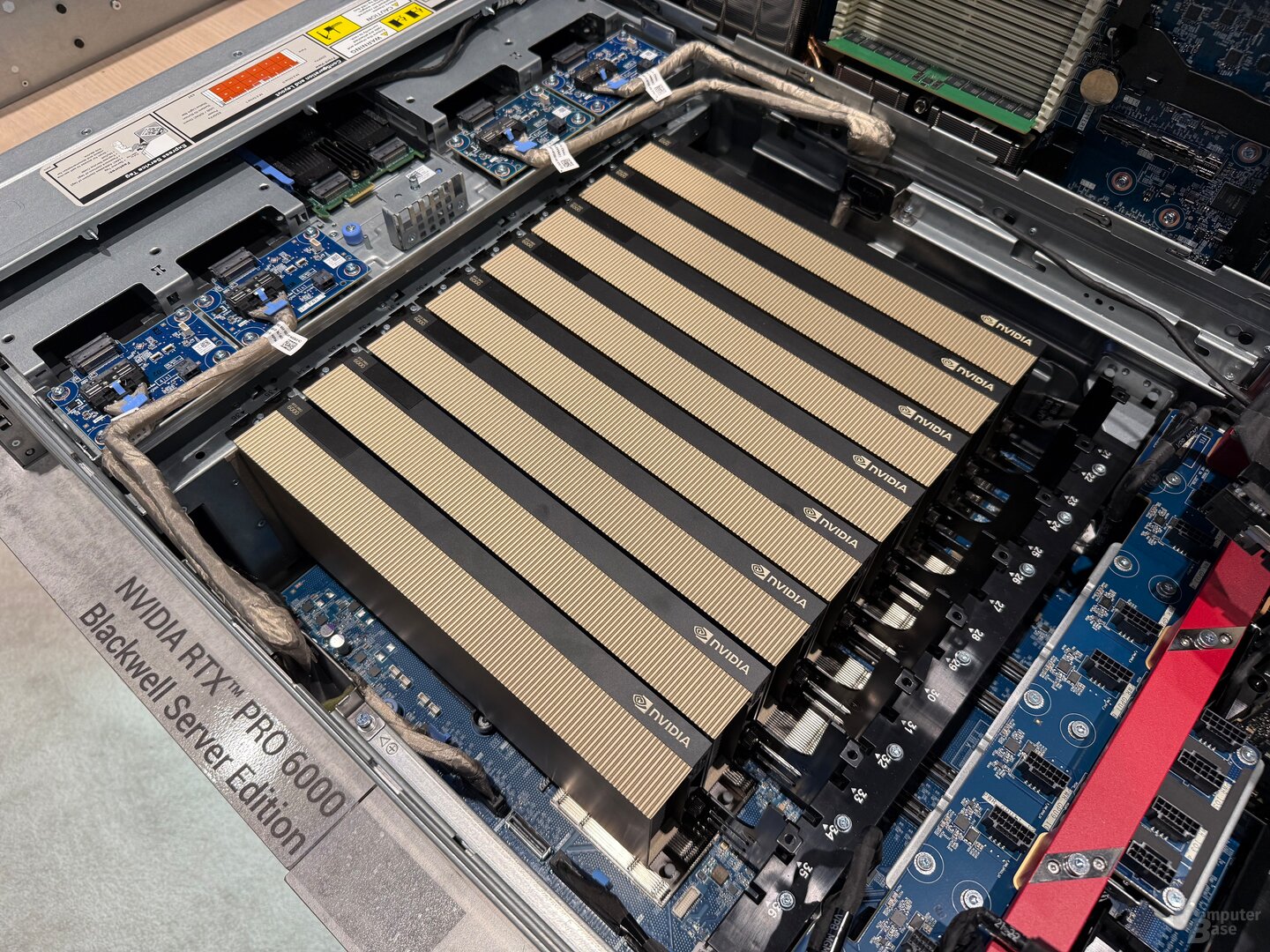

Die weltweit erste industrielle KI-Cloud für europäische Hersteller auf deutschem Boden soll mit dem Projekt entstehen. Erste technische Details hatte es zur europäischen Variante der GTC in Paris am Mittwoch gegeben, als Nvidia erklärt hatte, eine „AI Factory“ mit insgesamt 10.000 GPUs auf Basis der AI-Systeme DGX B200 und RTX Pro Server in Deutschland aufbauen zu wollen. Mit wem, wann genau und wo das Vorhaben umgesetzt werden soll, war zur ersten Ankündigung noch nicht bekannt.

Erste Kundenzugänge im Verlauf des Jahres 2026

Jetzt ist klar: Die Deutsche Telekom liefert Rechenzentren, Betrieb, Vertrieb sowie Security und AI-Lösungen. Die Umsetzung der industriellen KI-Cloud soll bis spätestens 2026 erfolgen, heißt es in der heutigen Ankündigung. ComputerBase hat bei der Deutschen Telekom nachgefragt, wie genau der zeitliche Ablauf aussehen soll. Einem Unternehmenssprecher zufolge sei mit der Formulierung „bis spätestens 2026“ die Inbetriebnahme im Verlauf des kommenden Jahres gemeint. Das Unternehmen strebe an, erste Anwendungen und Kundenzugänge im Verlauf des Jahres 2026 verfügbar zu machen. „Unser Ziel ist es, möglichst früh produktive Nutzung für unsere Industriekunden zu ermöglichen.“

Das Investment sei als Sprungbrett für die AI-Entwicklung in Europa gedacht und soll den Weg ebnen für künftige AI-Gigafabriken – der Name leitet sich von Gigawatt ab. Das hatte Nvidia zur Keynote in Paris am Mittwoch erklärt. Die jetzt entstehende KI-Fabrik zählt mit ihren 10.000 GPUs noch nicht zur Klasse der Gigafabriken. Auf den Servern sollen CUDA-X, RTX und Omniverse beschleunigte Workloads von „führenden Softwareanbietern“ laufen. 2027 sollen im Rahmen der europäischen AI-Gigafactory-Initiative auch Standorte mit 100.000 GPUs in Betrieb genommen werden.

Hardware-Partner und Standort noch unbekannt

Mit welchen weiteren Unternehmen die Telekom abseits der Chips und weiteren Komponenten von Nvidia für das Projekt kooperiert, dazu wollte der Konzern auf Nachfrage keine Angaben machen. Konkrete Hersteller oder Zulieferer nenne man derzeit nicht. Gleiches gilt für den respektive die gewählten Standorte, diese wolle man zum jetzigen Zeitpunkt nicht öffentlich machen. Maßgebliche Kriterien seien Nähe zur Industrie, schnelle Anbindung und eine nachhaltige Energieversorgung.

„Deutschland muss Umsetzungsrepublik werden.“

Die Deutsche Telekom spricht von einer souveränen Lösung, gemeint ist damit in erster Linie die europäische Datenverarbeitung. Das Unternehmen stelle ihre „sichere, souveräne und schnelle“ Infrastruktur zur Verfügung. Zudem will die Telekom garantieren, dass europäische Werte wie Datenschutz und Datensicherheit eingehalten und Daten nur nach europäischen Standards verarbeitet werden. Man wolle dazu beitragen, die europäische Industrie zu stärken und gleichzeitig die technologische Souveränität Europas zu fördern. „Deutschland muss von der Ankündigungs- zur Umsetzungsrepublik werden. Wir als Telekom machen KI einfach konsumierbar – und jetzt machen wir einfach“, sagte Timotheus Höttges, CEO der Deutschen Telekom AG.

Robotik-Unternehmen Neura soll Dienste nutzen

Laut Nvidia handele es sich um das aktuell größte KI-Einzelprojekt in Deutschland. In der Ankündigung der Chip-Entwickler wird mit dem Robotik-Unternehmen Neura auch schon ein erster Kunde der Rechenleistung genannt. Außerdem sollen Siemens, Ansys, Cadence und Rescale Anwendung für RTX-Grafikkarten und das Omniverse anbieten.

Treffen mit Bundeskanzler Merz

Auf seiner Europareise hat sich Nvidia-CEO Jensen Huang heute auch mit Bundeskanzler Friedrich Merz getroffen. Im Fokus des Austauschs stand die weitere strategische Zusammenarbeit zur Stärkung des KI-Standorts Deutschland. Deutschland verfüge über hervorragende Voraussetzungen für die Entwicklung und Anwendung Künstlicher Intelligenz, heißt es in einer Erklärung der Bundesregierung. Eine souveräne KI-Infrastruktur soll in Deutschland entstehen, dabei spiele aber die Kooperation „mit internationalen Technologieführern“ wie Nvidia eine wichtige Rolle. Die Bundesregierung lade Nvidia dazu ein, seine Aktivitäten in Deutschland weiter auszubauen. Die Beteiligten setzen sich für den Ausbau von KI-Kompetenzen ein, genannt werden Bildungsprogramme, Schulungen und Qualifizierungsangebote in Zusammenarbeit mit Nvidias Deep Learning Institute.

Apps & Mobile Entwicklung

Intel XeSS 2.1: Frame Generation & Low-Latency auch für Radeon & GeForce

XeSS Super Resolution ist schon immer auf Grafikkarten abseits von Intel Arc lauffähig. Mit Hilfe des DP4a-Befehlssatzes funktioniert Intels neuronales Netzwerk in vereinfachter Form auch auf GeForce- und Radeon-Grafikkarten. Für XeSS 2 Frame Generation benötigte es bis jetzt eine Intel Arc, was sich nun aber geändert hat.

Intel hat mit dem XeSS 2 SDK 2.1 Frame Generation, sowie das dazugehörige, genauso aber auch separat integrierbare XeLL (Xe Low Latency) als DP4a-Version hinzugefügt, sodass die bisherige Arc-Exklusivität damit beendet ist. Die künstlichen Bilder laufen nun ebenso auf sämtlichen AMD- und Nvidia-Grafikkarten, solange mindestens das Shader Model 6.4 und damit die DP4a-Fähigkeiten zur Verfügung stehen.

Was aktuell jedoch noch unklar ist und auch nicht aus Intels Dokumenten zu XeSS hervorgeht, ist, ob Frame Generation, wie auch schon Super Resolution in der DP4a-Variante, ein vereinfachtes neuronales Netzwerk ausführt, oder ob es in diesem Fall dasselbe Netzwerk ist – was auf Intel Arc schlicht auf den MXM genannten Matrix-Einheiten läuft und bei GeForce sowie Radeon auf deren FP32-Shadereinheiten.

Was dagegen auch mit XeSS 2.1 noch gleich bleibt, ist die Nutzung von DirectX 12, eine andere API unterstützt der Frame-Generation- sowie der Low-Latency-Algorithmus weiterhin nicht. DirectX 11 sowie Vulkan bleiben auch auf Arc-Grafikkarten außen vor.

In einem ersten Test wusste XeSS 2 zu gefallen

ComputerBase hatte sich XeSS 2 Frame Generation inklusive XeSS Low Latency im Launch-Review der Arc B580 (Test) separat in F1 25 angesehen und dort hat die Technologie einen guten Eindruck hinterlassen. Sowohl in Sachen Bildqualität als auch Performance und Latenzverbesserung gab es positive Ergebnisse, wobei diese nicht unbedingt auf andere Spiele übertragen werden können. Genauso ist unklar, ob sich die MXM-Version von Frame Generation anders als die DP4a-Variante verhält.

Theoretisch ist eine schlechtere Bildqualität, ein geringerer Leistungsgewinn oder ein schlechteres Frame Pacing denkbar, was aber nur mögliche Szenarien sind. Auch wird sich erst noch zeigen müssen, ob XeSS Low Latency denselben Effekt auf AMD- und Nvidia-Grafikkarten wie auf Intel Arc hat. Aktuell ist noch kein Spiel mit dem XeSS SDK 2.1 erschienen, überprüfen lässt sich Intels Öffnung der neuen Technologien daher noch nicht.

Apps & Mobile Entwicklung

Machen uns Social Media, KI und Fakenews dümmer?

Werden wir immer dümmer durchs Internet? Das war zumindest meine steile These, mit der ich Fabi konfrontiert habe. In der neuen Podcastfolge der Casa Casi gehen wir dieser Sache gewohnt seriös auf den Grund.

Ohne zu viel vorab zu verraten: Nein, natürlich ist nicht jeder intelligente Mensch auf einmal komplett verblödet, nur weil er sich regelmäßig im Internet herumtreibt. Es geht auch nicht um Intelligenz im Sinne von IQ, sondern eher darum, dass auch intelligente Menschen, gerne mal dumme Dinge tun. Und ja, im Netz begehen wir jede Menge Dummheiten, egal ob es der übertriebene Konsum von Kurzvideos ist, das Teilen von Fake-News, oder zu glauben, dass alle bei Instagram außer mir voll spannende Leben haben.

Sind wir auf dem Weg in die Verblödung?

Der Ausgangspunkt für meine Überlegungen waren Studien an der TU Braunschweig. Es ging darum, ob man durch Kurzvideos den Unterricht aufpeppen könne. Ihr kennt ja sicher alle solche „Erklärbär“-Videos, wo auf TikTok oder einer anderen Plattform in kurzen Videos schnell die verschiedensten Sachverhalte erklärt werden. Es ist knackig kurz, also snackable – und man lernt was. Wie soll uns das also dumm machen?

Zugegeben, die wir-werden-dumm-These ist vielleicht etwas überspitzt und auch nicht wirklich zutreffend für die expliziten Studien hier. Die haben nämlich lediglich ergeben, dass das Gelernte weniger im Kopf bleibt bei diesen Videos, als hätte man etwa einen Text zum Thema gelesen.

Das allerdings war der Anfang meiner Gedankenreise. Ihr kennt meine gesunde Abneigung gegen TikTok aus den verschiedensten Gründen. Falls nicht, gerne in die unten verlinkte „TikTok verbieten!“-Folge reinhören. Wenn wir wissen, dass selbst die Erklär-Videos nicht die cleverste Form der Bildung darstellen, bleibt eigentlich nicht mehr viel Positives übrig, was man über TikTok sagen könnte. Grundsätzlich gilt das – zumindest abgeschwächt – auch für Reels oder YouTube-Shorts, also für Kurzvideos generell.

Wir fallen auf Algorithmen rein, die uns viel zu lange binden und uns viel zu wenig Nachhaltiges bringen. Wir konsumieren, stumpfen ab, verringern unsere Aufmerksamkeitsspanne – oder wann habt Ihr das letzte Mal ernsthaft einen Film oder eine Serie auf der Couch geschaut, ohne sehr schnell dabei zum Handy greifen zu wollen? Ich selbst ertappe mich bei dem Reflex und bin alles andere als happy damit!

Die Gefahr lauert im Netz überall

Es wäre aber zu einfach, die Schuld jetzt komplett bei TikTok oder generell Kurzvideos zu suchen. Wir haben in der Casa Casi dafür viel zu viele Themen besprochen, die allesamt durchblicken ließen, dass wir im Netz dumme Dinge tun. Einige Punkte daraus haben wir uns für den Podcast heute vorgenommen, um diese These zu stützen. Erst jüngst hatten wir das Thema AI Slop, bei dem wir uns wirklichen Irrsinn ohne jeden Mehrwert reinziehen.

Weiter belasten wir unsere Psyche in Social Media, wenn wir neidisch auf die tollen Leben der anderen blicken und uns ein mieses Selbstwertgefühl und FOMO einreden. Wir fallen auf Fake-News rein, manche von uns teilen sie sogar bereitwillig, solange sie die eigene Meinung abbilden. Und wir geben uns vertrauensvoll in die Hände von KI. Dort verlernen wir möglicherweise, wie man wirklich lernt. Wir erhalten Antworten, die mitunter Bias-behaftet sind, oder komplett von der KI ausgedacht.

Die Liste könnten wir so weiterführen, aber irgendwann stoßen wir in einer Podcast-Folge natürlich zeitlich an unsere Grenzen. Ganz wichtig ist uns dabei diesmal aber auch gewesen, kein pauschales Urteil zu fällen. Der Gesellschaft werden unzählige dieser Dummheiten vorgesetzt. Weil es vielleicht eine politische Motivation gibt, aber hauptsächlich, weil man mit uns Geld verdienen möchte. Wir lassen uns daher viel zu oft auf diese Dummheiten ein. Aber fest steht eben auch: Das muss nicht so sein! Wir können da gegensteuern und das jederzeit.

So ein bisschen hoffen wir also, dass wir Euch fürs Thema sensibilisieren können, indem wir da ausgiebig drüber sprechen. Schließlich ist ein erkanntes Problem ein lösbares Problem. Geht also mal in Euch und überlegt, wo Ihr selbst klüger im Netz agieren könntet. Vielleicht einfach die Zeit drosseln, die man vorm Handy verbringt. Vielleicht weniger Doomscrolling und vor allem weniger TikTok. Und erzählt den Leuten, wieso diese Mechanismen so verhängnisvoll sind, denen wir so gerne auf den Leim gehen. Habt Ihr das Gefühl, dass unsere Folge heute dazu beiträgt, auf diese Missstände hinzuweisen? Dann bewertet uns gern positiv, und teilt die Episode mit den Leuten, die es wissen sollten!

Show Notes 163:

Apps & Mobile Entwicklung

NEX Group wird eigenständig: Ericsson potenziell vor Einstieg in Intels Netzwerksparte

Ericsson plant laut Medienberichten einen dreistelligen Millionenbetrag in Intel NEX (Network and Edge) zu investieren. Die Sparte soll in Zukunft eigenständig werden und von Intel losgelöst sein, ähnlich wie das Unternehmen sich zuletzt von anderen Firmenteilen wie Altera trennte.

Ericsson und Intel arbeiten schon lange zusammen. Intel liefert Chips und Lösungen – zuletzt beispielsweise den neuen Xeon 6 SoC – die in Ericssons Infrastruktur und Netzwerken zum Einsatz kommen, auf die wiederum Cloud Service Provider (CSP) setzen. Ein großes Thema dabei ist Cloud RAN für ein Cloud-basiertes, virtualisiertes Radio Access Network.

Intels Netzwerksparte bald auf eigenen Beinen

Im Nachgang des Quartalsberichts in der vergangenen Woche hat Intel erstmals öffentlich durchblicken lassen, dass die NEX Group auf eigene Beine gestellt werden soll, nachdem es im Mai durch die Nachrichtenagentur Reuters bereits Gerüchte gab. Die Aussagen aus einem internen Memo wurden Ende Juli nun gegenüber CRN bestätigt.

We plan to establish key elements of our Networking and Communications business as a stand-alone company and we have begun the process of identifying strategic investors

Intel

Ericsson soll einer der ersten möglichen Investoren sein. Bloomberg berichtet, dass mehrere hundert Millionen US-Dollar in einen Anteil an der Sparte fließen könnten. Noch stünden die Gespräche aber am Anfang, das Ganze könnte auch noch ins Wasser fallen, heißt es weiter.

Die gesamte Sparte bekommt Ericsson dafür aber vermutlich ohnehin nicht, das Unternehmen wäre eher ein kleiner Anteilseigner. Intel würde vermutlich ein Prozedere wie bei Altera vorziehen: Hier gingen am Ende 51 Prozent an Silver Lake, ein Investmentkonsortium, Intel behielt aber 49 Prozent, um immer noch ein Wörtchen mitreden zu können.

Da die NEX Group in vielen Bereichen noch enger verzahnt ist mit Intels Kerngeschäft, als es Altera jemals war, dürfte eine komplette Lösung vom Konzern ohnehin aus dem Stand heraus sehr schwer umzusetzen sein oder Jahre benötigen. Intel beschreibt es deshalb diplomatisch, dass man die NEX Group wachsen sehen und davon in Zukunft auch profitieren möchte.

Like Altera, we will remain an anchor investor enabling us to benefit from future upside as we position the business for future growth.

Intel

Am Ende setzt Intel den bereits unter Pat Gelsinger gestarteten Plan, den Fokus allein auf das Kerngeschäft zu lenken, weiter um. Unter Gelsinger wurden bereits ein Dutzend Teilbereiche geschlossen oder verkauft, der neue CEO geht nun aber an die noch größeren Positionen heran. Im Zusammenspiel mit den Entlassung vieler Angestellte soll das den Konzern bis Jahresende auf 75.000 Mitarbeiter verschlanken.

-

Datenschutz & Sicherheitvor 2 Monaten

Datenschutz & Sicherheitvor 2 MonatenGeschichten aus dem DSC-Beirat: Einreisebeschränkungen und Zugriffsschranken

-

Online Marketing & SEOvor 2 Monaten

Online Marketing & SEOvor 2 MonatenTikTok trackt CO₂ von Ads – und Mitarbeitende intern mit Ratings

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenMetal Gear Solid Δ: Snake Eater: Ein Multiplayer-Modus für Fans von Versteckenspielen

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenPhilip Bürli › PAGE online

-

Digital Business & Startupsvor 1 Monat

Digital Business & Startupsvor 1 Monat80 % günstiger dank KI – Startup vereinfacht Klinikstudien: Pitchdeck hier

-

Apps & Mobile Entwicklungvor 1 Monat

Apps & Mobile Entwicklungvor 1 MonatPatentstreit: Western Digital muss 1 US-Dollar Schadenersatz zahlen

-

Social Mediavor 2 Monaten

Social Mediavor 2 MonatenLinkedIn Feature-Update 2025: Aktuelle Neuigkeiten

-

Digital Business & Startupsvor 1 Monat

Digital Business & Startupsvor 1 Monat10.000 Euro Tickets? Kann man machen – aber nur mit diesem Trick