Entwicklung & Code

Wie KI die Open-Source-Entwicklung verändert

KI wirbelt die die Communities von Open-Source-Projekten durcheinander und stellt Entwicklerinnen und Entwickler vor wichtige Fragen. Darf Open-Source-Code zum Trainieren von KI-Modellen uneingeschränkt verwendet werden? Wo hilft KI und wo schadet sie Open-Source-Projekten – beim Beantworten von Fragen zum Code, beim Programmieren und beim Projektmanagement? Was ist Open Washing und welche Rolle spielt Open Source im EU AI Act? Und schließlich die entscheidende Frage: Wird KI Open Source verdrängen? Antworten liefert die Community selbst. Tiefere Einblicke bieten die im Text verlinkten Videos von Vorträgen von Open-Source-Konferenzen der letzten sechs Monate: der Open Community Experience (OCX) mit den Unterkonferenzen EclipseCon und OSGi Summit, dem 38C3 sowie der FOSDEM 2025. Antworten auf diese Fragen liefern zudem Vertreter der Eclipse Foundation, dem Veranstalter der OCX.

Holger Voormann ist als Diplom-Informatiker freiberuflich tätig. Für heise online berichtet er regelmäßig über neue Releases der Entwicklungsumgebung Eclipse. Er ist Contributor bei Eclipse, llama.cpp und weiteren Open-Source-Projekten.

Open-Source-Code als KI-Trainingsdaten: (l)egal?

Code macht einen großen Teil der Daten aus, mit denen heutige KI-Modelle trainiert werden. Benötigt wird er nicht nur, um die Modelle für Programmieraufgaben fit zu machen, sondern auch, um deren Schlussfolgerungsfähigkeit, das Reasoning, zu verbessern. Einige Chatbot-Modelle sind zudem in der Lage, anstatt direkt eine Antwort zu geben, Python-Code zu erstellen, der die Antwort teilweise berechnet und – damit er keinen Schaden anrichten kann – in einer Sandbox läuft. Mit der Ausgabe von der Programmausführung generiert dann das Modell die eigentliche Antwort. Dieser Code Interpreter hilft insbesondere bei Fragen, deren Beantwortung komplexere Berechnungen benötigt.

Der Code, der für das Training der Modelle verwendet wird, ist – wie könnte es anders sein – Open Source: in großen Mengen im Netz frei erhältlich. Die Llama-3-Basismodelle von Meta entstanden beispielsweise aus einem Training mit 15 Billionen Token, was mehr als 10 Billionen Wörtern entspricht, 17 Prozent davon Code. Aber wie ist das rechtlich? Ist ein Large-Language-Model ein von dem Code, anhand dessen es trainiert wurde, abgeleitetes Werk? Und wenn ja, unterliegt es dann den jeweiligen Lizenzbedingungen?

Die rechtliche Lage ist unklar. In Hugging Face BigCode (siehe OCX-Vortrag), einer umfangreichen Sammlung von Quelltexten, die aus öffentlichen GitHub-Repositories zusammengesammelt wurden, findet sich kein Code unter der Eclipse Public License (EPL), sondern nur Code unter der Apache-, MIT- und ähnlichen Lizenzen. Bei diesen Lizenzen ist im Gegensatz zur EPL nicht vorgeschrieben, dass abgeleitete Werke unter derselben Lizenz veröffentlicht werden müssen. Mike Milinkovich, Geschäftsführender Direktor der Eclipse Foundation, geht nicht von einer Verletzung der EPL aus, kann sie aber auch nicht sicher ausschließen. Es könne noch einige Jahre dauern, bis die KI-Frage geklärt sei, da das Urheberrecht von Land zu Land zwar weitgehend einheitlich, aber im Detail unterschiedlich sei und es noch keinen starken Konsens darüber gebe, ob es sich um ein abgeleitetes Werk oder um Fair Use handele. Eine EPL Version 3.0, die explizit die Verwendung als Trainingsdaten erlaubt oder verbietet, ist jedenfalls nicht geplant und würde ohnehin nicht rückwirkend für bereits vorhandenen Code gelten.

Unabhängig davon, ob die Verwendung als Trainingsdaten rechtlich unter Fair Use fällt oder nicht, stellt sich die Frage, ob es moralisch in Ordnung ist, Open-Source-Code ungefragt zum Trainieren von KI-Modellen zu verwenden. Wer seinen Code als Open Source veröffentlicht, macht das in der Regel in der Hoffnung auf Beiträge von anderen: Fehlerberichte, Verbesserungsvorschläge und gelegentliche Codebeiträge bis hin zur aktiven Beteiligung am Projekt. Eine Zweckbindung oder ein Verbot der kommerziellen Nutzung ist hier eher hinderlich. Restriktive Nutzungsbedingungen schränken den Kreis der potenziellen Nutzenden ein, aus dem sich wiederum die Mitwirkenden rekrutieren. Durch die Auslagerung eines Open-Source-Projekts an einen herstellerunabhängigen Ort, wie ihn die Eclipse Foundation oder andere Open-Source-Organisationen bieten, gibt man noch mehr Kontrolle ab, macht es aber für Unternehmen und Einzelpersonen attraktiver, sich zu beteiligen. Solange nicht alle, die Open Source direkt nutzen, sich auch daran beteiligen, kann man schlecht von denen, die den Code indirekt als Trainingsdaten nutzen, verlangen, etwas zurückzugeben.

Arbeitserleichterung oder Mehraufwand durch Chatbots?

Aber es ist nicht nur ein Nehmen von Trainingsdaten, sondern auch ein Geben: Chatbots entlasten Entwicklerinnen und Entwickler, indem sie Fragen zu Open-Source-Projekten beantworten. Fragen, die ansonsten in projektinternen Foren oder auf Webseiten wie Stack Overflow gestellt und dort von den Developern selbst oder Anwendern beantwortet worden wären. Kleinere Modelle lassen sich selbst ohne teure Grafikkarte auf dem eigenen Rechner ausführen, wenn man Geschwindigkeitseinbußen in Kauf nimmt: unter anderem mit einem der beiden bekannten Open-Source-Kommandozeilentools MLX von Apple für Apple-Computer oder llama.cpp für macOS, Linux und Windows; mit Ollama, das die Verwaltung von Modellen vereinfacht, oder mit llamafile, welches das Modell und den Code zum Ausführen in einer einzelnen Datei packt und wie Ollama auf llama.cpp basiert.

Chatbots laufen Stack Overflow den Rang ab: Seit Erscheinen von ChatGPT Ende November 2022 halbiert sich jährlich die Anzahl neuer Fragen und Antworten auf Stack Overflow. Und auch die Fragen, die noch gestellt werden, verweisen mitunter auf nicht funktionierende Chatbot-Lösungsvorschläge und Dinge, die es nicht gibt und die vermutlich eine KI herbeihalluziniert hat. Auch wenn Chatbots mal daneben liegen, geben sie doch zumeist schneller und freundlicher Auskunft als Menschen auf Stack Overflow und anderswo oder als eine Websuche es vermag. „Let me ask ChatGPT for you“ ist das neue „Let me google that for you“.

Die Kehrseite dieser KI-Helfer ist, dass sie auch Stack-Overflow-Antworten oder Beiträge für Open-Source-Projekte – beispielsweise Curl – generieren, die sich erst bei genauerem Hinsehen als nutzlos erweisen und so unnötigen Aufwand verursachen. Ein weiterer Nachteil von KI-generierten Lösungsvorschlägen ist, dass sie dazu neigen, ältere statt aktueller Frameworks und Tools zu bevorzugen. Neuere Informationen werden zwar berücksichtigt, wenn sie in einer Anfrage mitgegeben werden. Damit die KI sie jedoch sinnvoll anwenden, also generalisieren kann, muss sie zuvor anhand entsprechender Daten in ausreichender Quantität und Qualität trainiert worden sein.

Wenn Fragen nicht öffentlich, sondern an Chatbots gestellt werden, erfahren Projekt-Maintainer außerdem nicht, welche Probleme andere mit ihrer Software haben. Nicht nur das ausbleibende Feedback könnte sich als problematisch für die Projekte erweisen, sondern auch weniger öffentlich verfügbare Fragen und Antworten für das Training zukünftiger Modelle. Langfristig liegt es daher im Interesse beider Seiten, eine Lösung für den zerbrochenen Feedback-Loop zu finden.

KI-Unterstützung beim Programmieren

Neben allgemeinen Chatbots gibt es auch KI-Unterstützung speziell fürs Programmieren: zum Generieren von Code, Code-Kommentaren und Tests sowie zur Fehlerbehebung und Verbesserung von bestehendem Code. Integriert als Chatbot oder – um kontextabhängige Vorschläge auf Basis des umgebenden Codes zu liefern, speziell oder zusätzlich zur Interaktion in Chat-Form trainiert – direkt im Code-Editor als Codevervollständigung, helfen sie auch bei der Verwendung von Open-Source-Frameworks. Durch den hinzugefügten Kontext sind die Anfragen in der Regel länger, der Rechenaufwand dadurch höher. Frei verfügbare Angebote gibt es wenige, die zudem eine Anmeldung erfordern und auf eine bestimmte Anzahl Codevervollständigungsvorschläge und Chat-Anfragen pro Monat begrenzt sind.

Es gibt Open-Source-Tools als Alternativen zum Platzhirsch GitHub Copilot und solche, die sich Copilot zunutze machen, um ein besseres Tooling anbieten zu können. Eclipse Theia ist eine Alternative zu Visual Studio Code mit GitHub Copilot (weitere Informationen hierzu in einem Blogpost und OCX-Vortrag von EclipseSource): Anfragen, die nach außen gesendet werden, werden protokolliert und sind einsehbar; es lassen sich Agenten definieren, bei denen man festlegen kann, welche Zusatzinformation genau enthalten sein soll. Neben GitHub Copilot lassen sich auch lokal auf dem Rechner installierte Modelle verwenden, was bei GitHub Copilot erst seit Kurzem möglich ist.

Ein Vertreter eines mithilfe von GitHub Copilot verbesserten Toolings ist die Visual-Studio-Code-Erweiterung Spring Tools zur Unterstützung beim Programmieren in Java mit dem Webframework Spring (siehe OCX-Vortrag). So erscheinen im Code an bestimmten Stellen „Explain … with Copilot“-Links. Klickt man beispielsweise auf den Link „Explain Query with Copilot“, den Spring Tools bei Spring-spezifischen Annotationen mit einer SQL-Abfrage anzeigt, erhält man die von Copilot generierte Erklärung, ohne selbst eine Frage zu formulieren. Bei manuell erstellten Fragen kann Spring Tools den Prompt um wichtige Hinweise anreichern, bevor dieser an Copilot gesendet wird – beispielsweise, dass bei einem Projekt mit Spring Boot 3 Jakarta EE und nicht mehr Java EE zu verwenden ist.

Auch die von Copilot zurückgesendete Antwort kann Spring Tools um Schaltflächen anreichern, zum Beispiel „Apply Changes“ am Ende einer Antwort mit mehreren Codefragmenten, um alle mit einem Klick an die jeweils richtige Stelle im Projekt zu übernehmen. Copilot-basiertes Tooling besitzt unter anderem die Schwierigkeit, dass Copilot laufend weiterentwickelt wird: Derselbe „Explain … with Copilot“-Link, der heute eine gute Erklärung liefert, kann morgen schon nicht mehr funktionieren. Eine weitere Schwierigkeit entsteht, wenn GitHub Copilot nicht kennt, wonach gefragt wird, weil das verwendete Framework zu neu beziehungsweise der Wissensstand von Copilot zu alt ist. Bei der Anreicherung des Prompts kann auch die Längenbeschränkung ein Problem darstellen.

(Bild: TechSolution/Shutterstock)

Nach dem großen Erfolg der ersten betterCode() GenAI findet die Online-Konferenz zur KI-gestützten Softwareentwicklung am 26. Juni erneut statt.

Die Veranstalter iX und dpunkt.verlag haben das Programm der Konferenz aktualisiert und anhand des Feedbacks weiter verbessert. Es bietet folgende Vorträge:

- Softwareentwicklung mit Copilot, ChatGPT und Co

- Was gibt es Neues bei KI-Coding-Tools?

- Software mit KI-Unterstützung testen

- Mit ChatGPT Dinosaurier besiegen – LLMs für die Analyse alter Systeme

- Stärken und Schwächen KI-unterstützter, sicherer Softwareentwicklung

- Rechtliche Aspekte KI-gestützter Softwareentwicklung

Entwicklung & Code

Angular Signals: Elegante Reaktivität als Architekturfalle

Mit Angular 17 hielten Signals 2023 offiziell Einzug in das Framework. Sie versprechen eine modernere, klarere Reaktivität: weniger Boilerplate-Code, bessere Performance. Gerade im Template- und Komponentenbereich lösen sie viele Probleme eleganter als klassische Observable-basierte Ansätze.

Nicolai Wolko ist Softwarearchitekt, Consultant und Mitgründer der WBK Consulting AG. Er unterstützt Unternehmen bei komplexen Web- und Cloudprojekten und wirkt als Sparringspartner sowie Gutachter für CTOs. Fachbeiträge zur modernen Softwarearchitektur veröffentlicht er regelmäßig in Fachmedien und auf seinem Blog.

Statt Subscriptions, pipe() und komplexen Streams genügen nun wenige Zeilen mit signal(), computed() und effect(). Der Code wirkt schlanker, intuitiver und näher am User Interface (UI).

Da liegt die Idee nahe: Wenn Signals im UI überzeugen, warum nicht auch in der Applikationslogik? Warum nicht RxJS vollständig ersetzen? Ein Application Store ohne Actions, Meta-Framework und Observable: direkt, deklarativ, minimalistisch.

Ein Ansatz, der im Folgenden anhand eines konkreten Fallbeispiels analysiert und kritisch hinterfragt wird. Anschließend wird behandelt, in welchen Kontexten sich Signals sinnvoll einsetzen lassen.

Aufbau des Fallbeispiels

Auf den ersten Blick besitzt dieses Beispiel einen klar strukturierten Architekturansatz. Doch der Wandel beginnt unauffällig. RxJS bleibt zunächst außen vor. Das UI reagiert flüssig, der Code bleibt übersichtlich. Komplexe Streams, verschachtelte Operatoren oder eigenes Subscription Handling entfallen. Stattdessen kommen Signals zum Einsatz. Es liegt nahe, diese unkomplizierte Herangehensweise auch für die Applikationslogik zu übernehmen. Im folgenden Beispiel übernimmt ein ProductStore die Zustandslogik. Signals organisieren Kategorien, Filter und Produktdaten – reaktiv und direkt.

@Injectable({ providedIn: 'root' })

export class ProductStore {

private allProducts = signal([]);

readonly selectedCategory = signal('Bücher');

readonly onlyAvailable = signal(false);

readonly productList = computed(() => {

return this.allProducts().filter(p =>

this.onlyAvailable() ? p.available : true

);

});

selectCategory(category: string) {

this.selectedCategory.set(category);

}

toggleAvailabilityFilter() {

this.onlyAvailable.set(!this.onlyAvailable());

}

constructor(private api: ProductApiService) {

effect(() => {

const category = this.selectedCategory();

const onlyAvailable = this.onlyAvailable();

this.api.getProducts(category, onlyAvailable).then(products => {

this.allProducts.set(products);

});

});

}

}

Die Struktur überzeugt zunächst durch Klarheit. Die Komponente konsumiert productList direkt, ohne eigene Logik. Der Store verwaltet den Zustand, Signals sorgen für die Weitergabe von Änderungen.

Doch mit der nächsten Anforderung ändert sich das Bild: Bestimmte Produkte sollen zwar im Katalog verbleiben, aber im UI nicht mehr erscheinen. Da auch andere Systeme die bestehende API verwenden, ist eine Anpassung nicht möglich. Stattdessen liefert das Backend eine Liste freigegebener Produkt-IDs, anhand derer das UI filtert.

@Injectable({ providedIn: 'root' })

export class ProductStore {

// [...]

readonly backendEnabledProductIds = signal>(new Set());

readonly productList = computed(() => {

return this.allProducts().filter(p =>

this.onlyAvailable() ? p.available : true

).filter(p => this.backendEnabledProductIds().has(p.id));

});

constructor(private api: ProductApiService) {

effect(() => {

const category = this.selectedCategory();

const onlyAvailable = this.onlyAvailable();

this.api.getProducts(category, onlyAvailable).then(products => {

this.allProducts.set(products);

});

});

effect(() => {

this.api.getEnabledProductIds().then(ids => {

this.backendEnabledProductIds.set(new Set(ids));

});

});

}

// [...]

}

Nach außen bleibt die Architektur zunächst unverändert. Die Komponente enthält weiterhin keine eigene Logik, Subscriptions sind nicht notwendig, und die Reaktivität scheint erhalten zu bleiben. Im Service jedoch nimmt die Zahl der effect()s zu, Abhängigkeiten werden vielfältiger, und die Übersichtlichkeit leidet.

Nach und nach wandert Logik in verteilte effect()s, bis ihre Zuständigkeiten kaum noch greifbar sind. Aus einem überschaubaren ViewModel entsteht ein Gebilde mit immer mehr impliziten Reaktionen – eine Entwicklung, die ein waches Auge für Architektur erfordert.

Wenn reaktive Systeme entgleisen

Das Setup wirkt zunächst unspektakulär. Die Produktliste wird über ein computed() erstellt, gefiltert nach Verfügbarkeit und den vom Backend freigegebenen IDs. Zwei effect()s laden die Daten.

Der Code wirkt aufgeräumt und lässt sich modular erweitern. Doch der nächste Feature-Wunsch stellt das System auf die Probe: Die Stakeholder möchten wissen, wie oft bestimmte Kategorien angesehen werden. Die Entwicklerinnen und Entwickler entscheiden sich für einen naheliegenden Ansatz. Eine Änderung der Kategorie löst ein Tracking-Event aus. Ein effect() scheint dafür perfekt geeignet – unkompliziert und ohne erkennbare Nebenwirkungen:

effect(() => {

const category = this.selectedCategory();

this.analytics.trackCategoryView(category);

});

Schnell eingebaut, kein zusätzlicher State, keine neue Subscription. Eine Reaktion auf das bestehende Signal, unkompliziert und ohne erkennbare Nebenwirkungen. Doch damit verlässt der Code den Bereich kontrollierter Reaktivität.

Der Kipppunkt

Die Annahme ist klar: Ändert sich die Kategorie, wird ein Tracking ausgelöst. Was dabei leicht zu übersehen ist: Signals reagieren nicht auf Bedeutung, sondern auf jede Mutation. Auch wenn set() denselben Wert schreibt oder zwei Komponenten nacheinander dieselbe Auswahl treffen, passiert zwar technisch etwas, semantisch aber nicht. Das Ergebnis sind doppelte Events und verzerrte Metriken, ohne dass der Code einen Hinweis darauf gibt. Alles sieht korrekt aus.

Das Tracking erfolgt unmittelbar im selben Ausführungstakt (Tick), ohne Möglichkeit zur Entkopplung. Wenn parallel ein weiterer effect() ausgelöst wird – etwa durch ein zweites Signal –, fehlt jegliche Koordination.

Die Reihenfolge ist nicht vorhersehbar, und das UI kann in einen inkonsistenten Zustand geraten: Daten werden mehrfach geladen, Reaktionen überschneiden sich, Seiteneffekte sind nicht mehr eindeutig zuzuordnen. Mit jedem zusätzlichen effect() steigt die Zahl impliziter Wechselwirkungen. Was wie ein reagierendes System wirkt, ist längst nicht mehr entscheidungsfähig.

In einem Kundenprojekt führte genau dieser Zustand dazu, dass ein effect() mehrfach pro Sekunde auslöste. Nicht wegen einer echten Änderung, sondern weil derselbe Wert mehrfach gesetzt wurde. Das UI zeigte korrekte Daten, aber das Backend war mit redundanten Anfragen überlastet.

Das Missverständnis

effect() wirkt wie ein deklarativer Controller: „Wenn sich X ändert, tue Y.“ Doch in Wirklichkeit ist es ein reaktiver Spion. Er beobachtet jedes Signal, das gelesen wird, unabhängig von der semantischen Bedeutung. Er feuert sogar dann, wenn niemand es erwartet. Und er ist nicht koordiniert. Jeder effect() lebt in seiner eigenen Welt, ohne zentrale Regie.

Was als architektonische Vereinfachung begann, endet in einer Blackbox aus Zuständen, Reaktionen und Nebenwirkungen. Mit jedem weiteren Feature wächst diese Komplexität. Es gibt keinen großen Knall, aber eine zuvor elegant erscheinende Struktur driftet leise auseinander.

Entwicklung & Code

KubeSphere entfernt Open-Source-Dateien und stellt Support ein

Die chinesische Kubernetes-Plattform KubeSphere hat auf GitHub angekündigt, die Open-Source-Version des Produkts zurückzuziehen und den kostenlosen Support einzustellen: „Ab dem Datum dieser Ankündigung werden die Download-Links für die Open-Source-Version von KubeSphere deaktiviert und der kostenlose technische Support eingestellt.“

Das Kernprojekt von KubeSphere auf GitHub bleibt jedoch Open Source unter Apache-2-Lizenz. Als Grund für den Wechsel nennt der Hersteller die Änderung der Digitalisierung mit Gen AI, wodurch auch die Infrastruktur-Branche tiefgreifende Veränderungen erfahren hat. „Um sich an die neue Ära anzupassen, die Produktkapazitäten und die Servicequalität weiter zu verbessern und sich auf die Forschung und Entwicklung von Kerntechnologien sowie die Optimierung kommerzieller Lösungen zu konzentrieren, hat das Unternehmen nach mehrjähriger Planung und sorgfältiger Prüfung beschlossen, die folgenden Anpassungen am Open-Source-Projekt KubeSphere vorzunehmen.“ Es folgt die oben genannte Ankündigung.

Welche aktuellen oder künftigen Produkte konkret nicht mehr Open Source sind, ist der Ankündigung nicht zu entnehmen. Auf der Webseite weist der Hersteller derzeit sogar noch auf die CNCF-Zertifizierung hin. Nutzern von KubeSphere rät der Diskussionsbeitrag, sich für eine kommerzielle Version an den Support zu wenden.

Der Beitrag ist auf Chinesisch, darunter findet sich eine englische Übersetzung. Wir haben mit KI-Hilfe direkt aus dem Chinesischen übersetzt.

(who)

Entwicklung & Code

JetBrains: Preissprung bei Entwicklungsumgebungen ab 1. Oktober

Das tschechische Softwareunternehmen JetBrains hat angekündigt, seine Preise am 1. Oktober 2025 anzuziehen. Nach drei Jahren der Preisstabilität sieht sich der Hersteller beliebter Entwicklungsumgebungen (Integrated Development Environments, IDEs) aufgrund der Inflation gezwungen, die Preise für Abonnements zu erhöhen. Wer im Voraus zahlt, kann die bisherigen Preise noch für eine begrenzte Zeitdauer über den 1. Oktober hinaus beibehalten.

Preissteigerungen für IDEs, .NET-Tools, dotUltimate und All Products Pack

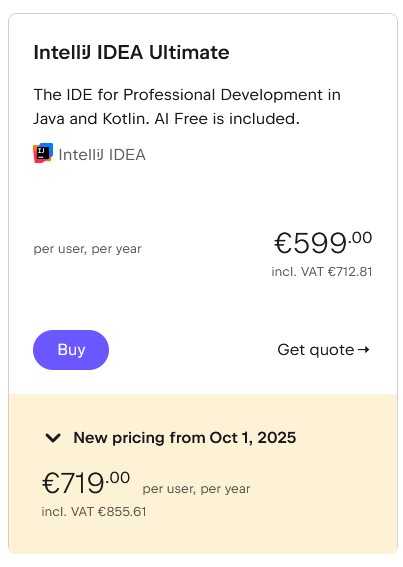

Betroffen sind die Abos für die JetBrains-Entwicklungsumgebungen – wie IntelliJ IDEA, WebStorm oder PhpStorm –, die .NET-Tools, das .NET-Toolkit dotUltimate und die IDE-Sammlung All Products Pack. Auf einer Webseite informiert JetBrains über die Preisänderungen. Beispielsweise erhöhen sich die Kosten der IDE IntelliJ IDEA Ultimate für den individuellen Einsatz bei jährlicher Zahlweise von 169 Euro auf 199 Euro (plus Mehrwertsteuer), bei monatlicher Zahlung von 16,90 Euro auf 19,90 Euro – jeweils auf das erste Nutzungsjahr bezogen. Für Unternehmen fallen die Steigerungen happiger aus: Das gleiche Produkt kostet pro User und Jahr derzeit 599 Euro (oder 59,90 Euro monatlich), ab dem 1. Oktober 719 Euro (oder 71,90 Euro monatlich) – eine Erhöhung um rund 20 Prozent.

Kosten für IntelliJ IDEA Ultimate für die individuelle Nutzung

(Bild: JetBrains)

Kosten für IntelliJ IDEA Ultimate für Unternehmen

(Bild: JetBrains)

Beim All Products Pack, das aus elf Entwicklungsumgebungen und weiteren Inhalten besteht, steigen die Preise für den individuellen Einsatz von 289 Euro auf 299 Euro pro Jahr an, für den Einsatz in Unternehmen pro Jahr und User von 779 Euro auf 979 Euro.

Für bestimmte Nutzergruppen wie Lehrkräfte, Schülerinnen und Schüler oder Core Maintainer von Open-Source-Projekten sind weiterhin kostenfreie Angebote aufgeführt.

Alternative: Im Voraus bezahlen und sparen

JetBrains bietet seinen bestehenden sowie neuen Kundinnen und Kunden die Möglichkeit, im Voraus noch zu den derzeitigen Preisen zu bezahlen: Für individuelle Abos gilt dieser dann bis zu drei Jahre lang, für kommerzielle bis zu zwei Jahre. Dann wird die entsprechende Zahlung jedoch auf einen Schlag vor dem 1. Oktober 2025 fällig.

Weitere Details bieten der JetBrains-Blog und die Preisübersichtsseite.

(mai)

-

Datenschutz & Sicherheitvor 2 Monaten

Datenschutz & Sicherheitvor 2 MonatenGeschichten aus dem DSC-Beirat: Einreisebeschränkungen und Zugriffsschranken

-

Online Marketing & SEOvor 2 Monaten

Online Marketing & SEOvor 2 MonatenTikTok trackt CO₂ von Ads – und Mitarbeitende intern mit Ratings

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenMetal Gear Solid Δ: Snake Eater: Ein Multiplayer-Modus für Fans von Versteckenspielen

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenPhilip Bürli › PAGE online

-

Digital Business & Startupsvor 1 Monat

Digital Business & Startupsvor 1 Monat80 % günstiger dank KI – Startup vereinfacht Klinikstudien: Pitchdeck hier

-

Digital Business & Startupsvor 1 Monat

Digital Business & Startupsvor 1 Monat10.000 Euro Tickets? Kann man machen – aber nur mit diesem Trick

-

Apps & Mobile Entwicklungvor 1 Monat

Apps & Mobile Entwicklungvor 1 MonatPatentstreit: Western Digital muss 1 US-Dollar Schadenersatz zahlen

-

Social Mediavor 2 Monaten

Social Mediavor 2 MonatenLinkedIn Feature-Update 2025: Aktuelle Neuigkeiten