Apps & Mobile Entwicklung

Amiga 1000: Vor 40 Jahren brach das Zeitalter der 16 Bit endgültig an

Mit dem Amiga 1000 stellte Commodore vor genau 40 Jahren einen Rechner vor, dessen Bedeutung für die Entwicklung moderner Computertechnik vielfach unterschätzt blieb, was nicht zuletzt auch daran lag, dass der später sehr erfolgreiche Amiga 500 nie wirklich aus dem Schatten des legendären Commodore C64 heraustreten konnte.

Computer für den berühmten Jedermann

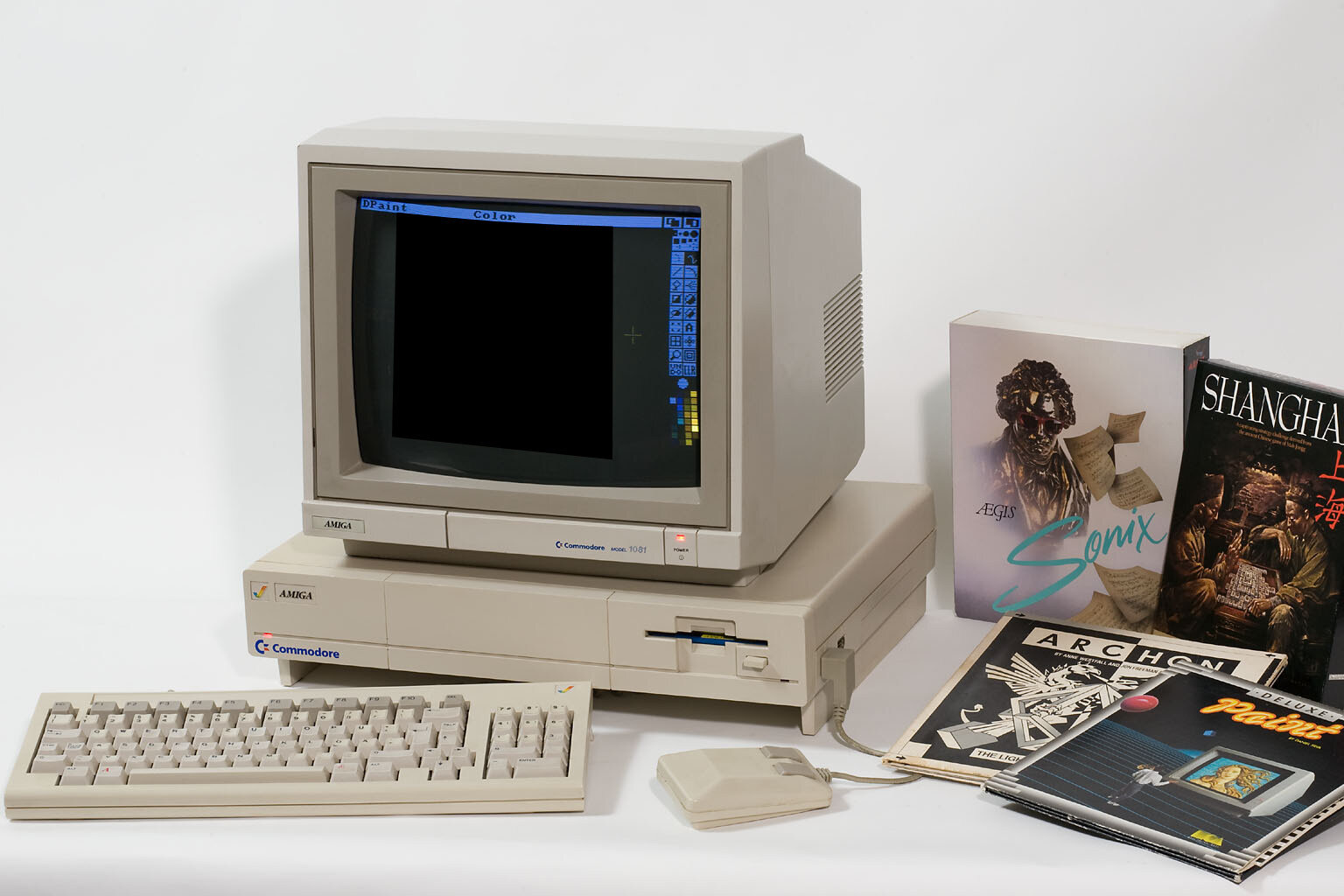

Die Geschichte des Amiga, genauer gesagt des ersten Modells, des Amiga 1000, das zunächst nur aus einem Motherboard mit dem Code-Namen „Lorraine“ bestand, reicht zurück bis in die frühen 1980er-Jahre. Damals formierte sich eine Gruppe technikbegeisterter Computer-Entwickler mit dem Ziel, ein leistungsstarkes, aber dennoch erschwingliches System zu schaffen, das sowohl für den Heimgebrauch als auch im Büroalltag überzeugen konnte. Im Zentrum der Gruppe stand der Chipdesigner Jay Miner, ein Ausnahmetalent, der bereits maßgeblich an der Entwicklung der Spielkonsole Atari VCS 2600 sowie an den Computern Atari 400 und 800 beteiligt gewesen war.

Hoch gesteckte Ziele in Sachen Ausstattung

Der Amiga war von Beginn an darauf ausgelegt, echtes Multitasking zu ermöglichen, und sollte standardmäßig mit Tastatur, Diskettenlaufwerk, der Möglichkeit für eine Speichererweiterung sowie diversen Schnittstellen für externe Geräte ausgestattet werden. Herzstück des Systems war der Motorola 68000, einer der leistungsfähigsten Prozessoren seiner Zeit, der von mehreren eigens entwickelten Chips unterstützt wurde, welche unter anderem die Grafik- und Audioverarbeitung übernahmen.

Pakt mit dem Teufel

Da die Entwicklung zunehmend kostspieliger wurde, drohte das Projekt jedoch zeitweise zu scheitern. In dieser Phase konnte Atari als Kapitalgeber gewonnen werden, mit einem Darlehen über 500.000 US-Dollar wurde die Weiterentwicklung der Chips gesichert. Die Vereinbarung hatte jedoch einen entscheidenden Haken: Würde das Geld nicht bis zum 30. Juni 1984 zurückgezahlt, sollten die entwickelten Chips und ihre Technologie an Atari übergehen. Um dies zu verhindern, wurde Amiga an Commodore verkauft, wodurch die fällige Summe erst kurz vor Ablauf der 24-Stunden-Frist beglichen werden konnte.

Zunächst geringes Interesse

Der Amiga 1000 wurde am 23. Juli 1985 in den USA vorgestellt, während die Präsentation in Deutschland am 21. Mai 1986 stattfand – moderiert von Frank Elstner. Trotz seiner technischen Stärken blieb das Interesse gering, was unter anderem auf fehlendes Marketing und eine unklar definierte Zielgruppe zurückgeführt werden kann. Der Einstiegspreis von 5.900 DM (inflationsbereinigt etwa heute 6.500 Euro) dürfte ebenfalls eine Hürde dargestellt haben. Zudem versuchte Commodore 1985 gleichzeitig mit dem C128 den Nachfolger des C64 zu etablieren, was jedoch ebenfalls scheiterte. Mit der Fokussierung auf mehrere Modelle gleichzeitig agierte das Unternehmen über seinen Möglichkeiten und so schaffte es dieses nicht, zum Weihnachtsgeschäft 1985 ausreichende Stückzahlen des Amiga 1000 zu produzieren.

Aufteilung als Erfolg

Erst mit der Aufteilung der Produktlinie im Jahr 1987 in den für Heimanwender gedachten Amiga 500 und das für den professionellen Einsatz konzipierte Modell Amiga 2000 – letzteres entwickelt von der Commodore-Niederlassung in Braunschweig – konnte Commodore Erfolge verbuchen. Beide Modelle wurden zunächst zu Preisen von etwas über 1.000 DM beziehungsweise rund 3.000 DM angeboten. Besonders der Amiga 500 entwickelte sich zu einem Verkaufsschlager, nicht zuletzt durch die für diese Zeit außergewöhnlichen Spielefähigkeiten. Diese waren unter anderem den Chips Agnus als Adressgenerator, Denise (ursprünglich Daphne) für Grafik, Paula für Audio und Peripherie sowie Gary, der exklusiv im Amiga 500 verbaut war, zu verdanken. Denise ermöglichte eine Auflösung von bis zu 640 × 512 Pixel – zwar im Zeilensprungverfahren und dadurch mit starkem Flackern verbunden, aber immerhin mit bis zu 4.096 darstellbaren Farben. Eine derartige grafische Leistungsfähigkeit war in dieser Preisklasse bis dahin unerreicht.

Weltweit sollen bis zum Konkurs von Commodore im Jahr 1994 rund sechs Millionen Geräte verkauft worden sein – davon etwa eine Million in Deutschland und 1,5 Millionen in Großbritannien. Dennoch blieb der Amiga 500 deutlich hinter dem C64 zurück, der es während seiner elfjährigen Produktionszeit auf über 22 Millionen verkaufte Einheiten brachte.

Bis heute lebendig

Der Commodore Amiga hat bis heute nichts von seiner Faszination eingebüßt und lebt sowohl in der Popkultur als auch in Form zahlreicher Emulationen weiter, zuletzt etwa mit dem TheA500 Mini (Test) von Retro Games. Eine neue, größere Variante mit echter Tastatur war zuletzt ebenfalls geplant, doch kommt deren Entwicklung aufgrund von Schwierigkeiten bei den Lizenzverhandlungen rund um das Betriebssystem aktuell nicht voran.

Wer mehr über die Geschichte des Commodore Amiga erfahren möchte, dem sei die sehenswerte Dokumentation „Die Amiga-Story“ empfohlen, die auf YouTube und gelegentlich auch in der ZDF-Mediathek verfügbar ist und deutlich umfassendere Einblicke in die Entstehung des Systems bietet, als es dieser kurze Überblick leisten kann.

Apps & Mobile Entwicklung

Apple iPhone 17, Air und Pro ohne Tarif vorbestellen: Hier wird’s besonders teuer!

Das Warten hat ein Ende. In wenigen Tagen sind auch das neue Apple iPhone 17, iPhone Air und iPhone 17 Pro (Max) im Vorverkauf erhältlich. Möchtet Ihr Euch das iPhone ohne Vertrag schnappen, verraten wir Euch, wo Ihr die Smartphones bekommt. Außerdem erfahrt Ihr, wie viel Ihr zahlen dürft, ob es Vorbesteller-Aktionen gibt und natürlich auch, wie Ihr an die neue Apple Watch und Apple AirPods Pro kommt.

Die Hallen der IFA sind noch nicht einmal geräumt und schon erwartet uns der nächste Tech-Hammer: die Apple-Keynote. Traditionell stellt das Unternehmen im September die neuen iPhone-Modelle mitsamt einer neuen Apple Watch und Apple AirPods vor. Möchtet Ihr nicht bis zum offiziellen Verkaufsstart warten, habt Ihr ab dem 12. September die Möglichkeit, die Geräte vorzubestellen. Häufig lohnt sich das dank Trade-In-Bonus sogar deutlich.

Hinweis: Aktuell ist nur die Vorbestellung über den Apple Store möglich. Sobald weitere Shops verfügbar sind, werden wir diesen Artikel direkt updaten.

Die neue iPhone-17-Serie ist ab dem 12. September im Vorverkauf erhältlich. Ab dem 19. September sind die Geräte dann auch im (Online)-Handel verfügbar. Wie bei den meisten aktuellen Smartphone-Releases könnt Ihr mit Trade-In-Boni eine ganze Menge sparen, indem Ihr Euer altes Handy einsendet. Dadurch sind das iPhone 17, iPhone 17 Plus, iPhone 17 Pro und iPhone 17 Pro Max selbst ohne dazugehörigen Tarif durchaus erschwinglich.

Möchtet Ihr Euch die Premium-Smartphones also ohne einen Handyvertrag vorbestellen, habt Ihr neben dem Apple Store natürlich auch die Möglichkeit, bei weiteren Händlern zuzugreifen. Vor allem Amazon und MediaMarkt dürften zu den beliebtesten Anbietern zählen. Doch auch Shops wie CoolBlue oder Cyberport bieten die iPhone-17-Reihe an. Bei allen Händlern zahlt Ihr natürlich denselben Preis. Hier findet Ihr zudem die neue Apple Watch oder die neuen Apple AirPods.

Beachtet allerdings, dass es in den letzten Jahren immer wieder zu Lieferschwierigkeiten, vor allem im Apple Store kam. Vor allem die Pro-Modelle sind äußerst begehrt und hier galt vor allem beim iPhone 15 Pro Max (Test) von 2023 „First come, first serve“. Ob es sich in diesem Jahr wiederholt, bleibt allerdings abzuwarten. Schauen wir uns aber zunächst einmal an, was Ihr für die jeweiligen iPhone-17-Modelle zahlen dürft.

Kosten der iPhone-16-Serie

| Modell | Speicherplatz | Preis |

|---|---|---|

| iPhone 17 | 256 GB | 949 € |

| 512 GB | 1.199 € | |

| iPhone Air | 256 GB | 1.199 € |

| 512 GB | 1.449 € | |

| 1 TB | 1.699 € | |

| iPhone 17 Pro | 256 GB | 1.299 € |

| 512 GB | 1.549 € | |

| 1 TB | 1.799 € | |

| iPhone 17 Pro Max | 256 GB | 1.449 € |

| 512 GB | 1.699 € | |

| 1 TB | 1.949 € | |

| 2 TB | 2.449 € |

Apple belässt die Preise größtenteils. Das iPhone Air wird deutlich teurer, als das bisherige iPhone Plus, bietet dafür aber auch etwas mehr. Vor allem die Upgrades der Pro-Varianten sind spannend. Denn abseits des Einstiegspreises für das iPhone 17 Pro und der Kosten für die 2-TB-Variante des Pro Max, hat sich hier nicht viel getan. Interessant ist auch, dass die 128-GB-Versionen im Jahr 2025 nicht mehr verkauft werden.

Zusätzlich solltet Ihr Euch darauf vorbereiten, die iPhone-16-Serie ab dem Release-Tag nicht mehr im Apple Store zu finden. Doch keine Sorge: Ihr bekommt das Smartphone nach wie vor bei anderen Händlern. So bietet Netto das iPhone 16 aktuell noch für 729 Euro* an.

Apple iPhone 17 vorbestellen

Wir werden Euch an dieser Stelle nicht alles dazu verraten, was die neuen iPhones auf dem Kasten haben. Schaut dafür auf nextpit vorbei, um keine News zum neuen Apple-Flaggschiff zu verpassen. Ab dem 12. September ist das Apple iPhone 17 vorbestellbar. Das Apple iPhone 17 Plus wird durch ein neues Gerät ersetzt. Die Auslieferung beginnt am 19. September. Glücklicherweise bleibt Apple sich hier treu und erhöht die Einstiegskosten für seine Smartphones nicht. Dementsprechend zahlt Ihr für die kleinste Speichervariante 949 Euro.

Allem Anschein nach hat Apple hier eher Modellpflege betrieben, was auch die Preise erklärt. Allerdings zeichnet sich dadurch auch ein spannender Trend ab. Während das Apple-Smartphone vor einigen Jahren noch als überteuertes Luxusprodukt galt, haben Android-Geräte in den letzten Jahren ordentlich zugelegt. So kostet das Google Pixel 10 ebenfalls mindestens 899 Euro und das Pixel 10 Pro (Test) gibt’s sogar erst ab 1.099 Euro. Meiner Meinung nach werden iPhones dadurch nur noch interessanter.

Egal, für welchen Shop Ihr Euch entscheidet: Die Preise sind überall gleich. Die vergangenen Jahre haben lediglich gezeigt, dass die Auslieferung bei Amazon am schnellsten ablief, während der Apple Store am längsten gebraucht hat.

Apple iPhone Air vorbestellen

Neu in der Apple-Familie ist das iPhone Air, welches das Apple iPhone Plus ersetzt. Mit 5,6 mm in der Breite, ist es das dünnste iPhone, das jemals geschaffen wurde. Mit einem 6,5-Zoll-Display ist es zudem nicht allzu groß und soll sogar die Power eines iPhone Pro beinhalten. Das lässt sich der Hersteller auch einiges Kosten. Der Startpreis liegt hier bei $999, also gehen wir von einem Preis über 1.199 Euro aus. Farblich steht Euch hier neben Schwarz, Weiß und Gold auch Hellblau zur Verfügung.

Spannend ist hier auch die Kamera. Denn Apple verzichtet beim Air zwar auf ein Multi-Kamera-System, integriert jedoch ein solches in die sogenannte „Fusion Main Camera“, die mit 48 Megapixeln aufnimmt. Zusätzlich ist eine 12-MP-Telekamera hier eingelassen. Möglich wird das dünne Smartphone im Übrigen dadurch, dass Ihr das Gerät nur via eSIM nutzen könnt.

Apple iPhone 17 Pro (Max) vorbestellen

Abseits des neuen iPhone Air gab es die größten Neuerungen beim iPhone 17 Pro und iPhone 17 Pro Max. Allerdings ist auch hier kein Preisanstieg zu befürchten. Trotz verbesserter Kamera, stärkerem Prozessor und Apple Intelligence bekommt Ihr das „kleinste“ Pro-Modell bereits ab 1.299 Euro.

Dieser Preis wirkt noch recht moderat. Beim iPhone 17 Pro Max sieht die Sache etwas anders aus. Denn für das Flaggschiff-Smartphone solltet Ihr den nächstgelegenen Schwarzmarkt aufsuchen, um eine Eurer Nieren zu versetzen.Mit einem Preis von mindestens 1.449 Euro, setzt Apple für das iPhone 17 Pro Max erneut ein Zeichen. Vor allem die 2-TB-Version für fast 2.500 Euro ist nicht gerade ein Schnapper. Aufgrund der hohen Preisstabilität von iPhones lässt sich das nur schwer mit Android-Geräten vergleichen.

Besonders spannen ist das neue Kamerasystem der Pro-Varianten. Die neuen Kameras setzen ebenfalls auf die „Fusion“-Technologie und bieten jeweils 48 Megapixel – auf allen drei Rückkameras. Wie bereits angekündigt, könnte es bei den äußerst beliebten Pro-Modellen jedoch zu Lieferschwierigkeiten kommen. Bei der Farbauswahl stehen Euch folgende Möglichkeiten zur Verfügung:

Apple iPhone 17 mit Tarif vorbestellen

In diesem Artikel schauen wir uns diese Angebote nicht genauer an – Sorry! Das Angebot im Netz ist so riesig, dass wir es nicht in einem Abschnitt abdecken könnten. Allerdings solltet Ihr unsere Deal-Übersicht verfolgen, da wir hier in den nächsten sicherlich einige Deals für Euch vorbereiten.

Apple AirPods Pro 3 vorbestellen

Auch die neuen Apple AirPods Pro 3 sind offiziell vorgestellt worden. Hier sorgen vor allem die neuen Funktionen rund um die Live-Übersetzung und den Herzfrequenz-Sensor für Aufsehen. Ihr könnt die In-Ear-Kopfhörer ab sofort vorbestellen und erhaltet sie ab dem 19. September. Ab diesem Tag sind sie auch in den „Offline“-Shops erhältlich. Bei Amazon und MediaMarkt zahlt Ihr aktuell 249 Euro für die AirPods Pro 3.

Neue Apple Watch-Serie vorbestellen

Natürlich darf bei einer September-Keynote auch die neue Apple Watch nicht fehlen. Mit der Series 11 geht Apple im Jahr 2025 nicht unbedingt neue Wege, bietet aber dennoch einige Neuerungen. Neben einem verbesserten Akku wurden auch die Sensoren verbessert und selbst 5G als Mobilfunkstandard wurde integriert. Beim Design gibt es kaum etwas Neues, außer einem neuen Alumium-Gehäuse in „Space Grey“. Die Apple Watch Series 11 kostet Euch mindestens 449 Euro.

Auch die günstigere Apple Watch SE geht in die dritte Generation. Sie soll stabiler sein als die Vorgänger, bietet einen neuen S10-Chip und nutzt ähnliche Sensoren, die wir bereits bei der Apple Watch Series 11 sehen. Preislich befindet Ihr Euch hier bei mindestens 269 Euro.

Die Apple Watch Ultra erhält ebenfalls ein Update. Apple hat großen Wert auf die Verbesserung der Satellitenkommunikation gelegt. Zudem wurde der Akku verbessert und soll nun bis zu 48 Stunden durchhalten. Bei den Farben des Gehäuses steht Euch neben dem klassischen Schwarz auch eine polierte graue Variante zur Verfügung. Zusätzlich wurde das Display durch dünnere Ränder optisch erweitert. Preislich befindet Ihr Euch hier bei mindestens 899 Euro.

Alle Apple Watches sind ab heute vorbestellbar und werden ebenfalls ab dem 19. September ausgeliefert.

Was haltet Ihr von den neuen Apple-Geräten? Bestellt Ihr Euch etwas vor? Wir sind gespannt auf Eure Kommentare!

Apps & Mobile Entwicklung

Apple iPhone 17: Größeres 120-Hz-Display, härteres Glas und mehr Speicher

Apple hat mit dem iPhone 17 das Display des Basis-iPhones auf Pro-Niveau angehoben und kratzfester gemacht, die Ultraweitwinkelkamera mit einem neuen 48-MP-Sensor ausgestattet, die Akkulaufzeit verbessert und die Ladegeschwindigkeit erhöht. Im Inneren werkeln nun der A19-SoC und Apples N1.

Größeres, flüssigeres und helleres Display

Mit dem iPhone 17 führt Apple erstmals ProMotion auch auf einem Nicht-Pro-Modell ein. Damit unterstützt das iPhone 17 neben der Bildwiederholrate von 120 Hz (vormals 60 Hz) auch das Always-On-Display mit nur einem Hz. Gleichzeitig wächst das Display auf 6,3″ an und erbt damit die Displaydiagonale des iPhone 16 Pro und 17 Pro. Zudem ist der Bildschirm nun wie auch bei den restlichen Modellen heller: Bis zu 3.000 cd/m² anstelle von 2.000 cd/m² sind unter Sonneneinstrahlung nun möglich. Für den alltäglichen Gebrauch bleiben die Angaben mit 1.000 cd/m² im SDR-Modus und bis zu 1.600 cd/m² im HDR-Modus unverändert.

Weniger Reflexionen jetzt auch auf dem iPhone

Auf dem Display sitzt mit Ceramic Shield 2 die zweite Generation von Apples Displayschutz. Dieser soll 3 × kratzfester sein und besser mit Reflexionen umgehen können. Der Konzern spricht von einem verdoppelten Kontrast, wenn das iPhone im Freien genutzt wird.

48 Megapixel für beide Rückkameras

Wie schon beim Vorgänger bekommt das iPhone 17 mit einer Ultraweitwinkel- und einer Hauptkamera gleich zwei Kamerasensoren spendiert. Dieses Jahr wird die Ultraweitwinkelkamera mit einem neuen 48-MP-Sensor ausgestattet, wodurch nun beide Rückkameras hochauflösende Bilder schießen können. Wie üblich wird die 48-MP-Hauptkamera als Telefotokamera mit zweifachem optischen Zoom beworben, auch wenn es sich hierbei eigentlich um einen digitalen handelt. Die Ultraweitwinkelkamera kann auch als Kamera für Makroaufnahmen verwendet werden. Die Videoaufnahme über die Hauptkamera verbleibt bei UHD-60-HDR-Aufnahmen mit Unterstützung für Dolby Vision.

Neue 18-MP-Frontkamera

Überarbeitet hat Apple auch die Frontkamera. Anstelle des bisherigen 12-MP-Sensors verbaut der Konzern jetzt einen neuen 18-MP-Sensor, der per Center Stage automatisch den Bildausschnitt anpasst. Die zusätzlichen Pixel werden dementsprechend für einen automatischen digitalen Zoom genutzt, können aber auch für hochauflösendere Aufnahmen eingesetzt werden. Die neue Kamera unterstützt zudem UHD-HDR-Aufnahmen und kann zusammen mit der Rückkamera Aufnahmen mit beiden Kameras gleichzeitig erstellen.

Schnelleres Laden mit mehr Akkulaufzeit

Das iPhone 17 unterstützt wie auch das neue iPhone 17 Pro schnelleres Laden mit bis zu 40 Watt. In nur 20 Minuten soll das Smartphone damit auf bis zu 50 Prozent aufgeladen sein, anstelle der bisherigen 30 Minuten für dieselbe Zielmarke. Ein passendes Ladegerät von Apple gibt es vorerst nicht in Deutschland zu kaufen, doch USB-C-Netzteile von Drittanbietern werden ebenfalls unterstützt. Weiterhin werden MagSafe bzw. Qi2 mit bis zu 25 Watt als kabelloser Ladestandard unterstützt.

Daneben gibt Apple bei der Akkulaufzeit nun Werte von rund 30 Stunden beim Schauen von Videos an. Beim iPhone 16 waren es noch 22 Stunden. Die vom Konzern angegebene Akkulaufzeit aus Labortests steigt dementsprechend um 37 Prozent.

A19 und N1 treiben iPhone 17 an

Ursächlich für die längere Akkulaufzeit soll laut Apple auch die neue Technik im Inneren sein: Der neue A19-SoC wird in TSMCs aktuellster 3-nm-Fertigung hergestellt und soll damit besonders effizient sein. Während andere Modelle auf den A19 Pro setzen, müssen Nutzer beim iPhone 17 mit einem weniger starken Modell rechnen. Anstelle von sechs GPU-Kernen gibt es nur fünf, die Anzahl der CPU-Kerne verbleibt jedoch bei sechs. Zudem integriert Apple eine neue Display-Engine, um das neue ProMotion-Display besser anzusprechen. Wie sich diese Änderungen konkret auf Benchmarks auswirken, kann nur ein Test aufzeigen, denn der Konzern macht dazu wie gewöhnlich keine Angaben. Im Alltag wirken sich diese Änderungen für gewöhnlich jedoch nicht mehr auf die Leistung aus.

Wie auch im iPhone 17 Pro und iPhone Air setzt Apple zudem erstmals auf einen hauseigenen Chip für Bluetooth und WiFi. Der N1 soll besonders sparsam sein und unterstützt neben Bluetooth 6 auch WiFi 7. Der exklusiv im iPhone Air eingesetzte C1X für Mobilfunk kommt hingegen nicht zum Einsatz.

Mehr Details zu den neuen Chips in den neuen iPhones hat die Redaktion in einem separaten Artikel zusammengefasst.

- A19 (Pro), N1 und C1X: Diese neuen Chips treiben iPhone 17, 17 Pro und Air an

Wie auch schon beim Vorgänger kann das iPhone 17 Daten nur per USB 2.0 übertragen. Ebenfalls wird Apple Intelligence mit allen neuen Funktionen, die für iOS 26 angekündigt sind, unterstützt.

Speicher und Preis

Beim Speicher streicht Apple die 128-GB-Konfiguration, sodass das iPhone 17 nur noch in 256 GB und 512 GB erhältlich ist. Der Preis bleibt hingegen gleich: Das iPhone 17 startet wie das iPhone 16 ab 949 Euro, für 512 GB werden 1.199 an der Ladentheke erwartet.

Neues Zubehör im Apple Store

Zudem bietet Apple wie üblich passende Silikonhüllen, ein durchsichtiges Case sowie eine Körpertrageschlaufe in verschiedenen und passenden Farben an. Die neuen TechWoven-Hüllen sind den Pro-Modellen vorbehalten.

Keine eSim-Pflicht in Deutschland

Die Gerüchte im Vorfeld des Events haben sich unterdessen in einem Punkt nicht (ganz) bewahrheitet: In Deutschland wird es für das iPhone 17 keine Pflicht zur Verwendung einer eSim geben. Hierzulande wird es weiterhin mit einem SIM-Slot ausgeliefert. Es lassen sich jedoch auf Wunsch zwei eSims digital nutzen oder wie gewohnt auf die Kombination aus Nano-SIM und eSim zurückgreifen. Anders jedoch beim iPhone Air, das aufgrund des schmalen Formfaktors alleinig auf eSIM setzt.

Preise und Verfügbarkeit

Das iPhone 17 wird zusammen mit dem iPhone Air und iPhone 17 Pro (Max) ab Freitag in den Farben Schwarz, Lavendel (Lila), Salbei (Grün), Nebelblau und Weiß vorbestellbar sein und dann ab dem 19. September zusammen mit den neuen AirPods Pro 3 ausgeliefert werden. Ein Plus-Modell gibt es nicht mehr.

Apps & Mobile Entwicklung

iPhone 17, iPhone Air und iPhone 17 Pro sind offiziell

Apple hat die neue iPhone-Generation enthüllt – und bringt gleich vier Modelle an den Start: das reguläre iPhone 17, das brandneue iPhone Air, sowie das iPhone 17 Pro in zwei Größen.

iPhone 17: Größeres Display, mehr Pro-Features

Das Standardmodell wächst von 6,1 auf 6,3 Zoll, bleibt dank schmalerer Ränder aber gleich groß in der Hand. Endlich gibt es auch hier 120 Hertz Bildwiederholrate – was in den Jahren zuvor oft als größter Kritikpunkt der regulären iPhones genannt wurde. Dazu kommt erstmals ein Always-On-Display, höhere Helligkeit von bis zu 3.000 Nits (peak) und eine neue Antireflexions-Beschichtung gegen Spiegelungen im Sonnenlicht.

Optisch bleibt alles beim Alten, abgesehen von neuen Farben. Im Inneren arbeitet der A19 Chip, der laut Apple energieeffizienter arbeitet und so für eine längere Akkulaufzeit sorgen soll. Auch das Laden geht nun schneller. Apple verspricht 50 Prozent in rund 20 Minuten. Die Rückkamera erhält nur Detailverbesserungen, dafür ist die Frontkamera komplett neu: ein quadratischer Sensor, der Hoch- und Querformat ermöglicht, ohne das Smartphone zu drehen. Diese Technik ist in Smartphones einmalig und dürfte in den kommenden Jahren viele Nachahmer finden. Die Auflösung beträgt 18 Megapixel und das Sichtfeld wurde für Gruppenfotos vergrößert.

iPhone Air: Dünn wie nie

Mit nur 5,6 Millimetern ist das iPhone Air das dünnste Smartphone der Welt – sogar noch schlanker als Samsungs Galaxy S25 Edge. Dabei soll es laut Apple stabiler sein, als alle vorherigen iPhone-Generationen. Möglich macht das ein Titanrahmen und das neue Ceramic Shield 2 Glas auf Vorder- und Rückseite. Das 6,5-Zoll-Display liegt zwischen iPhone 17 und dem eingestellten Plus-Modell. Auf der Rückseite sitzt nur eine Kamera mit 48 Megapixel Auflösung und 2-fach optischem Zoom per Sensor-Crop.

Im Inneren steckt der A19 Pro Chip, aktuell der schnellste Smartphone-Prozessor auf dem Markt. Um Platz für den Akku zu schaffen, verzichtet Apple weltweit auf einen SIM-Slot – eSIM ist Pflicht. Wie gut die Akkulaufzeit ausfällt, muss unser Test zeigen. Apple verspricht bei der Videowiedergabe einen Wert von bis zu 27 Stunden – das ist mehr als beim iPhone 16 aber etwas weniger als beim neuen iPhone 17.

iPhone 17 Pro: Neues Design, stärkere Kameras

Das Pro-Modell kommt im komplett neuen Unibody-Gehäuse aus Aluminium und nicht mehr mit Titan. Der angehobene Kamerabereich schafft Platz für Antennen und weitere Bauteile, um weiter unten eine größere Batterie einzubauen. Erhältlich ist es mit 6,3 oder 6,9 Zoll Display, jeweils mit A19 Pro Chip und verbessertem Hitzemanagement, um Überhitzung zu vermeiden. Dadurch soll ein weiterer Kritikpunkt aus dem Weg geschafft werden, dass iPhones bisher bei hoher Leistung schnell die Displayhelligkeit drosseln müssen, um eine Überhitzung zu vermeiden. Laut Apple bietet das iPhone 17 Pro ein 40 Prozent besseres Hitzemanagement als sein Vorgänger.

Und auch die Kamera erhält ein großes Upgrade: Erstmals bieten alle drei Sensoren eine 48-Megapixel-Auflösung. Der Hauptsensor ist größer als zuvor und ermöglicht bessere Low-Light-Aufnahmen. Die Telekamera bietet nun 4-fach optischen Zoom und per Sensor-Crop auch 8-fache optisch Vergrößerung. Die selbe Technik nutzt Apple bereits seit einigen Generationen für den 2-fach Zoom mit der Hauptkamera. Digital ist bis zu 40-facher Zoom möglich.

Was kosten die neuen iPhones?

Alle Modelle starten mit 256 GB Speicher, bis zu 2 TB sind möglich. Vorbestellungen laufen ab sofort, die Auslieferung startet ab dem 19. September. Erwartungsgemäß dürfte es hier je nach Modell, Farbe und Apeicher-Ausstattung aufgrund der hohen Nachfrage zu mehrwöchigen Wartezeiten kommen.

-

iPhone 17: ab 949 Euro

-

iPhone Air: ab 1.199 Euro

-

iPhone 17 Pro: ab 1.299 Euro (6,3 Zoll) / 1.449 Euro (6,9 Zoll)

Im Programm bleiben das iPhone 16e (699 Euro) sowie iPhone 16 (849 Euro) und 16 Plus (949 Euro).

-

Datenschutz & Sicherheitvor 3 Monaten

Datenschutz & Sicherheitvor 3 MonatenGeschichten aus dem DSC-Beirat: Einreisebeschränkungen und Zugriffsschranken

-

UX/UI & Webdesignvor 3 Wochen

UX/UI & Webdesignvor 3 WochenDer ultimative Guide für eine unvergessliche Customer Experience

-

Apps & Mobile Entwicklungvor 3 Monaten

Apps & Mobile Entwicklungvor 3 MonatenMetal Gear Solid Δ: Snake Eater: Ein Multiplayer-Modus für Fans von Versteckenspielen

-

UX/UI & Webdesignvor 2 Wochen

UX/UI & Webdesignvor 2 WochenAdobe Firefly Boards › PAGE online

-

Social Mediavor 3 Wochen

Social Mediavor 3 WochenRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

Online Marketing & SEOvor 3 Monaten

Online Marketing & SEOvor 3 MonatenTikTok trackt CO₂ von Ads – und Mitarbeitende intern mit Ratings

-

Entwicklung & Codevor 3 Wochen

Entwicklung & Codevor 3 WochenPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 7 Tagen

Entwicklung & Codevor 7 TagenEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events