Apps & Mobile Entwicklung

Benchmarks Linux vs. Windows 11 auf Radeon & GeForce

Windows ist nach wie vor die mit Abstand größte Gaming-Plattform, Windows-Spiele auf Linux auszuführen funktioniert aber immer besser. Doch wie viel Leistung kostet das? ComputerBase hat sich im Test die Gaming-Performance von Linux auf einer GeForce- und einer Radeon-Grafikkarte angesehen und diese mit Windows 11 verglichen.

Windows-Spiele unter Linux spielen

In den letzten Jahren hat sich Linux immer weiter verbessert, was die Kompatibilität zu Windows-Spielen angeht. Denn dank Projekten wie Wine, DXVK oder VKD3D und deren Bündelung durch Valve und CodeWeavers in Proton für Steam (Linux) laufen die meisten auf Steam verfügbaren Windows-Spiele tatsächlich auch auf Linux problemlos. Wie schnell, klärt dieser Test mit Benchmarks auf einer Radeon RX 9070 XT und einer GeForce RTX 5070 Ti.

Auch Windows-Spiele, die nicht auf Steam erschienen sind, lassen sich über Wine und Co. oder über den Umweg über Steam fit machen – das ist dann allerdings nicht ganz so einfach. Denn bei Steam reicht es aus den Linux-Client zu installieren und ein Windows-Spiel zu starten.

Eine Diskussion über die Erfahrungen und Ergebnisse haben Wolfgang und Jan auch in der aktuellen Episode des ComputerBase-Podcasts CB-Funk geführt:

Anti-Cheat-Mechanismen sind ein Problem

Ein Aspekt, der das Ausführen eines Windows-Spiels unter Linux verhindern kann, ist ein Anti-Cheat-Mechanismus. Das gilt nicht für alle Spiele, denn der Hersteller kann den Schutz kompatibel zu Linux gestalten. Aber oft entscheiden sich Publisher dagegen, weil sie fürchten, ansonsten eine Hintertür zu schaffen. F1 25 von EA, das eigentlich mit getestet werden sollte, läuft beispielsweise nicht. Dasselbe gilt seit 2024 auch für League of Legends.

Die meisten Steam-Spiele laufen hingegen unter Linux. Wie gut welche Spiele laufen, darüber klärt Steam selbst, aber auch die ProtonDB auf. Handfeste Aussagen zur Performance Windows vs. Linux gibt es dort aber nicht.

Dieser Artikel soll die Lücke schließen. Ein aktuelles Linux muss sich beweisen und in 21 Spielen gegen Windows 11 stellen. Die Benchmarks werden dabei mit zwei verschiedenen Grafikkarten-Herstellern, der GeForce RTX 5070 Ti und der Radeon RX 9070 XT durchgeführt, sodass etwaige Unterschiede zwischen einer Nvidia- und einer AMD-Grafikkarte bzw. den Treibern sofort sichtbar werden. Alle Tests werden in den Auflösungen WQHD sowie Ultra HD durchgeführt.

Die Distribution im Test: Arch Linux (EndeavourOS)

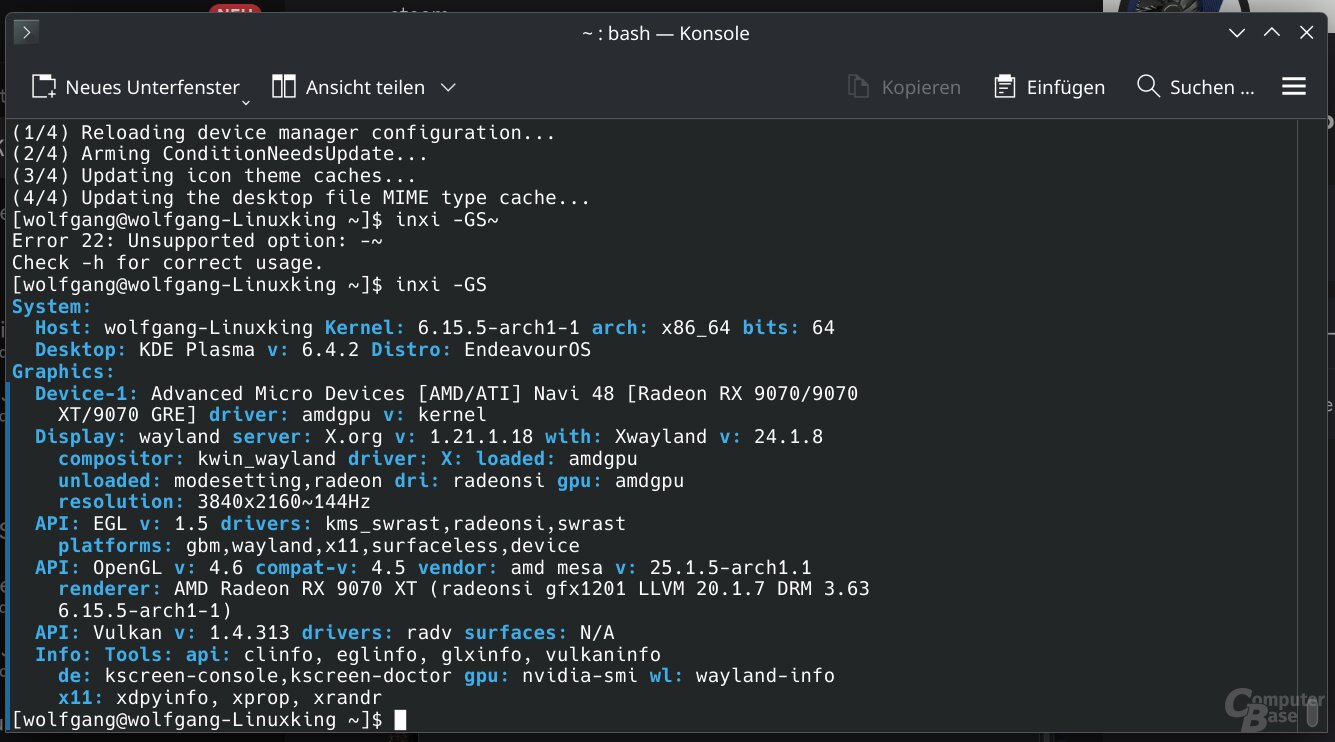

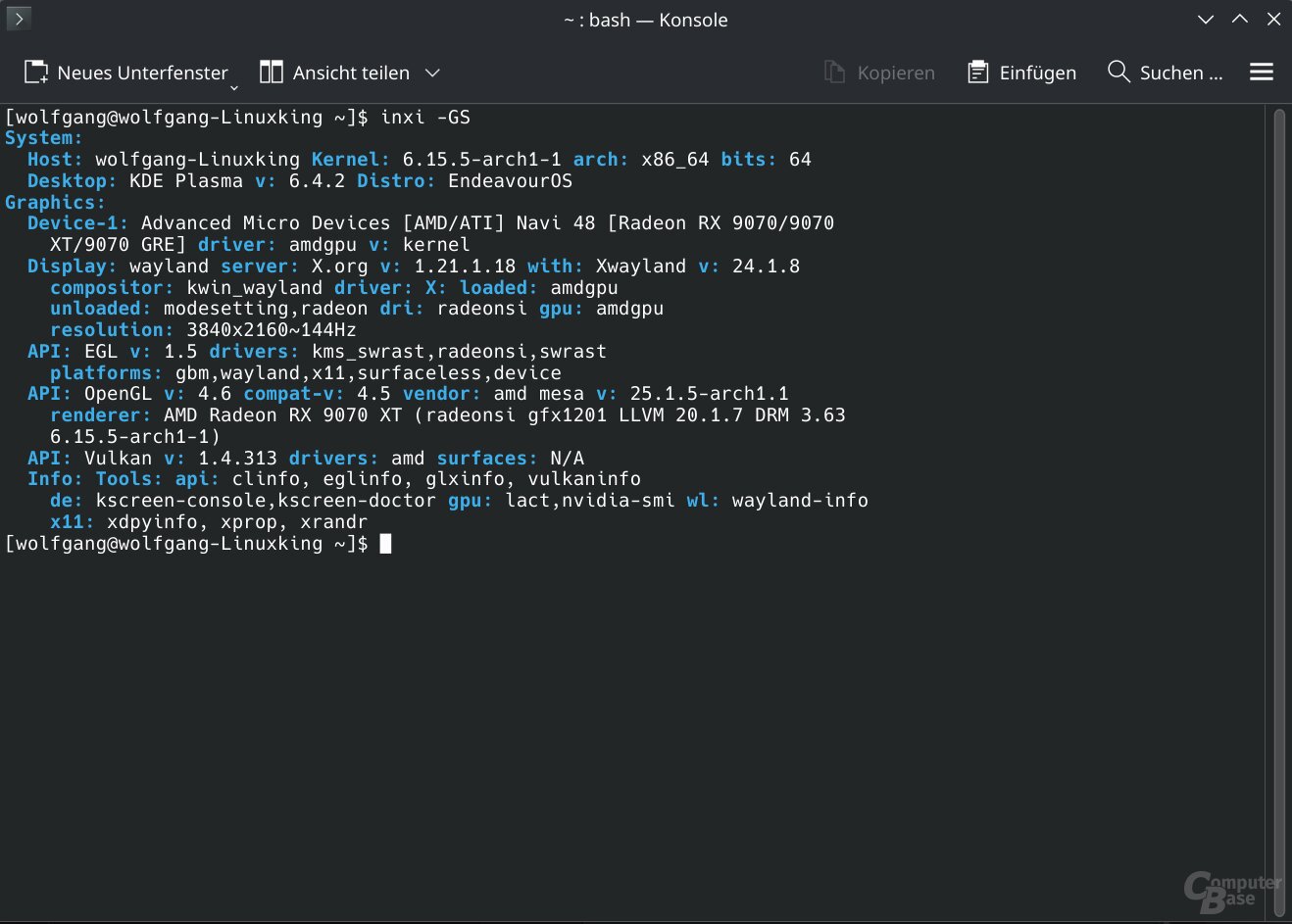

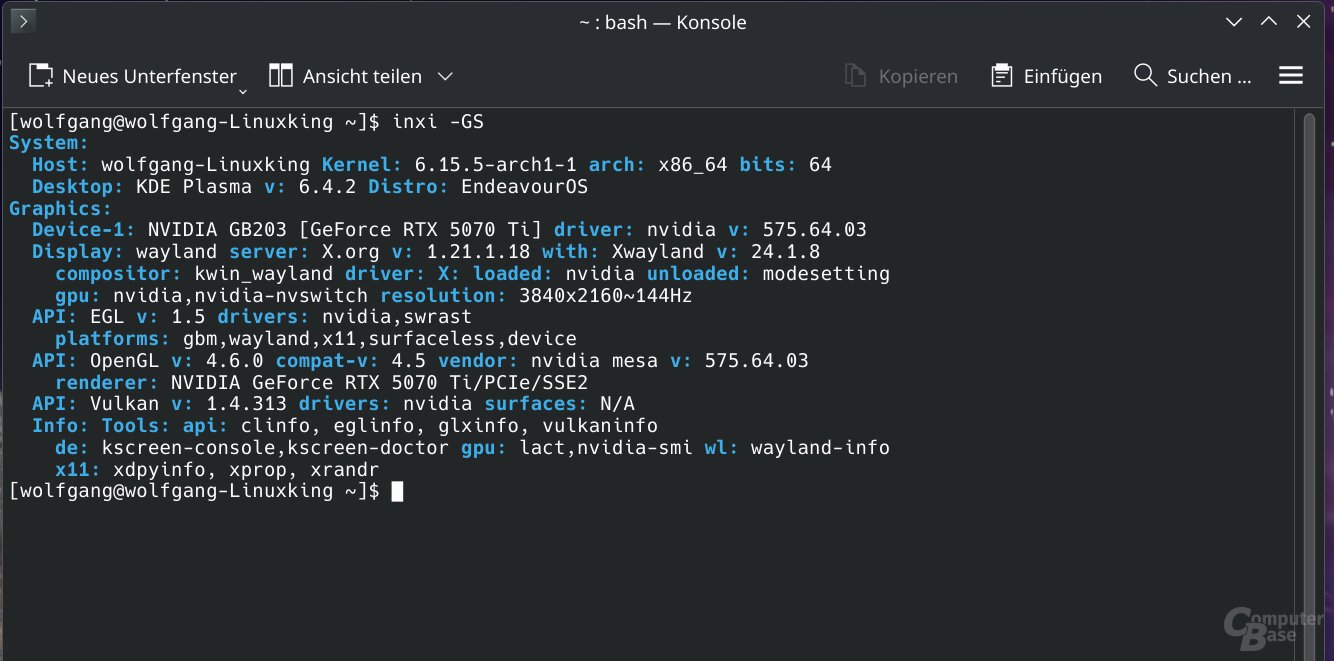

Als Distribution ist die Wahl auf EndeavourOS gefallen, das Arch Linux als Technik-Plattform nutzt und mit dem KDE-Plasma-Desktop als Oberfläche daherkommt. Bei Arch Linux handelt es sich um eine Variante, die auf das Konzept der „maximalen Schlankheit“ setzt, während EndeavourOS das Konzept zwar weiterführt, dem Ganzen aber etwas Komfort beimischt. Der Vorteil des minimalistischen Ansatzes ist, dass die Programmversionen frühzeitig aktualisiert werden und damit immer dem Stand der Dinge entsprechen. Jedoch handelt es sich nicht unbedingt um eine Kombination, die immer selbsterklärend ist, Linux-Anfänger sollten sich lieber nach einer anderen Distribution umsehen. Der Linux-Kernel im Test liegt in der Version 6.15.5-arch1-1 vor.

Die Grafikkarten im Test

Als Grafikkarten kommen die GeForce RTX 5070 Ti und die Radeon RX 9070 XT zum Einsatz. Da unter Linux nicht die von Windows gewohnten Tools und teils auch Treibermenüs zur Verfügung stehen, verzichtet die Redaktion dieses Mal darauf, die eingesetzten Custom-Designs auf das Referenzniveau von Nvidia und AMD herunterzutakten. Denn unter den gegebenen Möglichkeiten ist es nicht gesichert, dass sich Linux und Windows diesbezüglich gleich verhalten.

Entsprechend arbeiten die von Haus aus übertakteten Grafikkarten etwas schneller als gewöhnlich. Im Test wird die MSI GeForce RTX 5070 Ti Ventus 3X OC (Test) sowie die Sapphire Radeon RX 9070 XT Pure (Test) eingesetzt, beide sind geringfügig übertaktet. Mehr als 1 bis 2 Prozent zusätzliche Leistung erbringen diese jedoch nicht. Dennoch hat die Redaktion auch die Windows-Benchmarks entsprechend erneuert, damit die Ergebnisse 1:1 zusammenpassen.

Die Treiber im Test

Bei den Treibern ist es kompliziert: Denn ComputerBase testet die Radeon-Performance mit gleich zwei verschiedenen Treibern – die von verschiedenen Entwicklern kommen. Zum einen handelt es sich um RADV (25.1.5-arch1.1). Dies ist ein „Userspace Treiber“, der nicht von AMD kommt, aber Code von AMD enthält und Teil des Open-Source-Mesa-Pakets ist. Dieser soll erfahrungsgemäß eine bessere Performance aufweisen als der eigentliche AMD-Treiber.

AMD selbst bietet auch einen Treiber an, der in Spielen oft jedoch langsamer sein soll – zumindest in Rasterizer-Titeln. Bei Raytracing wird diesem eine bessere Leistung nachgesagt. Ob dies tatsächlich so ist, wird ComputerBase mit AMDvlk in der Version 2025.Q2.1-1 herausfinden.

Einfacher ist die Situation bei Nvidia, denn einen wirklichen Open-Source-Treiber gibt es (auch nach Jahren anhaltender Kritik der Linux-Community) nicht, die Hauptbestandteile des Treibers stammen nach wie vor komplett von Nvidia selbst. Und damit gibt es im Test auch nur einen Treiber, der auf die Versionsnummer 575.64.03 hört.

Unter Windows kommen die Treiberversionen GeForce 576.88 und Adrenalin 25.6.3 zum Einsatz.

Das Testsystem und die Spiele

Als Rechner dient das Grafikkarten-Testsystem, das unter anderem mit einem AMD Ryzen 7 9800X3D als CPU ausgestattet ist. Das komplette System ist bei den Linux- und den Windows-Benchmarks identisch, einzig die NVMes mit dem Betriebssystem wurden ausgetauscht.

Aus insgesamt 21 Spielen besteht der Testparcours, mit dabei sind aktuelle AAA-Spiele, ältere AAA-Titel, kleinere Spiele sind vertreten und dasselbe gilt auch für einen Multiplayer-Klassiker. Als Auflösungen werden WQHD sowie Ultra HD genutzt, die Grafikdetails sind durchweg maximiert. Neben Rasterizer-Benchmarks wird, wenn vorhanden, auch Raytracing getestet.

Sämtliche Spiele werden, wenn verfügbar, mit Upsampling getestet. Die GeForce RTX 5070 Ti arbeitet mit DLSS 3 SR Quality, wenn im Spiel nativ integriert, kommt alternativ DLSS 4 SR Quality zum Einsatz. Die Radeon RX 9070 XT arbeitet dagegen durchweg mit FSR 3 Quality, was vor allem DLSS 4 Quality qualitativ weit unterlegen ist. Das ebenbürtige FSR 4 steht aktuell unter Linux jedoch nicht zur Verfügung und ist entsprechend keine Alternative. Deshalb ist zu bedenken, dass die Bildqualität auf der Nvidia-Grafikkarte sichtbar besser ist, was für den direkten Linux-Windows-Vergleich aber keine Rolle spielt – schon aber, wenn die GeForce-Leistung direkt mit der der Radeon verglichen wird, das gibt es zu bedenken!

Probleme beim Spielen von Windows-Spielen unter Linux

Die gute Nachricht: Der ohne einen Blick in Kompatibilitätsdatenbanken gewählte Testparcours läuft gut. ComputerBase hat insgesamt 23 Titel ausprobiert, von denen 20 absolut problemlos laufen.

Probleme mit Spielen

Eines zeigt leichte Grafik-Probleme (die laut Community auch unter Windows auftreten können), zwei laufen (zuerst) nicht.

- Überhaupt nicht läuft F1 25. Das liegt an der EA-eigenen Anti-Cheat-Software, die nicht lauffähig unter Linux ist.

- The Alters startete zwar normal, stürzte aber entweder bereits im Hauptmenü, spätestens jedoch nach wenigen Sekunden beim eigentlichen Spielgeschehen ab. ProtonDB nennt das Problem: Im Fenstermodus will es nicht.

Hinzu kommen Grafikfehler auf einer Nvidia-Grafikkarte in Spider-Man 2, dort flimmern die Baumschatten sichtbar. Indiana Jones und der große Kreis arbeitet ebenso nicht fehlerfrei, wobei die Probleme sowohl AMD- als auch Nvidia-Grafikarten betreffen. An sich funktioniert das Spiel zwar normal. Doch manchmal startet das Spiel einfach nicht, stürzt im Hauptmenü ab oder eben im Spiel selbst. Manchmal gibt es aber auch keine Probleme, das ist immer ein wenig eine Überraschungstüte.

Nvidia Reflext geht, AMD Anti-Lag 2 nicht

Alle Grafik-Features, die in einem Spiel integriert sind, funktionieren eigentlich auch unter Linux. Sei es Raytracing, DLSS oder FSR. Was jedoch nicht funktioniert, ist AMD Anti-Lag 2, die Option ist in Spiele ausgegraut und steht nicht zur Verfügung. Das Feature wird vermutlich in einem der kommenden Mesa-Updates Einzug in Linux erhalten. Besser schaut es dagegen bei Nvidia Reflex aus, das in allen Titeln einwandfrei funktioniert.

Der Energiesparmodus will nicht so richtig

Auch der Energiesparmodus verhält sich auf dem Testsetup unter Linux zickig. Auf der Radeon RX 9070 XT will er nur ab und zu funktionieren. Anstatt der gewünschten 10 Watt liegen oft aber auch 20 Watt, teilweise auch 40 bis 50 Watt an, ohne dass auf dem Windows-Desktop irgend etwas passiert. Warum der Idle-Modus so „hibbelig“ ist, ist unklar, doch gibt es so ein Verhalten von Zeit zu Zeit auch unter Windows.

Die GeForce RTX 5070 Ti reagiert etwas gleichmäßiger, benötigt aber ebenso zu viel Energie. Rund 33 Watt meldet die Telemetrie und dies fluktuiert auch nicht großartig. Mal sind es ein paar wenige Watt mehr, mal weniger, größere Unterschiede finden sich aber weder nach oben, noch nach unten.

Keine „Windows-Benchmark-Tools“

Was die klassischen Hardware- sowie Benchmark-Tools angeht, herrscht unter Linux Flaute. Das, was man unter Windows gewohnt ist, funktioniert unter Linux nicht, so zum Beispiel MSI Afterburner oder CapFrameX. Auf einer Radeon fehlt sogar das gesamte Treibermenü. Das hat zur Folge, dass potenziell eine ganze Menge Dritt-Software installiert werden muss.

Das fehlende Treibermenü hat eine weitere schwerwiegende Folge: Dass es aktuell kein FSR 4 unter Linux gibt (denn dafür benötigt es das Treibermenü). FSR-4-Kompatibilität wird derzeit von der Community über Mesa zur Verfügung gestellt – regulär allerdings erst mit dem kommenden Release Mesa 25.2 und somit bisweilen nur mit der nicht finalen Mesa-Git-Version.

Zumindest die der Redaktion bekannten Software-Alternativen bieten weder den Funktionsumfang, noch die Qualität der Windows-Tools. Mit Hilfe von „Linux GPU Control Application“ (LACT) lassen sich die Grafikkarten zum Beispiel ordentlich übertakten und protokollieren, doch ist dies eben nur ein Teil von dem, was die Windows- beziehungsweise Treiber-Tools ermöglichen.

Als Benchmark-Software dient MangoHUD mit Goverlay als grafische Oberfläche, wo sich durchaus einiges einstellen lässt, Funktionen aber auch Bugs aufweisen und nicht funktionieren. Wichtig ist, dass die Zählweise der Frames völlig anders als unter Windows funktioniert und zumindest mit MangoHUD deutlich ungenauer ist.

Denn während die Benchmark-Tools unter Windows zum Beispiel durchweg jeden einzelnen Frame erfassen, macht dies zumindest MangoHUD nicht. Stattdessen wird nur alle x Millisekunden (konfigurierbar) die Informationen abgefragt, was weniger genau ist und auch mehr Hardware-Ressourcen fordert. Das Frame-genaue Protokollieren unter Windows kostet weniger CPU-Zeit als das Protokollieren alle 10 Millisekunden unter Linux, obwohl ersteres genauer ist. Die Performancekosten sind zwar gering, aber auch mit einer schnellen CPU messbar. Das gilt auch für diesen Artikel: Je nach Spiel gehen zwischen 0 bis 2 Prozent an FPS durch die Benchmark-Protokollierung unter Linux verloren.

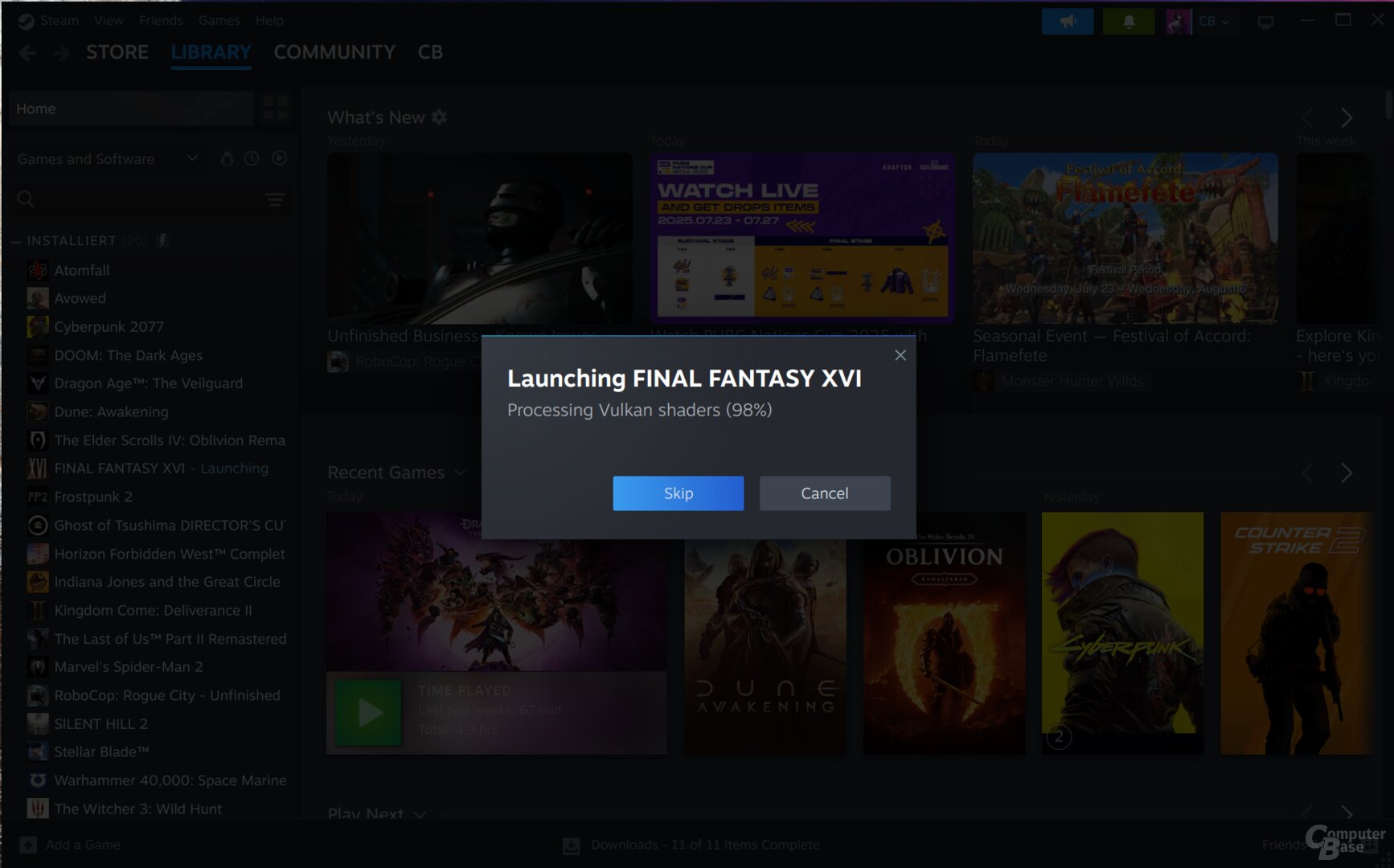

Es werden viele (ganz viele) Shader kompiliert

Shader vorab zu kompilieren, ist in Spielen mittlerweile ganz normal. Auch via Steam für Linux wird dies gemacht, in diesem Fall aber initiiert auch über Proton. Das von Windows bekannte Kompilieren in Spielen fällt dann weg oder kürzer aus, das Prozedere vor dem Start zieht sich aber. Wenn es gut läuft, ist es nach einer Minute erledigt, der Vorgang kann aber auch schonmal 20 Minuten dauern. Man kann in Steam auch auswählen, dass darauf verzichtet wird – laut Community sogar weitestgehend problemlos. Für den Test wurde das aber nicht gemacht, um jedweden Einfluss auf die Benchmarks auszuschließen.

Apps & Mobile Entwicklung

Jetzt 800 Euro Rabatt sichern

Ein Balkonkraftwerk allein kann schon ordentlich dabei helfen, die Stromkosten zu senken. Wirklich genial wird das Ganze aber erst in Kombination mit einem passenden Speicher. Und genau so ein Komplettset, bestehend aus hochwertigen Solarmodulen und der Anker Solix Solarbank 3 Pro, gibt es hier jetzt mit über 800 Euro Rabatt.

Möglich macht den Deal unsere Kooperation mit Kleines Kraftwerk. Der deutsche Händler hat uns nämlich einen exklusiven Deal zukommen lassen, bei dem Ihr tatsächlich über 800 Euro günstiger an die Anker Solix 3 Pro Solarbank samt passenden Solarmodulen kommt. Enthalten sind hier neben der Powerstation vier Module, welche Ihr problemlos auf Eurem Balkon, an Eurer Fassade, in Eurem Garten oder auf Eurem Dach anbringen könnt.

Bis zu 2.250 Watt Leistung dank innovativer Technik

Im Paket enthalten sind vier bifaziale Full-Black Module mit jeweils 450 Watt Leistung, ausgestattet mit modernster TOPCon-Technologie. Das bedeutet, dass sie nicht nur auf der Vorderseite, sondern auch über die Rückseite Sonnenenergie aufnehmen. Im Ergebnis steigert das den Wirkungsgrad um bis zu 30 Prozent gegenüber klassischen Modulen. Statt den rechnerischen 1.800 Watt erreicht Ihr so eine tatsächliche Leistung von bis zu 2.250 Watt.

Das Herzstück ist jedoch die Anker Solix 3 Solarbank: Sie speichert überschüssige Energie, die nicht sofort verbraucht wird, und macht sie Euch abends oder nachts verfügbar. Auf diese Weise nutzt Ihr Eure erzeugte Energie wirklich zu 100 Prozent. Mit einer Kapazität von 2,7 Kilowattstunden holt Ihr das Maximum aus Eurem Balkonkraftwerk heraus. Besonders praktisch: Die Solarbank arbeitet vollautomatisch, erkennt Überschüsse selbstständig und gibt die gespeicherte Energie dann ab, wenn sie gebraucht wird – etwa am Abend nach der Arbeit oder wenn Ihr die Stereoanlage ausreizen möchtet.

Ein weiterer Pluspunkt ist die modulare Bauweise: Die Anker Solix 3 lässt sich später durch zusätzliche Speichereinheiten auf bis zu 16,12 Kilowattstunden erweitern, falls Euer Energiebedarf steigt. Zudem ist die Batterie mit einem intelligenten Batteriemanagementsystem (BMS) ausgestattet, das vor Überladung, Kurzschluss oder Überhitzung schützt und so eine besonders lange Lebensdauer garantiert.

Auch beim Thema Bedienung zeigt sich die Solarbank modern: Über die Anker-App habt Ihr jederzeit Zugriff auf alle wichtigen Daten – von der aktuellen Ladung über den Verbrauch bis hin zu detaillierten Statistiken zur Energieeinsparung. So behaltet Ihr die volle Kontrolle und könnt noch gezielter Strom sparen. Zusätzlich erhaltet Ihr kostenlos den Anker Smart Meter im Wert von 99 Euro. Dieser misst in Echtzeit Euren Stromverbrauch, analysiert Euer Nutzerverhalten und hilft Euch, die Energie optimal einzusetzen. In Kombination mit der Solix 3 könnt Ihr dadurch nicht nur mehr Geld sparen, sondern auch Euren Haushalt noch effizienter gestalten.

Auch die passende Halterung könnt Ihr direkt bei Kleines Kraftwerk erwerben: Statt 369 Euro zahlt Ihr aktuell nur 199 Euro. Gefertigt in Deutschland und statisch geprüft, könnt Ihr Euch auf höchste Sicherheit verlassen.

Balkonkraftwerk mit Speicher: Ganze 800 Euro sparen

Normalerweise kostet das Set „Quattro“ satte 2.159 Euro. Als treue nextpit-Leserinnen und -Leser profitiert Ihr aber von einem Rabatt in Höhe von 800 Euro. Damit bleiben nur noch 1.359 Euro übrig – und das für vier Solarmodule, einen Smart Meter zur Verbrauchsmessung und die leistungsstarke Anker Solarbank Solix 3. Dieses Paket gibt es ausschließlich bei Kleines Kraftwerk. Ein Blick zu anderen Händlern zeigt: Vergleichbare Sets mit Speicher liegen dort schnell bei rund 2.000 Euro. Ihr bekommt hier also ein echtes Schnäppchen.

Für 1.359 Euro erhaltet Ihr alles, was Ihr für Euren Einstieg in die eigene Stromproduktion benötigt. Wenn Ihr schon länger mit dem Gedanken spielt, Euch ein Balkonkraftwerk zuzulegen, dann ist jetzt der perfekte Moment gekommen.

Was haltet Ihr von dem Angebot? Lasst es uns in den Kommentaren wissen!

Dieser Artikel ist Teil einer Kooperation zwischen nextpit und Kleines Kraftwerk. Auf die redaktionelle Meinung von nextpit hat diese Zusammenarbeit keinen Einfluss.

Apps & Mobile Entwicklung

Bundesweiter Warntag 2025: Morgen um 11 Uhr steht wieder der Probealarm an

Morgen um 11 Uhr findet erneut der bundesweite Warntag des Bundesamts für Bevölkerungsschutz und Katastrophenhilfe (BBK) statt. Es werden Probewarnungen via Cell Broadcast und Warn-App NINA an mobile Endgeräte gesendet. Auch andere Kanäle wie Rundfunk und Sirenen werden mit einbezogen, auch die Kommunen testen ihre Systeme.

Cell Broadcast wird warnen, aber nicht entwarnen

Um 11 Uhr wird über das Modulare Warnsystem des Bundes (MoWaS) eine Probewarnung in Form eines Texts an die sogenannten Warnmultiplikatoren in Form von Mobilfunkdiensten, App-Servern und Rundfunkanstalten geschickt, welche diese entsprechend an Endgeräte weiterleiten oder ausstrahlen. Insbesondere Cell Broadcast soll alle unterstützten Mobilgeräte innerhalb einer Funkzelle erreichen und damit potenziell die größte Reichweite in der Bevölkerung haben. Unterstützt werden praktisch alle Geräte der letzten Jahre, das BBK hält außerdem eine Übersicht von Smartphone-Modellen bereit.

Der Bundesweite Warntag ist unser Stresstest unter Volllast: Wir prüfen die gesamte Übermittlungskette von der Auslösung bis zum Endgerät. Entscheidend ist dabei die enge Zusammenarbeit von Bund, Ländern, Kommunen und Warnmultiplikatoren – und das Zusammenspiel der unterschiedlichen Warnkanäle, die Millionen Menschen gleichzeitig erreichen.

BBK-Vizepräsident Dr. René Funk

Um 11:45 Uhr soll eine Entwarnung erfolgen – allerdings nicht über Cell Broadcast. Wie schon in den Vorjahren lässt das BBK verlauten, dass die Möglichkeit, auch über diesen Kanal Entwarnungen bekanntzugeben, von den Betreibern der Mobilfunknetze geprüft werde. Alle anderen Kanäle sollen die Entwarnung allerdings an die Bevölkerung weiterleiten.

Rückmeldung aus der Bevölkerung erwünscht

Das Bundesamt für Bevölkerungsschutz und Katastrophenhilfe bittet außerdem um Rückmeldung, sollte das Warnsystem für manche Bürger nicht funktionieren. Das Feedback sei wichtig, um mögliche Fehlerquellen zu finden und Verbesserungen vorzunehmen.

Eine effektive Warnung geht über technische Funktionalitäten hinaus. Damit Warnung ankommt und verstanden wird, brauchen wir die Bevölkerung an unserer Seite: Ihre Rückmeldungen nach dem Warntag sind für uns ein zentraler Bestandteil der Auswertung. Nur wenn Bürgerinnen und Bürger ihre eigenen Erfahrungen mit den verschiedenen Warnmitteln einbringen, können wir das System gezielt weiterentwickeln und für den Ernstfall noch verständlicher und verlässlicher machen. Der Warntag ist deshalb ein gemeinsamer Aktionstag – von Staat und Gesellschaft.

BBK-Präsident Ralph Tiesler

Dafür wird morgen um 11 Uhr eine Online-Umfrage des BKK starten, über das Erfahrungen mit den verschiedenen Warnkanälen gemeldet werden können. Die Teilnahme wird bis zum 18. September möglich sein, die Ergebnisse fließen in die Weiterentwicklung des Warnsystems ein.

Apps & Mobile Entwicklung

Alles zum iPhone-Event und allen neuen Produkten

Wenn Apple ein iPhone-Event plant, lohnen sich vorab zwei Dinge: Genau hinzusehen, was Apple präsentiert – und sich einen Experten wie Timo in den Podcast zu holen, der souverän einordnen kann, was da genau rund ums iPhone Air zu sehen war. Habe ich beides getan, also reden wir heute übers Apple-Event und über jede Menge Hardware!

Ja, „Hardware“ ist auch irgendwie direkt das Stichwort. Mir fiel nämlich auf, dass Apple in den vergangenen Jahren viel über Services, Plattformen, Software und nicht zuletzt Apple Intelligence geredet hat und immer weniger über Hardware. Der iPhone-Launch am 09. September war hingegen vollgepackt mit Hardware: 1 x AirPods, 3 x Apple Watch und 4 x iPhone, davon eine ganz neue iPhone-Klasse mit dem iPhone Air!

Wird das iPhone Air Apples erhoffter Verkaufs-Hit?

Falls Ihr Euch weniger für das lediglich 5,6 mm dünne und als dünnstes Smartphone der Welt titulierte iPhone Air interessiert: Kein Problem, denn wir haben uns wirklich zu allen neuen Apple-Produkten ausgelassen. Aber klar, übers iPhone Air war natürlich etwas mehr zu sagen. Ganz ehrlich? Ich hab auch direkt ein paar Kritikpunkte bei diesem Modell entdeckt, aber findet am besten beim Hören der neuen Folge heraus, was mich da stört.

Als Experten hatte ich erfreulicherweise Timo zu Gast, der gerade erst frisch von der IFA kam und sich mit mir jetzt direkt in den Apple-Trubel stürzte. Er ist auch schon in freudiger Erwartung der Apple-Testgeräte. Stellt Euch also darauf ein, dass es hier bald Testberichte regnen wird.

In unserer wirklich lang geratenen, aber hoffentlich dennoch kurzweiligen Folge haben wir – wie ich finde – ein faires Urteil übers Apple-Event gefällt. Zudem hat mir die Folge riesig Spaß bereitet und ja, natürlich hoffe ich, dass es Euch beim Zuhören ebenso ergeht.

Wenn dem so ist: Teilt unseren Podcast gerne, empfehlt uns weiter, bewertet uns da, wo immer man Podcasts bewerten kann, und hinterlasst uns auch gerne Kommentare. Viel Vergnügen mit der 165. Ausgabe der Casa Casi!

Show Notes 166:

-

Datenschutz & Sicherheitvor 3 Monaten

Datenschutz & Sicherheitvor 3 MonatenGeschichten aus dem DSC-Beirat: Einreisebeschränkungen und Zugriffsschranken

-

UX/UI & Webdesignvor 3 Wochen

UX/UI & Webdesignvor 3 WochenDer ultimative Guide für eine unvergessliche Customer Experience

-

Apps & Mobile Entwicklungvor 3 Monaten

Apps & Mobile Entwicklungvor 3 MonatenMetal Gear Solid Δ: Snake Eater: Ein Multiplayer-Modus für Fans von Versteckenspielen

-

Social Mediavor 3 Wochen

Social Mediavor 3 WochenRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

UX/UI & Webdesignvor 2 Wochen

UX/UI & Webdesignvor 2 WochenAdobe Firefly Boards › PAGE online

-

Online Marketing & SEOvor 3 Monaten

Online Marketing & SEOvor 3 MonatenTikTok trackt CO₂ von Ads – und Mitarbeitende intern mit Ratings

-

Entwicklung & Codevor 1 Woche

Entwicklung & Codevor 1 WocheEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

Entwicklung & Codevor 3 Wochen

Entwicklung & Codevor 3 WochenPosit stellt Positron vor: Neue IDE für Data Science mit Python und R