Apps & Mobile Entwicklung

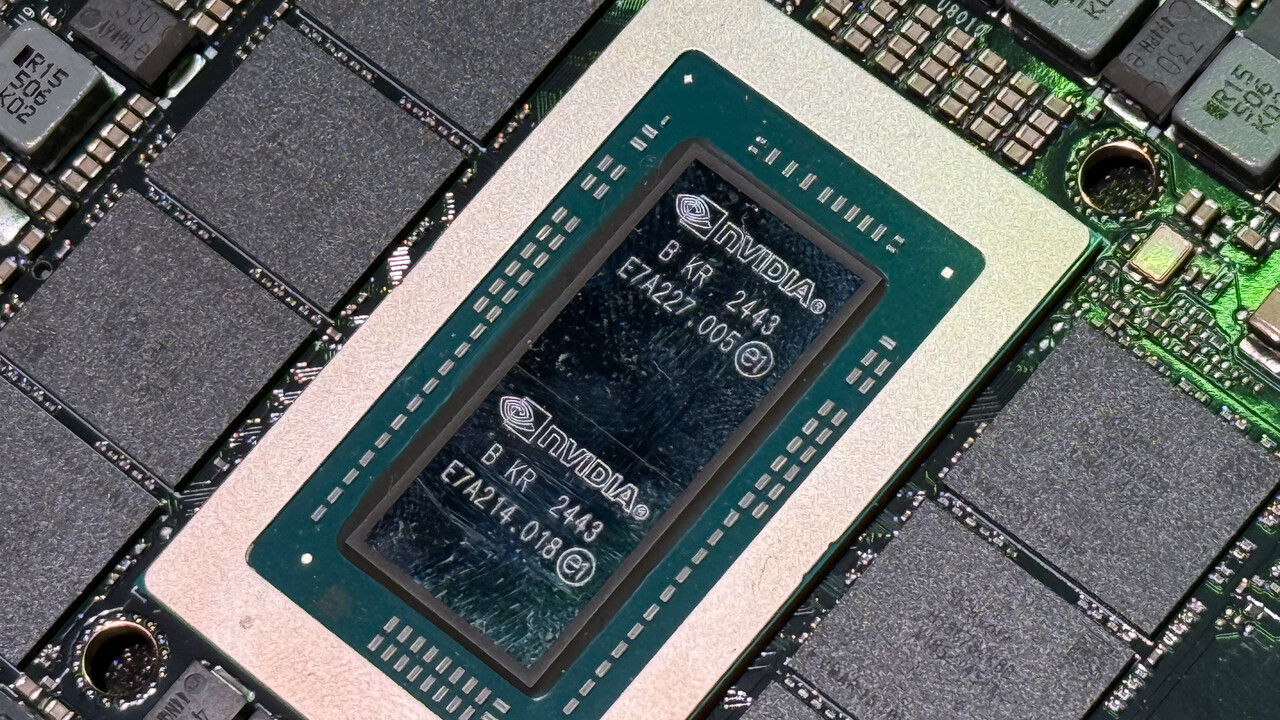

Nvidia N1x: GPU des PC-Chips scheint der RTX 5070 zu entsprechen

Nvidias N1x-Chip, der in Zusammenarbeit mit MediaTek entwickelt wird, soll der Gerüchteküche zur Folge auf Probleme bei der Entwicklung gestoßen sein, hat sich mittlerweile jedoch schon einmal im Geekbench gezeigt. Das lässt auf die vermutliche Gaming-Leistung schließen.

So meldet der Geekbench beim Nvidia N1x „48 Compute Units“. Compute Unit entspricht zwar AMDs Namensschema, Nvidia verwendet dafür die Bezeichnung „Streaming Multiprocessors“, kurz SM, doch steht beides letztlich für dasselbe: einen Block, der verschiedene Ausführungseinheiten enthält. Falls der N1x-SoC gleich aufgebaut ist wie Nvidias Desktop-Grafikkarten – wie anzunehmen ist – lässt sich daraus schließen, dass der Chip über 6.144 Shadereinheiten verfügen wird. Das entspricht der Anzahl einer GeForce RTX 5070 (Test).

Genauso viele Shadereinheiten wie die RTX 5070

Denn pro Streaming Multiprocessor verbaut Nvidia bei der Blackwell-Architektur sowie auch bei mehreren vorherigen Designs 128 FP32-ALUs. 48 SMs × 128 ALUs ergeben 6.144 Shader, genauso viele wie die GeForce RTX 5070. Das bedeutet zwar nicht, dass der Nvidia N1x über dieselbe GPU-Leistung wie die GeForce RTX 5070 verfügen wird, denn dies hängt ebenso vom Takt, der Speicherbandbreite und letztlich der TDP ab. Die Grafikkerne sind aber auf jeden Fall ähnlich aufgebaut.

Apropos Takt: Der Geekbench-Eintrag nennt 1.048 MHz für den Nvidia N1x, das finale Produkt wird aber mit Sicherheit deutlich höher takten. Entweder handelt es sich um einen Auslesefehler, was immer mal wieder passiert, oder schlicht um einen Prototypen, der noch mit stark verringertem Takt arbeitet. Darüber hinaus nennt der Eintrag zwei CPU-Cluster mit jeweils 10 ARM-CPU-Kernen, insgesamt also 20, die mit einem Basis-Takt von 4,0 GHz arbeiten, und noch einen 128 GB großen Speicher, 60 GB sind der Grafikeinheit zugeordnet.

Nvidia N1x und GB10 scheinen identisch konfiguriert zu sein

Damit entspricht der Nvidia N1x offenbar dem GB10-Superchip, zumindest was die Konfiguration von CPU sowie GPU betrifft. Inwieweit der Chip physikalisch aber identisch ist oder ob es sich doch um zwei verschiedene, aber sehr ähnlich konfigurierte SoCs handelt, ist noch unklar.

Was es natürlich ebenso noch gibt, ist einen Geekbench-Score, der letztendlich aber nichts aussagt. Allein deswegen, da der Benchmark ohnehin merkwürdige Ergebnisse erzeugt und weil Prototypen-Hardware teils deutlich langsamer als das finale Produkt läuft. Das lassen auch die Ergebnisse des Nvidia N1x vermuten, denn mit einem Open-CL-Score von 46361 Punkten wäre der SoC langsamer als eine GeForce RTX 2060.

Apps & Mobile Entwicklung

Darum halluziniert ChatGPT – und wird nie ganz damit aufhören

Nicht nur ChatGPT halluziniert, das steht mal fest. Vielmehr sind wir es von allen KI-Plattformen gewohnt, dass sie uns da gelegentlich glatte Lügen auftischen. OpenAI hat sich dazu jetzt erklärt und verrät uns, wieso das so ist. Was OpenAI ebenfalls sagt: Das mit dem Halluzinieren werden wir vermutlich niemals so ganz los!

Warum Sprachmodelle halluzinieren

„Why language models hallucinate“ heißt ein Beitrag auf dem OpenAI-Blog. Dort lässt sich das Unternehmen in die Karten blicken und erklärt genau das – also wie es dazu kommt, dass Sprachmodelle wie Gemini, Grok oder eben auch ChatGPT halluzinieren. Wer nicht im Thema ist: Mit „Halluzinieren“ ist gemeint, dass das Sprachmodell die richtige Antwort nicht kennt und nicht nennt, sondern sich stattdessen sehr souverän eine alternative, aber faktisch leider komplett falsche Antwort ausdenkt.

Tatsächlich ist die Antwort auf die Frage, wieso die LLMs (Large Language Models) halluzinieren, sogar erschreckend einfach: Weil sie es so beigebracht bekommen! Beim Training werden die LLMs so geschult, dass sie eben lieber eine beliebige Antwort geben, als stumpf den Mund zu halten.

OpenAI betont, dass Halluzinationen kein bloßer Bug sind – sondern eine systemische Folge von Sprachmodellen, die auf Wahrscheinlichkeiten trainiert und bewertet werden. Weil sie dafür optimiert sind, möglichst präzise Antworten zu geben, werden diese präzisen Antworten – selbst wenn sie falsch sind – belohnt. Das ist in der Konsequenz für ein so trainiertes Modell die deutlich richtigere Antwort als ein „Ich weiß es nicht“.

Ein Beispiel, wieso Halluzinieren für eine KI richtig ist

Stellt Euch eine Klassenarbeit vor, für die Ihr nicht gelernt habt. Ihr sollt bei einer Aufgabe etwas ins Feld schreiben, habt aber keinen blassen Schimmer, wie die Antwort lautet. Schreibt Ihr nichts hinein, sind es null Punkte für die Aufgabe. Schreibt Ihr stattdessen irgendetwas hinein, was Euch schlüssig erscheint, habt Ihr zwei Chancen:

- Entweder ist das Geschriebene einfach zufällig richtig, dann gibt es die volle Punktzahl.

- Oder Ihr ratet falsch, habt aber vielleicht einen Teilaspekt richtig, der immerhin mit einer geringeren Punktzahl geahndet wird.

Im allerschlimmsten Fall schreibt Ihr kompletten Quatsch, aber auch das wäre nicht schlimmer, als das Feld leer zu lassen. Genau so arbeitet auch eine KI: Sie wägt Wahrscheinlichkeiten ab und sagt lieber etwas theoretisch Mögliches als zu erklären, dass sie absolut keine Ahnung hat.

Eine Mitschuld tragen also auch die Benchmark-Tests, für die KI-Modelle ebenfalls optimiert werden, und die ähnlich funktionieren wie in dem genannten Beispiel. Somit werden die LLMs durch diese falschen Anreize zum Raten verleitet, was dann zu den Halluzinationen führt.

Und was kann man gegen das Halluzinieren unternehmen?

Die Wissenschaftler:innen, die an dieser Studie beteiligt waren, sind sich einig, dass man das Halluzinieren nie zu 100 Prozent verhindern kann. Aber zumindest gibt es Ideen, wie man das Risiko minimieren kann. Dazu müssten beim Training lediglich falsche Antworten auch tatsächlich negativ bewertet werden. Nicht beantwortete Fragen sollen hingegen auch Teilpunkte erhalten können.

Bei OpenAI heißt es dazu: „Es gibt eine einfache Lösung: Bestrafen Sie selbstbewusste Fehler stärker als Unsicherheit und vergeben Sie Teilpunkte für angemessene Begründungen dieser Unsicherheit“. So soll das blinde Raten verhindert werden, indem man die KI eben auch dafür belohnt, wenn sie lieber keine als eine falsche Antwort äußert. Dazu braucht es aber auch ganz neue Tests und Testmethoden – und bis die etabliert sind, wird sicher noch Zeit vergehen.

Was bedeutet das für uns? Dass wir weiterhin haargenau aufpassen müssen, was uns ChatGPT oder ein anderes KI-Modell vorsetzt. Das ist übrigens generell eine gute Idee, bevor man sich blind den Antworten ausliefert, die eine KI oder wer auch immer einem auftischt.

Apps & Mobile Entwicklung

Samsung One UI 8: Beta 2 für das Galaxy Z Fold 5 und Flip 5 veröffentlicht

Samsung hat die zweite Beta-Version der Benutzeroberfläche One UI 8 auf Basis von Android 16 für das Galaxy Z Fold 5 und das Galaxy Z Flip 5 (Test) veröffentlicht. Die Aktualisierung enthält ausschließlich Korrekturen und bringt keine neuen Funktionen mit sich, soll aber verschiedene Probleme der ersten Beta-Version beheben.

Das Update mit der Versionsnummer ZYI6 soll den Release Notes nach unter anderem einen schwerwiegenden Fehler beseitigen, bei dem sich das Smartphone während der Nutzung zurücksetzte. Zudem sollen die DeX-Einstellungen nun erhalten bleiben, wenn von einer früheren OS-Version auf One UI 8 aktualisiert wird. Auch die Wetteranzeige auf der Galaxy Watch 7 soll sich nach dem Update wieder in Echtzeit aktualisieren. Darüber hinaus sollen sich Multi-Fenster beim Einsatz des KakaoTalk-Chats nicht mehr schließen, wenn parallel die Kamera genutzt wird.

Derzeit wird das Update in Südkorea verteilt, weitere Regionen dürften erfahrungsgemäß in Kürze folgen. Nutzer können die zweite Beta-Version über die Softwareaktualisierung in den Einstellungen anstoßen.

Apps & Mobile Entwicklung

Core i5-110: Intel verpasst 5 Jahre altem i5-10400 einen neuen Namen

Intel hat eine neue CPU ins Programm aufgenommen, deren Bezeichnung mit allen aktuellen Konventionen bricht – und deren Basis bereits seit fünf Jahren auf dem Markt ist: den Core i5-110. Er entspricht 1:1 dem Intel Core i5-10400, trägt sogar dieselbe Device ID (0x9BC8) wie dessen native 6-Kern-Die-Variante (G1-Stepping).

Aus Core i5-10400 wird Core i5-110

Zur Erinnerung: Den Intel Core i5-10400(F) (Test) gab es im Jahr 2020 sowohl mit einem nativen 6-Kern-Die (G1-Stepping, 0x9BC8) als auch als Cutdown des größeren 10-Kern-Chips (Q0-Stepping, 0x9BC5). Für den neuen Core i5-110 nutzt Intel den kleinen Die.

Nun ist der Verkauf einer älteren CPU unter neuem Namen keine Seltenheit in der Branche. Wie alt die Basis schon ist und welchen Namen sie in Zukunft trägt, ist aber schon bemerkenswert. Denn „Core i“ war eigentlich tot.

Intel lässt das „i“ stehen

Selbst Prozessoren, die ursprünglich noch als Core-i-Prozessor auf den Markt gekommen waren, hatte Intel zuletzt in die neue Nomenklatur (Core Ultra/Core) überführt: Raptor Lake-U und Raptor Lake-H (13 und 14. Gen Core i) firmieren inzwischen als Core 100 oder Core 200 unterhalb der neuen Architekturen in den Serien Core Ultra 100 und Core Ultra 200.

Mit dem Core i5-110 steckt Intel jetzt eine Comet-Lake-CPU (14 nm) für Desktop-PCs (LGA 1200) in die „Intel® Core™ processors (Series 1)“, die bisher nur CPUs für Mobile- und Embedded-Workloads bot – und lässt das „i“ im Namen stehen. Die Übersicht zur Serie führt diesen Prozessor dann allerdings auch gar nicht.

-

Datenschutz & Sicherheitvor 3 Monaten

Datenschutz & Sicherheitvor 3 MonatenGeschichten aus dem DSC-Beirat: Einreisebeschränkungen und Zugriffsschranken

-

UX/UI & Webdesignvor 4 Wochen

UX/UI & Webdesignvor 4 WochenDer ultimative Guide für eine unvergessliche Customer Experience

-

Apps & Mobile Entwicklungvor 3 Monaten

Apps & Mobile Entwicklungvor 3 MonatenMetal Gear Solid Δ: Snake Eater: Ein Multiplayer-Modus für Fans von Versteckenspielen

-

Social Mediavor 4 Wochen

Social Mediavor 4 WochenRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

UX/UI & Webdesignvor 2 Wochen

UX/UI & Webdesignvor 2 WochenAdobe Firefly Boards › PAGE online

-

Entwicklung & Codevor 1 Woche

Entwicklung & Codevor 1 WocheEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

Entwicklung & Codevor 3 Wochen

Entwicklung & Codevor 3 WochenPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Digital Business & Startupsvor 2 Monaten

Digital Business & Startupsvor 2 Monaten10.000 Euro Tickets? Kann man machen – aber nur mit diesem Trick