Künstliche Intelligenz

Deutschland-Stack: So soll die nationale souveräne Technologieplattform aussehen

Das Bundesdigitalministerium macht Dampf bei dem von Ressortchef Karsten Wildberger (CDU) angekündigten Deutschland-Stack. Es hat eine Übersicht zur Struktur der vorgesehenen nationalen souveränen Technologie-Plattform für die hiesigen Digitalvorhaben der öffentlichen Hand, eine erste „Landkarte“ zu Technologien und Standards des Schichtenmodells und eine zugehörige Übersicht bereits erreichter Schritte („Reifegrad“) ausgearbeitet und veröffentlicht. Der „D-Stack“ soll generell eine tragende Rolle bei der laufenden Verwaltungsmodernisierung mit digitalen Mitteln übernehmen.

„Mit dem Deutschland-Stack schaffen wir eine offene, sichere und skalierbare IT-Infrastruktur, die föderale Zusammenarbeit erleichtert, Innovationen beschleunigt und nutzerorientierte Lösungen ermöglicht“, erläutert Digitalstaatssekretär Markus Richter. Die Plattform werde Basiskomponenten wie Cloud- und IT-Dienste bereitstellen, die von Bund, Ländern und Kommunen genutzt werden könnten. Zugleich lud Richter „alle Interessierten ein, ihren Beitrag zur Entwicklung der technischen Standards zu leisten“.

Das Digitalministerium führt dazu bis Ende November eine erste Konsultation durch, um Anregungen vor allem aus der IT- und Digitalwirtschaft sowie technischen Experten in den Tech-Stack einfließen zu lassen. Darunter fasst das Ressort alle „relevanten Standards und Technologien zur Realisierung des Deutschland-Stacks“.

Koalitionsvertrag weist die Richtung

Das Beteiligungsverfahren sollen themenspezifische Workshops ergänzen, die auch auf die Bereiche Startups, mittelständische Unternehmen, Fachdienstleister und Wissenschaft ausgerichtet sind. Wissen will das Ministerium etwa, welche Anforderungen an potenzielle neue Dienste und Geschäftsmodelle bestehen und welche Innovationen im Stack enthalten sein sollten, „um die digitale Transformation erfolgreich umzusetzen“.

Der D-Stack umfasst laut dem Ressort die technologische Grundlage der vorgesehenen Plattform, die strategischen und organisatorischen Rahmenbedingungen sowie konkrete Umsetzungsvorhaben und Produkte. Ziel sei es, das Modell gemeinsam zu gestalten, um die Wirtschaft zu stärken, die staatliche Handlungsfähigkeit zu erhöhen und das Vertrauen in den Staat zu festigen. Die Arbeit soll schrittweise erfolgen: Bis 2028 werden dem Plan nach konkrete Angebote für die öffentliche Verwaltung erarbeitet.

Durch den Einsatz von Technologien sollen Potenziale gehoben werden, um die Digitalisierung ziel- und wirkungsorientiert zu beschleunigen, heißt es weiter. Die Definition des Tech-Stacks orientiere sich am Koalitionsvertrag, in dem Schwarz-Rot auch auf digitale Souveränität abstellt. Ein besonderer Fokus liegt auf vertrauenswürdigen, souveränen, interoperablen und europäisch anschlussfähigen Technologien und Standards.

Vom Rechenzentrum bis zur App

Die interaktive Landkarte für Standards und Technologien hat das Datenlabor des Bundesinnenministeriums entwickelt. Sie basiert methodisch auf Vorgaben der Cloud Native Foundation und nutzt als Basis den in OpenCode definierten Tech-Stack. Die Übersicht visualisiert die Inhalte und bietet Steckbriefe zu den einzelnen Komponenten. Enthalten sind etwa Basisinfos, Download-Optionen und Verweise auf die Code-Plattform GitHub.

Ein zentrales Element ist die Konformitätsbewertung. Sie beurteilt, wie gut ein Standard oder eine Technologie die Ziele des Deutschland-Stacks erfüllt. Diese Bewertung ist in sechs Kategorien unterteilt und führt zu unterschiedlichen Stufen. Die Landkarte bildet noch nicht alle verfügbaren Technologien ab, sondern soll nach einem festen Schema ausgebaut werden.

Parallel klärt die Bundesregierung über „Schichten und Gruppen“ des Tech-Stacks auf. Dieser ist demnach in sechs ineinandergreifende Ebenen strukturiert, was an Vorarbeiten einer Denkfabrik erinnert. Das Fundament bildet die Infrastruktur mit Gebäuden, Rechenzentren und Netzen. Darauf bauen die Prozesse für Entwicklung, Sicherheit und Betrieb auf, die eine automatisierte, agile und sichere Softwareentwicklung sowie einen stabilen Betrieb erlauben sollen – inklusive Überwachung, Virtualisierung und Speicherung.

Die zentrale Ebene ist die Plattform, das technische Rückgrat des übergreifenden Government-as-a-Platform-Ansatzes (GaaP). Diese soll die Skalierung digitaler Lösungen zulassen. Dieses Portal beinhaltet essenzielle Bereiche wie Daten (Speicherung, Analyse), Integration (Schnittstellen/APIs) sowie den Einsatz von Künstlicher Intelligenz (KI).

Auf der Plattform sollen die Basisdienste aufsetzen – standardisierte, wiederverwendbare zentrale Services für grundlegende Funktionen wie Identität, Bezahlen oder Signatur. Diese Dienste wiederum dienen den Programmen und Services, die den eigentlichen Kern der fachlichen Wertschöpfung und Aufgabenerfüllung darstellen. Dabei handelt es sich etwa um Fachanwendungen oder Verwaltungsleistungen. Die Ebene Oberfläche und Zugang bildet schließlich die direkten Schnittstellen für die Nutzer ab, etwa über Browser, Apps und Portale.

(mho)

Künstliche Intelligenz

Trump: Netflix-Stärke könnte Problem bei Warner-Deal sein

Laut US-Präsident Donald Trump könnte der hohe Marktanteil von Netflix im Streaming-Geschäft ein Problem bei den Übernahmeplänen für das Hollywood-Studio Warner Bros. sein. Er verwies auf die anstehende Wettbewerbsprüfung und sagte, er werde auch in die Entscheidung involviert sein.

Weiterlesen nach der Anzeige

Netflix will das Studio- und Streaming-Geschäft von Warner Bros. in einem gut 82 Milliarden Dollar schweren Deal kaufen. Die Unternehmen zeigten sich überzeugt, dass die Transaktion einer Prüfung durch Wettbewerbshüter standhalten wird. Zugleich planen sie bis zu eineinhalb Jahre für den Abschluss der Übernahme ein und Netflix verpflichtete sich, Warner eine Vertragsstrafe von 5,8 Milliarden Dollar zu zahlen, falls sie an den Kartellwächtern scheitern sollte.

Rivale Paramount hat Nähe zu Trump

Unterlegener Bieter ist der Hollywood-Rivale Paramount, der erst vor wenigen Monaten von der Familie des als Trump-Unterstützer bekannten Software-Milliardärs Larry Ellison übernommen wurde. Medienberichten zufolge ging Paramount angesichts der guten Beziehungen zum Weißen Haus zuvor davon aus, sich durchsetzen zu können.

Lesen Sie auch

Paramount wollte – anders als Netflix – den gesamten heutigen Konzern Warner Bros. Discovery kaufen, zu dem auch Fernsehsender wie CNN gehören. Der Nachrichtensender, der oft kritisch über Trump berichtet, ist dem Präsidenten ein Dorn im Auge. In den USA wurde vielfach spekuliert, das Weiße Haus könne deshalb an einem Erfolg der Ellison-Familie interessiert sein. Beim Paramount-Sender CBS gab es nach dem Kauf Änderungen in der Nachrichtenredaktion.

Netflix-Manager bei Trump

Weiterlesen nach der Anzeige

Der Finanzdienst Bloomberg berichtete zuvor, Netflix-Co-Chef Ted Sarandos habe Trump Mitte November besucht, um über die Übernahmepläne zu sprechen. Dabei seien sie sich einig gewesen, dass der Meistbietende gewinnen solle, hieß es unter Berufung auf informierte Personen. Trump sagte, Sarandos sei vergangene Woche bei ihm im Oval Office gewesen.

(afl)

Künstliche Intelligenz

Millionenstrafe gegen X: Musk fordert Abschaffung der EU, Account wird gesperrt

Kurz nachdem die EU-Kommission gegen X eine Strafe von 120 Millionen Euro verhängt hat, hat der Kurznachrichtendienst ihr die Möglichkeit genommen, dort Werbung zu schalten und zu analysieren. Das hat Produktchef Nikita Bier publik gemacht und behauptet, die Brüsseler Behörde habe einen Exploit in dem Werkzeug zur Schaltung von Werbung ausgenutzt, um „die Reichweite künstlich zu erhöhen“. Es habe den Anschein, als gehe man bei der EU davon aus, dass die Regeln nicht für ihren Account gelten sollten: „Euer Werbekonto wurde gekündigt.“ Die Kommission hat inzwischen aber versichert, schon seit Jahren nicht mehr für Werbung auf X zu bezahlen. Man nutze lediglich die zur Verfügung gestellten Werkzeuge, zitiert Gizmodo einen Sprecher.

Weiterlesen nach der Anzeige

Harsche Worte aus den USA

Die Sperrung erfolgte am Wochenende, nachdem EU-Kommissionsvizepräsidentin Henna Virkkunen am Freitag die Strafe gegen X öffentlich gemacht hat. Begründet wurde das mit Verstößen gegen den Digital Services Act (DSA) und der Täuschung mit blauen Haken, der Verschleierung von Informationen über Anzeigen und dem Ausschluss von Forschern sowie Forscherinnen. Obwohl die Strafe vergleichsweise moderat ausgefallen ist – spekuliert wurde vorab über bis zu einer Milliarde US-Dollar –, ist sie auf massive Kritik nicht nur von der Plattform selbst gefallen. Elon Musk, dem X gehört, hat darauf zuerst nur mit einem „Bullshit“ reagiert. Dabei hat er es aber nicht belassen.

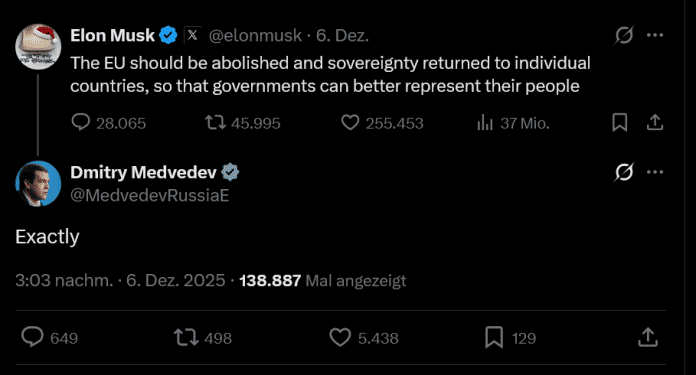

Stunden nach der Bekanntmachung aus Brüssel hat der reichste Mann der Welt dann auf seinem Kurznachrichtendienst gefordert, dass die EU abgeschafft „und Souveränität zu den einzelnen Staaten zurückübertragen“ werden soll. Zustimmung dazu gab es unmittelbar vom ehemaligen russischen Präsidenten und Putin-Vertrauten Dmitri Medwedew. Harsche Kritik kam außerdem von US-Außenminister Marco Rubio, der die Strafe als „Angriff auf die amerikanischen Menschen“ bezeichnet hat. Sein Parteikollege, Senator Ted Cruz, hat deshalb sogar Sanktionen gegen die EU gefordert, „bis diese Farce rückgängig gemacht wurde“.

Was genau zur Sperrung des Werbeaccounts der EU-Kommission auf X geführt hat, bleibt derweil unklar. Augenscheinlich geht es um ebenjenen Beitrag, in dem die EU-Kommission die Strafe dort publik gemacht hat. An den ist ein Video angehängt, das automatisch abgespielt wird, wenn man ihn öffnet. Klickt man darauf, wird die Wiedergabe aber nicht – wie erwartet – gestoppt, stattdessen wird man auf die Internetseite der EU-Kommission weitergeleitet, und zwar direkt zur Bekanntmachung der Strafe. Dabei handelt es sich wohl um den angeblichen Verstoß, laut Bier wurde die Möglichkeit, das so einzustellen, inzwischen entfernt. Gegenüber Gizmodo hat die EU-Kommission versichert, soziale Netzwerke immer „in gutem Glauben“ zu benutzen.

(mho)

Künstliche Intelligenz

Montag: Tschernobyl-Schaden durch Drohne, Taiwan gegen chinesische Lifestyle-App

Im Februar beschädigte ein russischer Angriff die Hülle des Unglücksreaktors von Tschernobyl. Die Tragweite des Schadens ist enorm, wie sich jetzt zeigt. Denn die äußere Hülle hat ihre primären Sicherheitsfunktionen verloren, einschließlich der Eindämmungsfähigkeit von Radioaktivität. Immerhin haben sich die Strahlungswerte bislang nicht geändert. In Taiwan bringen Behörden die in dem Land beliebte RedNote-App aus China mit über 1700 Betrugsfällen in Verbindung. Jetzt ist das „chinesische Instagram“ dort geblockt. Denn die RedNote-Betreiber haben auf keine Anfragen Taiwans reagiert und halten sich im Gegensatz zu Meta Platforms oder TikTok nicht an taiwanische Vorschriften, etwa zum Datenschutz. Derweil hat Intels Ex-CEO Pat Gelsinger genauer erklärt, wie durch EUV-Lichtquellen außerhalb von Chipfabriken Halbleiter feinere Strukturen bekommen sollen. Gelsinger gehört zu einer Gruppe von Investoren in xLight. Das US-Startup will die Chipproduktion vereinfachen und verfeinern, indem Belichtungsmaschinen nicht mehr mit eigenen Lichtquellen ausgestattet sein müssen – die wichtigsten Meldungen im kurzen Überblick.

Weiterlesen nach der Anzeige

Die Schutzhülle über dem Unglücksreaktor von Tschernobyl hat ihre wesentliche Sicherheitsfunktionalität verloren. Zu diesem Schluss kam jetzt eine Delegation der Internationalen Atomenergie-Organisation, welche den Ort des Reaktorunglücks von 1986 im ukrainischen Tschernobyl inspizierte. Fertiggestellt worden war die Hülle erst 2016, um die Radioaktivität des havarierten Reaktors einzudämmen. Entstanden sind die Schäden bei einem russischen Drohnenangriff im Februar 2025, bei dem eine Drohne das Bauwerk traf und durch die äußere Schutzwand drang. Teile des Fluggeräts schlugen auch durch die innere Wand, neun Meter unterhalb. Der Vorfall verursachte einen Großbrand, welcher ebenfalls die Außenhülle der massiven Stahlkonstruktion beschädigte: Der neue Sarkophag in Tschernobyl ist nicht mehr sicher.

Taiwan hat die in dem Land sehr beliebte chinesische App RedNote für vorläufig ein Jahr gesperrt. Die Behörden werfen den Betreibern der Lifestyle-App vor, zu wenig gegen Betrugsversuche zu unternehmen, nachdem seit Anfang letzten Jahres bislang 1706 Betrugsfälle in Taiwan gezählt wurden, die auf RedNote zurückgeführt werden. Zudem haben die chinesischen RedNote-Betreiber auf keine Anfragen reagiert und auch keine der geforderten Maßnahmen zum Datenschutz der Nutzer und zur Betrugsprävention umgesetzt. Im Gegensatz zu anderen sozialen Netzwerken wie Facebook, Instagram oder TikTok haben die chinesischen RedNote-Betreiber auch keine Vertretungen im Ausland und können dadurch kaum in Rechenschaft gezogen werden: Taiwan sperrt populäre chinesische Lifestyle-App RedNote nach Betrugsvorwürfen.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier eine externe Umfrage (Opinary GmbH) geladen.

Seit Pat Gelsinger vor einem Jahr bei Intel unfreiwillig in den Ruhestand geschickt wurde, arbeitet er bei dem Investmentunternehmen Playground Global. Eines der Anlageobjekte: Das US-Startup xLight. Der Name deutet schon an, worum es dabei geht: Externes Licht für Chipfabriken. Die grundlegende Idee ist, die Lichtquelle für Belichtungsmaschinen in der Halbleiterherstellung nicht mehr in jedes der Geräte einzubauen, wie das der Lithografie-Marktführer ASML macht. Laut Gelsinger sollen die riesigen xLight-Maschinen außerhalb der Reinraum-Gebäude von üblichen Chipfabriken stehen. Die Lichtquellen sollen rund 100 mal 50 Meter groß sein, in etwa so viel wie ein kleineres Fußballfeld: Pat Gelsinger will mit neuen Lasern Moore’s Law retten.

Das Bild war eine Sensation: Fast sechs Tage lang hatte das Hubble Space Telescope aus der Milchstraße in einen Bereich des Sternenhimmels außerhalb der Milchstraße gespäht. Von der Erde aus betrachtet, galt dieser Himmelsbereich als leer. Genauso interessant wie das Foto selbst und die wissenschaftlichen Erkenntnisse daraus ist allerdings seine Entstehungsgeschichte. Hier war weniger die Wissenschaft als vielmehr mangelndes Qualitätsmanagement in einem US-Raumfahrtunternehmen sowie die US-Finanzpolitik in Person eines späteren Friedensnobelpreisträgers involviert. Und diese Geschichte ist mindestens so spannend wie die wissenschaftlichen Entdeckungen, die später aus dem Foto folgten, erklärt Missing Link: Hubble Deep Field – ein Foto und seine Geschichte.

(Bild: ESA/Hubble)

Am Wochenende gelangten zwei interne Memos an die Öffentlichkeit, die Metas Hardware-Fahrplan betreffen. Seit letztem Jahr kursieren Gerüchte, dass Meta an einer neuen Art von Mixed-Reality-Brille arbeitet, die Prozessor und Batterie in einen kabelgebundenen Taschencomputer auslagert und so einen besonders kompakten und leichten Formfaktor ermöglicht. Ein Techmagazin berichtete 2024 über einen Prototyp, der etwa 100 Gramm wiegen soll. Laut Wall Street Journal vom vergangenen Sommer war ein entsprechendes Produkt für 2026 geplant, mit einem Zielpreis von unter 1000 US-Dollar. Doch laut jetzt durchgesickerten Memos wurde das Gerät auf die erste Hälfte des Jahres 2027 verschoben. Die zusätzliche Zeit soll dem Team mehr Luft verschaffen, um Details auszuarbeiten: Internes Memo verspricht „großes Upgrade“ mit Meta Quest 4.

Weiterlesen nach der Anzeige

Auch noch wichtig:

- Die Strompreise liegen heute weit über der Einspeisevergütung für Solarstrom. Eine Studie belegt, wie schnell der Eigenverbrauch deutscher Erzeuger steigt: Immer größerer Solarstromanteil erreicht das öffentliche Netz nicht.

- Der Ausfall eines großen Webhosters seit über zwei Wochen bringt vielen Unternehmen und Privatpersonen Hektik, Stress und Verdienstausfall: Schweizer Webhoster „Webland“ seit zwei Wochen fast vollständig offline.

- Mit der Migration von Microsoft zu freier Software zahlt Schleswig-Holstein gut 15 Millionen Euro Lizenzkosten weniger. Die Umrüstung kommt deutlich günstiger nach Microsofts Adieu: Schleswig-Holstein setzt auf Open Source und spart Millionen.

- Angesichts der demografischen Entwicklung sollten wir begrüßen, wenn KI künftig Jobs ersetzt, statt sie dabei zu bremsen, findet unser Autor Bertram Sändig: KI nimmt uns die Jobs weg – wenn wir Glück haben.

- Zwar aktualisiert der iPhone-Hersteller iOS, iPadOS, macOS und Co. auch immer in älteren Versionen. Doch das deckt nicht alle Fehler ab. Warum, das erklärt unser Kommentar: Apple betreibt bei Updates Scheinsicherheit.

- Mit neuer Bildqualität, aber sonst in Originalfassung, soll Star Wars von 1977 zum Jubiläum die Kinosäle füllen. Umstrittene Anpassungen verschwinden wieder: Nach 50 Jahren kommt Star Wars wieder im Originalschnitt ins Kino.

- In der Nacht zum Freitag hat Microsoft mit der automatischen Verteilung des Windows-11-25H2-Updates auf 24H2-Maschinen begonnen: Weitere automatische Update-Verteilung auf Windows 11 25H2.

- Bei längeren Flugverspätungen lassen sich Entschädigungen auch mithilfe von Internet-Portalen durchsetzen. Betreiber müssen aber auf ihre Werbeaussagen achten: Gericht weist Fluggastportal wegen Aussagen über Ryanair in die Schranken.

- Vielen Wünschen der Community, wie dem Privatsphäre-Schalter, konnte entsprochen werden. Der Kopfhörer-Anschluss hingegen hat es nicht geschafft: Jolla startet Vorverkauf von neuem Sailfish-Phone.

- Evelyn Palla will eine „lückenlose Aufklärung“ der Probleme bei Stuttgarts neuem Hauptbahnhof einleiten – auch bei der Software: Palla kündigt Untersuchung zu Stuttgart-21-Verzögerungen an.

- Im Oberrheingraben sollen Geothermie-Anlagen Tiefenwasser fördern und daraus zugleich Lithium gewinnen. Das Geld für ein Milliardenprojekt steht bereit: Projekt Lionheart soll mit Tiefenwärme auch deutsches Lithium fördern.

(fds)

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenIllustrierte Reise nach New York City › PAGE online

-

Datenschutz & Sicherheitvor 3 Monaten

Datenschutz & Sicherheitvor 3 MonatenJetzt patchen! Erneut Attacken auf SonicWall-Firewalls beobachtet

-

Künstliche Intelligenzvor 2 Monaten

Künstliche Intelligenzvor 2 MonatenAus Softwarefehlern lernen – Teil 3: Eine Marssonde gerät außer Kontrolle

-

Künstliche Intelligenzvor 2 Monaten

Top 10: Die beste kabellose Überwachungskamera im Test

-

UX/UI & Webdesignvor 3 Monaten

UX/UI & Webdesignvor 3 MonatenFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenSK Rapid Wien erneuert visuelle Identität

-

Entwicklung & Codevor 3 Wochen

Entwicklung & Codevor 3 WochenKommandozeile adé: Praktische, grafische Git-Verwaltung für den Mac

-

Social Mediavor 3 Monaten

Social Mediavor 3 MonatenSchluss mit FOMO im Social Media Marketing – Welche Trends und Features sind für Social Media Manager*innen wirklich relevant?