Apps & Mobile Entwicklung

Sparsame Festplatten: Western Digital will Stromverbrauch um 20 Prozent senken

Western Digital will Festplatten nicht nur größer und schneller machen, sondern plant auch spezielle Modelle, die weniger Strom verbrauchen. Eine um bis zu 20 Prozent reduzierte Leistungsaufnahme wird versprochen. Dabei nimmt die Leistung allerdings etwas ab. Daher wird der Einsatz für eher „kalte“ Daten erwogen.

Der Hersteller spricht bisher lediglich von „energieoptimierten HDDs“ im gewohnten 3,5-Zoll-Format, nennt aber noch keine konkreten Modelle oder technische Details. So bleibt vorerst auch offen, auf welche Weise die Energie eingespart werden soll. Eine einfache Lösung wäre eine reduzierte Drehzahl bei den Magnetscheiben, die heute meist mit 7.200 U/min rotieren. Modelle mit 5.400 U/min sind aus der Mode gekommen, könnten aber ein Comeback feiern. Allerdings nimmt mit einer geringeren Drehzahl auch die Geschwindigkeit der Dateizugriffe sowie der Durchsatz ab.

Laut Western Digital sollen die energieoptimierten HDDs eine nur um 5 bis 10 Prozent geringere Leistung als herkömmliche HDDs besitzen. An anderer Stelle ist von einer minimal geringeren I/O-Leistung bei zufälligen Zugriffen die Rede – die IOPS sinken also leicht. Ein Zugriff soll noch „unter einer Sekunde“ erfolgen, was aber eher nach deutlichen Einbußen klingt. Üblich bei HDDs sind Zugriffszeiten im niedrigen zweistelligen Millisekundenbereich.

KI-Training und Inferenz erzeugen große Mengen an wertvollen „kalten“ Daten, die dennoch innerhalb kürzester Zeit zugänglich sein müssen. Damit sind sie zu aktiv für Bandlaufwerke, aber zu teuer für herkömmliche Kapazitätslaufwerke. WDs energieoptimierte HDDs bieten hierfür eine speziell entwickelte Lösung, die den Stromverbrauch und damit die Betriebskosten reduziert, während der Zugriff weiterhin unter einer Sekunde erfolgt – und das im selben 3,5-Zoll-Formfaktor.

Diese HDDs setzen auf höhere Kapazität und deutlich niedrigeren Stromverbrauch zulasten von minimal zufälligen Ein-/Ausgaben – eine für kalte Daten ideale Designentscheidung – und verringern die Lücke zwischen Warm- und Kalt-Speicher. Damit wird die wirtschaftlich nachhaltige Speicherung großer KI-Datenmengen ermöglicht. Voraussichtlich ab 2027 gehen die energieoptimierten HDDs in die Kundenqualifikation.

Western Digital

Die Energiespar-Festplatten sollen im Jahr 2027 die Phase der Qualifizierung bei Geschäftskunden erreichen.

Angekündigt wurde diese Neuheit auf dem gestrigen Investor Day 2026 von Western Digital. Dort wurde auch eine neue Roadmap mit den ersten HAMR-Festplatten des Herstellers sowie neuen auf höhere Leistung getrimmten Modellen präsentiert. Mehr dazu im nachfolgend verlinkten Bericht:

- Western Digital: Neue Roadmap, HAMR-Debüt und 14 Platter für 140 TB

Apps & Mobile Entwicklung

Western Digital (WD): Zwei neue Techniken für HDDs mit 1,2 GB/s

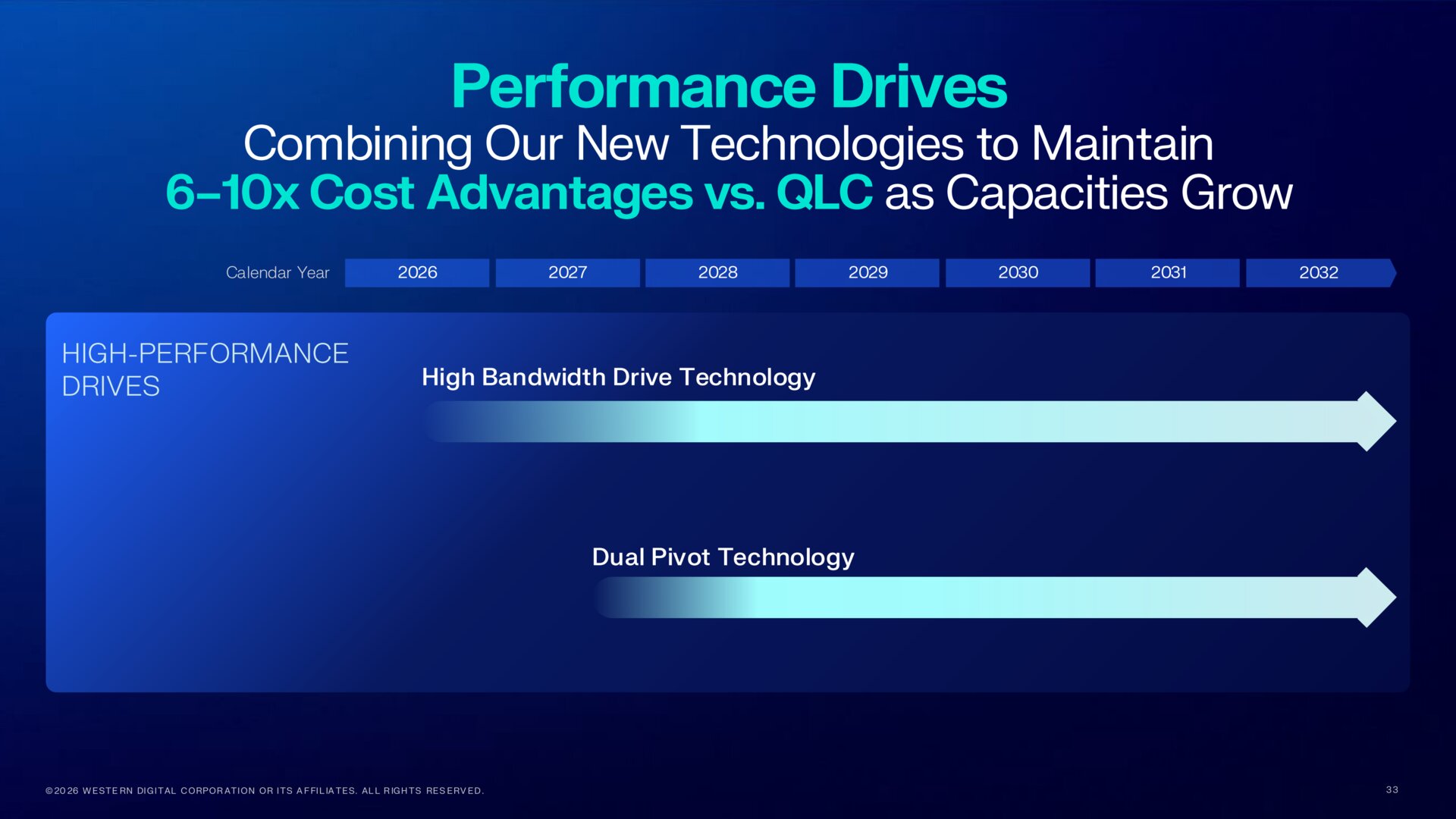

Während Festplatten immer mehr Terabyte speichern können, stagniert die Leistung nahezu oder nimmt pro Terabyte sogar ab. Das will Western Digital (WD) bald ändern. Durch die Kombination von „High Bandwidth Drive“ und „Dual Pivot“ soll sich der Durchsatz von 300 MB/s auf 1,2 GB/s vervierfachen.

High Bandwidth Drive Technology (HBDT)

Die erste neue Technik nennt WD High Bandwidth Drive Technology (HBDT). Das Prinzip klingt zunächst einfach: Statt wie bisher nur auf eine Datenspur (Track) der Magnetscheiben zuzugreifen, sollen künftig zwei davon gleichzeitig gelesen und geschrieben werden. Dadurch wird der Durchsatz verdoppelt, wie der Hersteller mit einem Vorserienmodell demonstriert hat. Während die herkömmliche HDD etwa 274 MB/s erreicht, sind es bei dem HBDT-Modell 554 MB/s, womit bereits am Limit der SATA-Schnittstelle gekratzt wird.

Für die Zukunft wird erwogen, sogar bis zu acht Tracks simultan zu nutzen, wodurch die Leistung noch höher ausfallen würde.

Im Unternehmensblog und in Videos wird die im Rahmen des Investor Day vorgestellte Technik genauer beschrieben. Der Schlüssel dahinter ist der sogenannte Triple-Stage-Actuator, mit dem die Lese/Schreib-Köpfe der Festplatten präziser als zuvor über den rotierenden Magnetscheiben platziert werden können. Bildlich gesprochen stellen die drei Aktoren nun einen Arm mit Schulter (Actuator), Ellenbogen (Milli-Actuator) und Handgelenk dar. Letzteres ist der besonders fein arbeitende Micro-Actuator, der auch den weiteren Weg der ePMR-Festplatten ebnen soll.

Die Spuren können damit präziser und schneller angesteuert werden, erklärt WD. Dies ermögliche nun „die gleichzeitige, genaue Positionierung der Köpfe über mehrere Spuren“ hinweg. Allerdings müssen diese „paarweise“ direkt nebeneinander liegen. Der Durchsatz skaliere mit der Anzahl der aktiven Köpfe und Spuren. Während sich die sequenziellen Transferraten bei zwei Spuren verdoppeln, seien die Zugewinne bei wahlfreien Zugriffen sehr variabel, was allein daran liegt, dass Daten eben nicht immer auf nebeneinander liegenden Spuren platziert sind. Im schlechtesten Fall gebe es dann bei kleinen Dateien gar keine Leistungssteigerung und im besten Fall das bis zu 1,7-Fache bei größeren Dateien.

Dual Pivot Technology (DPT)

Mit Dual Pivot (übersetzt doppelter Drehpunkt) greift WD den Ansatz der Dual-Actuator-Technik auf, die zuerst Seagate und später auch WD zwischenzeitlich eingeführt hatten. Es kommen also zwei „Arme“ mit Köpfen zum Einsatz, wodurch die Leistung erhöht werden kann. Doch da diese bisher übereinander gestapelt waren, musste aus Platzgründen auf Magnetscheiben verzichtet werden. Daher nahm die Speicherkapazität ab. Dies sei der Hauptgrund dafür, dass diese Technik bisher erfolglos geblieben sei. Es habe sich wirtschaftlich schlicht nicht rentiert, argumentiert WD.

Beim neuen Ansatz Dual Pivot sitzen die beiden Aktoren nicht übereinander, sondern gegenüberliegend auf gleicher Ebene neben den Scheiben. Die zusätzlichen Kosten für den zweiten Aktor bleiben zwar bestehen, doch können wieder mehr Scheiben eingesetzt werden, da vertikal genügend Platz vorhanden ist. Wenn die Köpfe an einem Aktor nur die Oberseite der Scheiben ansteuern, während der andere die Unterseite übernimmt, ließe sich zudem der Abstand zwischen den Scheiben weiter verringern, um noch mehr von diesen unterzubringen. Das wird als Beispiel angeführt, könnte aber den beschriebenen Weg zu 14 Plattern in einem 3,5″-Gehäuse ebnen, den WD einschlagen will.

Die unabhängig voneinander agierenden Aktoren sorgen für höheren Durchsatz und mehr IOPS.

Kombiniert für vierfachen Durchsatz

Die eingangs erwähnte Steigerung der Datentransferrate von bisher maximal 300 MB/s auf 1.200 MB/s oder 1,2 GB/s soll durch eine Kombination aus HBDT mit zwei Spuren und der Dual-Pivot-Technik erreicht werden. Damit soll sichergestellt werden, dass kommende HDDs der 100-TB-Klasse beim Durchsatz pro Terabyte das gleiche Niveau wie derzeitige 26-TB-HDDs erreichen.

Für die ferne Zukunft ist Achtspur-HBDT mit Dual Pivot angedacht, was 4,8 GB/s ermöglichen würde, so die Prognose von WD. Dann könnten solche HDDs sogar mit mancher SSD beim Durchsatz mithalten. Die erheblich geringeren Zugriffszeiten beim NAND-Flash-Speicher wären damit aber nicht zu erreichen.

Apps & Mobile Entwicklung

Samsung streicht Updates für diese Smartphones

Samsung hat den Software-Support für seine beliebte Flaggschiff-Serie offiziell eingestellt, sodass Millionen von Geräten ohne wichtige Sicherheits-Patches dastehen. Warum eure Daten gefährdet sein könnten, wenn ihr ein solches Gerät benutzt, und was ihr als Nächstes tun solltet, erfahrt ihr hier.

Samsung ist nach wie vor der einzige Android-Hersteller, der mit Googles umfangreichem Software-Engagement für seine Flaggschiffe mithalten kann und bis zu sieben Jahre lang Updates für das Android-Betriebssystem verspricht. Dieses Versprechen gilt jedoch erst ab dem Galaxy S24 und den Nachfolgemodellen, sodass frühere Generationen einen viel kürzeren Zeitrahmen haben. Das gilt auch für die Galaxy S21-Serie, die im vergangenen Jahr offiziell ihr letztes großes Update bekommen hat.

Keine Android-Updates mehr für das Galaxy S21

Samsung veröffentlichte One UI 7, basierend auf Android 15, für das Galaxy S21, S21+ und S21 Ultra im letzten Jahr als letztes großes Betriebssystem-Upgrade. Gleichzeitig wurde die Serie von monatlichen Sicherheitspatches auf einen vierteljährlichen Zeitplan umgestellt. Insgesamt signalisierten diese Schritte, dass diese Geräte in die Endphase des offiziellen Supports eintreten würden.

Dieses Ende ist nun gekommen, denn Samsung hat das Galaxy S21-Trio von seiner Liste der unterstützten Geräte entfernt (via SamMobile). Damit erhalten diese Smartphones keine routinemäßigen Sicherheitsupdates mehr. Damit ist der letzte vierteljährliche Patch, der Ende 2025 veröffentlicht wird, der letzte reguläre Software-Support, den diese Geräte jemals erhalten werden.

Das Galaxy S21 FE ist die einzige Variante in der Reihe, die noch am „Lebenserhaltungssystem“ hängt, auch wenn es jetzt ebenfalls auf eine vierteljährliche Routine umgestellt wurde. Da das S21 FE-Modell später auf den Markt kam als das Standard-S21-Trio, hat es Anspruch auf ein paar verbleibende Monate planmäßiger Wartung.

Angreifer können veraltete Android-Geräte ins Visier nehmen

Während die Hardware des Galaxy S21 relativ leistungsfähig bleibt, bringt der fehlende Software-Support Nutzer in eine prekäre Lage, da Sicherheitslücken ungepatcht bleiben.

Ein nicht unterstütztes Gerät dient als offene Tür für Angreifer, um Schlupflöcher für schädliche Zwecke wie Daten- und Finanzdiebstahl auszunutzen. Angesichts der Tatsache, dass Samsung Millionen von Geräten dieser Serie verkauft hat, ist die Zahl der potenziell betroffenen Nutzer nach wie vor hoch.

Samsung gibt jedoch gelegentlich Notfall-Patches für nicht mehr unterstützte Geräte heraus, wenn kritische, schwerwiegende Sicherheitslücken auftreten. Auch Google kann weiterhin Aktualisierungen von Apps und Komponenten über das Google-Play-System bereitstellen, allerdings haben diese Aktualisierungen oft eine geringere Priorität als bei Modellen mit aktuellen Android-Versionen.

Diejenigen, die noch ein Galaxy S21 oder auch ein Galaxy S22 besitzen, welches ebenfalls bereits auf einen vierteljährlichen Zeitplan umgestellt wurde, sollten nicht auf „Gnaden“-Updates von Samsung oder Google warten. Stattdessen sollten Nutzer ein Upgrade auf das kommende Galaxy S26 in Erwägung ziehen oder die aktuellen Rabatte auf die Galaxy S25 (Test) Generation nutzen.

Welches Samsung-Handy besitzt ihr derzeit? Bekommt ihr noch regelmäßig Software- oder Sicherheitsupdates? Wir würden uns freuen, Eure Meinung in den Kommentaren unten zu hören.

Apps & Mobile Entwicklung

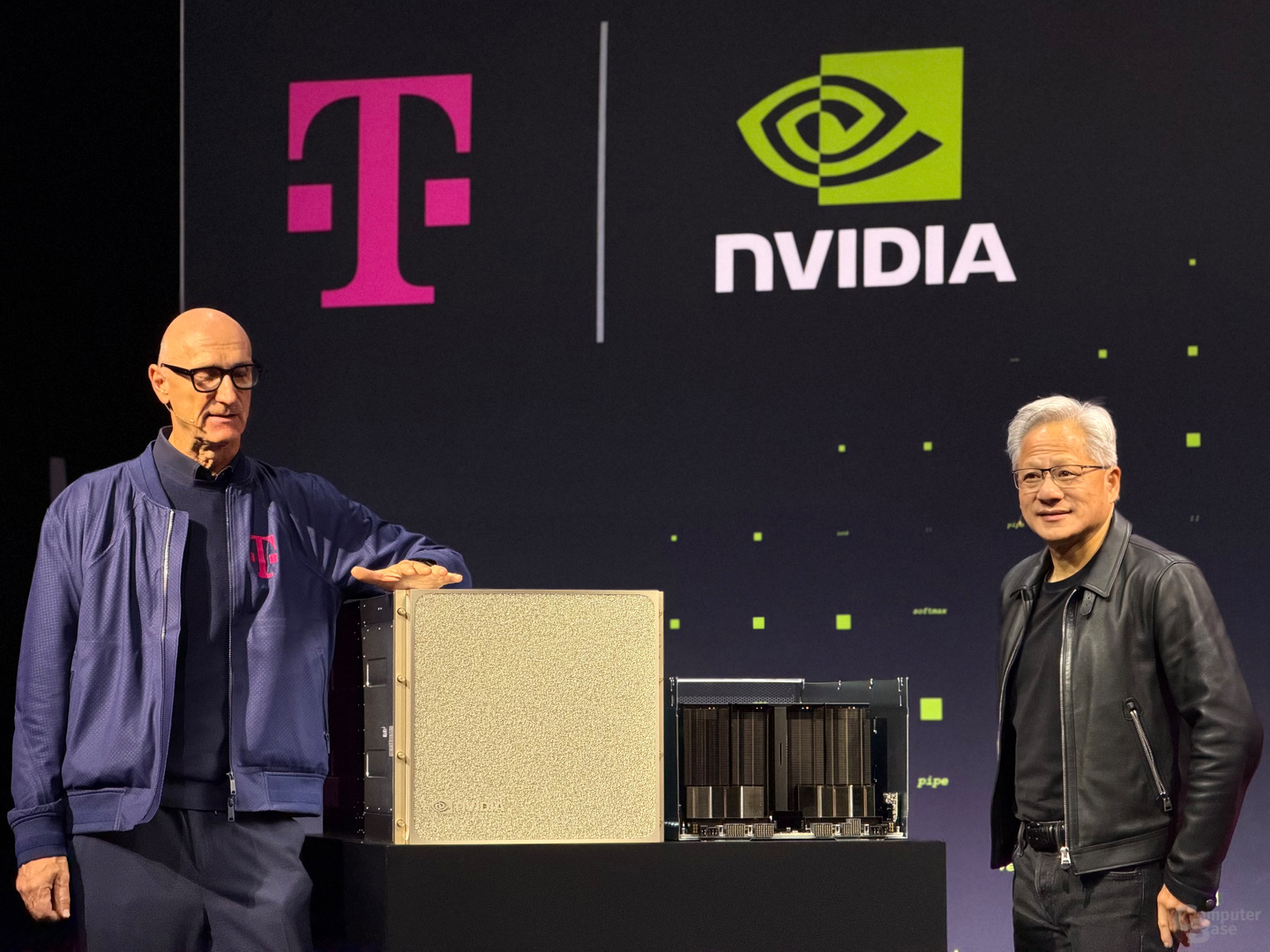

Telekom und Nvidia: Deutschlands erste KI-Fabrik mit 10.000 GPUs ist online

Die Telekom hat heute ihre erstmals im Sommer 2025 in Aussicht gestellte KI-Fabrik mit rund 10.000 Nvidia-GPUs der Blackwell-Generation in Betrieb genommen. Die AI-Kapazität in Deutschland soll damit auf einen Schlag um 50 Prozent gesteigert werden. Das Rechenzentrum am Münchener Tucherpark hat bereits mehrere Kunden.

Erstmals zu hören war von der KI-Fabrik durch Nvidia-CEO Jensen Huang im Rahmen der GTC Paris im Juni 2025. Kurz darauf folgten weitere Details, bevor man sich schließlich im November letzten Jahres auf einen Start Anfang 2026 festlegte. Für diese Ankündigung (und ein wenig Marketing) war Jensen Huang sogar nach Berlin gereist.

Betrieb vollständig mit erneuerbaren Energien

Heute ist der Startschuss gefallen, Deutschland hat eine erste KI-Fabrik. Für das Datacenter wurde ein ehemaliges Rechenzentrum der Hypovereinsbank im Tucherpark im Münchener Stadtteil Schwabing-Freimann gewählt. Der Standort mit einer Fläche von etwa 10.700 m² musste entkernt und grundlegend modernisiert werden, etwa mit einer leistungsstarken Glasfaseranbindung.

Das Rechenzentrum wird vollständig aus erneuerbaren Energien betrieben. Es sei auf höchste Energieeffizienz ausgelegt. Die Abwärme werde in Zukunft das gesamte Quartier Tucherpark mit Wärme versorgen. Ein modernes Kühlkonzept setzt auf Kühlung des Rechenzentrums durch Wasser des nahegelegenen Eisbaches. Den Energiebedarf bezifferte Telekom-CEO Timotheus Höttges im November auf 12 Megawatt. Die Telekom betreibt und least derzeit insgesamt 184 Rechenzentren mit einem Energiebedarf von 390 MW.

Nvidia DGX B200 und RTX Pro Server für insgesamt 0,5 ExaFLOPS

Gekühlt werden 10.000 GPUs der Blackwell-Generation, genauer gesagt eine Mischung aus Nvidia DGX B200 und RTX Pro Server. DGX B200 ist die weniger dicht gepackte, luftgekühlte x86-Plattform von Nvidia, bei der sich ein Node aus zwei Xeon Platinum 8570 und acht Nvidia B200 für insgesamt 16 GPU-Dies zusammensetzt. Bis zu 72 PFLOPS für das Training und 144 PFLOPS für das Inferencing stellt eines dieser Systeme bei einem Energiebedarf von bis zu 14,3 kW zur Verfügung. Bei den RTX Pro Servern handelt es sich um luftgekühlte Systeme mit acht RTX Pro 6000 Blackwell Server Edition via PCIe. Die Telekom gibt die Gesamtrechenleistung mit bis zu 0,5 ExaFLOPS an. Damit könnten alle 450 Millionen EU-Bürger gleichzeitig einen KI-Assistenten nutzen.

Daten sollen vollständig in Deutschland verbleiben

Geschaffen werden soll eine digitale Infrastruktur für öffentliche Einrichtungen und innere Sicherheit. Die physische Infrastruktur stellt die Telekom, involviert war auch der Datacenter-Partner Polarise. SAP steuert die eigene Business Technology Platform und Anwendungen bei. Von einem „Deutschland-Stack“ und deutscher KI-Souveränität war zur Ankündigung in Berlin die Rede. Auf diesem Stack sollen künftig alle digitalen Lösungen für die genannten Zielgruppen entwickelt werden. Während die Technologie aus den USA und Deutschland stammt, soll der Betrieb nur in deutscher und europäischer Hand liegen. Die Daten sollen vollständig in Deutschland verbleiben.

Telekom vermeldet ein Drittel Auslastung zum Start

Die KI-Fabrik sei mit den bisherigen Kunden bereits über ein Drittel ausgelastet, sagte die Telekom heute. Im B2B-Sektor sind das Siemens, Agile Robots, Wandelbots, PhysicsX und EY. Mit Quantum Systems ist zudem ein deutscher Hersteller von zivilen und militärischen Überwachungsdrohnen vertreten. Und im B2C-Segment schafft die Telekom mit dem Datacenter neue Inferencing-Kapazitäten für den AI-Anbieter Perplexity. Die KI-Fabrik steht ab sofort Kunden aus Industrie, Start-ups, Forschung und öffentlichem Sektor zur Verfügung. Unternehmen können Rechenleistung und Plattformdienste flexibel nach Bedarf buchen – von Pilotprojekten bis hin zu unternehmenskritischen Produktionssystemen.

-

Entwicklung & Codevor 3 Monaten

Entwicklung & Codevor 3 MonatenKommandozeile adé: Praktische, grafische Git-Verwaltung für den Mac

-

Künstliche Intelligenzvor 1 Monat

Künstliche Intelligenzvor 1 MonatSchnelles Boot statt Bus und Bahn: Was sich von London und New York lernen lässt

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenHuawei Mate 80 Pro Max: Tandem-OLED mit 8.000 cd/m² für das Flaggschiff-Smartphone

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenFast 5 GB pro mm²: Sandisk und Kioxia kommen mit höchster Bitdichte zum ISSCC

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenKommentar: Anthropic verschenkt MCP – mit fragwürdigen Hintertüren

-

Social Mediavor 2 Monaten

Social Mediavor 2 MonatenDie meistgehörten Gastfolgen 2025 im Feed & Fudder Podcast – Social Media, Recruiting und Karriere-Insights

-

Datenschutz & Sicherheitvor 2 Monaten

Datenschutz & Sicherheitvor 2 MonatenSyncthing‑Fork unter fremder Kontrolle? Community schluckt das nicht

-

Künstliche Intelligenzvor 3 Monaten

Künstliche Intelligenzvor 3 MonatenWeiter billig Tanken und Heizen: Koalition will CO₂-Preis für 2027 nicht erhöhen