Künstliche Intelligenz

Android 16: Google erklärt, wie Live-Updates genutzt werden können

Die neue Live-Update-Funktion sollte mit Android 16 auf Smartphones einziehen, ist aber wie Material 3 Expressive noch immer nicht wirklich verfügbar. Es deutet sich an, dass sie erst mit dem nächsten größeren Update, das voraussichtlich im September erscheint, kommen wird. Damit Entwickler sie einfacher in ihre Apps integrieren können, hat der Konzern eine Dokumentation veröffentlicht, die ihnen bei der Implementierung helfen soll. Auch für Endanwender ist sie aufschlussreich.

Für „zeitkritische Aktivitäten“

Die Live-Updates von Android 16 werden von manchen als Googles Interpretation von Apples Live-Aktivitäten verstanden. Andere sehe in ihr eine Erweiterung einer Funktion von Android 12, mit der Telefon-Apps die Dauer eines laufenden Anrufs in der Statusleiste anzeigen konnten. Vielleicht ist auch beides irgendwie richtig, denn die Funktion soll es Apps ermöglichen, Echtzeit-Fortschrittsbenachrichtigungen von ausgewählten Apps, auf dem Sperrbildschirm oder in den Benachrichtigungen anzuzeigen.

So kann Google Maps die Live-Update-Funktion von Android 16 verwenden.

(Bild: Google)

Nutzer können damit etwa schneller erfassen, wann ein Uber-Fahrer eintrifft oder die Essenslieferung ankommt, ohne das Smartphone zu entsperren oder die App öffnen zu müssen.

Im neuen Entwickler-Beitrag wird Google etwas konkreter und erklärt, dass die Android-16-Funktion für „fortlaufende, vom Nutzer initiierte und zeitkritische Aktivitäten“ verwendet werden können. Der Konzern gibt zudem einige Beispiele, zu denen unter anderem eine aktive Navigation, Telefonanrufe, die Verfolgung von Fahrdienstbestellungen und Lebensmittellieferungen gehören.

Live-Updates: Keine Werbung, keine Chat-Nachrichten

Google weist überdies ausdrücklich darauf hin, dass Live-Updates nicht für „Werbung, Promotionen, Chat-Nachrichten, Benachrichtigungen, bevorstehende Kalenderereignisse und einen schnellen Zugriff auf App-Funktionen“ verwendet werden dürfen.

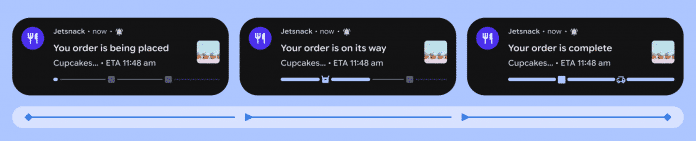

Screenshots zeigen, wie die Live-Update-Funktion für eine Essensbestellung aussehen könnte

(Bild: Google)

Ferner ergänzt das Unternehmen, dass die meisten Live-Updates Aktivitäten darstellen sollten, „die explizit vom Nutzer ausgelöst werden“. Als Beispiele nennt Google „das Einleiten einer Navigation oder das Bestellen einer Mitfahrgelegenheit“. Interessanterweise nennt Google auch das „Starten eines Trainings“, was darauf hindeutet, dass künftig Entwickler von Fitness- oder Trainings-Apps diese Funktion nutzen dürfen.

Google sagt überdies, dass „Umgebungsinformationen, wie beispielsweise Informationen über die Umgebung des Nutzers, seine Interessen oder bevorstehende Ereignisse“ nicht in Live-Updates angezeigt werden sollen. Entwickler dürfen zudem nicht zulassen, „dass Aktivitäten, die von anderen Parteien ausgelöst werden, Live-Updates erzeugen.

Google erklärt in seinem Artikel auch den „zeitkritischen Aspekt“ der Funktion: Es heißt, ein Live-Update sei „oft für Aktivitäten geeignet, die zwischen Live-Updates und normalen Benachrichtigungen übergehen“. Als Beispiel nennt der Hersteller die Anzeige einer Bordkarten-Benachrichtigung, die auch viele Stunden vor dem Flug eines Nutzers angemessen sei. Die Benachrichtigung sollte indes erst dann zu einem Live-Update werden, „wenn der Nutzer ein dringendes Bedürfnis hat, z. B. wenn er am Flughafen oder Veranstaltungsort angekommen ist oder wenn das Boarding begonnen hat“.

Für die Verfolgung von Paketlieferungen sieht Google die Funktion nicht geeignet. Denn der Nutzer müsse diese nicht ständig überwachen.

Zeitsensitive Live-Updates: Bordkarten ja, Paketlieferungen nein

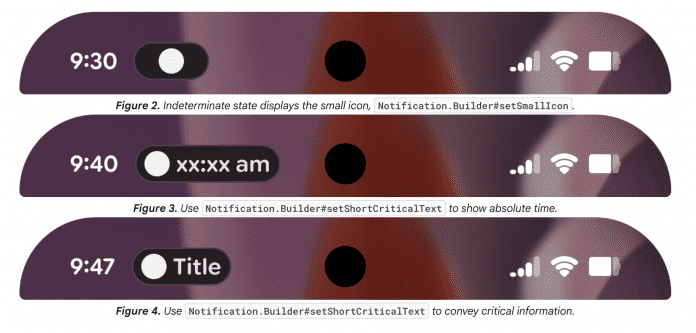

Der Artikel erläutert außerdem, wie sogenannte „Status-Chips“ genutzt werden können. Die Hinweise in der Statusleiste können etwa nur ein Symbol, ein Symbol und bis zu sieben Zeichen Text oder eine bestimmte Uhrzeit enthalten.

Beispiele für Live-Update-„Chips“ in der Statusleiste

(Bild: Google)

Google spricht Entwicklern zudem die Empfehlung aus, die Live-Update-Funktion nicht zu missbrauchen. Außerdem sollte die App-Funktion so konzipiert sein, dass das Live-Update nicht wieder sofort angezeigt werden sollte, wenn ein Nutzer es wegwischt.

Die Live-Updates sind keine Funktion, die nur auf Pixel-Smartphones ein Zuhause finden. Im Zuge der Entwicklerkonferenz I/O 2025 im Mai sagte Google, dass sie mit Android 16 auf Geräte vieler Hersteller wie Samsung, Xiaomi, Oppo und Oneplus landen wird.

(afl)

Künstliche Intelligenz

Deadpool VR: Absurdes Slapstick-Gemetzel für die Meta Quest 3

Auch in seinem exklusiven VR-Spiel für Quest 3 kann Deadpool einfach nicht die Klappe halten. Das war unsere erste Erkenntnis, als wir uns auf der Gamescom mit schnellen Schwerthieben, Schüssen und Kombos durch die vermummten Dämonenhorden von „Marvel’s Deadpool VR“ metzelten. Der maskierte Antiheld quittiert jede noch so missliche Lage mit einem albernen Kommentar, selbst wenn ihm sämtliche Gliedmaßen abgehackt wurden: „Was für eine Schande, jetzt werde ich nie beim Yu-Gi-Oh!-Turnier antreten können!“

Das klassische Action-Adventure mit einer neuen Story führt Deadpool an verschiedene Orte des Marvel-Universums. Dort muss er Schurken wie Mephisto, Lady Deathstrike, Omega Red und Ultimo entführen, um sie in einer intergalaktischen Spielshow zu blutigen Kämpfen zu zwingen. Nicht gerade die feine Art, aber Alien-Produzent Mojo (gesprochen vom Schauspieler John Leguizamo) hat wenig Toleranz für schlechte Quoten. Das degenerierte Publikum will schließlich mit expliziter Brutalität bei Laune gehalten werden.

Meta

)

Die USK hat die „drastische Gewalt“ des Spiels bereits ab 18 eingestuft. Der Humor soll ihre Wirkung aber etwas abschwächen, zumal man nur bei Finishern Gegner zerteilt. Auch der euphorische Soundtrack und das Comic-Design mit lautmalerischen Sprechblasen („Boop!“) tragen dazu bei, dass das Gemetzel wie eine spielbare Action-Komödie wirkt.

Alles für die Quote

Ein wichtiges Instrument dazu sind wild kombinierte Kill-Manöver. Hat man im Sprung bereits ein Schwert geworfen, kann man danach zwei herannahende Dolche eines Gegners aus der Luft fischen, um sie zurückzuschleudern. Dann verpasst man dem Widersacher den Rest – etwa mit einem Sprungkick, einer Granate, einem Pfeil oder Schrotflinte. Auf diesem Weg lädt man Energie für Deadpools Special-Meter auf und erhält so Zugriff auf aufgemotzte Mojo-Versionen typischer Marvel-Waffen. Dazu gehören beispielsweise der übergroße „Mojo-Nir Hammer“ oder Mojos explosive Cajun-Karten. Bei Letzteren handelt es sich um zielsuchende, magische Spielkarten, die sich lässig aus dem Handgelenk werfen lassen.

Zu Beginn gestaltete es sich etwas verwirrend, verschiedene Attacken aneinanderzuketten. Nach einigen Minuten kamen wir aber immer besser in den Flow aus Schliddern, Wandläufen, Schwerthieben oder zweihändigen Pistolensalven. Am meisten Spaß machte es, die Gegner mit der Harpune in die Luft zu zerren, um sie nach einem Doppelsprung in Zeitlupe mit den Klingen zu bearbeiten.

Mithilfe der Harpune erreichten wir auf dem Parcours durch den ersten Tempel auch Vorsprünge. Bislang beschränkte sich die Mechanik auf ein einfaches, schnurgerades Emporziehen. Am Seil schwingen mussten wir noch nicht. Neben Plattformpassagen mit einer angenehm präzisen Sprungsteuerung begegneten uns auf dem linearen Weg durch die Gebirgskatakomben auch kleine Puzzles. Dazu gehören etwa große Pfeil- und Stachelfallen mit blinkenden Hinweisen. Die Rätsel bleiben dieses Mal jedoch mehr im Hintergrund als in „Defector”, dem letzten wilden Actionheldenspiel des Studios. Sie sollen die schnelle Action nicht ausbremsen, erklärte uns Animation Director Matt Schmitz auf der Messe. Im Fokus stehe klar das Gefühl, Deadpool zu verkörpern.

Zu wild für Marvel?

Bei der Verwirklichung dieses Konzepts überboten sich die Entwickler regelrecht mit albernen oder makabren Splatter-Ideen: „Zunächst hatten wir die Befürchtung, die Ideen würden Marvel zu weit gehen. Doch oft haben sie unsere Vorschläge selbst mit noch verrückteren Ideen übertroffen“, berichtet Schmitz.

Bei der Erkundung erster Schauplätze konnten wir bisher nicht nachvollziehen, warum die Veröffentlichung auf die Meta Quest 3 (S) beschränkt. Die stilistisch passende, aber schlicht gehaltene Comic-Grafik wäre mit etwas Feintuning sicherlich auch auf der alten Quest 2 machbar gewesen. Eine aufwendige Beleuchtung fehlt beispielsweise.

Die Entscheidung für die Unreal Engine statt für Unity ist im VR-Bereich eher ungewöhnlich. Laut Schmitz erwies sich die Engine in der Praxis aber als komfortable Option. Sie habe gerade in aktiven Momenten dabei geholfen, viele bewegte Objekte flüssig darzustellen, so Schmitz. Übel wurde uns dabei übrigens nicht: Grafik-Tricks wie Bewegungslinien in der Luft beugten effektiv der Simulationskrankheit vor.

Zwischenfazit

Unterm Strich hat uns der erste Ausflug in Deadpools actionreiches VR-Abenteuer Lust auf mehr gemacht. Technisch spielt der exklusive Quest-3-Titel zwar nicht in der gleichen Liga von Grafikperlen wie Assin’s Creed VR oder Red Matter 2. Sobald wir jedoch in den Flow kamen, gewannen wir immer mehr Spaß daran, durch Höhlen und Arenen zu turnen und für die Quote immer wildere Attacken zu verketten.

„Marvel’s Deadpool VR“ erscheint am 18. November exklusiv für die Meta Quest 3 zum Preis von 49 Dollar. Ein Euro-Preis steht noch nicht fest. USK ab 18.

(jpw)

Künstliche Intelligenz

Samsung Galaxy Watch 8 im Test: Die beste Smartwatch für Samsung-Handys

Mit einem kantigen und flachen Gehäuse kombiniert die Galaxy Watch 8 frische Funktionen mit bewährter Ausstattung. Neu ist etwa die Antioxidantien-Messung.

Mit der Galaxy Watch 8 bringt Samsung sein neuestes Modell unter den Smartwatches mit Wear OS heraus. Gegenüber dem Vorgänger hat der Hersteller insbesondere das Design deutlich überarbeitet. Die Watch 8 erinnert jetzt etwas mehr an die Watch Ultra.

Auch die Sensorik wurde erweitert. Neben präziser Pulsmessung und der Aufzeichnung eines 1-Kanal-EKGs ist jetzt auch die Bestimmung körpereigener Antioxidantien möglich. Dank enger Verzahnung mit Android-Smartphones integriert sich die Uhr tief ins Ökosystem – viele Funktionen bleiben leider erneut nur Nutzern von Samsung-Geräten vorbehalten. Wie sich die Galaxy Watch 8 im Alltag schlägt, zeigt unser Test.

Design & Tragekomfort

Samsung hat das Design der Watch 8 stärker an die Watch Ultra angelehnt. Zwar bleibt das runde Zifferblatt erhalten, doch das Gehäuse ist kantiger und besitzt abgerundete Ecken – allerdings weniger markant als beim Ultra. Man spricht von einem „Squircle“-Design – ein Mix aus kreisförmig und eckig. Als Inspiration dienten offenbar klassische Modelle wie die Omega Jedi. So wirkt die Watch 8 erwachsener und eigenständiger als der schlichte Vorgänger.

Die Uhr ist in zwei Gehäusegrößen erhältlich: 40 mm und 44 mm. Vor allem die kleinere Variante eignet sich für schmalere Handgelenke. Das gebürstete Aluminiumgehäuse ist hochwertig verarbeitet und wiegt mit 30 g oder 34 g nur sehr wenig. Der Tragekomfort überzeugt: Durch das flachere, dünnere Gehäuse sitzt die Watch 8 angenehmer als die Watch 7 und stört selbst über längere Zeit, etwa im Schlaf, kaum.

Die Armbänder lassen sich weiterhin schnell wechseln. Samsung hat den Mechanismus verbessert, was jedoch den Nachteil hat, dass ältere Bänder nur mit Adaptern passen. Im Test nutzten wir das waschbare Fluorelastomer-Armband, das sich für Sport eignet. Überdies gibt es zahlreiche Varianten aus Nylon oder Kunstleder und weiteren Materialien von Samsung und Drittanbietern.

Die Galaxy Watch 8 ist nach IPX8 und 5 ATM (50 Meter) wasserdicht. Schwimmen ist problemlos möglich, Tauchen jedoch nicht.

Samsung Galaxy Watch 8 – Bilderstrecke

Display

Das OLED-Display der Galaxy Watch 8 misst 1,47 Zoll und löst mit 480 × 480 Pixeln auf. Es ist größer und vor allem deutlich heller als beim Vorgänger. Mit bis zu 3000 Nits bleibt es selbst in direkter Sonne einwandfrei ablesbar und liefert eine überzeugende Bildqualität.

Saphirglas gibt es nicht bei diesem Modell – das bleibt der Watch 8 Classic und der Ultra vorbehalten. Stattdessen kommt gehärtetes Glas zum Einsatz, dessen Widerstandsfähigkeit hinter den Top-Modellen zurückbleiben dürfte. Insgesamt wirkt die Uhr etwas filigran, wenngleich robuster als die Google Pixel Watch, und empfiehlt sich für Outdoor-Abenteuer nur eingeschränkt.

Ausstattung

Die Galaxy Watch 8 setzt wie schon der Vorgänger auf den Exynos W1000, der sich im Alltag als flott und effizient erweist. Mit 2 GB RAM und 32 GB Speicher läuft das System weitgehend ruckelfrei und bietet ausreichend Performance. Neben der reinen Bluetooth-Version mit Wi-Fi-4 gibt es auch ein Modell mit LTE per eSIM. GPS arbeitet nun noch präziser und zuverlässiger.

Zur Ausstattung zählen zudem optische Sensoren, Sturzerkennung sowie Bezahlen per Google Pay. Der Vibrationsmotor könnte kräftiger sein, dafür liefern die integrierten Lautsprecher ordentliche Sprachqualität – Ansagen und Telefonate sind weitgehend verständlich.

Software & Bedienung

Mit der Galaxy Watch 8 führt Samsung Wear OS 6 samt One UI Watch 8 ein. Die Software ist übersichtlich, bietet eine riesige App-Auswahl und zählt zu den smartesten Systemen bei Uhren. Neu ist etwa das Stapeln von Widgets, was die Bedienung flexibler macht.

Die Kopplung erfolgt über die App Galaxy Wearable. Auf Samsung-Smartphones ist sie vorinstalliert, andere Android-Geräte benötigen zusätzlich zur App ein Plug-in für die Uhr, das bei der Koppelung automatisch heruntergeladen wird. Gesundheitsdaten landen hingegen in der App Samsung Health, wo etwa Schlafanalysen ausgewertet werden. Funktionen wie EKG und Blutdruckmessung stehen lediglich Nutzern mit einem Samsung-Handy zur Verfügung.

Bedient wird die Uhr per Touchscreen sowie zwei Tasten. Beide Seitentasten sind frei belegbar. Zusätzlich gibt es eine digitale Lünette. Neu ist die direkte Nutzung von Gemini auf der Uhr, was eine Internetverbindung voraussetzt.

Samsung Galaxy Watch 8 – App

Sport & Fitness

Die Galaxy Watch 8 eignet sich hervorragend als Sportuhr. Für zahlreiche Sportarten gibt es vordefinierte Profile, der optische Pulssensor lieferte im Test sehr genaue Werte und reagierte zuverlässig auf Belastungswechsel. Wir hatten das mit einem Brustgurt verglichen und hatten nur minimale Abweichungen.

Die automatische Aktivitätserkennung funktioniert zuverlässig und erkennt Spaziergänge oder Radtouren meist selbstständig. Während des Trainings zeigt die Uhr Daten wie Distanz, Geschwindigkeit, Kalorien und Puls, eine detaillierte Analyse erfolgt in Samsung Health.

Der Laufcoach bietet weiterhin Trainingsunterstützung und enthält nun einen Cooper-Test, der anhand von Strecke und Puls nach zwölf Minuten das Fitness-Level bestimmt und einen individuellen Plan erstellt. Ergänzend liefern erweiterte Laufmetriken Hinweise zur Optimierung des Laufstils.

Daneben gibt es eine Schlafanalyse, die Tief-, Leicht- und REM-Phasen unterscheidet. In der Praxis bleibt sie jedoch ungenau: Wachzeiten werden oft übersehen und Einschlafen zu früh erkannt, was zu geschönten Ergebnissen führt – ein bekanntes Problem vieler Smartwatches. Smarte Ringe wie Oura oder Ringconn sind hier präziser.

Zusätzlich misst die Watch 8 Blutsauerstoff und Stresslevel. EKG und Blutdruck bleiben dagegen Samsung-Smartphones vorbehalten: Das 1-Kanal-EKG zeigte im Test zwar korrekte Werte, wirkte beim Puls aber teils hoch. Die Blutdruckmessung erfordert eine einmalige Kalibrierung mit Manschette und ist alltagstauglich, wenngleich weniger exakt als eine klassische Messung.

Der AGEs-Index erfasst schädliche Zucker-Protein-Verbindungen im Körper, die mit Alterung sowie Krankheiten wie Diabetes oder Herzproblemen in Zusammenhang stehen. Er dient als Indikator für ein mögliches Erkrankungsrisiko und wird ermittelt, indem man die Watch 8 regelmäßig am Handgelenk trägt.

Ganz neu ist die Antioxidantien-Messung, die Hinweise auf die Fähigkeit des Körpers zur Abwehr freier Radikale geben soll. Hierzu muss man die Uhr abnehmen und den Finger auf die Sensoren auf der Rückseite legen. Diese Werte sind jedoch eher als grobe Trends zu verstehen, da eine verlässliche Analyse üblicherweise nur im Labor per Blut- oder Urinprobe möglich ist. Das macht sie eher zu einer Wellness-Funktion.

Akku

Eine Schwachstelle bleibt der Akku bei Smartwatches mit umfangreicher Software und großer App-Auswahl – das gilt auch für die Apple Watch. Modelle von Garmin oder Huawei laufen zwar deutlich länger, bieten dafür aber weniger smarte Funktionen.

Im Test kam die Galaxy Watch 8 auf etwas mehr als einen Tag Laufzeit und damit nur auf eine minimale Verbesserung gegenüber dem Vorgänger. Aufgeladen wird sie induktiv über ein Pad mit USB-C-Anschluss, der Ladevorgang dauert rund 75 Minuten und ist damit vergleichsweise lang. Prinzipiell kann man die Uhr auch mit anderen Ladepads induktiv laden – im Test funktionierte das jedoch nicht zuverlässig.

Preis

Die Galaxy Watch 8 startet mit einer UVP von 379 Euro (40 mm) sowie 409 Euro (44 mm). Für die LTE-Variante fällt ein Aufpreis von 60 Euro an. Bereits kurz nach Marktstart sind die Preise deutlich gefallen: Die 40-mm-Version mit WLAN und Bluetooth gibt es ab 264 Euro, das 44-mm-Modell ab 285 Euro. Mit LTE startet die Uhr bei rund 345 Euro (40 mm) oder 359 Euro (44 mm).

Mit der Zeit dürfte der Preis noch deutlich fallen. Als Farben gibt es Silber mit weißem Armband oder ganz Anthrazit. Das Band ist standardmäßig aus Fluorelastomer. Es gibt aber zahlreiche Austauschvarianten bei Samsung und Drittanbietern.

Fazit

Die Samsung Galaxy Watch 8 zeigt eindrucksvoll, wie smart eine Uhr mit Wear OS sein kann. Sie bietet eine sehr genaue Pulsmessung, spannende Features wie EKG, Blutdruckmessung sowie die neue Antioxidantien-Bestimmung – letztere ist allerdings in der jetzigen Form eher von begrenztem medizinischem Wert. Positiv fallen zudem das kantigere Design und das helle Display auf.

Allerdings gibt es erneut Einschränkungen: Viele Funktionen – etwa das EKG – stehen ausschließlich Nutzern eines Samsung-Smartphones zur Verfügung. Damit ist die Galaxy Watch 8 zwar die beste Smartwatch für Samsung-Handys, aber nicht unbedingt für andere Android-Smartphones. Wer mit der kurzen Akkulaufzeit leben kann, bekommt dennoch eine hervorragend ausgestattete Smartwatch mit breiter App-Auswahl und sehr genauen Sensoren.

Künstliche Intelligenz

Teslas Cybertruck: Kein Bestseller in den USA

Die Ursachen mögen vielfältig sein, am Resultat allerdings gibt es nichts misszuverstehen: Die Verkaufszahlen des Tesla Cybertrucks sind bislang mäßig. Im zweiten Quartal halbierten sich die Erstzulassungen nach Zahlen des Branchendienstleisters Cox Automotive im Jahresvergleich auf 4306 abgesetzte Fahrzeuge. Tesla selbst macht keine Angaben zu Auslieferungen des Cybertrucks, der bisher nur in Nordamerika verkauft wird.

Cybertruck: 2025 werden es wohl weniger als 20.000 Stück

Dabei waren die Hoffnungen von Tesla und die Befürchtungen der Konkurrenz einst riesig. Bis zu 250.000 Cybertrucks pro Jahr wollte Tesla bauen. In diesem Jahr wird der Absatz wohl bei weniger als 20.000 liegen. Pickups sind in Nordamerika ein großes und lukratives Marktsegment, das von schweren Verbrennern der absatzstarken Marken Ford, GM und dem Vielmarken-Verbund Stellantis dominiert wird. Als Tesla 2019 den Vorstoß in dieses Geschäft mit dem ungewöhnlich geformten Cybertruck ankündigte, bangten die drei Großen um ihr Geschäft. In aller Eile schob Ford einen batterieelektrischen F-150 Lightning auf den Markt.

Doch trotz Milliardeninvestitionen wird der überwiegende Anteil der in den USA verkauften Pickups weiterhin von Verbrennungsmotoren angetrieben. Die vor allem gewerblichen Käufer steigen bei weitem nicht in dem Umfang auf batterieelektrische Antriebe um, wie das noch vor wenigen Jahren prognostiziert wurde. Bei Ford sanken im vergangenen Quartal die Verkäufe des F-150 Lightning zwar auch um gut ein Viertel. Aber mit 5842 Fahrzeugen fand er wenigstens etwas mehr Abnehmer als der Cybertruck. Dennoch ist auch bei Ford der E-Anteil klein. Im zweiten Quartal hat Ford eigenen Angaben zufolge 222.459 Modelle der F-Serie absetzen können.

Neue Anreize

Tesla ist aktuell mit fünf Modellen auf dem US-Markt vertreten. Wie auf anderen Märkten dominiert auch in den Vereinigten Staaten das Model Y die Verkaufszahlen. Für das SUV wurde gerade eine Version mit langem Radstand vorgestellt, die chinesische Interessenten ansprechen soll. Zumindest vorerst wird das Model Y L auch nur dort verkauft. Der Radstand wächst um 18 cm auf 3,04 m. Nur den USA vorbehalten bleiben zunächst die leicht überarbeiteten Fassungen von Model S und Model X. Um den Absatz zu beleben, gibt es derzeit auch Überlegungen, für einige Modellreihen das kostenlose Laden an eigenen Superchargern wieder einzuführen.

Lesen Sie mehr zur Marke Tesla

(mfz)

-

Datenschutz & Sicherheitvor 2 Monaten

Datenschutz & Sicherheitvor 2 MonatenGeschichten aus dem DSC-Beirat: Einreisebeschränkungen und Zugriffsschranken

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenMetal Gear Solid Δ: Snake Eater: Ein Multiplayer-Modus für Fans von Versteckenspielen

-

Online Marketing & SEOvor 2 Monaten

Online Marketing & SEOvor 2 MonatenTikTok trackt CO₂ von Ads – und Mitarbeitende intern mit Ratings

-

UX/UI & Webdesignvor 2 Tagen

UX/UI & Webdesignvor 2 TagenDer ultimative Guide für eine unvergessliche Customer Experience

-

Digital Business & Startupsvor 2 Monaten

Digital Business & Startupsvor 2 Monaten10.000 Euro Tickets? Kann man machen – aber nur mit diesem Trick

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenPhilip Bürli › PAGE online

-

Digital Business & Startupsvor 2 Monaten

Digital Business & Startupsvor 2 Monaten80 % günstiger dank KI – Startup vereinfacht Klinikstudien: Pitchdeck hier

-

Social Mediavor 2 Monaten

Social Mediavor 2 MonatenAktuelle Trends, Studien und Statistiken