Apps & Mobile Entwicklung

ComputerBase in den Reinräumen von Intels Fab 52

Heute wird Intels nagelneue Fab 52 offiziell eröffnet. Sie fertigt Intel Panther Lake (Details) und Clearwater Forest in Intel 18A – also in Großserie! Bis dahin war es ein beschwerlicher Weg; der Campus in Chandler, Arizona, hat schon so einiges durchgemacht, aber auch noch viel vor. ComputerBase hat sie im Bunny Suit besucht.

Zu Besuch in der Intel Fab 52

Alles andere als normal

Halbleiterhersteller lassen sich ungern in die Karten sehen, schon gar nicht in die neuesten Anlagen sollen Personen gelangen, die dort nicht hingehören. Selbst bei Intel werden die meisten Angestellten, auch wenn sie zum Teil schon Jahrzehnte dort arbeiten, eine Fab nie von innen sehen.

Für ausgewählte Medienvertreter gab es jetzt allerdings die berühmte Ausnahme, denn Intel will zeigen: Intel 18A läuft in Großserie an – eine Notbremse wie auf den letzten Metern bei Intel 20A gibt es dieses Mal nicht.

Konkret lud Intel Medienvertreter und Analysten in der vergangenen Woche nach Arizona in die Fab 52, die heute offiziell die Serienproduktion der Intel-18A-Chips für Panther Lake und Clearwater Forest aufnimmt.

Einblicke auch im Podcast-Format

Neben dem nachfolgenden Bericht hat sich Volker diese Woche gemeinsam mit Jan im Podcast über seinen Besuch in der Intel Fab 52 unterhalten. Wie es sich angefühlt hat, in den Bunny Suit zu steigen oder vom Werksleiter mitten im Reinraum den Schuh neu gebunden zu bekommen, gibt es in CB-Funk #139 ab Minute 39:10 zu hören.

Die Intel Fab 52

Intels Historie am Standort

Baubeginn der Fab 52 war 2021. Mit der Eröffnung heute sind letztlich rund vier Jahre vergangen, was für eine State-of-the-Art-Fab ein ziemlich normales Zeitfenster darstellt. Die Fabrik steht in Chandler, Arizona, quasi einem Vorort südlich von Phoenix. Intel ist dort bereits seit 1980 vertreten. 1990 ging es dann richtig los: Fab 12 als hochmoderne Anlage wurde an der Ocotillo Site (OC), wie der Campus heißt, errichtet, Fab 22 folgte rasch und wurde bereits 1996 eröffnet. Anfang der 2000er gab es die nächste Erweiterung: Fab 32. Danach wurde es ruhiger.

Fab 42 war als Riesenprojekt ab 2011 geplant, dann jedoch aufgrund der schwachen wirtschaftlichen Lage nicht ausgerüstet worden. 2017 holte Intel den Bau wieder aus dem Winterschlaf und stellte ihn für 7 Milliarden US-Dollar fertig. Unter Pat Gelsinger und dem neuen Foundry-Ansatz kamen 2021 dann die Pläne für Fab 52 und 62 hinzu.

Heute baut Fab 42 Intel-7-Lösungen (10 nm), Fab 52 nebenan nun die neuen 18A-Chips. Und Fab 62 ist im Rohbau fertig, aber noch nicht ausgerüstet. Sollten alle Module, wie die Ausrüstungsphasen bei Intel heißen, hier aber einmal installiert werden, dann wäre Fab 62 noch größer als die Fab 52, erklärte Intel auf Nachfrage von ComputerBase. Doch dafür braucht es wohl echte Foundry-Kundschaft – also externe Kunden.

Ein Rundgang zum Auftakt

Der Auftakt der Tour war eine Runde um das Gelände. Das gibt einen guten Überblick, wie sich Intel hier entwickelt hat, aber auch, wie groß Halbleiterfabriken in den letzten Jahren geworden sind. Fab 12 ist nach heutigen Maßstäben winzig, Fab 22 kaum größer. Fab 32 legte die Messlatte höher dann, Fab 42 ist schon ziemlich groß. Fab 52 und Fab 62 sind jedoch noch einmal ein ganz anderes Kaliber. Für neue Maschinen mussten sie anders aufgebaut werden und sind daher auch höher.

Ein von Intel bereitgestelltes Drohnen-Video zeigt die verbundene Anlage aus Fab 42, Fab 52 und zukünftiger Fab 62.

100 Megawatt sind möglich

Auch die Stromversorgung des Komplexes, die südöstlich der Fab 62 liegt, wurde zuletzt auf 100 Megawatt aufgewertet – denn hochmoderne Lithographiesysteme benötigen jede Menge Energie. Und natürlich auch Wasser. Eine große Aufbereitungsanlage steht auf der anderen Seite des Komplexes.

Intel betont, dass man in Arizona nach den neuesten Bauten „water positive“ sei. Dies bedeute nicht, dass Intel wenig Wasser verbraucht, man jedoch der Community durch zusätzliche Projekte unter dem Strich aber mehr Wasser zurückgibt als entnimmt.

Die gesamten Investitionen von Intel in Arizona liegen bisher bei rund 50 Milliarden US-Dollar, erklärte das Unternehmen. Das Unternehmen ist vor allem auf den letzten Meilenstein so stolz, dass es diese letzte Errungenschaft auch teilen möchte. In Form kleiner Gruppen aus Personen in weißen Anzügen, den sogenannten „Bunny Suits“, ging es deshalb nach dem Rundgang in die heiligsten Hallen.

Im Bunny Suit durch Fab 42 und Fab 52

Für Besucher einer dieser hochmodernen Anlagen, sofern sie überhaupt zugelassen sind, gibt es diverse strikte Auflagen. Das oberste Ziel dabei ist, Verunreinigungen im Reinraum zu vermeiden.

Frisch geduscht ins Hasenkostüm

Frisch geduscht sollte man sein, aber das war es dann auch: Nichts in die Haare, nichts ins Gesicht, kein Duft oder Parfüm – Aerosole gilt es zu vermeiden. Dress Code: Geschlossene Schuhe und eine lockere Hose, dazu ein Shirt – mehr nicht. Denn über all das kommt der berühmte Bunny Suit – und darunter ist es warm.

Da der Laie mit dessen Anlegen total überfordert wäre beziehungsweise der Prozess viel zu lange dauern würde, bekam jeder Journalist vor Ort eine Anzieh-Hilfe. Der Autor war zwar bereits in den Fabs in Kyriat Gat, Israel, und den Produktionsstätten in Malaysia, aber mit Jahren Abstand halfen diese Erfahrungen in der Praxis in Arizona dann letztlich nicht mehr.

Im Aufenthaltsraum außerhalb der Reinräume konnten sich die Besucher aber schon einmal mit den Dingen vertraut machen.

20 Minuten durch einen Parcours

Denn der Zeitplan war eng gesteckt. Kleine Gruppen von je sechs bis acht Personen durften einen vorgegebenen und abgesteckten Parcours ablaufen und dabei die Fabrik im regulären Arbeitsprozess nicht behindern. Um Notizen zu ermöglichen, stellt Intel spezielle Notizblöcke zur Verfügung: Reinraum abgesegnet! Eigene Fotos oder Videos waren nicht erlaubt – aber das ist wenig überraschend. Denn eine bessere Fertigung in Serienproduktion gibt es aktuell nicht, sagt Intel – und hat damit durchaus recht: TSMCs neuer 2-nm-Prozess ist noch nicht in Serie, bis dahin dürfte Intel 18A die beste Lösung sein.

Die Gruppe machte sich nach dem Einkleiden durch einen kleineren Supportbereich auf in die Fab 42, die über einen Zugangstunnel direkt mit Fab 52 verbunden ist. Fab 42 fertigt Chips mit Intel 7 (10 nm). Hier sind unter anderem ASMLs DUV-Systeme sowie unzählige zusätzliche Tools und Gerätschaften zu sehen, deren Namen aber nicht genannt werden dürfen – das wollen sowohl die Partner als auch Intel nicht. Schon nach wenigen Minuten ist aber beinahe jeder Name der großen westlichen Fabrikausrüster zu sehen gewesen. ASMLs DUV-System ist das beste im Markt, wenn Chips ohne EUV gefertigt werden müssen. Genau das macht Fab 42.

Das an der Decke verbaute Transportsystem, welches die Wafer umherfährt, ist komplett über alle fünf Fabs verbunden. Das ist nicht unwichtig, denn die allerbesten Fertigungsschritte werden nicht überall und bei jedem Produkt und in allen Layern benötigt, also können diese auch woanders hinfahren und dort fertiggestellt werden.

Der heilige Gral: der EUV-Belichter

Endlich in Fab 52 angekommen, geht der Weg direkt zum wichtigsten Gerät der Anlage: einem EUV-System von ASML. Dies ist der aktuell modernste und teuerste EUV-Belichter des niederländischen Fabrikausrüsters, hier fertigt er aktuell die Compute-Tiles von Panther Lake und bald auch Clearwater Forest. Beeindruckend ist dabei einmal mehr die schiere Größe dieses einzelnen Systems, der DUV-Belichter in der Fab zuvor fällt deutlich kleiner und kompakter aus. Wie üblich sieht man dabei auch nur den einen Teil, die ganzen zusätzlichen Gerätschaften beispielsweise darunter eben nicht.

ASMLs EUV-Systeme können wie die DUV-Belichter stets auf den letzten Stand aufgerüstet werden. Jeder Kunde ist also bestrebt, dies auch schnellstmöglich zu tun, da damit einher oft viele Verbesserungen ins Spiel gelangen und der Durchsatz erhöht sowie die Fehlerquote und die Downtime reduziert werden.

Selbst wollte Intel nicht sagen, wie viele dieser Belichtungssysteme in Fab 52 verbaut sind. Die optimistischen Schätzungen gehen von einem Dutzend Systemen oder mehr aus, da vieles intern symmetrisch respektive dann auch gespiegelt aufgebaut ist.

Jedes dieser Systeme schafft die Belichtung von 200 bis 220 300-mm-Wafern die Stunde. Weil oftmals Schritte mehrfach vollzogen werden, ist die einfache Hochrechnung über x Systeme dann jedoch nicht so einfach, um in Richtung monatliche Kapazität hochzurechnen. Letzte Gerüchte, die aber nur von 1.000 bis 5.000 Wafern im Monat sprachen, klingen jedoch eher zu niedrig, wenn die Fab wie geplant arbeitet.

Nachdem die Medienvertreter ihr Programm abgeschlossen hatten, überzeugte sich Anfang Oktober auch Intels CEO Lip-Bu Tan im Bunny Suit von den Arbeiten in der Fab und positioniert sich vor dem EUV-System als dann auch vor der Anlage mit einem Intel-18A-Wafer.

Kein (interessantes) Packaging vor Ort

Was Fab 52 nicht macht, ist das Packaging, also das Verbinden unterschiedlicher Chips auf einem Träger. Natürlich werden vor Ort einige erste Tests gemacht, doch das komplette Die-Sort, Prep und Co geschieht dann in New Mexico.

Unterm Strich ist ein Packaging-Werk das viel interessantere für einen Besuch, denn während in der Fab 52 primär „nur graue Kästen“ angesehen werden konnten, konnte vor zwei Jahren in Malaysia der ganze Rest betrachtet werden – und das auch nicht nur in 20 Minuten, sondern über Stunden in mehreren Komplexen. Mehr Details zu diesen Schritten, die auch bei Panther Lake noch Bestand haben, gibt es im Bericht aus Malaysia:

- Vor-Ort-Besuch: Einblicke in Intels Test- und Packaging-Prozess in Malaysia

Intel 18A im Überblick

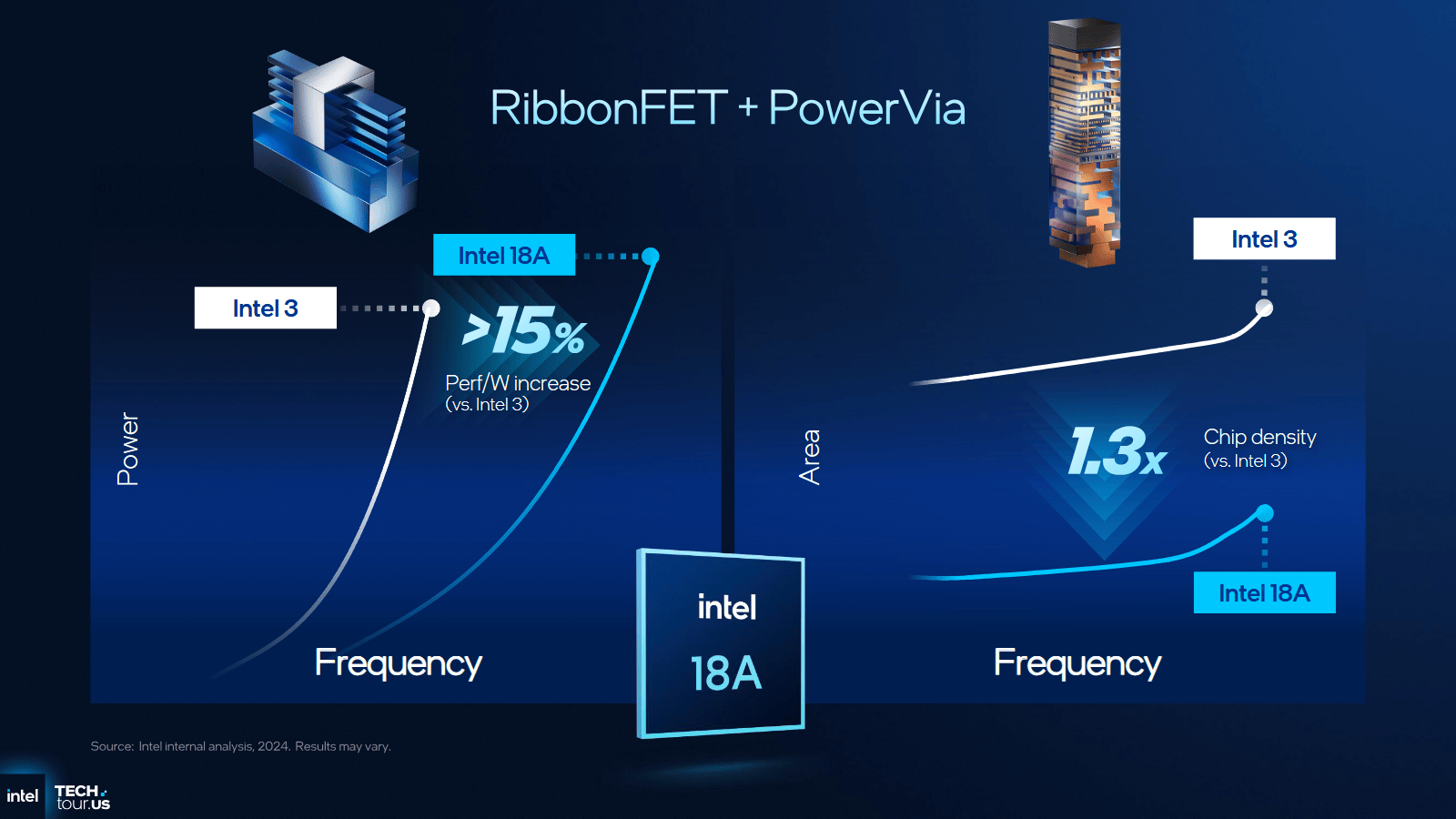

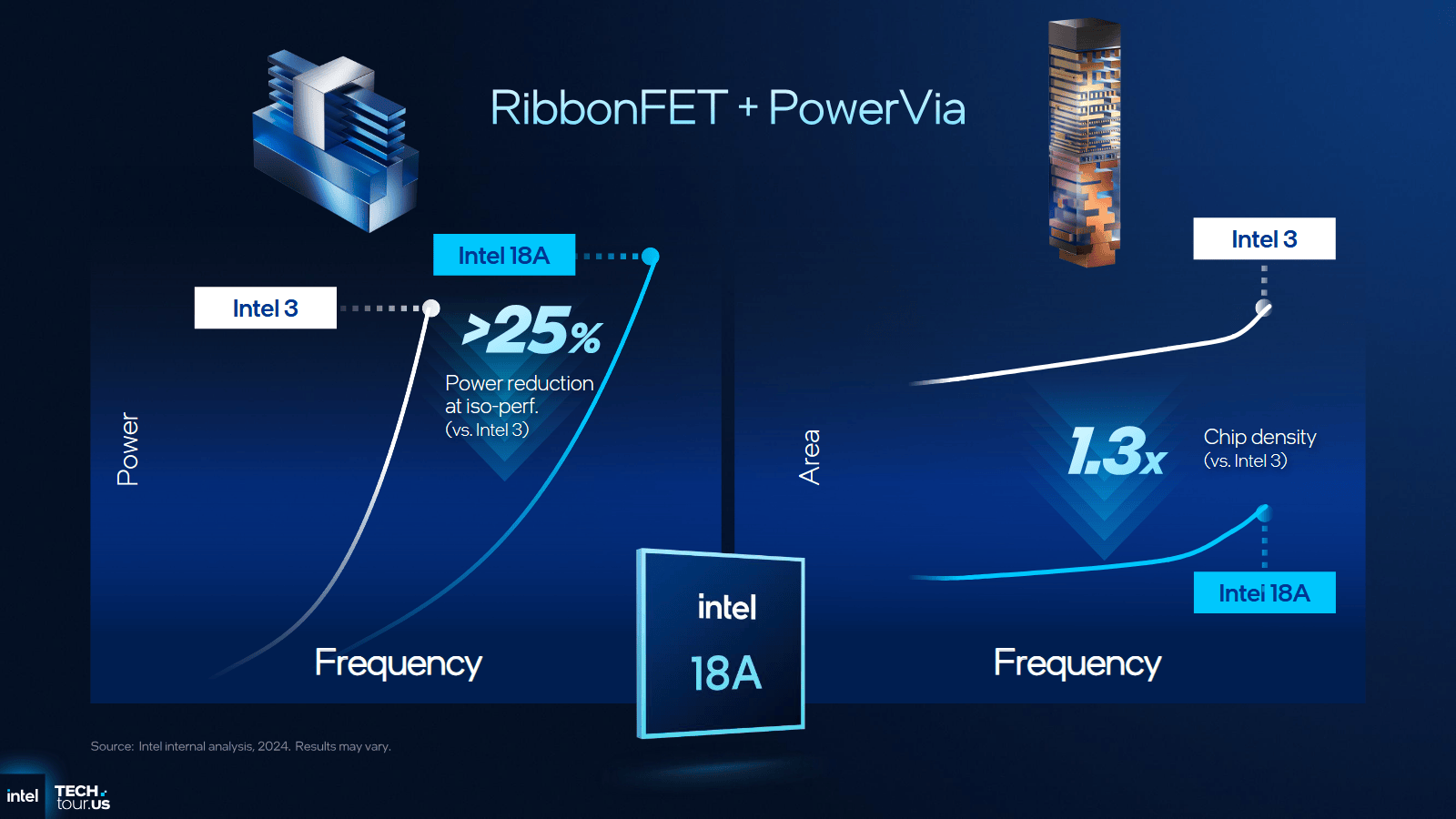

Mit RibbonFET und PowerVia

Eine bahnbrechende Neuerung bei Intel 18A ist zum Beispiel RibbonFET, wie Intel die Next-Gen-Fertigung rund um Gate all around (GAA) nennt. Das ist bei jedem Halbleiterhersteller aktuell das große Ding, das die nächste Dekade über Transistoren definieren wird. Oft auch Nanosheets genannt, sind diese extrem dünnen Fäden – 10.000 Sheets wären noch dünner als ein Blatt Papier – komplett umschlossen und ermöglichen so den perfekten Transistor. Daran wurde Jahrzehnte lang geforscht, nun gehen Samsung, Intel und TSMC hier nahezu im Gleichschritt in die Massenproduktion über.

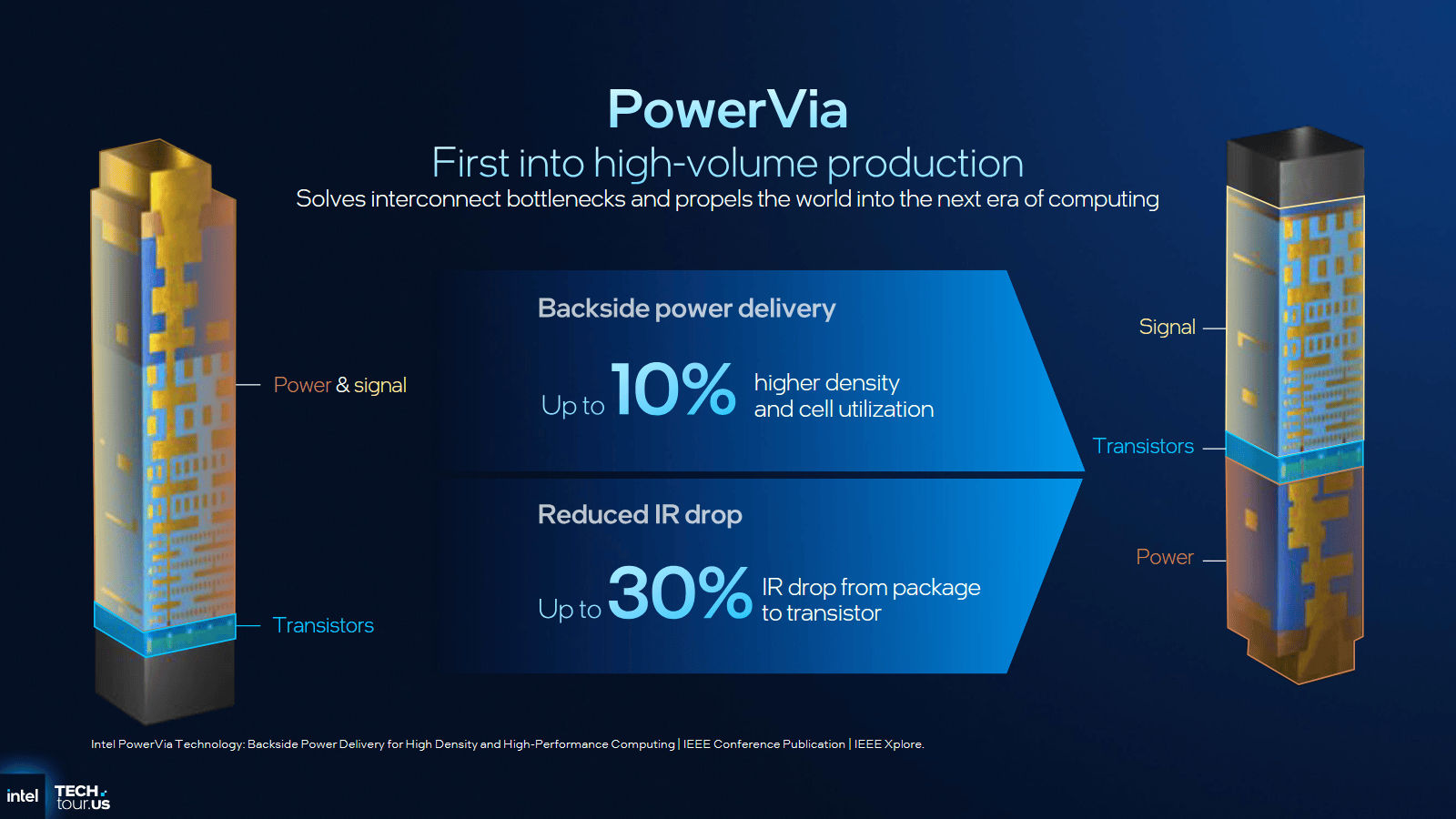

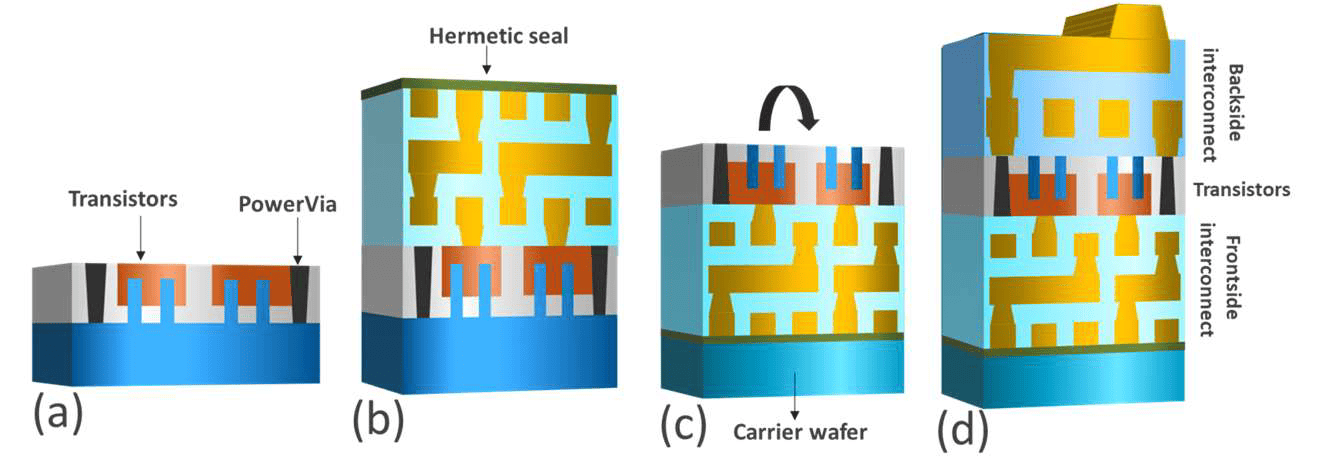

Backside Power Delivery (BSPD) heißt bei Intel PowerVia. Intels eigene Umsetzung der Technologie soll sich dabei etwas vom Original unterscheiden, nicht nur der Name sei ein anderer. Die grundlegende Technik der rückseitigen Stromversorgung von Transistoren ist wiederum keine exklusive Entwicklung, sie steht bei jeder Firma auf der Roadmap. Intel ist hier jedoch am weitesten fortgeschritten, geht nun als erster in Serienproduktion.

Bisher machen sich Strom- und Signalleitungen auf der Vorderseite eines Chips gegenseitig den Platz streitig, behindern sich mitunter sogar. Die Trennung von beiden bietet mehrere Vorteile sowohl in Richtung Skalierung als auch Effizienz: Signalleitungen haben mehr Platz, während sich auf der Rückseite die Stromzufuhr austoben kann. Ein Nachteil ist jedoch das Handling der Wafer, die in der Produktion gedreht werden müssen.

Da Intel beide neuen Technologien auf Intel 18A optimiert hat, verspricht das Unternehmen diverse Vorteile gleich zu Beginn. Denn das Herauslösen der Stromleitungen vereinfacht am Ende den Produktionsprozess sogar so weit, dass deutlich weniger Masken und Schritte nötig sind, wenn es mit einem klassischen Prozess verglichen würde.

Am Ende soll Intel 18A mit den beiden neuen Technologien Vorteile sowohl bei der Leistung, dem Stromverbrauch und natürlich dem Flächenbedarf bieten.

Höherer Yield als in der Vergangenheit

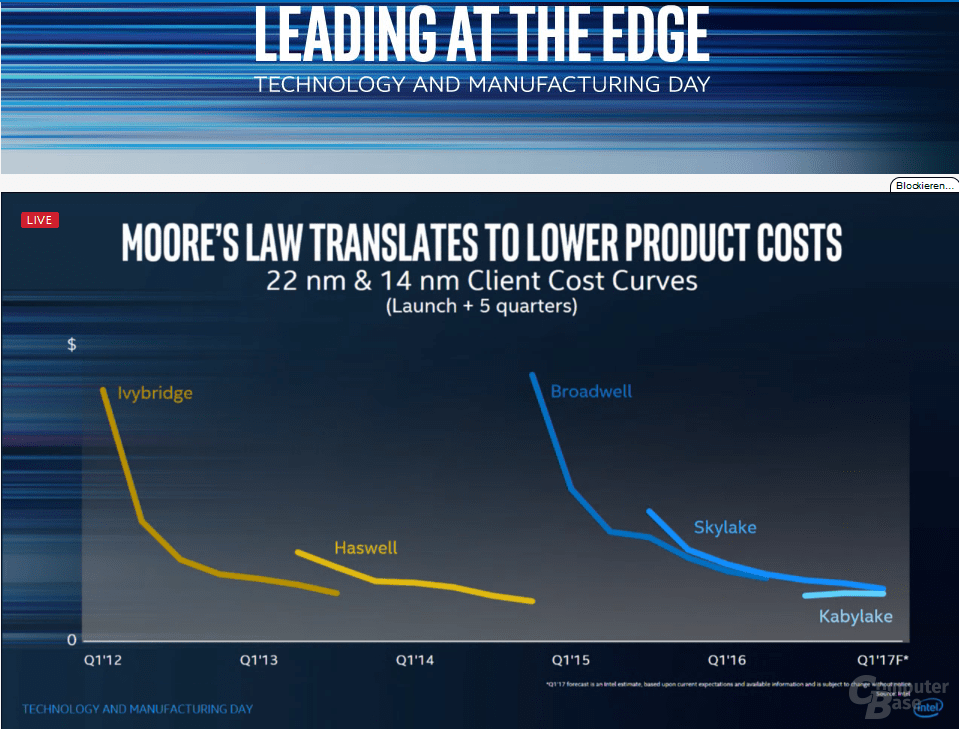

Intel gibt an, dass die Ausbeute von Intel 18A zum Start besser oder auf vergleichbarem Niveau liegt mit dem, was in den letzten 15 Jahren bei Intel neu gefertigt wurde.

Was das absolut bedeutet, ist allerdings nicht klar, denn wie in den letzten Jahren bekannt wurde, lief eigentlich keiner der Prozesse zum Auftakt wirklich rund: 10 nm war ein vollkommener Fehlschlag, 14 nm mit Broadwell war zum Start ein Desaster und selbst 22 nm mit der Einführung von FinFETs im Jahr 2012 mit Ivy Bridge startete nicht rund. Im Jahr 2017 hatte das Intel im Rahmen einer Präsentation selbst einmal so bestätigt. Am Ende sind aber auch nicht die ersten Wochen entscheidend, sondern wie schnell der Prozess reift. Das wird sich die kommenden Monate zeigen.

Für weitere Details hat Intel zum Start der Fertigung auch noch einmal viele Informationen in einem Video zusammengestellt.

Intel 18A ist nur für Intel

Am Ende ist und bleibt Intel 18A aber ein Prozess erst einmal ausschließlich für Intel. Denn für Intel wurde dieser entwickelt und optimiert, nicht für externe Kundschaft. Deshalb konnte Intel Foundry bisher auch keinen Großkunden gewinnen – ihnen stehen schlichtweg nicht die Tools zur Verfügung, um eigene Chips auf Intel 18A auszulegen.

Für die nächste große Stufe, Intel 14A, wird das andersherum angegangen. Hier soll ein universeller Prozess entstehen, Kunden können diesen dann mit Intel Foundry zusammen optimieren.

Ob das funktioniert, werden die kommenden Jahre zeigen. Platz für zusätzliche EUV-Belichter hat Intel jedenfalls, und das nicht nur in Arizona. Schließlich baut Intel – aktuell zwar nur langsam – einen großen Komplex in Ohio. Ob und wann dieser fertig, oder am Ende komplett kassiert wird, hängt am Erfolg von Intel 14A bei externen Kunden ab, aber auch dem Grundstein, der nun mit Intel 18A gelegt wird.

ComputerBase hat Informationen zu diesem Artikel von Intel im Vorfeld und im Rahmen einer Veranstaltung des Herstellers in Chandler, Arizona, unter NDA erhalten. Die Kosten für Anreise, Abreise und vier Hotelübernachtungen wurden von dem Unternehmen getragen. Eine Einflussnahme des Herstellers auf die oder eine Verpflichtung zur Berichterstattung bestand nicht. Die einzige Vorgabe war der frühestmögliche Veröffentlichungszeitpunkt.

Dieser Artikel war interessant, hilfreich oder beides? Die Redaktion freut sich über jede Unterstützung durch ComputerBase Pro und deaktivierte Werbeblocker. Mehr zum Thema Anzeigen auf ComputerBase.

Apps & Mobile Entwicklung

DDR5, LPDDR5X, GDDR7: Samsungs DRAM hat doppelt so hohe Margen gegenüber HBM

Zuletzt schon vermeldet untermauern weitere Medienberichte dies nun: Samsung wird viel mehr DRAM fertigen, (auch) weil die Margen sehr hoch sind. Die Zahlen gehen dabei in eine Richtung, die zuletzt schon spekuliert wurden: Um die 75 Prozent könnten es vor allem bei Serverspeicher nun werden, Tendenz steigend.

Die explosionsartig gestiegene Nachfrage nach klassischem Arbeitsspeicher ist ein (Geld-)Segen für Samsung. Vor allem Arbeitsspeicher für Serversysteme, also DDR5 als RDIMM, rechnet sich. War er ohnehin schon stets etwas teurer als DDR5 für Consumer, werden mit ihm ab Anfang 2026 rekordverdächtige Margen eingefahren. Der Durchschnittspreis für ein 64-GByte-Modul soll dann jenseits der 500-US-Dollar-Marke rangieren, zuletzt wanderte der tagesaktuelle Spotpreis mitunter schon auf 780 US-Dollar, während der Durchschnittspreis noch bei 450 US-Dollar lag.

Die Margen sollen schon jetzt bei um die 75 Prozent liegen, mit der Tendenz zu weiteren Steigerungen. Samsung plant deshalb, zusätzliche Kapazitäten für klassischen DRAM freizumachen, was neben DDR5 auch die Verfügbarkeit von LPDDR5X und GDDR7 verbessern soll. Wie bei SK Hynix vermeldet soll dabei auch eine Aufrüstung der Produktionsanalgen vom 1a-Prozess auf neuere helfen. Die Rede ist von bis zu 80.000 Wafern zusätzlicher Kapazität, die so im Monat bereitstehen könnten.

Bei HBM konzentriert sich das Unternehmen voll auf HBM4. Samsung war bekanntlich viel zu spät im Geschäft mit HBM3E. Dies musste am Ende teuer erkauft werden, denn nun versuchte der südkoreanische Mischkonzern SK Hynix zu unterbieten. Preislich gesehen ist Samsung HBM3E laut Medienbericht nun bis zu 30 Prozent günstiger als der HBM von SK Hynix, doch Langzeitverträge verhindern hier unter anderem einen Durchbruch. Zudem wird erwartet, dass HBM3E ohnehin ab 2026 günstiger wird, da der Fokus zu HBM4 schwenkt – für Samsung gibt es bei HBM3E nicht mehr viel zu gewinnen. Während SK Hynix so bisher auch Margen über 60 Prozent mit HBM einfährt, sind es bei Samsung nur um die 30 Prozent. Dies Aussagen wurden zuletzt durch ähnliche Berichte bereits deutlich.

Apps & Mobile Entwicklung

Neues Hilfsprogramm soll Menschen entlasten, die beim Heizen an ihre Grenzen stoßen

Immer mehr Haushalte kämpfen mit explodierenden Heizkosten – manche lassen ihr Zuhause sogar bewusst auskühlen. Neue Daten zeigen das ganze Ausmaß der Belastung. Gleichzeitig kündigt sich erstmals gezielte Unterstützung für Betroffene an.

Vielleicht kennt Ihr dieses Gefühl gerade selbst: Die Heizung läuft niedriger als Euch eigentlich lieb ist, weil die nächste Rechnung im Hinterkopf sitzt. Genau damit seid Ihr nicht allein – im Gegenteil. Eine aktuelle Auswertung zeigt, wie viele Menschen inzwischen im eigenen Zuhause frieren. Doch erstmals reagiert ein großer Energieversorger mit gezielter Unterstützung, die genau dort ansetzt, wo der finanzielle Druck am stärksten ist

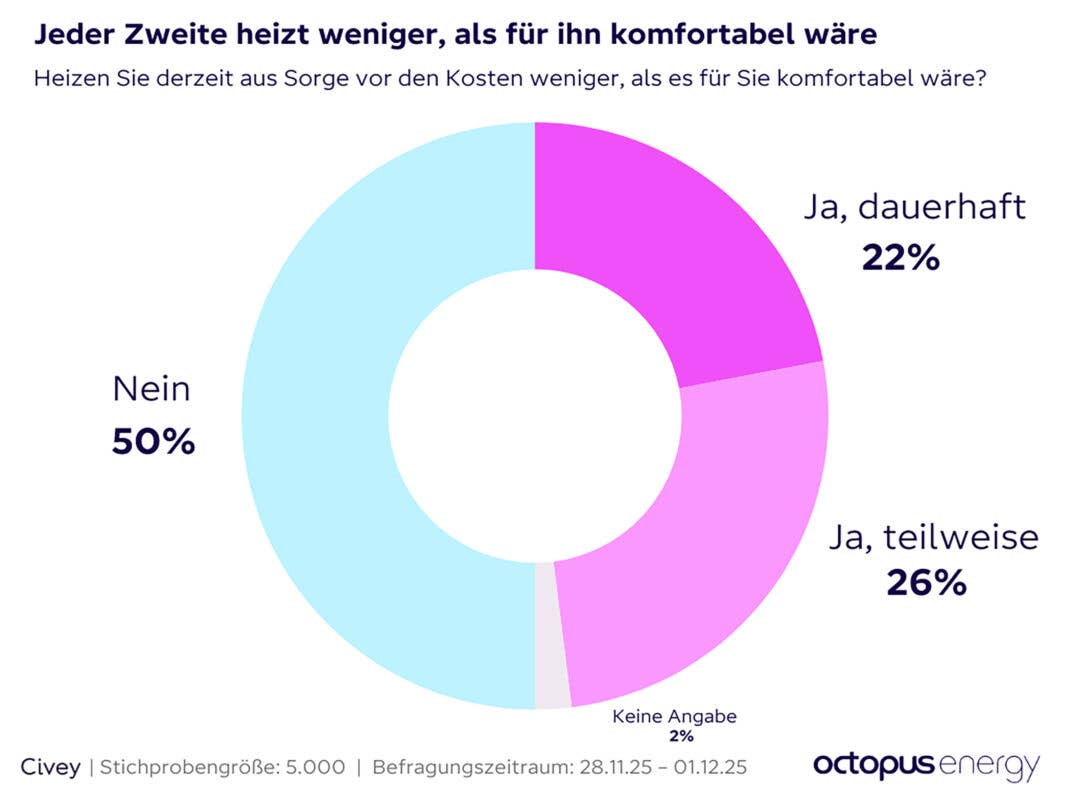

Jeder Zehnte konnte die letzte Heizrechnung nicht zahlen

Die neue Auswertung von Octopus Energy und Civey zeigt eine alarmierende Entwicklung: Etwa die Hälfte aller Deutschen heizt aktuell weniger, als sie es für angenehm halten würde. Und der Grund ist klar – die Sorge vor den Kosten. Besonders eindrücklich: Jeder Fünfte verzichtet dauerhaft auf die Wunschtemperatur, und ein Viertel zumindest teilweise. Damit ist klar, dass die steigenden Heizkosten längst nicht nur die finanziell Schwächsten treffen, sondern mitten im Alltag der Mittelschicht angekommen sind.

Noch deutlicher wird das Bild, wenn man auf die Zahlungsfähigkeit blickt: Jeder Zehnte konnte seine Heizkosten in den vergangenen zwei Jahren nicht oder nur verspätet zahlen. Ein Drittel musste an anderer Stelle spürbar sparen, um die Rechnungen zu begleichen. Besonders stark betroffen sind Mietende: Mit 29 Prozent ist der Anteil derjenigen, die dauerhaft frieren müssen, mehr als doppelt so hoch wie bei Hauseigentümern.

Und wenn es um Unterstützung geht, ist das Bild eindeutig: Die meisten Menschen sehen die Verantwortung nicht beim Vermieter, sondern bei der Politik und den Energieversorgern. Genau hier setzt nun ein neues Hilfsprogramm an, das vielen Betroffenen spürbare Entlastung versprechen soll.

Octopus Energy startet Hilfsprogramm über 1 Million Euro

Auf Basis der alarmierenden Ergebnisse hat Octopus Energy das neue Hilfsprogramm „OctoHilfe“ angekündigt. Der Energieversorger greift dabei auf Erfahrungen aus Großbritannien zurück: Dort wurden unter dem Programm „Octo Assist“ bereits über 100.000 Haushalte mit insgesamt 45 Millionen Euro unterstützt. Die bald startende Maßnahme soll gezielt jenen helfen, die unter den hohen Energiekosten besonders leiden.

Die Unterstützung umfasst mehrere Bausteine – von direkter finanzieller Entlastung über den Erlass von Grundgebühren bis hin zu flexiblen Zahlungsplänen und individueller Energieberatung. Interessierte können sich bereits jetzt auf der Webseite registrieren, um den Start der Antragsphase nicht zu verpassen.

Octopus-CEO Bastian Gierull betont dabei die gesellschaftliche Dimension: „Energiearmut trifft in Deutschland vor allem Menschen, die keine Stimme in der Öffentlichkeit haben. Als Energieversorger können wir zwar helfen, aber den Kern des Problems muss die Politik lösen.“ Vor allem fordert er faire Preise und ein Marktmodell, das die finanziell Schwächsten nicht zusätzlich belastet.

5.000 kostenlose Heizdecken – viertes Jahr in Folge

Parallel zur neuen Initiative läuft ein weiteres Hilfsprojekt bereits im vierten Jahr: Octopus Energy verschenkt mehr als 5.000 Heizdecken an bedürftige Kundinnen und Kunden. Die elektrischen Decken benötigen rund 4 Cent pro Stunde – eine extrem günstige Möglichkeit, zumindest punktuell für Wärme zu sorgen, ohne gleich das ganze Zuhause aufzuheizen.

Der Bedarf dafür ist enorm: Mehr als 60.000 Menschen haben sich in diesem Jahr bereits um eine der Decken beworben. Gerade für Haushalte, die im Winter bewusst frieren, kann eine solche Unterstützung einen spürbaren Unterschied machen.

Fazit: Erste Hilfe – doch das Grundproblem bleibt

Die neuen Daten zeigen klar, wie sehr die hohen Heizkosten inzwischen in den Alltag vieler Menschen eingreifen. Wenn jeder Fünfte in den eigenen vier Wänden friert und jeder Zehnte Rechnungen nicht mehr zahlen kann, geht es längst nicht mehr um Einzelfälle – sondern um ein strukturelles Problem.

Programme wie die „OctoHilfe“ oder die Aktion mit den Heizdecken schaffen kurzfristige Entlastung und können genau dort unterstützen, wo die Not am größten ist. Doch dauerhaft müssen Energiepreise sinken und faire Rahmenbedingungen entstehen – sonst bleibt das Frieren für viele ein wiederkehrender Wintergast.

Apps & Mobile Entwicklung

Herder-Supercomputer: Hunter-Nachfolger in Stuttgart setzt auf Zen 6 und MI430X

Der Hunter-Nachfolger Herder setzt am HLRS in Stuttgart ab 2027 erneut voll auf AMD. Dafür paart das System Venice-CPUs mit Instinct MI430X. Wie im Sommer beim ComputerBase-Besuch versprochen hat das Institut zusammen mit AMD und HPE, die die Blades dann zu einem Supercomputer zusammenbauen, noch 2025 Details bekannt gegeben.

Hawk -> Hunter -> Herder

Hunter ist am staatlich betriebenen Höchstleistungsrechenzentrum Stuttgart (HLRS) der Nachfolger von Hawk, die Vorstellung erfolgte Ende 2023. Hunter ist dabei nur ein Zwischenschritt auf dem Weg zu Herder, mit dem die Leistung am Standort weiter deutlich steigen soll. Herder geht offiziell 2027 in Betrieb, Hunter soll dann direkt heruntergefahren werden.

Viel schneller – aber auch viel energiehungriger

Denn Herder ist noch einmal deutlich schneller und effizienter unterwegs. Die AMD Instinct MI300A als „übergroße APU“ in Hunter sind bekanntlich ziemlich speziell, zumal sie in Hunter auch nur einen Teil des Gesamtsystems ausmachen. Neben 752 AMD Instinct MI300A gibt es da nämlich auch noch 512 AMD Epyc 9374F.

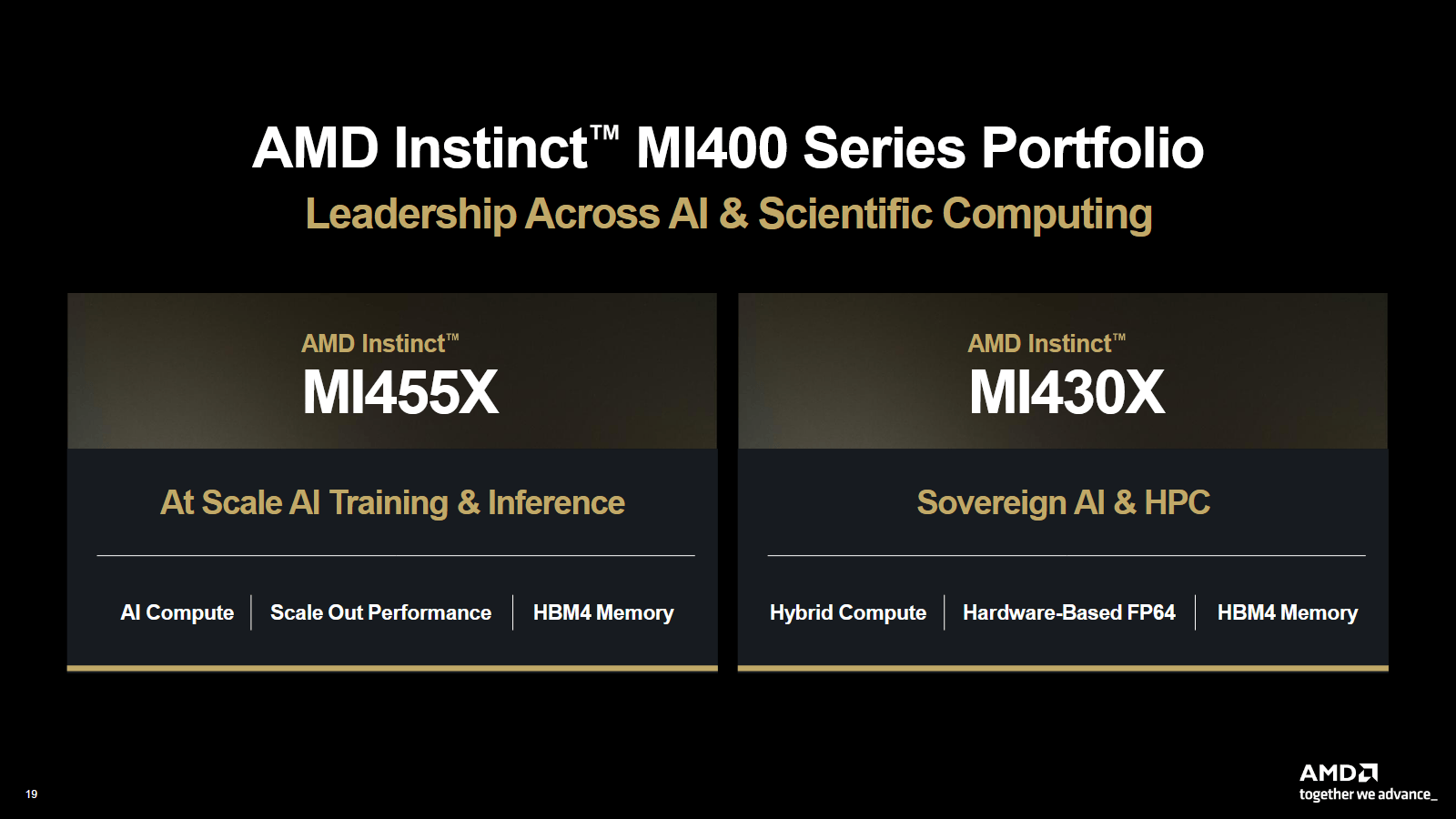

In Herder übernehmen wieder klassisch CPUs vom Typ AMD Epyc Venice mit neuen Zen-6-Kernen und und GPUs vom Typ Instinct MI430X. Damit steigt der Energieverbrauch des Gesamtsystem jedoch auch deutlich an, die CPUs rangieren im Normalfall bei 400 bis 500 Watt, und Instinct MI430X dürfte irgendwo im 2.000-Watt-Umfeld spielen, nachdem zuletzt MI455X anscheinend in die Region 2.500 Watt befördert wurde.

AMD Instinct MI430X bietet 432 GByte HBM4 und wurde von AMD erst vor einem Monat offiziell bestätigt. Der Beschleuniger weicht doch etwas von den klassischen AI-Beschleunigern ab: Denn statt nur FP8 und FP4 oder andere kleine Formate mit maximalem Fokus zu unterstützen, ist diese Lösung explizit auch noch für FP64 gedacht. MI430X ist also ein klassischer HPC-Beschleuniger.

Verpackt werden die CPUs und Beschleuniger in HPEs neuem Baukasten-System Cray Supercomputing GX5000. Dabei dürfte es sich um die Ausführung „HPE Cray Supercomputing GX350a Accelerated Blade“ handeln, die explizit eine Venice-CPU mit vier MI430X paart. 28 dieser Blades passen laut HPE in ein Rack, 112 MI430X sind dann in einem Kasten verbaut. Hinzu gesellt sich das HPE Cray Storage System E2000, HPE Slingshot 400 übernimmt als Netzwerk. Das System ist zu 100 Prozent wassergekühlt.

Da die passenden neuen Blades erst ab 2027 verfügbar sind und ausgeliefert werden, kann auch Herder nicht früher gebaut werden. Laut aktuellem Plan soll er aber noch Ende 2027 in Betrieb gehen können. Stehen wird das System im Neubau HLRS III, direkt nebenan des Gebäudes, in dem Hunter steht. Die Abwärme von dort soll vollständig für den Universitätscampus in Stuttgart genutzt werden.

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenIllustrierte Reise nach New York City › PAGE online

-

Datenschutz & Sicherheitvor 3 Monaten

Datenschutz & Sicherheitvor 3 MonatenJetzt patchen! Erneut Attacken auf SonicWall-Firewalls beobachtet

-

Künstliche Intelligenzvor 2 Monaten

Künstliche Intelligenzvor 2 MonatenAus Softwarefehlern lernen – Teil 3: Eine Marssonde gerät außer Kontrolle

-

Künstliche Intelligenzvor 2 Monaten

Top 10: Die beste kabellose Überwachungskamera im Test

-

UX/UI & Webdesignvor 3 Monaten

UX/UI & Webdesignvor 3 MonatenFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenSK Rapid Wien erneuert visuelle Identität

-

Entwicklung & Codevor 3 Wochen

Entwicklung & Codevor 3 WochenKommandozeile adé: Praktische, grafische Git-Verwaltung für den Mac

-

Social Mediavor 3 Monaten

Social Mediavor 3 MonatenSchluss mit FOMO im Social Media Marketing – Welche Trends und Features sind für Social Media Manager*innen wirklich relevant?