Datenschutz & Sicherheit

Damit müssen Menschen auf der Pride in Budapest rechnen

Dieser Plan könnte gründlich schiefgegangen sein. Mitte März beschloss das ungarische Parlament ein queerfeindliches Gesetz, das Veranstaltungen faktisch verbietet, die ein Leben jenseits von Heterosexualität und Cisgeschlechtlichkeit zeigen. Seitdem wächst die Solidarität mit der queeren Community. 15 EU-Staaten haben die EU-Kommission zu einem „schnellen Handeln“ aufgefordert. Aus ganz Europa werden Teilnehmer*innen für die Pride-Parade in Budapest erwartet – die trotz aller Hindernisse Ende Juni stattfinden soll.

„Das wird mit Sicherheit die bisher größte Pride-Parade in Ungarn werden“, sagte Viktória Radványi, Vorsitzende von Pride Budapest, bei der Eröffnung der Feierlichkeiten am vergangenen Wochenende.

Die Regierung rechtfertigt das Verbot mit der Behauptung, solche Veranstaltungen könnten die „körperliche, geistige und moralische Entwicklung“ von Kindern gefährden. Es ist das beliebte Muster autoritärer Regime: eine bedrohte, queere Minderheit wird zur angeblichen Gefahr erklärt; Homo- und Transfeindlichkeit werden zur Waffe gegen Demokratie und Menschenrechte.

Nach diesem Drehbuch entstand bereits das ungarische Kinderschutzgesetz von 2021, das Minderjährigen jede Information über Homosexualität oder Transgeschlechtlichkeit vorenthält. Werbung, Bücher, Filme zu diesen Themen sind seither für unter 18-Jährige tabu. Seit März gilt das Verbot nun auch für öffentliche Veranstaltungen wie die Pride, die diese Vielfalt feiern.

Demonstrieren als Ordnungswidrigkeit

Nicht nur die Veranstalter*innen, auch Teilnehmer*innen der Demonstration können auf dieser Grundlage bestraft werden. Das Verbot sieht vor, dass die Polizei sie per Gesichtserkennung identifizieren und mit Bußgeldern bis zu 500 Euro belegen darf.

Es steht viel auf dem Spiel im EU-Land Ungarn. Es geht um Menschenrechte aus der EU-Grundrechtecharta: Nichtdiskriminierung, Versammlungsfreiheit, freie Meinungsäußerung. Das wirft die Frage auf, wer es noch wagt, friedlich zu protestieren, wenn dafür biometrische Identifikation und Geldstrafe droht.

Was erwartet also die Teilnehmer*innen, die sich für die Pride angekündigt haben? Welche Rechte und Pflichten haben sie auf der Demonstration? Und was ist das für ein System zur Gesichtserkennung, mit dem Orbáns Regierung zu abschrecken will? Wir haben die wichtigsten Informationen zusammengetragen.

1. Wird die Pride überhaupt in Budapest stattfinden können?

Noch kämpfen die Veranstalter*innen darum, wie in vergangenen Jahren durch die Budapester Innenstadt ziehen zu dürfen, und zwar entlang der Prachtstraße Andrássy ut. Die Polizei hat die Route nicht genehmigt, mit der Begründung, es könne auf der Demonstration zu verbotenen Handlungen kommen. Demnach sei es nicht auszuschließen, dass auch Minderjährige teilnehmen; außerdem drohten auch „passive Opfer“ unter den Zuschauer*innen, so die Begründung. Stattdessen soll die Demonstration auf einer abgelegenen Pferderennbahn am Stadtrand stattfinden. Das wollen Veranstalter*innen nicht hinnehmen.

Am Montag schaltete sich dann Budapests liberaler Bürgermeister ein: Die Stadt werde die Pride als kommunales Fest für Liebe und Freiheit ausrichten, gemeinsam mit den Veranstalter*innen. Dafür brauche es keine Genehmigung der Polizei.

2. Warum darf die ungarische Polizei Gesichtserkennung bei der Pride einsetzen?

Bis vor Kurzem durfte die ungarische Polizei Gesichtserkennung nur bei Straftaten oder Delikten nutzen, die mit einer Freiheitsstrafe geahndet werden können. Mit der im März verabschiedeten Gesetzesänderung gilt das nicht mehr. Nun darf die Polizei die Technologie bei allen Arten von Gesetzesverstößen anwenden. Das heißt, sie kann jetzt auch Personen damit identifizieren, die eine geringfügige Ordnungswidrigkeiten begehen – etwa bei Rot über die Straße gehen oder bei der verbotenen Pride-Parade mitlaufen.

3. Wie funktioniert die biometrische Gesichtserkennung in Ungarn?

Ermittlungsbehörden arbeiten für die Identifikation unbekannter Personen mit dem Ungarischen Institut für Forensische Wissenschaften zusammen, eine dem Innenministerium unterstellte Behörde. Das Institut betreibt eine Datenbank zur biometrischen Gesichtserkennung, in die Bilder aus verschiedenen staatlichen Quellen fließen.

Gespeichert werden nicht die Bilder selbst, sondern ihre biometrische Entsprechung. Dazu erfasst das Institut die einzigartigen Merkmale der Gesichter, etwa die Abstände von Augen, Nase und Kinn. Das Ergebnis wird in Form einer mathematischen Repräsentation gespeichert.

Bekommt das Institut über eine Schnittstelle von der Polizei ein Bild zur Identifizierung übermittelt, kommt es zu einem automatisierten Abgleich mit der Datenbank. Die Polizei bekommt daraufhin die Treffer mit der höchsten Übereinstimmung angezeigt.

4. Wer ist in Ungarns Gesichter-Datenbank gespeichert?

Gesichter-Suchmaschinen für die Strafverfolgung wie Clearview AI durchsuchen des gesamte öffentliche Internet und speichern die biometrischen Profile der dort gefundenen Gesichter.

Im Gegensatz dazu hat das Forensische Institut in seiner Datenbank nur biometrische Daten aus staatlichen ungarischen Quellen: Personalausweise oder Führerscheine, Aufnahmen aus dem Melderegister und Bilder aus Polizeidatenbanken, die bei der Strafverfolgung, Einreise oder Flucht erstellt wurden.

Gesichtserkennung in Ungarn verstößt gegen EU-Gesetze

5. Womit müssen Pride-Protestierende aus dem Ausland rechnen?

Bürger*innen anderer Staaten tauchen in der Datenbank der ungarischen Behörden nicht auf, solange sie keine Aufenthaltsgenehmigung oder andere ungarische Dokumente besitzen. Das erklärt die NGO Hungarian Helsinki Committee, sie sich mit Fragen der Rechtsstaatlichkeit in Ungarn befasst. Laut ihrer Aussage kann die Polizei diese Personen daher nicht per Gesichtserkennung identifizieren.

Demonstrant*innen können jedoch sofort vor Ort mit einer Geldstrafe belegt werden. Das Hungarian Helsinki Committee weist darauf hin, dass Teilnehmer*innen das Recht haben, die sofortige Geldstrafe abzulehnen und nichts unterschreiben müssen. In diesem Fall leitet die Polizei ein Ordnungswidrigkeitsverfahren ein und die Betroffenen werden per Post über die Geldstrafe informiert. Sie können dann darauf bestehen, von der Polizei angehört zu werden und Widerspruch vor Gericht einlegen. Das Gericht kann die Rechtmäßigkeit der Strafe überprüfen, diese aufheben oder reduzieren.

6. Wie schnell kann die ungarische Polizei Protestierende identifizieren?

Schneller als etwa einen Bankräuber oder Steuerflüchtigen. Im Fall einer Straftat ist vorgesehen, dass zwei Fachleute des Forensischen Institutes die Ergebnisse des automatisierten Abgleichs unabhängig voneinander bestätigen müssen – erst damit gilt das Ergebnis als Treffer. Geht es dagegen nur um ein geringfügiges Vergehen wie die Teilnahme an der Pride, entfällt diese Kontrolle.

Die Polizei hat nun eine direkte Schnittstelle zur Datenbank und kann darüber einen automatisierten Abgleich beantragen. Die Hungarian Civil Liberties Union (HCLU), die sich für den Schutz von Grundrechten in Ungarn einsetzt, spricht von einer Identifikation in „Echtzeit oder annähernder Echtzeit“.

Wie schnell der Prozess genau abläuft, weiß allerdings auch die HCLU nicht. Das Forensische Institut hat auf ihre Anfrage nach dem Informationsfreiheitsgesetz nur ausweichend geantwortet: Der automatisierte Abgleich falle nicht in den Zuständigkeitsbereich des Institutes, heißt es dazu.

Laut der neuen KI-Verordnung der EU wäre eine Identifikation in Echtzeit nur bei Verdacht auf eine Straftat erlaubt; in keinem Fall dürfte Ungarn sie für die Ermittlung der Identität bei einer Ordnungswidrigkeit einsetzen.

7. Wäre die Gesichtserkennung nicht von den Menschenmassen überfordert?

Wahrscheinlich ja. „Das System ist nicht für die Massenüberwachung von Zehntausenden von Menschen konzipiert“, sagt der Jurist Ádám Remport, der sich für die HCLU mit dem Fall beschäftigt.

Das liegt an den Verfahren: Um eine Person identifizieren zu lassen, muss die Polizei händisch einen Fall im System anlegen. Bei mehreren Zehntausend Teilnehmenden würde das sehr viel Zeit erfordern. Zwar könnten auch mehrere Personen im System zu einem Fall zusammengezogen werden, rechtlich wäre das kein Problem. Aber ob das auch in einer Größenordnung von mehreren Zehntausend Personen funktioniert, da ist sich auch Ádám Remport nicht sicher. Bisher sei so ein Fall nicht vorgekommen.

Sollte die Polizei die zu identifizierenden Personen hingegen einzeln im System bearbeiten müssen, würde das sehr lange dauern, sagt Remport. Und: „Wenn die Behörden versuchen würden, alle Teilnehmer einer so großen Demonstration zu identifizieren, könnte das möglicherweise die Gesichtserkennungssysteme Ungarns überlasten.“

Der Jurist sieht noch ein weiteres Nadelöhr im System: Verdächtige hätten das Recht auf eine polizeiliche Anhörung, wenn sie wegen einer Ordnungswidrigkeit mit einer Geldstrafe belegt werden. Wenn die Polizei das Verfahren nicht einstellt oder die Geldstrafe nicht herabsetzt, können sie sich an ein Gericht wenden. „Bei einem massiven Einsatz der Gesichtserkennung könnte die schiere Menge der Verfahren die Polizei und die Justiz überfordern.“

Eine Entwarnung ist das jedoch nicht: Teilnehmer*innen müssten auch Wochen später noch damit rechnen, verfolgt zu werden. Aktuell dürfen Aufnahmen aus Überwachungskameras in Ungarn 30 Tage lang gespeichert werden.

8. Wie gefährlich sind falsche Treffer bei der Gesichtserkennung?

Mit dem Wegfall der menschlichen Kontrollen steigt die Wahrscheinlichkeit, dass falsche Treffer bei der Polizei landen, warnt Ádám Remport. Das heißt, die Polizei verdächtigt Personen, die nicht in der Aufnahme zu sehen waren. „Rechtlich gibt es so gut wie keine Sicherheitsvorkehrungen“, so Remport. Einzelne Beamt*innen werden dann entscheiden müssen, ob ein Treffer tatsächlich die gesuchte Person zeigt.

„Bei Tausenden solcher Anfragen, wird der Druck groß sein, so schnell wie möglich zu arbeiten“, erklärt Remport. Auch würden viele ausländische Teilnehmende auf der Demonstration sein, die nicht in der ungarischen Datenbank erfasst sind. Das System könne für sie aber womöglich ähnliche Gesichter in der Datenbank finden. So könne es zu vielen falschen Entscheidungen kommen.

Hier werden Protestierende mit Gesichtserkennung verfolgt

9. Welche Software nutzt Ungarn zur Gesichtserkennung?

Bislang ist nicht bekannt, welche Software das Forensische Institut und damit die Polizei für die Gesichtserkennung einsetzt. Auf eine Frage des HCLU nach Marke und Typ antwortete das Institut, es nutze die verwendete Software nur als Klient und machte darüber hinaus keine Angaben.

Mehrere Tech-Konzerne und Unternehmen bieten Gesichtserkennungssoftware als Dienstleistung für Strafverfolgungsbehörden an, darunter US-Konzerne wie Microsoft und Amazon, aber auch chinesische Unternehmen für Überwachungstechnologien wie Dahua.

10. Wo wird der öffentliche Raum in Budapest bereits per Kamera überwacht?

Für die Identifikation von Teilnehmer*innen kann die Polizei auf Bilder aus Tausenden Überwachungskameras zurückgreifen. Laut einer Datenvisualisierung des Investigativmediums Atlo waren bereits 2019 mindestens 2.500 Kameras im Budapester Stadtgebiet installiert, betrieben von der Polizei, den Verkehrsbetrieben und den einzelnen Bezirken. Die höchste Überwachungsdichte haben dabei die Bezirke der Innenstadt – und damit auch die von den Veranstalter*innen gewünschte Route der Pride, die entlang der Prachtstraße Andrássy út führen soll.

Zusätzlich zu den fest installierten Kameras kann die Polizei außerdem mobile Kameras einsetzen, um die Demonstration zu filmen – und tut das auch regelmäßig, schreibt etwa das Hungarian Helsinki Committee.

11. Wie können sich Pride-Protestierende vor Gesichtserkennung schützen?

Das ist schwer zu sagen, weil nicht bekannt ist, welches System die ungarische Polizei zur Erkennung einsetzt. Leitfäden der Polizei zur Beschaffenheit der einzureichenden Bilder deuten aber darauf hin, dass maskierte Gesichter vom System nicht oder schlechter erkannt werden.

Das Hungarian Helsinki Committee rät allerdings davon ab, eine Maske zu tragen, sei es auch nicht eine medizinische. Denn auch in Ungarn gilt ein Vermummungsverbot auf Demonstrationen: Wer eine Maske trägt, begeht damit eine Straftat – während der Besuch der Pride nur eine Ordnungswidrigkeit wäre. Auch könnte die Maskierung eher dazu führen, dass man von der Polizei aufgefordert wird, sich auszuweisen. Und ja: Demonstrant*innen müssen einen Ausweis bei sich tragen und auf Aufforderung vorzeigen können.

12. Müssen Protestierende in Budapest mit Festnahmen oder Polizeigewalt rechnen?

Wer sich in Ungarn auf Aufforderung der Polizei nicht ausweist und sich anderen Anweisungen widersetzt, kann auch mit auf die Wache genommen und dort bis zu 12 Stunden lang festgehalten werden. Auch physische Gewalt darf die Polizei bei Widerstand einsetzen. Das gilt für die gesamte Demonstration, sollte diese aufgelöst werden und nicht freiwillig den Platz verlassen. Wie man sich in solche riskanten Situationen verhalten sollte, dazu informiert das Hungarian Helsinki Committee in einem ausführlichen FAQ. Die NGO hat zudem angekündigt, Betroffene rechtlich zu unterstützen.

Datenschutz & Sicherheit

Datenschutz und KI: Schluss mit der Zögerlichkeit!

Hinter weitverbreiteten KI-Anwendungen stehen generative Sprach- und Bildmodelle, die mit riesigen Datenmengen gefüttert werden, auch mit personenbezogenen Daten. Das Problem: Teile der Trainingsdaten, darunter personenbezogene, lassen sich aus vielen der Modelle extrahieren. Unter welchen Umständen sich ein Modell zu viel „merkt“ und wie sich das verhindern lässt, ist bislang wenig erforscht. Zugleich werden Extrahierungsmethoden immer besser. Anbieter*innen können bislang nicht verhindern, dass Modelle personenbezogene Trainingsdaten ausgeben. Auch Chatbots können personenbezogene Daten von anderen verraten.

Außerdem „halluzinieren“ die Modelle. Sie generieren also falsche Informationen, die nicht in den Trainingsdaten enthalten sind. Weil KI-Unternehmen diese nicht offenlegen, können Forscher*innen nicht zuverlässig messen, wann ein Modell Informationen erfindet und wann es unrichtige Trainingsdaten wiedergibt. Zuverlässige Methoden zur Vermeidung von Halluzinationen gibt es bisher nicht.

Werden personenbezogene Daten aus einem Modell extrahiert, kann für Betroffene gerade die Kombination aus „Erinnerung“ und „Halluzination“ gefährlich sein. Ein mit personenbezogenen Daten trainiertes Modell generiert unter Umständen Falschinformationen über sie. Gerade bei öffentlichen Modellen besteht das Risiko, dass Nutzer*innen diese Informationen unkritisch weiterverbreiten.

Meta fragt lieber nicht um Erlaubnis

Mit Llama (Large Language Model Meta AI) ist auch Meta an dem KI-Rennen beteiligt. Meta nutzt Llama für eigene KI-Funktionen wie Transkriptions- oder Suchfeatures auf Instagram, Facebook und WhatsApp sowie für Chatbots oder in KI-Brillen, die das Unternehmen anbietet. Außerdem stellt Meta seine Modelle anderen zur Nutzung bereit. So können etwa Forscher*innen die Modelle testen oder Unternehmen auf Basis von Llama KI-Dienstleistungen oder -Produkte anbieten.

Im Juni 2024 informierte Meta die Nutzer*innen von Instagram und Facebook über eine Aktualisierung seiner Datenschutzrichtlinie. Diese Aktualisierung ließ Metas Vorhaben erkennen, seine KI-Modelle mit Nutzer*innendaten zu trainieren. Die Nutzer*innen konnten dem zwar widersprechen, die Widerspruchsmöglichkeit war jedoch schwer auffindbar.

Nachdem Datenschutzorganisationen wie noyb Meta scharf kritisierten, veröffentlichte der Konzern noch gleichen Monat weitere Informationen zum geplanten Training. Demnach beabsichtigte der Konzern, nur noch öffentliche Daten für das Training zu verwenden. Kurz darauf verkündete Meta, die irische Datenschutzbehörde verzögere das Training in der EU. Im April 2025 verkündete der Konzern dann den baldigen Trainingsstart.

Was trainiert Meta eigentlich mit welchen Daten?

Inzwischen hat der Konzern damit begonnen, seine KI mit den Daten europäischer Nutzer*innen zu trainieren. Unklar ist weiterhin, welche Daten dafür genau genutzt werden. Meta stellt im Vergleich zu anderen KI-Unternehmen zwar mehr Informationen über das Training mit Social-Media-Daten bereit. Diese Informationen haben sich aber immer wieder verändert und lassen Fragen offen.

Das betrifft insbesondere den Umgang mit sensiblen Daten. Bei Llama handelt es sich um ein multimodales Sprachmodell, das neben Texten auch Bilder, Videos und Tondateien verarbeitet. Der für das Training genutzte Social-Media-Content umfasst damit etwa auch Fotos der Nutzer*innen. Metas Datenschutzinformationen verweisen auf öffentliche Inhalte wie Beiträge, Kommentare und Audiospuren.

Inzwischen heißt es in den Datenschutzinformationen, dass auch Daten von Drittpartner*innen und KI-Interaktionen für die KI-Entwicklung genutzt würden. Als Beispiele für KI-Interaktionen nennt Meta Nachrichten, die Nutzer*innen oder andere Personen von der KI erhalten, mit ihr teilen oder an diese senden.

Diese Angaben schließen private Sprachnachrichten und Transkriptionen nicht aus. Metas Umschreibung passt auch auf Chatverläufe mit Chatbots. Solche Chatverläufe können besonders sensible Daten enthalten, wenn etwa Chatbots für intime Gespräche zu mentaler Gesundheit oder parasoziale romantische Beziehungen genutzt werden.

Verbraucherzentrale scheitert vor Gericht

Um den Beginn des Trainings zu verhindern, hat die Verbraucherzentrale Nordrhein-Westfalen im Mai 2025 einen Eilantrag beim Oberlandesgericht (OLG) Köln gestellt. Sie argumentierte insbesondere, dass Meta das Training nicht auf eine wirksame Rechtsgrundlage stützen könne, ist mit dem Eilantrag jedoch gescheitert. Das Urteil und Einblicke in die mündliche Verhandlung in Köln offenbaren erhebliche Mängel.

Meta hatte sich entschieden, keine Einwilligungen einzuholen, sondern beruft sich auf ein berechtigtes Interesse an der Nutzung der Daten für KI-Training. Die Verbraucherzentrale hält das für unzureichend, doch das Gericht folgt Metas Argumentation in seinem Urteil. Nach der Datenschutzgrundverordnung (DSGVO) können berechtigte Interessen die Verarbeitung personenbezogener Daten rechtfertigen, solange die Interessen Betroffener nicht schwerer wiegen. Dabei müssen diese der Datenverarbeitung aber widersprechen können.

Die Verbraucherzentrale NRW hat darauf hingewiesen, dass nicht alle Betroffenen widersprechen können. Facebook- und Instagram-Beiträge enthalten zuhauf personenbezogene Daten von Nicht-Nutzer*innen. Die Widerspruchsfunktion steht aber nur Nutzer*innen offen. Das Gericht ignoriert diesen Einwand. Zudem behauptet es ohne Begründung und trotz gegenteiliger Hinweise, Meta erfülle die Anforderungen der DSGVO an den Schutz von Minderjährigen.

Das Gericht halluziniert niedrige Risiken herbei

Berechtigte Interessen geben außerdem keine Rechtsgrundlage für Verarbeitungen her, die für Betroffene zu riskant sind. Das OLG Köln behauptet, die Risiken für Nutzer*innen seien gering. Dabei legt das Urteil nahe, dass die Richter*innen nicht verstanden haben, was Meta trainiert. Das Wort „Llama“ taucht im gesamten Urteil nicht auf. Auch beschreibt das Gericht keine Anwendungsszenarien.

Auf diese kommt es aber entscheidend an. Ein Transkriptionsfeature gibt wahrscheinlich keine extrahierbaren Daten aus. Aus Llama selbst werden jedoch sicher Daten extrahiert. Forscher*innen wenden Extrahierungsmethoden auf alle bekannten Modelle an. Je nachdem, welche Arten von Daten wie gut extrahierbar sind, könnte es dabei versehentlich auch zu Datenlecks kommen.

Gerichte prüfen in Eilverfahren die Rechtslage nur „kursorisch“, also nicht im Detail. Das OLG Köln reiht dabei aber mit großem Selbstbewusstsein Behauptungen aneinander, die aus Sicht der Datenschutzforschung haltlos sind. Selbst wenn Metas Training transparent genug wäre, fehlt es an tragfähigen Forschungsergebnissen für die Einschätzung des Gerichts.

Ein grober Fehler des Urteils betrifft besondere Kategorien personenbezogener Daten. Das sind sensible Daten, die die DSGVO besonders schützt, zum Beispiel Daten über Race, religiöse Anschauungen oder sexuelle Orientierungen. Social-Media-Daten enthalten viele solcher Daten. Besondere Kategorien personenbezogener Daten dürfen nicht auf Basis berechtigter Interessen verarbeitet werden, sondern nur unter strengeren Voraussetzungen, in vielen Fällen nur aufgrund von Einwilligungen. Das OLG Köln stört sich daran nicht.

Stattdessen behauptet das Gericht, dass die Anwendung der besonderen Schutzanforderungen nicht geboten sei. Das Urteil stellt hier wieder auf ein nicht weiter begründetes geringes Risiko ab. Dabei kommt es gerade im Bereich des maschinellen Lernens leicht zu unbemerkten Modellbias, also zu systematischen Fehleinschätzungen, die zum Beispiel zu rassistischer Diskriminierung führen. Besondere Kategorien personenbezogener Daten bergen dabei potenziell besonders hohe Risiken.

Bedenkliche Informationslage

Bedenklich ist zudem die Informationslage, auf die sich das Gericht stützt. In diesem Fall sind das vor allem die Angaben von Meta selbst. Das ist in einem Eilverfahren an sich nicht zu beanstanden – weil es schnell gehen muss, gelten geringere Beweisanforderungen. Gerichte arbeiten daher mit eidesstattlichen Versicherungen, formellen Erklärungen der Parteien. Um Falschangaben vorzubeugen, sind falsche eidesstattliche Versicherungen nach dem Strafgesetzbuch strafbar.

Das Urteil stellt entscheidend auf eidesstattliche Versicherungen von Metas Produktmanager für generative KI ab. Zwei in der mündlichen Verhandlung in Köln anwesende Personen berichten allerdings, dass die Versicherungen nie formgerecht abgegeben worden sind. (Die Autorin hat von zwei in der Verhandlung in Köln anwesenden Personen Informationen zum Ablauf der mündlichen Verhandlung und dabei getroffenen Aussagen des Gerichts erhalten. Eine der Personen ist seitens der klagenden Verbraucherzentrale am Verfahren beteiligt, die andere Person hat den Prozess beobachtet, ohne daran beteiligt zu sein.)

Wir sind ein spendenfinanziertes Medium

Unterstütze auch Du unsere Arbeit mit einer Spende.

Eidesstattliche Versicherungen müssen mündlich oder im Original mit händischer Unterschrift abgegeben werden. Selbst wenn die Erklärungen von Meta formgerecht wären, hätte sich das OLG Köln besser nicht darauf verlassen. Es gibt zwar keine Anzeichen dafür, dass diese Falschangaben enthalten. Durch das deutsche Strafgesetzbuch wäre deren Richtigkeit aber nicht abgesichert: Falls der in Kalifornien ansässige Manager nicht einreisen will, hätten Falschangaben keine strafrechtlichen Folgen für ihn.

Zudem legt das Urteil nahe, dass Metas Erklärungen inhaltlich dünn sind. Sie bestätigen etwa das Funktionieren der Widerspruchsfunktion. Eine Pressemitteilung der für Meta zuständigen irischen Datenschutzbehörde (Data Protection Commission, DPC) zeigt jedoch, dass die Behörde Meta zur Nachbesserung der Widerspruchsfunktion aufgefordert hat. Es bleibt somit zweifelhaft, ob Widersprüche in der Vergangenheit einfach genug möglich waren und funktioniert haben.

Datenschutzbehörden lassen Meta erst mal machen

Auch die Pressemitteilung der irischen Datenschutzbehörde und der Umgang des Gerichts damit verdienen besondere Aufmerksamkeit. Die für ihre Nachsicht gegenüber Datenkonzernen bekannte Behörde hat die Pressemitteilung am Vorabend der mündlichen Verhandlung in Köln veröffentlicht. Sollte die Behörde sich etwa mit Meta abgestimmt und so das Verfahren beeinflusst haben?

Das OLG Köln hat nach Berichten Anwesender schon in der mündlichen Verhandlung signalisiert, der Rechtsauffassung der irischen Behörde wahrscheinlich folgen zu müssen, warum auch immer das Gericht sich an deren Einschätzung auch nur lose gebunden fühlt. Das ist nicht nur im Hinblick auf die Gewaltenteilung bedenklich. Die Pressemitteilung enthält auch keinerlei Rechtsauffassung zur Frage nach der Datenschutzkonformität, der das Gericht folgen könnte. Sie enthält schlicht gar keine rechtliche Einschätzung. Es heißt lediglich, Meta habe in Absprache mit der Behörde Maßnahmen zur Verbesserung des Datenschutzes ergriffen und verfolge die Umsetzung weiter.

Aus der Pressemitteilung wird ersichtlich, dass die irische Behörde Meta nur beraten hat. Das war dem OLG Köln auch von Metas Hauptaufsichtsbehörde in Deutschland, dem Hamburger Datenschutzbeauftragten, bekannt. Im Urteil heißt es ausdrücklich, die Behörde habe Meta das Training „bislang“ nicht untersagt und beobachte derzeit die Folgen der Trainings.

Der Hamburger Datenschutzbeauftragte hatte im Juli 2024 die Datenschutzauswirkungen des Trainings generativer Sprachmodelle noch unterschätzt. Nach Berichten aus der mündlichen Verhandlung hat er angesichts seiner Einblicke in Metas Training diese Auffassung zurückgenommen, erhebliche Datenschutzbedenken geäußert und zunächst sogar ein eigenes Verfahren gegen Meta angekündigt. Außerdem berichtete er, dass die irische Behörde plane, ein Verletzungsverfahren im Oktober einzuleiten. Das spricht dafür, dass europäische Datenschutzbehörden von Verstößen wissen, Meta aber zunächst gewähren lassen.

Wider den KI-Hype

Die Bedeutung des Kölner Verfahrens weist über Meta und über Deutschland hinaus. Das Urteil und die Vorgänge im Prozess legen nahe, dass europäische Gerichte und Aufsichtsbehörden bei KI dem Ansatz „Abwarten und Teetrinken“ folgen. Es lässt sich nur spekulieren, welche Rollen hier der Druck des KI-Hypes, Innovationspläne der EU oder auch blanke Naivität spielen.

Dabei macht die DSGVO nicht nur klare Vorgaben an KI-Unternehmen, sondern bietet diesen auch ausreichende Möglichkeiten, sich an die Vorgaben zu halten. Demnach müssen KI-Unternehmen die Datenschutzkonformität ihrer Vorhaben begründet nachweisen. Sie dürfen ihre Modelle trainieren und testen – allerdings nur zu reinen Forschungszwecken und ohne die KI in der Praxis einzusetzen – und damit blind auf die Menschheit loszulassen. Gerichte und Aufsichtsbehörden sollten diese Vorgaben durchsetzen, anstatt sich dem KI-Hype zu beugen.

Prof. Dr. Paulina Jo Pesch ist Juniorprofessorin für Bürgerliches Recht sowie das Recht der Digitalisierung, des Datenschutzes und der Künstlichen Intelligenz am Institut für Recht und Technik der Friedrich-Alexander-Universität Erlangen-Nürnberg. Sie koordiniert das vom Bundesministerium für Forschung, Technologie und Raumfahrt (BMFTR) geförderte interdisziplinäre Forschungsprojekt SMARD-GOV, das Datenschutzaspekte großer Sprachmodelle erforscht.

Eine englischsprachige Langfassung der Analyse des Verfahrens sowie eines weiteren Verfahrens beim OLG Schleswig-Holstein ist im CR-online blog erschienen.

Datenschutz & Sicherheit

Cybercrime: Microsoft gelingt Schlag gegen Phishing-Trojaner RaccoonO365

Die Digital Crime Unit (DCU) von Microsoft hat eigenen Angaben zufolge einen Erfolg gegen Cyberkriminelle erzielt, die auf der Jagd nach Microsoft-365-Accounts sind. Dafür haben sie 338 mit dem Phishing-Trojaner RaccoonO365 im Zusammenhang stehende Websites aus dem Verkehr gezogen.

Crimeware-as-a-Service

Wie aus einem Bericht zu der Aktion hervorgeht, ist dadurch ein großer Teil der Infrastruktur lahmgelegt und Angreifer haben so unter anderem keinen Zugriff mehr auf kompromittierte PCs von Opfern. Intern bezeichnet Microsoft den Trojaner als Storm-2246.

Erschreckend professionell: Cybercrime-Anwärter haben die Wahl aus verschiedenen Abo-Stufen inklusive Discounts und Support.

(Bild: Microsoft)

Die Basis der Kampagne ist der Schädling RaccoonO365. Dabei handelt es sich um ein Phishing-Kit, das Kriminelle mieten können. Das All-in-One-Paket erstellt unter anderem betrügerische Mails und Websites mit dem Branding von Microsoft, um Opfer aufs Glatteis zu führen und ihnen ihre Accountdaten zu entlocken. Problematisch dabei ist, dass dem Bericht zufolge selbst Anfänger mit der Bedienung klarkommen sollen, sodass der Cybercrime-Einstieg erschreckend niederschwellig ist.

Die DCU erläutert, dass der Schädling in einer Gruppe des Messengers Telegram verkauft wurde. Diese Gruppe habe mehr als 850 Mitglieder und die Kriminellen sollen mit dem Verkauf von RaccoonO365 bislang rund 100.000 US-Dollar Profit gemacht haben. Die Kriminellen sollen sehr professionell vorgehen und bieten unter anderem sogar Support für ihre Kunden an.

Verbreitung

Microsoft gibt an, dass RaccoonO365 seit Juli 2024 in 94 Ländern eingesetzt wurde, um rund 5000 Accounts zu kapern. Darunter seien primär Opfer in den USA, auch aus dem Gesundheitssektor. Ob die Phishing-Kampagne durch den erfolgreichen Schlag nun endgültig beendet ist, geht aus dem Bericht nicht konkret hervor.

(des)

Datenschutz & Sicherheit

Biometrische Gangerkennung: Zeige mir, wie du gehst, und ich sage dir, wer du bist

Biometrische Gangerkennung soll Menschen aus der Ferne identifizieren können, selbst wenn sie ihr Gesicht verhüllen. Unser Überblick zeigt, wie die Technologie funktioniert und wo sie bereits eingesetzt wird. Menschenrechtler*innen fordern ein Verbot.

Unser Gang ist besonders. Wir unterscheiden uns zum Beispiel darin, wie wir unsere Füße aufsetzen, unsere Arme beim Gehen schlenkern lassen oder wie lange unsere Schritte dauern. Solche Merkmale sind individuell und potenziell auch verräterisch, denn sie werden wie beiläufig bei der Videoüberwachung mit aufgezeichnet. Und anders als bei der biometrischen Gesichtserkennung kann man nicht einfach eine Maske aufsetzen, um den eigenen Gang zu verschleiern.

Wenn man Menschen auch von Weitem anhand ihrer Körpermerkmale erkennt, nennt man das biometrische Fernidentifizierung. In der öffentlichen Debatte darüber geht es meist um Gesichtserkennung. Dabei gibt es noch weitere Möglichkeiten, Menschen biometrisch zu erkennen. Eine solche Methode ist die biometrische Gangerkennung.

Verboten ist der Einsatz der Technologie in der EU nicht, im Gegenteil. Dort, wo die KI-Verordnung (AI Act) den Staaten Spielraum für biometrische Gesichtserkennung lässt, können Behörden auch andere biometrische Technologien einsetzen – auch wenn darüber selten diskutiert wird.

Dieser Artikel erklärt, was Gangerkennung bereits kann, und wo sie schon angewandt wird. Die Organisationen Amnesty International und AlgorithmWatch warnen vor der Technologie – die beispielsweise die Polizei bereits auf dem Schirm hat. Und im Auftrag der Europäischen Union erkunden Forscher*innen in Österreich ihren Einsatz an der EU-Grenze.

- Wie funktioniert Gangerkennung?

- Wie korrekt ist Gangerkennung?

- Deutschland: Polizei bildet sich zu Gangerkennung weiter

- Deutschland: Erkennung gehender Personen im Supermarkt

- EU: Forschung an Gangerkennung für die Grenze

- China und Russland: Gangerkennung über 50 Meter Entfernung

- Grundrechte in Gefahr: Menschenrechtler*innen fordern Verbot

Wie funktioniert Gangerkennung?

Auch Menschen können andere Personen anhand ihres Gang identifizieren. Unter anderem in Großbritannien werden dafür Sachverständige vor Gerichte geladen, um etwa die Identität eines Tatverdächtigen festzumachen. Einer Studie über diese forensische Gangerkennung aus dem Jahr 2018 zufolge würden solche Gang-Expert*innen allerdings noch wenig mit Software arbeiten.

Inzwischen gibt es zunehmend technisch gestützte Methoden für Gangerkennung, die gemeinhin als „KI“ bezeichnet werden. Einer der Menschen, der dazu forscht, ist Simon Hanisch. „Gangerkennung funktioniert mittlerweile sehr gut mithilfe von Deep Learning und Objekterkennung“, erklärt der Forscher, der am Karlsruher Institut für Technologie zur Anonymisierung biometrischer Daten arbeitet.

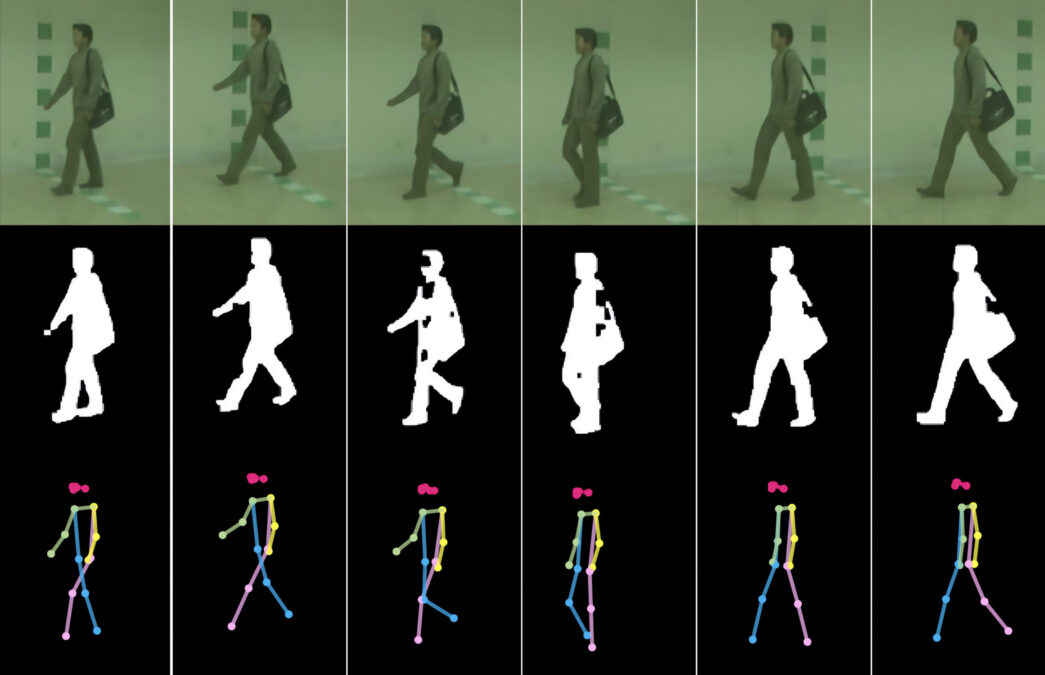

Im Gespräch mit netzpolitik.org beschreibt er eine Art, wie Gangerkennung per Software heutzutage funktionieren kann: Zuerst zerlegt die Software das Video einer laufenden Person in einzelne Frames, also Momentaufnahmen. So lassen sich etwa die Phasen eines Schritts nachvollziehen, die Bewegungen von Armen und Beinen. Danach stellt die Software die Umrisse der Person frei. Sie sieht dann so ähnlich aus wie ein Ampelmännchen. Schließlich legt die Software die Umrisse aus mehreren Frames in Graustufen übereinander. Das sieht dann aus wie ein Ampelmännchen mit vielen Armen und Beinen.

Auf diese Weise sollen möglichst einzigartige Profile entstehen, anhand derer sich Menschen voneinander unterscheiden lassen – und wiedererkennen.

Wie korrekt ist Gangerkennung?

Zu Gangerkennung sind in den vergangenen Jahren viele Studien erschienen. Sie beschreiben mehrere Verfahren, die verschieden genau sind. Manche Forschende verweisen auf äußere Faktoren, die Einfluss auf unseren Gang haben und deshalb die Wiedererkennung erschweren würden. Zum Beispiel könnten Schuhe, die Beschaffenheit des Bodens oder Taschen das Gangprofil verändern.

So stellten auch die Autor*innen der oben erwähnten Studie zur forensischen Gangerkennung fest: Der Beweiswert eines menschlichen Gang-Gutachtens vor Gericht sei relativ niedrig. Das war jedoch im Jahr 2018. Mittlerweile sind die technischen Mittel ausgereift genug, um Personen auch trotz sich ändernder Bedingungen zu identifizieren, wie Simon Hanisch erklärt. Die Software könnte auch Veränderungen des Gangs einbeziehen.

Eine KI ist jedoch nur so gut wie die Daten, mit denen sie trainiert wurde. „Für das Training benötigt man viele Daten“, sagt Hanisch, „die entsprechenden Datensätze gibt es aber heute schon“. Um nur eine einzelne Person anhand ihres Gangs über mehrere Überwachungskameras hinweg zu verfolgen, brauche es nicht sehr viele Daten, so der Forscher. Zur Identifikation würden bereits einige Beispiele genügen, die zeigen, wie diese Person geht.

Anders sehe es aus, wenn eine beliebige Person in einem Video eindeutig identifiziert werden soll, erklärt Hanisch. Dafür „wäre eine große Datenbank erforderlich, in der Gangbeispiele aller Personen vorhanden sind – analog zu einer Datenbank mit Gesichtsbildern oder Fingerabdrücken.“ Im Moment gibt es allerdings keine Anzeichen dafür, dass in Deutschland größere Datenbanken mit biometrischen Gangprofilen existieren.

Eine wichtige Komponente könne auch die Zeitspanne sein. Wie verändert sich der Gang eines Menschen über Jahrzehnte? Es gibt „noch nicht genug Forschung, um sagen zu können, wie gut die Gangerkennung über die Zeit funktioniert“, sagt Hanisch. „Wahrscheinlich wird es einen großen Einfluss haben; allerdings sind mir keine Studien bekannt, die das wirklich gut untersucht haben.“

Für eine realistische Anwendung von Gangerkennung brauche es noch mehr Forschung. „Meiner allgemeinen Vermutung nach würde die Gangerkennung in einem realistischen Setting außerhalb des Labors wahrscheinlich eher mäßig gut funktionieren.“

Trotzdem warnt Hanisch vor der Technologie: „Man sollte nicht vergessen, dass sich biometrische Merkmale kombinieren lassen, um bessere Ergebnisse zu erzielen, beispielsweise Gangerkennung mit Gesichtserkennung.“ Das Potenzial für staatliche Überwachung sieht Hanisch durchaus. Besonders sei es für Behörden vorteilhaft, Gangerkennung einzusetzen, weil „man seinen Gang nur schwer verstecken kann“.

Deutschland: Polizei bildet sich zu Gangerkennung weiter

Wir haben bei deutschen Polizeibehörden nachgefragt, ob sie biometrische Gangerkennung einsetzen oder sich zumindest damit beschäftigen. Die Landeskriminalämter (LKAs) aus 16 Bundesländern sowie das Bundeskriminalamt (BKA) haben den Einsatz computergestützter biometrischer Gangerkennung verneint.

Laut der Pressestelle des LKA Hessen „fehlt es an einer Datenbank, gegen die ein solches System Daten abgleichen könnte“. Gangerkennung hätten die Beamt*innen in Hessen allerdings auf dem Schirm. „Denkbar wären 1:1 Vergleiche, beispielsweise den Gang einer unbekannten Person mit dem Gang einer bekannten Person abzugleichen“, schreibt die Pressestelle. Dies könne „als Sachbeweis in einem laufenden Ermittlungsverfahren herangezogen werden“.

Das LKA Berlin hat sich ebenso mit Gangerkennung beschäftigt, allerdings nicht computerbasiert. Stattdessen würden Gutachten des kriminaltechnischen Instituts (KTI) des LKA Berlin „nach der Methode der beobachtenden Gangbildanalyse erstellt, wie sie auch in der Medizin und der Sportwissenschaft angewandt wird“. Auch das LKA Rheinland-Pfalz wende sich für solche Gutachten an das LKA Berlin.

Das LKA Saarland hat sich nach eigenen Angaben bereits mit biometrischer Gangerkennung beschäftigt, und zwar im Rahmen einer Fortbildung durch das BKA. Das BKA wiederum teilt mit, die angesprochene Fortbildung sei eine Online-Vortragsreihe der Deutschen Hochschule der Polizei gewesen. Dort habe man Vertreter*innen der Polizeien von Bund und Ländern über aktuelle Entwicklungen in der Kriminaltechnik informiert.

Deutschland: Erkennung gehender Personen im Supermarkt

Gangerkennung findet wohl auch Verwendung in der freien Wirtschaft. Bereits 2024 berichtete netzpolitik.org von einem Rewe-Supermarkt in Berlin, der seine Besucher*innen mit hunderten Überwachungskameras durch den Laden verfolgt, die mitgenommenen Waren erkennt und dann an der Kasse abrechnet. Dabei arbeitet Rewe mit der israelischen Firma Trigo zusammen, die es sich zur Mission gemacht hat, den Einzelhandel mit sogenannter KI zu optimieren.

Im Rewe-Supermarkt soll es allerdings keine Gesichtserkennung geben, wie Rewe und Trigo betonten. Stattdessen würden Kameras die schematische Darstellung des Knochenbaus der Besucher*innen erfassen, um sie voneinander zu unterscheiden. Auch das kann eine Form biometrischer Gangerkennung sein, wie sie etwa in einer Studie der TU München beschrieben wird. Demnach könne Gangerkennung per Skelettmodell sogar besser funktionieren als über die Silhouette. Die Strichmännchen mit Knotenpunkten an den Gelenken aus der Münchner Studie ähneln optisch dem Pressematerial von Trigo.

Auf Anfrage von netzpolitik.org verneint Trigo allerdings den Einsatz von Gangerkennung: „Unser System unterscheidet zwischen Käufer*innen mittels computerbasiertem Sehen (‚computer vision‘)“, schreibt die Pressestelle. „Aus wettbewerbstechnischen Gründen können wir nicht tiefer auf technologische Details eingehen, aber wir nutzen keine Gangerkennung oder biometrische Identifikation.“

Ohne die technologischen Details, die Trigo vorenthält, lässt sich die Technologie nicht abschließend bewerten. Bereits 2024 hatten wir den Biometrie-Experten Jan Krissler (alias starbug) um eine Einschätzung gebeten. Er sagte mit Blick auf Trigo: „Körpermerkmale erfassen ist der Inbegriff von Biometrie – und das passiert hier.“

Die Technologie, deren Details das Unternehmen geheimhalten will, wird nach Angaben von Trigo schon in mehreren europäischen Länder eingesetzt. Wo genau? Auch hierzu verweigert die Pressestelle eine Antwort, wieder mit Verweis auf Wettbewerber*innen.

EU: Forschung an Gangerkennung für die Grenze

Die EU erforscht den Einsatz von Gangerkennung an der Grenze, Projektname: PopEye. Das Projekt läuft von Oktober 2024 bis September 2027. Auf der Projektwebsite gibt es beim Klick auf „Ergebnisse“ noch nichts zu sehen. In der dazugehörigen Beschreibung heißt es auf Englisch: „Das von der EU geförderte Projekt PopEye zielt darauf ab, die Sicherheit an den EU-Grenzen durch den Einsatz fortschrittlicher biometrischer Technologien zur Identitätsüberprüfung in Bewegung zu erhöhen“. Eine dieser Technologien ist Gangerkennung.

Die Grenzagentur Frontex listet PopEye als eines von mehreren Forschungsprojekten auf der eigenen Website auf. Bereits 2022 hatte Frontex Gangerkennung in einer Studie über biometrische Technologien beschrieben. Demnach benötige Gangerkennung „keine Kooperation der betreffenden Person und kann aus mittlerer Entfernung zum Subjekt funktionieren“. In der Studie schätzt Frontex: Bis biometrische Gangerkennung im Alltag ankommt, würden noch mindestens zehn Jahre vergehen.

Frontex ist auch an illegalen Pushbacks beteiligt. Das heißt, Beamt*innen verhindern, dass schutzsuchende Menschen an der EU-Grenze Hilfe bekommen. Auf Anfrage von netzpolitik.org will sich Frontex nicht zu PopEye äußern und verweist auf das AIT, das Austrian Institute of Technology. Das Institut aus Österreich koordiniert das Projekt im Auftrag der EU.

Das AIT wiederum erklärt auf Anfrage, selbst nicht im Bereich Gangerkennung zu arbeiten. Allerdings sei Gangerkennung eines von mehreren biometrischen Verfahren, die im Rahmen von PopEye erforscht würden. In dem Projekt würden biometrische Methoden entwickelt, die auch dann funktionieren, wenn sich eine Person bewegt und etwas entfernt ist. Kurzum: Man will Menschen identifizieren können, auch wenn sie gerade nicht aktiv ihr Gesicht vor eine Kamera halten oder ihren Finger auf einen Sensor legen. Das könne etwa die Wartezeit von Reisenden verkürzen, so das AIT.

Weiter erklärt das AIT, man wolle die Technologie verstehen, ihre Einschränkungen und Risiken. Ohne, dass wir ausdrücklich danach gefragt hätten, betont das AIT mehrfach, nichts Verbotenes zu tun. „Wir verpflichten uns, alle geltenden Vorschriften einzuhalten und die Werte der EU sowie die Grundrechte zu fördern und zu wahren.“ Sollte das nicht selbstverständlich sein?

Die gemeinnützige Organisation AlgorithmWatch kritisiert Gangerkennung an der Grenze, gerade mit Blick auf einen möglichen Einsatz bei Geflüchteten. „Wie so häufig wird also die Entwicklung digitaler Überwachungstools an Menschen auf der Flucht getestet, die sich kaum dagegen wehren können“, schreibt Referentin Pia Sombetzki auf Anfrage.

China und Russland: Gangerkennung über 50 Meter Entfernung

Die chinesische Regierung treibt Forschung zu Gangerkennung voran. Einer der größeren Datensätze mit Gangprofilen ist Gait3D, der auf Videodaten aus einem Supermarkt basiert. Das im Jahr 2022 veröffentliche Projekt hat China mit staatlichen Mitteln gefördert.

Nach Berichten der Agentur AP News soll China bereits 2018 Überwachung per Gangerkennung eingeführt haben, und zwar durch Polizeibehörden in Beijing und Shanghai. Die Technologie komme von der chinesischen Überwachungsfirma Watrix. Nach Angaben des CEOs gegenüber AP News könne das System Personen aus bis zu 50 Metern Entfernung identifizieren. Das System lasse sich angeblich nicht täuschen, etwa durch Humpeln.

In einer Spiegel-Reportage aus dem Jahr 2019 erklärte eine Pressesprecherin von Watrix, das System würde weitere Informationen nutzen, um Menschen zu identifizieren, etwa Körpergröße und Statur. Angeblich erkenne die Software Menschen in einer Sekunde. „Zwei Schritte reichen.“ Auch in Gruppen von bis zu 100 Leuten könne die Software Menschen erkennen, deren Gangprofil dem System bekannt sei. Es ist üblich, dass Überwachungsfirmen die Fähigkeiten ihrer Produkte überhöhen. Auf unsere Fragen hat Watrix nicht reagiert.

Auch das russische Regime soll biometrische Gangerkennung einsetzen. Im Jahr 2020 berichtete das russische Exilmedium Meduza von entsprechenden Plänen für das Folgejahr. Die Technologie sollte demnach Teil der staatlichen Kameraüberwachung in Moskau werden. Im Jahr 2021 schreib das staatliche Propaganda-Medium Rossiyskaya Gazeta von einem solchen Überwachungssystem im Auftrag des Innenministeriums. Angeblich könne die Gangerkennung eine Person aus einer Entfernung von bis zu 50 Metern identifizieren. Es fehlt allerdings eine unabhängige Prüfung, um festzustellen, viel davon Einschüchterung ist und wie viel korrekt.

Grundrechte in Gefahr: Menschenrechtler*innen fordern Verbot

Menschenrechtsorganisationen betrachten Gangerkennung schon länger kritisch. Privacy International warnte bereits 2021 vor den Gefahren von Gangerkennung bei Protesten. Auch Amnesty International beschäftigt sich damit. Gangerkennung funktioniere aus der Ferne und bleibe dadurch unbemerkt, schreibt Lena Rohrbach auf Anfrage von netzpolitik.org. Sie ist Referentin für Menschenrechte im digitalen Zeitalter bei Amnesty International in Deutschland.

Behörden könnten Gangerkennung etwa ergänzend zu Gesichtserkennung einsetzen, um Menschen auch auf Distanz zu identifizieren. „Überwachung durch Gangerkennung ist ein tiefgreifender Eingriff in Menschenrechte und geht mit umfassenden Risiken einher“, warnt Rohrbach. „Jede Form biometrischer Fernidentifizierung ist potenziell geeignet, zur Repression genutzt zu werden und die freie und unbeobachtete Bewegung im öffentlichen Raum vollständig zu beenden.“

Amnesty International setze sich deshalb für ein umfassendes Verbot biometrischer Fernidentifizierung zur Überwachung des öffentlichen Raums ein – inklusive Gangerkennung. Die EU hat die Gelegenheit verpasst, ein solches Verbot im Rahmen der KI-Verordnung zu beschließen.

In Deutschland befasst sich die Organisation AlgorithmWatch mit den Auswirkungen sogenannter KI auf Menschenrechte. Auf Anfrage vergleicht Referentin Pia Sombetzki Gangerkennung mit Gesichtserkennung. „Die Anonymität im öffentlichen Raum wird effektiv aufgehoben, und Menschen dürften es sich tendenziell eher zweimal überlegen, an welcher Versammlung sie noch teilnehmen“, schreibt sie. Neben Demonstrierenden könnten zum Beispiel auch Obdachlose oder Suchtkranke beobachtet werden.

Das Problem betreffe grundsätzlich alle, die sich in der Öffentlichkeit frei bewegen wollten. Rufe nach mehr KI in der Polizeiarbeit könnten in eine Sackgasse führen, warnt Sombetzki. „Denn je mehr die Freiheitsrechte auch hierzulande eingeschränkt werden, desto weniger bleibt von der demokratischen Gesellschaft übrig, die es eigentlich zu schützen gilt.“

Die Arbeit von netzpolitik.org finanziert sich zu fast 100% aus den Spenden unserer Leser:innen.

Werde Teil dieser einzigartigen Community und unterstütze auch Du unseren gemeinwohlorientierten, werbe- und trackingfreien Journalismus jetzt mit einer Spende.

-

UX/UI & Webdesignvor 4 Wochen

UX/UI & Webdesignvor 4 WochenDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 3 Wochen

UX/UI & Webdesignvor 3 WochenAdobe Firefly Boards › PAGE online

-

Social Mediavor 4 Wochen

Social Mediavor 4 WochenRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

Entwicklung & Codevor 4 Wochen

Entwicklung & Codevor 4 WochenPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 2 Wochen

Entwicklung & Codevor 2 WochenEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

Digital Business & Startupsvor 3 Monaten

Digital Business & Startupsvor 3 Monaten10.000 Euro Tickets? Kann man machen – aber nur mit diesem Trick

-

Digital Business & Startupsvor 3 Monaten

Digital Business & Startupsvor 3 Monaten80 % günstiger dank KI – Startup vereinfacht Klinikstudien: Pitchdeck hier

-

UX/UI & Webdesignvor 1 Tag

UX/UI & Webdesignvor 1 TagFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online