Künstliche Intelligenz

Das fehlende Puzzleteil für Passkeys: Apple stellt Exportfunktion in Aussicht

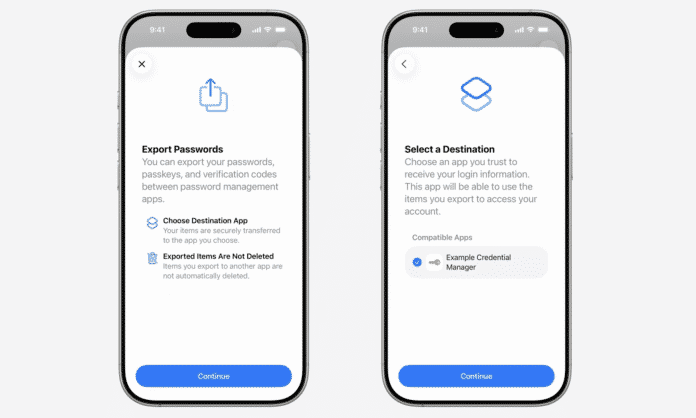

Apple-Nutzer können ihre Passkeys bald exportieren. Dies stellte der Hersteller auf der WWDC 2025 für die Betriebssysteme iOS, iPadOS und macOS 26 in Aussicht, die im Herbst erscheinen. So wird erstmals möglich, die im iCloud-Schlüsselbund respektive in Apples Passwörter-App gespeicherten Passkeys in eine andere Passwortverwaltung umzuziehen. Das Exportieren von Passwörtern und Einmal-Codes wird dabei obendrein unterstützt, betonte Apple – ebenso wie ein Import.

Der neue Transferprozess sei zudem sicherer als der bisherige Weg, die sensiblen Zugangsdaten im Klartext in einer JSON- oder CSV-Datei zu speichern.

Passwörter und Passkeys sollen sich in iOS 26 einfach in einen anderen Passwort-Manager übertragen lassen.

(Bild: Apple)

FIDO-Spezifikation für sicheren Passkey-Export

Für den sicheren Transferprozess kommt ein von der FIDO-Allianz spezifiziertes Verfahren zum Einsatz, so Apple. Gemeint sind offenbar das Credential Exchange Protocol (CXP) und das Credential Exchange Format (CXF), das die Allianz im vergangenen Herbst vorgestellt hat. Es soll einen direkten Austausch der Zugangsdaten zwischen zwei Passwortverwaltungen ermöglichen. Dafür müssen beide Seiten die Spezifikation unterstützen.

Apple stellt dafür neue Schnittstellen bereit, die Apps integrieren können. Bestehende Passkeys werden durch den Transferprozess nicht verändert und lassen sich nahtlos weiterverwenden, verspricht das Unternehmen. Passwort-Manager wie 1Passwort haben bereits angekündigt, die Spezifikation zu unterstützen, auch viele weitere bekannte Namen sind laut FIDO beteiligt, darunter Bitwarden, Dashlane, Google und Microsoft.

Passkey-Silos hinderten Verbreitung

Passkeys sind als sicherere Alternative zu Passwörtern konzipiert und sollen diese langfristig ablösen. Bislang ist die Technik aber eine Insellösung geblieben, da Passkeys in die Silos großer Passwort-Manager eingesperrt sind und so hauptsächlich bei den integrierten Diensten der Plattformanbieter Apple, Google oder Microsoft liegen.

Zwar ließen sich Passkeys auch plattformübergreifend nutzen, etwa über Googles in Chrome integrierte Passwortverwaltung, doch gibt es viele Stolperfallen und längst nicht jeder möchte seine Zugangsdaten der Cloud eines IT-Riesen anvertrauen. Eine standardisierte arbeitende Exportier- und Importierfunktion könnte künftig für mehr Passkeys-Akzeptanz sorgen, falls Nutzer in der Lage sind, ihre kompletten Zugangsdaten wirklich nahtlos von einer Passwortverwaltung zur nächsten mitzunehmen.

(lbe)

Künstliche Intelligenz

Elektronische Patientenakte: Transparenz stärkt Vertrauen, Realitätscheck nötig

Datenschutzinformationen in patientenfreundlicher Sprache erhöhen die Bereitschaft, medizinische Daten in die elektronische Patientenakte (ePA) hochzuladen. Das zeigt eine neue Studie der Technischen Universität Berlin.

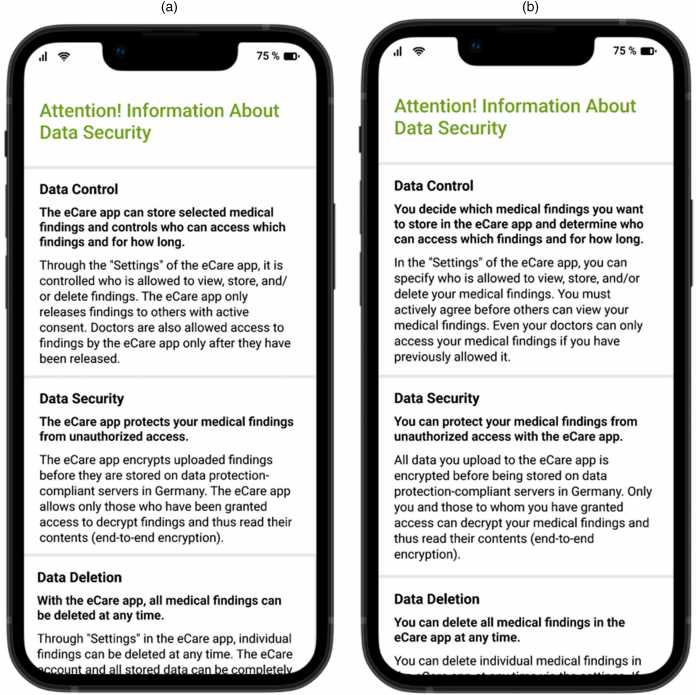

Datenschutzhinweise, die in der Studie verwendet wurden – mit der technikzentrierten Formulierung (links) und der patientenzentrierter Formulierung (rechts). Für die Veröffentlichung der Studie wurde das Material in englische Sprache übersetzt.

(Bild: Kalkreuth et al.)

In der Studie, an der 227 Probanden teilnahmen, wurden verschiedene Varianten sogenannter Privacy Fact Sheets (PFS), also kompakte Datenschutz-Infoblätter, getestet. Heraus kam dabei: Wer vor dem Upload medizinischer Befunde ein PFS mit einer patientenzentrierten Formulierung – bei Patienten direkter angesprochen wurden – sah, war viermal so häufig bereit, die sensiblen Daten in der ePA zu speichern. Bei einem systemzentrierten Text – bei dem hingegen die Patientenakte im Mittelpunkt steht – waren die Probanden hingegen deutlich zurückhaltender. Ob das Infoblatt kurz oder lang war, spielte hingegen keine Rolle.

Entscheidend ist laut Studie, dass Nutzer das Gefühl bekommen, selbst Kontrolle über ihre Daten zu haben. Demnach scheint „für die Entscheidung, Gesundheitsdaten in die elektronische Patientenakte hochzuladen, die wahrgenommene Kontrolle der Nutzer über ihre Daten entscheidend zu sein, die durch eine patientenzentrierte Gestaltung der Datenschutzrichtlinien maximiert wurde“. „Viele Menschen wollen ihre Gesundheitsdaten eigentlich sinnvoll nutzen, haben aber Angst vor Kontrollverlust. Unsere Studie zeigt, dass dieses Gefühl durch eine einfache Intervention vermieden werden kann und sie sich dadurch sicherer fühlen“, erklärt Niklas von Kalckreuth. Datenschutzhinweise direkt in der App – statt in schwer verständlichen AGB – könnten helfen, die Akzeptanz digitaler Gesundheitsanwendungen zu steigern.

Wirklichkeit hinkt hinterher

In der Realität ist es jedoch anders. Verbraucherschützer kritisierten zum Start der ePA fehlende Datenschutzmöglichkeiten und nicht ausreichende Informationen über die elektronische Patientenakte – vor allem nicht über die Risiken. Datenschützer warnten zudem davor, dass Versicherte nicht wissen, was mit der Patientenakte auf sie zukommt. Beispielsweise war vielen nicht klar, welche Auswirkungen der Paradigmenwechsel hat: Jeder erhält sie automatisch, es sei denn, er widerspricht – zuvor war es andersherum der Fall. Gleiches gilt für die geplante Ausleitung der Daten an das Forschungsdatenzentrum Gesundheit. Seit Jahren macht der CCC auf Sicherheitslücken bei der elektronischen Patientenakte aufmerksam, zuletzt auch bei Version 3.0 der elektronischen Patientenakte.

Darüber hinaus gibt es noch weitere Unzulänglichkeiten der ePA, die das Vertrauen der Nutzer nicht gerade wachsen lassen. Patienten können nicht individuell steuern, welche Daten für welchen Arzt sichtbar sind. Mit dem neuesten Update sollen Versicherte immerhin entscheiden können, welche Ärzte alle Medikationsinformationen des digital gestützten Medikationsprozesses sehen können. Bisher war die Medikationsliste entweder für alle oder keine Einrichtung sichtbar oder verborgen. Ähnlich verhält es sich nach wie vor mit den übrigen Informationen in der ePA. Ein Arzt sieht entweder die gesamte Akte oder keine Daten. Außerdem ist die ePA weder nutzerfreundlich noch barrierefrei.

Störungen und Fehler

Schon vor dem offiziellen Start der „ePA für alle“ warnten Hersteller, dass das System nicht ausreichend getestet sei. Dennoch wurde sie – auf politischen Druck – mit großem Werbeaufwand eingeführt. Immer wieder kommt es zu Verzögerungen, unausgereifte Versionen werden veröffentlicht, Störungen und technische Fehler sind an der Tagesordnung. Die Telematikinfrastruktur, das digitale Rückgrat der ePA, kämpft seit Jahren mit Verfügbarkeitsproblemen.

Im Oktober wird die ePA für Ärzte zur Pflicht, bisher sind aber immer noch nicht alle Praxen gerüstet, nach wie vor treten Fehler auf. So kann es beispielsweise sein, dass Akten als nicht angelegt angezeigt werden, obwohl sie es sind und der Versicherte nicht widersprochen hat. Auch gab es Fälle, in denen Widersprüche technisch nicht korrekt verarbeitet wurden, was inzwischen nicht mehr der Fall ist.

Verunsicherung bei Ärzten

Für Verunsicherung bei Ärzten sorgte jüngst eine Datenschutzpanne beim Praxisverwaltungssystem T2med. Dort kam es in einer Praxis dazu, dass eArztbriefe versehentlich falschen Patientenakten zugeordnet wurden. Laut Hersteller ist das Problem inzwischen behoben, die Praxen wurden informiert und ein Update bereitgestellt.

Weniger transparent agierte hingegen der Softwareanbieter CGM: Wieder einmal funktioniert CGM-Software nicht mit RISE-Konnektoren. Während heise online Informationen über ein angekündigtes Update zur Fehlerbehebung vorliegen, erklärte sich die Pressestelle auf Anfrage ahnungslos.

Digital Health abonnieren

Alle 14 Tage bieten wir Ihnen eine Übersicht der neuesten Entwicklungen in der Digitalisierung des Gesundheitswesens und beleuchten deren Auswirkungen.

E-Mail-Adresse

Ausführliche Informationen zum Versandverfahren und zu Ihren Widerrufsmöglichkeiten erhalten Sie in unserer Datenschutzerklärung.

(mack)

Künstliche Intelligenz

VR in den 90ern: Die gescheiterten VR-Brillen von Nintendo, Atari, Sega & Hasbro

Im Jahrzehnt nach dem Videospielcrash der Achtziger wollten gleich mehrere große Namen der Unterhaltungsindustrie mit Virtual Reality in den Konsumentenmarkt vordringen. Nintendo, Sega, Atari und Hasbro entwickelten aufwendig konzipierte VR-Brillen für Spielkonsolen, doch keines dieser Projekte schaffte es über den Status von Prototypen oder kurzlebigen Marktauftritten hinaus.

Nintendos Virtual Boy: Ambition trifft auf technische Grenzen

Nintendo startete Anfang der 1990er-Jahre mit viel Enthusiasmus in die Erforschung stereoskopischer 3D-Technologien. Unter der Leitung von Gunpei Yokoi, der maßgeblich an der Entwicklung des Game-Boys beteiligt war, begann der Konzern ab 1991 mit der Entwicklung eines VR-Systems. Die zugrunde liegende Technik stammte vom US-Unternehmen Reflection Technology und basierte auf einer LED-Zeilenanzeige, dem „Scanned Linear Array“. Dabei wurde anstatt eines klassischen Displays für jedes Auge eine vertikale LED-Leiste („Linear Array“) mit 224 roten LEDs genutzt. Jedes LED-Array bildete eine einzelne Pixel-Spalte und ein sich schnell hin- und herbewegender Spiegel, angetrieben von einem Voice-Coil-Motor, reflektierte das Licht jeweils über die Breite des Sichtfeldes.

Dadurch entstand für das jeweilige Auge der Eindruck eines vollständigen, 384 × 224 Pixel großen Bildes. Die Spiegel vibrierten mit etwa 50 Hz, also 50 Bildwiederholungen pro Sekunde. Da effiziente blaue oder grüne LEDs in den Neunzigern technisch und wirtschaftlich nicht verfügbar waren, erschienen alle dargestellten Bilder monochromatisch in rot – das bekannte Markenzeichen des Virtual Boy. 1995 brachte Nintendo seine neue Konsole schließlich mit teilweise völlig absurden und irreführenden Werbespots auf den Markt. Von einer VR-Brille war das Gerät trotz stereoskopischer Darstellung aber weit entfernt.

Statt des ursprünglich geplanten Headset-Formfaktors entschied sich Nintendo wegen Gesundheits- und Sicherheitsbedenken, den Virtual Boy als stationäres Gerät mit Ständer und Okular zu veröffentlichen. Nintendo investierte viel, gab früh Entwicklerkits aus und baute eigene Produktionslinien auf. Doch der Erfolg blieb aus. Das Gerät war unbequem, die Darstellung ermüdete die Augen und verursachte häufig Kopfschmerzen. Auch die Spielauswahl war mit nur 22 Titeln spärlich. Nach enttäuschenden Verkaufszahlen von lediglich 770.000 weltweit abgesetzten Einheiten stellte Nintendo das Gerät bereits 1996 wieder ein und richtete den Fokus auf das N64. Yokoi verließ kurz darauf das Unternehmen.

Sega VR: Zu realistisch für die Marktreife

Auch Nintendos größter Konkurrent unternahm ab 1991 Anstrengungen, VR in den Heimkonsolenmarkt zu bringen. In den USA entwickelte Sega unter Leitung von Stewart Kosoy ein Headset für das Mega Drive. Die Technik war für die damalige Zeit fortschrittlich: integrierte Kopfhörer mit Stereoton, Kopfbewegungstracking und zwei LC-Displays. Diese lieferten allerdings ein ähnlich monochromatisches Bild wie der Virtual Boy. Unterstützt wurde das Projekt von Firmen wie Ono-Sendai, IDEO und Durand Interstellar. Geplante Spiele wie „Nuclear Rush“ oder „Iron Hammer“ erreichten allerdings nie den Markt.

1994 stoppte Sega die Entwicklung. Die offizielle Begründung, das System sei „zu realistisch“, um es bedenkenlos auf den Markt zu bringen, sollte allerdings nur von den tatsächlichen Problemen ablenken. Es kam zu massiven Beschwerden über Schwindel und Übelkeit, insbesondere bei Kindern, und ein kritischer Bericht des Stanford Research Institute stufte die VR-Brille sogar als Gesundheitsrisiko ein. Mit der geringen Rechenleistung der damaligen Sega-Konsolen erreichte die VR-Brille nur eine sehr geringe Auflösung von 320 × 240 Pixeln und eine schwache Bildfrequenz von maximal 30 Hz.

Erfolgreicher liefen hingegen Segas Arcade-VR-Projekte in japanischen Freizeitparks. In Zusammenarbeit mit Virtuality entstand das „Mega Visor Display“, das in der Vergnügungspark-Attraktion VR-1 zum Einsatz kam. Ohne die technische Limitierung der Heimkonsolen konnte Sega erstmals hochwertige VR-Erlebnisse mit 3D-Grafik, Bewegungssimulatoren und Multiplayer-Funktionen bieten. Die Systeme basierten auf Sega-Model-1-Chips und boten immersive Spiele. Sie waren technisch zwar ausgereifter, aber sehr kostspielig und auf Freizeitparks in Japan und den USA beschränkt. Versuche, eine VR-Brille für die nächste heimische Saturn-Konsole zu entwickeln, endeten bereits im frühen Prototypenstadium.

Atari Jaguar VR: Der Sargnagel für Virtuality

Nachdem Atari in den Achtzigern zwei der bedeutendsten VR-Forscher überhaupt hervorgebracht hatte, versuchte sich das Unternehmen in den 1990er-Jahren selbst an VR-Systemen. Unterstützen sollte dabei der erfolgreiche britische VR-Arcade-Hersteller Virtuality. Aus der Kooperation entstand eine für den Heimgebrauch optimierte Version von Virtualitys „Visette“-VR-Brille, die ursprünglich für Arcades entwickelt worden war. Das „Jaguar V““-Projekt sollte die 64-Bit-Konsole Atari Jaguar um ein VR-Headset erweitern und wurde 1995 auf der CES vorgestellt.

Es umfasste zwei Farb-LC-Displays, die je nach Prototyp entweder rot-graue oder blau-graue Bilder lieferten, integrierte Kopfhörer, Infrarot-Tracking und einen separaten VR-Controller – den „Space Joystick“. Spiele wie „Missile Command 3D“ und „Zone Hunter“ waren bereits in Entwicklung, doch auch der Jaguar war technisch zu schwach für Virtual Reality.

Die geringe Rechenleistung führte zu ruckelnden Bildern und häufigen Trackingfehlern, was bei Nutzern in starker Motion Sickness resultierte. Dazu kamen negative Rückmeldungen auf Messen sowie interne wirtschaftliche Probleme. Die Jaguar-Konsole verkaufte sich schlecht, und nach Ataris Fusion mit JT Storage wurden sämtliche Investitionen in Spielekonsolen eingestellt. Virtuality erlitt durch das Scheitern große finanzielle Verluste, von denen sich das Unternehmen nicht mehr erholte.

Hasbros nie erschienener VR-Toaster

Neben den großen Konsolenherstellern arbeitete auch der Spielzeuggigant Hasbro an einem ambitionierten VR-Projekt. Unter wechselnden Codenamen wie „Sliced Bread“, „Toaster“, „Rush“ oder „Xscape VR“ wollte der Konzern ein günstiges Heim-VR-System etablieren und suchte sich dafür gleich mehrere Experten. Initiator war Chris Gentile von AGE Inc., der schon maßgeblich an der Entwicklung von Mattels NES-Zubehör „PowerGlove“ beteiligt war. Unterstützt wurde er beim Headset-Design Steve E. Tice von QWC und dem David Sarnoff Research Center, das ein eigenes VR-Linsensystem zur Projektion auf beide Augen entwickelte.

Hasbros VR-System sollte von einem optimierten ARM-Core-Prozessor angetrieben werden, der von Argonaut Games stammte, den Entwicklern von Nintendos Super FX Chip. Ab 1994 startete Hasbro erste Pressekampagnen. Geplant waren mindestens fünf Starttitel, darunter die Spiele „Nero Zero“, „Intruder“ und verschiedene VR-Rennspiele. Trotz zahlreicher Demos und Hardwareplanungen scheiterte das Projekt ebenfalls an technischen Hürden, steigenden Kosten und einer schwierigen Marktsituation, die mit der anstehenden Veröffentlichung von Sonys Playstation nicht leichter wurde.

Die ursprünglich angepeilten 200 US-Dollar Verkaufspreis stiegen im Verlauf der Entwicklung auf bis zu 499 US-Dollar. 1996 stellte Hasbro das Projekt schließlich ein, da es kaum noch Chancen auf eine zufriedenstellende VR-Darstellung und eine erfolgreiche Markteinführung sah. Hasbro soll zwischen 40 und 60 Millionen US-Dollar in das System investiert haben. Ein fertiges Produkt entstand nie.

Ein gemeinsames Scheitern mit langfristigen Folgen

Alle vier Unternehmen scheiterten an ähnlichen Problemen: unzureichende Technik, gesundheitliche Bedenken, fehlende Inhalte und hohe Kosten. Nintendo brachte zumindest ein marktreifes Produkt in den Handel, während Sega, Atari und Hasbro mit ihren Heim-VR-Systemen nur jede Menge Geld verbrannten und nie über das Prototypenstadium hinauskamen.

Die gescheiterten Projekte der 1990er-Jahre gelten heute dennoch als frühe Wegbereiter für spätere Entwicklungen in 3D- und VR-Technologie. Viele der beteiligten Ingenieure und Unternehmen, darunter etwa Reflection Technology, das Sarnoff Center oder Virtuality, lieferten Impulse für spätere Systeme. Doch für die damalige Zeit war die Technik nicht ausgereift genug, um auf dem Massenmarkt zu bestehen. Die Euphorie wich schnell der Ernüchterung und der Begriff Virtual Reality verschwand für viele Jahre aus den Wohnzimmern – bis ein findiger Tüftler 2009 in seiner Garage den ersten Prototypen einer VR-Brille bastelte, die später als „Oculus Rift“ für Aufsehen sorgen sollte.

(joe)

Künstliche Intelligenz

Mit der Kamera durch Tirana: Architekturfotografie in Albaniens Hauptstadt

Umgeben von Hügeln und Bergketten, die sich wie eine grüne Krone über der Stadt erheben, liegt im Zentrum Albaniens: Tirana. In der Nähe von Flüssen und reichlich Wasser, an der Kreuzung wichtiger Handelswege, die den Norden mit dem Süden und den Osten mit dem Westen verbinden – diese Lage hat Tirana im Laufe der Geschichte von der Steinzeit über die Antike und das Mittelalter bis in die Neuzeit zu einem bevorzugten Siedlungsort gemacht.

Neben ihrer günstigen geografischen Lage zeichnet sich die albanische Hauptstadt durch eine vielfältige Baukunst aus verschiedenen Epochen und politischen Regimen aus. So ist ihr architektonisches Erbe besonders vielfältig und umfasst Gebäude aus der Zeit der osmanischen Invasion, des neuen Bürgertums in den 1920er- und 1930er-Jahren, dazu moderne und rationale Bauten aus der faschistischen Zeit in den 1940er-Jahren und eine Stadtstruktur aus der sozialistischen Zeit bis in die 1990er-Jahre. Alle haben ihre eigenen Charakteristika, die von den Bewohnern unterschiedlich erlebt werden.

Die Architektur der sogenannten „italienischen Epoche“ ist dabei einzigartig. Obwohl zahlreiche der bürgerlichen Villen aus den 1920er-Jahren verfallen sind, ziehen sie die Aufmerksamkeit der vielen jungen Tiraner auf sich, die die Villen teilweise renovieren und für Gastronomie und Bars umnutzen. Darüber hinaus besteht ein Großteil der städtischen Bausubstanz aus sozialistischer Architektur und Bauten aus den 1990er-Jahren, die oft als monoton oder unästhetisch empfunden werden. Dennoch kann es gerade für viele Stadt- und Architekturfotografen interessant sein, diese zu dokumentieren, um auch die jüngere Geschichte und den Geist der Stadt einzufangen.

Das war die Leseprobe unseres heise-Plus-Artikels „Mit der Kamera durch Tirana: Architekturfotografie in Albaniens Hauptstadt“.

Mit einem heise-Plus-Abo können Sie den ganzen Artikel lesen.

-

Datenschutz & Sicherheitvor 2 Monaten

Datenschutz & Sicherheitvor 2 MonatenGeschichten aus dem DSC-Beirat: Einreisebeschränkungen und Zugriffsschranken

-

Online Marketing & SEOvor 2 Monaten

Online Marketing & SEOvor 2 MonatenTikTok trackt CO₂ von Ads – und Mitarbeitende intern mit Ratings

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenMetal Gear Solid Δ: Snake Eater: Ein Multiplayer-Modus für Fans von Versteckenspielen

-

Digital Business & Startupsvor 1 Monat

Digital Business & Startupsvor 1 Monat10.000 Euro Tickets? Kann man machen – aber nur mit diesem Trick

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenPhilip Bürli › PAGE online

-

Digital Business & Startupsvor 1 Monat

Digital Business & Startupsvor 1 Monat80 % günstiger dank KI – Startup vereinfacht Klinikstudien: Pitchdeck hier

-

Apps & Mobile Entwicklungvor 1 Monat

Apps & Mobile Entwicklungvor 1 MonatPatentstreit: Western Digital muss 1 US-Dollar Schadenersatz zahlen

-

Social Mediavor 2 Monaten

Social Mediavor 2 MonatenLinkedIn Feature-Update 2025: Aktuelle Neuigkeiten