Künstliche Intelligenz

ESA-Satellitenpaar erzeugt künstliche Sonnenfinsternis | heise online

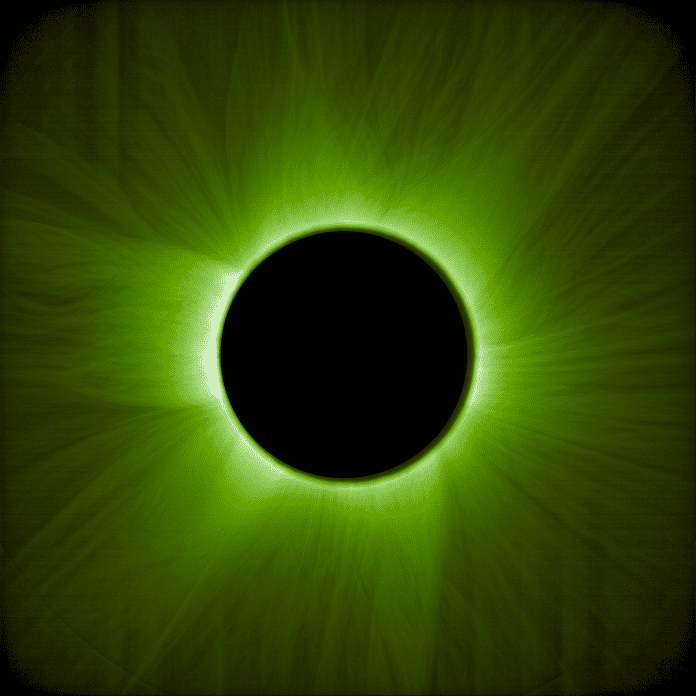

Das ESA-Satellitenpaar „Proba-3“ hat erste Bilder einer künstlichen Sonnenfinsternis geliefert. Auf den Aufnahmen, die die Europäische Raumfahrtbehörde (ESA) veröffentlichte, ist die Sonnenkorona zu sehen, also die äußere Atmosphäre der Sonne. Auf einem Bild erscheint sie in Violett, auf einem anderen so, wie das menschliche Auge sie bei einer echten Sonnenfinsternis durch einen grünen Filter wahrnehmen würde.

Die Sonnenkorona ist normalerweise nicht sichtbar, da sie vom hellen Licht der Sonne überstrahlt wird. Zu sehen ist sie nur bei einer totalen Sonnenfinsternis, also wenn der Mond das Sonnenlicht für einen Teil der Erde vollständig verdeckt. Genau dieses Phänomen simuliert das im Dezember gestartete Satellitenpaar.

ESA/Proba-3/ASPIICS/WOW algorithm (ESA Standard License)

)

Für die Bilder flogen die beiden Satelliten im März in präziser Formation: Einer der beiden Satelliten blockierte dabei das Sonnenlicht und warf einen etwa acht Zentimeter breiten Schatten auf den 150 Metern entfernten zweiten Flugkörper. Dessen Teleskop mit einer fünf Zentimeter großen Blende befand sich genau im Zentrum des Schattens. So blieb die Sonne verdeckt und die Korona wurde sichtbar.

Mit den Daten über die Sonnenkorona hoffen Forschende, mehr über Weltraumwetter, koronale Massenauswürfe und Sonnenstürme zu lernen, die Satelliten beeinträchtigen und sich auch auf die Kommunikation auf der Erde auswirken können. Auch warum die Korona deutlich heißer ist als die Sonnenoberfläche, wollen sie verstehen. An der zweijährigen „Proba-3“-Mission sind 14 ESA-Mitgliedsstaaten beteiligt, darunter auch Österreich und die Schweiz.

(mack)

Künstliche Intelligenz

Pixel 7 und 7 Pro: Nutzerbeschwerden über aufgeblähte Akkus

In den vergangenen Monaten häuften sich die Berichte über Batterieprobleme bei mehreren Pixel-Modellen. Neben dem Pixel 4a und 6a war auch das Pixel 7a betroffen. Nun beschweren sich einige Besitzerinnen und Besitzer der Modelle Pixel 7 und 7 Pro über aufgeblähte Akkus, die den Bildschirm aus dem Gehäuse drücken können.

Auch Pixel 7 mit Akkuproblemen

Wie PiunikaWeb und Android Authority berichten, kann einer der ersten Fälle zum Pixel-7-Pro-Problem auf Anfang Mai dieses Jahres zurückdatiert werden. Damals schrieb ein Nutzer im Google-Support-Forum:“Ich schreibe Ihnen, um ein ernstes Problem mit meinem Pixel 7 Pro zu melden, das ich vor etwa zwei Jahren gekauft habe. Vor kurzem habe ich festgestellt, dass sich die Seitenabdeckung des Geräts zu lösen beginnt, wie auf dem beigefügten Foto deutlich zu sehen ist.“

Der Beitrag sammelte bislang über 140 Stimmen von Personen, die offenbar mit dem gleichen Problem konfrontiert sind. Zudem teilten unter dem Post weitere Nutzer Bilder ihrer Pixel-7-Geräte mit aufgeblähten Akkus.

Begleiterscheinungen: Displaytausch und kurze Laufzeit

Ein weiterer betroffener Nutzer schrieb, dass er sein Pixel 7 Pro mit aufgeblähtem Akku zu einer renommierten Reparaturkette gebracht hätte. Die Reparaturwerkstatt teilte ihm mit, dass wegen der Ablösung des Bildschirms mit hoher Wahrscheinlichkeit auch der Bildschirm ausgetauscht werden müsse.

Lesen Sie auch

Zum Begleiteffekt der aufgeblähten Akkus des Pixel 7 und 7 Pro gehört den Berichten zufolge auch eine rapide Abnahme der Laufzeit, wobei es ohnehin ratsam ist, die betroffenen Geräte besser nicht mehr zu verwenden. Einige berichten zudem, dass einige Geräte trotz vollem Akku nicht mehr einschaltbar seien.

Kommentare im Google-Forum deuten darauf hin, dass das Support-Team bei der Bearbeitung der Nutzerbeschwerden keine einheitliche Vorgehensweise hatte. In einigen Fällen seien Kunden gebeten worden, dem Support Fotos von allen Seiten ihres Smartphones zuzusenden. Ein Nutzer erhielt etwa eine Erstattung für den Austausch des Akkus durch einen Drittanbieter. Ein anderer gab an, dass Google ihm eine kostenlose Reparatur angeboten und versprochen hätte, das aufgeblähte Pixel 7 durch ein generalüberholtes Gerät zu ersetzen, falls die Reparatur nicht erfolgreich sein sollte.

Von Google gab es bislang noch keine offizielle Stellungnahme zu der neuen Akkuproblematik. Wir haben Google Deutschland um ein Statement gebeten. Angesichts der sich offenbar häufenden Stimmen dürfte der Konzern alsbald reagieren.

Nicht die ersten Pixel mit Akkuproblemen

Es ist leider nicht das erste Mal, dass Chargen von Googles Pixel-Geräte mit Akku-Problemen zu kämpfen haben. Im April startete der Konzern ein kostenloses Akku-Austauschprogramm für Pixel-7a-Geräte und räumte ein, dass sich die Akkus bei einigen Geräten aufblähen können. Je nach Garantiestatus und Region bietet Google auch eine andere Kulanzleistung von bis zu 400 Euro an.

Neben dem Pixel 7a bestätigte Google auch Akkuprobleme beim Pixel 6a, für das der Hersteller im Juli ein Softwareupdate zur Reduzierung der Batteriekapazität wegen möglicher Überhitzungsprobleme veröffentlicht hatte. Nutzer, die bei ihren Pixel-Geräten einen aufgeblähten Akku feststellen, sollten die Richtlinien im Support-Bereich studieren und den Kundendienst kontaktieren.

(afl)

Künstliche Intelligenz

„Die Sonne wacht langsam auf“: Sonnenaktivität steigt seit 2008 überraschend an

Die Sonnenaktivität ist seit 17 Jahren kontinuierlich gestiegen, sollte dieser Trend anhalten, könnten Sonnenstürme und Sonneneruptionen unabhängig vom jeweiligen Sonnenzyklus häufiger werden. Das haben zwei Forscher der NASA ermittelt, die verschiedene Entwicklungen beim Verhalten unserer Sonne ausgewertet haben. Demnach hat ein in den 1980er-Jahren begonnener Trend der abnehmenden Sonnenaktivität 2008 geendet, aber das damals erwartete Verharren auf diesem niedrigen Niveau sei nicht eingetreten. Stattdessen habe die Sonne den Kurs gewechselt und sei immer aktiver geworden. Das könnte künftig nicht nur Folgen für die Raumfahrt haben.

Dass die Sonne bei ihrer Aktivität einen ungefähr elfjährigen Zyklus durchläuft, ist seit mehr als 200 Jahren bekannt. Die wurden von dem Schweizer Astronomen Rudolf Wolf im 18. Jahrhundert bis zum Jahr 1749 zurückgerechnet, dem Maximum des sogenannten 0. Zyklus. Inzwischen wurde der Elfjahreszyklus anhand von Baumringen sogar lückenlos für die vergangenen 1000 Jahre bestätigt und bis ins Jahr 969 zurückverfolgt. Gleichzeitig durchläuft die Sonne aber langfristigere Veränderungen, die dafür sorgen, dass die Aktivität unabhängig von den Zyklen zu- oder abnimmt. Am inaktivsten war die Sonne beispielsweise aus bislang ungeklärten Gründen im 17. Jahrhundert und dann noch einmal am Anfang des 19. Jahrhunderts. Am Beginn des Raumfahrtzeitalters war sie dann so aktiv wie lange nicht mehr.

Sonnenaktivität mit konkreten Folgen auf der Erde

Dass der aktuelle 25. Sonnenzyklus stärker ausgefallen ist als erwartet, war bereits bekannt. Auch sein Maximum hat er früher erreicht. Die beiden NASA-Forscher haben nun aber bestätigt, dass das Teil eines größeren Trends ist: „Die Sonne wacht langsam auf“, meint Studienleiter Jamie Jasinski vom Jet Propulsion Laboratory der NASA. Insgesamt sei das eine Überraschung gewesen, denn eigentlich habe alles darauf hingedeutet, dass die Sonne in eine längere Phase geringer Aktivität eingetreten ist. Dass dem nicht so ist, hat er mit Marco Velli unter anderem anhand von Daten zum Sonnenwind und zum Magnetfeld ermittelt. Ihre Forschungsarbeit haben sie in den Astrophysical Journal Letters veröffentlicht.

Die kontinuierliche Beobachtung und Vorhersage der Sonnenaktivität sind nicht nur für die Erforschung unserer Sonne von Belang, Phasen besonders hoher Aktivität können ganz konkrete Folgen auf der Erde haben. Schlimmstenfalls kann eine besonders aktive Sonne – also eine mit vielen Sonnenflecken und großen Ausbrüchen auf der Oberfläche – technische Systeme wie etwa Satelliten beschädigen oder gar zur Gefahr für Astronauten werden. Eine besonders starke Sonneneruption könnte sogar eine „Internet-Apokalypse“ auslösen. Zudem hat erst vor wenigen Monaten ein Forschungsteam herausgefunden, dass sogenannte Superflares unserer Sonne viel häufiger sind als angenommen. Dabei handelt es sich um gigantische Eruptionen auf der Sonne mit potenziell verheerenden Folgen für moderne Infrastruktur.

(mho)

Künstliche Intelligenz

Steam-Spiele tauchen jetzt in der Xbox-App auf

Microsoft macht die Xbox-App zur zentralen Anlaufstelle für alle installierten PC-Spiele. Aktuell verteilt Microsoft ein Update für die Xbox-App, nach dessen Installation auch Spiele in der Xbox-Bibliothek auftauchen, die über andere Plattformen installiert wurden. Zu den unterstützten Stores gehören Steam, GOG und der Epic Games Store.

Angekündigt hat Microsoft diese Neuerung schon im Juni, seitdem wurden die neuen Features getestet. Nun wurde die überarbeitete Xbox-App für alle Nutzer veröffentlicht. Das Update kann auch in Deutschland bereits heruntergeladen werden. Dazu klickt man in der Xbox-App auf die Glocke und stößt den Download der neuen Version an – insofern sie nicht schon automatisch heruntergeladen wurde.

Nach dem Update braucht die App einen kurzen Moment, um alle auf dem PC installierten Spiele aus den unterschiedlichen Stores zu erfassen. Dieser Schritt erfolgt automatisch. Die zuletzt gespielten Titel tauchen in der linken Leiste auf, eine Komplettübersicht bekommt man über den Bibliotheks-Reiter.

Aktuell nicht installierte Spiele, die in anderen Stores erworben wurden, können über die Xbox-App nicht verwaltet werden. Die Integration installierter Spiele beschränkt sich vorrangig auf das Starten der Titel – für alles andere muss man in die App der jeweiligen Plattform wechseln.

Entwickelt für Xbox Ally

Standardmäßig indiziert die Xbox-App Spiele aus allen unterstützten Apps. Wer einzelne Apps abschalten oder das Feature komplett deaktivieren möchte, muss aktiv werden: Über den Klick auf den Benutzernamen und „Einstellungen“ kann man zu „Bibliothek und Erweiterungen“ navigieren. Dort kann man die Einbindung für jede einzelne Plattform aktivieren oder deaktivieren.

Das Feature wurde vorrangig für den Xbox Ally entwickelt: Nutzer des kommenden Handhelds von Asus und Microsoft bekommen eine neue, um die Xbox-App aufgebaute Oberfläche, die viele fürs Gaming weniger wichtige Funktionen in den Hintergrund rückt. Damit Handheld-User nicht ständig zwischen verschiedenen Apps hin- und herwechseln müssen, hat Microsoft an einer Einbindung der Spiele aus anderen Stores gearbeitet. Davon profitieren nun auch alle anderen PC-Systeme.

(dahe)

-

UX/UI & Webdesignvor 4 Wochen

UX/UI & Webdesignvor 4 WochenDer ultimative Guide für eine unvergessliche Customer Experience

-

Social Mediavor 4 Wochen

Social Mediavor 4 WochenRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

UX/UI & Webdesignvor 2 Wochen

UX/UI & Webdesignvor 2 WochenAdobe Firefly Boards › PAGE online

-

Entwicklung & Codevor 4 Wochen

Entwicklung & Codevor 4 WochenPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 2 Wochen

Entwicklung & Codevor 2 WochenEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

Digital Business & Startupsvor 3 Monaten

Digital Business & Startupsvor 3 Monaten10.000 Euro Tickets? Kann man machen – aber nur mit diesem Trick

-

Digital Business & Startupsvor 3 Monaten

Digital Business & Startupsvor 3 Monaten80 % günstiger dank KI – Startup vereinfacht Klinikstudien: Pitchdeck hier

-

Apps & Mobile Entwicklungvor 3 Monaten

Apps & Mobile Entwicklungvor 3 MonatenPatentstreit: Western Digital muss 1 US-Dollar Schadenersatz zahlen