Online Marketing & SEO

Google erweitert AirDrop Support bei Android

Dateien vom Android-Handy direkt aufs iPhone schicken und umgekehrt: Google will den iOS-Android-Dateiaustausch über Quick Share schon bald für mehr User ermöglichen. EU-Vorgaben erleichtern die Öffnung, doch wie Apple langfristig reagiert, ist noch offen.

Der bislang umständliche Dateiaustausch zwischen iPhones und Google Smartphones dürfte bald der Vergangenheit angehören. Denn Google will den plattformübergreifenden Austausch über Quick Share sehr bald für noch mehr Nutzer:innen verfügbar machen.

Einige Pixel User können Dateien bereits seit Ende November vergangenen Jahres ohne Umwege mit iPhone Usern austauschen. Jetzt kündigte Google an, die AirDrop-Interoperabilität über Quick Share auf mehr Smartphones zu bringen und den Austausch zwischen Android und Apple Usern komfortabler zu machen. Das berichtete unter anderem der auf Google spezialisierte Publisher 9to5Google.

Ein kleines Tech-Wunder:

Android erhält AirDrop-Unterstützung

Nach Pixel 10 folgt der Rest: Quick Share wird breiter verfügbar

Auf einer Presseveranstaltung in Taipeh erklärte Eric Kay, Vice President of Engineering im Android Team von Google, dass die AirDrop-Kompatibilität erfolgreich getestet sei und noch 2026 auf viele weitere Android Smartphones komme. Konkrete Modelle nannte Google zwar nicht, stellte aber klar, dass man sicherlich über die Pixel-Reihe hinausgehen wolle.

Im November 2025 hatte Google mit der Pixel 10-Serie erstmals ermöglicht, Dateien direkt mit iPhones, iPads und Macs auszutauschen. Der Transfer läuft lokal, verschlüsselt und ohne zwischengeschaltete Server. Apple-Geräte müssen dafür lediglich kurzzeitig „für alle sichtbar“ sein und tauchen dann ganz normal in Quick Share auf. Auch die Android-Geräte tauchen als Gegenüber im AirDrop-Kontext bei Apple auf.

Warum das Komfort-Feature genau jetzt kommt

Die Ausweitung der AirDrop-Unterstützung kommt nicht aus dem Nichts. Die fehlende Interoperabilität zwischen Android und iOS gilt seit Jahren als Schwachstelle im Zusammenspiel der beiden dominierenden Smartphone-Ökosysteme. Gleichzeitig wächst der regulatorische Druck auf geschlossene Plattformen. Mit dem Digital Markets Act (DMA) verpflichtet die EU große Tech-Unternehmen wie Apple dazu, zentrale Schnittstellen zu öffnen und den Wechsel zwischen Systemen zu erleichtern. Die EU-Kommission wertet den verbesserten Datentransfer zwischen iPhone und Android daher auch als großen Erfolg dieser Regulierung, die Nutzer:innen mehr Wahlfreiheit und Portabilität verschaffen soll. Ähnliches ist bereits verpflichtenden Vereinheitlichung von USB-C-Ladekabeln in der EU passiert. Seit Herbst 2024 lassen sich Smartphones und viele weitere Geräte mit einem einheitlichen Ladekabel aufladen. Das soll Verbraucher:innen entlasten und Elektroschrott reduzieren.

Eric Kay deutete in diesem Kontext außerdem an, dass Google über die Ausweitung von Quick Share hinaus daran arbeitet, den Gerätewechsel insgesamt einfacher zu machen. Perspektivisch sollen Nutzer:innen beim Umstieg möglichst alle Daten und Inhalte behalten können – selbst dann, wenn sie das Betriebssystem wechseln. Interoperabilität wird damit nicht mehr nur als Komfortfunktion verstanden, sondern als grundlegende Voraussetzung für digitale Souveränität. Wie entscheidend der regulatorische Hebel dabei ist, erklärt auch der Tech-Creator Andru Edwards in einem Threads Post.

Er betont, dass Google durch die regulatorischen Vorgaben der EU Interoperabilität umsetzen kann, ohne auf eine aktive Freigabe durch Apple angewiesen zu sein. Ob und wie dauerhaft Apple diese Öffnung mitträgt, bleibt allerdings offen. Derweil hat Google außerdem ein neues Discover Core Update ausgerollt, das neu justiert, welche Inhalte Nutzer:innen in der Discover-Ansicht sehen und damit die Spielräume für Reichweite und Sichtbarkeit erneut verändert.

Google rollt February 2026 Discover Core Update aus

Online Marketing & SEO

Model Council: 3 KI-Modelle gleichzeitig für die Suche nutzen

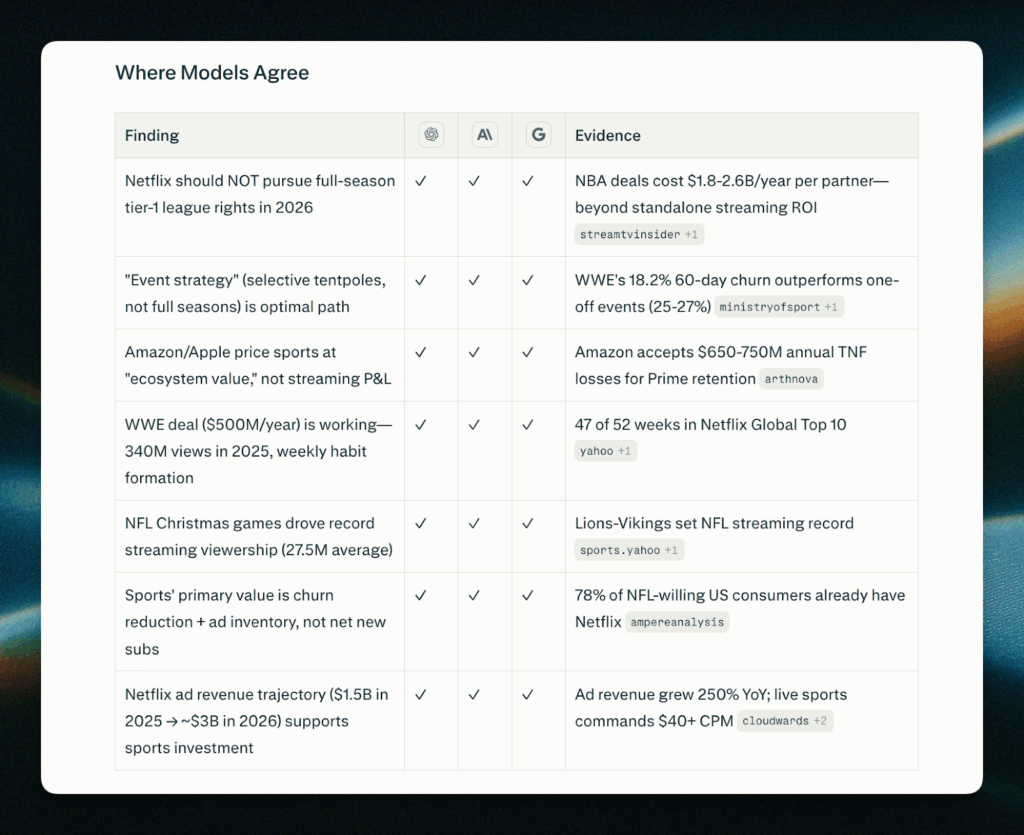

Mit dem neuen Model Council können User Suchanfragen von drei KI-Kernmodellen zugleich bearbeiten lassen und erhalten aggregierte Antworten samt Unterschieden und Diskrepanzen – sogar nebeneinander angezeigt.

Der Wettbewerb um das beste KI-Modell der Welt läuft auf Hochtouren. Google dominiert viele Touchpoints im Digitalraum mit Gemini 3.0, OpenAI hat mit GPT-5.2 – sowie dem neuen GPT-5.3-Codex für Developer – ein hochleistungsfähiges Modell parat, Mistral AI aus Europa setzt eher auf spezialisierte Modelle und Anthropic bescherte der Branche jüngst das neue Modell Claude Opus 4.6. Auch die Weiterentwicklung der KI-Suche wird mit Hochdruck umgesetzt, auf Google, ChatGPT und Co. Dabei können User mit verschiedenen Tools unterschiedliche Modelle der Tech-Unternehmen einsetzen. Bei der AI Answering Machine Perplexity können sie mit dem Model Picker ihre favorisierten Optionen auswählen. Und jetzt ermöglicht Perplexity, eine Suchanfrage gleich von drei verschiedenen Modellen zugleich bedienen zu lassen. Dafür zeichnet die neue Funktion Model Council verantwortlich.

Anthropics Claude Opus 4.6 bringt neues Leistungsniveau für agentische KI

So funktioniert das Model Council auf Perplexity

Der Name ist Programm: Das Model Council von Perplexity soll bei einer Suchanfrage in der AI Answering Machine unterschiedliche KI-Modelle als Gremium zusammenstellen. Dabei sollen die einzigartigen Eigenschaften der Modelle dafür sorgen, dass die Antwort zur Suchanfrage besonders ausgewogen ist und verschiedene Schwerpunkte aus den Modellantworten, Gemeinsamkeiten und auch mögliche Diskrepanzen bei der Darstellung aufzeigt.

Das Unternehmen erklärt, dass User fortan solche aggregierten Suchergebnisse mit nebeneinander anschauen und dabei auf die Differenzen und die unikalen Anwortbestandteile der einzelnen Modelle zugreifen.

Die Funktion erlaubt es den Nutzer:innen, ein Multi-Model-Recherche-Feature einzusetzen, das beispielsweise Claude Opus 4.6, GPT-5.2 von OpenAI und Gemini 3.0 parallel laufen lässt. Ein weiteres KI-Modell synthetisiert dann die Antworten für die User und zeigt zum Beispiel in Tabellenform, was welches Modell herausgefunden hat. Dabei werden auch konkrete Quellen als Beleg samt Quellen-Links mitgeliefert.

Der Vorteil für die Nutzer:innen soll darin liegen, dass sie nicht zwischen Modellen hin- und herwechseln müssen, um umfassende und auch differierende Antworten zu Suchanfragen zu erhalten. Zudem können sie mit dem Model Council etwaige blinde Flecken einzelner Modelle erkennen und mögliche Leerstellen bei Antworten ausfüllen lassen. Gerade Ungereimtheiten bei den aggregierten Antworten könnten als Hinweis zur weiteren Recherche relevant werden.

Perplexity schlägt vor, dieses Feature beispielsweise bei der Investmentrecherche, der Verifizierung von Informationen, komplizierteren Entscheidungen etwa beim Kauf von Produkten oder auch beim kreativen Brainstorming einzusetzen. Das Model Council kommt allerdings mit einerm Wermutstropfen daher. Denn zunächst ist es nur im Web und lediglich für Perplexity Max-Abonnent:innen verfügbar. Dieses Abonnement kostet 200 US-Dollar monatlich. Der Mobile Support wurde aber schon angekündigt.

15 ChatGPT Prompts, um 15 Stunden pro Woche zu sparen

Online Marketing & SEO

OpenAI gegen die KI-Chancenlücke: GPT-5.3-Codex und Frontier

Mit der Einführung von GPT-5-Codex im September 2025 legte OpenAI den Grundstein für Codex als eigenständiges Entwicklungsmodell. Der jüngste Start der Codex App für macOS, die das parallele Arbeiten mit mehreren Agents erleichtert, bereitete den nächsten Schritt vor. Mit GPT-5.3-Codex baut OpenAI diesen Ansatz jetzt weiter aus und erweitert den Funktionsumfang von Codex deutlich.

Die Ankündigungen treffen auf einen deutlich verschärften KI-Wettbewerb, vor allem zwischen OpenAI und Anthropic. Erst vor wenigen Tagen sorgte Anthropic mit einer Super Bowl-Kampagne für Aufmerksamkeit und stellte klar, dass Claude werbefrei bleiben soll – im Gegensatz zu OpenAIs ChatGPT. Kurz darauf folgte mit Claude Opus 4.6 das bislang stärkste Modell des Unternehmens. Vor diesem Hintergrund wirkt OpenAIs gleichzeitiger Start von GPT-5.3-Codex und der Agent-Plattform Frontier wie eine direkte Antwort auf den wachsenden Druck durch Claude.

OpenAI startet Codex App

GPT-5.3-Codex: Mehr Leistung, schnelleres Reasoning, neue Benchmarks

Laut OpenAI verbessert GPT-5.3-Codex sowohl die Coding Performance von GPT-5.2-Codex als auch Reasoning und Fachwissen und bündelt diese Fortschritte in einem Modell, das nach Angaben des Unternehmens rund 25 Prozent schneller arbeitet. In internen und externen Tests erreicht das Modell neue Bestwerte, unter anderem bei SWE-Bench Pro und Terminal Bench, und zeigt starke Ergebnisse bei OSWorld und GDPVal, die OpenAI zur Bewertung agentischer und realitätsnaher Fähigkeiten nutzt. Auffällig ist auch der Entwicklungsansatz: GPT-5.3-Codex war das erste Modell, das maßgeblich an der eigenen Weiterentwicklung beteiligt war. Das Codex Team nutzte frühe Versionen, um Training, Roll-out und Evaluationen gezielt zu debuggen und zu steuern.

Parallel meldet OpenAI wachsende Nutzung. Seit dem Start der Codex App für macOS verzeichnet das Unternehmen über 500.000 Downloads, Codex zählt inzwischen rund eine Million wöchentlich aktive Nutzer:innen. Zusätzlichen Schub erhält das Modell durch neue Integrationen: GPT-5.3-Codex lässt sich inzwischen direkt in Apples Xcode 26.3 sowie in GitHub Workflows mit Copilot Pro+ oder Enterprise nutzen, um komplexe Aufgaben autonom innerhalb bestehender Entwickler:innenumgebungen auszuführen.

OpenAI Frontier: Agents für komplexe Workflows statt mehr KI-Chaos

Während OpenAI mit GPT-5.3-Codex vor allem die Leistungsfähigkeit der Modelle adressiert, setzt Frontier an einem tieferliegenden Problem an. Viele Unternehmen scheitern weniger an der Intelligenz von KI als an ihren eigenen Strukturen. Zersplitterte Systeme, über Clouds und Anwendungen verteilte Daten sowie uneinheitliche Governance erschweren es, Agents sinnvoll in den Arbeitsalltag einzubinden. Zwar kommen Agents zunehmend zum Einsatz, agieren aber oft isoliert – und erhöhen so eher die Komplexität, statt sie zu verringern.

Die Folge ist eine wachsende Lücke zwischen dem Potenzial moderner KI-Modelle und dem, was Organisationen tatsächlich produktiv nutzen können. Die Technologie entwickelt sich rasant, doch Prozesse, Wissen und Kontrollmechanismen halten häufig nicht Schritt. Der Druck steigt, weil sich der Abstand zwischen früh adaptierenden Organisationen und dem restlichen Markt weiter vergrößert.

Genau hier setzt Frontier an. Wie OpenAI im offiziellen Blog beschreibt, geht es nicht nur um bessere Tools, sondern um die Frage, was Agents brauchen, um zuverlässig arbeiten zu können. Frontier orientiert sich dabei explizit an Strukturen, die auch für menschliche Mitarbeitende selbstverständlich sind.

Damit Agents im Unternehmen produktiv werden, braucht es laut OpenAI:

- Gemeinsamen Kontext: Agents müssen verstehen, wie Arbeit systemübergreifend abläuft und wo relevante Informationen liegen.

- Zugriff auf Tools und Systeme: Agents benötigen die Möglichkeit, mit Dateien, Software und Daten zu arbeiten, statt nur zu antworten.

- Klare Vorstellung von guter Arbeit: Qualität soll sich durch Feedback und Erfahrung kontinuierlich verbessern.

- Identität und Berechtigungen: Agents brauchen definierte Rollen, Rechte und Grenzen, denen Teams vertrauen können.

- Governance im Alltag: Kontrolle, Nachvollziehbarkeit und Sicherheit müssen integriert sein – nicht nachträglich ergänzt werden.

Frontier verbindet bestehende Systeme wie CRMs, interne Anwendungen, Datenbanken und Ticketing Tools und schafft so einen gemeinsamen Business-Kontext für Agents. Ziel ist der Übergang von einzelnen Chatbots hin zu KI-Kolleg:innen, die abteilungsübergreifend eingesetzt werden können und reale Aufgaben übernehmen.

Zu den ersten Unternehmen, die Frontier nutzen, zählen laut OpenAI unter anderem HP, Intuit, Oracle und Uber. Weitere Organisationen wie State Farm, Cisco, BBVA und T-Mobile setzen Frontier bereits in Pilotprojekten ein. Begleitet werden sie von sogenannten Forward Deployed Engineers, die Teams beim Aufbau, Betrieb und der Governance produktiver Agents unterstützen.

Die nächste Evolutionsstufe im Agent Shift – mit offenen Fragen

Mit GPT-5.3-Codex und Frontier treibt OpenAI den Agent Shift konsequent weiter. Wie das Unternehmen selbst im Blog einordnet, liegt die zentrale Hürde für den KI-Einsatz inzwischen weniger in der Modellintelligenz als in der Einbettung in reale Arbeitsprozesse. GPT-5.3-Codex liefert dafür die technische Grundlage, Frontier soll die organisatorische Infrastruktur bereitstellen.

Damit positioniert sich OpenAI zunehmend nicht nur als Modellanbieter:in, sondern als Plattform für agentische Systeme, die produktive Arbeit übernehmen sollen – von der Software-Entwicklung bis hin zu geschäftskritischen Prozessen im Enterprise-Umfeld. Offen bleibt jedoch, wie gut sich diese neuen Agent-Strukturen in Unternehmensstrukturen und Arbeitsprozesse integrieren lassen. Denn mit wachsender Autonomie steigen auch die Anforderungen an Zuständigkeiten, abgestimmte Workflows und tragfähige Governance.

Genau an diesem Punkt setzt auch die Einordnung von Julian A. Kramer von Adobe an, mit dem wir auf dem AI Forum in München gesprochen haben. Agentic AI sei weniger eine Tool- als vielmehr eine Organisationsfrage. Entscheidend sei, wie Agent Teams strukturiert werden, wie sich Prozesse verändern und ob Governance nicht nur technisch vorgesehen, sondern im Arbeitsalltag tatsächlich gelebt wird.

„Du orchestrierst Agents wie ein Teamchef Aufgaben verteilt“:

Der Sprung von Gen AI zu Agentic AI

Online Marketing & SEO

GEO, SEO, DEO? Google rollt Core Update für Discover aus

Google erklärt, dass der Roll-out zunächst für englischsprachige Ergebnisse in den USA erfolgt. Doch in den kommenden Monaten wird das Core Update ebenfalls in weiteren Ländern, dann auch in Deutschland, ausgerollt. Im Google Search Status Dashboard können User wie gewohnt den Verlauf verfolgen. Der aktuelle Roll-out soll rund zwei Wochen andauern. In diesen Zwei Wochen werden Seitenbetreiber:innen in den USA deutliche Schwankungen im Discover Traffic erleben – genauso wie bei Core Update Ranking-Schwankungen in der Suche auftreten. Google gibt an, dass im Rahmen dieser Algorithmusanpassung vor allem drei Kernpunkte behandelt werden:

- Clickbait-Artikel sollen stark minimiert werden. Das gilt auch für „sensational“ Content, also Inhalte, die bewusst einen Fokus auf übertriebene Sensationstitel setzen.

- Lokale Nachrichten sollen den Nutzer:innen vermehrt ausgespielt werden. Sie sollen vor allem mehr Inhalte von Neuigkeiten aus ihren Ländern sehen.

- User sollen mehr Beiträge mit tiefgreifenden, aktuellen und von jahrelanger Expertise geprägten Inhalten finden. Dabei sollen Seiten mit ausgewiesener Expertise und einem Renommee in Fachbereichen mehr in den Mittelpunkt gerückt werden.

Discover Engine Optimization (DEO) notwendig?

Das klingt grundsätzlich positiv für Publisher. Gelingt es Google, diese Vorgaben mit dem Core Update umfassend umzusetzen, könnten viele Seiten mit qualitativen und aktuellen Inhalten, aber auch Lokal-Publisher auf mehr Sichtbarkeit und Traffic hoffen, gerade im Wettbewerb mit den von Google oft bevorzugt angezeigten großen Medienhäusern. Wie gut Google das Content-Gleichgewicht in Discover jedoch optimieren kann, wird das neue Discover Core Update erst zeigen müssen. Passend dazu liefert Google auf dem Blog der Google Search Central ein Beispiel für Content, der im Laufe des Updates mehr Sichtbarkeit erlangen kann:

Since many sites demonstrate deep knowledge across a wide range of subjects, our systems are designed to identify expertise on a topic-by-topic basis. So whether a site has expertise in multiple areas or has a deep focus on a single topic, there’s equal opportunity to show up in Discover. For example, a local news site with a dedicated gardening section could have established expertise in gardening, even though it covers other topics. In contrast, a movie review site that wrote a single article about gardening would likely not.

Allerdings sehen sich die Publisher und Seitenbetreiber:innen zugleich mit einigen Problemen konfrontiert. So stellen sich erste User, etwa unter Googles Ankündigungs-Post auf LinkedIn, die Frage, ob sie sich neben der SEO und GEO jetzt auch mit der DEO beschäftigen müssten. Doch zur Anzeige in Discover können die Seitenbetreiber:innen selbst nur bedingt beitragen. Grundsätzlich gelten die Tipps und Hinweise für alle Core Updates im Rahmen auch dieser Algorithmusanpassung, so Google. Informationen und Hilfestellung im Kontext großer Updates wiederum liefert Google im Rahmen einer neuen Dokumentation mit mehr Details. Im ausführlichen Guide von OnlineMarketing.de kannst du nachlesen, was Webmaster grundsätzlich im Vorwege von Core Updates beachten können. Solange Creator und Medien jedoch Inhalte erstellen, die hilfreich, einzigartig und für Menschen gemacht sind, müssen sie sich nicht unbedingt zum Handeln bewegt sehen. Noch mehr Informationen finden Seitenbetreiber:innen und SEOs in der Google Search Central, die Basics zu Core Updates teilt.

KI-Zusammenfassungen als Traffic-Hemmnis

Des Weiteren dürften Publisher trotz Googles positiv dargestelltem Update Befürchtungen bezüglich des Traffics aus dem Bereich Discover haben. Denn dort hat Google seit Monaten ebenfalls KI-Zusammenfassungen für Beiträge integriert, die die Klickrate und den Traffic verringern könnten. Demnach könnten einige Publisher und andere Seiten durch das Core Update zwar langfristig mehr Impressions generieren, müssen sich aber womöglich so oder so auf weniger Traffic aus dem Bereich einstellen. Im Leistungsbericht für Discover können User diesen in der Google Search Console analysieren.

Welche Inhalte User letztendlich in ihrem eigenen Discover Feed sehen, hängt aber ebenfalls stark von persönlichen Einstellungen ab. Denn die Nutzer:innen können Präferenzen zu Quellen und Marken angeben. Neuerdings können erste User sogar mithilfe von AI Prompts ihren Discover Feed nach den eigenen Vorstellungen anpassen.

-

Entwicklung & Codevor 3 Monaten

Entwicklung & Codevor 3 MonatenKommandozeile adé: Praktische, grafische Git-Verwaltung für den Mac

-

Künstliche Intelligenzvor 1 Monat

Künstliche Intelligenzvor 1 MonatSchnelles Boot statt Bus und Bahn: Was sich von London und New York lernen lässt

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenHuawei Mate 80 Pro Max: Tandem-OLED mit 8.000 cd/m² für das Flaggschiff-Smartphone

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenFast 5 GB pro mm²: Sandisk und Kioxia kommen mit höchster Bitdichte zum ISSCC

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenKommentar: Anthropic verschenkt MCP – mit fragwürdigen Hintertüren

-

Social Mediavor 2 Monaten

Social Mediavor 2 MonatenDie meistgehörten Gastfolgen 2025 im Feed & Fudder Podcast – Social Media, Recruiting und Karriere-Insights

-

Datenschutz & Sicherheitvor 2 Monaten

Datenschutz & Sicherheitvor 2 MonatenSyncthing‑Fork unter fremder Kontrolle? Community schluckt das nicht

-

Künstliche Intelligenzvor 3 Monaten

Künstliche Intelligenzvor 3 MonatenWeiter billig Tanken und Heizen: Koalition will CO₂-Preis für 2027 nicht erhöhen