Künstliche Intelligenz

Google Street View: 12.500 Dollar Schadenersatz wegen Nacktaufnahme im Garten

Den eigenen Hintern entblößt auf Google Street View zu entdecken, dürfte für viele Nutzer keine schöne Vorstellung sein. Ein argentinischer Polizist, dem das widerfuhr, erstritt vor Gerichten seines Landes nun umgerechnet rund 12.500 US-Dollar Schadensersatz. Denn nicht nur sein nackter Po war auf dem Straßenansichtsdienst des Suchmaschinenriesen öffentlich zu bewundern gewesen, sondern auch andere Teile seines Körpers.

2017 hatte sich der Ordnungshüter dem US-Sender CBS zufolge nackt in seinem Garten in einer argentinischen Kleinstadt aufhalten. Just in diesem Moment fuhr ein Google Street View-Auto mit einer hoch montierten Kamera vorbei, die ihn von hinten aufnahm. Obwohl er sich hinter einer fast zwei Meter hohen Mauer befand, waren sein unverhüllter Körper, die Nummer seines Hauses und der Straßenname im Internet sichtbar. Für das argentinische Fernsehen und Kommentatoren in sozialen Netzwerken ein gefundenes Fressen.

Der Kläger argumentierte laut CBS, aufgrund der Veröffentlichung und Verbreitung des Bildes an seinem Arbeitsplatz und in der Nachbarschaft verspottet worden zu sein. Zunächst wies die erste Instanz seine Eingabe aber ab. Die Richter stellten darauf ab, der Polizist sei selbst schuld, wenn er „unter unangemessenen Bedingungen“ nackt im Garten herumlaufe. Google führte zudem zunächst erfolgreich ins Feld, die Mauer sei nicht hoch genug gewesen.

Eklatanter Grundrechtseingriff

Die Berufungsrichter sahen die Sache anders. Sie entschieden, dass die Persönlichkeitswürde des Klägers klar verletzt worden sei und sprachen ihm die vergleichsweise hohe Entschädigung zu. Diese müsse Google zahlen. Die zweite Instanz begründete das damit, dass das Bild seiner Person nicht im öffentlichen Raum, sondern im privaten Zuhause hinter einem hohen Zaun aufgenommen worden sei. Die Richter erkannten darin einen „eklatanten Eingriff in die Privatsphäre“. Das Gericht betonte weiter, es gebe „keine Rechtfertigung“ dafür, dass Google die Verantwortung für diesen „schwerwiegenden Fehler“ ablehne.

Als Beleg dafür, dass Google sich seiner Verantwortung bewusst war, verwiesen die Richter auf Googles eigene Richtlinie, Gesichter und Nummernschilder auf Street View-Bildern zu verpixeln. Sie argumentierten, dass in diesem Fall der gesamte nackte Körper sichtbar war, was erst recht hätte verhindert werden müssen. Andere Beklagte wie ein Telekommunikationsunternehmen und den Betreiber einer Nachrichtenseite sprach das Gericht von der Haftung für die Verbreitung des Bildes frei: Deren Handlungen hätten mit dazu beigetragen, den Fehler von Google aufzudecken.

Street View ist für viele ein rotes Tuch

Google verweist auf Maßnahmen zum Schutz der Privatsphäre, die das Unternehmen ergreife. Außerdem gebe es einen Weg, über den Nutzer beantragen können, ihr gesamtes Haus, Auto oder ihren Körper unkenntlich zu machen.

In der Vergangenheit gab es bereits Fälle, in denen Google für Street View-Aufnahmen Schadensersatz leistete: 2019 zahlte das Unternehmen 13 Millionen US-Dollar in einem Vergleich wegen der Sammlung privater Daten durch Street View. 2010 zahlte Google einem Paar einen symbolischen US-Dollar Schadensersatz wegen einer unerlaubten Aufnahme ihres Hauses für Street View. In Deutschland war Street View jahrelang heftig umstritten. Der hessische Datenschutzbeauftragte Alexander Roßnagel mahnte voriges Jahr zur Vorsicht angesichts der Aktualisierung und Erweiterung des Services. Es sei nötig, bereits erteilte Widersprüche gegen das Anzeigen unerwünschter Aufnahmen zu erneuern.

(nen)

Künstliche Intelligenz

Live Translation für die AirPods Pro: EU-Nutzer bekommen die Funktion nicht

Große Enttäuschung bei Besitzern von AirPods Pro, die auf die neue Liveübersetzungsfunktion gewartet haben: Die Funktion wird laut Apple im Gebiet der Europäischen Union (EU) nicht zur Verfügung stehen. Betroffen davon sind Nutzer, die sich in der EU befinden und deren Apple-Konto einem EU-Land zugeordnet ist. Zu den Gründen schweigt Apple. Die Information selbst wurde einem Support-Dokument entnommen, das im Netz einsehbar ist. Eine Anfrage von Mac & i hat Apple bislang nicht beantwortet.

Mit Blick auf die Geschehnisse der letzten Zeit gilt es allerdings als sehr wahrscheinlich, dass die Entscheidung mit dem anhaltenden Zwist zwischen Apple und der Europäischen Kommission über Fragen der Interoperabilität zu tun haben dürfte. Die EU möchte, dass Apple sich bei seiner Hard- und Software für Mitbewerber öffnet. Apple lehnt dies an vielen Stellen mit Hinweis auf Risiken für die Sicherheit der Nutzer und Geräte ab. Offen ist allerdings, ob Apple im Falle der Live-Übersetzung in vorauseilendem Gehorsam handelt. Oder ob es schon Signale aus Brüssel gegeben hat.

Viele EU-Sprachen werden unterstützt

Die neue Live-Übersetzung – im Original Live Translation – hat Apple am Dienstag während des „Awe Dropping“-Events am Beispiel der neuen AirPods Pro 3 vorgestellt. Sie steht aber als Softwareupdate im Zusammenhang mit iOS 26 für das iPhone auch für die AirPods 4 sowie für die AirPods Pro 2 zur Verfügung. Nötig ist allerdings mindestens ein iPhone 15 Pro oder ein anderes geeignetes Gerät, das Apple Intelligence unterstützt.

Die Funktion ermöglicht es, beim Tragen der Ohrhörer auf KI-Funktionen zurückzugreifen, die das Gesagte des Gegenübers in die eigene Sprache übersetzen. Umgekehrt wird das eigene Gesagte auch in die Gegenrichtung übersetzt. Wenn nur einer der Gesprächspartner über geeignete AirPods verfügt, werden die Antworten auf dem iPhone-Display angezeigt. Wenn beide die Geräte haben, erfolgt die Übersetzung beim Gegenüber direkt per Sprache.

Apple unterstützt zum Auftakt Englisch, Französisch, Deutsch, Portugiesisch und Spanisch. Noch in diesem Jahr sollen auch Italienisch, Japanisch, Koreanisch und Chinesisch folgen.

Knackpunkte an mehreren Stellen

Rechtliche Knackpunkte im Falle einer EU-Einführung sind an mehreren Stellen denkbar. Der AI-Act etwa könnte Anwendung finden, da die neue Funktion dauerhaft Sprache verarbeitet. Hier wäre eine Einstufung als sensibler KI-Anwendungsfall möglich. Auch im Zusammenhang mit der Datenschutzgrundverordnung besteht Konfliktpotenzial, mit Blick auf die Frage, ob andere Personen erkennen können, dass eine aufnehmende und sprachverarbeitende Funktion der AirPods Pro aktiv ist. Und schließlich könnten auch die Interoperabilitätsanforderungen eine Hürde sein. Apple müsste dann Mitbewerbern gleichberechtigt auch solche Funktionen anbieten lassen, etwa mit einem anderen Smartphone als dem iPhone – etwas, was Apple ablehnt.

Apples Mitbewerber sehen das Thema augenscheinlich entspannter. Die Pixel Buds von Google bieten bereits seit Längerem eine Live-Übersetzung im EU-Raum an.

Bei Software-Features für das iPhone scheint die Lage deutlich entspannter zu sein als bei der Live-Übersetzung mit AirPods. Entsprechende Übersetzungsfunktionen, die mit iOS 26 kommen sollen, stehen bislang nicht auf der Streichliste für EU-Nutzer.

Apple-Nutzer sind verärgert

In Foren sind bereits zahlreiche verärgerte Reaktionen von Apple-Kunden zu lesen. Der Frust richtet sich zumeist allerdings gegen die Europäische Union und ihre Regulierung. Apple selbst unternimmt bislang wenig, um die Situation aufzuklären. Ähnlich lief es bei der Einführung der Apple Intelligence, wo lange unklar war, ob und wann sie in der EU eingeführt wird. Am Ende gehörten EU-Länder und -Sprachen sogar zu den ersten in der internationalen Erweiterung. Aber es gibt auch andere Beispiele: Das iPhone-Mirroring, das es ermöglicht, ein iPhone per Mac fernzusteuern, gibt es bis heute nicht in der EU. Auch hierzu äußert sich Apple nicht, woran es liegt und ob eine Perspektive besteht.

(mki)

Künstliche Intelligenz

Material 3 Expressive: Googles neues Design für Pixel angeschaut

Das im Mai im Zuge der Entwicklerkonferenz I/O angekündigte Material 3 Expressive (M3E) ist angekommen. Erst lieferte Google es mit der Pixel-10-Serie aus und seit dem 3. September können es mit dem Release von Android 16 QPR1 (aka Pixel Drop) Besitzerinnen und Besitzer eines Pixel 6 und neuer auf ihren Geräten installieren. Vieles ist (optional) bunter, mutiger und mit prominenteren Schriftelementen versehen. Aber auch bei der Bedienung hat sich etwas geändert.

Wir werfen einen zweiten Blick auf die nun überwiegend fertige Bedienoberfläche, die von ersten, teils angepassten Apps begleitet wird.

Auf Wunsch bunt

Wie Google im Mai sagte, handelt es sich bei Material 3 Expressive um die „am umfangreichsten erforschte Designsprache des Konzerns, die die breiteste Nutzerschicht über Generationen hinweg ansprechen soll“. Damit könnte Google recht haben, denn auch wenn sie auf den ersten Blick mit viel „Buntifunti“ und knalligen Farben daherkommt, bietet sie umfangreiche Anpassungsoptionen. Damit kommen auch Nutzerinnen und Nutzer, die dezente Farben oder sogar ein komplett farbloses Erscheinungsbild bevorzugen, auf ihre Kosten.

Kaum Unterschiede zum Vorgänger: Der anpassbare Homescreen von Android 16 Material 3 Expressive.

(Bild: Andreas Floemer / heise medien)

Optische Änderungen sind beim Blick auf den Homescreen zunächst nicht zu erkennen, es sei denn, man schaut auf Details wie die Akkuanzeige, Netzwerksymbole und die Uhr, die Google neu gestaltet hat. Größer ist die Änderung in den Schnelleinstellungen, denn die einzelnen Schaltflächen lassen sich in ihrer Breite anpassen, wodurch mehr Platz für Buttons in einer Ansicht zur Verfügung steht. Einige Schaltflächen wie Bluetooth sollte man jedoch in ihrer normalen Breite belassen, da sie so zwei Funktionen innehaben: Tippt man auf die linke Seite des Buttons, kann Bluetooth deaktiviert werden, während ein Tipp auf die rechte Seite zu den weiteren Einstellungen führt.

Die neuen Schnelleinstellungen sind in ihrer Größe anpassbar.

(Bild: Andreas Floemer / heise medien)

Eine neue Form hat außerdem der Helligkeitsregler in den Schnelleinstellungen, der nun weniger abgerundet ist und einen schmalen Querbalken als Indikator erhalten hat. Die gleiche Designänderung ist auch bei den Lautstärke- und Medienreglern zu finden, die über die Lautstärkeleiste erreichbar sind.

Helligkeitsregler und die Lautstärke sind unter Android 16 Material 3 Expressive optisch aufgefrischt worden.

(Bild: Andreas Floemer / heise medien)

In der Übersicht der zuletzt geöffneten Apps, die entweder über den Recents-Button (rechts in der Button-Navigation) oder über die entsprechende Wischgeste auffindbar ist, hat jede App ein Drop-down-Menü erhalten, in dem eine einzelne App entfernt werden kann. Weiterhin gelangt man hierüber in die jeweiligen App-Einstellungen, um etwa Berechtigungen einzusehen und zu verwalten.

Lesen Sie auch

Neu gestaltet ist die App-Übersicht, die jetzt wie eine zusätzliche Ebene auf den Homescreen gezogen wird. Wie bei den Schnelleinstellungen schimmern in der App-Übersicht stets Farbnuancen des Bildschirmhintergrunds hindurch, was eine gewisse Leichtigkeit im Vergleich zu den bisher verwendeten einfarbigen und intransparenten Hintergründen erzeugt.

Die App-Übersicht unter Android16 Material 3 Expressive mit verschiedenen, leicht hindurchscheinenden Hintergründen.

(Bild: Andreas Foemer / heise medien)

Abseits der Optik zieht mit Material 3 Expressive auch eine neue Haptik ein: Beim Wegwischen einer Benachrichtigung aus der Benachrichtigungsübersicht oder einer Mail in der Gmail-App vibriert das Gerät jetzt auf Wunsch. Auch die neuen Animationen beim Ausblenden einer Benachrichtigung, bei denen die danebenliegenden Benachrichtigungen auf die Interaktion reagieren, sind hübsch anzusehen und bringen ein dynamischeres Gefühl bei der Bedienung des Geräts.

Neue Tricks für den Sperrbildschirm

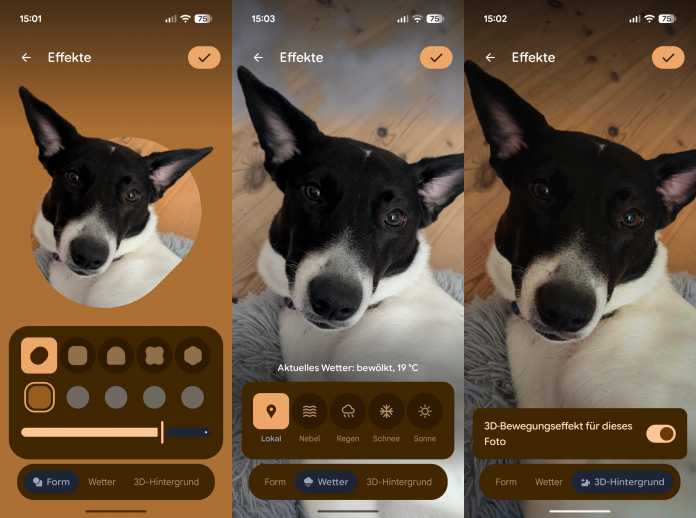

Mit Material3 Expressive verabreicht Google dem Sperrbildschirm neue Effekte: Zum einen können Nutzer ein eigenes Bild verwenden, das sie mit unterschiedlichen Rahmenformen und verschiedenfarbigen Hintergrundfarben versehen können. Während dies in der Betaversion noch nicht fehlerfrei funktionierte, ist es in der finalen Release besser nutzbar. Leider ist die Auswahl der Hintergrundfarben eine Nuance zu reduziert.

Funktionen des neuen Lockscreens.

(Bild: Andreas Floemer / heise medien)

Zum anderen ist es möglich, Witterungsbedingungen wie Sonne, Regen oder Schnee auf den Sperrbildschirm zu zaubern – selbst das lokale Wetter lässt sich dort dezent abbilden. Wer mag, kann sein Bild auch mit einem 3D-Effekt versehen, wodurch es räumlicher erscheint. Der Effekt ist auch auf dem Homescreen abbildbar.

Stückwerk: Material 3 Expressive in Apps

Material 3 Expressive durchzieht nicht nur Android 16 (QPR1), sondern es landet portionsweise auch in Anwendungen – allen voran natürlich in Googles eigenen Apps. Das neue Design scheint der Konzern zudem nicht auf einmal im vollen Umfang umzusetzen, sondern schubweise. So sind in Gmail, Chrome und der Wallet erste M3E-Elemente zu finden, ebenso hat Google die „Mein Gerät finden“-App als auch Files schon angefasst.

Googles Anruferansicht unter Android ähnelt in gewisser Hinsicht Apples Kontaktpostern.

(Bild: Google)

Derweil hat Google die Telefon-App umfangreich überarbeitet und mit einem iOS-ähnlichen Anrufbildschirm versehen. Im Zuge dessen hat Google die Übersicht der eigenen Favoriten in ihrer Größe reduziert und in ein Karussell verfrachtet, was wenig nachvollziehbar ist – die bisherige Ansicht war übersichtlicher. Vollkommen an die neue Optik angepasst sind derweil die Screenshots- und die neue Tagebuch-App.

Sukzessive dürften auch andere Entwickler das neue Design übernehmen, wobei es derzeit noch überschaubar ist. Lediglich die Wallpaper-App Backdrops wurde schon ein Stück weit überarbeitet.

Die an M3E angepassten Apps kommen zudem nicht nur auf Smartphones mit Android 16 zum Einsatz, sondern auf allen Android-Versionen. Überdies landet die neue Optik auch auf Wear-OS-Geräten wie der Pixel Watch. Hier hat Google ebenfalls schon vorgelegt und erste Anwendungen überarbeitet.

Mit QPR1 ist noch nicht Schluss

Mit dem Feinschliff vor allem auf App-Ebene hat Google unterm Strich noch allerhand zu tun. Allerdings zeigt die nächste Beta-Version von Android 16 namens QPR2, die im Dezember als Pixel Drop erscheinen wird, dass Google automatisch ein themenbezogenes Symbol für Apps bereitstellt, sofern Entwickler keines für das dynamische Theme von Android hinterlegt haben.

Mit dem Update auf Android 16 QPR2 (Pixel Drop) will Google die App-Icon-Desings – falls Nutzer es einstellen – farblich vereinheitlichen.

(Bild: Andreas Floemer / heise medien)

Das System wendet laut Google dann einen Farbfilteralgorithmus auf das vorhandene App-Symbol an, „um es in einem monochromen Stil darzustellen, sodass es sich in das vom Benutzer gewählte Theme integrieren lässt“. Neu ist außerdem, dass die Bedienoberfläche der App vollständig interaktiv bleibt, wenn das System-Sharesheet geöffnet ist. Selbst große Entwickler wie Microsoft, Netflix oder Amazon bieten keine entsprechend angepassten Apps für Outlook oder Amazon Prime Video an. Zudem können Nutzer mit QPR2 den Dunkelmodus in Apps erzwingen, auch wenn Entwickler keinen integriert haben.

Wie bei Googles Material You von 2021 dürfte Google die neue Material 3 Expressive auch für weitere Hersteller bereitstellen, sodass sie es zumindest teilweise für ihre Bedienoberflächen übernehmen. Motorola bleibt bei der Bedienoberfläche für die eigenen Smartphones recht nah bei Googles Design, während andere Hersteller wie Samsung oder Oneplus eher nur Elemente wie das dynamische Theming übernehmen. Bei den Apps mit Material 3 Expressive haben sie jedoch keine Wahl.

(afl)

Künstliche Intelligenz

Beamer-Trends von der IFA 2025

Heute steckt in vielen Projektoren Lasertechnik, die den Bildwerfern zu mehr Lichtleistung verhilft. Dabei muss man jedoch unterscheiden zwischen echten Lasern und solchen, deren Licht über den Umweg einer Phosphorschicht angeregt wird. Diese Technik erzeugt insbesondere grünes Licht indirekt.

Echte grüne Festkörperlaser sind sehr aufwendig, teuer und brauchen starke Kühlung; ihr Licht entsteht durch die Umwandlung der Wellenlänge von Infrarotlasern am nichtlinearen Kristall (sogenannte Frequenzverdopplung). Sie stecken allenfalls in professionellen Kinoprojektoren.

In Heimkinobereich kommen stattdessen blaue Halbleiterlaser und zuweilen auch rote Laserdioden zum Einsatz. Der blaue Laserstrahl fällt innerhalb der Projektionseinheit auf eine beschichtete Phosphorscheibe, die daraufhin gelbes Licht reflektiert. Der gelbe Lichtstrahl wird über einen dichroitischen Spiegel in grünes und rotes Licht zerlegt. Zusätzliche rote und blaue Laser-LEDs verstärken den Lichtstrahl weiter, bevor er auf den DLP-Spiegelchip fällt (Digital Light Processing) und auf die Leinwand reflektiert wird. Am Ende bringen selbst die kompakten Laser-Projektoren über 5000 Lumen auf die heimische Leinwand. Das reicht auch für Räume, die nur leicht abgedunkelt sind.

Das war die Leseprobe unseres heise-Plus-Artikels “ Beamer-Trends von der IFA 2025″.

Mit einem heise-Plus-Abo können Sie den ganzen Artikel lesen.

-

Datenschutz & Sicherheitvor 3 Monaten

Datenschutz & Sicherheitvor 3 MonatenGeschichten aus dem DSC-Beirat: Einreisebeschränkungen und Zugriffsschranken

-

UX/UI & Webdesignvor 3 Wochen

UX/UI & Webdesignvor 3 WochenDer ultimative Guide für eine unvergessliche Customer Experience

-

Apps & Mobile Entwicklungvor 3 Monaten

Apps & Mobile Entwicklungvor 3 MonatenMetal Gear Solid Δ: Snake Eater: Ein Multiplayer-Modus für Fans von Versteckenspielen

-

Social Mediavor 3 Wochen

Social Mediavor 3 WochenRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

UX/UI & Webdesignvor 2 Wochen

UX/UI & Webdesignvor 2 WochenAdobe Firefly Boards › PAGE online

-

Online Marketing & SEOvor 3 Monaten

Online Marketing & SEOvor 3 MonatenTikTok trackt CO₂ von Ads – und Mitarbeitende intern mit Ratings

-

Entwicklung & Codevor 3 Wochen

Entwicklung & Codevor 3 WochenPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 1 Woche

Entwicklung & Codevor 1 WocheEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events