Künstliche Intelligenz

Googles Kohlendioxid-Emissionen steigen erneut | heise online

Wieder ein Anstieg bei den CO2-Emissionen: Das geht aus Googles Nachhaltigkeitsbericht hervor, den das Unternehmen hinter der bekannten Suchmaschine jetzt veröffentlicht hat. Demnach ist die Gesamtmenge des ausgestoßenen Kohlendioxids um elf Prozent auf rund 11,5 Millionen Tonnen angewachsen. Verglichen mit 2019 ist das ein Anstieg von 51 Prozent.

Die Zahl repräsentiert jedoch nicht das komplette Ausmaß. Google spricht hier nur von „ambitionsbasierten“ („ambition-based“) Emissionen. Mit dieser Definition schließt das Unternehmen Emissionen aus seiner CO2-Kalkulation aus, die innerhalb seiner Lieferketten auftreten und auf die Google nach eigenen Angaben keinen Einfluss hat, udn mutmaßlich auch keine Ambitionen. Ausgeschlossen werden zum Beispiel bestimmte eingekaufte Waren oder Lebensmittel.

Das wahre Ausmaß ist größer

Ein entsprechend erweitertes Ausmaß der CO2-Emissionen ist in einer Tabelle im Anhang des Berichts zu finden. Demnach hat Google im Jahr 2024 rund 15,2 Millionen Tonnen an Treibhausgasen verursacht. Zum Vergleich: Ein mittelgroßes Kohlekraftwerk stößt laut der Umweltschutzorganisation Worldwide Fund for Nature rund zehn Millionen Tonnen CO2 pro Jahr aus.

Google pocht in seinem Bericht auch auf einen Rückgang der CO2-Emissionen im Bereich der Rechenzentren. Der Energieverbrauch steigt aufgrund des hohen Aufwands zur Entwicklung von Modellen Künstlicher Intelligenz (KI) jedoch weiter an. Im Vergleich zu 2019 sind auch die CO2-Emissionen durch Rechenzentren deutlich höher. Waren es vor sechs Jahren noch rund eine halbe Million Tonnen CO2, waren es 2024 etwas weniger als drei Millionen Tonnen. Immerhin unterbietet das den Wert von rund drei Millionen Tonnen im Jahr 2023 knapp, was Google nun positiv hervorhebt.

Google: CO2-Emissionen schwer kontrollierbar

KI sieht Google auch als einen der wesentlichen Faktoren, der sich bei der Kontrolle der eigenen CO2-Emissionen nur schwer beeinflussen lässt. Die schnelle Entwicklung in diesem Bereich mache den zukünftigen Energiebedarf des Unternehmens nur schwer prognostizierbar.

Lesen Sie auch

Außerdem kritisiert der Nachhaltigkeitsbericht Veränderungen in der Klima- und Energiepolitik, die „langsamer als erforderlich“ voranschreitende Einführung CO2-neutraler Energieversorgung und ein Mangel an CO2-neutralen Lösungen in bestimmten Märkten werden genannt. Diese externen Faktoren könnten sich demnach auf die Kosten, die Machbarkeit und den Zeitplan der eigenen Fortschritte auswirken. Und um das zu bewältigen, sei Flexibilität erforderlich.

Die veröffentlichten Zahlen belegen Googles Trend weg von dem Ziel, das sich das Unternehmen 2019 noch selbst gesetzt hat: Da wollte der Suchmaschinen-Gigant bis 2030 nur noch die Hälfte der jährlichen CO2-Emissionen verursachen, die er für 2019 auswies. Zwar wurde dieses Ziel nie offiziell gestrichen – doch die CO2-Zahlen stiegen seitdem um etwas mehr die Hälfte an – gemessen an den tatsächlichen Emissionen, nicht den „ambitionsbasierten“.

(nen)

Künstliche Intelligenz

WhatsApp-Funktion ermöglicht KI-Abschaltung in Chats – ist aber nicht nötig

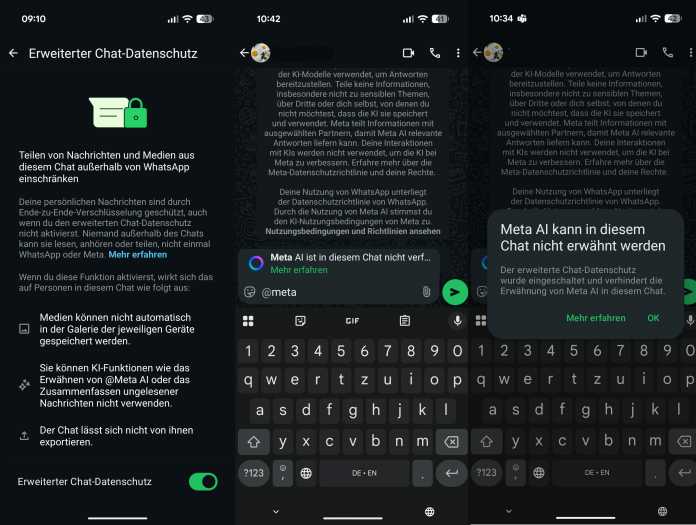

Der Chatbot Meta AI ist seit März in WhatsApp integriert. Die KI, die in der App prominent als blau umrandeter Ring auf der Startseite zu finden ist, kann nicht entfernt werden, auch wenn diese Frage offenbar immer wieder gestellt wird. Mithilfe der Funktion „Erweiterter Datenschutz“ (Advanced Chat Privacy), die im April eingeführt wurde, können Nutzer die KI allerdings aus Einzel- und Gruppenchats blockieren, damit Teilnehmer eines Chats die KI nicht zuschalten können.

Dass Meta AI auf alle Daten in WhatsApp zugreifen kann, wie in aktuellen Kettenbriefen kolportiert wird, ist indes nicht korrekt – und schon gar nicht ohne Auftrag des Nutzers.

Meta AI in WhatsApp nur durch Nutzer aktivierbar

Ein Panik verbreitender Kettenbrief warnt vor Meta AI in Whatsapp.

(Bild: heise medien)

Die KI in WhatsApp kann nur auf die Daten des Nutzers oder der Nutzerin zugreifen, wenn man mit ihr interagiert und ihr den Auftrag dazu gibt. Sämtliche Einzel- und Gruppenchats sind standardmäßig Ende-zu-Ende-verschlüsselt, sodass nur die Teilnehmer einer Chatrunde Zugriff auf die darin geteilten Informationen haben.

Die in WhatsApp integrierten KI-Funktionen greifen nur dann, wenn Nutzerinnen und Nutzer sie aktiv verwenden. Das heißt: Es findet kein automatischer Zugriff auf Inhalte, geschweige denn Telefonnummern, statt. Zur Erinnerung: Letztere liefern Nutzer übrigens aktiv an Meta aus, wenn sie ihr Adressbuch mit WhatsApp synchronisieren, um ihre Kontakte zu finden.

Nur, wenn Meta AI über den Befehl @Meta in einem Chatfenster angesprochen wird, öffnet der Nutzer quasi die Tür zum Chat für Metas KI. Mit der KI im Chat können etwa verpasste Nachrichten zusammengefasst werden (zunächst nur in den USA) – diese Funktion ist in Deutschland noch nicht verfügbar.

Wie der Konzern erklärt, wird für diese private KI-Zusammenfassung eine Sitzung mit einem Cloud-Server aufgebaut – anonymisiert durch Oblivious HTTP (OHTTP) über Drittanbieter-Zwischenstationen. Die Session soll der Erläuterung zufolge mit einem temporären Schlüssel verschlüsselt sein, auf den „Meta und WhatsApp keinen Zugriff haben“; nur das Endgerät und die Private-Processing-Server können ihn demnach nutzen: Meta betont, dass „niemand außer dem Gerät des Nutzers oder den ausgewählten TEEs (Trusted Execution Environment)“ die Anfrage entschlüsseln könne.

Zudem unterliegt der „Inhalt und die näheren Umstände von Chats zwischen Nutzerinnen und Nutzern von TK-Diensten“, zu denen WhatsApp gehört, „dem besonderen Schutz des Fernmeldegeheimnisses (§ 3 TDDDG), das im Grundgesetz verankert ist (Art. 10 GG) und dessen Verletzung strafbar ist (§ 206 Strafgesetzbuch),“ erklärt die Bundesbeauftragte für den Datenschutz und die Informationsfreiheit (BfDI).

Erweiterter Datenschutz sperrt Nutzer von KI-Verwendung im Chat

Für noch mehr Kontrolle über die Meta-KI, wenngleich nicht wirklich erforderlich, können Nutzer die Funktion „Erweiterter Datenschutz“ aktivieren. Dieses Feature muss indes für jeden Chat einzeln aktiviert werden. Dies erfolgt über die jeweiligen Einstellungen, die durch einen Druck auf den Empfänger des Chats oder den Gruppennamen aufgerufen werden können (nicht das Drei-Punkte-Menü). Tippt man nun @Meta in ein Chatfenster, erhält man den Hinweis, dass die Funktion in dem jeweiligen Chat nicht verfügbar ist.

Erweiterter Chat-Datenschutz: Unter anderem können Nutzer mit der Funktion Meta AI für einzelne Chats sperren.

(Bild: heise medien)

Durch die Aktivierung der „Erweiterten Datenschutzfunktion“ wird nicht nur der Zugriff von Meta AI im Chat gesperrt, sondern mehr: Das Feature sperrt gleichzeitig die Exportfunktion für den jeweiligen Chat und den Medienzugriff, sodass Bilder und Co. nicht in der jeweiligen Mediengalerie des Geräts gesichert werden. Wie erwähnt, ist diese Funktion nicht erforderlich, um Meta AI von unerlaubtem Datenzugriff abzuhalten. Es genügt, wenn keiner der Teilnehmer in einem WhatsApp-Gruppenchat sie verwendet.

Lesen Sie auch

Die „Erweiterte Datenschutz“-Funktion dient laut Meta vor allem in WhatsApp-Gruppen, in denen jemand nicht alle Teilnehmer näher kennt, jedoch auch vertraulichere Dinge besprochen werden. Als ein Beispiel nennt der Konzern etwa Gespräche über gesundheitliche Probleme in Unterstützer-Gruppen.

(afl)

Künstliche Intelligenz

Wärme aus Haus und Wohnung bekommen: Wie Sie es clever und automatisch umsetzen

Die Wetterfrösche erklären es jeden Sommer neu: Die heißesten Stunden des Tages liegen am Abend, oft zwischen 17 und 19 Uhr. Die kühlsten Stunden liegen in der Früh. Trotzdem schließen viele Leute um 10 Uhr das Fenster, um es um 18 Uhr zu öffnen, die wärmste Luft des Tages hereinlassend. Dann wird es jeden Tag wärmer drinnen. Um Wärmeakkumulation im Haus zu minimieren, helfen Automatisierungen, die nach kühler Maschinenlogik lüften und verschatten.

Algorithmen verarbeiten dabei die Temperaturwerte innen und außen. Normalerweise kommt gleich noch eine Wetterprognose aus dem Internet dazu. Ausgefeiltere Lösungen verarbeiten zusätzlich lokale Wetterstationsdaten, Regensensoren an den Fenstern, Anwesenheit, Türkontakte und den CO₂-Gehalt der Raumluft, um außer für eine erträgliche Temperatur auch für annehmbare Qualität der Atemluft zu sorgen.

- Manuelles Lüften und Verschatten hat seine Tücken.

- Automatische Systeme holen das Optimum aus dem Gebäude heraus.

- Eine Vorstellung beispielhafter Systeme mit konkreten Implementierungs-Einordnungen

Dieser Artikel umreißt das Problem, zeigt den Einsatzbereich und das Potenzial des passiven Hitzeschutzes und auch die Grenzen, an denen es dann in die aktive Klimatisierung übergeht. Die wiederum profitiert von intelligenter Lüftung, weil sie weniger laufen muss und die restliche Laufzeit vermehrt in den Sonnenstunden liegt, in denen es viel Solarstrom gibt. Der Artikel endet mit dem kosteneffizientesten Praxistipp für die Nachrüstung eines komplett passiven Systems auch in der Mietwohnung.

Das war die Leseprobe unseres heise-Plus-Artikels „Wärme aus Haus und Wohnung bekommen: Wie Sie es clever und automatisch umsetzen“.

Mit einem heise-Plus-Abo können Sie den ganzen Artikel lesen.

Künstliche Intelligenz

Anthbot Genie 3000 im Test: Mähroboter mit RTK und vier Kameras für große Gärten

Der Genie 3000 von Anthbot ist ein RTK-Mähroboter, der für einen vergleichsweise niedrigen Preis einiges zu bieten hat. Doch überzeugt er auch in der Praxis?

Der aus einem Kickstarter-Projekt hervorgegangene Anthbot Genie 3000 bietet mit einem 10-Ah-Akku eine lange Betriebszeit. Die wird auch benötigt. Schließlich ist das Gerät für Gartengrößen bis 3600 m² vorgesehen. Dank integriertem 4G-Dienst, der für ein Jahr kostenlos ist, lässt er sich von unterwegs jederzeit steuern. Zudem soll er mit den vier Kameras nicht nur fehlerfrei navigieren, wenn das RTK-Signal mal unter Bäumen nicht empfangbar ist, sondern auch zahlreiche Hindernisse erkennen. Gemessen an der Ausstattung ist der kabellose Mähroboter mit einer Preisempfehlung von 1699 Euro relativ günstig. Aktuell gibt es ihn sogar im Angebot für 1459 Euro. Ob sich die Investition in den Anthbot Genie 3000 lohnt, zeigt unser Testbericht.

Anthbot Genie 3000: Design, Ausstattung, Funktionen

Der Anthbot Genie 3000 fällt mit 41 × 27 × 64 Zentimetern (BHL) und einem Gewicht von 13 Kilogramm im Vergleich zu anderen Mährobotern, die für eine Rasenfläche von 3000 m² und größer gedacht sind, relativ kompakt und leicht aus. Der Mammotion Luba 2 AWD ist etwa 5 Zentimeter länger, 10 cm breiter und über 5 kg schwerer. Diese Kompaktheit hat aber ihren Preis. Während der Luba 2 AWD eine Schnittbreite von 40 cm bietet und so beim Mähvorgang entsprechend schnell voranschreitet, begnügt sich der Anthbot Genie 3000 mit einer Schnittbreite von gerade einmal 20 cm. Die großen Hinterräder bieten ein großes Profil, sodass der Genie 3000 auch steilere Stücke bis zu 45 Prozent Steigung schafft.

Die vier Kameras zur Optimierung der Navigation sowie der Erkennung von Objekten befinden sich an der Front und an den Seiten. Der 10-Ah-Akku bietet eine Betriebszeit von vier Stunden. Das ist enorm und erlaubt dem Genie 3000 auch größere Rasenflächen in einem Stück zu mähen. Außerdem ist er austauschbar und unterstützt ein schnelles Aufladen innerhalb von zwei Stunden. Ein Ersatz-Akku kostet für den Genie 3000 329 Euro.

Bilder: Anthbot Genie 3000

Anthbot Genie 3000: Das Überfahren von Rasengrenzen können Anwender mit der App unter der Option „Rand“ je nach Randbereich für ein optimales Mähergebnis unterschiedlich konfigurieren.

Anthbot Genie 3000: Das Überfahren von Rasengrenzen können Anwender mit der App unter der Option „Rand“ je nach Randbereich für ein optimales Mähergebnis unterschiedlich konfigurieren.

Anthbot Genie 3000: Die Mähscheibe bietet fünf Klingen und eine Schnittbreite von 20 cm. Der Abstand vom Gehäuserand bis zur Mähscheibe beträgt etwa 12 cm. Somit bleibt an einer mit hohen Randsteinen begrenzten Rasenfläche ein 12 cm großer Streifen ungemäht.

Anthbot Genie 3000: Die Mähscheibe bietet fünf Klingen und eine Schnittbreite von 20 cm. Der Abstand vom Gehäuserand bis zur Mähscheibe beträgt etwa 12 cm. Somit bleibt an einer mit hohen Randsteinen begrenzten Rasenfläche ein 12 cm großer Streifen ungemäht.

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: Nicht immer erkennt der Mähroboter die Rasengrenze. Tritt ein solcher Fall ein, muss man die Grenze der Karte anpassen oder eine No-Go-Zone anlegen. Das gilt jedoch für alle Mähroboter.

Anthbot Genie 3000 im Test: Nicht immer erkennt der Mähroboter die Rasengrenze. Tritt ein solcher Fall ein, muss man die Grenze der Karte anpassen oder eine No-Go-Zone anlegen. Das gilt jedoch für alle Mähroboter.

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Anthbot Genie 3000 im Test: RTK-Mähroboter mit vier Kameras und großem Akku

Wie alle bislang getesteten RTK-Mähroboter hat auch der Anthbot Genie 3000 das enge Verbindungsstück zwischen zwei Rasenflächen nicht geschafft. Diese Engstelle haben bislang nur Lidar-basierte Geräte wie Ecovacs Goat A3000, Dreame A2 sowie Mammotion Luba Mini AWD Lidar gemeistert.

Wie alle bislang getesteten RTK-Mähroboter hat auch der Anthbot Genie 3000 das enge Verbindungsstück zwischen zwei Rasenflächen nicht geschafft. Diese Engstelle haben bislang nur Lidar-basierte Geräte wie Ecovacs Goat A3000, Dreame A2 sowie Mammotion Luba Mini AWD Lidar gemeistert.

Der Anthbot Genie 3000 bietet auch eine automatische Kartierung. Das ist aber bei Gärten ohne feste Begrenzung zu etwa Beeten nicht sinnvoll. Exakter wird die Karte, wenn man manuell kartiert. Hierfür steuert man den Mähroboter einmal um den Rasen. Schließt sich der Kreis, stoppt die Kartierung automatisch und speichert die Karte ab. Zonen zur Aufteilung der Rasenfläche kann man später hinzufügen.

Der Anthbot Genie 3000 bietet auch eine automatische Kartierung. Das ist aber bei Gärten ohne feste Begrenzung zu etwa Beeten nicht sinnvoll. Exakter wird die Karte, wenn man manuell kartiert. Hierfür steuert man den Mähroboter einmal um den Rasen. Schließt sich der Kreis, stoppt die Kartierung automatisch und speichert die Karte ab. Zonen zur Aufteilung der Rasenfläche kann man später hinzufügen.

Der Anthbot Genie 3000 bietet auch eine automatische Kartierung. Das ist aber bei Gärten ohne feste Begrenzung zu etwa Beeten nicht sinnvoll. Exakter wird die Karte, wenn man manuell kartiert. Hierfür steuert man den Mähroboter einmal um den Rasen. Schließt sich der Kreis, stoppt die Kartierung automatisch und speichert die Karte ab. Zonen zur Aufteilung der Rasenfläche kann man später hinzufügen.

Der Anthbot Genie 3000 bietet auch eine automatische Kartierung. Das ist aber bei Gärten ohne feste Begrenzung zu etwa Beeten nicht sinnvoll. Exakter wird die Karte, wenn man manuell kartiert. Hierfür steuert man den Mähroboter einmal um den Rasen. Schließt sich der Kreis, stoppt die Kartierung automatisch und speichert die Karte ab. Zonen zur Aufteilung der Rasenfläche kann man später hinzufügen.

Der Anthbot Genie 3000 bietet auch eine automatische Kartierung. Das ist aber bei Gärten ohne feste Begrenzung zu etwa Beeten nicht sinnvoll. Exakter wird die Karte, wenn man manuell kartiert. Hierfür steuert man den Mähroboter einmal um den Rasen. Schließt sich der Kreis, stoppt die Kartierung automatisch und speichert die Karte ab. Zonen zur Aufteilung der Rasenfläche kann man später hinzufügen.

Der Anthbot Genie 3000 bietet auch eine automatische Kartierung. Das ist aber bei Gärten ohne feste Begrenzung zu etwa Beeten nicht sinnvoll. Exakter wird die Karte, wenn man manuell kartiert. Hierfür steuert man den Mähroboter einmal um den Rasen. Schließt sich der Kreis, stoppt die Kartierung automatisch und speichert die Karte ab. Zonen zur Aufteilung der Rasenfläche kann man später hinzufügen.

Anthbot Genie 3000: Pro Zone kann man die Mähhäufigkeit, die Schnitthöhe, die Hinderniserkennung sowie die Mährichtung konfigurieren.

Anthbot Genie 3000: Pro Zone kann man die Mähhäufigkeit, die Schnitthöhe, die Hinderniserkennung sowie die Mährichtung konfigurieren.

Anthbot Genie 3000: Der Rasenrand lässt sich aufteilen, sodass man das Randmähen für unterschiedliche Situationen (Begrenzung, offen) optimieren kann. Bei einer festen Rasenbegrenzung bleibt bauartbedingt 12 cm Rasen ungemäht. So groß ist der Abstand von Mähteller bis zum Gehäuserand.

Anthbot Genie 3000: Der Rasenrand lässt sich aufteilen, sodass man das Randmähen für unterschiedliche Situationen (Begrenzung, offen) optimieren kann. Bei einer festen Rasenbegrenzung bleibt bauartbedingt 12 cm Rasen ungemäht. So groß ist der Abstand von Mähteller bis zum Gehäuserand.

Anthbot Genie 3000: Der Rasenrand lässt sich aufteilen, sodass man das Randmähen für unterschiedliche Situationen (Begrenzung, offen) optimieren kann. Bei einer festen Rasenbegrenzung bleibt bauartbedingt 12 cm Rasen ungemäht. So groß ist der Abstand von Mähteller bis zum Gehäuserand.

Anthbot Genie 3000: Der Rasenrand lässt sich aufteilen, sodass man das Randmähen für unterschiedliche Situationen (Begrenzung, offen) optimieren kann. Bei einer festen Rasenbegrenzung bleibt bauartbedingt 12 cm Rasen ungemäht. So groß ist der Abstand von Mähteller bis zum Gehäuserand.

Anthbot Genie 3000: Der Rasenrand lässt sich aufteilen, sodass man das Randmähen für unterschiedliche Situationen (Begrenzung, offen) optimieren kann. Bei einer festen Rasenbegrenzung bleibt bauartbedingt 12 cm Rasen ungemäht. So groß ist der Abstand von Mähteller bis zum Gehäuserand.

Anthbot Genie 3000: Der Rasenrand lässt sich aufteilen, sodass man das Randmähen für unterschiedliche Situationen (Begrenzung, offen) optimieren kann. Bei einer festen Rasenbegrenzung bleibt bauartbedingt 12 cm Rasen ungemäht. So groß ist der Abstand von Mähteller bis zum Gehäuserand.

Anthbot Genie 3000: Der Rasenrand lässt sich aufteilen, sodass man das Randmähen für unterschiedliche Situationen (Begrenzung, offen) optimieren kann. Bei einer festen Rasenbegrenzung bleibt bauartbedingt 12 cm Rasen ungemäht. So groß ist der Abstand von Mähteller bis zum Gehäuserand.

Anthbot Genie 3000: Der Rasenrand lässt sich aufteilen, sodass man das Randmähen für unterschiedliche Situationen (Begrenzung, offen) optimieren kann. Bei einer festen Rasenbegrenzung bleibt bauartbedingt 12 cm Rasen ungemäht. So groß ist der Abstand von Mähteller bis zum Gehäuserand.

Anthbot Genie 3000: Der Rasenrand lässt sich aufteilen, sodass man das Randmähen für unterschiedliche Situationen (Begrenzung, offen) optimieren kann. Bei einer festen Rasenbegrenzung bleibt bauartbedingt 12 cm Rasen ungemäht. So groß ist der Abstand von Mähteller bis zum Gehäuserand.

Anthbot Genie 3000: Der Rasenrand lässt sich aufteilen, sodass man das Randmähen für unterschiedliche Situationen (Begrenzung, offen) optimieren kann. Bei einer festen Rasenbegrenzung bleibt bauartbedingt 12 cm Rasen ungemäht. So groß ist der Abstand von Mähteller bis zum Gehäuserand.

Die RTK-Antenne signalisiert mit einer grün leuchtenden LED, dass sie genügend Satellitendaten für die Navigation empfängt. Wird sie vom Strom getrennt, meldet die App einen Fehler, dass sich die Antenne zur Seite geneigt hätte. Dann muss man die Karte neu anlegen – ein Fehler, der hoffentlich bald korrigiert wird.

Die RTK-Antenne signalisiert mit einer grün leuchtenden LED, dass sie genügend Satellitendaten für die Navigation empfängt. Wird sie vom Strom getrennt, meldet die App einen Fehler, dass sich die Antenne zur Seite geneigt hätte. Dann muss man die Karte neu anlegen – ein Fehler, der hoffentlich bald korrigiert wird.

Die Mähscheibe bietet fünf Klingen, eine Modifikation der Drehgeschwindigkeit wie bei Mammotion-Mährobotern ist allerdings nicht möglich. Im Lieferumfang befinden sich neben dem Mähroboter noch eine RTK-Empfangseinheit mit Erdstab, die Strom direkt von der mitgelieferten Ladestation erhält. Es gibt zwar ein RTK-Verlängerungskabel, sodass man die Antenne einige Meter vom Aufstellort der Ladestation platzieren kann, dennoch hätte uns eine Antenne mit Netzteil, weil flexibler positionierbar, besser gefallen. Wie üblich muss die Ladestation auf einer ebenen Fläche stehen. Laut Handbuch soll man sie entweder auf dem Rasen oder an der Rasengrenze aufstellen. Mäher, Ladestation und RTK-Antenne sind nach IPX6 gegen starkes Strahlwasser geschützt. Eine Garage ist also nicht unbedingt nötig, kann aber sinnvoll sein, wenn der Aufstellort starker Sonneneinstrahlung ausgesetzt ist. Die kann in der Praxis für eine Erwärmung des Akkus sorgen, sodass der Mähroboter seine Arbeit nicht beginnen kann. Das gilt allerdings für sämtliche Modelle.

Das Gehäuse in Anthrazit-Grau ist einwandfrei verarbeitet. Beim ersten Kontakt bemerkt man allerdings, dass es recht wacklig ist. Der Grund dafür ist recht simpel: Es dient damit zusätzlich als Bumper, auf den die Steuerung entsprechend korrigierend eingreift, wenn der Genie 3000 Kontakt mit Objekten hat. Auf der Oberseite befindet sich wie üblich der Not-Aus-Schalter. Darüber befinden sich drei Soft-Touch-Schalter sowie ein Display. Nach dem Einschalten gibt man über diese den vierstelligen PIN-Code ein. Erst danach ist das Gerät betriebsbereit. Überdies kann man mit den Tasten den Mähroboter ein- und ausschalten, einen Mähvorgang starten oder ihn zurück zur Ladestation schicken. Unterhalb des Not-Aus-Schalters sitzt der Regensensor, der dafür sorgt, dass bei Regen der Genie 3000 seine Arbeit einstellt und zur Ladestation zurückkehrt. Hört der Regen auf, setzt der Mähroboter innerhalb einer per App definierten Zeit (0 bis 8 Stunden) den Mähvorgang fort.

Ausgestattet ist der Genie 3000 außerdem mit einer 4G-SIM-Karte, für die im ersten Jahr keine Servicegebühr anfällt. Danach kann man den Dienst innerhalb der App verlängern. Über den 4G-Dienst ist der Roboter auch dann erreichbar, wenn er sich außerhalb der Reichweite des heimischen WLANs befindet. Zudem kann der Genie 3000 damit einen Alarmton von sich geben, wenn sich das Gerät fünf Meter außerhalb der Rasengrenze befindet. Diese Funktion muss man in der App über die Option Diebstahlschutz-Modus aktivieren.

Aufstellort, Inbetriebnahme, Kartierung und Konfiguration

Die Inbetriebnahme sollte dank einer großformatigen Schnellstart-Anleitung schnell erledigt sein. Das mitgelieferte Handbuch, das elektronisch auch innerhalb der App zur Verfügung steht, bietet zusätzliche Informationen. Überdies hat Anthbot Videos zur Inbetriebnahme und Konfiguration sowie zur Wartung des Mähroboters veröffentlicht. Damit sollten selbst Anfänger kein Problem haben, einen passenden Aufstellort zu finden und den Mähroboter mit der Anthbot-App einzurichten. Letztlich muss man bei der Wahl des Aufstellorts nur darauf achten, dass die RTK-Antenne Satellitensignale empfangen kann. Im Erfolgsfall signalisiert die RTK-Antenne dies mit einer grün leuchtenden LED.

Nachdem der Mähroboter mit der Anthbot-App, – die leider nicht für Tablets, sondern nur für Smartphones optimiert ist, – über das heimische 2,4-GHz-WLAN verbunden wurde, erfolgt als Erstes die Kartierung. Hierbei kann man zwischen automatischer und manueller Kartierung wählen. Bei Gärten mit fester Begrenzung kann die automatische Kartierung funktionieren, dennoch bekommt man mit der manuellen Kartierung eine präzisere Karte hin. Wer also an einem optimalen Mähergebnis inklusive gutem Randschnitt interessiert ist, wählt die manuelle Kartenerstellung. Bei Rasenflächen, wie in unserem Test-Garten, mit offenen Übergängen und über einen schmalen Pfad verbundenen Bereichen, ist die automatische Kartierung keine Option. Hier ist die manuelle Erstellung Pflicht.

Bei der manuellen Kartierung steuert man den Mähroboter über die App an der Rasengrenze entlang, bis man wieder zum Ausgangspunkt kommt. Die Kartenerstellung stoppt dann automatisch und speichert die Karte ab. Mit der App kann man anschließend Zonen anlegen, um den Garten sinnvoll aufzuteilen. Das ist etwa dann empfehlenswert, wenn zur Rasenfläche Bereiche gehören, die der Roboter mit einer global eingestellten Mährichtung nicht optimal mäht. So kann man pro Zone nicht nur die Mährichtung festlegen, sondern auch die Anzahl der Mähvorgänge (1 oder 2), die Schnitthöhe (3–7 cm) und die Empfindlichkeit der Kameras zur Objekterkennung (hoch, mittel, niedrig). Letztere lässt sich auch ganz deaktivieren, was etwa in Gärten sinnvoll sein kann, wenn angrenzende Sträucher mit ihren Ästen in die Rasenfläche hineinreichen. In diesem Fall mäht der Roboter die darunterliegende Rasenfläche nicht, weil er die Äste als Hindernis erkennt und sie umfährt. Wer die „Visuelle Inspektionseinstellung“ komplett deaktiviert, sollte aber bei Gärten mit Gefahrenbereichen wie Beete, Schwimmbecken und innerhalb der Rasenfläche stehende Bäume oder Sträucher entsprechende No-Go-Zonen anlegen, um sicherzustellen, dass der Genie 3000 diese Bereiche unter keinen Umständen befährt.

Neben der Möglichkeit, die Rasenfläche in Zonen aufzuteilen, um den Rasenschnitt individuell in puncto Mährichtung und Schnitthöhe anzupassen, bietet die Anthbot-App, wie könnte es anders sein, auch noch eine KI-Funktion. Damit soll der Genie 3000 die Mähstrategie an das Wachstum des Rasens anpassen. Bei dieser Option lässt sich allerdings nur die Zeit sowie Wochentag und Schnitthöhe für die gesamte Rasenfläche einstellen. Die individuellen Einstellmöglichkeiten für die Zonen in Verbindung mit einem Zeitplan gefallen uns für unseren anspruchsvollen Test-Garten jedoch besser. So lassen wir den Mähroboter 3x die Woche für die ihm zugänglichen Bereiche mähen. Leider lässt sich das Randmähen nur manuell durchführen und nicht per Zeitplan festlegen.

Anthbot Genie 3000 im Praxiseinsatz

Der Anthbot Genie 3000 mäht unsere Rasenflächen in gleichmäßigen Bahnen, auch wenn die Vorderräder nicht sehr spurtreu sind und auf unebenem Untergrund zu leichten Schlangenlinien neigen. Dennoch kann sich das Mähergebnis sehen lassen. Auch Beschädigungen am Rasen bleiben aus. Allerdings ist das bei aktuellen Robotern bei den derzeit trockenen Verhältnissen kein nennenswertes Problem. Auf nassem Untergrund sollte man die Geräte ohnehin nicht zur Arbeit schicken.

Das Randmähen gehört standardmäßig allerdings nicht zu seinen Stärken. Hier lässt er mehr Abstand als nötig. Hinzu kommen bauartbedingt noch etwa 12 cm (Abstand vom Gehäuserand zum Messerteller). Hier arbeiten die Ecovacs-Modelle A3000 Lidar und A1600 RTK mit einem Abstand vom Rand zum Messerteller von nur 5 cm deutlich effizienter. Doch das Problem kann teilweise behoben werden, indem man in der App unter „Rand“ die Grenzen der Rasenfläche unterteilt und die Randüberlappung (5–20 cm) je nach Bereich anpasst.

Mit der niedrigsten Einstellung fährt er direkt am Rand, während er mit den anderen Werten diesen in einer bestimmten Breite überfährt. Letzteres ist etwa sinnvoll, wenn an den Rasen eine nicht bewachsene Fläche auf gleicher Ebene grenzt. Wird die Mähfläche hingegen von wenigen Zentimetern hohen Randsteinen begrenzt, ist erstere Einstellung empfehlenswert. Damit verbessert sich das Mähergebnis an der Rasengrenze erheblich. Allerdings muss man den Rand zusätzlich mähen lassen. Das ist zwar etwas umständlicher als bei anderen Herstellern wie Mammotion, deren Mähroboter die Ränder automatisch bei einem Mähvorgang gezielt abfahren, dafür differenziert der Mammotion nicht nach Randtyp.

Wie alle RTK-Mäher scheitert auch der Genie 3000 an unserer Engstelle, die zwei Rasenzonen verbindet. Dabei rutscht er ab und seine Messer touchieren die Begrenzungssteine. Bislang haben diese Herausforderung nur Modelle mit Lidar wie der Ecovacs Goat A3000 Lidar (Testbericht) und der Dreame A2 (Testbericht) sowie der aktuell im Test befindliche Mammotion Luba Mini AWD Lidar gemeistert.

Im Test mäht der Genie 3000 recht flott und benötigt für 339 m² etwa 3,5 Stunden – und das dank des großen Akkus an einem Stück. 80 m² schafft er in 45 Minuten. Klar ist aber auch, dass Mähroboter mit einer größeren Schnittbreite wie der Ecovacs Goat A3000 oder der Mammotion Luba 2 AWD mit 32 cm und 40 cm deutlich flotter zu Werke gehen als der Genie 3000, der nur eine Schnittbreite von 20 cm bietet. Der Ecovacs Goat A3000 schafft etwa eine Fläche von 258 m² in 73 Minuten.

Die Hinderniserkennung funktioniert im Test gut: Menschen, Hunde und Katzen erkennt der Genie 3000 einwandfrei und umfährt sie. Bei kleineren Objekten wie Tennisbällen hat er aber Probleme – hier liegt die Erkennungsquote bei etwa 50 Prozent.

Im Test zeigt der Genie 3000 respektive seine RTK-Station aber Mängel. Trennt man die Ladestation vom Strom und schließt sie wieder an, meldet die App, dass die RTK-Antenne bewegt wurde. Dann ist eine Neukartierung fällig. Wer also die RTK-Station samt Mäher während der Wintermonate einlagert und sie im Frühjahr wieder in Betrieb nimmt, darf – Stand heute – eine Neukartierung vornehmen. Es bleibt zu hoffen, dass dieses Problem durch ein Firmware-Update behoben wird.

Nicht immer hat der Genie 3000 die Grenzen unseres Gartens korrekt interpretiert und ist etwa über Randsteine gefahren. Das Problem betrifft aber nahezu alle Mähroboter. In diesem Fall muss man die Kartierung anpassen oder No-Go-Zonen anlegen. Zudem hat er Schwierigkeiten bei Rasenflächen, die mit Fliesen durchsetzt sind. Hier hat der Genie 3000 häufig die Richtung gewechselt. Irgendwann hat er aber auch diesen Bereich gemeistert.

Preis: Was kostet der Anthbot Genie 3000?

Mit einem empfohlenen Verkaufspreis von 1699 Euro zählt der Anthbot Genei 3000 zu einem der günstigsten Mähroboter ohne Begrenzungskabel, die für große Flächen ab 3000 m² vorgesehen sind. Erst recht, wenn man ihn, wie aktuell, für 1459 Euro kaufen kann. Unter 2000 Euro listet der Preisvergleich nur noch den Segway Navimow H-Serie (Testbericht) für 1889 Euro und den Dreame A2 (Testbericht) für 1949 Euro.

Für kleinere Gärten hat Anthbot die Modelle Genie 600 und Genie 1000 im Programm. Sie eignen sich für Rasengrößen von 900 m² und 2000 m² und basieren auf dem Genie 3000, sind aber mit leistungsschwächeren Akkus ausgestattet und können nur 20 Zonen verwalten, während der Genie 3000 bis zu 30 Zonen unterstützt. Bei der Einstiegsvariante muss man zudem auf 4G verzichten. Den Anthbot Genie 600 gibt es aktuell für knapp 700 Euro auf Ebay, während der Genie 1000 1200 Euro kostet.

Fazit

Der noch relativ unbekannte Hersteller Anthbot bietet mit dem Genie 3000 einen überzeugenden Mähroboter ohne Begrenzungskabel mit langer Akkulaufzeit. Mit einem Preis von nur 1459 Euro ist der Genie 3000 aktuell der günstige Mähroboter, der für Gärten mit 3000 m² und größer ausgelegt ist. Die App bietet eine ausgezeichnete Zonenverwaltung mit unterschiedlichen Einstellungsmöglichkeiten je nach Gartenbereich für ein optimales Mähergebnis. Auch die individuelle Konfiguration des Randschnitts ist positiv hervorzuheben.

Wie alle Mähroboter mit Satellitennavigation passiert aber auch der Genie 3000 nicht unsere Engstelle im Garten, sodass wir ihn in die daran anschließende Zone tragen müssen, damit er seine Arbeit dort fortsetzen kann. In diesem speziellen Fall zeigen Mähroboter mit Lidar-Navigation wie Ecovacs Goat A3000 Lidar (Testbericht) und Dreame A2 (Testbericht) klare Vorteile. Auch die teilweise erratische Navigation auf Flächen, bei denen der Rasen mit Steinplatten durchsetzt ist, ist zu bemängeln. Und die App könnte mehr technische Daten liefern, etwa wie stark der aktuelle Satellitenempfang pro Zone ist, und eine Quadratmeterangabe für die Rasenfläche in der Karte, so wie sie in der Mähaufzeichnung angegeben ist, wäre ebenfalls wünschenswert.

-

Datenschutz & Sicherheitvor 2 Monaten

Datenschutz & Sicherheitvor 2 MonatenGeschichten aus dem DSC-Beirat: Einreisebeschränkungen und Zugriffsschranken

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenMetal Gear Solid Δ: Snake Eater: Ein Multiplayer-Modus für Fans von Versteckenspielen

-

Online Marketing & SEOvor 2 Monaten

Online Marketing & SEOvor 2 MonatenTikTok trackt CO₂ von Ads – und Mitarbeitende intern mit Ratings

-

Digital Business & Startupsvor 1 Monat

Digital Business & Startupsvor 1 Monat10.000 Euro Tickets? Kann man machen – aber nur mit diesem Trick

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenPhilip Bürli › PAGE online

-

Digital Business & Startupsvor 2 Monaten

Digital Business & Startupsvor 2 Monaten80 % günstiger dank KI – Startup vereinfacht Klinikstudien: Pitchdeck hier

-

Social Mediavor 2 Monaten

Social Mediavor 2 MonatenAktuelle Trends, Studien und Statistiken

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenPatentstreit: Western Digital muss 1 US-Dollar Schadenersatz zahlen