Künstliche Intelligenz

Greifbare Pixel durch Laser und Luftkammern

Bildschirme mit Flüssigkristallen, Quantenpunkten oder organischen LEDs dominieren unseren Alltag. Doch sie teilen eine Einschränkung: Sie übermitteln Daten ausschließlich optisch. Die sonst für den Alltag wichtige haptische Wahrnehmung fehlt. Touchscreens erlauben zwar Fingersteuerung und Smartphones liefern Vibrationsrückmeldungen, der angezeigte Inhalt bleibt jedoch zweidimensional und flach. Er lässt sich nicht durch Berührung erfahren beziehungsweise ertasten.

Weiterlesen nach der Anzeige

Wie Science Robotics berichtet, haben Max Linnander und sein Team von der University of California in Santa Barbara ein Display entwickelt, das Inhalte gleichzeitig sichtbar und greifbar darstellt. Aktive Bildpunkte sorgen dabei nicht nur für die gewohnte zweidimensionale Darstellung, sondern heben entsprechend markierte Bereiche als kleine „Buckel“ hervor. Dazu integrieren sie winzige, mit Luft gefüllte Hohlräume unter der flexiblen Oberfläche. Laserlicht bestrahlt diese Elemente, erhitzt das Gas darin und lässt die Schicht sich spürbar nach oben wölben. Der Vorteil: Diese haptischen Punkte sind nicht nur für statische Bilder geeignet, sondern wechseln fast so rasch wie herkömmliche Bildschirmelemente das Erscheinungsbild. Die ersten Prototypen erreichen Reaktionszeiten von 2 bis 100 Millisekunden bei maximal 1511 adressierbaren Pixeln.

Greifbare Bildinhalte

Linnander und sein Team prüften in Versuchen mit Teilnehmern, wie zuverlässig dieses haptische System im Einsatz funktioniert. Die Probanden sollten allein durch Fingerberührung Formen und Dynamiken wie die Bewegungsrichtung oder Rotation eines Objekts erkennen. Ergebnis: Die Nutzer identifizieren die Inhalte in 93 bis 100 Prozent der Durchgänge korrekt. Der im Test verwendete Prototyp des Displays verfügte über 1.511 Elemente auf 15 x 15 Zentimetern. „Das ist bereits ein Vielfaches der bisher verfügbaren taktilen Displays mit ähnlichen Merkmalen“, sagt Linnander.

<ir_inline itemname=inread type=0>

Verfügbare haptische Displays

Bis diese Technik die Serienreife erreicht und nicht nur als Prototyp in Forschungseinrichtungen und Entwicklungslabors zur Verfügung steht, müssen sich Maker und DIY-Enthusiasten mit weniger leistungsfähigen Lösungen auf anderer technischer Basis begnügen. Für Maker und DIY-Enthusiasten bieten sich Aktuatoren wie ERM- und LRA-Vibrationsmotoren (beispielsweise von TITAN Haptics oder Precision Microdrives) an. Zusätzlich sind piezoelektrische Elemente für Surface-Haptics (wie von KEMET oder Novasentis) und weiche EAP-Aktuatoren für flexible Interfaces verfügbar. Open-Source-Projekte wie der SmartKnob View auf ESP32-Basis mit programmierbarem Feedback sind ebenfalls brauchbare Lösungen für den DIY-Bereich.

<ir_inline itemname=inline_branding type=0>

(usz)

Künstliche Intelligenz

Nach Netflix-Deal: Paramount bietet 108 Milliarden US-Dollar für Warner Bros.

Der Poker um die Übernahme von Warner Bros. gewinnt an Dramatik: Nachdem sich Warner und Netflix auf einen Übernahme-Deal in Höhe von 83 Milliarden US-Dollar geeinigt haben, mischt sich nun Netflix-Konkurrent Paramount ein: Das Medienunternehmen bietet 108 Milliarden US-Dollar in Cash, um Warner Bros. zu kaufen.

Weiterlesen nach der Anzeige

Das Angebot macht Paramount den Aktionären, die 30 US-Dollar pro Aktie bekommen sollen. Rein finanziell ist das ein stärkeres Angebot als das von Netflix: Der Deal, den Netflix mit Warner ausgehandelt hat, sieht für Aktionäre eine Mischung aus Cash und Netflix-Aktien vor, die gemeinsam einen Wert von 27,75 US-Dollar pro Aktie haben sollen.

„Höherer Wert und sicherer Abschluss“

Das Netflix-Angebot sei für Aktionäre schlechter, argumentiert Paramount in einer Mitteilung. Die Mischung aus Bargeldwerten und Netflix-Aktien sei volatil, zudem sei der Ausgang der Kartellprüfungen unklar und der erfolgreiche Abschluss der Übernahme nicht garantiert: Dass Netflix und Warner weltweit auf 43 Prozent Marktanteil beim Streaming-Geschäft kämen, könnte laut Paramount für viele Kartellbehörden inakzeptabel sein. Zudem habe Netflix nie eine große Akquisition abgeschlossen. Eine Übernahme von Warner durch Paramount würde dagegen den Wettbewerb stärken, argumentiert das Medienunternehmen.

„Unser öffentliches Angebot, das zu denselben Bedingungen erfolgt wie das, das wir dem Vorstand von Warner Bros. Discovery privat vorgelegt haben, bietet einen höheren Wert sowie einen sichereren und schnelleren Weg zum Abschluss“, sagte Paramount-Chef David Ellison. Dass Paramount am Warner-Kauf interessiert ist, wurde schon vor Monaten bekannt. Insgesamt habe man Warner Bros. Discovery sechs Angebote vorgelegt, berichtet Paramount in der Mitteilung. Warner habe sich damit aber nie ernsthaft auseinandergesetzt. Paramount wendet sich daher nun direkt an die Aktionäre und hofft auf deren Unterstützung, um Warner Bros. umzustimmen.

Paramount will auch Nachrichtensender

Während sich das Netflix-Angebot nur auf die Film-Studios und das Streaming-Geschäft von Warner Bros. konzentriert, will Paramount mit seiner Offerte die komplette Firma kaufen. Das bedeutet, dass Paramount auch die Warner-Nachrichtensender kaufen will, darunter CNN und TNT.

Weiterlesen nach der Anzeige

Paramount selbst kommt gerade erst aus einer Fusion mit Skydance, die im Sommer für 8 Milliarden US-Dollar abgeschlossen wurde. Paramount-CEO David Ellison ist der Sohn von Oracle-Gründer Larry Ellison und pflegt gute Beziehungen zum US-Präsidenten Donald Trump.

Das aktuelle Angebot von Paramount hat Gültigkeit bis zum 8. Januar 2026, kann aber verlängert werden. Zuvor hatten Warner Bros. und Netflix angekündigt, die Übernahme bis zum dritten Quartal 2026 vollziehen zu wollen.

(dahe)

Künstliche Intelligenz

WhatsApp: Funktion in Beta vereinfacht Schutz vor Cyberangriffen

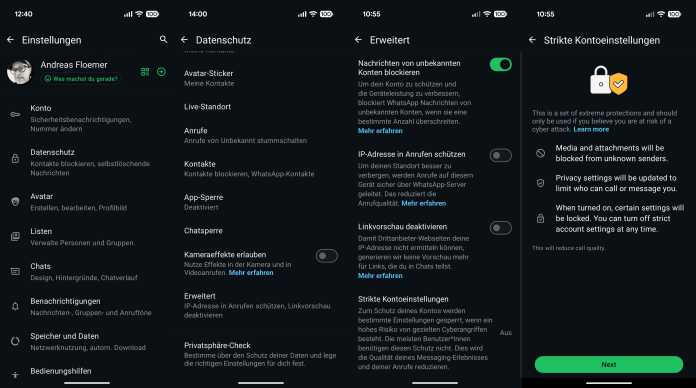

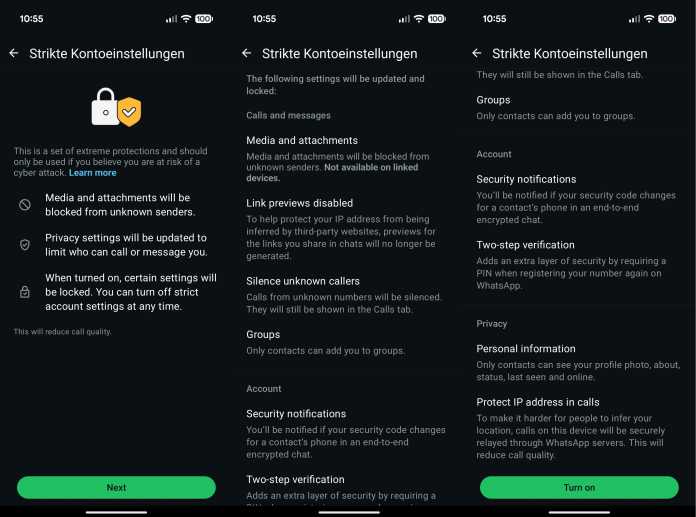

WhatsApp kann als Einfallstor für Schadsoftware dienen: In den vergangenen Monaten kursierten Berichte, denen zufolge sowohl iPhones also wohl auch Samsung-Galaxy-Geräte über den Meta-Messenger angegriffen wurden. Um Angreifern möglichst wenig Angriffsfläche zu bieten, integriert Meta in seinen Messenger eine neue Funktion, die mit einem Klick erweiterte Datenschutz- und Sicherheitsfunktionen aktiviert. Die Funktion nennt sich „strikte Kontoeinstellungen“.

Weiterlesen nach der Anzeige

Schutzschilde hoch

Wie Meta im Supportdokument zu der Funktion schreibt, wurde sie für Benutzerinnen und Benutzer entwickelt, „die Ziel solcher Angriffe sein könnten“. Nutzer sollten die Einstellungen nur aktivieren, wenn sie dazu einen Anlass sehen, betont das Unternehmen – etwa wenn man glaubt, Ziel einer „raffinierten Cyberkampagne“ zu sein. „Die meisten Personen sind von solchen Angriffen nicht betroffen,“ heißt es weiter. Nutzer, die WhatsApp mit einem möglichst weitreichenden Schutz verwenden wollen, können die Funktion dennoch nutzen, jedoch ist die Einstellung nicht prominent platziert.

Recht tief in den Einstellungen versteckt: Die neue WhatsApp-Funktion „Strikte Kontoeinstellungen“.

(Bild: Andreas Floemer / heise medien)

Derzeit steht das Feature nur registrierten Nutzern der Beta-Versionen des Messengers für Android und laut WABetaInfo für iOS zur Verfügung. Nutzer der Beta finden den Knopf zur Aktivierung der „strikten Kontoeinstellungen“ künftig unter „Einstellungen“ > „Datenschutz“ > „Erweitert“.

Nach Aktivierung der „strikten Kontoeinstellungen“ blockiert das Feature sämtliche Medien von unbekannten Absendern. Zudem deaktiviert die Funktion Linkvorschauen und schaltet Anrufe von unbekannten Nummern stumm. Die werden jedoch in der Anrufübersicht angezeigt. Ferner schränkt die Funktion Gruppeneinladungen ein und erzwingt eine zweistufige Verifizierung. Überdies begrenzen die „strikten Kontoeinstellungen“ die Sichtbarkeit von Profilen. Sie leiten außerdem zum Verschleiern der eigenen IP-Adresse Anrufe über WhatsApp-Server weiter.

WhatsApp „Strikte Kontoeinstellungen“: In der Beta sind die Einstellungen noch nicht lokalisiert.

(Bild: Andreas Floemer / heise medien)

Auch der „Zuletzt online“-Zeitstempel und der „Online“-Status, das Profilbild und die Nutzerinfo sind laut Meta nur für die eigenen Kontakte oder eine zuvor festgelegte, eingeschränktere Liste von Personen sichtbar. Zudem rät Meta Nutzern mit aktivierten Backups, die Ende-zu-Ende-verschlüsselte Backup-Funktion zu verwenden.

Weiterlesen nach der Anzeige

Laut WhatsApp können Nutzer die strikten Kontoeinstellungen nur über das Hauptgerät ein- und ausschalten. Weiter heißt es, dass Nutzer alle gegen Änderungen gesperrte Einstellungen unter dem Punkt „Einstellungen“ > „Datenschutz“ > „Erweitert“ > „Strikte Kontoeinstellungen“ > „Gesperrte Einstellungen“ ansehen können.

Wann WhatsApp die Funktion aus der Beta-Version hievt und für alle Nutzerinnen und Nutzer bereitstellt, ist derzeit unklar.

(afl)

Künstliche Intelligenz

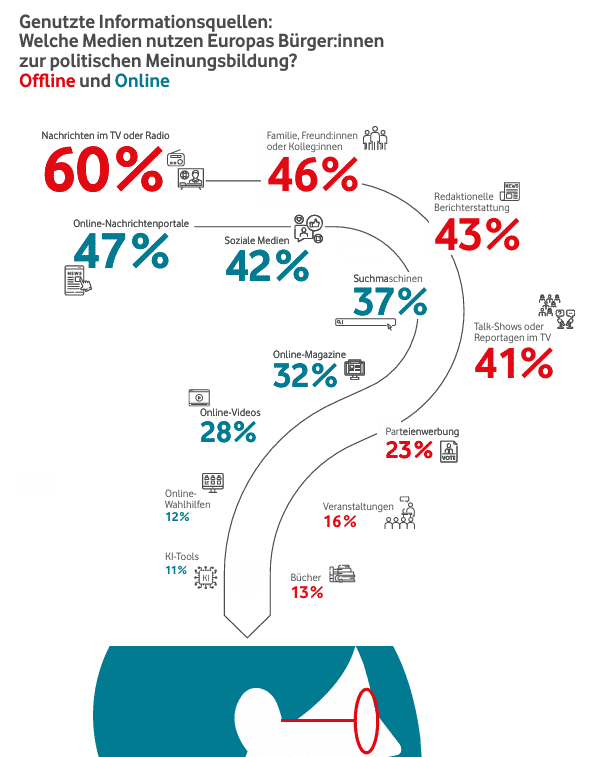

Europäer: Klassische Medien, KI-Detektoren und Staat müssen KI-Inhalte prüfen

Der Schutz der Demokratien in Europa vor KI-Falschnachrichten und Manipulationsversuchen kann aus Sicht der Europäer durch einen Dreiklang von prüfenden Institutionen gewährleistet werden: klassische Medien, KI-Detektoren und staatliche Regulierung. Die eigene Medienkompetenz wird als weniger wirksam eingestuft. Das geht aus einer aktuellen Studie des Vodafone Instituts hervor, der Denkfabrik des Telekommunikationsdienstleisters. KI wird demnach als große Gefahr für die Manipulation von Wahlen und auch das Untergraben des Vertrauens in politische Institutionen durch generierte Falschnachrichten beziehungsweise Desinformation gesehen.

Weiterlesen nach der Anzeige

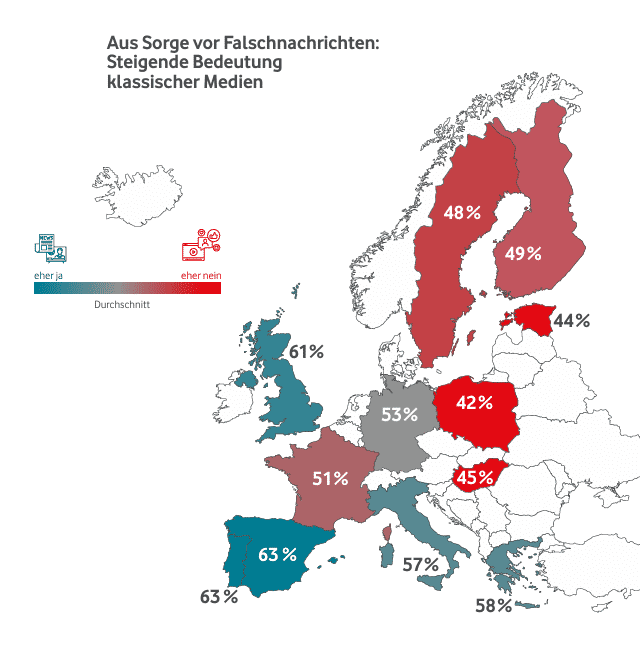

Bedeutung klassischer Medien hat zugenommen

Für die Studie wurden 12.086 wahlberechtigte Personen ab 18 Jahren in zwölf europäischen Ländern über computergestützte Online-Interviews im Frühjahr 2025 befragt, darunter auch 1002 Personen aus Deutschland. Der Befragung zufolge hat für mehr als die Hälfte der Europäer – unabhängig vom Alter – die Bedeutung redaktioneller Berichterstattung aufgrund der steigenden Gefahr von Falschnachrichten zugenommen. So stimmten insgesamt 53 Prozent der Befragten der Aussage zu, dass die Bedeutung redaktioneller Beiträge aufgrund der aktuellen Lage gestiegen sei. Unter den 25- bis 34-Jährigen sind es 57 Prozent, bei den 18- bis 24-Jährigen und 35- bis 44-Jährigen mit 54 Prozent etwas mehr.

Jüngere informieren sich eher online, ältere eher in klassischen Medien, durch aktuelle Entwicklungen gewinnen redaktionelle Berichterstattungen an Gewicht, um Falschnachrichten zu vermeiden oder besser zu erkennen.

(Bild: Vodafone Institut)

Ältere Menschen konsumieren ohnehin eher klassische Medien, belegt die Studie: Im europäischen Durchschnitt und über alle Altersklassen hinweg greifen rund 60 Prozent der Befragten für politische Informationen auf klassische Medien wie Nachrichten im Fernsehen und Radio zurück. Die Nutzung von Fernsehen und Radio nimmt mit höherem Alter zu. Der Anteil in der Altersgruppe der 18- bis 24-Jährigen liegt bei gut 40 Prozent. Neben Nachrichten im Fernsehen und Radio spielen weitere Quellen eine wichtige Rolle: der persönliche Austausch innerhalb der Familie, im Freundeskreis oder am Arbeitsplatz (46 Prozent), redaktionelle Berichterstattung (43 Prozent) sowie politische Talkshows und Reportagen im Fernsehen (41 Prozent)

60 Prozent der 18- bis 24-Jährigen nutzen für politische Informationen soziale Medien. Instagram (61 Prozent), YouTube (57 Prozent) und TikTok (56 Prozent) sind hierbei die maßgeblichen Plattformen, die zumindest schon einmal zu diesem Zweck genutzt wurden. Mit Blick auf alle Befragten über alle Altersklassen hinweg zeigt sich ein zweigeteiltes Bild für den Nachrichtenbezug online: 47 Prozent informieren sich über Nachrichtenportale, 42 Prozent über soziale Medien.

Jüngere nehmen mehr Fake News wahr

Weiterlesen nach der Anzeige

Wie häufig Menschen in Kontakt mit Falschnachrichten kommen, ist unter den Generationen ebenfalls unterschiedlich. Demnach gaben unter den 18- bis 24-Jährigen 38 Prozent an, in den vergangenen Monaten sehr oder extrem häufig Fake News wahrgenommen zu haben, während der Wert bei den über 64-Jährigen bei 16 Prozent liegt. Die Studie mutmaßt, dass dies unter anderem daran liegen könnte, dass junge Menschen mehr Zeit online verbringen und dadurch öfter Kontakt zu Desinformation haben. Ob sie vielleicht auch besser darin sind, Fake News zu erkennen, hat die Studie nicht untersucht. Sie kommentiert aber an anderer Stelle: „Während die meisten überzeugt sind, sich nicht von Falschnachrichten beeinflussen zu lassen, werden die Manipulationsgefahren bei anderen Personen als viel stärker eingeschätzt: 39 Prozent gegenüber 18 Prozent. Dies ist ein bekanntes Phänomen und daher wenig überraschend, dass es in allen Ländern vorzufinden ist. Es ist aber durchaus relevant, da es zu sozialer Spaltung beitragen kann. Wenn einzelne Gruppen glauben, dass „die Anderen“ durch Medien manipuliert werden, kann dies das Misstrauen in der Gesellschaft verstärken.“

In Südeuropa hat die Bedeutung von klassischen Medien aufgrund der Sorge vor Falschnachrichten zugenommen, in Nordeuropa eher weniger.

(Bild: Vodafone Institut)

Dass Falschnachrichten eine sehr große oder extreme Gefahr für die Demokratie darstellen, gaben 28 Prozent aller Befragten an. Am stärksten davon überzeugt sind Menschen aus Spanien mit 38 Prozent Zustimmung, und am wenigsten Menschen aus Finnland mit 15 Prozent. Je jünger die Befragten, desto stärker bewerten diese den Einfluss von Falschinformationen auf die Demokratie (35 Prozent bei den 25- bis 34-Jährigen vs. 21 Prozent bei den über 64-Jährigen). Wie häufig Fake News wahrgenommen werden, unterscheidet sich auch deutlich zwischen den Ländern: So wurden in Estland und Griechenland (39 und 35 Prozent) wesentlich mehr Fake News von Befragten wahrgenommen als etwa in Finnland und Schweden (20 und 19 Prozent).

KI als Brandbeschleuniger für Fake News

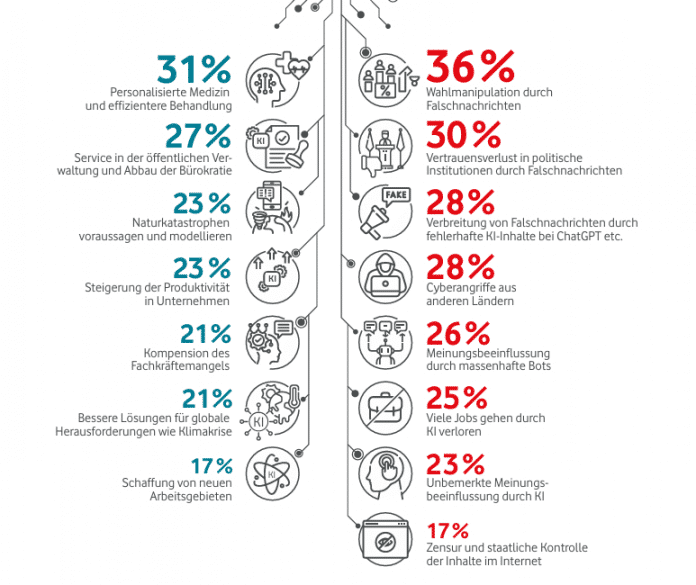

Da KI auch zur Erstellung von Fake News und täuschend echter Videos und Fotos im politischen Kontext genutzt werden kann, wurden Teilnehmende auch hierzu befragt: Die größten Risiken von KI für die Demokratie werden in Wahlmanipulationsmöglichkeiten im Vorfeld von Wahlen (36 Prozent) und dem Untergraben des Vertrauens in politische Institutionen durch KI-generierte Falschnachrichten (30 Prozent) gesehen. Auch überwiegt bei den befragten Europäerinnen und Europäern derzeit die Skepsis bei der Wahrnehmung von KI. Nur etwa 30 Prozent glauben, dass die Vorteile von KI insgesamt die Nachteile überwiegen. Besonders kritisch gegenüber KI-Inhalten zeigen sich Befragte aus Deutschland und dem Vereinigten Königreich, während es in Südeuropa mehr Zutrauen gibt.

Gute Seiten – schlechte Seiten: KI wird eher skeptisch betrachtet, wo Vor- oder Nachteile liegen (könnten), wurde genauer abgefragt.

(Bild: Vodafone Institut)

Ein Dreiklang aus Maßnahmen hat den Befragten zufolge das größte Zukunftspotential, dem zu begegnen: KI-Detektoren, klassische Medien und staatliche Regulierungen. 45 Prozent sehen vor allem eine Überprüfung durch klassische Medien als relevant an, was besonders von Älteren genannt wurde. Als weniger zukunftsrelevant werden Erkennungsalgorithmen in sozialen Medien (35 Prozent), medienkompetente Nutzer (31 Prozent) und die Förderung des Austauschs von Best Practices durch internationale Organisationen (23 Prozent) gesehen.

Die Befragten sprechen sich dementsprechend für Maßnahmen wie das Kennzeichnen von KI-generierten Inhalten (65 Prozent), Faktenchecks (59 Prozent) sowie den Einsatz nationaler Aufsichtsbehörden (58 Prozent) aus. Teilnehmende aus Portugal befürworten in diesem Zusammenhang die verschiedenen Aspekte des DSA und des AI Act mit 70 Prozent am stärksten, während das Menschen aus Polen mit 50 Prozent am wenigsten tun. Zudem steigt die Zustimmung zu regulatorischen Maßnahmen mit dem Alter und der formalen Bildung. So werden beispielsweise Faktenchecks und die Unterbindung von Hassrede von knapp der Hälfte der formal niedrig Gebildeten (47 Prozent) befürwortet, bei den formal höher Gebildeten sind es zwei Drittel (65 Prozent).

Des Weiteren betrachten 43 Prozent aller Befragten Tools zur Erkennung von künstlich erstellten oder veränderten Videos, Bildern oder Audiodateien (KI-Detektoren) als zukunftsträchtige Lösungen. Bisher nutzen nur 14 Prozent der Befragten solche Detektoren, das Interesse sei aber bei jungen und formal höher gebildeten Menschen größer. Die Nutzungsbereitschaft variiert zwar zwischen den Ländern, aber fast ein Drittel der Europäer kann sich deren Einsatz zur Verifizierung politischer Inhalte gut vorstellen. Insgesamt zeigt die Studie: Ältere Befragte setzen mehr auf staatliche Regulierungen und Überprüfung mit klassischen Medien (49 Prozent bzw. 56 Prozent der über 64-Jährigen), Jüngere halten KI-Detektoren für geeigneter (50 Prozent der 18- bis 24-Jährigen).

KI mehr ein Thema für Jüngere

Der Studie zufolge sind Jüngere aber ohnehin diejenigen, die sich mehr mit KI-Tools auseinandersetzen und diese auch schon für politische Themen genutzt haben. Je jünger die Befragten sind, desto größer ist die Bereitschaft für die (zumindest einmalige) Nutzung. Bei den 18- bis 24-Jährigen sind es 79 Prozent, bei den über 64-Jährigen nur 24 Prozent.

Mit Abstand Spitzenreiter bei den KI-Tools ist ChatGPT, das bereits von einem Drittel im politischen Kontext mindestens einmal genutzt wurde, gefolgt von Google Gemini, Meta AI, Copilot und DeepSeek. Überbewertet werden dürfen diese Daten allerdings nicht, denn wie die Studie auch klarmacht, liegt die Nutzung von KI-Tools für die politische Meinungsbildung im Vergleich zu klassischen Medien oder Nachrichtenportalen und Social Media weit zurück: Insgesamt nur 11 Prozent der Befragten nutzen regelmäßig ChatGPT oder anderen KI-Tools, wenn es um die Beschaffung von politischen Informationen geht.

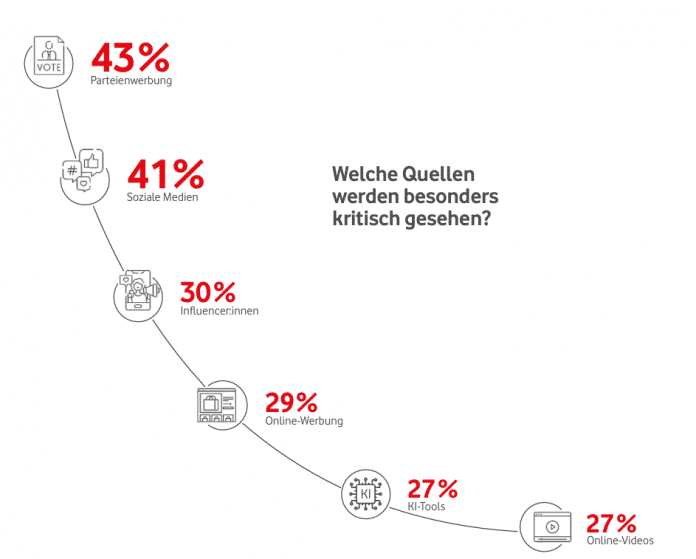

Parteienwerbung hat einen noch schlechteren Ruf als soziale Medien oder KI-Tools.

(Bild: Vodafone Institut)

Und auch wenn jüngere Befragte von 18 bis 24 Jahren zu 48 Prozent die Meinung vertreten, dass KI mehr Vor- als Nachteile bringt, hinterfragen diese Altersgruppen KI-generierte Inhalte mit 43 Prozent sogar leicht überdurchschnittlich. Über alle Altersgruppen hinweg sind 40 Prozent der Befragten KI-Inhalten gegenüber misstrauisch, ähnlich wie auch gegenüber Social-Media-Inhalten mit 41 Prozent. Mit 43 Prozent schneidet nur noch die Werbung von Parteien unter den Befragten schlechter ab.

(kbe)

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenIllustrierte Reise nach New York City › PAGE online

-

Datenschutz & Sicherheitvor 3 Monaten

Datenschutz & Sicherheitvor 3 MonatenJetzt patchen! Erneut Attacken auf SonicWall-Firewalls beobachtet

-

Künstliche Intelligenzvor 2 Monaten

Künstliche Intelligenzvor 2 MonatenAus Softwarefehlern lernen – Teil 3: Eine Marssonde gerät außer Kontrolle

-

Künstliche Intelligenzvor 2 Monaten

Top 10: Die beste kabellose Überwachungskamera im Test

-

UX/UI & Webdesignvor 3 Monaten

UX/UI & Webdesignvor 3 MonatenFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenSK Rapid Wien erneuert visuelle Identität

-

Entwicklung & Codevor 3 Wochen

Entwicklung & Codevor 3 WochenKommandozeile adé: Praktische, grafische Git-Verwaltung für den Mac

-

Social Mediavor 3 Monaten

Social Mediavor 3 MonatenSchluss mit FOMO im Social Media Marketing – Welche Trends und Features sind für Social Media Manager*innen wirklich relevant?