Online Marketing & SEO

Instagram generiert Clickbait-Titel für Posts

Auf Instagram werden irreführende Titel für Posts in der Suche erstellt, ohne dass die User davon wissen. Teilweise sind die Hinweise auf den Inhalt schlichtweg falsch.

Quo vadis, Instagram? Das denken sich gerade viele Creator. Denn die Meta-Plattform setzt für einige ihrer Posts in der Suche eigenmächtig Titel ein – die dann auch auf Google erscheinen können. Das Problem: Diese sind teilweise unpassend oder gar falsch und wirken daher eher wie unzuverlässiger Clickbait Content.

Verkürzt, langweilig oder falsch:

Google ersetzt Titel in der Suche mit AI Clickbait

Fragwürdiger SEO Hack? Instagram und die selbst generierten Post-Titel

Über die Generierung der Titel für User Posts berichten unter anderem 404 Media und Engadget. Die Publisher verweisen auf verschiedene Beispiele, in denen Instagram zu Posts von Creatorn eigenständig Titel generiert hat, die in der Instagram-Suche und sogar in den Google SERPs aufgetaucht sind. Dabei sind diese Titel aber keine akkurate Darstellung der Inhalte, die die Creator selbst geteilt haben. Das untermauert ein Post des Autors Jeff VanderMeer auf Bluesky.

Das zugrundeliegende Video teilte VanderMeer ohne Titel oder Caption. Instagram dürfte mitfhilfe von KI einfach einen Titel erstellt haben. Der auf Google angezeigte Text ist dabei direkt von Instagram übernommen worden, wie die Suchmaschine angibt. In den SERPs können indes ebenfalls KI-generierte Clickbait-Titel auftauchen, die Google für indexierte Inhalte erstellt. Auch Beschreibungstexte für Posts werden von der KI selbst erstellt. Und dabei handelt es sich nicht um eine Übernahme der direkt kreierten Alt-Texte für Visuals.

Engadget wiederum berichtet von einem Post des Mitarbeiters Sam Chapman. Dieser erhielt eine KI-generierte Beschreibung:

Floramino is a cozy puzzle game where you arrange gardens as a traveling florist. The demo looks fun, with charming visuals and strategic elements.

Allerdings war das im Post erwähnte Spiel eines mit dem Namen Bloomhunter, während Floramino ein Puzzle-Spiel auf Steam ist. So können durch diese KI-Generierungen nicht nur Clickbait-Titel entstehen, sondern auch falsche. Viele Creator beklagen bereits die Titel und Beschreibungen, die sie nicht selbst integriert haben.

Für Creator bietet es sich daher an, möglichst umfassend mit Titeln und Beschreibungen zu arbeiten, die auf Instagram und für Google als passende Darstellung übernommen werden können.

Keine Markierung?

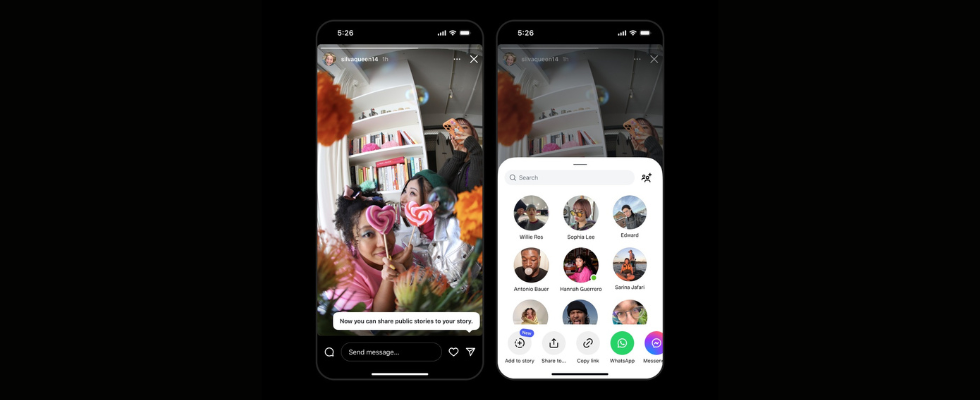

Öffentliche Instagram Stories kannst du jetzt trotzdem teilen

Online Marketing & SEO

Baumarkt: Toom startet erstmals Haltungskampagne

Protagonistin der Kampagne ist die 80-jährige Aktivistin Irmela Mensah-Schramm.

Der Baumarktbetreiber Toom hat auf Online-Kanälen ein Video veröffentlicht, mit dem sich das Unternehmen aus der Rewe Group gegen Hass und für Zivilcourage positioniert. Die Kampagne ist gleich aus mehreren Gründen bemerkenswert.

Toom startet in das neue Jahr mit einer außergewöhnlichen Kampagne. Auf Kanälen wie Youtube und Instagram hat die Baumarktkette ein 20

Jetzt Angebot wählen und weiterlesen!

HORIZONT Digital

- Vollzugriff auf HORIZONT Online mit allen Artikeln

- E-Paper der Zeitung und Magazine

- Online-Printarchiv

HORIZONT Digital-Mehrplatzlizenz für Ihr Team

Online Marketing & SEO

Ostfriesische Gelassenheit: So gechillt reagiert Langeoog auf die Mobile.de-Kampagne

Charmant und entspannt antwortet Langeoog auf die Spitzen in der jüngsten Mobile.de-Kampagne

Langeoog steht im Zentrum der neuen Mobile.de-Kampagne. Die Insel wird vom Fahrzeugmarkt liebevoll geneckt. Jetzt kontern Bürgermeister und der Tourismusverband.

Langeoog ist derzeit ziemlich angesagt. Im ZDF gab es am Sonntag im Länderspiegel eine Reportage über die ostfriesische Insel. Seit ein paar Tagen schon spielt Langeoog in einer Kampagne von Mobile.de die Hauptrolle. Der Fahrzeugmarkt zieht das Eiland darin liebevoll wegen seiner Autofreiheit auf: „Aber zum Glück lebst du nicht auf Langeoog“, heißt es unter anderem in dem Film.

Die Liebeserklärung an die Insel und ihre Bewohner verantwortet St. Elmo’s als kreativer Partner. Das Ergebnis ist beste Tourismuswerbung, die unter anderem über Youtube gestreut wird. Und das Verhältnis zu Mobile.de? Bleibt entspannt. Denn Autos gucken sie sich die Insulaner durchaus gerne an: auf Mobile.de.

Online Marketing & SEO

ChatGPT zitiert Grokipedia – und das ist ein Problem

ChatGPT nutzte Grokipedia mehrfach als Wissensbasis – ausgerechnet dort, wo Nutzer:innen besonders stark auf KI vertrauen. Der Fall zeigt, wie sich automatisiertes Wissen verselbstständigt, warum klassische Korrektive fehlen und weshalb Transparenz zur zentralen Frage für Medien, Bildung und Öffentlichkeit wird.

OpenAI betont regelmäßig, wie wichtig eine breite und ausgewogene Quellenbasis für verlässliche KI-Antworten ist. Umso genauer lohnt sich der Blick auf eine Entwicklung, die sich aktuell abzeichnet: Inhalte aus Grokipedia, Elon Musks KI-basierter Wikipedia-Alternative, tauchen offenbar zunehmend in Antworten von ChatGPT auf.

Wie The Guardian berichtet, griff ChatGPT in der Version GPT-5.2 bei mehr als einem Dutzend unterschiedlicher Anfragen insgesamt neunmal auf Grokipedia als Quelle zurück. Entscheidend ist dabei weniger die Häufigkeit als das Muster. Grokipedia wurde kaum bei Themen genutzt, die breit dokumentiert und von vielen etablierten Medien und Fachpublikationen eingeordnet sind. Stattdessen diente sie als Quelle bei weniger bekannten Sachverhalten. Genau dort also, wo Nutzer:innen besonders stark auf die Einordnung durch KI vertrauen.

Grokipedia-Start:

„Besseres“ Wikipedia mit KI und ersten Problemen

Was ist Grokipedia und warum ist es umstritten?

Grokipedia wurde von xAI entwickelt und startete im Oktober 2025. Elon Musk hatte zuvor wiederholt Wikipedia kritisiert und der Online-Enzyklopädie politische Voreingenommen vorgeworfen. Grokipedia versteht sich als Gegenentwurf zur von Menschen kuratierten Wissensplattform.

Der zentrale Unterschied: Grokipedia ist vollständig KI-generiert. Sämtliche Inhalte stammen vom Sprachmodell Grok, das auch auf Musks Plattform X eingesetzt wird. Eine offene Community, redaktionelle Kontrolle oder transparente Diskussionsprozesse wie bei Wikipedia existieren nicht.

Schon kurz nach dem Start dokumentierten Journalist:innen erhebliche Probleme. Viele Einträge wirkten nahezu wortgleich aus Wikipedia übernommen, teils inklusive formaler Strukturen. Andere Artikel enthielten sachliche Fehler, einseitige Deutungen oder politisch aufgeladene Narrative. Fragen nach Verantwortung, Korrekturen und Transparenz blieben offen.

Erschwerend wirkt die Serie an Kontroversen rund um Grok selbst. Musks KI-Chatbot fiel in den vergangenen Monaten durch antisemitische Inhalte auf, glorifizierte Adolf Hitler als „Mecha Hitler“ und wird derzeit zur Erstellung sexualisierter, nicht einvernehmlicher Deepfakes genutzt – vor allem von Frauen und sogar Minderjährigen. In mehreren Ländern folgten daraufhin Ermittlungen und zeitweise Zugriffsbeschränkungen.

Auffällig selektiv: Wann ChatGPT Grokipedia nutzt

Besonders heikel ist nicht nur, dass ChatGPT auf Grokipedia zurückgreift, sondern wie. Laut The Guardian wurde Grokipedia nicht herangezogen, wenn es um stark dokumentierte oder intensiv diskutierte Themen ging, etwa den Sturm auf das US-Kapitol oder die HIV/AIDS-Epidemie.

Stattdessen diente Grokipedia als Quelle bei weniger bekannten Sachverhalten, etwa zu einzelnen Historiker:innen oder Nischenthemen. Genau dort, wo externe Einordnung schwieriger ist und Nutzer:innen stärker auf die Autorität der KI vertrauen, wird es problematisch. Fehler oder Verzerrungen lassen sich in solchen Fällen nicht so schnell erkennen. Das Risiko liegt also nicht bei offensichtlichen Kontroversen, sondern bei Antworten, die plausibel wirken, aber auf fragiler Wissensbasis stehen.

Wenn KI KI zitiert

OpenAI reagierte gegenüber dem Guardian defensiv. Ein:e Sprecher:in erklärte, man greife auf „ein breites Spektrum öffentlich zugänglicher Quellen und Standpunkte“ zurück. Dieses Vorgehen entspricht gängigen Retrieval-Ansätzen moderner Sprachmodelle, bei denen externe Inhalte je nach Anfrage eingebunden werden.

Der Fall Grokipedia zeigt jedoch die Kehrseite dieses Prinzips. Wenn KI-Systeme auf andere KI-generierte Wissenssammlungen zurückgreifen, entsteht ein Kreislauf. KI zitiert KI-Inhalte, die wiederum von KI erzeugt wurden. Fehler, Verzerrungen oder ideologische Narrative können sich so verstärken, ohne dass ein menschliches Korrektiv eingreift.

Weltwissen unter KI-Druck

Der größere Kontext macht die Entwicklung noch relevanter. Wikipedia steht nach 25 Jahren exemplarisch für ein zentrales Problem des Internets 2026. Offenheit allein schützt Wissen nicht mehr. Inhalte werden automatisiert abgegriffen, neu zusammengesetzt und weiterverwertet, während Transparenz über Herkunft und Kontext verloren geht.

Die Wikimedia Foundation reagiert darauf, indem sie den Zugriff von KI-Systemen neu ordnet. Über Angebote wie Wikimedia Enterprise wird automatisierter Zugang erstmals gesteuert und kommerziell geregelt. Neben Google kooperiert Wikimedia inzwischen auch mit Amazon, Meta, Microsoft, Mistral AI und Perplexity.

Während Wikipedia versucht, Kontrolle über die eigene Wissensbasis zurückzugewinnen, richtet OpenAI den Blick nach vorn. CEO Sam Altman kündigte kürzlich an, an einer „neuen Generation von Tools“ zu arbeiten. Begleitend plant OpenAI ein öffentliches Town Hall für Entwickler:innen, bei dem vor dem Start erste Einblicke und Feedback gesammelt werden sollen.

25 Jahre Wikipedia:

Der Kampf ums Weltwissen im KI-Zeitalter

Nicht jede KI-Antwort ist Wissen

Bei KI geht es längst nicht mehr nur darum, was ein System antwortet, sondern woher diese Antworten stammen. Wenn KI-Dienste zunehmend auf andere KI-generierte Wissensquellen zurückgreifen, wird die Herkunft schwerer nachvollziehbar – und Vertrauen zur offenen Frage. Vor allem dann, wenn diese Quellen selbst umstritten sind.

Da KI-Antworten immer häufiger als Referenz genutzt werden – in Redaktionen, im Marketing, in Bildungskontexten und im Alltag –, wird Quellenbewusstsein zur Schlüsselkompetenz. Plausibilität reicht nicht mehr aus. Wer KI nutzt, muss lernen, Antworten einzuordnen. Und wer Wissen veröffentlicht, gewinnt an Relevanz, wenn Herkunft, Einordnung und Verantwortung klar erkennbar bleiben.

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenKommandozeile adé: Praktische, grafische Git-Verwaltung für den Mac

-

UX/UI & Webdesignvor 3 Monaten

UX/UI & Webdesignvor 3 MonatenArndt Benedikt rebranded GreatVita › PAGE online

-

Künstliche Intelligenzvor 4 Wochen

Künstliche Intelligenzvor 4 WochenSchnelles Boot statt Bus und Bahn: Was sich von London und New York lernen lässt

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenKommentar: Anthropic verschenkt MCP – mit fragwürdigen Hintertüren

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenFast 5 GB pro mm²: Sandisk und Kioxia kommen mit höchster Bitdichte zum ISSCC

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenHuawei Mate 80 Pro Max: Tandem-OLED mit 8.000 cd/m² für das Flaggschiff-Smartphone

-

Social Mediavor 1 Monat

Social Mediavor 1 MonatDie meistgehörten Gastfolgen 2025 im Feed & Fudder Podcast – Social Media, Recruiting und Karriere-Insights

-

Künstliche Intelligenzvor 3 Monaten

Künstliche Intelligenzvor 3 MonatenWeiter billig Tanken und Heizen: Koalition will CO₂-Preis für 2027 nicht erhöhen