Online Marketing & SEO

Mistral Vibe 2.0: Top Coding Agent aus Europa

Mit Mistral Vibe 2.0 kommt ein Coding Agent, der Subagents ermöglicht, deine ganze Code-Basis versteht und eine Alternative zu Codex, Opus, Gemini und Co. von den US Tech Playern bietet.

Schnelleres Coding mitten aus Europa: Mistral Vibe 2.0 verspricht agentische Code-Arbeit, die all deine Prozesskontexte aufnimmt und schneller denn je ist. Dabei kannst du personalisierte Subagents erstellen und Multi-Choice-Klarstellungen bei Unklarheiten nutzen. Mistral AI bietet mit dieser Neuheit eine weitere Alternative zu Big Tech aus den USA. Mit le Chat stellt das Unternehmen bereits eine Alternative zu ChatGPT, Gemini und Claude bereit. Mit Mistral Vibe 2.0 soll Gemini 3 Pro, GPT-5.3-Codex (Spark) und Claude Opus 4.6 Konkurrenz gemacht werden.

Anthropics Claude Opus 4.6 bringt neues Leistungsniveau für agentische KI

Was Mistral Vibe 2.0 alles kann: Zehn Mal schneller und codebase aware

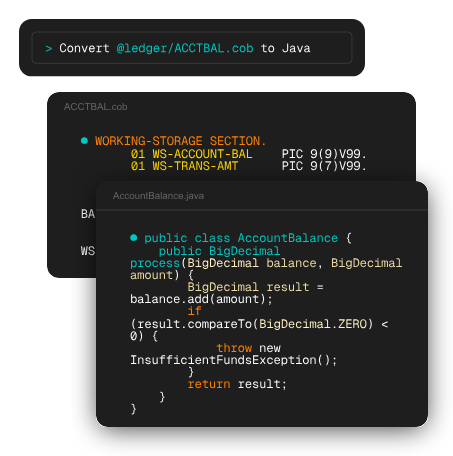

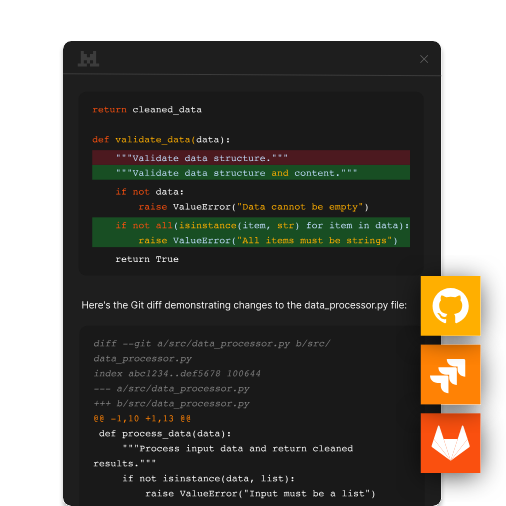

Auf X stellt Mistral den neuen Coding Agent vor. Dabei verweist das Unternehmen direkt darauf, dass User damit schneller denn je arbeiten können. Die Pull-Request-Zeit soll halbiert werden können, insgesamt arbeitet Mistral Vibe 2.0 bei der Code-Bearbeitung zehn Mal schneller. Ein weiterer Vorteil, der für User gegeben ist, bezieht sich auf die Subagents. Diese lassen sich für spezifische Aufgaben anlegen und on Demand für Tests, Skripts, Reviews und Co. einsetzen.

Custom subagents – build specialized agents for targeted tasks. Deploy scripts, PR reviews, test generation – invoke them on demand. pic.twitter.com/VsWeigHay6

— Mistral Vibe (@mistralvibe) January 27, 2026

Besonders hilfreich ist außerdem, dass der Agent die gesamte Code-Basis der Nutzer:innen nicht nur verstehen, sondern auf Wunsch auch in moderne Stacks übertragen kann.

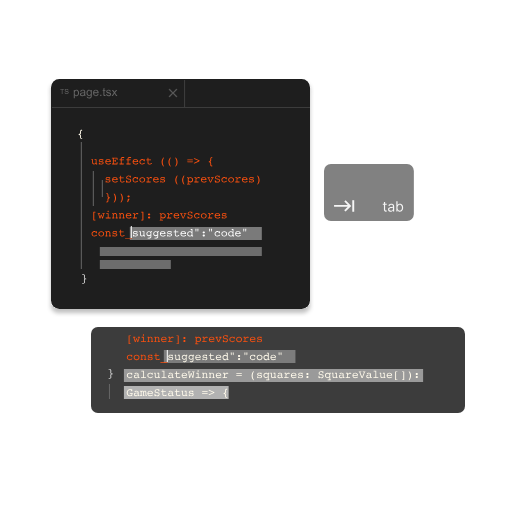

Des Weiteren bietet Mistral Vibe 2.0 sogenannte Multi-Choice-Klarstellungen, die bei etwaigen ambigen Intentionen aus Coding-Vorgaben Nachfragen und Handlungsoptionen bieten. So sollen fehlerhafte Schritte ausgeschlossen werden. Sogar intelligente Coding-Vorschläge – ähnlich wie bei einem Autocomplete Feature – liefert der Agent.

Zusätzlich gibt es die Möglichkeit, schon vorgefertigte Workflows zu integrieren und im Unified-Agent-Modus personalisierte Modi mit spezifischen Erlaubnissen, Tool-Zugriffen und Verhaltensmustern einzupflegen.

Unified agent modes – configure custom modes that combine tools, permissions, and behaviors. Switch contexts without switching tools. pic.twitter.com/VgiGYD3oLQ

— Mistral Vibe (@mistralvibe) January 27, 2026

Du kannst mit Mistral Vibe 2.0 diverse Dateien aus der Code-Basis bearbeiten und smarte Referenzen einstellen sowie personalisierte Agent Skills hinzufügen. Schließlich kannst du den Agent auch mit GitHub, GitLab, Jira und proprietären Code-Kontexten verknüpfen und auf IDE-Erweiterungen setzen.

Verfügbar ist Mistral Vibe 2.0 für Abonnent:innen von Le Chat Pro (17,99 Euro pro Monat) und Team (29,99 Euro pro Monat und pro Mitglied). Mistral schreibt über großzügige Limits; wenn diese erreicht werden, gilt das Pay-as-you-go-Prinzip. Über die Devstral 2 API gibt es ebenfalls Zugriff. Wer auf das Mistral Studio Experiment zugreifen kann, erhält die neue Vibe 2.0-Option for free testen.

OpenAI holt OpenClaw-Macher an Bord und verabschiedet sich von Kultmodell GPT-4o

Online Marketing & SEO

So detailliert kannst du jetzt Bilder mit Nano Banana Pro prompten

Google zeigt Usern, wie sie mit dem Kreations-Tool Nano Banana Pro so granular prompten, dass die Bilder täuschend echt aussehen. Aber klappt das immer?

Der Start von Googles KI-Visual-Creator Nano Banana Pro sorgte 2025 für zahlreiche Gemini App Downloads und einen regelrechten Hype. Zwischenzeitlich musste Google sogar die Limits anpassen, um dem Nutzungsinteresse technisch gerecht werden zu können. Mit Nano Banana Pro können User realitätsnahe Bilder erstellen, dabei diverse Anpassungen per Prompt eingeben, und müssen sich nur wenigen Grenzen beugen. Jetzt zeigt Google, wie granular Nutzer:innen prompten können, um Bilder hervorzurufen, die wie ein Foto daherkommen können. Das kann Creatorn und Marken helfen, birgt aber auch Gefahren.

Nano Banana Pro Hype zwingt Google jetzt zu neuen Limits

Prompt-Beispiel von Google: „Very, very specific“

Auf X zeigt der Nano Banana Pro Account von Google mithilfe eines Beispiels, mit welch genauen Angaben User beim Prompting für Visuals ein äußerst detailreiches und realistisch wirkendes Bild erstellen können. In diesem Beispiel hat das Team ein Visual von zwei Personen in einem Café erstellen lassen, die an einem Tisch sitzen, samt Hund darunter, und eine lustige Pose einnehmen. Besonders sind aber die vielen Details, von dem Schriftzug „Nano’s Café“ über das Buch samt Titel „How to Prompt AI“ auf dem Tisch bis hin zur Latte Art im Cappucino.

You can be very, very specific with your prompts. Here’s an example to show just how detailed you can be:

– a photo of a man and woman at a cafe in San Francisco, they are sat by the window

– the view behind them is like the view from Dolores park, it is sunny, in the morning,… pic.twitter.com/lmjn4YNrPa— Nano Banana Pro (@NanoBanana) February 16, 2026

Der konkrete Prompt lautet:

– a photo of a man and woman at a cafe in San Francisco, they are sat by the window

– the view behind them is like the view from Dolores park, it is sunny, in the morning, blue sky, with warm remnants of fog

– the cafe is a bit cramped and it’s a busy morning

– the man is wearing a pink polo t-shirt and white shorts, the shorts have an NBP motto

– the woman is in a green and yellow summer dress with a banana motif, she has yellow-rimmed sunglasses, her shoes are blue

– beneath their table is a curled up sleeping dog, it’s a black and white french bulldog with a blue collar

– the table is round and metallic

– on the table lies an old 80s book with the title „How to prompt AI“, a pink post-it note acts like a bookmark

– on the window of the cafe a beautiful design says „Nano’s Cafe“ in gold etched lettering in a circle (it’s mirrored),

– on the table is an iced latte and a capuccino, the capuccino has swan latte art

– there’s also a Nano’s Cafe menu on the table

– they are both pulling awkward poses for the photo

Diesen Prompt können User als Vorbild für detaillierte Bilder nehmen und entsprechend ihrer Ideen abwandeln. Allerdings führt er nicht immer zum gleichen Ergebnis, wie zum Beispiel die Userin Ava Mitchell auf X zeigt.

My photo with same prompt❤️ pic.twitter.com/0OICJdMDjW

— Ava Mitchell (@AvaMitchell310) February 17, 2026

Auch in unserem Test mit dem selben Prompt kommt ein anderes Bild heraus.

Wer noch mehr Inspiration für Prompting-Grundlagen benötigt, kann in unserem Guide nachlesen oder einfach eine KI nach passenden Vorgaben fragen. Auch dabei gilt aber, dass die Ideen schon vorhanden sein sollten. Denn je detaillierter der Prompt, desto besser das Ergebnis bei Visuals, Videos und Co.

Noch mehr Prompt-Inspiration findest du in unserer Übersicht nützlicher Prompts für ChatGPT, die sich auch auf andere Tools und Modelle übertragen lassen.

15 ChatGPT Prompts, um 15 Stunden pro Woche zu sparen

Noch mehr Fähigkeiten von Nano Banana Pro

Googles Nano Banana Pro bietet Usern viele Möglichkeiten zur Bildbearbeitung – und das inzwischen sogar im Chrome Browser, in der Suche, bei NotebookLM und Co. So können User beispielsweise im Create Mode auch Ideen für Outfits oder Interior-Design im AI Mode diskutieren.

Des Weiteren ist 4K Upscaling und eine präzise Fotorestauration möglich, die selbst winzige oder beschädigte Bilder in klare, farbtreue Aufnahmen verwandelt. Besonders fallen bei Nano Banana Pro drei Vorteile für Nutzer:innen auf:

- Lichtverständnis: Das Modell reagiert auf Lichtstimmungen außergewöhnlich präzise. Szenen wechseln innerhalb eines Prompts von neutralem Tageslicht zu einer abendlichen, kühlen Atmosphäre, ohne die harten Übergänge oder Artefakte, die das Basismodell prägen.

- Perspektive und Komposition: Ob Weitwinkel, Totale oder Close-up: Nano Banana Pro setzt Perspektiven konsistent um. Die Ergebnisse wirken weniger berechnet und mehr wie bewusst angelegte Kompositionen, ähnlich einer filmischen Inszenierung.

- Typografie und Struktur: Texte, Diagramme oder UI Frames erscheinen erstmals in einer Qualität, die nicht mehr aufwändig nachbearbeitet werden muss. Poster, Interfaces oder Layouts erinnern in ihrer Klarheit eher an professionelle Designentwürfe als an typische KI-Kompositionen.

Nano Banana und automatisches Browsing in Chrome:

Gemini Update erinnert an Atlas

Online Marketing & SEO

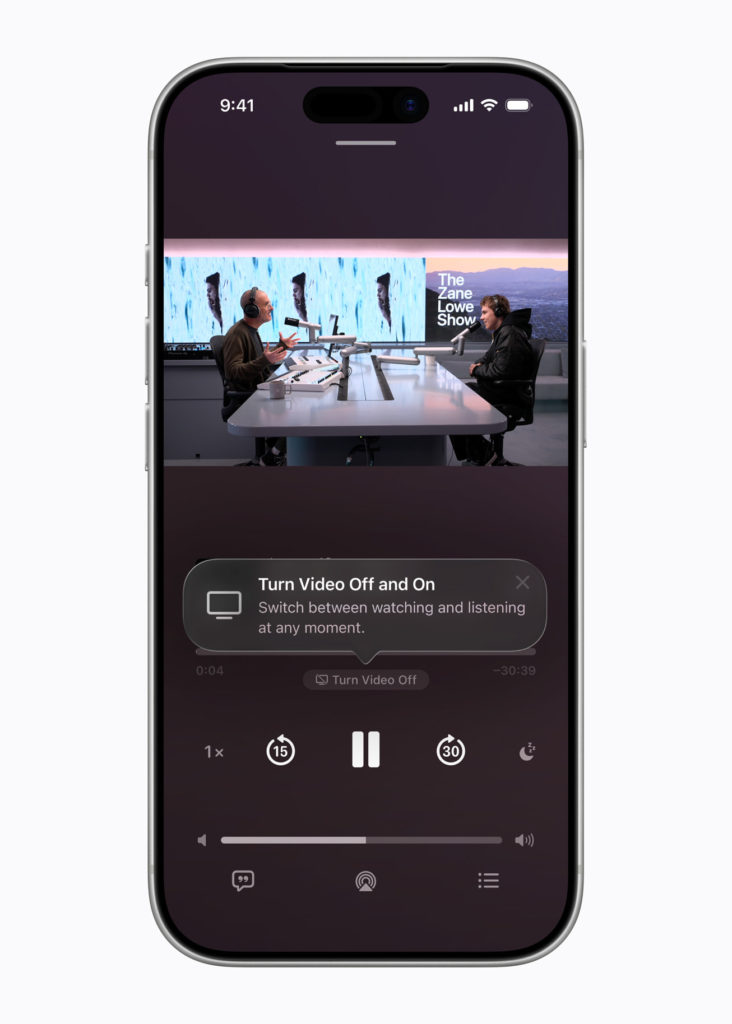

Apple launcht Video-Podcasts und könnte Bugdet-iPhone bringen

Denn mit iOS 26.4 integriert der iPhone-Konzern Video erstmals in Apple Podcasts und bringt sich im Wettbewerb um Video-Podcasts in Stellung. Während YouTube laut eigenen Angaben auf dem offiziellen YouTube Blog inzwischen die Marke von über einer Milliarde monatlich aktiven Podcast Streamern erreicht hat und allein im Oktober 2025 mehr als 700 Millionen Stunden Podcasts auf TV-Geräten angesehen wurden, baut auch Spotify sein Videosegment weiter aus. Im Spotify Newsroom spricht das Unternehmen von über 250.000 Video-Podcasts sowie mehr als 170 Millionen Nutzer:innen, die bereits Podcasts schauen. Und auch Netflix hat im April 2025 Video-Podcasts für sich entdeckt. Seit Anfang 2026 lassen sich ausgewählte Formate wie The Bill Simmons Podcast oder My Favorite Murder direkt auf der Plattform ansehen – ein weiteres Zeichen dafür, wie stark sich Podcasting aktuell in Richtung Video verschiebt.

Apple zieht jetzt nach und verankert visuelle Formate direkt in der eigenen App. Das schafft neue Voraussetzungen für Discoverability, Advertising und plattforminterne Reichweite. Parallel verdichten sich rund um Apples überraschend angekündigtes Event Anfang März die Spekulationen über neue Hardware. Gleichzeitig bringt iOS 26.4 erstmals Ende-zu-Ende-Verschlüsselung für den RCS-Standard.

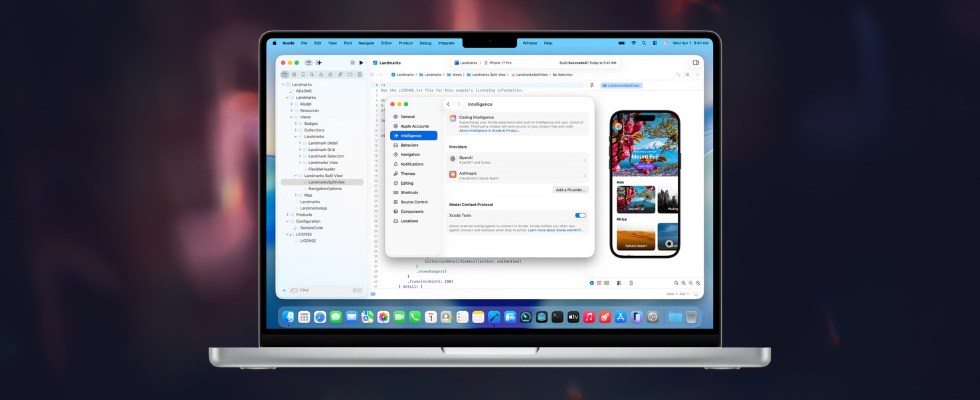

Apples Integration von Claude Agent in Xcode heizt die Spekulationen um Claude 5 weiter an

Video-Podcasts bei Apple schaffen neue Chancen für Publisher

Mit iOS 26.4 integriert Apple erstmals ein Videoerlebnis in Apple Podcasts, so wie viele es von Spotify und YouTube bereits kennen. Du kannst künftig direkt zwischen Audio und Video wechseln, Episoden im Querformat ansehen oder Inhalte herunterladen und später offline weiterschauen. Möglich macht das die HTTP-Live-Streaming-Technologie, die für flüssiges Streaming sorgt und Videoepisoden nahtlos in die bestehende Podcast App einbettet. Zum Start arbeitet Apple mit Acast, SiriusXM oder Omny Studio zusammen.

Mit der Einführung von Video-Podcasts öffnet Apple auch neue Türen für Advertising und Brand Integrations. Dynamische Videoanzeigen lassen sich künftig direkt in Episoden ausspielen, während Sponsoring-Formate stärker visuell gedacht werden können. Gleichzeitig bleiben bestehende Hosting- und Distributionswege bestehen, sodass Publisher ihre Reichweite ausbauen können, ohne ihre Infrastruktur neu aufzusetzen.

Dass Video im Podcasting immer wichtiger wird, zeigt sich branchenweit. Sharon Taylor, Chief Revenue Officer von Triton Digital, ordnet die Entwicklung so ein:

Video is becoming an increasingly important way audiences engage with audio content, and Apple’s move into this space marks a meaningful step forward. An open approach that enables publishers to retain control over their audiences, advertising, and measurement – while expanding access to content across formats – supports long-term growth and greater choice for listeners.

Die erste Beta von iOS 26.4 ist bereits für Entwickler:innen verfügbar. Eine öffentliche Beta dürfte zeitnah folgen, der finale Release wird aktuell für Ende März oder April 2026 erwartet.

iOS 26.4 verbindet Video, KI und Sicherheit stärker im Apple-Ökosystem

Doch die Video-Podcast-Offensive ist nur ein Teil des Updates. Mit iOS 26.4 dreht Apple an mehreren zentralen Stellschrauben gleichzeitig. In Apple Music tauchen in der Entwickler:innenbeta neue Apple Intelligence-Funktionen auf, darunter die Funktion Playlist Playground, die Playlists aus Texteingaben generiert. Zusätzlich testet Apple Features, die dir Konzerte in deiner Nähe anzeigen können. Über beide Funktionen berichtete unter anderem 9to5Mac.

Parallel dazu verschärft Apple das Sicherheitsniveau im Messaging-Bereich. In iOS 26.4 Beta 1 startet der Konzern erste Tests für eine Ende-zu-Ende-Verschlüsselung von RCS-Nachrichten. Aktuell funktioniert das jedoch nur zwischen Apple-Geräten zu Testzwecken und noch nicht mit Android. Grundlage ist das RCS Universal Profile 3.0, das perspektivisch auch Funktionen wie Nachrichtenbearbeitung oder Inline Replies ermöglicht. Gleichzeitig wird der Schutz gestohlener Geräte weiter ausgebaut und ist künftig standardmäßig aktiviert. Damit verankert Apple sicherheitsrelevante Features tiefer im System, während die plattformübergreifende Verschlüsselung noch in der Entwicklung bleibt.

Überraschendes Apple-Event im März sorgt für Spekulationen um iPhone 17e, Macs und iPads

Das hatte keine:r auf dem Schirm: Am 4. März lädt Apple überraschend zur Special Apple Experience, wie heise online berichtet, und bringt Journalist:innen sowie Influencer nach New York, London und Shanghai. Welche Ankündigungen geplant sind, hält der Konzern bislang unter Verschluss.

In der Branche wird derzeit über ein vergleichsweise günstiges MacBook mit A18-Chip spekuliert, das sich stärker an Studierende und Unternehmen richten könnte. Auch die frühlingshaften Gelb- und Grüntöne der Einladung gelten als möglicher Hinweis auf ein auffälligeres Design. Parallel kursieren Gerüchte über ein neues günstiges iPhone, das iPhone 17e, als Einstieg ins Apple-Ökosystem. Darüber hinaus stehen neue MacBook Air- und Pro-Modelle mit M5-Varianten, aktualisierte iPads sowie weitere Hardware Updates im Raum.

ChatGPT-Konkurrenz:

Apple macht Siri zum AI-Chatbot

Online Marketing & SEO

Meta Vibes und „Scream 7“: Werde Teil der Horror-Experience

Zum Kinostart von „Scream 7“ am 27. Februar 2026 bringen Meta und Paramount eine KI-Experience in den Vibes Feed der Meta AI App. Mit einem Selfie wirst du Teil personalisierter Horrorszenen, die sich direkt auf Instagram und Co. teilen lassen. Während TikTok Filme längst über Creator Content und virale Edits antreibt, testet Meta damit neue Wege für interaktive Filmpromotion im Feed.

Geh nicht allein ins Haus, nimm keine unbekannten Anrufe an und unterschätze niemals Ghostface: Wenn ein Horrorfilm dafür bekannt ist, Regeln zu brechen, dann Scream. Eine neue Kampagne zu Scream 7, der am 27. Februar 2026 im Kino startet, bricht mit klassischen Rezeptionsmustern und verschiebt die Interaktionsgrenze zwischen Zuschauer:innen und Film.

Meta Platforms und Paramount Pictures holen dich direkt in die Story. Im Vibes Feed der Meta AI App lädst du ein Selfie hoch und wirst Teil einer personalisierten Horrorsequenz – für maximalen Gruselspaß mit Viralpotenzial. Damit schließt sich Meta einem Trend im Film-Marketing an, den bislang vor allem TikTok mit Community-Formaten, Creator Edits und viralen Kampagnen prägt.

Vibes oder AI Slop?

Metas KI-Feed bald als App

Was Vibes ist und warum Meta damit Filmkampagnen neu aufzieht

Vibes ist Metas KI-Feed für Videos. In diesem noch jungen Bereich kannst du inzwischen auch bereits in Deutschland AI-generierte Clips ansehen, selbst erstellen und bearbeiten. Aktuell läuft der Feed vor allem in der Meta AI App, von dort lassen sich Inhalte direkt in Reels oder Stories auf Facebook und Instagram teilen. Gleichzeitig testet Meta bereits eine eigene Standalone App für Vibes. Erste Tester:innen sollen dort Videos kreieren, bearbeiten und den KI-Video-Feed verfolgen können. Meta plant, das Produkt auf Basis des Feedbacks aus der Testphase weiter auszubauen.

Mit der Scream 7 Experience nutzt Meta Vibes jetzt auch für Entertainment Marketing. Ein Selfie reicht und Meta AI setzt dich beispielsweise in nervenaufreibende Szenen aus dem neuen Sequel oder in einen Throwback zum Originalfilm von 1996. Wer die Reihe kennt, weiß, dass Scream immer mit Metaebenen spielt und genau daran knüpft die Kampagne an. Du bist nicht nur Zuschauer:in, sondern selbst Teil der Geschichte.

Im Clip „Deadly Reception“ landest du beispielsweise in einer angespannten Begegnungsszene, die sich wie der Auftakt eines klassischen Scream-Moments anfühlt.

„Chandelier“ arbeitet stärker mit dramatischen Lichtstimmungen, schnellen Perspektivwechseln und einem Tempo..

„Between the Walls“ setzt dagegen auf psychologischen Horror. Enge Räume, leise Bewegungen und Perspektiven aus dem Off sorgen dafür, dass du dich fühlst, als wärst du selbst im Haus gefangen.

Wenn du also schon immer wissen wolltest, wie du dich in einer Horrorzzene schlagen würdest, kannst du es jetzt selbst testen. Ein Selfie reicht für deinen persönlichen kleinen Scream-Auftritt.

Warum Social Plattformen Kino für sich entdecken

Film-Marketing funktioniert längst nicht mehr nur über die Leinwand. Viele Geschichten laufen im Feed auf dem Smartphone weiter und genau daran knüpft die Scream Experience an. Die Berlinale setzt vor diesem Hintergrund in diesem Jahr schon zum zweiten Mal auf TikTok als offizielle:n Entertainment-Partner:in und baut mit Hashtags wie #FilmTok oder #WhatToWatch digitale Treffpunkte für Filmfans auf.

Als erstes deutsches Produktionsunternehmen nutzte Constantin Film TikTok Spotlight zur Promotion von 15 Titeln im vergangenen Jahr – mit großem Erfolg. Rund um die Filme entstanden Millionen Videoaufrufe, Likes und Kommentare. Mehrere Produktionen landeten später unter den Top 20 der erfolgreichsten Kinotitel in Deutschland. Laut Plattformdaten waren 15 der 20 erfolgreichsten Filme 2025 hierzulande gleichzeitig virale TikTok-Hits. Zudem lassen sich 65 Prozent der Nutzer:innen dort zu einem Kinobesuch inspirieren.

Auch die Communities rund um Filme wachsen rasant. Allein 2025 wurden weltweit durchschnittlich 6,5 Millionen Beiträge pro Tag zu Film- und TV-Inhalten auf TikTok veröffentlicht. Filmkultur findet längst nicht mehr nur im Kino oder im Streaming statt. Sie lebt auch in kurzen Clips, Fanvideos und Diskussionen im Feed. Genau dort entsteht Aufmerksamkeit, die sich später an der Kinokasse bemerkbar machen kann.

Der Weg ins Kino beginnt heute mit einem Swipe

Filmpromotion verlagert sich längst in die Social Feeds vieler Fans – aktuelle Kampagnen zeigen, wie stark Social Media dabei mitgestaltet. So setzte Constantin Film für Das Kanu des Manitu auf TikTok Spotlight und traf damit einen Nerv der Community. Noch vor dem Kinostart entwickelte sich der Titel auf TikTok zum viralen Trend, mit Engagement-Spitzen rund um die Premiere und über 100 Millionen Views. Besonders auffällig: Rund 94 Prozent der Videos stammten nicht vom Studio selbst, sondern von Creatorn und Fans. Sounds, Szenen und Running Gags wurden weitergedacht, remixt und millionenfach geteilt.

Während TikTok vor allem auf Fandom, Trends und Community-Mechaniken setzt, gehen Meta Platforms und Paramount Pictures mit der Scream Experience einen Schritt weiter und machen dich selbst zur Figur innerhalb der Kampagne. Mit personalisierten KI-Erlebnissen wird der Film selbst zum Social-Format. Das passt erstaunlich gut zur Reihe. Scream spielt seit den 90ern mit Medienlogiken, bricht Horrorregeln ironisch und lebt davon, dass Zuschauer:innen Teil des Spiels werden.

Wie stark Plattformstrategien heute darüber entscheiden, wie Filme sichtbar werden, zeigt auch unser Gespräch mit Kim Teys Beavers und Sara-Leona Seibert (Berlinale). Im Gespräch mit OnlineMarketing.de erklärten sie vergangenes Jahr, wie sich das Festival auf TikTok erfolgreich positioniert und was andere Kulturinstitutionen daraus lernen können.

Wie die Berlinale TikTok für sich erobert

– und was Kulturmarken daraus lernen können:

Interview mit Kim Teys Beavers und Sara-Leona Seibert

-

Entwicklung & Codevor 3 Monaten

Entwicklung & Codevor 3 MonatenKommandozeile adé: Praktische, grafische Git-Verwaltung für den Mac

-

Künstliche Intelligenzvor 2 Monaten

Künstliche Intelligenzvor 2 MonatenSchnelles Boot statt Bus und Bahn: Was sich von London und New York lernen lässt

-

Social Mediavor 6 Tagen

Social Mediavor 6 TagenCommunity Management zwischen Reichweite und Verantwortung

-

Apps & Mobile Entwicklungvor 3 Monaten

Apps & Mobile Entwicklungvor 3 MonatenHuawei Mate 80 Pro Max: Tandem-OLED mit 8.000 cd/m² für das Flaggschiff-Smartphone

-

Apps & Mobile Entwicklungvor 3 Monaten

Apps & Mobile Entwicklungvor 3 MonatenFast 5 GB pro mm²: Sandisk und Kioxia kommen mit höchster Bitdichte zum ISSCC

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenKommentar: Anthropic verschenkt MCP – mit fragwürdigen Hintertüren

-

Datenschutz & Sicherheitvor 2 Monaten

Datenschutz & Sicherheitvor 2 MonatenSyncthing‑Fork unter fremder Kontrolle? Community schluckt das nicht

-

Social Mediavor 2 Monaten

Social Mediavor 2 MonatenDie meistgehörten Gastfolgen 2025 im Feed & Fudder Podcast – Social Media, Recruiting und Karriere-Insights