Datenschutz & Sicherheit

PerfektBlue: Bluetooth-Lücke in Entertainment-Systemen von Mercedes, Skoda & VW

„PerfektBlue“ haben IT-Sicherheitsforscher eine Kombination aus Bluetooth-Sicherheitslücken in einem Bluetooth-Stack genannt, der in mehreren Auto-Entertainment-Systemen zum Einsatz kommt. Die Entdecker schreiben von „kritischen Lücken, die Over-the-Air-Angriffe auf Millionen Geräten in Autos und anderen Branchen“ ermöglichen. Die Gefahr ist jedoch im Regelfall deutlich geringer als angedeutet.

Ein IT-Forscher-Team von PCA Cybersecurity hat die Schwachstellen in dem OpenSynergy Bluetooth Protocol Stack (BlueSDK) aufgespürt und analysiert. Dieser Stack kommt etwa in der Autobranche zum Einsatz, aber auch für andere – nicht erforschte – Geräte, etwa im IoT-Bereich. Darin klafften bis in den September 2024 die vier Sicherheitslücken, die OpenSynergy mit Patches korrigiert und an die betroffenen Hersteller verteilt hat.

PerfektBlue: Vier Sicherheitslücken in Kombination

Die IT-Sicherheitsforscher haben vier Schwachstellen ausgemacht. Die gravierendste stammt daher, dass das BlueSDK die Existenz eines Objekts nicht prüft, bevor es darauf Operationen vornimmt – eine Use-after-free-Lücke. Das mündet darin, dass eingeschleuster Schadcode ausführbar ist (CVE-2024-45434 / noch kein EUVD, CVSS 8.0, Risiko „hoch„). Hier weicht PAC Security von der CVSS-Einstufung ab und behauptet, die Lücke sei gar kritisch. Eine weitere Lücke lässt sich zur Umgehung einer Sicherheitsprüfung in RFCOMM und der Verarbeitung eingehender Daten missbrauchen (CVE-2024-45433 / noch kein EUVD, CVSS 5.7, Risiko „mittel„).

Zudem nutzt das BlueSDK in der RFCOMM-Komponente eine falsche Variable als Funktionsargument, was unerwartetes Verhalten oder ein Informationsleck erzeugt (CVE-2024-45432 / noch kein EUVD; CVSS 5.7, Risiko „mittel„). Die L2CAP-Channel-ID (CID) prüft das BlueSDK nicht korrekt, wodurch Angreifer einen L2CAP-Kanal mit Null-Identifier als Remote CID anlegen können – die IT-Forscher erklären jedoch nicht, inwiefern das problematisch ist (CVE-2024-45431 / noch kein EUVD, CVSS 3.5, Risiko „niedrig„).

Die IT-Sicherheitsforscher haben die Schwachstellenkombination auf Infotainment-Systemen von Mercedes Benz (NTG6 Head Unit), Volkswagen (MEB ICAS3 Head Unit) und Skoda (MIB3 Head Unit) getestet und verifiziert. Nicht genannte OEMs sollen ebenfalls anfällig sein. Auffällig ist, dass recht alte Firmware-Stände und Geräte getestet wurden. Es seien aber auch neuere Modelle anfällig, erklären die PAC-Mitarbeiter. Laut Timeline sollten etwa ab September 2024 fehlerkorrigierende Updates von den Autoherstellern verteilt werden.

Die Sicherheitslücken erlauben den Einbruch in verwundbare Infotainment-Systeme. Die Hersteller verteilen in der Regel Aktualisierungen Over-the-Air (OTA), sofern die PKW-Besitzer entsprechende, üblicherweise mit beschränkter Laufzeit versehene Verträge unterschrieben haben. Diese Updates müssen Nutzer in der Regel aber auch aktiv akzeptieren und installieren lassen. Das sollten Betroffene jetzt gegebenenfalls nachholen. Wer keine OTA-Update-Möglichkeit hat, muss für die Aktualisierung einen Termin in der Werkstatt machen oder eine Aktualisierung über USB vornehmen.

Gefährdungseinschätzung von PerfektBlue

Sofern Firmen, die das BlueSDK nutzen und ein sehr niedriges Sicherheitsprofil oder „Just Works“-SSP-Modus dafür konfigurieren, ließen sich die Lücken ohne vorheriges Pairing missbrauchen. Das machen aber zumindest die PKW-Hersteller nicht. Dort ist Bedingung, dass ein Angreifer-Gerät mit dem Infotainment-System gekoppelt wird.

In einer Stellungnahme gegenüber heise online nennt VW das auch als eine der großen Hürden, die ein Ausnutzen der Schwachstellen unwahrscheinlich macht. Das Infotainment-System muss zunächst in den Pairing-Modus versetzt werden. Das passiert in der Regel lediglich einmalig. VW unterstellt zudem, dass Angreifer maximal fünf bis sieben Meter vom angegriffenen Wagen entfernt sein dürften. Diese Zahl lässt sich jedoch mit diversen Ansätzen weiter dehnen. Ein Start-up aus den USA will angeblich Bluetooth-Verbindungen zu Satelliten hergestellt haben.

Dann müssen potenzielle Opfer außerdem der Kopplung des Angreifer-Geräts zustimmen. In der Regel findet eine Kopplungsanfrage unter Anzeige einer Nummer an, die dann mit dem eigentlich in dem Moment zum Koppeln vorgesehenen Gerät nicht übereinstimmt.

Hürdenlauf

Wenn diese Hürden genommen sind, ist der Einbruch in die verwundbaren Infotainment-Systeme möglich. Angreifer können eigenen Code darauf ausführen. Volkswagen schreibt dazu: „Die Untersuchungen haben außerdem ergeben, dass die Fahrzeugsicherheit zu keinem Zeitpunkt betroffen ist, ebenfalls hat es keine Auswirkungen auf die Integrität des Autos. Eingriffe auf Fahrzeugfunktionen, die über das Infotainment hinausgehen, sind nicht möglich, z.B. also keine Lenkeingriffe, keine Eingriffe in Fahrerassistenzsysteme oder Motor- oder Bremsfunktionen. Diese liegen im Fahrzeug auf einem anderen Steuergerät, welches über seine eigenen Sicherheitsfunktionen ggü. Eingriffen von außen geschützt ist“. Es gebe zudem keine Hinweise, dass die Lücken in freier Wildbahn missbraucht würden.

Der Teil der Einschätzung ist zumindest fragwürdig. Bislang bekannt gewordene Angriffe auf Fahrzeugtechnik gelangen oftmals etwa über einen initialen Einbruch in das Infotainment-System, das mit CAN-Bus/RS485 an weitere Kfz-Elektronik und Steuergeräte angebunden ist. Über den CAN-Bus lassen sich etwa auch Autos starten.

In dem Kontext mit „PerfektBlue“ ist es jedoch weitgehend müßig, über solche Auswirkungen zu sinnieren. Es ist ziemlich unwahrscheinlich, dass die Bedingungen für einen erfolgreichen Angriff vorherrschen. Dennoch sollten PKW-Besitzer sicherstellen, dass sie die Firmware ihrer Head-Units auf den aktuellen Stand bringen.

(dmk)

Datenschutz & Sicherheit

Ameos Kliniken: Nach IT-Angriff steht Auskunftsformular für Datenschutz bereit

Nach einer IT-Attacke auf den Klinikkonzern Ameos im Juli hat der Verbund nun ein Auskunftsformular veröffentlicht, auf der Patienten Auskunftsersuchen stellen können. „Ob im Einzelfall personenbezogene Daten betroffen sind, muss jeweils aufwendig und individuell geprüft werden. Daher können wir keine verlässliche Aussage dazu machen, wie viele Personen tatsächlich betroffen sind“, sagte ein Sprecher gegenüber heise online.

Nach Ausfüllen des auf der Informationswebpage verlinkten Auskunftsformulars werde individuell geprüft, welche Daten in welchem Zeitraum betroffen waren. Dazu müssen sich Patienten identifizieren und eine Kopie ihres Ausweisdokuments hochladen.

„Betroffen sind die deutschen und österreichischen Einrichtungen der Ameos Gruppe“, fügte der Sprecher hinzu. Möglich sei auch, dass keine personenbezogenen Daten betroffen sind, meinte eine Sprecherin gegenüber der dpa. Gemeinsam mit den zuständigen Behörden und externen Dienstleistern arbeite Ameos an der Aufklärung des Angriffs.

Strafanzeige erstattet

Die Ameos Gruppe arbeitet laut dpa eng mit internen und externen forensischen Expertinnen und Experten, den Datenschutzbehörden der Bundesländer sowie dem Landeskriminalamt Sachsen-Anhalt zusammen. Dort sei zentral Strafanzeige erstattet worden. Die Versorgung der Patientinnen und Patienten sei jederzeit gesichert gewesen.

Der Angriff auf die IT-Systeme des Gesundheitskonzerns führte zu erheblichen Störungen in den deutschen Einrichtungen. In den Kliniken werden nach Angaben Ameos‘ mehr als 500.000 Patienten jährlich betreut. Zum Klinikverbund gehören mehr als 100 Einrichtungen an über 50 Standorten, darunter zahlreiche Spitäler für psychische Gesundheit. Ameos ist neben Helios und Sana einer der größeren privaten Klinikbetreiber im deutschsprachigen Raum.

(mack)

Datenschutz & Sicherheit

Google Chrome: Kritische Sicherheitslücke in Webbrowser

Im Webbrowser Google Chrome haben die Entwickler eine Sicherheitslücke geschlossen, die als kritisches Risiko eingestuft wurde. Wer den Browser einsetzt, sollte sicherstellen, die jüngste Version zu nutzen.

In der Versionsankündigung bleibt Google bekannt schmallippig zu den Details der Schwachstelle. Es handelt sich um einen „Use after free“-Fehler, bei dem der Programmcode auf Ressourcen zugreift, die bereits freigegeben wurden und somit undefinierte Inhalte aufweisen. Dieser Fehler findet sich im WebGL-Render-Backend Angle (CVE-2025-9478 / EUVD-2025-25822, noch kein CVSS, Risiko laut Google jedoch „kritisch„). Der CVE-Eintrag verrät immerhin, dass Angreifer aus dem Netz einen Speicherfehler auf dem Heap etwa mit sorgsam präparierten HTML-Webseiten missbrauchen können – oftmals gelingt darüber das Einschleusen und Ausführen von Schadcode, was aufgrund des Schweregrads auch hier anzunehmen ist.

In den Versionen Google Chrome 139.0.7258.158 für Android, 139.0.7258.154 für Linux sowie 139.0.7258.154/.155 für macOS und Windows haben die Entwickler die Schwachstelle ausgebessert. Das Update steht nun zum Download bereit.

Versionsprüfungen

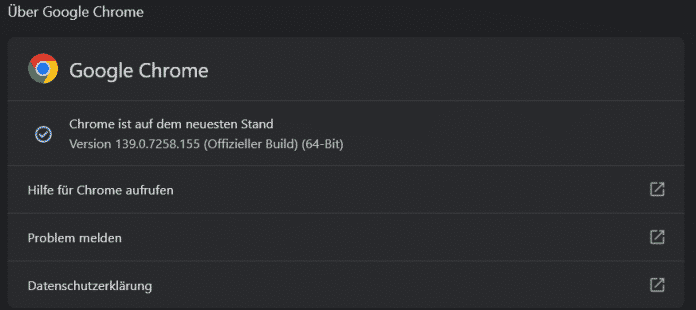

Ob die aktuelle Fassung des Webbrowsers läuft, verrät der Versionsdialog. Der öffnet sich nach Klick auf das Symbol mit drei aufgestapelten Punkten rechts von der Adressleiste. Dort geht es weiter über „Hilfe“ – „Über Google Chrome“.

Der Versionsdialog von Google Chrome zeigt den aktuell laufenden Softwarestand an. Gegebenenfalls startet er die Aktualisierung.

(Bild: heise medien)

Bei Verfügbarkeit von aktualisierter Software startet das auch den Update-Prozess. Unter Linux ist dafür die distributionseigene Softwareverwaltung zuständig. Unter Android steht die Aktualisierung im Google Play Store bereit – jedoch nicht sofort für alle Smartphones. Die Lücke betrifft das Chromium-Projekt und dürfte somit darauf fußende Software wie den Microsoft-Edge-Browser ebenfalls anfällig machen. Dafür dürfte in Kürze ebenfalls ein Update bereitstehen, das Nutzerinnen und Nutzer zeitnah installieren sollten.

Zuletzt musste Google Mitte Juli eine bereits attackierte Schwachstelle im Chrome-Webbrowser abdichten.

(dmk)

Datenschutz & Sicherheit

Elektronische Fußfesseln sollen Täter*innen auf Abstand halten

Künftig sollen Familiengerichte bundesweit elektronische Fußfesseln anordnen können, um gewaltsame Täter*innen auf Abstand zu halten. Auf das Vorhaben hatte sich die schwarz-rote Regierung bereits im Koalitionsvertrag geeinigt. Nun hat das Justizministerium einen Gesetzentwurf vorgelegt.

Die Fußfessel soll dabei helfen, Annäherungsverbote durchzusetzen, etwa bei häuslicher Gewalt. Die Geräte haben einen GPS-Sender und werden am Bein befestigt, beispielsweise bei einem gewaltsamen Ex-Partner. Sobald er sich etwa einer bedrohten Ex-Partnerin nähert, soll ein Alarm ausgelöst werden.

Eine solche Maßnahme gibt es bereits in einzelnen Bundesländern sowie in Spanien. Deshalb ist oft die Rede vom „spanischen Modell“. Die Ampel-Regierung hatte Ende 2024 eine bundesweite Regelung auf den Weg gebracht, aber nicht beschlossen. Fachleute lehnen die elektronische Fußfessel zwar nicht ab, verweisen aber auf den weitaus größeren Handlungsbedarf beim Gewaltschutz.

Elektronische Fußfesseln: So soll das ablaufen

Die Grundlage für elektronische Fußfesseln ist das Gewaltschutzgesetz. Es soll Menschen schützen, die bereits Gewalt erfahren haben, etwa Partner*innen oder Kinder. Demnach können Familiengerichte Täter*innen verbieten, sich einer Person erneut zu nähern. Die Fußfessel soll das nach Plänen des Justizministeriums kontrollieren und weitere Übergriffe durch einen Alarm verhindern.

Nicht nur Täter*innen sollen einen Peilsender bekommen. Auch zu schützende Personen können – auf eigenen Wunsch – ein Empfangsgerät tragen. Dann erhalten sie selbst eine Warnung, sobald der angeordnete Mindestabstand unterschritten wird.

Kommt es zu einem Alarm, landet er bei einer zentralen Anlaufstelle, etwa der HZD (Hessische Zentrale für Datenverarbeitung) oder der GÜL (Gemeinsame elektronische Überwachungsstelle der Länder). Dort müssen die Angestellten je nach Kontext eine Entscheidung treffen: Ist es ein technischer Fehlalarm? Sollten Täter*in oder Opfer kontaktiert werden? Muss die Polizei direkt vor Ort einschreiten?

Das Justizministerium rechnet damit, dass die Fußfesseln vor allem bei Partnerschaftsgewalt zum Einsatz kommen; also bei Menschen, die aktuell in einer Beziehung sind oder sich getrennt haben. Möglich sein sollen Fußfesseln allerdings auch im Eltern-Kind-Verhältnis, bei Stalking oder Konflikten unter Nachbar*innen.

Die Anordnung für elektronische Fußfesseln soll zunächst für sechs Monate gelten und sich danach beim Familiengericht um jeweils drei Monate verlängern lassen. Eine Strafandrohung soll verhindern, dass Täter*innen die Fußfessel ablehnen, entfernen oder zerstören. Das geplante Strafmaß ist eine Freiheitsstrafe bis zu drei Jahren oder eine Geldstrafe.

Kritik am begrenzten Nutzen

Die zentrale Kritik an elektronischen Fußfesseln ist ihr begrenzter Nutzen. So rechnet das Justizministerium selbst aufgrund bisheriger Erfahrungen damit, dass die elektronische Fußfessel bei jährlich 160 Fällen zum Einsatz kommt.

Allerdings gab es im Jahr 2023 rund 256.000 dokumentierte Fälle häuslicher Gewalt in Deutschland. Das entspricht in etwa einem neuen Fall alle zwei Minuten. Besonders betroffen sind Frauen. Sie machen mehr als zwei Drittel der Betroffenen aus. 155 Frauen sind 2023 durch ihren Partner oder Ex-Partner getötet worden.

Auf Anfrage von netzpolitik.org zeigt sich der Verein Frauenhauskoordinierung skeptisch zu den Plänen für Fußfesseln. Der Verein unterstützt die bundesweit 280 Frauenhäuser und mehr als 285 Fachberatungsstellen. „Bevor neue Maßnahmen eingeführt werden, sollten die bereits geltenden Rechtsinstrumente voll ausgeschöpft werden“, schreibt eine Sprecherin. So würden Richter*innen und Polizist*innen die Frauen nicht immer ernst nehmen; bei Verfahren würden gründliche Prüfungen fehlen.

Nur ein Bruchteil der Bewohnerinnen von Frauenhäusern (10 Prozent) würde überhaupt Anträge nach dem Gewaltschutzgesetz stellen. „Es bräuchte nicht nur mehr Personal, sondern vor allem intensiv und besser geschultes Personal – bei Polizei, Gerichten und Jugendämtern“, schreibt die Sprecherin.

Der oft zitierte Vergleich mit dem spanischen Modell greife zu kurz. „Dort werden gewaltbetroffene Frauen ganz anders begleitet – mit kontinuierlichen Kontrollanrufen, Polizeibesuchen und engmaschiger Überwachung der Gefährdungslage“, erklärt die Sprecherin. Diese Infrastruktur fehle in Deutschland vollständig.

Wir sind ein spendenfinanziertes Medium

Unterstütze auch Du unsere Arbeit mit einer Spende.

Ähnliche Kritik übte der Deutsche Juristinnenbund (djb) zu einem ähnlichen Gesetzentwurf der Union aus dem Jahr 2024. Der Einsatz der Fußfessel sei nur „eine situationsbezogene, kurzfristige Form der Prävention“, heißt es in einer 15-seitigen Stellungnahme. Weder würde die Maßnahme die Ursachen der Gewalt adressieren, noch langfristigen Schutz gewähren. Nur selten könnten von Gewalt betroffene Frauen und Kinder eine Wohnung alleine nutzen. Das heißt: Vielen fehlt die Möglichkeit, einfach so auf Abstand zum Täter zu gehen. Das Fazit der Jurist*innen: Der flächendeckende Ausbau von Beratungsstellen und Schutzunterkünften sei „unabdingbar“.

Wie viel Geld ist dem Staat der Gewaltschutz wert?

Dass elektronische Fußfesseln allein nicht genügen, ist dem Justizministerium offenbar bewusst. Der Gesetzentwurf sieht weitere Maßnahmen zum Gewaltschutz vor. So sollen Familiengerichte auch Täter*innen zu Anti-Gewalt-Trainings verpflichten können. Spätestens fünf Jahre nach Inkrafttreten soll das neue Gesetz zudem überprüft werden. Weitere Maßnahmen seien geplant, teilt das Ministerium mit, etwa im Sorge- und Mietrecht.

Zum Nutzen der Maßnahmen äußert sich das Justizministerium teils irreführend. In der Pressemitteilung zum Gesetzentwurf heißt es etwa: „Die Justiz soll häusliche Gewalt besser verhindern können“ und „Jeder Fall von häuslicher Gewalt ist einer zu viel.“ Aber die vorgeschlagenen Maßnahmen – Fußfesseln und Anti-Gewalt-Trainings – greifen erst, nachdem es bereits zu Gewalt gekommen ist. Nur wenn Betroffene die Ressourcen haben, Hilfe beim Familiengericht zu suchen, können die Neuerungen weitere Gewalt verhindern.

Der Knackpunkt beim Gewaltschutz sind die Kosten. Wie viel Geld ist es dem Staat wert, Menschen, insbesondere Frauen, vor Gewalt zu schützen? Immer wieder beklagen Fachleute: Es gebe nicht genug Hilfe für alle, die Hilfe benötigen; die Finanzierung sei unsicher. Schätzungen zufolge fließen ins Hilfesystem aus Schutzeinrichtungen und Beratungsstellen jährlich rund 270 Millionen Euro. Nötig seien allerdings 1,6 Milliarden Euro, wie der Verein Frauenhauskoordinierung festhält. Zum Vergleich: Für die neuen, elektronischen Fußfesseln rechnet das Justizministerium mit jährlich laufenden Kosten von rund 11 Millionen Euro.

Eine weitere konkrete Hochrechnung liefert der Verein Frauenhauskoordinierung in seiner bundesweiten Statistik für das Jahr 2023. Demnach gebe es in Deutschland rund 7.700 Plätze in Frauenhäusern; benötigt würden aber rund 21.000. Das heißt, der Bedarf ist nur zu rund einem Drittel gedeckt.

Im Februar hatten sich Bundestag und Bundesrat auf ein Gewalthilfegesetz geeinigt. Darin steht ein Rechtsanspruch auf Schutz und Beratung bei geschlechtsspezifischer und häuslicher Gewalt für Frauen und ihre Kinder. Für die Umsetzung wurde den Ländern viel Zeit eingeräumt: Der Anspruch soll erst 2032 in Kraft treten.

-

Datenschutz & Sicherheitvor 3 Monaten

Datenschutz & Sicherheitvor 3 MonatenGeschichten aus dem DSC-Beirat: Einreisebeschränkungen und Zugriffsschranken

-

UX/UI & Webdesignvor 1 Woche

UX/UI & Webdesignvor 1 WocheDer ultimative Guide für eine unvergessliche Customer Experience

-

Apps & Mobile Entwicklungvor 3 Monaten

Apps & Mobile Entwicklungvor 3 MonatenMetal Gear Solid Δ: Snake Eater: Ein Multiplayer-Modus für Fans von Versteckenspielen

-

Online Marketing & SEOvor 3 Monaten

Online Marketing & SEOvor 3 MonatenTikTok trackt CO₂ von Ads – und Mitarbeitende intern mit Ratings

-

Digital Business & Startupsvor 2 Monaten

Digital Business & Startupsvor 2 Monaten10.000 Euro Tickets? Kann man machen – aber nur mit diesem Trick

-

Entwicklung & Codevor 1 Woche

Entwicklung & Codevor 1 WochePosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Social Mediavor 1 Woche

Social Mediavor 1 WocheRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

UX/UI & Webdesignvor 3 Monaten

UX/UI & Webdesignvor 3 MonatenPhilip Bürli › PAGE online