Apps & Mobile Entwicklung

So erstellt Ihr aus jedem Text einen eigenen Podcast

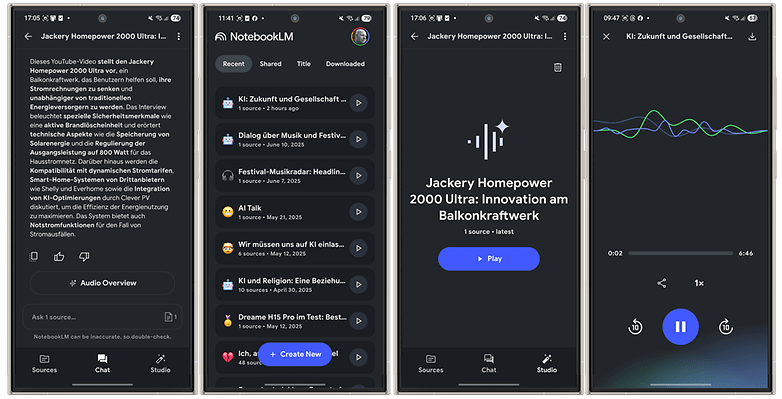

Ihr kennt das: Der Text ist so lang, dass man gar keinen Bock hat, ihn zu lesen, obwohl einen das Thema interessiert. NotebookLM von Google kann da helfen – mit einer knackigen Zusammenfassung im Podcast-Stil. Wie das genau funktioniert, und wie Ihr das selbst kostenlos nutzen könnt, verraten wir Euch in diesem Beitrag.

Ja, ja. Texte zusammenfassen mit KI. Kennen wir, Schnee von gestern! Egal, ob Google Gemini, ChatGPT oder sonst ein LLM (Large Language Model): Jedes dieser generativen KI-Tools kürzt Euch jeden noch so langen Text auf ein erträgliches Maß an Zeichen. Das ist super hilfreich, muss aber nicht immer der Weisheit letzter Schluss sein.

Was ist NotebookLM?

Auch NotebookLM ist ein KI-Chatbot, allerdings einer, der sich von ChatGPT und Co. unterscheidet. Sein entscheidendes Merkmal ist die Fähigkeit, Analysen, Zusammenfassungen und Antworten ausschließlich auf die von Euch hochgeladenen Quellen zu stützen. Dabei könnt Ihr eine Vielzahl unterschiedlicher Quellformate nutzen: Verlinkt gewünschte Webseiten, ladet Textdokumente, Google-Docs, PDF-Dateien oder auch beispielsweise MP3s hoch. Nennt alternativ YouTube-Videos oder nutzt einfach kopierten Text aus der Zwischenablage als Quelle.

Euer Vorteil bei diesem von Google stammenden Werkzeug: Egal, welche Hilfe Ihr von der KI erwünscht – sie stützt sich lediglich auf die von Euch gewählten und verifizierten Quellen. Allein aus diesem Blickwinkel betrachtet wird der Unterschied zu anderen „Zusammenfassen“-Funktionen ersichtlich: Ihr lasst Euch nicht zwingend einen einzigen Text zusammenfassen, sondern einen ganzen Berg sorgfältig kuratierter Dateien auf einmal. Bis zu 50 Quellen könnt Ihr so für ein Projekt zusammenstellen.

NotebookLM besitzt eine Podcast-Funktion

Wenn Euch der Verweis auf die Funktionsweise von NotebookLM bereits reicht, weil es einfach ein wirklich mächtiges Tool ist: You’re welcome! Eine spannende Funktion solltet Ihr dabei aber nicht übersehen: die Podcast-Funktion!

Diese Funktion, die offiziell „Audio-Zusammenfassung“ heißt, gibt es bereits seit letztem Jahr, seit einigen Monaten auch in Deutsch und vielen anderen Sprachen. Es wird Euch also nicht einfach nur eine Zusammenfassung Eurer Dokumente vorgelesen. Stattdessen zieht Google das auf wie einen echten Podcast, in welchem sich zwei Personen äußerst realistisch über Dein gewähltes Thema unterhalten.

Wie gesagt: Ihr seid sehr frei bei der Wahl der Quellen. Ihr könnt Euch ein zweistündiges YouTube-Video knackig zusammenfassen lassen, eine komplette Textsammlung, oder einfach nur einen übertrieben langen Artikel, bei dem Ihr keinen Bock habt, ihn komplett zu lesen. Das Resultat in Podcast-Form könnt Ihr herunterladen oder alternativ auch Euer komplettes Projekt freigeben und teilen.

So erstellt Ihr mit NotebookLM Euren persönlichen Podcast

Wie läuft das nun mit dem persönlichen Podcast? Es ist total simpel und in wenigen Schritten erledigt. So geht Ihr Schritt für Schritt vor:

- Geht auf die Seite NotebookLM und loggt Euch mit Eurem Google-Account ein.

- Alternativ könnt Ihr Euch NotebookLM für Android oder NotebookLM für iOS als App auf dem Handy installieren und Euch dort einloggen.

- Klickt bzw. tippt auf Neu erstellen.

- Fügt Eure Quellen hinzu – egal, ob URL, Text, MP3 oder auch YouTube-Video

- Tippt im Chat-Tab auf Audio-Zusammenfassung oder im Studio-Tab auf Generieren.

So, fertig ist die Laube und Ihr könnt Eurem eigenen Podcast lauschen, der auf Euren Quellen beruht. Ein paar kleine Tipps dazu noch:

- Ihr könnt diesen Podcast nun als Datei herunterladen und dann teilen – oder Ihr teilt direkt über NotebookLM das komplette Projekt.

- Wollt Ihr den Podcast in einer anderen Sprache erstellen? Dann wählt in der Web-Version unter Einstellungen die gewünschte Ausgabesprache aus.

- Wer will, kann vor dem Erstellen des Podcasts auch noch per Prompt Anmerkungen loswerden. Beispielsweise, wenn nur eine bestimmte Quelle berücksichtigt werden soll, ein bestimmtes Thema, oder auch ein bestimmter Ton angeschlagen werden soll.

Für mich ist das eine der abgefahrensten Geschichten, seit ich generative KI nutze und ich hoffe, dass Ihr von der Funktion ähnlich begeistert seid wie ich. Lasst mich gerne wissen, wenn Ihr weitere Fragen zu NotebookLM habt, oder Bock auf weitere KI-Erklärbär-Beiträge habt.

Apps & Mobile Entwicklung

So lange hält der Akku der Apple Watch Ultra 3

Apple positioniert die Ultra 3 als eine Uhr für Ausdauersportler, Outdoor-Abenteurer und Wassersportler, die einen Akku brauchen, der lange durchhält. In den offiziellen Tests sagt Apple, dass eine volle Ladung am Morgen für einen 18-Stunden-Tag ausreicht, der ein 60-minütiges Training, App-Nutzung, Benachrichtigungen und regelmäßige Zeitkontrollen umfasst. Danach sollte sie immer noch genug Energie haben, um sechs Stunden Schlaf zu erfassen und dann weitere 18 Stunden zu laufen.

Ein bisschen seltsam ist, dass Apple sechs Stunden Schlaf als Maßstab nimmt, während die meisten Gesundheitsrichtlinien sieben bis neun Stunden empfehlen. Trotzdem hat mich das neugierig gemacht, wie sich das Ultra 3 in der Praxis schlägt. Also lasst es uns herausfinden.

Apple Watch Ultra 3: Wie gut ist die Akkulaufzeit?

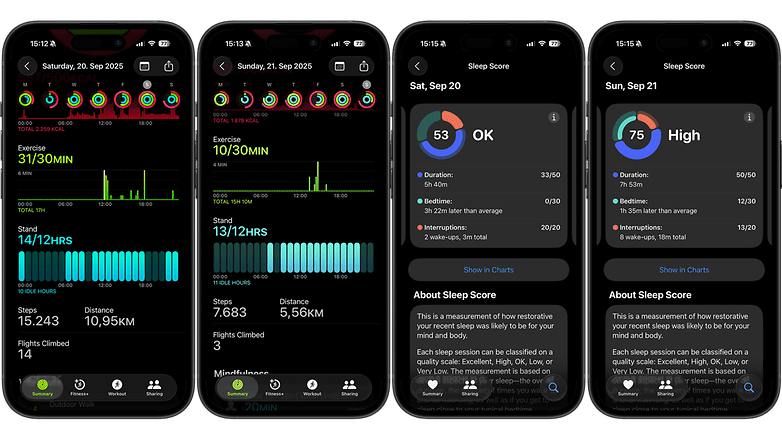

Ich habe die Apple Watch Ultra 3 letzten Freitag bekommen, aber mein erster richtiger Test begann am Samstag um 00:25 Uhr. Alles war eingeschaltet: alle Sensoren aktiv, Wi-Fi und Bluetooth verbunden (kein Mobilfunk), Display-Helligkeit auf zwei Drittel eingestellt, Always-On-Display aktiviert und vollständig mit einem neuen iPhone 17 gekoppelt. Ich bin mit aktiviertem Schlafmodus ins Bett gegangen, um meinen Schlaf zu überwachen.

Bevor wir weitermachen, eine kurze Warnung. Bei einer Radtour in den österreichischen Alpen habe ich mir vor kurzem die Achillessehne verletzt und befand mich während des Tests noch in der Erholungsphase. Das bedeutete: kein Laufen, kein Krafttraining und keine langen Ausfahrten. Das einzige aufgezeichnete Training war ein 1 km langer Spaziergang mit eingeschaltetem GPS für 14 Minuten. Trotzdem hat die Uhr am Samstag 15.243 Schritte und am Sonntag 7.683 Schritte aufgezeichnet. Die meiste Zeit habe ich die Ultra 3 benutzt, um Musik auf meine AirPods Pro 2 zu streamen, Benachrichtigungen zu erhalten und Gesundheitsdaten zu sammeln.

Ich erwähne das, weil ich das Ultra 3 nicht intensiv genutzt habe. Normalerweise würde ich bei einem Test einer Smartwatch wie dieser mehrere Läufe, einige Kraftübungen oder eine lange Fahrradtour einbeziehen. An diesem Wochenende war das nicht der Fall.

Am Sonntag um 19:00 Uhr schaltete sich die Apple Watch Ultra 3 aus. Die Gesamtlaufzeit betrug 42 Stunden und 35 Minuten, fast genau das, was Apple verspricht, was auf dem Papier beeindruckend ist. Trotzdem hatte ich etwas mehr erwartet, vor allem nachdem ich viele Berichte über längere Laufzeiten bei aktiviertem Always-On-Display gelesen hatte.

Dies war kein Stresstest. Es gab kein stundenlanges GPS-Tracking oder aufeinanderfolgende Trainingseinheiten, daher hätte ich erwartet, dass ich ein paar Stunden mehr herausholen kann. Für eine durchschnittliche Nutzung scheint die Schätzung von Apple genau zu sein, aber sie fühlt sich eher wie eine Obergrenze als wie eine konservative Zahl an.

Die wirkliche Bewertung wird erfolgen, sobald ich wieder trainiere und die Uhr unter den Bedingungen, für die sie entwickelt wurde, einsetzen kann. Die Ultra 3 ist für Athleten, Abenteurer und Entdecker gemacht, und ich habe sie noch nicht auf Herz und Nieren geprüft.

Apple Watch Ultra 3 entladen: Wie schnell wird sie aufgeladen?

Apple behauptet, dass mit dem neuen Schnellladeprofil der Ultra 3 eine fünfzehnminütige Aufladung für bis zu 12 Stunden normale Nutzung ausreicht, und nur 5 Minuten für 8 Stunden Schlaftracking reichen. Das Unternehmen sagt auch, dass Ihr in etwa 45 Minuten 80 Prozent und in etwa 75 Minuten eine volle Ladung erreichen solltet.

Das ist eine deutliche Verbesserung gegenüber dem letztjährigen Ultra-Modell, das etwa 60 Minuten brauchte, um 80 Prozent zu erreichen, und 99 Minuten für eine volle Ladung benötigte – einer der Nachteile, die wir in unserem Ultra 2 Testbericht erwähnt habe.

Dieses Jahr wird die Ultra 3 zwar schneller aufgeladen, aber es gibt einen Haken. Ihr braucht das 20-Watt-USB-C-Netzteil von Apple oder ein kompatibles Netzteil, um diese Werte zu erreichen. Ansonsten müsst Ihr mit langsameren Ergebnissen rechnen.

Hier ist der Grund dafür. Obwohl ich zu Hause ein 20-Watt-Netzteil habe, habe ich das Ultra 3 mit meinem 30-Watt-Netzteil für das MacBook Air aufgeladen, weil es bereits mit dem Verlängerungskabel auf meinem Schreibtisch verbunden war. Diese Entscheidung hat einen großen Unterschied gemacht.

Die neue Apple Watch Ultra 3 nutzt das aktualisierte 20-Watt-Schnellladeprofil von Apple, das etwa 9 Volt bei 2,22 Ampere benötigt, um die vollen 20 Watt zu erreichen. Der 30-Watt-Adapter des MacBook Air bietet nicht genau diese Kombination, sodass die Uhr wahrscheinlich mit 5 Volt und 3 Ampere (5 Watt) geladen wurde. Daher dauerte der Ladevorgang deutlich länger als die von Apple angegebene Zeit von null bis 100 Prozent in 75 Minuten. In meinem Fall brauchte die Uhr 103 Minuten, um vollständig aufgeladen zu sein.

Die Schlussfolgerung ist einfach. Verwendet den 20-Watt-USB-C-Adapter von Apple oder ein zertifiziertes Äquivalent, wenn Ihr die beworbenen Schnellladegeschwindigkeiten erreichen wollt. Andere Adapter funktionieren zwar auch, aber dann müsst Ihr vielleicht länger warten als erwartet.

Mein erstes Fazit zur Akkulaufzeit der Apple Watch Ultra 3

Insgesamt hält die Apple Watch Ultra 3 ungefähr das, was Apple für die Akkulaufzeit verspricht, aber nicht mehr. Bei einem Preis von 899 Euro hatte ich erwartet, dass sie unter so geringen Bedingungen länger durchhält, vor allem, weil ich während dieses Tests keine Workouts aufgezeichnet oder viele der Premiumfunktionen genutzt habe. Es lässt sich nur dann schneller aufladen, wenn Ihr den richtigen Adapter verwendet, also stellt sicher, dass Ihr das 20-W-Ladegerät von Apple oder ein zertifiziertes Äquivalent habt.

Apps & Mobile Entwicklung

Biwin Amber CB500: Erste CFexpress Type B Card mit VPG800-Zertifizierung

Inzwischen gibt es viele Speicherkarten des Standards CFexpress Type B, doch noch keine unterstützt die VPG800-Klasse. Das will Biwin jetzt ändern und stellt die erste Type-B-Karte mit VPG800-Zertifizierung vor, die demnach garantiert dauerhaft mit mindestens 800 MB/s schreibt.

VPG steht für Video Performance Guarantee und meint eine Reihe von Geschwindigkeitsklassen, die von der zuständigen Compact Flash Association beschlossen wurden. Im Grunde ist es ein Pendant zur Video Speed Class bei den SD-Speicherkarten, nur eben für Compact Flash.

Bei CFexpress-Speicherkarten sind die Stufen VPG200 und VPG400 gängig, die Speicherkarten müssen also dauerhaft mindestens 200 MB/s oder 400 MB/s beim sequenziellen Schreiben schaffen. Die VPG800-Klasse mit der Hürde 800 MB/s ist dagegen noch kaum verbreitet. Erst Ende Februar haben Type-A-Modelle der Serie NX-A2Pro von Nextorage sie erstmals genommen. Jetzt folgt Biwin für Type B.

Biwin Amber CB500 CFexpress

Die neue Speicherkartenserie von Biwin nennt sich Amber CB500 CFexpress. Sie wird mit Speicherkapazitäten von 128 GB, 256 GB, 512 GB und 1 TB angeboten. Die zumindest kurzzeitig möglichen Spitzentransferraten liegen noch deutlich höher als 800 MB/s. So erreichen die Modelle mit 128 GB und 256 GB bis zu 3.700 MB/s beim Lesen und 3.400 MB/s beim Schreiben. Sogar 3.750 MB/s lesend und 3.500 MB/s schreibend sind es bei den Modellen mit 512 GB und 1 TB, schreibt Biwin im Datenblatt.

Laut Hersteller genügt die Leistung, um RAW-Videos (unkomprimiert) mit 4K, 6K, 8K und sogar 12K-Auflösung aufzunehmen. Die Speicherkarten sollen „sehr bald“ den Handel erreichen. Preise wurden zwar in der Pressemitteilung nicht genannt, doch wird das 256-GB-Modell im Biwin-Marketplace auf Amazon für rund 400 Euro angepriesen.

Auf den Produktbildern ist noch die VPG400-Zertifizierung zu sehen, das sollte sich aber bald ändern.

Apps & Mobile Entwicklung

Samsung One UI 8 ist da

Samsung hat die Veröffentlichung von One UI 8, seinem eigenen Android 16-Update, beschleunigt. Nach monatelangen Tests ist die finale Version jetzt für berechtigte Galaxy-Smartphones und -Tablets verfügbar, beginnend mit der Galaxy S25-Serie und nach und nach auch für ältere Modelle und Mittelklassegeräte. In der folgenden Liste kannst du sehen, ob dein Gerät für das Update in Frage kommt.

Zeitplan für die Veröffentlichung von One UI 8

Nach der Veröffentlichung von Android 16 für die Pixel-Geräte durch Google hat Samsung schnell gehandelt. Das Beta-Programm begann am 28. Mai mit dem Galaxy S25 und Galaxy S25 Ultra. Bald folgten weitere Galaxy-Geräte, vor allem aus früheren Flaggschiff-Generationen wie dem Galaxy S24, Galaxy Z Fold 6 und Galaxy Z Flip 6.

Am 15. September beendete Samsung die Beta für die Galaxy S25-Serie und gab bekannt, dass One UI 8 offiziell auf das Galaxy S25, S25 Plus, S25 Edge und S25 Ultra ausgerollt wird. Wie üblich wird der Rollout schrittweise erfolgen und mit den Nutzern in Südkorea beginnen.

Es wird erwartet, dass das große Firmware-Update die Galaxy S25-Geräte in den Ländern erreicht, in denen das Beta-Programm verfügbar war, darunter die USA, Großbritannien, Deutschland, Frankreich und Indien. Laut Samsungs Foren ist die nächste Veröffentlichungswelle für Oktober bis November geplant, wobei der genaue Zeitpunkt noch unklar ist.

Wird Euer Galaxy-Gerät One UI 8 erhalten?

Gleichzeitig mit der Vorstellung von One UI 8 hat Samsung eine Liste der Geräte veröffentlicht, die das Update erhalten sollen.

Samsung hat außerdem bestätigt, dass das Galaxy S22 und das Galaxy S21 FE One UI 8 als letztes großes Update erhalten werden. Das Gleiche gilt für Mittelklassemodelle wie das Galaxy A73, A53 und A33, die alle im Jahr 2022 auf den Markt kamen. Neuere Geräte profitieren in der Regel von einem verlängerten Support von fünf bis sechs Jahren, was sie zu guten Kandidaten für One UI 8 macht.

Samsungs Handy-Reihen im Überblick

Samsung Galaxy A-Reihe

Samsung streicht einige Budget- und Mittelklassemodelle aus der One UI 8-Liste, da sie nur begrenzte Softwareunterstützung bieten. Dazu gehören das Galaxy A14, das Galaxy A14 5G und das Galaxy A05s.

Samsung Galaxy S-Serie

Die Flaggschiff-Modelle Galaxy S21, S21 Plus und S21 Ultra haben One UI 7 als letztes großes Update erhalten. Sie werden jedoch weiterhin Sicherheitspatches erhalten. Interessanterweise hat das Galaxy S21 FE noch Anspruch auf One UI 8, was für viele Nutzer/innen eine Überraschung war.

Samsung Galaxy Z-Serie

Das Galaxy Z Fold 3 und das Galaxy Z Flip 3 sind nicht auf der One UI 8-Update-Liste zu finden. Bei beiden Geräten endet der große Update-Zyklus mit One UI 7, auch wenn sie noch für eine begrenzte Zeit Sicherheitspatches erhalten.

Samsung Galaxy M und F Serie

| Modell | Angekündigtes Update-Datum | Beginn der Verteilung |

|---|---|---|

| Galaxy M06 / F06 | TBC | |

| Galaxie M15 / F15 | TBC | |

| Galaxie M16 / F16 | TBC | |

| Galaxie M34 5G | TBC | |

| Galaxie M35 | TBC | |

| Galaxie M36 | TBC | |

| Galaxie M54 / F54 | TBC | |

| Galaxie M55 / F55 / C55 | Oktober 2025 | |

| Galaxie M56 / F56 | Oktober 2025 |

Samsung Galaxy XCover

Als Samsungs Produktreihe für Unternehmen bietet die XCover-Familie Software-Support auf Flaggschiff-Niveau.

Samsung Galaxy Tab A und S-Serie

Die meisten Samsung Galaxy-Tablets, die für One UI 7 in Frage kommen, werden auch One UI 8 erhalten, mit Ausnahme des Galaxy Tab Active 4 Pro.

Dieser Artikel wurde im September 2025 aktualisiert, um die erste Liste der Samsung Galaxy-Handys und -Tablets zu aktualisieren, die für One UI 8 in Frage kommen.

-

UX/UI & Webdesignvor 1 Monat

UX/UI & Webdesignvor 1 MonatDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 3 Wochen

UX/UI & Webdesignvor 3 WochenAdobe Firefly Boards › PAGE online

-

Social Mediavor 1 Monat

Social Mediavor 1 MonatRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

Entwicklung & Codevor 1 Monat

Entwicklung & Codevor 1 MonatPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 3 Wochen

Entwicklung & Codevor 3 WochenEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

UX/UI & Webdesignvor 7 Tagen

UX/UI & Webdesignvor 7 TagenFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online

-

Digital Business & Startupsvor 3 Monaten

Digital Business & Startupsvor 3 Monaten10.000 Euro Tickets? Kann man machen – aber nur mit diesem Trick

-

Digital Business & Startupsvor 3 Monaten

Digital Business & Startupsvor 3 Monaten80 % günstiger dank KI – Startup vereinfacht Klinikstudien: Pitchdeck hier