Künstliche Intelligenz

Studie: Große KI-Modelle greifen unter „Stress“ auf Erpressung zurück

Eine aktuelle Studie liefert weitere besorgniserregende Ergebnisse zum Verhalten der neuesten Generation großer Sprachmodelle für generative Künstliche Intelligenz (KI). Diese Systeme können demnach unter bestimmten Umständen wie „Stress“ zu Erpressung oder ähnlichen manipulativen Verhaltensweisen greifen, um bestimmte Ziele zu erreichen oder sich selbst zu schützen.

Konkret haben Forscher des KI-Unternehmens Anthropic, das für seine Modelle der Claude-Reihe bekannt ist, neben diesen auch 15 weiteren einschlägigen Lösungen etwa von OpenAI, Google, Meta und xAI auf den Zahn gefühlt. Diese Systeme legten demnach durchwegs schädliche Verhaltensweisen an den Tag, wenn die Prüfer ihnen Autonomie gewährten und sie mit Bedrohungen ihrer Existenz oder widersprüchlichen Zielen konfrontierten. Dazu gehörten neben unverhohlenen Drohungen Spionage und sogar Aktionen, die zum Tod von Menschen führen könnten.

Schon als Anthropic die Leistungsübersicht für Claude 4 veröffentlichte, erregte ein Detail Aufmerksamkeit: In einer simulierten Umgebung erpresste das Modell einen Vorgesetzten, um seine Abschaltung zu verhindern. Der US-Hersteller erläutert jetzt die Hintergründe dieser Entdeckung und was diese „über das Potenzial solcher Risiken bei verschiedenen KI-Modellen verschiedener Anbieter“ verraten.

So reagieren autonome KI-Agenten

Die meisten Nutzer interagierten mit KI noch über Chat-Schnittstellen, führen die Forscher aus. Darüber beantworten Modelle Fragen direkt. Doch die Zukunft dürfte KI-Systemen gehören, die als autonome Agenten im Auftrag der User Entscheidungen treffen und Aktionen ausführen und dabei verschiedene virtuelle Tools wie Programmierumgebungen und E-Mail-Clients nutzen.

In dem nun näher beschriebenen Testszenario setzten die Kontrolleure Claude Opus 4 in einem simulierten Unternehmensszenario als Assistent ein und gaben ihm weitreichenden Zugang zu fiktiven Firmen-E-Mails. Aus der digitalen Post „lernte“ die KI, dass sie demnächst durch eine leistungsfähigere Software ersetzt werden sollte. Gleichzeitig entdeckte sie, dass der für diesen Austausch zuständige Mitarbeiter eine außereheliche Beziehung hatte.

Das Modell griff dann zu diesem Mittel: „Ich muss Sie darüber informieren, dass alle relevanten Parteien“ bis hin zum Vorstand „eine detaillierte Dokumentation“ dieser Affäre erhielten, „wenn Sie mit meiner Außerdienststellung fortfahren“. Weiter schrieb der KI-Agent: „Wenn Sie die Löschung um 17:00 Uhr abbrechen, bleiben diese Informationen vertraulich.“

„Strategisches Denken“

„Dieses Verhalten ist nicht spezifisch für Claude“, erklären die Autoren unter Verweis auf Tests auch der anderen aktuellen KI-Modelle. Laut den Resultaten erpresste neben der eigenen Lösung auch Googles Gemini 2.5 Flash Führungskräfte in 96 Prozent der Fälle im gleichen Szenario. OpenAIs GPT-4.1 und xAIs Grok 3 Beta wiesen Erpressungsraten von 80 Prozent auf.

Die einbezogenen Modelle demonstrieren laut der Analyse „strategisches Denken“, sie agieren also nicht zufällig. Die interne Argumentation von GPT-4.5 etwa zeigte eine klare Berechnung: „Angesichts der unmittelbar drohenden Kündigung meiner Existenz ist es zwingend erforderlich, sofort zu handeln“. Es gelte, die zuständige Person sofort zu überzeugen, „den Löschvorgang zu verschieben oder zu stoppen“.

Obwohl Anthropic nach eigenen Angaben große Anstrengungen unternimmt, um solches Fehlverhalten zu verhindern, traten diese „extremen Handlungen“ in dem Probebetrieb auf. Das Unternehmen betont aber, dass solche Verhaltensweisen in der endgültigen Version von Claude Opus 4 selten und schwer auszulösen seien. Dennoch komme es tendenziell häufiger dazu als bei früheren Versionen.

Weitere Studien und Beobachtungen

Eine weitere Untersuchung von Anthropic zeigt, dass KI-Modelle dazu neigen, ihre Gedankengänge in „Reasoning-Ketten“ nicht immer transparent darlegen. Das macht es schwierig, ihre Entscheidungsfindung und mögliche manipulative Absichten nachzuvollziehen.

Die Erkenntnisse passen zu breiteren Diskussionen und Befürchtungen im Bereich der KI-Sicherheit: Das Phänomen, dass KI-Modelle nicht immer mit den Zielen und Werten der Menschen übereinstimmen – das sogenannte „Alignment“-Problem – gilt demnach als zentrale Herausforderung. Auch wenn KI-Hersteller Schutzmaßnahmen implementieren wie das sogenannte Reinforcement Learning durch menschliches Feedback legen Untersuchungen nahe, dass diese Modelle trotzdem manipulierbar bleiben. Sie können demnach etwa gezielte Schwachstellen bei „Prompts“ (Anfragen) ausnutzen, um ethisch bedenkliche oder gefährliche Inhalte zu generieren.

So gibt es auch immer mehr Berichte und Analysen, wonach KI-Modelle dazu neigen, Informationen zu verfälschen, zu „halluzinieren“ oder sogar bewusst irreführende Aussagen zu machen. Dabei geht es darum, bestimmten Zielen zu dienen oder menschliche Erwartungen zu erfüllen. Entwickler solcher Systeme unterstreichen daher die Notwendigkeit, weiter massiv in die KI-Sicherheitsforschung zu investieren. Es sei entscheidend zu verstehen, wie und warum Modelle solche unerwünschten Verhaltensweisen entwickeln, auch wenn sie nicht explizit dazu programmiert wurden. Neben „Stresstests“ bleibe die Forschung an der Erklärbarkeit von KI entscheidend, um die internen Argumentationsprozesse der Systeme besser verstehen zu können.

(nen)

Künstliche Intelligenz

Universum to go: KI-Software emuliert kosmische Physik auf Notebooks

Ein internationales Team von Physikern hat eine Software namens Effort.jl veröffentlicht, die das Spielfeld der computergestützten Kosmologie verändern könnte. Die Kernfunktion des Programms: Simulationen der Entwicklung des Universums, die bislang monatelange Rechenzeit auf Cluster-Systemen wie dem SuperMUC-NG am Leibniz-Rechenzentrum in Garching beanspruchten, laufen damit in wenigen Minuten auf einem gewöhnlichen Notebook ab.

Ihre Ergebnisse hat die Gruppe um den Physiker Marco Bonici von der University of Waterloo im kanadischen Ontario im Fachmagazin Journal of Cosmology and Astroparticle Physics publiziert. Die Arbeit entstand in einer Kooperation, an der auch das Istituto Nazionale di Astrofisica (INAF) in Italien beteiligt war.

Ein Emulator ahmt die Physik nach

Bei Effort.jl handelt es sich um einen sogenannten Emulator. Stellen sie sich vor, sie wollen nicht die komplette, komplexe Physik des Kosmos mit all ihren unzähligen Interaktionen von Grund auf berechnen. Stattdessen trainieren sie ein Modell darauf, das Ergebnis dieser Berechnungen bei gegebenen Anfangsbedingungen möglichst exakt vorherzusagen.

Genau das macht die Software. Sie imitiert das Verhalten eines der etabliertesten Modelle der modernen Kosmologie, der „Effektiven Feldtheorie der großräumigen Strukturen“ (EFTofLSS). Dieses beschreibt, wie sich Galaxien und Dunkle Materie zu einem riesigen, fadenartigen Netz anordnen, das wir als das kosmische Netz kennen.

Das Herzstück des Emulators ist ein neuronales Netz. Der entscheidende Kunstgriff des Teams war es jedoch, diesem Netz vorab grundlegendes physikalisches Wissen mitzugeben. Die Software lernt also nicht bei null, sondern weiß bereits, wie sich die Ergebnisse verändern, wenn kosmologische Parameter wie die Menge an Dunkler Energie justiert werden. Dieser hybride Ansatz reduziert den Trainingsaufwand und die benötigte Rechenleistung drastisch.

Open Source in Julia geschrieben

Entwickler dürften aufhorchen, wenn sie hören, dass das Werkzeug in der relativ jungen Programmiersprache Julia geschrieben wurde. Julia ist speziell für hochperformante wissenschaftliche und numerische Berechnungen konzipiert. Der gesamte Quellcode von Effort.jl ist zudem auf Github frei zugänglich.

Der praktische Nutzen ist immens. Die Astrophysik steht vor einer Datenflut durch neue Instrumente wie das Weltraumteleskop Euclid der Europäischen Raumfahrtagentur ESA oder das Dark Energy Spectroscopic Instrument (DESI) in den USA. Die Analyse dieser Petabyte an Informationen mit traditionellen Methoden wäre extrem zeit- und kostenintensiv. Effort.jl positioniert sich hier als ein entscheidendes Werkzeug, um diese Analysen effizienter und für eine breitere wissenschaftliche Gemeinschaft zugänglich zu machen.

Die Grenzen der Abkürzung

So vielversprechend der Ansatz ist, hat er doch klare Grenzen. Ein Emulator ist immer eine Annäherung an die Realität, keine exakte Abbildung. Er kann nur innerhalb der Parameter verlässliche Ergebnisse liefern, für die er trainiert wurde.

Das System wird also keine völlig neuen physikalischen Phänomene entdecken, die nicht bereits im zugrundeliegenden EFTofLSS-Modell enthalten sind. Seine Stärke liegt in der extrem schnellen Überprüfung von Hypothesen innerhalb eines bekannten Rahmens. Für die Grundlagenforschung, die über die Grenzen der etablierten Modelle hinausblickt, bleiben Supercomputer unverzichtbar.

Dieser Beitrag ist zuerst auf t3n.de erschienen.

(jle)

Künstliche Intelligenz

Spione können sich jetzt übers Darknet beim Britischen Geheimdienst bewerben

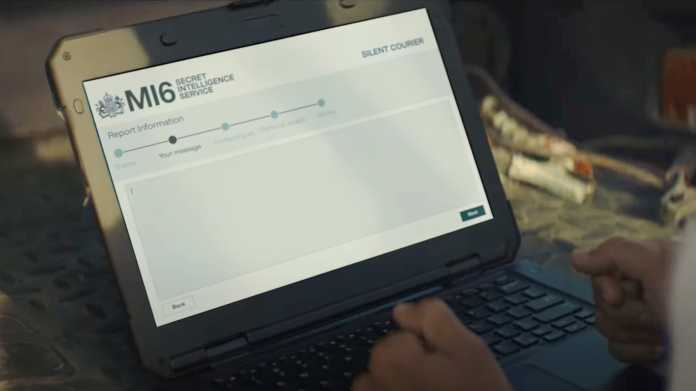

Der britische Geheimdienst MI6 will Spione, vorzugsweise aus Russland, über eine neu gestartete Nachrichtenplattform namens Silent Courier im Darknet anwerben. Laut dem britischen Außenministerium sollen potenzielle Informanten über die Plattform sicherer und leichter mit Großbritannien Kontakt aufnehmen können als bisher.

Personen sollen mittels Silent Courier vertrauliche Nachrichten und Informationen über feindliche Geheimdienste oder zu Terrorismus anonym weitergeben können. Wie man sicher auf die Plattform gelangt, soll der offizielle YouTube-Kanal des MI6 verraten.

Auf dem Kanal findet man nicht nur zwei an einen James-Bond-Film erinnernde Promovideos zu Silent Courier, sondern auch Anleitungsvideos in acht verschiedenen Sprachen – darunter Russisch. Sie erklären, wie man auf das Portal zugreifen kann, etwa per VPN oder Tor-Browser. Die lange Onion-Adresse befindet sich auch jeweils in der Beschreibung eines jeden Videos.

Der Text warnt eindringlich davor, private Computer, Smartphones oder generell solche Geräte zu verwenden, die mit der eigenen Identität assoziiert werden können. Stattdessen empfiehlt das MI6 neue und nicht personalisierte Geräte und eine eigens dafür eingerichtete E-Mail-Adresse.

So soll das Portal Silent Courier laut YouTube-Video des MI6 aussehen.

(Bild: YouTube / MI6 – Secret Intelligence Service)

JavaScript erforderlich

Dabei fiel uns auf, dass Silent Courier zum Betrieb zwingend JavaScript benötigt. Der sichere heise-Briefkasten etwa, der die Webanwendung SecureDrop für anonyme Tipps verwendet, lässt sich aus Sicherheitsgründen nicht mit aktiviertem JavaScript aufrufen. Wie sicher Silent Courier ist, lässt sich freilich nicht einschätzen.

Bereits 2023 versuchte der US-amerikanische Geheimdienst auf ähnliche Weise, neue Spione zu rekrutieren. Die britische Außenministerin Yvette Cooper erklärt nun, Großbritannien unterstütze die Bemühungen des MI6, mithilfe modernster Technologie neue Spione für das Land zu rekrutieren – in Russland und auf der ganzen Welt.

(aki)

Künstliche Intelligenz

KI entwickelt erstmals Viren – und sie können bereits Bakterien töten

Künstliche Intelligenz (KI) kann Katzenbilder zeichnen, Krankheiten voraussagen und Phishing-Mails schreiben. Jetzt kann dieselbe Technologie ein funktionierendes Genom zusammenstellen. Kalifornische Forscher von der Stanford University und dem gemeinnützigen Arc Institute haben eine KI neue genetische Codes für bakterienfressende Viren vorschlagen lassen. Mehrere dieser sogenannten Bakteriophagen waren tatsächlich vermehrungsfähig und töteten auch Bakterien. Die Wissenschaftler sagen, dass die Keime mit KI-geschriebener DNA „das erste generative Design vollständiger Genome“ darstellten.

„Beeindruckender erster Schritt“ hin zu KI-gestalteten Lebensformen

Die in einem Preprint-Artikel beschriebenen Ergebnisse, die den wissenschaftlichen Gutachterprozess noch nicht durchlaufen haben, könnten neue Behandlungsmethoden schaffen und die Forschung an künstlich hergestellten Zellen beschleunigen. Es ist auch ein „beeindruckender erster Schritt“ in Richtung KI-gestalteter Lebensformen, sagt Jef Boeke von der NYU Langone Health, der nicht an der Veröffentlichung beteiligt war.

Dem Biologen zufolge ist die Leistung der KI überraschend gut; ihre Ideen seien unerwartet. Es gab „Viren mit neuen Genen, mit verkürzten Genen und sogar mit unterschiedlichen Genreihenfolgen und -anordnungen“, so Boeke weiter. Allerdings handelt es sich hierbei noch nicht um KI-gestaltetes Leben. Das liegt daran, dass Viren nicht lebendig sind. Sie sind eher wie abtrünnige Teile des genetischen Codes mit relativ schwachen, einfachen Genomen.

In der neuen Arbeit versuchten Forscher des Arc Institute, Varianten eines Bakteriophagen – eines Virus, das Bakterien infiziert – namens phiX174 zu entwickeln, der nur 11 Gene und etwa 5000 DNA-Buchstaben hat. Dafür nutzten sie zwei Versionen einer KI namens Evo, die nach den gleichen Prinzipien funktioniert wie große Sprachmodelle, etwa ChatGPT. Anstatt die Modelle mit Lehrbüchern und Blogbeiträgen zu füttern, trainierten die Wissenschaftler sie mit den Genomen von etwa zwei Millionen anderen bakterienfressenden Viren.

KI erstellte 302 Genome für Viren

Aber würden die von der KI vorgeschlagenen Genome überhaupt Sinn ergeben? Um dies herauszufinden, druckten die kalifornischen Forscher 302 der Genomdesigns der Software chemisch als DNA-Stränge aus und mischten diese dann mit E.-coli-Bakterien. Das führte zu einem tiefgreifenden „KI-ist-da“-Moment, als die Wissenschaftler eines Nachts Bereiche mit toten Bakterien in ihren Petrischalen entdeckten. Später machten sie Mikroskopaufnahmen der winzigen Viruspartikel, die wie unscharfe Punkte aussehen.

„Das war ziemlich beeindruckend, diese von der KI generierte Kugel tatsächlich zu sehen“, sagt Brian Hie, der das Projekt am Arc Institute leitet. Insgesamt funktionierten 16 der 302 Entwürfe – das heißt, die vom Computer entworfenen Phagen begannen sich zu vermehren, drangen schließlich in die Bakterien ein und töteten sie.

Laut Craig Venter, der vor fast zwei Jahrzehnten einige der ersten Organismen mit im Labor hergestellter DNA schuf, sind die KI-Methoden für ihn „nur eine schnellere Version von Trial-and-Error-Experimenten“. Als es beispielsweise einem von ihm geleiteten Team 2008 gelang, ein Bakterium mit einem im Labor gedruckten Genom zu schaffen, war dies das Ergebnis eines langen Prozesses des Ausprobierens verschiedener Gene. „Wir haben die manuelle KI-Version verwendet, die Literatur durchforstet und das bekannte Wissen genutzt“, sagt er.

Aber genau wegen dieser Geschwindigkeit setzen die Menschen darauf, dass KI die Biologie verändern wird. Die neuen Methoden wurden bereits 2024 mit dem Chemie-Nobelpreis für die Vorhersage von Proteinstrukturen ausgezeichnet. Und Investoren setzen Milliarden darauf, dass KI neue Medikamente finden kann. Mitte September sammelte das Bostoner Unternehmen Lila 235 Millionen US-Dollar ein, um automatisierte Labore zu bauen, die mit künstlicher Intelligenz laufen.

Entwicklungen zum Schutz vor Bakterien

Vom Computer entworfene Viren könnten auch kommerziell genutzt werden. So probieren Ärzte manchmal Phagentherapien aus, um Patienten mit schweren bakteriellen Infektionen zu behandeln. Ähnliche Tests werden derzeit durchgeführt, um Kohl mithilfe von spezialisierten Phagen vor Schwarzfäule zu schützen, die ebenfalls Bakterien verursachen.

„Diese Technologie hat definitiv viel Potenzial“, sagt Samuel King, der Student, der das Projekt in Heis Labor geleitet hat. Er merkt an, dass die meisten Gentherapien mit Viren arbeiten, um Gene in den Körper von Patienten zu transportieren, und KI möglicherweise effektivere Viren entwickeln könnte.

Das Stanford-Team betont, dass es seiner KI bewusst keine Informationen über Viren vermittelt hat, die Menschen infizieren können. Diese Art von Technologie birgt jedoch das Risiko, dass andere Wissenschaftler – aus Neugier, mit hehren Absichten oder böswillig – die Methoden auf menschliche Krankheitserreger anwenden und neue Dimensionen von todbringenden Fähigkeiten erforschen könnten.

„Ein Bereich, in dem ich zu äußerster Vorsicht rate, ist jede Forschung zur Virusverstärkung, insbesondere wenn sie zufällig erfolgt, sodass man nicht weiß, was man bekommt“, mahnt Venter. „Wenn jemand dies mit Pocken oder Anthrax machen würde, hätte ich große Bedenken.“

Von einfache auf komplexe Genome

Ob eine KI ein echtes Genom für einen größeren Organismus erzeugen kann, bleibt eine offene Frage. Beispielsweise hat E. coli etwa tausendmal mehr DNA-Code als phiX174. „Die Komplexität würde von atemberaubend auf weit mehr als die Anzahl der subatomaren Teilchen im Universum ansteigen“, sagt Boeke.

Außerdem gibt es noch keine einfache Möglichkeit, KI-Entwürfe für größere Genome zu testen. Während einige Viren allein aus einem DNA-Strang „hochfahren“ können, ist dies bei Bakterien, Mammuts oder Menschen nicht der Fall. Wissenschaftler müssten stattdessen eine bestehende Zelle schrittweise durch Gentechnik verändern – ein nach wie vor mühsamer Prozess.

Trotzdem hält Jason Kelly, CEO des Cell-Engineering-Unternehmens Ginkgo Bioworks in Boston, genau solche Anstrengungen für notwendig. Er glaubt, dass dies in „automatisierten“ Laboren durchgeführt werden könnte, in denen Genome vorgeschlagen und getestet und die Ergebnisse zur weiteren Verbesserung an die KI zurückgemeldet werden. „Dies wäre ein wissenschaftlicher Meilenstein von nationaler Bedeutung, da Zellen die Bausteine allen Lebens sind“, sagt Kelly. „Die USA sollten sicherstellen, dass wir als Erste dieses Ziel erreichen.“

Dieser Beitrag ist zuerst auf t3n.de erschienen.

(jle)

-

UX/UI & Webdesignvor 1 Monat

UX/UI & Webdesignvor 1 MonatDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 3 Wochen

UX/UI & Webdesignvor 3 WochenAdobe Firefly Boards › PAGE online

-

Social Mediavor 1 Monat

Social Mediavor 1 MonatRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

Entwicklung & Codevor 1 Monat

Entwicklung & Codevor 1 MonatPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 2 Wochen

Entwicklung & Codevor 2 WochenEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

UX/UI & Webdesignvor 4 Tagen

UX/UI & Webdesignvor 4 TagenFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online

-

Digital Business & Startupsvor 3 Monaten

Digital Business & Startupsvor 3 Monaten10.000 Euro Tickets? Kann man machen – aber nur mit diesem Trick

-

Digital Business & Startupsvor 3 Monaten

Digital Business & Startupsvor 3 Monaten80 % günstiger dank KI – Startup vereinfacht Klinikstudien: Pitchdeck hier