Künstliche Intelligenz

Vollwertiger Mini-PC in Handflächengröße mit Intel N100: Aoostar T8 im Test

Der Aoostar T8 gehört zu den kleinsten Mini-PCs überhaupt und bietet eine überraschend gute und umfangreiche Ausstattung. Wie er sich schlägt, zeigt sich im Test.

Obwohl Mini-PCs an sich bereits kompakter sind als klassische Desktop-Rechner oder Laptops, schafft es der Aoostar T8 selbst in diesem Segment das noch zu unterbieten: Das kompakte Gehäuse füllt gerade mal eine Handfläche aus. Dennoch bietet der Mini-Computer eine erstaunlich gute Ausstattung und setzt etwa beim Prozessor auf den Klassiker der Office-Rechner – einen Intel N100.

Die weitere Ausstattung mit 12 GB Arbeitsspeicher (RAM) sowie 256 bis 512 GB SSD-Speicher ist überraschend solide. Nicht zu verwechseln ist er mit seinem minimal größeren, ebenfalls mit N100 ausgestatteten Bruder T8 Plus (Testbericht), den wir ebenfalls getestet haben. Ob auch der kleine T8 in der Praxis überzeugt oder sich der ultrakompakte Formfaktor als Nachteil erweist, zeigen wir im Test. Das Testgerät hat uns Geekbuying zur Verfügung gestellt.

Ausstattung: Welche Hardware bietet der Aoostar T8?

Geht es darum, welcher Prozessor in Mini-PCs bis 200 Euro zum Einsatz kommt, ist die Antwort fast so logisch wie ein Amen im Gebet – und sogar halbwegs erfreulich. Abgesehen von ein paar Ausreißern ist die Standardwahl fast immer der Intel N100, von dem auch der Aoostar T8 Gebrauch macht. Dieser Budget-Klassiker glänzt insbesondere durch seine hohe Effizienz bei einer TDP (thermischen Verlustleistung) von nur 6 Watt. Auch wenn er in gewisser Weise „kastriert“ ist – etwa bei den RAM-Speicherkanälen – so ist er für normale Office-Aufgaben mehr als ausreichend und bringt einen halbwegs performant durch den Alltag.

Ganz anders als die Zeiten der Celeron-Prozessoren, die geradezu körperliche Schmerzen bereiteten, ist der N100 ein solider und vor allem sparsamer Chip, mit dem man leben kann. Die im Januar 2023 vorgestellte CPU setzt auf eine Konfiguration aus vier Crestmont-Effizenz-Kernen bei vier Threads (also kein Hyperthreading) und taktet mit 1,8 bis 3,4 GHz. Er ist Teil der Alder-Lake-N-Reihe und im Intel-7-Prozess mit 10 nm gefertigt. Seine maximale Betriebstemperatur liegt bei 105 Grad. Als Grafikeinheit kommt eine Intel UHD Graphics 24EUs (Ausführungseinheiten; Englisch: Execution Units) zum Einsatz, die mit maximal 750 MHz taktet.

Der Nachteil der Alder-Lake-N-Reihe ist die kastrierte Speicheranbindung. So unterstützt der Intel N100 nur einen einzigen Speicherkanal mit maximal 16 GB. Immerhin kann er neben DDR4-RAM auch mit DDR5-RAM umgehen, wie ihn auch der Aoostar T8 einsetzt. Hier kommt fest verlöteter LPDDR5-RAM mit 12 GB und 4800 MT/s zum Einsatz, der Arbeitsspeicher kann also nicht getauscht werden. Das ist schade und ein Nachteil gegenüber anderen Mini-PCs, hier aber nachvollziehbar und der Größe geschuldet – ein klassischer SODIMM-RAM-Stick wäre bereits breiter als das gesamte Gehäuse des T8. Schön wäre zudem gewesen, wenn der Rechner die 16 GB voll ausgereizt hätte, 12 GB sind aber ein guter Kompromiss, um Geld zu sparen und nicht zu viel Leistung aufs Spiel zu setzen.

Beim Speicher setzt das System auf eine M.2-SSD im Formfaktor 2242 mit 256 GB oder 512 GB. Diese kommt vom Hersteller Shiji und schreibt im Falle des 512-GB-Modells ausweislich Crystaldiskmark mit 488 MB/s und liest mit 508 MB/s. Für ein SATA-Modell sind das solide Werte und in jedem Fall ist es schneller als eMMC-Flash-Speicher.

Bei den Anschlüssen hagelt es Überraschungen: Nicht nur gibt es trotz der geringen Gehäusegröße vier USB-A-Buchsen, davon zwei USB 2.0 und zwei USB 3.0, sondern auch noch HDMI sowie satte zwei LAN-Buchsen. On top verwendet der Aoostar T8 für die Stromversorgung einen USB-C-Port, der allerdings nicht nur Strom aufnehmen kann, sondern auch Bild und Daten übertragen kann.

Für drahtlose Verbindungen unterstützt der PC Wifi 5 und Bluetooth 4.2, was inzwischen deutlich veraltete Standards sind, die im Preisbereich bis 200 Euro allerdings noch immer häufig eingesetzt werden – irgendwo muss man eben sparen. Zum Einsatz kommt der Chipsatz Realtek RTL8168/8111.

Performance: Wie schnell ist der Aoostar T8?

Bei der Performance übertrifft das System unsere Erwartungen trotz des kompakten Gehäuses und den damit möglicherweise einhergehenden Problemen bei der Kühlung. Bei PCmark 10 erreicht der Aoostar T8 im Schnitt 3201 Punkte, mit Spitzen bei 3214 und 3189 Punkten. Das ist fast schon überdurchschnittlich für den Intel N100. Das Ergebnis von 3Dmark Time Spy ist mit 325 Punkten hingegen ein Stück hinter den Konkurrenz-Geräten mit gleicher CPU. Hier lohnt sich der Blick auf die Werte im Detail, denn der CPU-Score alleine liegt bei starken 2287 Punkten, was mit Abstand über der Konkurrenz ist.

Beim Grafik-Test hingegen schneidet er mit 283 Punkten deutlich schwächer ab, was den insgesamt niedrigeren Score trotz des starken CPU-Ergebnisses erklärt. Hintergrund könnte etwa der knapp bemessene RAM sein.

Die starke Performance der CPU bestätigt auch den Benchmark Cinebench 2024, wo es im Multi-Core 184 Punkte und im Single-Core 59 Punkte gibt. Insbesondere der Multi-Core-Score fällt hier auf, der Single-Core-Wert ist etwas niedriger als bei vergleichbaren Systemen. Auch im Cross-Plattform-Benchmark Geekbench 6 zeigt der T8 ein starkes Ergebnis mit 1186 Punkten im Single Core und 2992 im Multi-Core. Beides sind bessere Ergebnisse als die beim kürzlich getesteten Ninkear N10.

Aufgrund der hier verwendeten Hardware ist an Gaming nicht zu denken. Der Fokus des Systems liegt im leisen und sparsamen Office-Betrieb, insofern unterlassen wir den Feldversuch mit Spielen.

Aoostar T8 – Bilderstrecke

Software: Mit welchen Betriebssystemen arbeitet der Aoostar T8?

Der Aoostar T8 kommt mit Windows 11 Pro in der Version 23H2, entsprechend ist das langwierige Update auf 24H2 notwendig. Zusätzliche Bloatware ist nicht vorinstalliert, unser vollständiger Virentest mit Windows Defender findet keine Auffälligkeiten.

Auch der Betrieb von Linux ist möglich, wir haben das System mit dem auf Ubuntu basierenden Tuxedo OS ausprobiert. Dazu muss man zunächst die Bootreihenfolge im BIOS ändern, die sich via F7-Taste oder über die erweiterten Wiederherstellungsoptionen von Windows abrufen lässt. Secure Boot ist bereits ab Werk deaktiviert und macht insofern keine Probleme. Nach Auswahl des USB-Sticks als Bootmedium bootet das System in Tuxedo OS, das wir nach kurzer Einrichtung nutzen können. Dabei funktionieren WLAN, Bluetooth und Audio ordnungsgemäß und auch die Bildschirmauflösung wird richtig erkannt. Das Aufwecken aus dem Standby-Modus gelingt ebenfalls, was nicht erwartbar ist – einige Mini-PCs haben hier Probleme mit Linux.

Lüfter: Wie laut ist der Aoostar T8?

Der Lüfter des Aoostar T8 ist eine echte Besonderheit, denn es ist der erste in einem Mini-PC, den wir testen, wo man die Drehzahl softwareseitig frei einstellen kann. Das klappt in unserem Fall mit dem kostenlosen Tool Fancontrol, wo wir nach kurzem Selbsttest per Schieberegler oder Prozenteingabe die Geschwindigkeit des Gehäuselüfters verstellen können. Bei den meisten anderen Mini-PCs ist das nicht möglich, die Software hat hier keinen Zugriff auf den Lüfter.

Im automatischen Betrieb ist der Lüfter größtenteils nur minimal hörbar, im normalen Alltagsbetrieb sind es in der Regel nur 34 dB(A) am Gehäuse. Unter Last dreht das System dann aber auch auf 38 dB(A) am Gehäuse oder 27 dB(A) aus einem Meter Entfernung auf. Stellen wir den Lüfter manuell auf hundert Prozent, erreicht er sogar 42 dB(A). Das ist nicht gerade leise, bei dieser Kompaktheit hatten wir aber deutlich Schlimmeres befürchtet, zudem das System grundsätzlich angenehm leise arbeitet. Die maximal erreichte Temperatur des CPU-Package während eines Aida64-Stresstests liegt bei 83 Grad, die Taktrate pendelt sich bei 2,5 bis 2,6 GHz ein.

Der Verbrauch des Systems liegt bei ruhendem Desktop bei 12 Watt, bei Verwendung einzelner Anwendungen, wie dem Browser, bei bis zu 20 Watt. Unter Volllast steigt er zunächst auf 29 Watt an und pendelt sich dann bei 26 Watt ein. Damit ist der Betrieb auch mit 30 Watt starken GaN-Netzteilen möglich.

Bauform: Wie ist die Verarbeitung des Aoostar T8?

Die Verarbeitung des Aoostar T8 ist für einen Preis von etwa 200 Euro absolut tadellos und hochwertig. Während ein kleiner Teil des Mini-PCs aus weißem Kunststoff besteht, sind ringsum um die Anschlüsse sowie im Deckel Teile aus Aluminium eingesetzt, die die Wertigkeit deutlich steigern. Nichts knarzt oder wirkt deplatziert – eine richtig gute Verarbeitungsqualität. Die Maße des Gehäuses betragen 7,3 × 7,3 × 4,3 cm, das Gewicht liegt bei lediglich 190 g.

Auch die Gehäuseöffnung gelingt gut, trotz des kleinen Formfaktors sind die Bauteile schnell erreichbar. Dazu gehören SSD, Netzwerkkarte sowie die CMOS-Batterie. Sie erreicht man, indem man den Kunststoffdeckel auf der Unterseite nach dem Lösen von vier Schrauben abnimmt. Das geht sehr einfach, der Deckel muss nicht noch umständlich aufgehebelt werden, sondern kommt einem freiwillig entgegen. Aufpassen muss man mit dem nur lose eingelegten Ein-/Aus-Knopf, den man entsprechend schnell verlieren kann. Nach dem Abnehmen des Deckels muss man noch den Aluminiumring von den Anschlüssen streifen. Anschließend findet man die Hardware auf zwei übereinander geschraubten Platinen vor, die man voneinander lösen kann. SSD und WLAN-Karte finden sich dabei auf der unteren Seite, sind aber zusätzlich von einer Metallabdeckung geschützt, die man erst abnehmen muss.

Preis: Was kostet der Aoostar T8?

Der Aoostar T8 ist aktuell noch in der Ausstattungsvariante mit 12/256 GB bei Geekbuying für 200 Euro verfügbar.

Wer bei einem chinesischen Händler kauft, bezahlt in vielen Fällen weniger. Allerdings besteht im Gewährleistungs- oder Garantiefall die Gefahr eines schlechteren Service. Außerdem ist das Einfordern von Verbraucherrechten (Rückgabe, Gewährleistung) mit Hürden versehen oder nicht möglich. Wir verlinken hier Händler, mit denen wir im Allgemeinen gute Erfahrungen gemacht haben.

Fazit

Der Aoostar T8 kann trotz seiner geringen Größe im Test überzeugen. Klar, wir reden hier nur von einem Intel N100 und damit dem absoluten Einstieg, doch das System ist dennoch performant für Office-Aufgaben. Im Test wurde die Verwendung nie zur Qual.

Das haben wir bei vergleichbar kompakten Systemen schon anders erlebt, wo unsere Benchmark-Durchläufe neue Tiefstwerte erreichten. Nicht so hier. Zudem weiß auch die Anschlussausstattung mit zahlreichen Anschlüssen zu überzeugen, darunter auch ein vollwertiger USB-C-Port, der Bildausgabe und Stromeingang zum Betrieb des Mini-PCs vereint. Die 12 GB RAM sorgen zwar nicht für Luftsprünge, sind aber ausreichend und ein deutlicher Unterschied zu lediglich 8 GB RAM oder noch weniger – wie es früher in der günstigen Preisklasse üblich war. Auch mit übermäßiger Hitze oder einer überforderten und entsprechend lauten Kühlung muss das System nicht kämpfen.

Die SSD arbeitet zwar nur nach SATA-Geschwindigkeit, was bis 200 Euro aber noch häufig der Fall ist. Insofern können wir den Aoostar T8 klar empfehlen und bis auf den fest verlöteten RAM hat die geringe Größe gewissermaßen keine Nachteile. Daher gibt es im Test von uns viereinhalb Sterne.

Künstliche Intelligenz

WhatsApps neue Warnung bei Gruppenchat-Einladungen soll Scams eindämmen

WhatsApp will mit einer neuen Funktion mögliche Betrugsversuche innerhalb dieses Messengers bekämpfen. Bei Einladungen zu Gruppenchats von Personen, die nicht in der eigenen Kontaktliste stehen, wird künftig eine „Sicherheitsübersicht“ mit Informationen zu dieser Gruppe eingeblendet. Damit sollen Nutzer eventuelle Scams schneller erkennen können. Diese Funktion ist Teil einer Kampagne von WhatsApp-Betreiber Meta Platforms gegen kriminelle Scammer, die verschiedene Plattformen nutzen, um gutgläubige Menschen zu betrügen.

Bereits vor wenigen Monaten hat WhatsApp neue Funktionen für Gruppenchats und Videoanrufe vorgestellt. Dadurch können Anwender etwa auf einen Blick erkennen, wie viele Personen gerade in einem Gruppenchat online sind, was auf die Aktivität der Gruppe schließen lässt. Schon seit dem letzten Jahr zeigt WhatsApp eine kurze Übersicht in Form einer sogenannten Kontextkarte nach Gruppenchat-Einladungen unbekannter Personen, die es erlaubt, die Gruppe sofort zu verlassen.

Sicherheitsübersicht zur Scam-Erkennung

Die neue Sicherheitsübersicht geht einen Schritt über diese Kontextkarte hinaus. Jetzt zeigt die Meldung nicht nur den Namen des Gruppenchats, wann diese angelegt wurde und wer zu diesem Gruppenchat eingeladen hat, sondern auch, wie viele Teilnehmer es gibt und ob darunter eigene Kontakte sind. Zudem gibt es Hinweise auf Scam-Beispiele und Sicherheitseinstellungen. Der Nutzer kann die Gruppe daraufhin – wie bei der Kontextkarte – sofort verlassen, ohne den Chat zu betreten, oder jetzt auch zunächst einen Blick darauf werfen. Benachrichtigungen dieses Gruppenchats werden aber erst angezeigt, wenn die Teilnahme daran manuell bestätigt ist.

WhatsApp-Sicherheitsübersicht bei Gruppenchat-Einladungen

(Bild: Meta Platforms)

Im Rahmen der Kampagne gegen Scam hat Meta im ersten Halbjahr bereits mehr als 6,8 Millionen WhatsApp-Konten gelöscht, die mit kriminellen Scam-Zentren in Verbindung standen, heißt es im eigenen Blog. Diese vorwiegend in Südostasien zu findenden Scam-Zentren nutzen zumeist mehrere Plattformen, um automatischer Entdeckung zu entgehen. Es beginnt oft mit Textnachrichten oder innerhalb einer Dating-App und wechselt in soziale Netzwerke, dann zu privaten Messenger-Diensten und schließlich zu Bezahl- oder Kryptoplattformen.

Gemeinsam mit OpenAI gegen Scam

Als Beispiel führt WhatsApp das gemeinsame Vorgehen mit OpenAI gegen Betrugsversuche durch ein kriminelles Scam-Zentrum in Kambodscha an. Die Scammer haben laut OpenAI-Bericht ChatGPT für die ersten Textnachrichten genutzt, die einen Link zu einem WhatsApp-Chat enthalten. Daraufhin wurden die Opfer zum Telegram-Messenger geleitet, wo sie beauftragt wurden, TikTok-Videos anzuklicken und zu liken. Dafür sollten die Menschen bezahlt werden. Die Betrüger zeigten den Opfern auch die Einnahmen, die sie hypothetisch bereits verdient hätten, bevor sie als nächste Aufgabe in ein Kryptowährungskonto einzahlen sollten.

Solche Machenschaften möchte WhatsApp mit der neuen Sicherheitsübersicht eindämmen. Die Funktion wird jetzt weltweit ausgerollt.

(fds)

Künstliche Intelligenz

Elektronische Patientenakte: Transparenz stärkt Vertrauen, Realitätscheck nötig

Datenschutzinformationen in patientenfreundlicher Sprache erhöhen die Bereitschaft, medizinische Daten in die elektronische Patientenakte (ePA) hochzuladen. Das zeigt eine neue Studie der Technischen Universität Berlin.

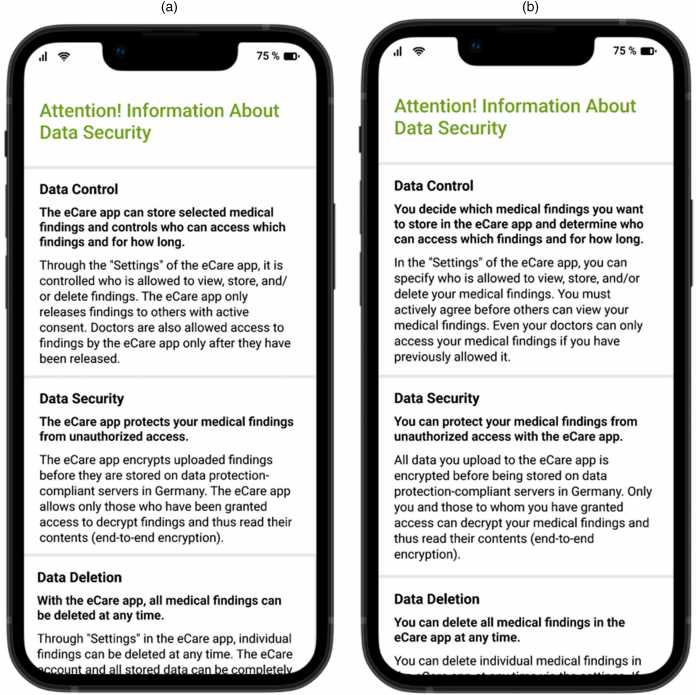

Datenschutzhinweise, die in der Studie verwendet wurden – mit der technikzentrierten Formulierung (links) und der patientenzentrierter Formulierung (rechts). Für die Veröffentlichung der Studie wurde das Material in englische Sprache übersetzt.

(Bild: Kalkreuth et al.)

In der Studie, an der 227 Probanden teilnahmen, wurden verschiedene Varianten sogenannter Privacy Fact Sheets (PFS), also kompakte Datenschutz-Infoblätter, getestet. Heraus kam dabei: Wer vor dem Upload medizinischer Befunde ein PFS mit einer patientenzentrierten Formulierung – bei Patienten direkter angesprochen wurden – sah, war viermal so häufig bereit, die sensiblen Daten in der ePA zu speichern. Bei einem systemzentrierten Text – bei dem hingegen die Patientenakte im Mittelpunkt steht – waren die Probanden hingegen deutlich zurückhaltender. Ob das Infoblatt kurz oder lang war, spielte hingegen keine Rolle.

Entscheidend ist laut Studie, dass Nutzer das Gefühl bekommen, selbst Kontrolle über ihre Daten zu haben. Demnach scheint „für die Entscheidung, Gesundheitsdaten in die elektronische Patientenakte hochzuladen, die wahrgenommene Kontrolle der Nutzer über ihre Daten entscheidend zu sein, die durch eine patientenzentrierte Gestaltung der Datenschutzrichtlinien maximiert wurde“. „Viele Menschen wollen ihre Gesundheitsdaten eigentlich sinnvoll nutzen, haben aber Angst vor Kontrollverlust. Unsere Studie zeigt, dass dieses Gefühl durch eine einfache Intervention vermieden werden kann und sie sich dadurch sicherer fühlen“, erklärt Niklas von Kalckreuth. Datenschutzhinweise direkt in der App – statt in schwer verständlichen AGB – könnten helfen, die Akzeptanz digitaler Gesundheitsanwendungen zu steigern.

Wirklichkeit hinkt hinterher

In der Realität ist es jedoch anders. Verbraucherschützer kritisierten zum Start der ePA fehlende Datenschutzmöglichkeiten und nicht ausreichende Informationen über die elektronische Patientenakte – vor allem nicht über die Risiken. Datenschützer warnten zudem davor, dass Versicherte nicht wissen, was mit der Patientenakte auf sie zukommt. Beispielsweise war vielen nicht klar, welche Auswirkungen der Paradigmenwechsel hat: Jeder erhält sie automatisch, es sei denn, er widerspricht – zuvor war es andersherum der Fall. Gleiches gilt für die geplante Ausleitung der Daten an das Forschungsdatenzentrum Gesundheit. Seit Jahren macht der CCC auf Sicherheitslücken bei der elektronischen Patientenakte aufmerksam, zuletzt auch bei Version 3.0 der elektronischen Patientenakte.

Darüber hinaus gibt es noch weitere Unzulänglichkeiten der ePA, die das Vertrauen der Nutzer nicht gerade wachsen lassen. Patienten können nicht individuell steuern, welche Daten für welchen Arzt sichtbar sind. Mit dem neuesten Update sollen Versicherte immerhin entscheiden können, welche Ärzte alle Medikationsinformationen des digital gestützten Medikationsprozesses sehen können. Bisher war die Medikationsliste entweder für alle oder keine Einrichtung sichtbar oder verborgen. Ähnlich verhält es sich nach wie vor mit den übrigen Informationen in der ePA. Ein Arzt sieht entweder die gesamte Akte oder keine Daten. Außerdem ist die ePA weder nutzerfreundlich noch barrierefrei.

Störungen und Fehler

Schon vor dem offiziellen Start der „ePA für alle“ warnten Hersteller, dass das System nicht ausreichend getestet sei. Dennoch wurde sie – auf politischen Druck – mit großem Werbeaufwand eingeführt. Immer wieder kommt es zu Verzögerungen, unausgereifte Versionen werden veröffentlicht, Störungen und technische Fehler sind an der Tagesordnung. Die Telematikinfrastruktur, das digitale Rückgrat der ePA, kämpft seit Jahren mit Verfügbarkeitsproblemen.

Im Oktober wird die ePA für Ärzte zur Pflicht, bisher sind aber immer noch nicht alle Praxen gerüstet, nach wie vor treten Fehler auf. So kann es beispielsweise sein, dass Akten als nicht angelegt angezeigt werden, obwohl sie es sind und der Versicherte nicht widersprochen hat. Auch gab es Fälle, in denen Widersprüche technisch nicht korrekt verarbeitet wurden, was inzwischen nicht mehr der Fall ist.

Verunsicherung bei Ärzten

Für Verunsicherung bei Ärzten sorgte jüngst eine Datenschutzpanne beim Praxisverwaltungssystem T2med. Dort kam es in einer Praxis dazu, dass eArztbriefe versehentlich falschen Patientenakten zugeordnet wurden. Laut Hersteller ist das Problem inzwischen behoben, die Praxen wurden informiert und ein Update bereitgestellt.

Weniger transparent agierte hingegen der Softwareanbieter CGM: Wieder einmal funktioniert CGM-Software nicht mit RISE-Konnektoren. Während heise online Informationen über ein angekündigtes Update zur Fehlerbehebung vorliegen, erklärte sich die Pressestelle auf Anfrage ahnungslos.

Digital Health abonnieren

Alle 14 Tage bieten wir Ihnen eine Übersicht der neuesten Entwicklungen in der Digitalisierung des Gesundheitswesens und beleuchten deren Auswirkungen.

E-Mail-Adresse

Ausführliche Informationen zum Versandverfahren und zu Ihren Widerrufsmöglichkeiten erhalten Sie in unserer Datenschutzerklärung.

(mack)

Künstliche Intelligenz

VR in den 90ern: Die gescheiterten VR-Brillen von Nintendo, Atari, Sega & Hasbro

Im Jahrzehnt nach dem Videospielcrash der Achtziger wollten gleich mehrere große Namen der Unterhaltungsindustrie mit Virtual Reality in den Konsumentenmarkt vordringen. Nintendo, Sega, Atari und Hasbro entwickelten aufwendig konzipierte VR-Brillen für Spielkonsolen, doch keines dieser Projekte schaffte es über den Status von Prototypen oder kurzlebigen Marktauftritten hinaus.

Nintendos Virtual Boy: Ambition trifft auf technische Grenzen

Nintendo startete Anfang der 1990er-Jahre mit viel Enthusiasmus in die Erforschung stereoskopischer 3D-Technologien. Unter der Leitung von Gunpei Yokoi, der maßgeblich an der Entwicklung des Game-Boys beteiligt war, begann der Konzern ab 1991 mit der Entwicklung eines VR-Systems. Die zugrunde liegende Technik stammte vom US-Unternehmen Reflection Technology und basierte auf einer LED-Zeilenanzeige, dem „Scanned Linear Array“. Dabei wurde anstatt eines klassischen Displays für jedes Auge eine vertikale LED-Leiste („Linear Array“) mit 224 roten LEDs genutzt. Jedes LED-Array bildete eine einzelne Pixel-Spalte und ein sich schnell hin- und herbewegender Spiegel, angetrieben von einem Voice-Coil-Motor, reflektierte das Licht jeweils über die Breite des Sichtfeldes.

Dadurch entstand für das jeweilige Auge der Eindruck eines vollständigen, 384 × 224 Pixel großen Bildes. Die Spiegel vibrierten mit etwa 50 Hz, also 50 Bildwiederholungen pro Sekunde. Da effiziente blaue oder grüne LEDs in den Neunzigern technisch und wirtschaftlich nicht verfügbar waren, erschienen alle dargestellten Bilder monochromatisch in rot – das bekannte Markenzeichen des Virtual Boy. 1995 brachte Nintendo seine neue Konsole schließlich mit teilweise völlig absurden und irreführenden Werbespots auf den Markt. Von einer VR-Brille war das Gerät trotz stereoskopischer Darstellung aber weit entfernt.

Statt des ursprünglich geplanten Headset-Formfaktors entschied sich Nintendo wegen Gesundheits- und Sicherheitsbedenken, den Virtual Boy als stationäres Gerät mit Ständer und Okular zu veröffentlichen. Nintendo investierte viel, gab früh Entwicklerkits aus und baute eigene Produktionslinien auf. Doch der Erfolg blieb aus. Das Gerät war unbequem, die Darstellung ermüdete die Augen und verursachte häufig Kopfschmerzen. Auch die Spielauswahl war mit nur 22 Titeln spärlich. Nach enttäuschenden Verkaufszahlen von lediglich 770.000 weltweit abgesetzten Einheiten stellte Nintendo das Gerät bereits 1996 wieder ein und richtete den Fokus auf das N64. Yokoi verließ kurz darauf das Unternehmen.

Sega VR: Zu realistisch für die Marktreife

Auch Nintendos größter Konkurrent unternahm ab 1991 Anstrengungen, VR in den Heimkonsolenmarkt zu bringen. In den USA entwickelte Sega unter Leitung von Stewart Kosoy ein Headset für das Mega Drive. Die Technik war für die damalige Zeit fortschrittlich: integrierte Kopfhörer mit Stereoton, Kopfbewegungstracking und zwei LC-Displays. Diese lieferten allerdings ein ähnlich monochromatisches Bild wie der Virtual Boy. Unterstützt wurde das Projekt von Firmen wie Ono-Sendai, IDEO und Durand Interstellar. Geplante Spiele wie „Nuclear Rush“ oder „Iron Hammer“ erreichten allerdings nie den Markt.

1994 stoppte Sega die Entwicklung. Die offizielle Begründung, das System sei „zu realistisch“, um es bedenkenlos auf den Markt zu bringen, sollte allerdings nur von den tatsächlichen Problemen ablenken. Es kam zu massiven Beschwerden über Schwindel und Übelkeit, insbesondere bei Kindern, und ein kritischer Bericht des Stanford Research Institute stufte die VR-Brille sogar als Gesundheitsrisiko ein. Mit der geringen Rechenleistung der damaligen Sega-Konsolen erreichte die VR-Brille nur eine sehr geringe Auflösung von 320 × 240 Pixeln und eine schwache Bildfrequenz von maximal 30 Hz.

Erfolgreicher liefen hingegen Segas Arcade-VR-Projekte in japanischen Freizeitparks. In Zusammenarbeit mit Virtuality entstand das „Mega Visor Display“, das in der Vergnügungspark-Attraktion VR-1 zum Einsatz kam. Ohne die technische Limitierung der Heimkonsolen konnte Sega erstmals hochwertige VR-Erlebnisse mit 3D-Grafik, Bewegungssimulatoren und Multiplayer-Funktionen bieten. Die Systeme basierten auf Sega-Model-1-Chips und boten immersive Spiele. Sie waren technisch zwar ausgereifter, aber sehr kostspielig und auf Freizeitparks in Japan und den USA beschränkt. Versuche, eine VR-Brille für die nächste heimische Saturn-Konsole zu entwickeln, endeten bereits im frühen Prototypenstadium.

Atari Jaguar VR: Der Sargnagel für Virtuality

Nachdem Atari in den Achtzigern zwei der bedeutendsten VR-Forscher überhaupt hervorgebracht hatte, versuchte sich das Unternehmen in den 1990er-Jahren selbst an VR-Systemen. Unterstützen sollte dabei der erfolgreiche britische VR-Arcade-Hersteller Virtuality. Aus der Kooperation entstand eine für den Heimgebrauch optimierte Version von Virtualitys „Visette“-VR-Brille, die ursprünglich für Arcades entwickelt worden war. Das „Jaguar V““-Projekt sollte die 64-Bit-Konsole Atari Jaguar um ein VR-Headset erweitern und wurde 1995 auf der CES vorgestellt.

Es umfasste zwei Farb-LC-Displays, die je nach Prototyp entweder rot-graue oder blau-graue Bilder lieferten, integrierte Kopfhörer, Infrarot-Tracking und einen separaten VR-Controller – den „Space Joystick“. Spiele wie „Missile Command 3D“ und „Zone Hunter“ waren bereits in Entwicklung, doch auch der Jaguar war technisch zu schwach für Virtual Reality.

Die geringe Rechenleistung führte zu ruckelnden Bildern und häufigen Trackingfehlern, was bei Nutzern in starker Motion Sickness resultierte. Dazu kamen negative Rückmeldungen auf Messen sowie interne wirtschaftliche Probleme. Die Jaguar-Konsole verkaufte sich schlecht, und nach Ataris Fusion mit JT Storage wurden sämtliche Investitionen in Spielekonsolen eingestellt. Virtuality erlitt durch das Scheitern große finanzielle Verluste, von denen sich das Unternehmen nicht mehr erholte.

Hasbros nie erschienener VR-Toaster

Neben den großen Konsolenherstellern arbeitete auch der Spielzeuggigant Hasbro an einem ambitionierten VR-Projekt. Unter wechselnden Codenamen wie „Sliced Bread“, „Toaster“, „Rush“ oder „Xscape VR“ wollte der Konzern ein günstiges Heim-VR-System etablieren und suchte sich dafür gleich mehrere Experten. Initiator war Chris Gentile von AGE Inc., der schon maßgeblich an der Entwicklung von Mattels NES-Zubehör „PowerGlove“ beteiligt war. Unterstützt wurde er beim Headset-Design Steve E. Tice von QWC und dem David Sarnoff Research Center, das ein eigenes VR-Linsensystem zur Projektion auf beide Augen entwickelte.

Hasbros VR-System sollte von einem optimierten ARM-Core-Prozessor angetrieben werden, der von Argonaut Games stammte, den Entwicklern von Nintendos Super FX Chip. Ab 1994 startete Hasbro erste Pressekampagnen. Geplant waren mindestens fünf Starttitel, darunter die Spiele „Nero Zero“, „Intruder“ und verschiedene VR-Rennspiele. Trotz zahlreicher Demos und Hardwareplanungen scheiterte das Projekt ebenfalls an technischen Hürden, steigenden Kosten und einer schwierigen Marktsituation, die mit der anstehenden Veröffentlichung von Sonys Playstation nicht leichter wurde.

Die ursprünglich angepeilten 200 US-Dollar Verkaufspreis stiegen im Verlauf der Entwicklung auf bis zu 499 US-Dollar. 1996 stellte Hasbro das Projekt schließlich ein, da es kaum noch Chancen auf eine zufriedenstellende VR-Darstellung und eine erfolgreiche Markteinführung sah. Hasbro soll zwischen 40 und 60 Millionen US-Dollar in das System investiert haben. Ein fertiges Produkt entstand nie.

Ein gemeinsames Scheitern mit langfristigen Folgen

Alle vier Unternehmen scheiterten an ähnlichen Problemen: unzureichende Technik, gesundheitliche Bedenken, fehlende Inhalte und hohe Kosten. Nintendo brachte zumindest ein marktreifes Produkt in den Handel, während Sega, Atari und Hasbro mit ihren Heim-VR-Systemen nur jede Menge Geld verbrannten und nie über das Prototypenstadium hinauskamen.

Die gescheiterten Projekte der 1990er-Jahre gelten heute dennoch als frühe Wegbereiter für spätere Entwicklungen in 3D- und VR-Technologie. Viele der beteiligten Ingenieure und Unternehmen, darunter etwa Reflection Technology, das Sarnoff Center oder Virtuality, lieferten Impulse für spätere Systeme. Doch für die damalige Zeit war die Technik nicht ausgereift genug, um auf dem Massenmarkt zu bestehen. Die Euphorie wich schnell der Ernüchterung und der Begriff Virtual Reality verschwand für viele Jahre aus den Wohnzimmern – bis ein findiger Tüftler 2009 in seiner Garage den ersten Prototypen einer VR-Brille bastelte, die später als „Oculus Rift“ für Aufsehen sorgen sollte.

(joe)

-

Datenschutz & Sicherheitvor 2 Monaten

Datenschutz & Sicherheitvor 2 MonatenGeschichten aus dem DSC-Beirat: Einreisebeschränkungen und Zugriffsschranken

-

Online Marketing & SEOvor 2 Monaten

Online Marketing & SEOvor 2 MonatenTikTok trackt CO₂ von Ads – und Mitarbeitende intern mit Ratings

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenMetal Gear Solid Δ: Snake Eater: Ein Multiplayer-Modus für Fans von Versteckenspielen

-

Digital Business & Startupsvor 1 Monat

Digital Business & Startupsvor 1 Monat10.000 Euro Tickets? Kann man machen – aber nur mit diesem Trick

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenPhilip Bürli › PAGE online

-

Digital Business & Startupsvor 1 Monat

Digital Business & Startupsvor 1 Monat80 % günstiger dank KI – Startup vereinfacht Klinikstudien: Pitchdeck hier

-

Apps & Mobile Entwicklungvor 1 Monat

Apps & Mobile Entwicklungvor 1 MonatPatentstreit: Western Digital muss 1 US-Dollar Schadenersatz zahlen

-

Social Mediavor 2 Monaten

Social Mediavor 2 MonatenLinkedIn Feature-Update 2025: Aktuelle Neuigkeiten