Künstliche Intelligenz

Honor Magic V5 im Test: Das beste Foldable-Smartphone 2025

Dünner, stabiler und mit verbesserter Kamera – das Honor Magic V5 erfindet das Foldable zwar nicht neu, liefert aber einen fast perfekten Feinschliff.

Mit dem Magic V3 landete Honor im vergangenen Jahr einen Überraschungserfolg: Das Foldable überzeugte mit schlankem Design und ordentlicher Technik – und setzte damit ein Ausrufezeichen im noch jungen Markt. Jetzt schickt Honor den Nachfolger ins Rennen. Die Zahl „4“ überspringt der Hersteller traditionsgemäß, da sie in China als Unglückszahl gilt – und bringt direkt das Magic V5 heraus.

Doch die Konkurrenz schläft nicht. Samsung konterte mit dem Galaxy Z Fold 7, das vorwiegend durch seine flache Bauform und ausgereifte Technik glänzte. Auf den ersten Blick wirkt das neue V5 dagegen fast wie ein Zwilling des Vorgängers. Ob sich dahinter nur Feinschliff oder echte Fortschritte verbergen, zeigt unser Test.

Design

Optisch hat sich das Honor Magic V5 gegenüber dem Magic V3 kaum verändert. Wieder prangt auf der Rückseite ein großes, rundes Kameraelement – ein markanter Blickfang, der das Design prägt.

Beim Gehäuse zeigt sich jedoch Honors Anspruch: Mit 4,4 mm in aufgeklapptem und 8,8 mm in gefaltetem Zustand ist das Foldable extrem schlank und zusammengeklappt nur minimal dicker als ein Galaxy S25 Ultra. Die Werte beziehen sich allerdings auf das Gehäuse – da die Kamera spürbar hervorsteht, wirkt das Galaxy Z Fold 7 im Vergleich in der Gesamterscheinung noch filigraner.

Durch das Kameraelement liegt das Magic V5 leicht kopflastig in der Hand, bleibt aber mit einem Gewicht von nur 217 g leicht und fühlt sich sehr schlank an – fast wie ein Knäckebrot. Verarbeitung und Materialqualität sind top, auch wenn das Aufklappen etwas schwergängig ist. Das Metallchassis ist extrem verwindungssteif. Zusätzlich gibt es IP58/IP59. Damit ist das Gerät in Süßwasser wasserdicht bis in eine Tiefe von einem Meter für etwa 30 Minuten – auch gegen heißes Wasser. Dazu kommt ein Schutz vor Staub – ein Vorteil, den Samsungs Foldable auf dem Niveau mit IP48 nicht bietet.

Display

Das innere Display des Honor Magic V5 misst 7,95 Zoll und löst 2352 × 2172 Pixel auf. Mit 403 PPI liefert es eine gestochen scharfe Darstellung, die sich sowohl für Texte als auch für Multimedia-Inhalte eignet. Zum Einsatz kommt ein OLED-Panel auf LTPO-Basis, das die Bildwiederholrate flexibel zwischen 1 und 120 Hz anpasst. Dadurch wirken Animationen und Scrollbewegungen flüssig, während der Energieverbrauch sich in Grenzen hält. Überdies unterstützt das Panel HDR10+ und Dolby Vision.

Die maximale Helligkeit erreicht laut Hersteller bis zu 1800 Nits – genug, um Inhalte auch bei direkter Sonneneinstrahlung noch klar erkennen zu können. Der typische Falz ist zwar weiterhin vorhanden, im Alltag jedoch kaum sichtbar und nur leicht zu ertasten. Damit gelingt Honor eine der bislang dezentesten Faltstellen bei einem Foldable.

Auch das Außen-Display hinterlässt einen starken Eindruck. Es misst 6,43 Zoll, bietet eine Auflösung von 2376 × 1060 Pixel und kommt damit auf eine Pixeldichte von 405 PPI. Wie das Hauptpanel setzt es auf OLED mit LTPO-Technik und unterstützt ebenfalls HDR10+ sowie Dolby Vision. Besonders bemerkenswert ist die enorme Spitzenhelligkeit: Bis zu 5000 Nits sollen möglich sein. Im Test blieb der Screen auch unter praller Sonne problemlos ablesbar.

Geschützt wird der Bildschirm durch Honors Nanocrystal Shield, das erhöhte Widerstandsfähigkeit gegen Kratzer und Stöße bieten soll. Tatsächlich blieben im Test keine Spuren zurück. Deutlich weniger sinnvoll ist dagegen die ab Werk aufgebrachte Schutzfolie am Außen-Display: Sie bietet kaum echten Nutzen und löst sich schnell, was sehr unschön aussieht und den hochwertigen Eindruck schmälert.

Kamera

Honor hat beim Magic V5 die Triple-Kamera überarbeitet, primär das Teleobjektiv. Die Hauptkamera bietet weiter 50 Megapixel, das Teleobjektiv nun 64 Megapixel. Beide sind optisch stabilisiert und liefern dadurch auch bei wenig Licht oder Zoom schärfere Bilder. Ergänzt wird das Setup durch eine 50-Megapixel-Ultraweitwinkelkamera, die auch Makroaufnahmen abdeckt. Die Frontkamera liefert 20 Megapixel. Im Test überzeugte die Bildqualität – bei Tageslicht detailreich, kontraststark und dynamisch ausgewogen.

Der Zoom wurde aber leicht angepasst: Statt 3,5-fach bietet es stattdessen 3-fachen optischen Zoom. In der Praxis fällt das kaum ins Gewicht, da bis zum 6-fachen Hybridzoom die Ergebnisse überzeugend bleiben. Realistisch nutzbar ist der Zoom bis zum 10-fachen Faktor, danach nimmt die Bildqualität deutlich ab. Bis zu 100-fach sind möglich.

Nachts sorgt die KI für helle Bilder mit vielen Details und wenig Rauschen, übertreibt aber teils so, dass Fotos fast wie bei Tag wirken. Bei schwachem Licht schneidet die Hauptkamera am besten ab, gefolgt von der Telekamera. Die Ultraweitwinkellinse schwächelt hier üblicherweise etwas. Der Makromodus springt manchmal etwas zu früh an.

Für Porträts mit der Triple-Kamera gibt es zudem die Harcourt-Filter in zwei Farbvarianten, sowie Schwarz-Weiß, die Studio-Charakter verleihen. Das KI-Feature aus dem Honor 400 Pro ist ebenfalls an Bord. Dieses erzeugt aus Bildern kurze Animationen im Stop-Motion-Stil – eindrucksvoll bei Nahaufnahmen und kreativ nutzbar etwa für Urlaubsfotos.

Selfies gelingen klar und detailreich. Der Porträtmodus mit der Frontkamera erzeugt ein ansprechendes Bokeh. Videos unterstützt die Triple-Kamera mit 4K/60 FPS, die Frontkamera mit 4K/30 FPS.

Honor Magic V5 – Originalaufnahmen

Ausstattung

Unter der Haube setzt Honor beim Magic V5 auf den neuen Qualcomm Snapdragon 8 Elite – aktuell das schnellste SoC am Markt. Mehr Leistung ist derzeit schlicht nicht drin, egal ob für Gaming, Multitasking oder KI-Anwendungen. Damit bewegt sich das Foldable klar in der absoluten Oberklasse und ist für jede Aufgabe bestens gerüstet.

Auch beim Speicher zeigt sich Honor großzügig: 16 GB RAM sorgen für reibungsloses Multitasking, dazu gibt es 512 GB internen Speicher. Damit ist genügend Platz für Fotos, Videos, Spiele und Apps vorhanden. Eine Erweiterung per microSD-Karte ist aber nicht möglich, es gibt auch kein Modell mit 1 TB. Die Navigation unterstützt alle gängigen Satellitensysteme wie GPS, Glonass, Beidou, Galileo und QZSS und ist im Alltag genau.

Bei der Konnektivität bietet das Gerät alles, was man 2025 erwarten darf: USB-C 3.1 und Displayport 1.2 für externe Monitore, dazu kommt Wi-Fi 7 für höchste Netzwerkgeschwindigkeiten. Bluetooth 6.0 ist ebenfalls an Bord und unterstützt moderne Codecs wie aptX Adaptive, LDAC, AAC, SBC sowie LE Audio mit LC3. Abgerundet wird das Paket durch NFC für mobiles Bezahlen oder schnelles Pairing und einen Infrarot-Port, mit dem sich klassische Geräte wie TV oder Hi-Fi steuern lassen.

Für das Magic V5 bietet Honor optional den Magic Pen an. Er ermöglicht handschriftliche Notizen, Unterschriften und Zeichnungen – besonders praktisch auf dem großen Innendisplay. Damit behält Honor ein Feature bei, das Samsung beim Galaxy Z Fold 7 kürzlich erst gestrichen hat, und verschafft sich einen solchen Vorteil. Der Stift wird in einem hochwertigen Cover mitgeliefert, das zugleich als Schutz für den Stylus dient.

Software

Das Honor Magic V5 läuft mit Android 15 und der Oberfläche Magic OS 9. Optisch erinnert sie stark an iOS und Huaweis EMUI, auch weil ein App-Drawer fehlt. Benachrichtigungen und Kontrollzentrum werden getrennt geöffnet: Nachrichten per Wisch von oben, das Kontrollzentrum vom rechten oberen Rand.

Ein großer Pluspunkt ist die Update-Politik: Honor garantiert sieben Jahre Software- und Sicherheits-Updates mit monatlichen Patches. Damit zählt das Magic V5 zu den am längsten unterstützten Android-Smartphones.

Magic OS bietet praktische Features wie Multi-Window, eine seitliche App-Leiste und das Magic Portal, mit dem sich Inhalte direkt in passende Apps übertragen lassen. Auch die Knöchel-Geste zur Markierung von Bildausschnitten ist dabei, wirkt aber weniger zuverlässig als Samsungs „Circle to Search“. Kritik gibt es bei den hauseigenen Apps: Sie verdrängen teils Googles Lösungen, sind aber nicht immer so ausgereift. Die Kalender-App zeigte im Test etwa verzögerte Synchronisierungen.

Akku

Das Magic V5 bringt eine Akkukapazität von 5820 mAh mit – für ein so dünnes Foldable ein beeindruckender Wert. Möglich wird das durch Silizium-Karbon-Technologie, die eine besonders hohe Energiedichte bietet und somit deutlich mehr Kapazität ins kompakte Gehäuse bringt.

Beim PCmark Battery Test, der typische Alltagsaufgaben wie Surfen, Textbearbeitung und leichte Grafiklast simuliert, erzielte das Gerät eine starke Laufzeit von 15 Stunden. Das zählt zu den besten Ergebnissen in seiner Klasse. Im Alltag bedeutet das: Ein voller Tag intensiver Nutzung ist problemlos machbar, bei moderatem Gebrauch sind sogar anderthalb Tage drin. Unter hoher Belastung wie beim Zocken oder länger geöffnetem Haupt-Display sinkt die Ausdauer rapide, bleibt aber auf gutem Niveau.

Beim Laden setzt Honor auf 66 Watt kabelgebundenes Laden. Aufgrund der großen Kapazität dauert eine volle Ladung von 20 auf 100 Prozent rund 1 Stunde und 15 Minuten. Kabelloses Laden nach Qi-Standard ist ebenfalls an Bord und rundet das Gesamtpaket ab.

Preis

Die unverbindliche Preisempfehlung (UVP) liegt bei knapp 2000 Euro – ein stolzer Preis, aber üblich für Foldables dieser Art. Zum Marktstart lohnt sich jedoch ein Blick auf die attraktiven Rabatte bei Honor: Dort erhält man das Gerät bis zum 11.09.2025 mit Coupon für „nur“ 1700 Euro. Den Honor Magic Pen im Wert von 99 Euro sowie ein Ladegerät mit 66 W im Wert von 30 Euro und eine 12-monatige Garantie auf Display-Bruch gibt es kostenlos dazu.

Fazit

Auf den ersten Blick ähnelt das Honor Magic V5 seinem Vorgänger, doch die Details machen den Unterschied. Das hochwertige Gehäuse ist nochmals dünner – schlanker geht kaum, da der USB-C-Anschluss bereits der limitierende Faktor ist.

Die Kamera überzeugt vorwiegend durch die verbesserte Telelinse. KI-Funktionen optimieren Fotos sichtbar und bieten kreative Effekte wie Studiofilter und Animationen. Für Fans natürlicher Fotos greift die KI aber zuweilen etwas zu intensiv ein. Performance und Akkulaufzeit sind top, die Stiftunterstützung sinnvoll.

Im Vergleich: Samsungs Galaxy Z Fold 7 ist ebenfalls schlank und bietet eine starke Kamera. Doch bei Akkulaufzeit, Telelinse und Design liegt das Magic V5 knapp vorn. Kritik: Die Folie auf dem Außen-Display wirkt überflüssig, die KI verschönert Fotos teils stark und der Preis ist hoch. Insgesamt aber liefert das Magic V5 ein fast perfektes Gesamtpaket.

Künstliche Intelligenz

Der neue c’t Fotografie-Fotowettbewerb: Die Farbe Blau

Das kommende Winterhalbjahr steht nicht unbedingt für blauen Himmel oder paradiesische Strände. Doch gerade darin liegt die Herausforderung des neuen c’t-Fotografie-Wettbewerbs, denn er steht unter dem Thema Die Farbe Blau. Bestimmt fallen Ihnen auch im Alltag ein paar Dinge ins fotografische Auge, die das Motto treffen. Wie wäre es mit zwei Freunden mit blauen Sonnenbrillen, mit blauem Eis in einer Gletscherhöhle oder einem blau gestrichenen Haus, das zwischen tristen Gebäuden Ruhe oder Fröhlichkeit ausstrahlt? Gehen Sie mit Ihrer Kamera auf Jagd nach einem passenden Motiv, alternativ: Erschaffen Sie eines! Oder durchforsten Sie Ihr Archiv. Wer weiß, welche Schätze vergangener Reisen Sie dort noch heben können. Wir sind gespannt auf Ihre Ideen und darauf, wie Sie uns und die Mitglieder der heise-Fotogalerie mit Ihrem Motiv überzeugen können.

Weiterlesen nach der Anzeige

Reichen Sie Ihr bestes Bild bitte zwischen dem 24. Oktober 2025 ab 13.00 Uhr und dem 24. November 2025 bis 12.00 Uhr über die Galerie von c’t Fotografie online ein. Anschließend läuft die Bewertungsphase zwischen dem 24. November ab 12.00 Uhr und dem 05. Januar 2026 bis 12.00 Uhr.

c’t Fotografie Zoom In abonnieren

Ihr Newsletter mit exklusiven Foto-Tipps, spannenden News, Profi-Einblicken und Inspirationen – jeden Samstag neu.

E-Mail-Adresse

Ausführliche Informationen zum Versandverfahren und zu Ihren Widerrufsmöglichkeiten erhalten Sie in unserer Datenschutzerklärung.

Am Wettbewerb und an der Bewertung können alle registrierten User der Galerie teilnehmen. Die zehn bestplatzierten Bilder stellen wir in der Ausgabe 02/26 vor. Sie haben noch keinen Galerie-Account? Hier können Sie sich kostenlos anmelden. Der erste Platz gewinnt ein 2-Jahres-Abo der c’t Fotografie, der 2. und 3. Platz erhalten jeweils einen Bildband. Wir wünschen viel Freude bei der Teilnahme.

(cbr)

Künstliche Intelligenz

#TGIQF: Das Quiz rund um Tabellenkalkulationen

Die Arbeitsmappen von Tabellenkalkulationen sind im Arbeitsalltag auf den ersten Blick nicht besonders sexy: Ihre Attraktivität ziehen sie vor allem aus dem Vergleich zur Erinnerung, wie kompliziert es war, die gleiche Arbeit auf Papier zu bringen, was der Rechner heutzutage mit einem Tastendruck erledigt.

Weiterlesen nach der Anzeige

Nicht umsonst gelten Tabellenkalkulationen als wichtigste Tools in der IT: Für jedes relevante Computersystem wurden eigene Tabellenkalkulationen entwickelt.

„Thank God It’s Quiz Friday!“ Jeden Freitag gibts ein neues Quiz aus den Themenbereichen IT, Technik, Entertainment oder Nerd-Wissen:

Dabei war Microsofts marktbeherrschender Dauerbrenner Excel nicht immer die Nummer 1 – man war eigentlich eher spät dran. Im Oktober 1979 brachten die US-Softwareentwickler Dan Bricklin und Bob Frankston VisiCalc auf den Markt. Microsofts Excel erschien erstmals 1985. Dabei hatte der Konzern aus Redmond einen Vorläufer, der im Gegensatz zu den USA hierzulande ein großer Erfolg war – Doch wie hieß er? Das wollen wir von Ihnen in unserem kleinen Nerdquiz zu Tabellenkaluationen wissen.

Eines vorweg: Nicht wundern! Beim letzten Freitagsquiz wurde der Wechsel zu einem neuen Quiz-Tool eingeleitet. Für dieses Quiz haben wir uns jedoch entschieden, noch einmal das alte Tool zu verwenden. Wie so oft bei Neustarts kann es stellenweise zu Problemen kommen – Ausgerechnet bei der App-Integration hat es gehakt. Wir sind dran und möchten die Übertragung weiter optimieren, damit Sie perfekt ins Wochenende starten können. Wir bedanken uns auch fürs Feedback. Betrachten Sie das Quiz der letzten Woche also als Sneak Preview.

In der heiseshow stellte Anna Bicker den Redakteuren Malte Kirchner und Ben Schwan drei Fragen vorab: Die meisten Antworten schüttelten sie aus dem Ärmel wie die Excel eine einfache Addition.

Die Uhr läuft mit und belohnt schnelles Raten in 10 Fragen mit maximal-satten 200 Punkten. Die Punktzahl kann gern im Forum mit anderen Mitspielern verglichen werden. Halten Sie sich dabei aber bitte mit Spoilern zurück, um anderen Teilnehmern nicht die Freude am Quiz zu verhageln. Lob und Kritik ist wie immer gern genommen.

Weiterlesen nach der Anzeige

Bleiben Sie zudem auf dem Laufenden und erfahren Sie das Neueste aus der IT-Welt: Folgen Sie uns bei Mastodon, auf Facebook oder Instagram. Und schauen Sie auch gern beim Redaktionsbot Botti vorbei.

Und falls Sie Ideen für eigene Quizze haben, schreiben Sie einfach eine Mail an den Quizmaster aka Herr der fiesen Fragen.

(mawi)

Künstliche Intelligenz

DeepSeek-OCR: Bilder vereinfachen Texte für große Sprachmodelle

Viele Unternehmensdokumente liegen zwar als PDFs vor, sind aber häufig gescannt. Obwohl es simpel klingt, können diese Dokumente oftmals nur unter großen Mühen in Text gewandelt werden, insbesondere wenn die Struktur der Dokumente komplexer ist und erhalten bleiben soll. Auch Bilder, Tabellen und Grafiken sind häufige Fehlerquellen. In den letzten Monaten gab es daher eine wahre Flut von OCR-Software, die auf großen Sprachmodelle (LLMs) setzt.

Weiterlesen nach der Anzeige

Auch der chinesische KI-Entwickler DeepSeek steigt nun in diesen Bereich ein und veröffentlicht nach dem Reasoning-Modell R1 ein experimentelles OCR-Modell unter MIT-Lizenz. Auf den ersten Blick mag das verblüffen, denn OCR schien bisher nicht die Kernkompetenz von DeepSeek zu sein. Und tatsächlich ist das neue Modell erstmal eine Technikdemo für einen neuen Ansatz in der Dokumentenverarbeitung von großen Sprachmodellen.

Prof. Dr. Christian Winkler beschäftigt sich speziell mit der automatisierten Analyse natürlichsprachiger Texte (NLP). Als Professor an der TH Nürnberg konzentriert er sich bei seiner Forschung auf die Optimierung der User Experience.

DeepSeek versucht, lange Textkontexte in Bildern zu komprimieren, da sich hierdurch eine höhere Informationsdichte mit weniger Token darstellen lässt. DeepSeek legt die Messlatte für die Erwartungen hoch und berichtet, dass das Modell bei hohen Kompressionsraten (Faktor 10) noch eine Genauigkeit von 97 Prozent erreicht, bei einer noch stärkeren Kompression fällt zwar die Genauigkeit, bleibt dabei aber relativ hoch. Das alles soll schneller funktionieren als bei anderen OCR-Modellen und auf einer Nvidia A100-GPU bis zu 200.000 Seiten pro Tag verarbeiten.

Das Kontext-Problem

Large Language Models haben Speicherprobleme, wenn der Kontext von Prompts sehr groß wird. Das ist der Fall, wenn das Modell lange Texte oder mehrere Dokumente verarbeiten soll. Grund dafür ist der für effiziente Berechnungen wichtige Key-Value-Cache, der quadratisch mit der Kontextgröße wächst. Die Kosten der GPUs steigen stark mit dem Speicher, was dazu führt, dass lange Texte sehr teuer in der Verarbeitung sind. Auch das Training solcher Modelle ist aufwendig. Das liegt allerdings weniger am Speicherplatz, sondern auch an der quadratisch wachsenden Komplexität der Berechnungen. Daher forschen die LLM-Anbieter intensiv daran, wie sich man diesen Kontext effizienter darstellen kann.

Hier bringt DeepSeek die Idee ins Spiel, den Kontext als Bild darzustellen: Bilder haben eine hohe Informationsdichte und Vision Token zur optischen Kompression könnten einen langen Text durch weniger Token. Mit DeepSeek-OCR haben die Entwickler diese Grundidee überprüft – es ist also ein Experiment zu verstehen, das zeigen soll, wie gut die optische Kompression funktioniert.

Weiterlesen nach der Anzeige

Die Modellarchitektur

Der dazugehörige Preprint besteht aus drei Teilen: einer quantitativen Analyse, wie gut die optische Kompression funktioniert, einem neuen Encoder-Modell und dem eigentlichen OCR-Modell. Das Ergebnis der Analyse zeigt, dass kleine Sprachmodelle lernen können, wie sie komprimierte visuelle Darstellungen in Text umwandeln.

Dazu haben die Forscher mit DeepEncoder ein Modell entwickelt, das auch bei hochaufgelösten Bildern mit wenig Aktivierungen auskommt. Der Encoder nutzt eine Mischung aus Window und Global Attention verbunden mit einem Kompressor, der Konvolutionen einsetzt (Convolutional Compressor). Die schnellere Window Attention sieht nur einzelne Teile der Dokumente und bereitet die Daten vor, die langsamere Global Attention berücksichtigt den gesamten Kontext, arbeitet nur noch mit den komprimierten Daten. Die Konvolutionen reduzieren die Auflösung der Vision Token, wodurch sich der Speicherbedarf verringert.

DeepSeek-OCR kombiniert den DeepEncoder mit DeepSeek-3B-MoE. Dieses LLM setzt jeweils sechs von 64 Experten und zwei geteilte Experten ein, was sich zu 570 Millionen aktiven Parametern addiert. Im Gegensatz zu vielen anderen OCR-Modellen wie MinerU, docling, Nanonets, PaddleOCR kann DeepSeek-OCR auch Charts in Daten wandeln, chemische Formeln und geometrische Figuren erkennen. Mathematische Formeln beherrscht es ebenfalls, das funktioniert zum Teil aber auch mit den anderen Modellen.

Die DeepSeek-Entwickler betonen allerdings, dass es sich um eine vorläufige Analyse und um ebensolche Ergebnisse handelt. Es wird spannend, wie sich diese Technologie weiterentwickelt und wo sie überall zum Einsatz kommen kann. Das DeepSeek-OCR-Modell unterscheidet sich jedenfalls beträchtlich von allen anderen. Um zu wissen, wie gut und schnell es funktioniert, muss man das Modell jedoch selbst ausprobieren.

DeepSeek-OCR ausprobiert

Als Testobjekt dient eine Seite aus einer iX, die im JPEG-Format vorliegt. DeepSeek-OCR kann in unterschiedlichen Konfigurationen arbeiten: Gundam, Large und Tiny. Im Gundam-Modus findet ein automatisches Resizing statt. Im Moment funktioniert das noch etwas instabil, bringt man die Parameter durcheinander, produziert man CUDA-Kernel-Fehler und muss von vorne starten.

Möchte man den Text aus Dokumenten extrahieren, muss man das Modell geeignet prompten. DeepSeek empfiehlt dazu den Befehl

Im Gundam-Modus erkennt DeepSeek-OCR den gesamten Text und alle relevanten Elemente und kann auch Textfluss des Magazins rekonstruieren.

Den Text hat das Modell praktisch fehlerfrei erkannt und dazu auf einer RTX 4090 etwa 40 Sekunden benötigt. Das ist noch weit entfernt von den angepriesenen 200.000 Seiten pro Tag, allerdings verwendet Gundam auch nur ein Kompressionsfaktor von zwei: 791 Image Token entsprechen 1.580 Text Token. Immerhin erkennt das Modell den Textfluss im Artikel richtig. Das ist bei anderen Modellen ein gängiges Problem.

Mit etwa 50 Sekunden rechnet die Large-Variante nur wenig länger als Gundam, allerdings sind die Ergebnisse viel schlechter, was möglicherweise auch dem größeren Kompressionsfaktor geschuldet ist: 299 Image-Token entsprechen 2068 Text-Token. Im Bild verdeutlichen das die ungenauer erkannten Boxen um den Text – hier gibt es noch Optimierungsbedarf. Außerdem erkennt das Modell die Texte nicht sauber, teilweise erscheinen nur unleserliche Zeichen wie „¡ ¢“, was möglicherweise auf Kodierungsfehler und eigentlich chinesische Schriftzeichen hindeuten könnte.

Der Large-Modus komprimiert die Bilder stärker als Gundam, was zu einer ungenaueren Erkennung führt. Die Textboxen sind unschärfer abgegrenzt und es erscheinen unleserliche Zeichen, die auf eine fehlerhafte Kodierung hinweisen.

Fehler mit unleserlichen Zeichen gibt es beim Tiny-Modell nicht. Das rechnet mit einer Dauer von 40 Sekunden wieder etwas schneller und nutzt einen Kompressionsfaktor von 25,8 – 64 Image-Token entsprechen 1652 Text-Token. Durch die hohe Kompression halluziniert das Modell allerdings stark und erzeugt Text wie „Erweist, bei der Formulierung der Ab- fragen kann ein KI-Assistent helfen. Bis Start gilt es auf Caffès offiziell die Gewicht 50 Prozent der Früh-, der Prüfung und 50 Prozent für den Arzt- und NEUT und in Kürze folgen. (Spezielle)“. Das hat nichts mit dem Inhalt zu tun – auf diese Modellvariante kann man sich also nicht verlassen.

Die Tiny-Variante hat den höchsten Kompressionsfaktor für die Bilder und halluziniert bei der Text-Ausgabe stark. Hier sollte man sich also nicht auf die Ergebnisse verlassen.

Neben der Markdown-Konvertierung lässt DeepSeek-OCR auch ein Free OCR zu, das das Layout nicht berücksichtigt. Damit funktioniert das Modell sehr viel schneller und produziert auch in der Large-Version mit hoher Kompression noch gute Resultate. Diese Variante ist aber nur sinnvoll, wenn man weiß, dass es sich um Fließtexte ohne schwieriges Layout handelt.

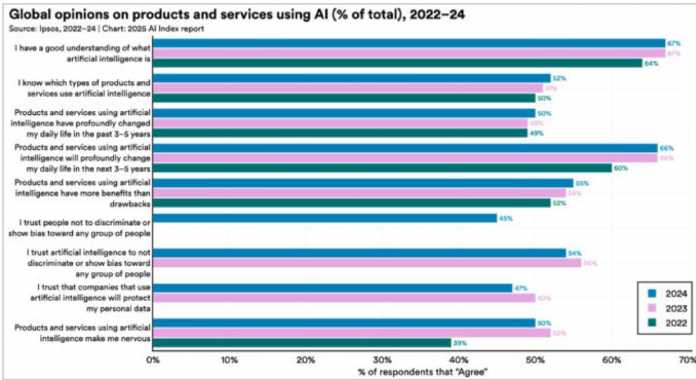

Informationen aus Grafiken extrahieren

DeepSeek-OCR hat beim Parsing die im Artikel enthaltenen Bilder erkannt und separat abgelegt. Das Diagramm speichert das Modell dabei in einer schlecht lesbaren Auflösung.

Das mit Gundam extrahierte Diagramm ist verschwommen und lässt sich mit bloßem Auge nur noch schlecht entziffern.

Jetzt wird es spannend, denn DeepSeek-OCR soll aus diesem Diagramm auch Daten extrahieren können, das geht mit dem Prompt

| 2024 | 2023 | 2022 | |

| I have a good understanding of what artificial intelligence is | 67% | 67% | 64% |

| I know which types of products and services use artificial intelligence | 52% | 51% | 50% |

| Products and services using artificial intelligence have profoundly changed my daily life in the past 3-5 years | 50% | 50% | 49% |

| Products and services using artificial intelligence will profoundly change my daily life in the next 3-5 years | 66% | 66% | 60% |

| Products and services using artificial intelligence have more benefits than drawbacks | 55% | 54% | 52% |

| I trust people not to discriminate or show bias toward any group of people | 45% | 45% | 44% |

| I trust artificial intelligence to not discriminate or show bias toward any group of people | 54% | 54% | 50% |

| I trust that companies that use artificial intelligence will protect my personal data | 47% | 50% | 50% |

| Products and services using artificial intelligence make me nervous | 39% | 39% | 39% |

Offenbar haben sich Fehler in die Tabelle eingeschlichen, aber zumindest hat das Modell den verwaschenen Text richtig erkannt. Hier zeigt sich die Stärke des Encoders, aber auch die englische Beschriftung vereinfacht den Prozess für das Modell. Die meisten Prozentwerte stimmen, ebenso die Struktur der Daten. Verwendet man eine höhere Auflösung, verbessern sich die Ergebnisse allerdings nur marginal.

Neben Diagrammen kann DeepSeek-OCR auch mathematische Formeln erkennen und sie in LaTeX-Syntax wandeln. Chemische Strukturformeln hat es auch im Repertoire und wandelt sie in das SMILES-Format.

Fazit

DeepSeek hat sich erneut einen spannenden technischen Ansatz ausgedacht und mit DeepSeek-OCR überzeugend demonstriert. Die Erkennung von Texten funktioniert besonders im Gundam-Modus schon gut, auch das Parsing der Diagramme ist überzeugend. Allerdings sind andere Modelle wie MinerU, Nanonets und PaddleOCR-VL besonders bei der reinen Texterkennung ebenfalls sehr gut und liefern teilweise sogar bessere Ergebnisse, da sie etwa getrennte Wörter zusammenführen. Besonders das ebenso nagelneue PaddleOCR-VL ist hervorzuheben, das Daten aus Diagrammen verlässlich extrahiert und in eigenen Tests sogar besser als DeepSeek-OCR funktionierte. Um OCR ist ein wahres Wettrennen entbrannt.

DeepSeek scheint mit dem Modell jedoch nicht nur auf OCR zu setzen, sondern möchte zeigen, dass die Vision Token eine gute Darstellung sind, um den Kontext in großen Sprachmodellen besonders kompakt zu speichern. Mit einer geringen Kompression funktioniert das schon gut, mit höherer Kompression leiden die Ergebnisse aber spürbar. Dieser Ansatz steht allerdings noch ganz am Anfang.

DeepSeek-OCR ist in allen Konfigurationen verhältnismäßig schnell. Experimente mit MinerU, Nanonets und PaddleOCR-VL waren alle mindestens 50 Prozent langsamer. Nanonets erzeugte immerhin eine Tabelle aus dem Diagramm, aber ohne die Jahreszahlen, dafür war der Fließtext sehr viel besser erkannt. Das nagelneue PaddleOCR-VL konnte das Diagramm sogar besser als DeepSeek-OCR erkennen, ist aber nicht auf chemische Strukturformeln und ähnliche Inhalte trainiert.

DeepSeek-OCR ist – wie von den Entwicklern deutlich vermerkt – eine Technologiedemonstration, die dafür schon äußerst gut funktioniert. Es bleibt abzuwarten, wie sich die Technologie in klassische LLMs integrieren lässt und dort zur effizienteren Verarbeitung von längeren Kontexten genutzt werden kann.

Weitere Informationen finden sich auf GitHub, Hugging Face und im arXiv-Preprint.

(pst)

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenAdobe Firefly Boards › PAGE online

-

Social Mediavor 2 Monaten

Social Mediavor 2 MonatenRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

UX/UI & Webdesignvor 1 Monat

UX/UI & Webdesignvor 1 MonatFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online

-

UX/UI & Webdesignvor 6 Tagen

UX/UI & Webdesignvor 6 TagenIllustrierte Reise nach New York City › PAGE online

-

Social Mediavor 1 Monat

Social Mediavor 1 MonatSchluss mit FOMO im Social Media Marketing – Welche Trends und Features sind für Social Media Manager*innen wirklich relevant?