Apps & Mobile Entwicklung

AMD Instinct MI350: Mit bis zu 1.400 Watt und neuem Package gegen Goliath Nvidia

Die von ComputerBase vorgestern publizierten Spezifikationen der MI350-Serie stimmten bis ins kleinste Detail. Zur offiziellen Vorstellung von MI350X und MI355X gibt es auch Vergleiche zum Vor-Vorgänger, aber auch gegenüber Nvidia GB200, dem großen Konkurrenten. AMD sieht sich sehr gut aufgestellt, aber der Kunde entscheidet.

Instinct MI325X ist kaum am Markt schon Geschichte

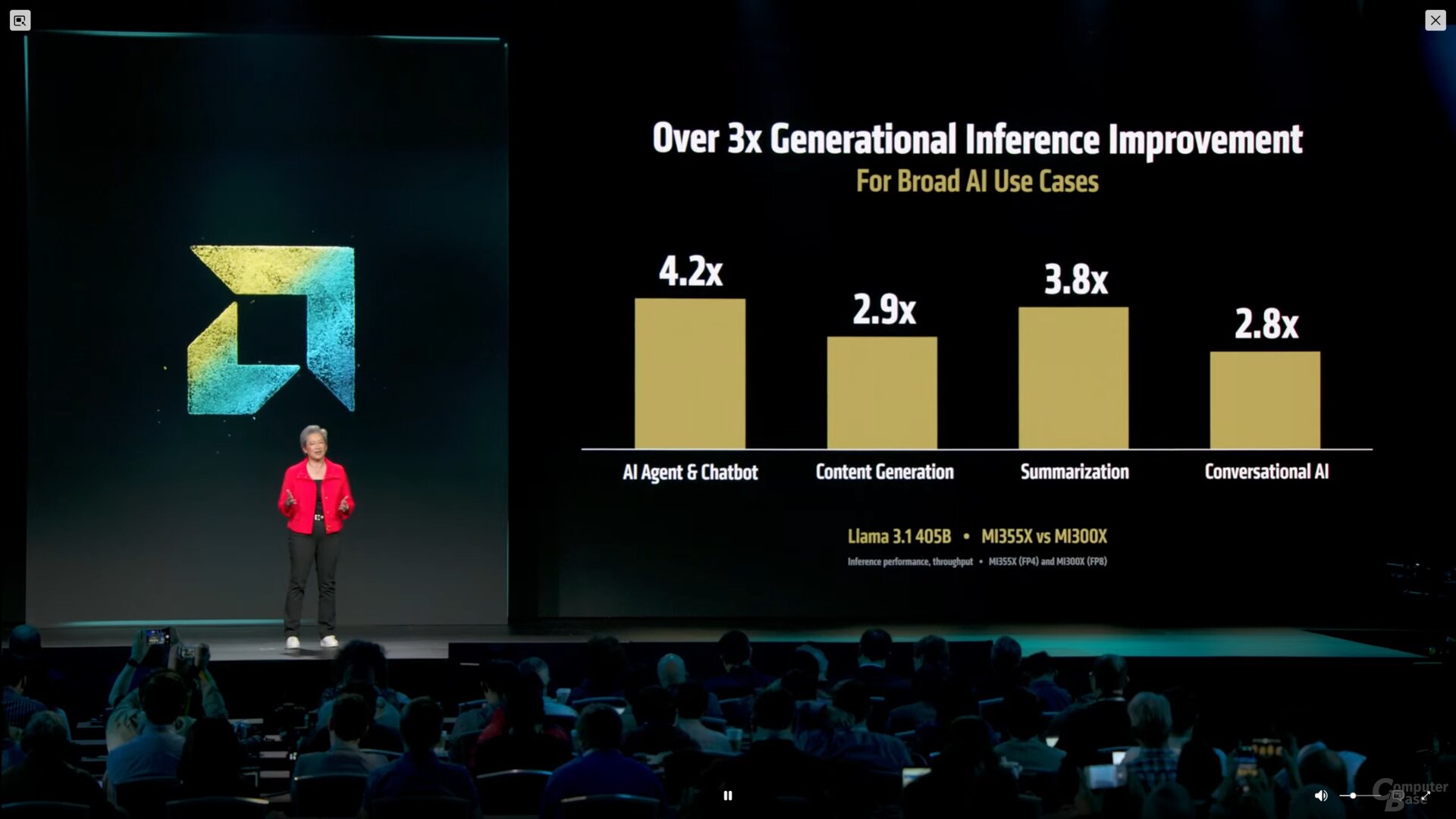

Erst vor einem halben Jahr offiziell vorgestellt und bisher kaum verfügbar, wird Instinct MI325X quasi direkt wieder abgelöst. Denn schon werden die ersten Instinct MI350 ausgeliefert, auch weil der Nachfolger das rundere Paket ist. Interessanterweise zieht AMD Leistungsvergleiche auch direkt zu MI300X, aber der Fortschritt ist in dem Fall natürlich auch noch größer. Dabei zieht AMD aber gern Vergleiche von FP4 vs. FP8 beim Vorgänger, der kann halt FP8 nicht. Wie üblich gilt es bei Performance-Angaben extrem aufs Detail zu achten.

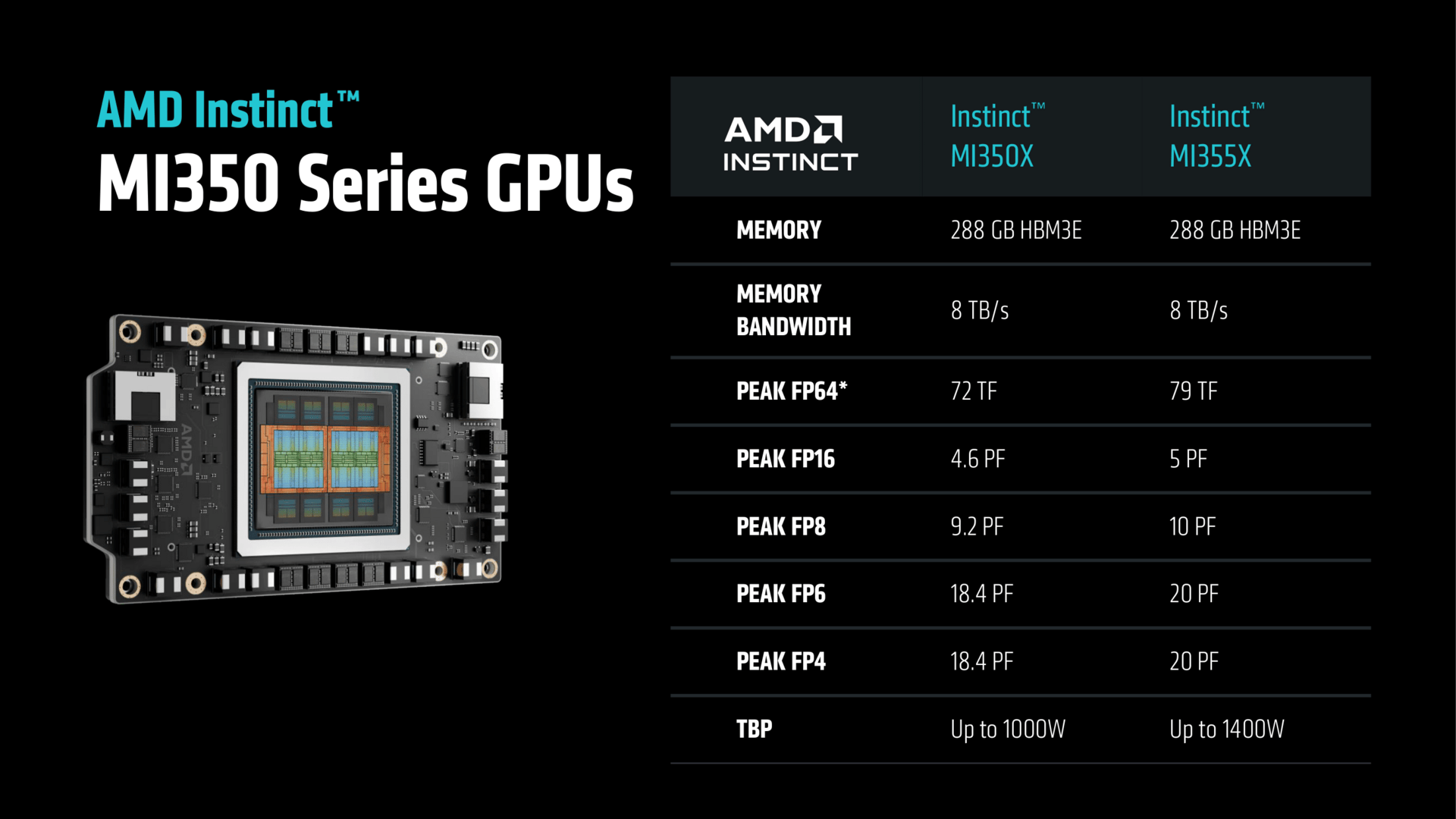

Zwei Varianten: MI355X und MI350X

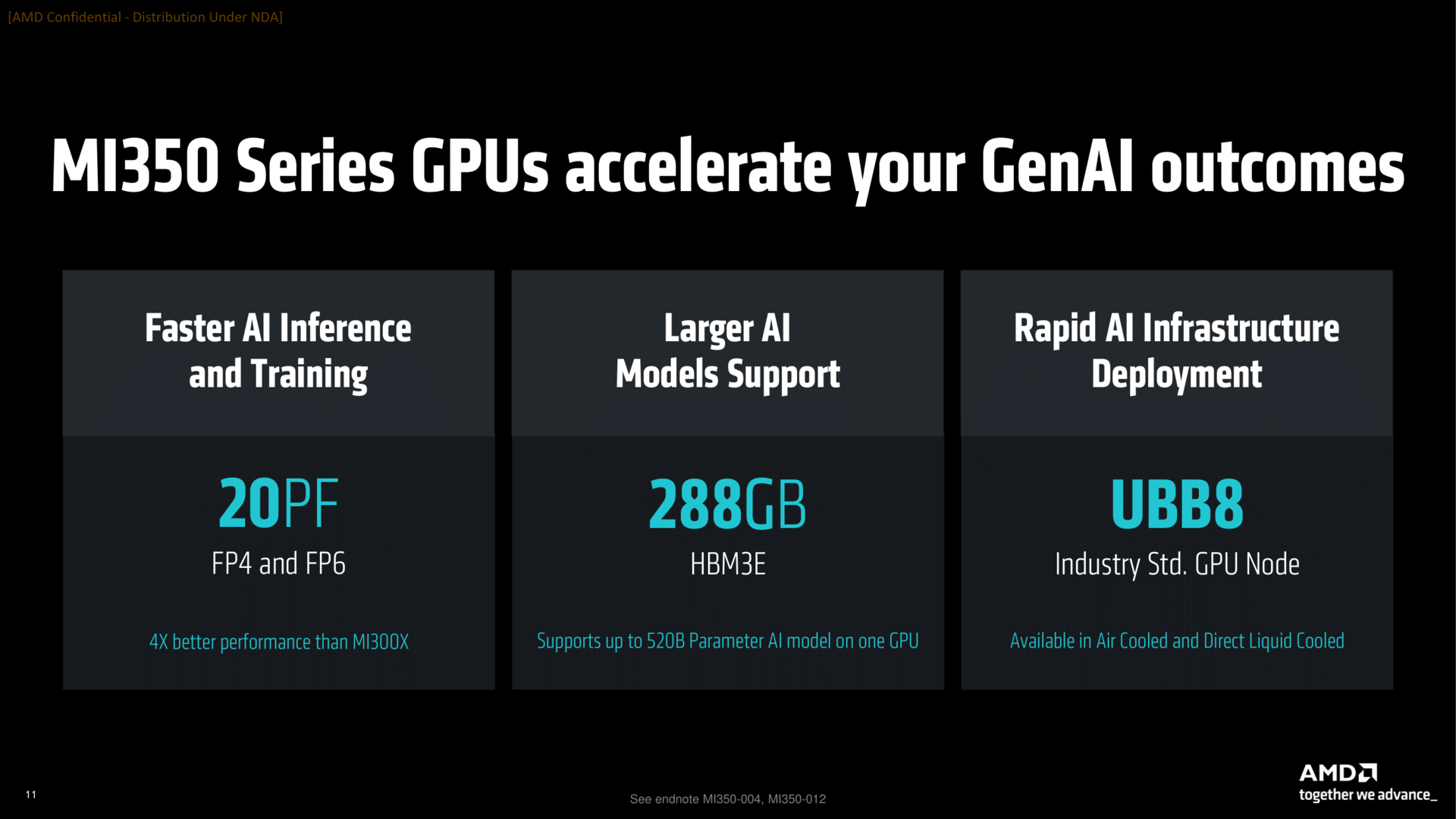

Die MI350-Serie setzt sich aus den Modellen Instinct MI350X und Instinct MI355X zusammen, die sich in der maximal zulässigen TDP unterscheiden. Der grundlegende Aufbau ist gleich, hat gegenüber den letzten Generationen aber einen Umbau erfahren.

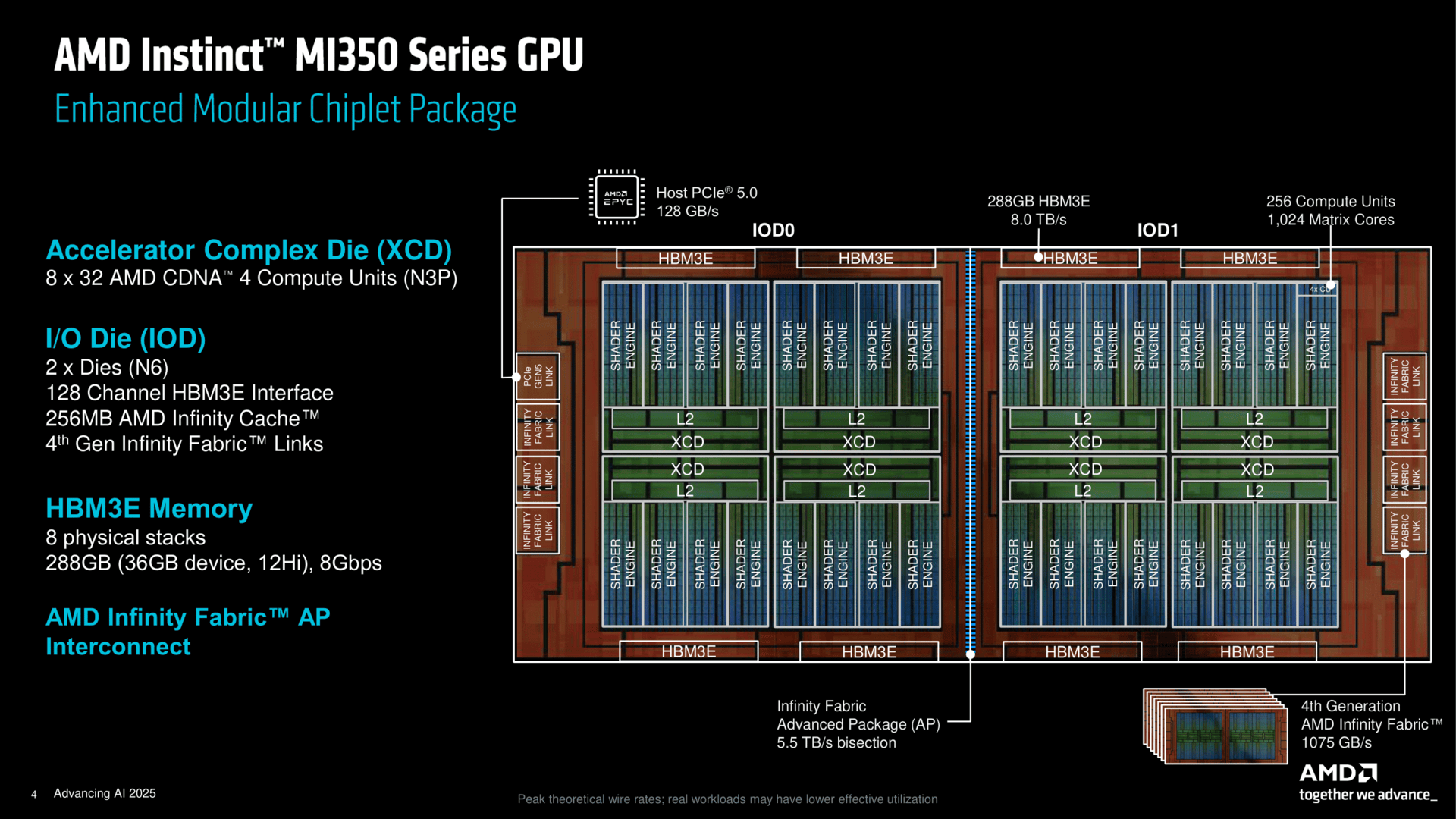

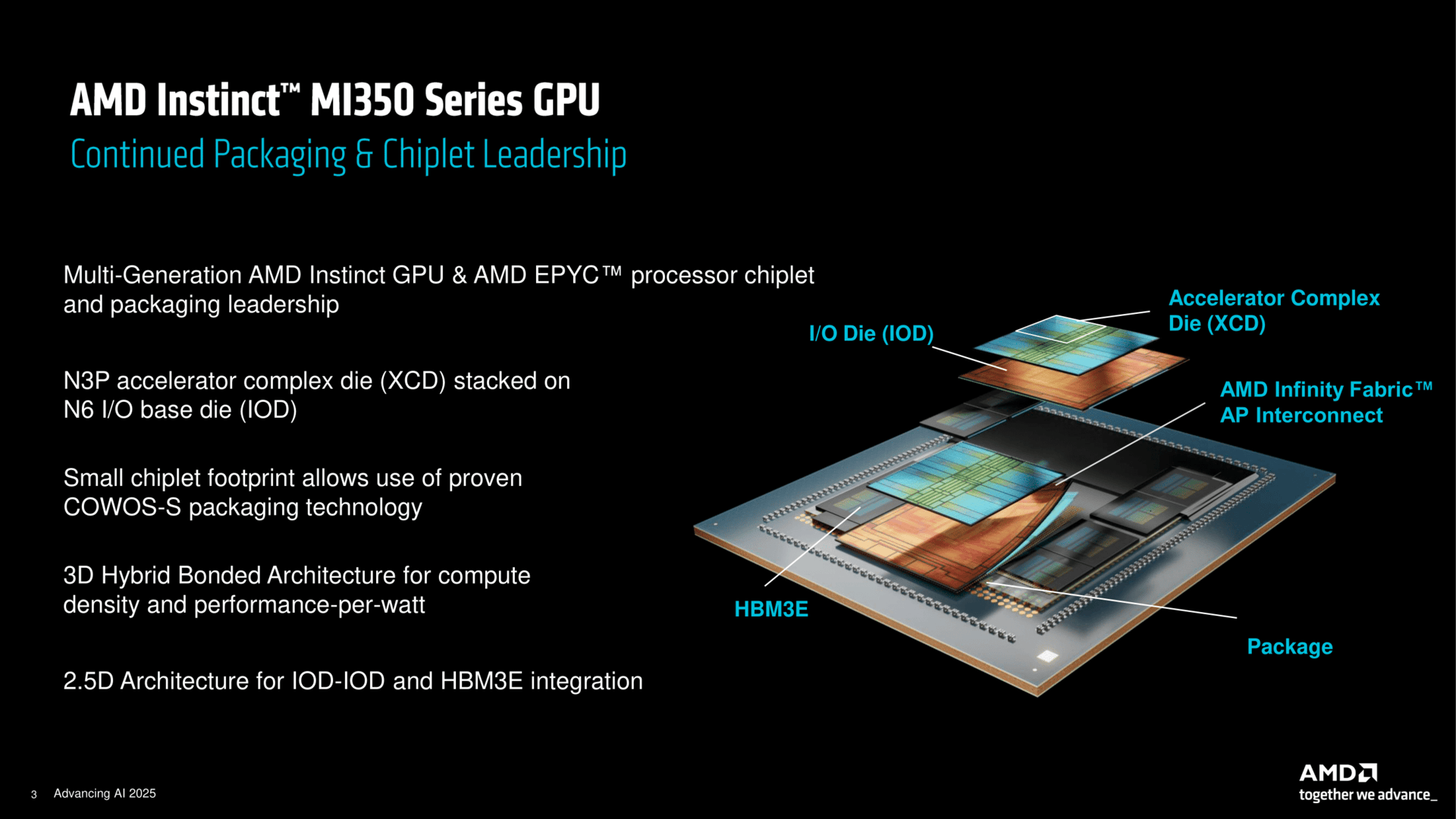

8 N3P-XCDs auf 2 N6-IO-Dies flankiert von HBM3E

In Grundzügen baut Instinct MI350 erst einmal auf das zuletzt bereits bekannte Produkt auf. Wie bei MI300 aus dem Jahr 2023 wird für die Base-Dies, also quasi die Bodenplatten, TSMCs N6-Fertigung genutzt. Der Base-Die fungiert dabei – ebenfalls wie bisher – auch als IO-Die (IOD) mit 256 MB AMD Infinity Cache und dem HBM3E-Speicherinterface. Es gibt bei MI350 allerdings zwei jetzt deutlich größere IODs, zuvor waren es vier.

Mittels TSMCs CoWoS-S-Verfahren werden erneut acht Accelerator Complex Die (XCD) aus TSMCs fortschrittlicher N3P-Fertigung darauf gestapelt, jeweils vier pro IOD. Zuvor waren es jeweils zwei auf den vier IODs. An den Seiten wird der Speicher platziert. Dass AMD dabei weiterhin das SoIC-Verfahren nutzt, welches auch X3D-Caches auf CPU-Dies stapelt, hilft laut AMD, das gesamte CoWoS-Package etwas kleiner zu halten. Dies wiederum hilft am Ende der Ausbeute.

CDNA 4 statt CDNA 3 in den XCDs

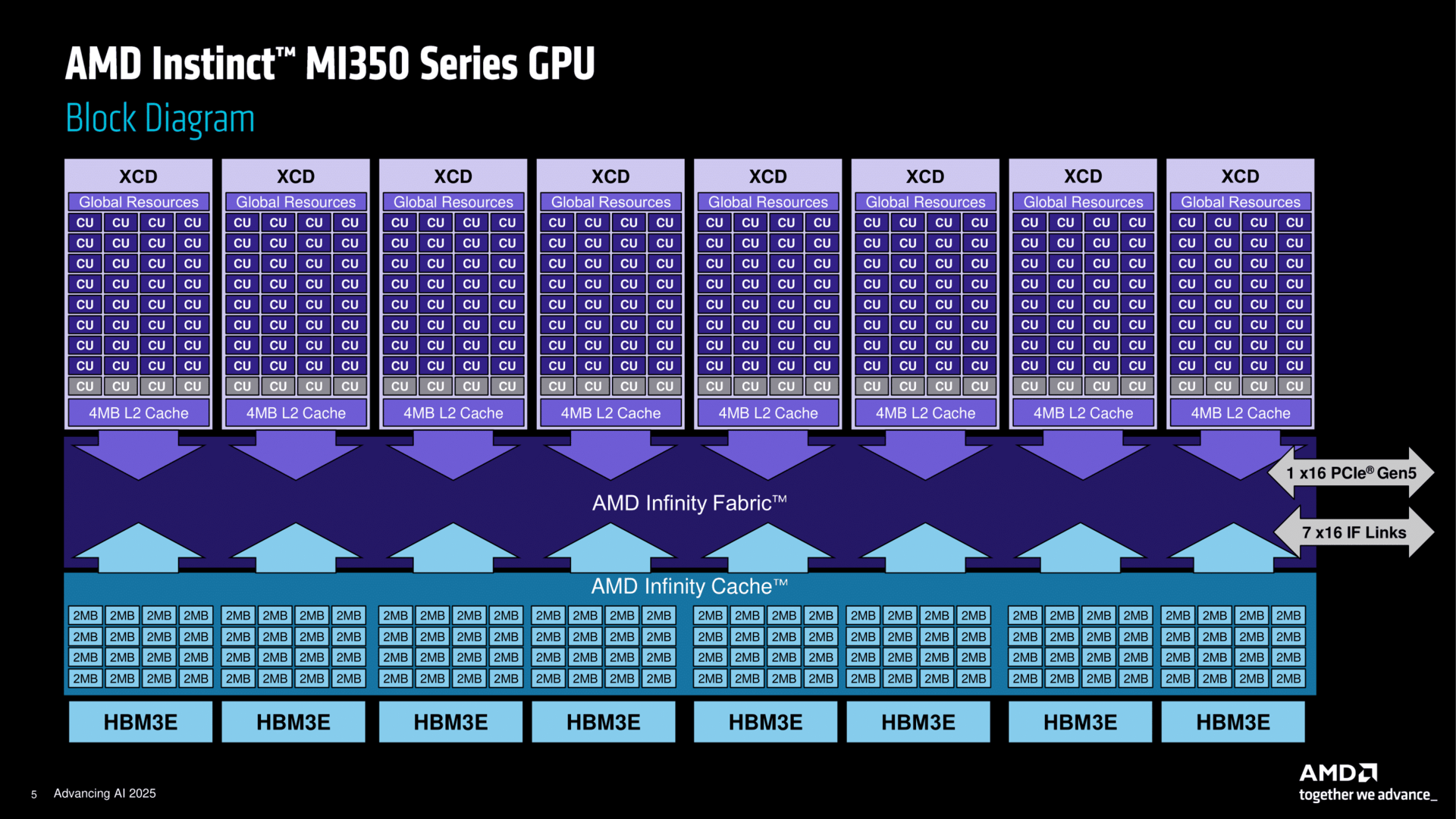

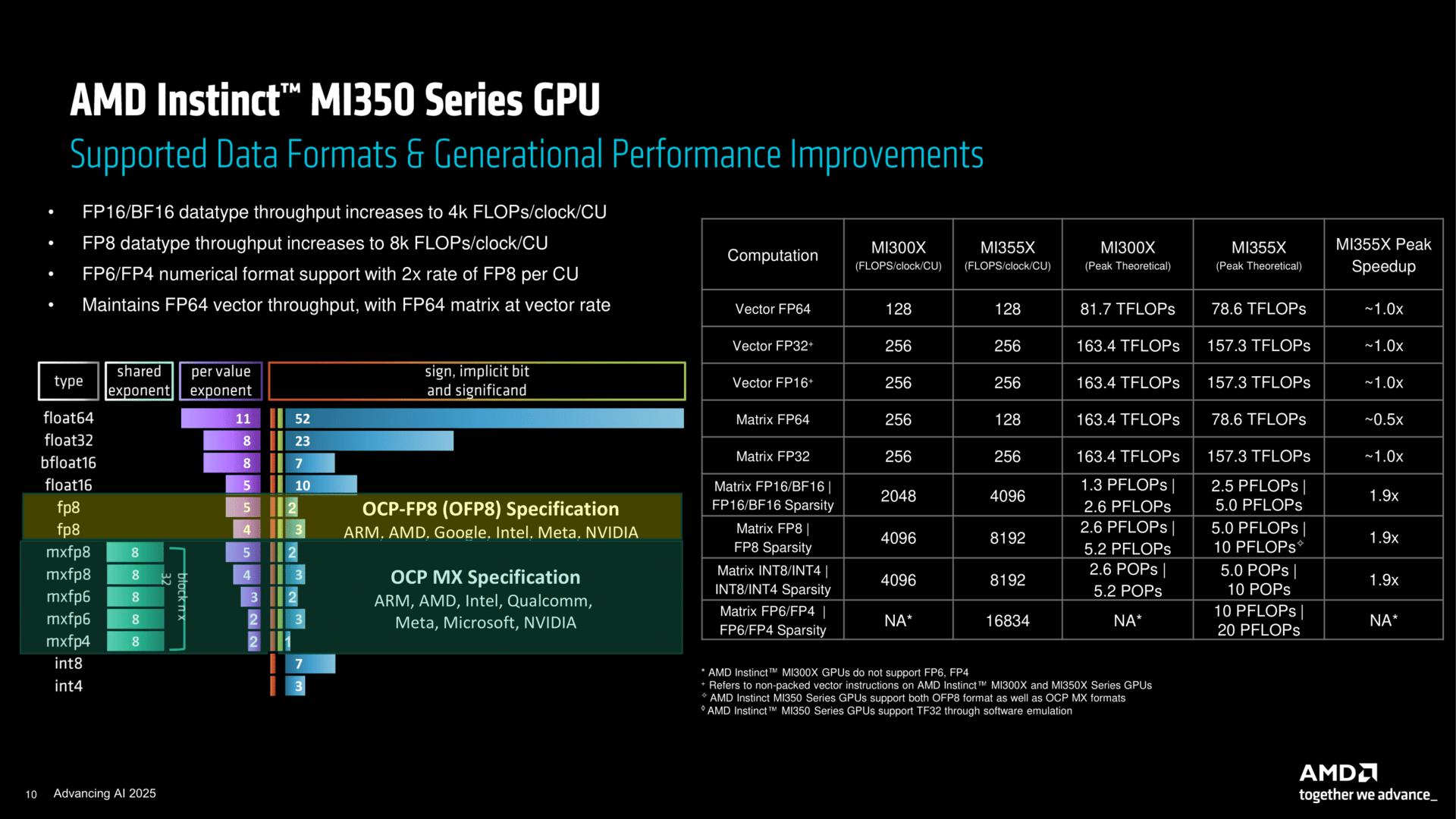

In einem XCD sind fortan 32 CUs nach neuer CDNA-4-Architektur zu finden, zuvor waren es 38 CUs CDNA 3. CDNA 3 wurde eher mit dem Fokus auf HPC und nebenbei AI ausgelegt, CDNA 4 schwenkt nun eher auf den AI-Zweig ein, ohne dabei aber HPC völlig fallen zu lassen, so AMD.

Die beiden IODs haben bei Instinct MI350 eine viel breitere Verbindung untereinander, bis zu 5,5 TByte pro Sekunden können hier ausgetauscht werden. Die Verbindung zu Außenwelt wird hingegen weiterhin über 4th Gen Infinity Fabric gelöst, sieben Links gibt es dafür, zusätzlich eine PCIe-5.0-x16-Schnittstelle. Aber das hatte auch MI300X bereits.

Deutliche Effizienzsteigerung

Bis zu 1.000 Watt (MI350X) oder gar bis zu 1.400 Watt (MI355X) dürfen die neuen Instinct-Lösungen verbrauchen, trotzdem sollen sie viel effizienter arbeiten als MI300X. Dabei hilft natürlich der Wechsel von der N5-Fertigung auf den aktuell besten N3P-Prozess von TSMC, der viel mehr Leistung bei geringerem Energiebedarf verspricht. Aber auch statt auf vier IO-Dies auf nur noch zwei zu setzen hilft laut AMD, denn so müssen die Daten nicht zwischen vier Chips hin und her wandern, sondern nur noch zwischen zwei – und diese Inter-Die-Kommunikation kostet viel elektrische Leistung.

Hersteller-Benchmarks

Die bereits von der ISC 2025 bekannt gewordenen Leistungswerte haben sich zur Präsentation in den USA ebenfalls bestätigt. AMD greift für die eigenen Angaben wie Nvidia nun zu Sparsity-Werten, um die maximale Peak-Leistung anzugeben. Diese ist doppelt so hoch wie zuvor bekannt wurde, dabei handelte es sich aber um die nach wie vor gültigen Leistungswerte ohne Sparsity. Insofern waren AMDs Prognosen aus dem letzten Jahr genau so korrekt wie die Werte vom Dienstag.

Die Besonderheit bei AMD ist und bleibt, dass FP64-Leistung nicht zugunsten der geringeren Genauigkeit geopfert wird. Bei AI ist FP8 bis hinab zu FP4 stark gefragt, AMD und Partner machten am Dienstag in Hamburg zu ISC 2025 aber auch klar, dass es ohne FP64 vor allem im wissenschaftlichen Bereich nicht geht.

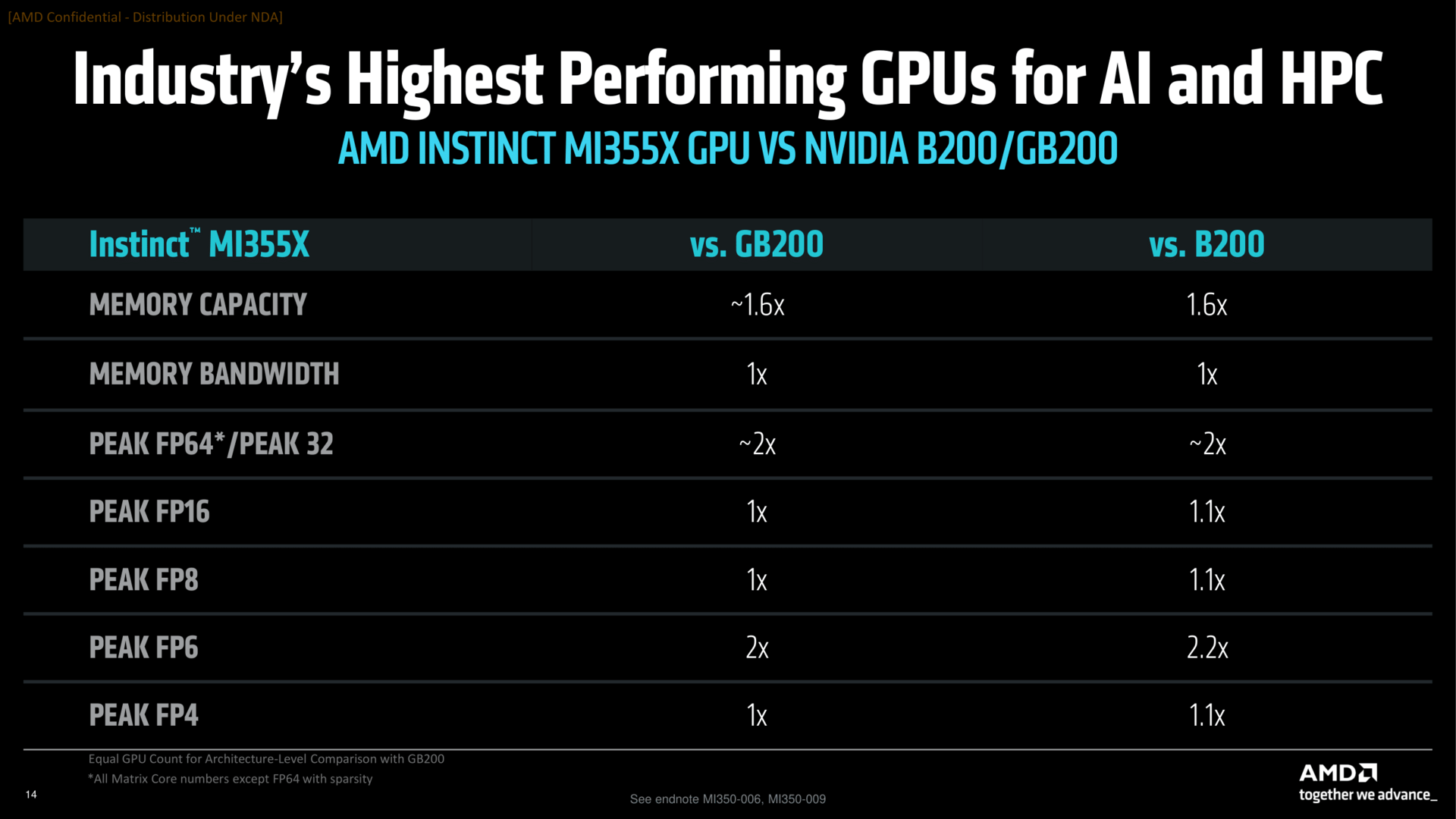

AMD Instinct MI355X vs. Nvidia B200/GB200

Nvidias aktuelle Lösung im Markt ist noch B200 respektive GB200, wenngleich GB300 vor der Auslieferung steht. Instinct MI355X zeigt gegenüber dem zuerst genannten Konkurrenten auf dem Papier gute Werte, die Theorie stimmt für AMD einmal mehr.

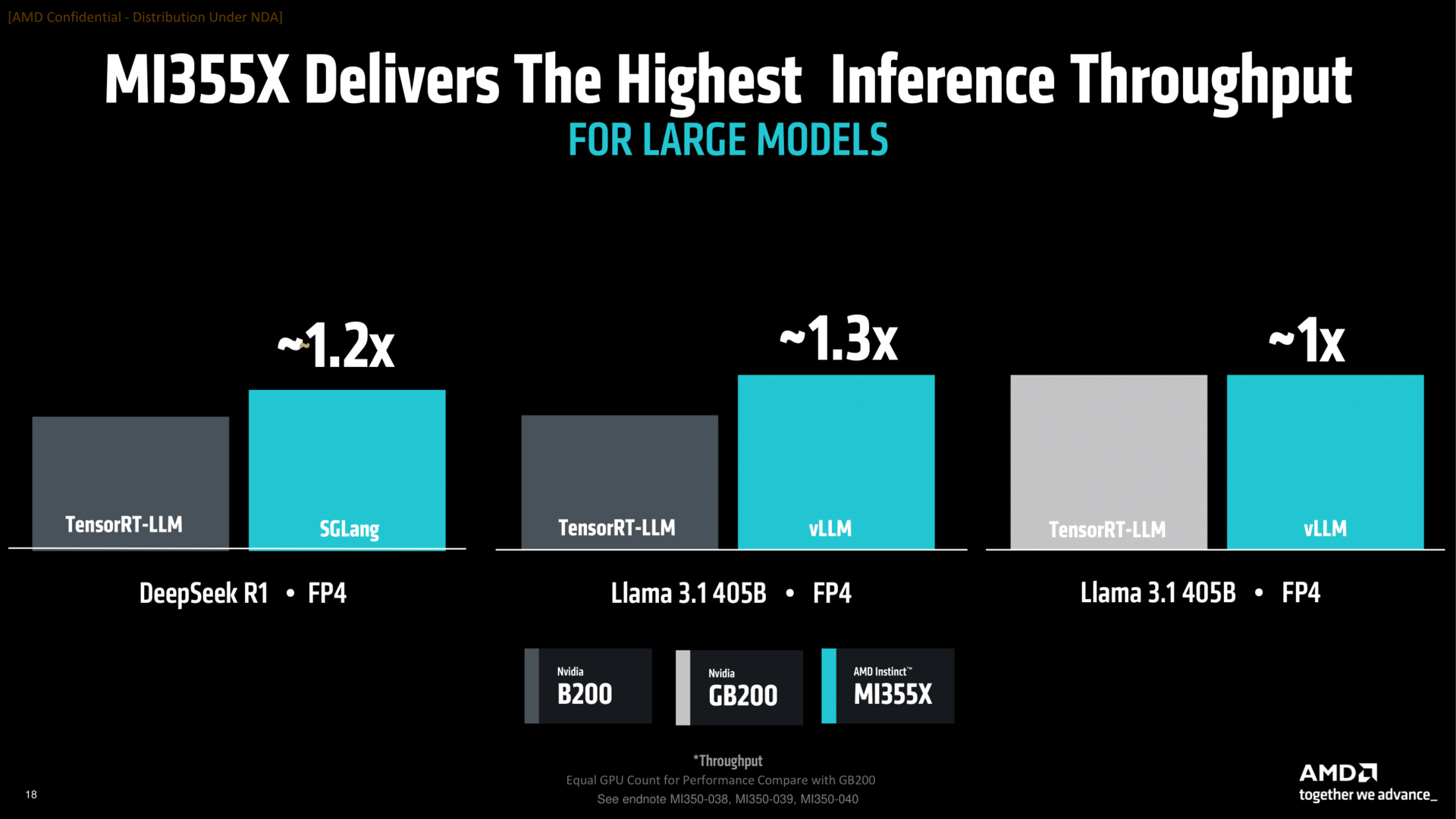

Aber es kommt wie üblich extrem auf das Szenario an. Hier dürften sich AMD und Nvidia in Zukunft erneut um die Benchmark-Hoheit streiten: Jeder sieht sich selbst in Front. AMD stellt vor allem Inference (Nutzung von trainierten AI-Modellen, kein AI-Training) in den Fokus, hier kann MI355X gegenüber B200 glänzen, vor allem, wenn dann auch noch der Preis berücksichtigt wird. Wie immer gilt zu beachten, dass dies Herstellerbenchmarks sind, die stets das beste zeigen.

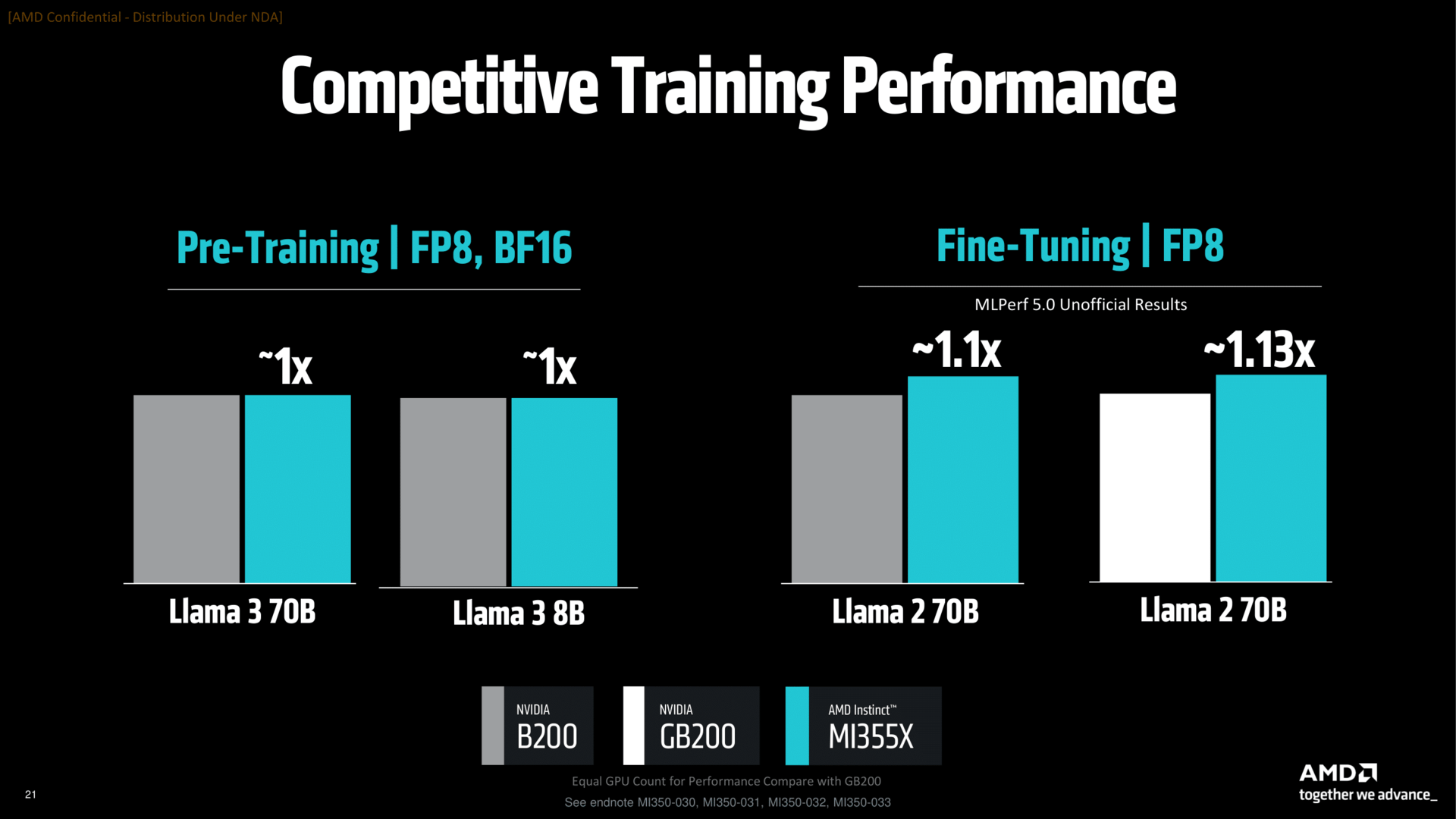

Bei Training wird das ganze Thema ausgeglichener – hier dürfte Nvidia vermutlich zuerst kontern und zeigen, dass man selbst noch weit vorn liegt. Aber auch hier heißt es stets, dass Herstellerwerte nur das beste zeigen.

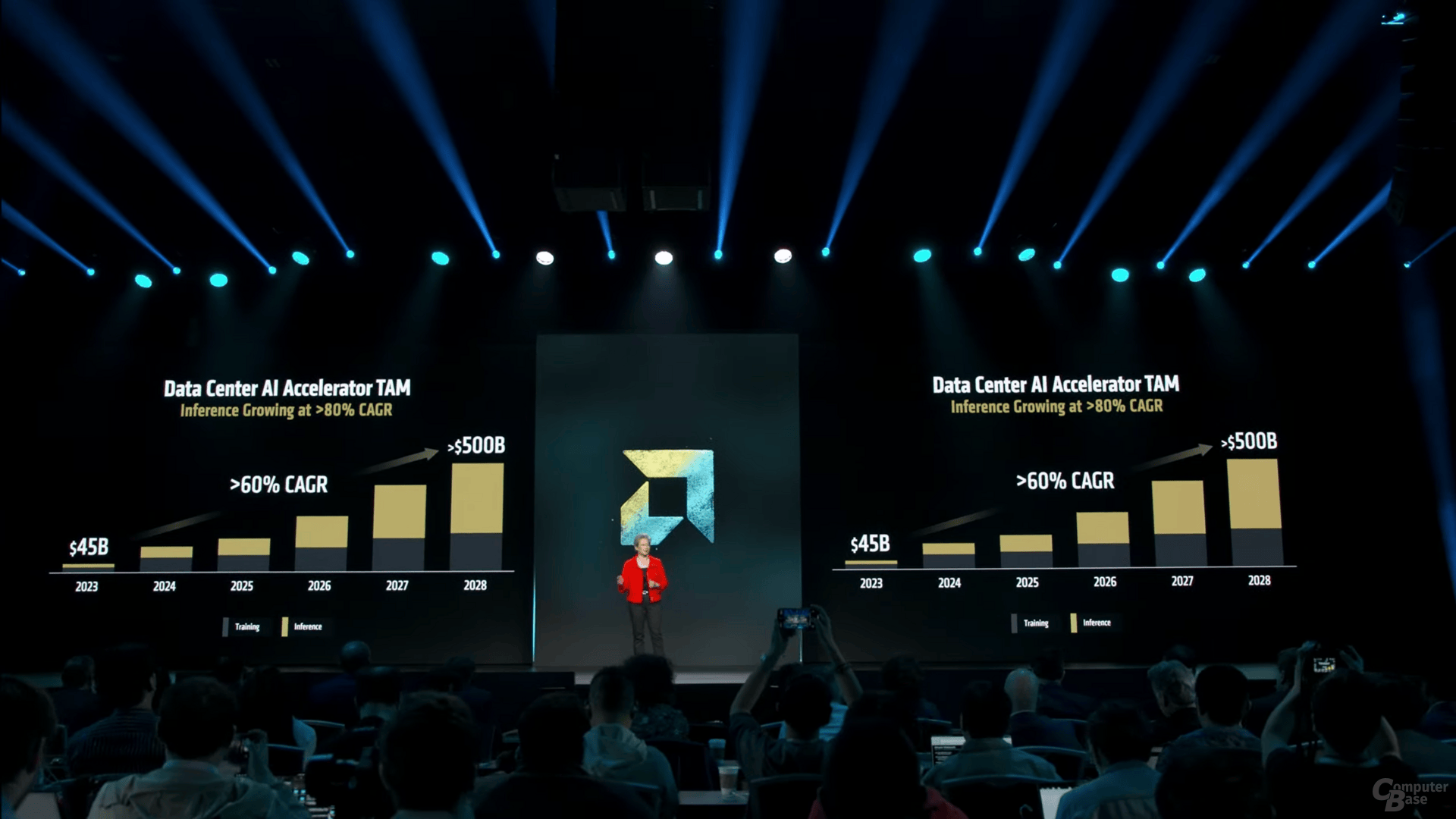

Inference wird aber auch in Zukunft das Thema sein, welches AMD favorisiert – hier sieht man die besten Wachstumschancen.

Ein weiterer Schritt zum Großprojekt

AMD Instinct MI350 ist unterm Strich eine Evolution in der MI300-Familie. Auch deshalb ging AMD den Schritt in die nächste echte Generation hier und heute nicht. Das nächste große Ding ist MI350 noch nicht, MI400 soll es dann wirklich sein – einen ersten Ausblick hat AMD in den USA am Abend ebenfalls präsentiert.

ComputerBase wurde von AMD zum Event Advancing AI 2025 nach San Jose in die USA eingeladen, hat die Einladung aus Termingründen aber ausgeschlagen. Die Redaktion erhielt dennoch alle Präsentationen und Informationen unter NDA vorab. Die einzige Vorgabe war der frühestmögliche Veröffentlichungstermin.

Apps & Mobile Entwicklung

Wuchang: Fallen Feathers im Benchmark-Test

Mit Wuchang: Fallen Feathers ist ein neues Soulslike-Spiel erfolgreich gestartet. ComputerBase hat die PC-Version im Benchmark-Test. Das Spiel stellt sehr hohe Anforderungen an die Grafikkarte, die gar nicht so einfach zu bewältigen sind.

Wuchang: Fallen Feathers: Die Technik der PC-Version

Das neue Wuchang: Fallen Feathers hat unglaublich viele Gemeinsamkeiten mit dem knapp ein Jahr alten Black Myth: Wukong (Test). Beide Spiele stammen von einem chinesischen Entwickler, es handelt sich bei beiden um einen Soulslike-Titel, beide haben denselben Grafikstil, beide nutzen eine ältere Version der Unreal Engine 5 und beide haben diese nach den eigenen Wünschen angepasst.

Auch davon abgesehen gibt es weitere Gemeinsamkeiten, zum Beispiel dass beide Spiele enorme Anforderungen an die Grafikkarte stellen – mehr dazu später. Zuerst ein Wort zur Grafik: Wuchang: Fallen Feathers nutzt die Unreal Engine 5.1, hat diese aber um eigene Features beziehungsweise welche aus neueren UE5-Versionen erweitert. Was es nicht ins Spiel geschafft hat, ist allerdings Hardware-Raytracing. Der Titel beschränkt sich für die Beleuchtung sowie die Reflexionen auf das bekannte Software-Lumen.

Die Grafik von Wuchang: Fallen Feathers ist insgesamt gelungen, vor allem die Umgebungen sehen schick aus. Insbesondere das Anfangsgebiet macht einiges her. Positiv hervorzuheben ist darüber hinaus das Gegnerdesign, das wirklich sehr gelungen ist. Beim eigenen Spielecharakter fällt die Qualität hingegen ab, allen voran beim Animationssystem, das ziemlich steif agiert und nicht mit der restlichen Qualität mithalten kann.

Ohne Intel XeSS (und FSR 4), aber mit TSR als Ersatz

Wuchang: Fallen Feathers kann seinen Grafikhunger effektiv mit Upsampling stillen, das für einen guten Spielfluss auch essenziell ist und aggressiv genutzt werden muss – denn die Grafikoptionen bringen nur eine bedingte Mehrleistung und dafür müssen diese stark reduziert werden. Im Spiel finden sich DLSS 4 mit dem Transformer-Model sowie FSR 3.1 wieder, während für FSR 4 noch der Treiber-Support fehlt. Für DLSS und FSR gibt es auch Frame-Generation sowie Multi Frame Generation. Intel XeSS fehlt vollständig, als Ersatz gibt es das UE-eigene TSR.

Upsampling (Nvidia DLSS / AMD FSR) in der Analyse

Bevor es an die Beurteilung geht, noch eine Anmerkung: Wuchang: Fallen Feathers bietet beim Upsampling nicht die gewohnten Qualitätseinstellungen wie „Quality“ oder „Performance“, sondern einen Prozent-Slider, der in 1-Prozent-Schritten von 25 auf 100 Prozent gestellt werden kann, und der sich auf die Renderauflösung bezieht. 100 Prozent bedeuten somit native Auflösung, 67 Prozent Quality, 58 Prozent Balanced und 50 Prozent Performance. Theoretisch sind damit auch zahlreiche Zwischenstufen einstellbar, doch reagiert das Spiel einzig auf die gewohnten Leistungsmodi: Wer zum Beispiel 55 Prozent einstellt, erhält trotzdem den Performance-Modus und damit 50 %.

Was nicht möglich ist, ist den gewählten Upsampling-Algorithmus abzuwählen. Entweder DLSS, FSR oder TSR sind immer aktiv, eine klassische TAA-Kantenglättung gibt es nicht. Das ist in Unreal-Engine-Spielen gar nicht so selten der Fall.

DLSS 4 ist der klare Gewinner

Der Upsampling-Gewinner ist schnell gefunden: Nvidia DLSS 4 dreht wenig verwunderlich Kreise um die versammelte Konkurrenz, da der Hauptgegner, AMD FSR 4, aktuell noch nicht unterstützt wird. Der Super-Resolution-Algorithmus arbeitet sehr effektiv und mit kaum Schwächen, kann darüber hinaus auch problemlos in aggressiven Einstellungen genutzt werden. DLSS Performance macht auch in WQHD noch einen guten Job, erst in Full HD sollte die Qualitätsstufe auf Quality hochgestellt werden, da es ansonsten zu einem sichtbaren Qualitätsverlust kommt.

FSR 3.1 macht die klassischen „FSR-3.1-Dinge“, ganz gleich in welcher Auflösung und Qualitätseinstellung der Algorithmus genutzt wird. FSR hat stark mit Problemen bei der Bildstabilität zu kämpfen, darüber hinaus gibt es sichtbar Disocclusion-Artefakte, eine starke Verpixelung bei manchen Effekten und ein generell unscharfes Bild. FSR 3.1 ist nicht empfehlenswert.

Die alternative, TSR, ist qualitativ in eigentlich allen Belangen deutlich überlegen. Die Bildstabilität ist deutlich besser, die Disocclusion-Problematik kaum ausgeprägt und die Verpixelung findet kaum statt. Trotz allem Lob ist DLSS 4 jedoch in allen Belangen weit überlegen, denn das Bewegtbild weist eine vergleichbare Unschärfe zu FSR auf. In Ultra HD funktioniert die Performance-Einstellung von TSR dennoch gut, in geringeren Auflösungen muss aber mit sichtbaren Problemen gerechnet werden.

FSR 4 geht auch jetzt schon – mit sehr gutem Ergebnis

Immerhin, eine gute Nachricht für Besitzer einer Radeon-RX-9000-Grafikkarte gibt es: AMDs Treiber ist zwar nicht nicht so weit, FSR 4 wird nicht unterstützt. Mittels des Tools Optiscaler (Download) lässt sich FSR 4 aber auch jetzt schon problemlos auf einer RDNA-4-Grafikkarte aktivieren und das Ergebnis ist durchweg positiv. Die Bildqualität überholt FSR 3.1 und TSR in allen Lebenslagen bei Weitem und spielt in der Liga von DLSS 4. Ob die Qualität tatsächlich vergleichbar ist, hat die Redaktion aber nicht im Detail überprüft. Es gilt auf jeden Fall auch mit FSR 4: Der Performance-Modus kann inklusive WQHD problemlos genutzt werden.

Widescreen im Kurz-Test

Die meisten Spiele unterstützen heute die beliebten Widescreen-Formate, alle Titel aber noch nicht – oder nicht korrekt. ComputerBase hat folgende 2 Screenshots in der Auflösung 3.440 × 1.440 (UWQHD) sowie 2.560 × 1.440 (WQHD) aufgenommen, was dem 21:9- und dem klassischen 16:9-Format entspricht. Daran lässt sich erkennen, wie das Spiel mit Widescreen-Auflösungen umgeht.

Die offiziellen Systemanforderungen

Die Ladezeiten

Manche Spiele laden unglaublich schnell, andere wiederum benötigen eine schiere Ewigkeit. Mit einer Stoppuhr ausgestattet, misst die Redaktion die Ladezeiten ins Hauptmenü und von dort in die Testsequenz. Da Ladezeiten variieren können, wird dies insgesamt dreimal durchgeführt und ein Durchschnitt gebildet. Zwischen jedem Versuch wird der Rechner neu hochgefahren, sodass keine Dateien mehr im Cache liegen. Falls es überspringbare Intros oder Videosequenzen gibt, werden sie weggeklickt, denn nur die reine Ladezeit ist wichtig. Sofern das Spiel vorab bemerkbar einmalig Shader kompiliert, wird dieser Lauf nicht in die Rechnung einbezogen. Die Zeit der Shader-Erstellung wird separat angegeben.

Dabei ist zu bedenken, dass ComputerBase einen High-End-PC besitzt, der unter anderem mit einem Ryzen 7 9800X3D und einer Seagate FireCuda 530 als PCIe-4.0-fähige NVMe-SSD ausgestattet ist. Auf den meisten Systemen werden die Ladezeiten länger ausfallen. Die Werte dienen nur zur Orientierung.

Offizielle Steam-Deck-Kompatibilität

Wenn Spiele auf der Plattform Steam erscheinen, laufen sie auch oft auf dem Steam Deck. Zwar hat die Redaktion bei Technik-Tests nicht immer die Möglichkeit, die Performance auf der tragbaren Konsole zu überprüfen, doch gibt Steam bei den Titeln auch stets eine generelle Einordnung der Kompatibilität an. Aktuell hat Valve aber noch keine Einordnung zur Steam-Deck-Kompatibilität für Wuchang: Fallen Feathers bekanntgegeben.

Apps & Mobile Entwicklung

MediaMarkt und Saturn: JD.com aus China übernimmt Europas größten Einzelhändler

Ceconomy, der Konzern hinter MediaMarkt und Saturn, hat eine Investorenvereinbarung mit dem E-Commerce-Riesen JD.com aus China unterzeichnet. Die Gerüchte der letzten Tage zu einer Übernahme zu einem Preis von 4,60 Euro je Aktie bewahrheiten sich. JD.com ist nach eigenen Angaben mit 57,1 Prozent bereits Hauptanteilseigner.

JD.com hat wie erwartet angekündigt, ein freiwilliges öffentliches Übernahmeangebot für alle Ceconomy-Aktien zu einem Angebotspreis von 4,60 Euro pro Aktie in bar zu unterbreiten. Ceconomy kommt zu diesem Preis auf eine Bewertung von rund 2,2 Milliarden Euro. JD.com hat bereits verbindliche Zusagen für rund 32 Prozent des Aktienkapitals erhalten, darunter von den Aktionären Haniel, Beisheim, Freenet und Convergenta, die zusammen 27,9 Prozent der Anteile an der MediaMarktSaturn-Mutter halten. Convergenta, die Beteiligungsgesellschaft der

Gründerfamilie Kellerhals, wird nach dem öffentlichen Übernahmeangebot einen Anteil

von rund 25,4 Prozent behalten – sie bleibt somit ein wichtiger Aktionär und gibt nur 3,81 Prozent ihrer Anteile ab.

Schnelleres Wachstum durch Expertise von JD.com

JD.com wird nach eigenen Angaben „seine fortschrittliche Technologie, seine führende Omnichannel-Handelsexpertise sowie seine internationalen Lieferketten-, Logistik- und Lagerkapazitäten einbringen“. So sollen „Wachstumsopportunitäten in einem sich dynamisch verändernden Marktumfeld vollumfänglich“ genutzt werden.

Mit JD.com soll die Digitalisierung des Kerngeschäfts von Ceconomy vorangetrieben, die Technologieplattform weiterentwickelt und die Logistiknetzwerke und das Lieferkettenmanagement verbessert werden, um das Wachstum im digitalen Bereich voranzutreiben. Die IT-Systeme und der Technologiestack von Ceconomy sollen strikt unabhängig bleiben.

Dr. Kai-Ulrich Deissner, CEO von Ceconomy, sagt, dass das Unternehmen mit den Qualitäten und Expertisen von JD.com den „erfolgreichen Wachstumskurs nochmal forcieren und über unsere aktuellen strategischen Ziele hinauswachsen“ könne. „Wir gehen eine Partnerschaft mit JD.com ein, um den europäischen Handel zu stärken“, so Dr. Deissner weiter.

Kurzfristig soll es keine Unternehmensänderungen geben

JD.com hat sich auch dazu verpflichtet, eng mit dem derzeitigen Vorstand von Ceconomy zusammenzuarbeiten, der weiterhin für die Umsetzung der Unternehmensstrategie und das Tagesgeschäft verantwortlich bleibt. JD.com plant auch keine wesentlichen Änderungen an der Unternehmensstruktur, der Organisation oder, für einen Zeitraum von fünf Jahren nach Angebotsvollzug, der Markenarchitektur von Ceconomy – die Marken MediaMarkt und Saturn bleiben somit erst einmal erhalten. Ceconomy mit Zentrale in Düsseldorf bleibt ein unabhängiges Unternehmen. Für einen Zeitraum von drei Jahren nach Angebotsvollzug gibt es darüber hinaus

keinerlei Pläne für den Abschluss einer Beherrschungs- und/oder Gewinnabführungsvereinbarung.

Mitarbeiter sind 3 Jahre geschützt

Das chinesische Unternehmen JD.com wird zudem für mindestens drei Jahre keine betriebsbedingten Kündigungen aussprechen und außerdem die bestehenden Betriebsvereinbarungen, Tarifverträge und die bestehende Unternehmensmitbestimmung im

Aufsichtsrat wahren.

Größter Einzelhändler Europas

Mit den Konzerntöchtern MediaMarkt und Saturn ist Ceconomy Europas größter Einzelhändler für Consumer Electronics und verfügt über mehr als 1.000 stationäre Märkte in 11 europäischen Ländern. Das Unternehmen kommt auf rund 50.000 Beschäftigte und erzielte zuletzt einen Jahresumsatz von 22,4 Milliarden Euro. Das Online-Geschäft trug hierzu 5,1 Milliarden Euro bei.

Die Übernahme soll im ersten Halbjahr 2026 abgeschlossen sein. Kartellrechtliche Hürden sehen die Unternehmen nicht.

Apps & Mobile Entwicklung

Quartalszahlen: Meta übertrifft Erwartungen und schickt Aktie auf Höhenflug

Meta überrascht die Börse mit ausgesprochen guten Quartalszahlen und schickt die Aktie auf Höhenflug. Das Unternehmen hat seinen Umsatz um 22 Prozent steigern können, den Nettogewinn gar um 36 Prozent. Dazu beigetragen hat in erster Linie das Werbegeschäft. Metas Ausgaben für KI-Infrastruktur fallen abermals immens aus.

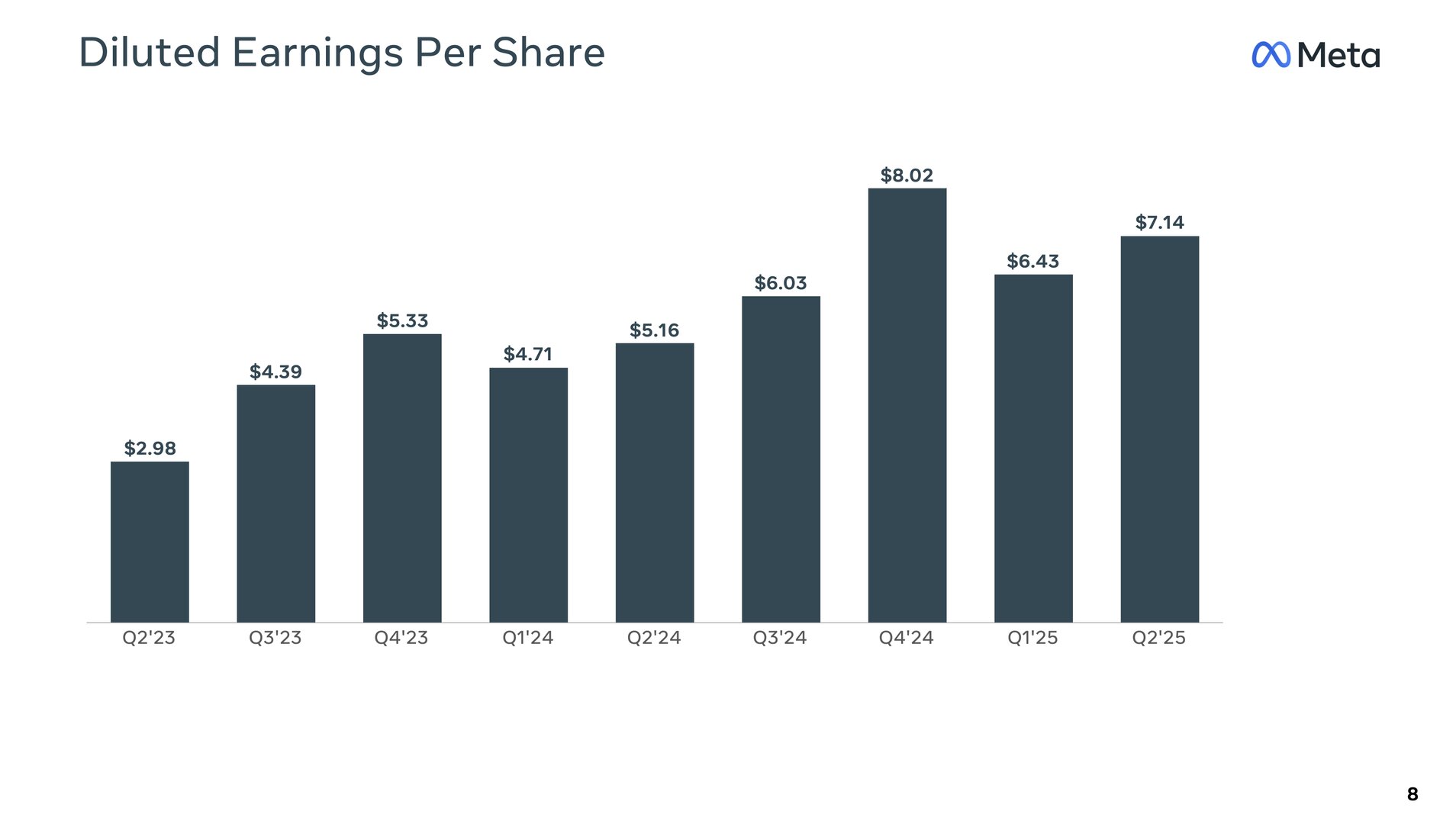

Der Mutterkonzern hinter Facebook, Instagram, Facebook Messenger und WhatsApp hat im zweiten Quartal des Fiskaljahres 2025, das am 30. Juni endete, 47,52 Milliarden US-Dollar eingenommen, was einem Anstieg von 22 Prozent gegenüber dem Vorjahr entspricht. Das operative Einkommen abzüglich Kosten lag bei 20,44 Milliarden US-Dollar, 38 Prozent mehr als im gleichen Zeitraum 2024. Bei einem effektiven Steuersatz von 11 Prozent kam Meta auf einen Nettogewinn von 18,34 Milliarden US-Dollar, was 36 Prozent mehr als 2024 entspricht. Der bereinigte Gewinn pro Aktie beträgt 7,14 US-Dollar (+38 Prozent).

Mehr Nutzer und Einnahmen pro Nutzer

Die Anzahl der Family Daily Active People (DAP), also der täglich aktiven Nutzer innerhalb der Meta-Apps, lag im zweiten Quartal bei 3,48 Milliarden, vor einem Jahr waren es noch 3,27 Milliarden. Den Nutzern wird Werbung ausgespielt, die Metas primäre Einnahmequelle darstellt und vor Kosten 46,56 Milliarden US-Dollar in die Kassen spülte – 98 Prozent des gesamten Umsatzes. Bei 13,65 US-Dollar lag der Family Average Revenue per Person (ARPP), also der Umsatz pro Benutzer im Meta-Ökosystem.

Die Anzahl der Ad Impressions, also der Aufrufe von Werbemitteln von einem Ad-Server, konnte über die verschiedenen Meta-Apps verteilt um 11 Prozent gegenüber dem zweiten Quartal 2024 gesteigert werden. Darüber hinaus ließ sich für jede Werbung ein um 9 Prozent höherer Preis gegenüber dem Vorjahr aufrufen.

Reality Labs mit hohem operativen Verlust

Die Reality Labs mit den Produkten rund um die Quest und das Metaverse erzielten einen Umsatz von 370 Millionen US-Dollar – weit entfernt vom Werbegeschäft oder dem saisonalen Hoch zur Weihnachtszeit, aber immerhin ein Plus von knapp 5 Prozent zum zweiten Quartal 2024. Die Sparte verbucht allerdings weiterhin hohe operative Verluste, diesmal lag der Verlust bei 4,53 Milliarden US-Dollar und damit knapp 1 Prozent höher als im Vorjahr. Die Einnahmen decken nicht die Betriebskosten des Metaverse.

Meta will noch mehr investieren

Zum Abschluss des Fiskaljahres 2024 hatte Meta Ausgaben von bis zu 119 Milliarden US-Dollar für das nächste Jahr in Aussicht gestellt, zuletzt waren die Ausgaben auf 113 bis 118 Milliarden US-Dollar eingegrenzt worden, im aktuellen Quartalsbericht auf 114 bis 118 Milliarden US-Dollar. Getrieben werden die hohen Ausgaben in erster Linie von KI-Infrastrukturinvestitionen, aber auch vom zweitgrößten Posten der Personalkosten. In diesem Zusammenhang kursierten zuletzt immer wieder wahnwitzige Millionensummen für neues Spitzenpersonal durch die Medien.

Infrastruktur rund um KI ist ein signifikanter Kostentreiber für Meta. Das Unternehmen will die Investitionen von zuletzt angegebenen 64 bis 72 Milliarden US-Dollar auf dieses Jahr 66 bis 72 Milliarden US-Dollar und somit am unteren Ende steigern. 30,7 Milliarden US-Dollar hat das Unternehmen seit Anfang des Jahres investiert, für das zweite Halbjahr steht demnach ein noch höherer Betrag an.

Die Börse erfreute sich auch an dem über den Erwartungen liegenden Ausblick auf das dritte Quartal, für das Meta einen Umsatz von 47,5 bis 50,5 Milliarden US-Dollar erwartet – es könnte ein neuer Rekord noch über dem traditionell stärksten vierten Quartal werden, das zuletzt auf 48,4 Milliarden US-Dollar kam. Im Handel hat Metas Aktie aktuell um rund 12 Prozent gegenüber dem gestrigen Schlusskurs zugelegt.

-

Datenschutz & Sicherheitvor 2 Monaten

Datenschutz & Sicherheitvor 2 MonatenGeschichten aus dem DSC-Beirat: Einreisebeschränkungen und Zugriffsschranken

-

Online Marketing & SEOvor 2 Monaten

Online Marketing & SEOvor 2 MonatenTikTok trackt CO₂ von Ads – und Mitarbeitende intern mit Ratings

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenMetal Gear Solid Δ: Snake Eater: Ein Multiplayer-Modus für Fans von Versteckenspielen

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenPhilip Bürli › PAGE online

-

Digital Business & Startupsvor 1 Monat

Digital Business & Startupsvor 1 Monat80 % günstiger dank KI – Startup vereinfacht Klinikstudien: Pitchdeck hier

-

Digital Business & Startupsvor 1 Monat

Digital Business & Startupsvor 1 Monat10.000 Euro Tickets? Kann man machen – aber nur mit diesem Trick

-

Apps & Mobile Entwicklungvor 1 Monat

Apps & Mobile Entwicklungvor 1 MonatPatentstreit: Western Digital muss 1 US-Dollar Schadenersatz zahlen

-

Social Mediavor 2 Monaten

Social Mediavor 2 MonatenLinkedIn Feature-Update 2025: Aktuelle Neuigkeiten