Apps & Mobile Entwicklung

Cooler Master NR200P V3: SFF-Gehäuse wird mit L-Mesh aktualisiert

Die dritte Generation des SFF-Gehäuses Cooler Master NR200P optimiert die Kühlung und aktualisiert die Technik. Das Design wird beim V3 im gleichen Zuge deutlich auffälliger und folgt dem gegenwärtigen Trend-Look mit L-Mesh.

Das Cooler Master NR200P V2 (Test) war im Prinzip die „Schuhkasten-Box“, mit rund 20 Liter Volumen und Platz für große Grafikkarten. Daran ändert sich gar nicht viel. Minimal andere Abmessungen und vor allem ein neu gestaltetes Äußeres heben das V3 allerdings deutlich von seinem Vorgänger ab.

Dazu gehört vor allem das Seitenelement, das seine Luftöffnungen nun durch ein Mesh-Gitter auf Höhe der Grafikkarte ersetzt – und dieses auch bis zur Front laufen lässt, die nun aus einem einzigen, gebogenen Panel besteht. Diese nun aus einem Element bestehende Außenhülle gibt es alternativ auch mit Sichtfenster.

Millimeter-Änderungen

Damit die Grafikkarte über das Seitenteil atmen kann, bleibt sie wie im V2 um 90 Grad gedreht, das nötige Riser-Kabel aktualisiert Cooler Master auf PCIe 5.0. Die GPU darf weiterhin rund 360 Millimeter lang und 160 Millimeter hoch bauen, die mögliche Breite sinkt allerdings von 80 auf 78,5 Millimeter (3,8 Slots).

Der gewonnene Platz im Gehäuse kommt dem CPU-Kühler zu Gute, der nun statt 67 Millimeter 70 Millimeter hoch werden darf. Das ist im Mini-Segment bei Top-Blow-Modellen keine insignifikante Änderung – ein paar Millimeter mehr schaffen zumindest bei Luftkühlern hinter der Grafikkarte mehr Raum zum Ansaugen von Luft.

Lüfter können im Deckel, wo maximal ein 280-mm-Radiator Raum findet, sowie am Boden montiert werden, wobei dort bei Vollbestückung ein 3,5″-Montageplatz verloren geht. Zudem können an der Unterseite lediglich 15 Millimeter hohe Ventilatoren verbaut werden. Mitgeliefert wird allerdings kein einziger Lüfter. Das SFX-Netzteil bleibt hinter der Front, hinter der Frontblende zudem der 2,5/3,5″-Montageslot für Datenträger.

Im Handel wird das NR200P V3 noch nicht geführt. Auch zum Preis schweigt Cooler Master noch. Anzunehmen ist allerdings aufgrund des ähnlichen Aufbaus und der vergleichbaren Ausstattung, dass die Preisempfehlung des Vorgängers von rund 120 Euro gehalten wird.

Apps & Mobile Entwicklung

WD_Black SN7100X: Das „X“ steht für Xbox-Ally-Lizenz, sonst ändert sich nix

Gerade erst fiel der Startschuss für Vorbestellungen der Xbox-Handheld-Konsolen ROG Xbox Ally und ROG Xbox Ally X, schon folgen die ersten Speicherprodukte mit offizieller Lizenz. SanDisk verpasst der WD_Black SN7100 dafür einfach ein „X“ und so wird sie zur WD_Black SN7100X. Eine microSD-Karte gibt es obendrein.

Aus SN7100 wird SN7100X

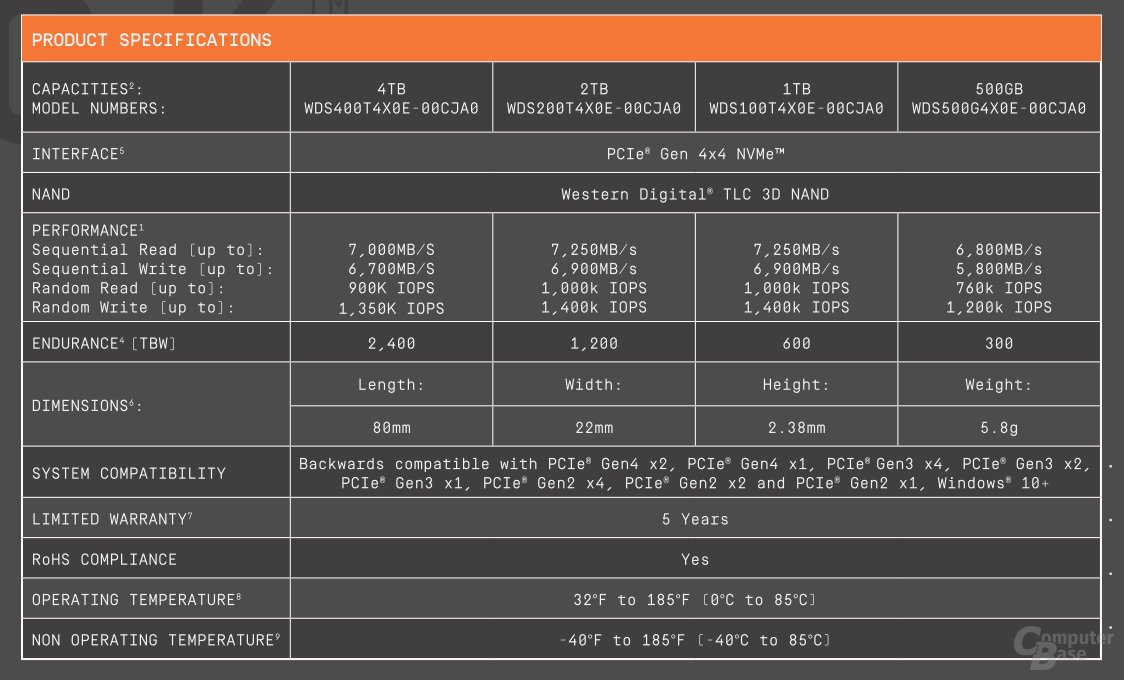

Bei der heute vorgestellten WD_Black SN7100X handelt es sich um die bisherige WD_Black SN7100 wie der Vergleich der Datenblätter mit identischen Spezifikationen aufzeigt. Das „X“ steht lediglich für die offizielle Lizenzierung für den Einsatz in ROG Ally (X). Die Serie ist zudem auf Modelle mit 2 TB und 4 TB begrenzt.

Die Preise der SN7100X im Hersteller-Shop liegen zur Stunde bei 143 Euro für 2 TB und 275 Euro für 4 TB. Die SN7100 ohne Xbox-Lizenz liegt bei 134 Euro für 2 TB und 270 Euro für 4 TB.

Ob mit oder ohne „X“: Die PCIe-4.0-SSDs besitzen einen 4-Kanal-Controller ohne eigenen DRAM-Cache und setzen auf den schnellen und effizienten BiCS8-TLC-Flash von SanDisk.

Es spricht aber nichts dagegen, eine beliebige andere SSD im Formfaktor M.2 2280 im ROG Xbox Ally (X) einzusetzen, die PCIe und NVMe unterstützt.

Eine Speicherkarte gibt es auch

Außerdem legt SanDisk microSD-Karten mit Xbox-Ally-Lizenz neu auf. Diese sind mit 512 GB, 1 TB oder 2 TB Speichervolumen zu Preisen von 58 Euro, 120 Euro oder 240 Euro erhältlich. SanDisk verspricht bis zu 200 MB/s beim Lesen und 140 MB/s beim Schreiben.

Auch für Nintendo Switch lizenzierte Speicherkarten hat SanDisk im Programm. Technisch unterscheiden sich diese nicht vom herkömmlichen Portfolio. Zum kleinen Aufpreis erhält der Kunde auch hier nur die absolute Gewissheit, dass der Speicher mit der jeweiligen Spielkonsole funktioniert. Es können aber selbstverständlich auch kompatible Speicherkarten ohne Lizenz eingesetzt werden. Das bestätigt übrigens SanDisk selbst auf seinen Produktseiten.

Apps & Mobile Entwicklung

Lidl verkauft ab Mittwoch einen Akku-Bohrschrauber mit Zubehör unter 30 Euro!

Ein Blick in den aktuellen Lidl-Prospekt kann sich wirklich lohnen. Denn ab Mittwoch verkauft der Discounter ein Werkzeug, dass Euch nicht nur den Aufbau von Möbeln deutlich einfacher macht, sondern direkt mit passendem 20-V-Akku angeboten wird. Allerdings müsst Ihr hier wirklich schnell sein.

Der Discounter Lidl bringt unter der Eigenmarke Parkside, die mittlerweile sogar mit dem bekannten Terminator-Schauspieler und ehemaligem US-Senator Arnold Schwarzenegger wirbt, regelmäßig Werkzeug in die deutschen Märkte. Auch Online findet sich eine große Bandbreite der Geräte, die vor allem bei Heimwerkern aufgrund des guten Preis-Leistungs-Verhältnisses äußerst beliebt sind. Ab Mittwoch legt Lidl allerdings nochmal einen drauf. Denn im aktuellen Lidl-Prospekt sorgt ein Akku-Bohrschrauber samt Akku für 24,99 Euro* für Aufsehen.

Akku-Bohrschrauber für 25 Euro – Das bietet Euch

Im Angebot befindet sich der PABS 20-Li G8*. Habt Ihr nicht das gesamte Parkside-Portfolio im Kopf, wovon ich jetzt mal stark ausgehen möchte, erklären wir Euch, was es mit dem Gerät auf sich hat. Ihr bekommt hier ein komplettes Starterset geliefert, dass aus dem Akku-Bohrer samt 20-V-Akku, Ladegerät und 17-teiligen Bits- und Bohrer-Set besteht.

Lidl gibt an, dass Ihr mit dem Gerät nicht nur Holz, sondern auch Metall, und Kunststoff durchbohren könnt. Auch zum Schrauben soll sich das Werkzeug eignen. Mit einer Leerlaufdrehzahl von 22.000 min und 25 stufenlos steuerbaren Drehmomentstufen bietet der PABS 20-Li G8 definitiv genug Power für den Heimgebrauch. Über „Cell Balancing“ soll zudem die Akku-Laufzeit erhöht werden. Dabei beträgt der Bohrdurchmesser maximal 30 mm in Holz und 13 mm in Metall, während die Bohrfutterkapazität mit 1,5 – 13 mm im Normalbereich liegt.

Das Lidl-Angebot im Kurz-Check

Wie bereits erwähnt bekommt Ihr das Gesamtset ab Mittwoch direkt im Lidl in Eurer Nähe für 24,99 Euro* geboten. Das ist für einen Akku-Bohrschrauber samt Akku ziemlich günstig. Für übliche Heimwerkerarbeiten, also beispielsweise das Bohren von Löchern zum Anbringen von Regalen oder das Festschrauben von Möbeln, hat der Discounter-Schrauber zudem ausreichend Leistung. Auch online soll das Gerät verfügbar sein. Zumindest zum Zeitpunkt des Schreibens, also am 29. September, ist er das jedoch nicht. Aber es gibt auch Alternativen.

Akku-Bohrer bei Lidl vergriffen? Wir haben drei Alternativen!

Seid Ihr lediglich auf der Suche nach einem Werkzeug, um Dinge zu fixieren und festzuschrauben, muss es gar nicht der Akku-Bohrschrauber sein. Denn Lidl verkauft im Online-Shop auch einen 12-V-Akkuschrauber*. Der PBSAE 12 A1 kommt ebenfalls mit Akku und USB-Ladekabel zu Euch nach Hause und kostet gerade einmal 26,99 Euro.

Alternativ findet Ihr bei Amazon aktuell auch zwei spannende Deals. Zum einen bekommt Ihr hier einen Akku-Bohrschrauber geboten, der es problemlos mit der Lidl-Variante aufnehmen kann. Tatsächlich ähnelt sich das Datenblatt in vielen Punkten und auch beim Design erkennt man kaum Unterschiede. Dank eines Gutscheins auf der Produktseite bekommt Ihr den Fahefana-Akku-Bohrschrauber jetzt für 27 Euro*.

Soll es doch mehr Power sein oder legt Ihr großen Wert auf bewährte Qualität, gibt es auch den Makita DDF482RFJ samt 2 Akkus* und Transportkoffer derzeit im Angebot. 183,60 Euro verlangt Amazon noch für das elektrische Werkzeug, was einer Ersparnis von 35 Prozent gegenüber der UVP entspricht. Nachfolgend haben wir Euch die drei Alternativen noch einmal aufgelistet:

Neben den Werkzeugen hat Lidl aktuell auch den Herbst-Sale* gestartet. Hier findet Ihr auf eine große Auswahl an Produkten bis zu 65 Prozent Rabatt.

Wie ist es bei Euch? Bevorzugt Ihr einen bestimmten Hersteller? Habt Ihr bereits Erfahrungen mit Parkside gemacht? Lasst es uns wissen!

Apps & Mobile Entwicklung

Server-SSDs: Samsung über PM1763 mit PCIe 6.0, 512 TB und Z-NAND Gen 7

Auf einer Fachkonferenz haben Hersteller der Flash-Speicher-Branche über kommende Produkte gesprochen. Samsung kündigte an, dass die PCIe-6.0-SSD PM1763 Anfang 2026 erscheint. Bis 2027 möchte Samsung zudem eine SSD mit 512 TB Speicherplatz anbieten können. Außerdem wurde die Entwicklung der siebten Generation Z-NAND bestätigt.

Samsungs erste PCIe-6.0-SSD kommt Anfang 2026

Die Ankündigungen erfolgten im Rahmen des Global Memory Innovation Forum (GMIF2025) in China. Samsung Electronics wurde dort durch Kevin Yoon vertreten, der als Chief Technology Officer in Samsungs Speichersparte tätig ist. Laut Medienberichten hat Yoon den Termin für das Erscheinen der zuvor angekündigten PCIe-6.0-SSD PM1763 auf Anfang 2026 eingegrenzt. Für die PM1763 hatte Samsung kürzlich einen Award auf dem Event Future of Memory and Storage 2025 erhalten.

Zu der SSD im Formfaktor E1.S liegen bisher nur wenig Details vor. Samsung spricht zumindest von einem 16-Kanal-Controller und einer Verdoppelung der Leistung. Via PCIe 6.0 x4 könnte sich der maximale Durchsatz im Bereich von rund 30 GB/s bewegen, sofern die Schnittstelle ausgereizt wird. Die Leistungsaufnahme soll bei 25 Watt liegen und die Energieeffizienz um 60 Prozent steigen.

Sehr wahrscheinlich ist die Vergleichsbasis in der Samsung PM1753 zu suchen, auch wenn es in dem Bericht nicht erörtert wird. Diese PCIe-5.0-SSD schafft 14,8 GB/s und 3,4 Millionen IOPS.

Micron hatte Ende Juli seine erste PCIe-6.0-SSD in Form der Micron 9650 mit 28 GB/s vorgestellt, die bereits bemustert wird. Samsung dürfte ähnlich soweit sein, wenn Anfang 2026 der Marktstart erfolgen soll.

In zwei Jahren will Samsung bei 512 TB ankommen

Während bei der PM1763 klar der Leistungsaspekt im Vordergrund steht, läuft parallel die Entwicklung von SSDs mit noch mehr Speichervolumen weiter. Innerhalb der nächsten zwei Jahre wolle Samsung zunächst 256 TB mit PCIe 5.0 und dann 512 TB mit PCIe 6.0 anbieten.

Hier ist der Einsatz von QLC-Speicher sehr wahrscheinlich. Obgleich Samsung mit der jüngsten QLC-Generation (V9) angeblich Probleme hat, die aber nächstes Jahr behoben sein sollen.

Mit 512 TB planen aber natürlich auch andere Hersteller und SanDisk hat diese Marke ebenfalls für 2027 auf der Roadmap stehen.

Z-NAND in 7. Generation

Vor rund 6 Wochen wurde gemunkelt, dass Samsung den auf niedrige Latenzen getrimmten Z-NAND, eine spezielle Form von 3D-NAND, wieder zurückbringen wird. Eine neue Generation wird erwartet, auf die GPUs Direktzugriff erhalten sollen.

Genau das wird jetzt noch einmal bestätigt. Angeblich sei Samsung bereits bei der 7. Generation Z-NAND angekommen. Die Weiterentwicklung lief demnach still und leise weiter. Vor Jahren hatte Samsung mit der Z-SSD auf Basis von Z-NAND eine Nische bedient.

Mit den wachsenden Anforderungen der KI-Rechenzentren könnte diese Form von Storage Class Memory ihren Höhepunkt erleben. Das Gegenstück von Kioxia heißt XL-Flash. Außerdem arbeiten SanDisk und SK Hynix noch an der Standardisierung des High Bandwidth Flash (HBF).

-

UX/UI & Webdesignvor 1 Monat

UX/UI & Webdesignvor 1 MonatDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 1 Monat

UX/UI & Webdesignvor 1 MonatAdobe Firefly Boards › PAGE online

-

Social Mediavor 1 Monat

Social Mediavor 1 MonatRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

Entwicklung & Codevor 1 Monat

Entwicklung & Codevor 1 MonatPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 4 Wochen

Entwicklung & Codevor 4 WochenEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

UX/UI & Webdesignvor 2 Wochen

UX/UI & Webdesignvor 2 WochenFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online

-

Digital Business & Startupsvor 3 Monaten

Digital Business & Startupsvor 3 Monaten10.000 Euro Tickets? Kann man machen – aber nur mit diesem Trick

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenFirefox-Update 141.0: KI-gestützte Tab‑Gruppen und Einheitenumrechner kommen