Künstliche Intelligenz

Dänemark will Persönlichkeitsrechte gegen Deepfakes stärken

Im Rahmen seiner EU-Ratspräsidentschaft ab dem 1. Juli 2025 möchte Dänemark eine Initiative einbringen, um Bürger besser vor der Nutzung ihrer Persönlichkeit in Deepfakes zu schützen. Dazu soll noch vor der Sommerpause des dänischen Parlaments ein entsprechendes nationales Gesetz vorgelegt werden. Im Herbst könnte dann dort darüber abgestimmt werden.

Der britischen Tageszeitung Guardian sagte der dänische Kulturminister Jakob Engel-Schmidt: „Mit dem Gesetzentwurf einigen wir uns auf die eindeutige Botschaft, dass jeder das Recht auf seinen eigenen Körper, seine eigene Stimme und seine eigenen Gesichtszüge hat. Das aktuelle Gesetz schützt die Menschen jedoch offenbar nicht vor generativer KI.“

Erweitertes Persönlichkeitsrecht

Die Vorlage geht dabei über das hinaus, was in den meisten Ländern als Persönlichkeitsrechte bekannt ist. Die gesamte Erscheinung eines Menschen, mitsamt seinem Wesen und seiner Ausdrucksmöglichkeiten, soll als dessen Eigentum geschützt werden. Das entspricht wohl der „likeness“, die im US-amerikanischen Recht schutzwürdig ist, und auch lizenziert werden kann. Ein Beispiel ist eine digital wieder auferstandene Marylin Monroe.

In Dänemark, wo Minister Engel-Schmidt mit einer breiten Zustimmung über mehrere Parteien rechnet, soll die Regelung zudem im Urheberrecht verankert werden. Die Bürger bekämen dann erweiterte Rechte an Darstellungen ihrer Person. Es soll ihnen damit leichter fallen, etwa die Entfernung von Deepfakes von Plattformen zu verlangen. Darüber hinaus soll das Gesetz auch Kunstwerke schützen, von denen laut Guardian eine „realistische, digital erzeugte Imitation“ erzeugt wurde. Parodien oder Satire soll davon jedoch nicht berührt sein.

(nie)

Künstliche Intelligenz

25 Jahre „Diablo 2“: Klick, Klick, Klick, Klick, Klick…

„Diablo 2“ ist vieles: Action-Rollenspiel, genau 25 Jahre alt, Vernichter von Fleischbestien, Auslöser von Sehnenscheidenentzündungen und eine Gefahr für das Sozialleben. Das gilt auch für die Entwickler von Blizzard North, die nach der aufreibenden Erschaffung von „Diablo“ fast nahtlos die Arbeiten am Nachfolger aufnahmen. Was laut einem Postmortem, das Projektleiter Erich Schaefer in der Oktober-2000-Ausgabe des Entwicklermagazins „Game Developer“ veröffentlichte, alle Beteiligten an den Rand ihrer körperlichen und seelischen Kräfte drückte: Die Arbeiten an „Diablo 2“ dauerte etwas mehr als drei Jahre, von denen das Team die zweite Hälfte praktisch im Dauercrunch verbrachte.

Das lag vor allem daran, dass „größer, schöner, besser, mehr!“ das wichtigste Entwicklungscredo war. Am eigentlichen Spieldesign wurde nicht viel geändert – und warum auch? Der Gameplay-Loop hatte sich bereits als ebenso erfolgreicher wie süchtig machender Jackpot entpuppt: Man rennt durch zufällig ausgewürfelte Dungeons, klickt Gegner kaputt, erhält dafür fette Beute, für die man sich immer bessere Ausrüstung leisten kann, woraufhin man in der Lage ist, immer härtere Gegner zu erledigen, was bessere Beute gibt, die bessere Ausrüstung ermöglicht, woraufhin man in der Lage ist…

heise online

)

Immer baumelt die motivierende Möhre vor der Nase, die verspricht, dass beim nächsten Gegnerkontakt bestimmt ein cooles Item abfällt oder man genug Erfahrungspunkte für den nächsten Levelaufstieg erhält. Klar, sind das Beschäftigungstherapie-Hamsterräder. Und rein logisch kann man nicht erklären, wieso man sich wieder und wieder und wieder und wieder dem „Okay, nur noch fünf Minuten, wirklich!“-Selbstbetrug hingibt. Man stellt nur irgendwann fest, dass neben einem ungefragt die Sonne aufgeht.

Das Ende der Dauerklickerei

Es gab natürlich schon vor dem ursprünglichen „Diablo“ Rollenspiele, in denen in Echtzeit gekämpft wurde, man denke da nur an Westwoods 1993er-Klassiker „Lands of Lore: The Throne of Chaos“. Aber erst „Diablo“ macht das pausenlose „Klick, Klick, Klick, Klick, Klick“ zu einem zentralen Spielelement, dem endlos viele Gegner und Computermäuse zum Opfer fielen. Dieser Vernichtungswille, zumindest in Hinsicht auf die vorhandene Hardware, wurde in „Diablo 2“ etwas zurückgekurbelt, denn man muss jetzt nicht mehr pausenlos das linke Mausohr malträtieren, um einen Gegner zu Tode zu klicken: Einmal anvisiert, wird der Feind automatisch so lange angegriffen, wie man die Maustaste gedrückt hält.

Ansonsten wurde vor allem aufgestockt: bessere Grafik, mehr Regionen, abwechslungsreichere Landschaften, mehr Gegner, mehr Items, mehr mehr. Anstelle von drei Charakterklassen (Krieger, Magier und Jägerin) gibt es jetzt fünf (Barbar, Amazone, Paladin, Totenbeschwörer und Zauberin). Die sich nicht nur in Sachen Stärke, Geschicklichkeit, Vitalität und Energie sehr stark voneinander unterscheiden, sondern vor allem sehr unterschiedliche Kampf- und Magie-Schwerpunkte besitzen und so mehrfaches Durchspielen sehr reizvoll machen. Kriegt man sie alle auf dem Maximallevel von 99 gekloppt?

Anstelle immergleicher Dungeons gab es jetzt eine ausgefeilte, abwechslungsreiche Welt; im Laufe der vier langen Kapitel durchquert man unter anderen Wüsten und Dschungel, bevor man sich in der Hölle das finale Gefecht gegen Diablo liefert. Eine jederzeit einblendbare Übersichtskarte sorgt für ständige Klarheit ohne Sackgassen. Und drückt man nach einem harten Gefecht gegen mehrere Gegner auf die Alt-Taste, zeigt einem das Spiel sämtliche im Bild befindlichen Beutegegenstände deutlich markiert an, inklusive einer sehr hilfreichen Bewertung. Oder anders ausgedrückt: „Diablo“-Kenner fühlten sich hier vom ersten Augenblick an direkt zuhause.

Künstliche Intelligenz

Missing Link: Machtzentrale Palantir – eine Software lenkt Organisationen

Kaum ein Technologieunternehmen polarisiert so stark wie Palantir Technologies. Das 2003 gegründete US-Unternehmen hat sich vom geheimnisvollen Start-up mit CIA-Verbindungen zu einem börsennotierten Konzern entwickelt, der Regierungen und Großkonzerne weltweit beliefert. Palantir verspricht, aus den Daten moderner Organisationen verwertbare Erkenntnisse zu gewinnen. Während Befürworter die Software als revolutionäres Werkzeug für datenbasierte Entscheidungen preisen, warnen Kritiker vor Überwachung, Intransparenz und Vendor-Lock-in-Effekten. Doch was steckt technisch dahinter?

„Palantir ist keine Datenfirma, sondern eine Softwarefirma“ betont das US-Technologie-Unternehmen seit Jahren. Dabei will Palantir mit seiner Software die zentrale Infrastruktur zur Entscheidungsunterstützung für jede Organisation sein. Um das zu erreichen, müsse man „Ordnung ins Datenchaos“ bei den Kunden bringen und eine vernetzte Organisation schaffen. Das Geschäftsmodell von Palantir beruht auf Software-as-a-Service, zu den Lizenzkosten kommen Servicegebühren und Schulungskosten. Wer sich für Palantir entscheidet, macht sich abhängig und verlagert seine digitale Infrastruktur in ein proprietäres Ökosystem.

Der Einsatz von Palantir bedeutet nicht nur eine technische, sondern auch eine strukturelle Bindung der eigenen Organisation an das US-Unternehmen. Ein späterer Systemwechsel ist aufwendig. Zwar bietet Palantir zahlreiche Schnittstellen, um bestehende Systeme und Datenquellen zu integrieren, aber keine Möglichkeit das einmal aufgebaute System zu einem anderen Anbieter umzuziehen. Bestimmte Daten lassen sich exportieren, doch das eigentliche Kapital – die semantischen Strukturen, Logiken, Interaktionen – sind tief mit Palantirs System verknüpft und funktionieren nur dort. Im Zentrum der Architektur steht eine einheitliche Ontologie – ein formales Bedeutungsmodell, das festlegt, wie Daten der Organisation verstanden, verknüpft und operational nutzbar gemacht werden. Auf einem solchen System basierende datengetriebene Entscheidungen und Prozesse können die Arbeitsweise einer Organisation verändern.

Was fehlt: In der rapiden Technikwelt häufig die Zeit, die vielen News und Hintergründe neu zu sortieren. Am Wochenende wollen wir sie uns nehmen, die Seitenwege abseits des Aktuellen verfolgen, andere Blickwinkel probieren und Zwischentöne hörbar machen.

Palantir verändert Organisationen

Ob sich Palantir als bundesweite Interimslösung für die Polizei eignet und eingeführt werden soll, wie es der Bundesrat im März 2025 gefordert hat und sich einige Innenminister wünschen, erscheint fraglich. Inzwischen zeigt sich wachsender Widerstand gegen die US-Big-Data-Software für die Polizei und bei der Innenministerkonferenz (IMK) konnte keine Einigung für die bundesweite Einführung von Palantir erzielt werden. Stattdessen stellte die IMK in ihrem Beschluss vom 18. Juni 25 fest, „dass die Fähigkeit der automatisierten Datenanalyse als ein Schlüsselelement der künftigen digitalen Sicherheitsinfrastruktur hinsichtlich Verfügbarkeit, Vertraulichkeit, Integrität und ihrer Rechtskonformität keiner strukturellen Einflussmöglichkeit durch außereuropäische Staaten ausgesetzt sein darf“ und „vor diesem Hintergrund die Entwicklung einer digital souveränen Lösung anzustreben ist“.

Den Bundesländern steht es nach wie vor frei, (weiter) mit Palantir zusammenzuarbeiten. Baden-Württemberg plant bereits seit Längerem die Einführung einer Landes-VeRA und hat dafür nach Rücksprache mit Bayern 18,5 Millionen Euro an Haushaltsmittel für 2025/2026 veranschlagt. Auch Sachsen-Anhalt möchte Palantir einführen, berichtet der MDR.

Wie sich die Arbeitsweise mit Palantir ändert, zeigen die Erfahrungen bei der Landespolizei Hessen, die Palantir Gotham als „HessenData“ seit 2017 einsetzt. Jährlich werden mehrere Tausend Abfragen mit dem System durchgeführt, das von jedem Arbeitsplatz aus erreichbar ist. Als im Februar 2023 das Bundesverfassungsgericht die Regeln zur Datenanalyse bei der Polizei beanstandete, wurde dem Land Hessen eine Frist für die Gesetzesänderung eingeräumt, in der die Nutzung von HessenData unter Auflagen weiter erlaubt war. Hessen passte seine Rechtsgrundlage an, weshalb HessenData weiter in Betrieb ist. Das System sorge für mehr Effizienz und „eigentlich ist jede Nutzung im Alltag der Kollegen schon ein Riesenerfolg“, zitiert die SZ in einem aktuellen Beitrag eine Polizistin aus dem Innovation Hub 110, die für den Betrieb der Plattform verantwortlich ist. Palantir scheint fester Bestandteil der hessischen Ermittlungsarbeit zu sein und Hessen ist auch an einem Ausbau der Analysefähigkeiten mit KI interessiert. So nahmen Mitarbeiter des Innovation Hub 110 im Mai 2025 mit einer eigenen Live-Demo an einer AIP Expo von Palantir in München teil, wie sie auf LinkedIn mitteilten. Palantir veranstaltet solche AIP Expos als geschlossenes Networking-Event für Führungskräfte aus seinem Kundenstamm, um die Integration von KI in seine Produkte in der Praxis durch einzelne Kunden selbst vorführen zu lassen.

Um die dahinterliegende Systemarchitektur besser einordnen zu können, lohnt sich ein Blick auf die zentralen Palantir-Produkte – insbesondere auf die modular aufgebauten Plattformen Foundry und Gotham. Sie bilden die technische Grundlage für Anwendungen wie HessenData , DAR (NRW) oder VeRA (Bayern), die sich mittels AIP (Artificial Intelligence Platform) leicht mit KI-Funktionalitäten ergänzen lassen könnten.

Keine Datenplattform, sondern ein Betriebssystem

Die Hauptprodukte sind Palantir Foundry und Palantir Gotham, dazu kommen Palantir AIP und Palantir Apollo. Alle Produkte werden als „Plattformen“ beworben, wobei betont wird, dass sie keine Datenplattform, sondern eine modular aufgebaute Betriebsplattform sind, und als OS dienen sollen.

Foundry wird als „Ontologie-basierte Betriebssystem für das moderne Unternehmen“ beworben; während der Slogan „Deine Software ist das Waffensystem“ für Gotham als „Betriebssystem für die globale Entscheidungsfindung“ bei Behörden und Organisationen im Sicherheitsbereich wirbt.

Das Betriebssystem setzt sich in seiner Basis aus dem „Palantir Data Store“ als physische/technische Ebene der Speicherstruktur für Roh- und Transformationsdaten und der Ontologie als logischer Bedeutungsebene für die Daten zusammen. Der „Palantir Data Store“ ist Bestandteil von Foundry. In Foundry erfolgt die Datenintegration, -modellierung und -analyse.

Von 100 fragmentierten zu einem Palantir-System

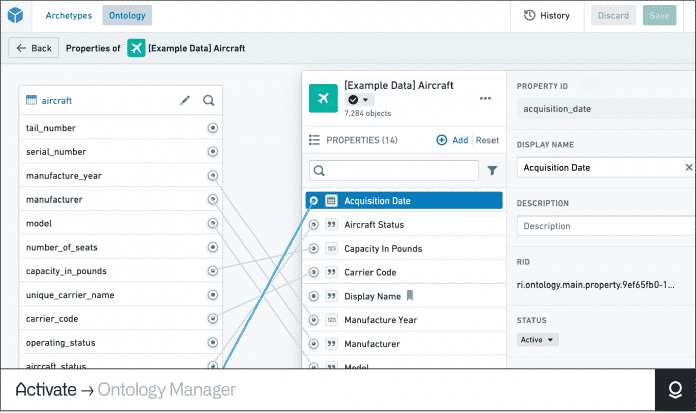

Die Ontologie ist als zentrales Struktur- und Organisationsprinzip das Herzstück des Palantir-Systems, das zum semantischen Rückgrat der das System nutzenden Organisation wird.

Eine Ontologie ist ein formales Modell, das Konzepte, Entitäten und ihre Eigenschaften und Beziehungen zueinander einheitlich und strukturiert beschreibt.

So wird eine gemeinsame Bedeutungswelt in einem zentralen System geschaffen, in dem Daten quer über Systeme hinweg aus unterschiedlichsten Quellen und Formaten zusammenfließen, vereinheitlicht, kontextualisiert und analysierbar werden.

Über heterogene IT-Systemlandschaften einer Organisation und ihrer Daten hinweg wird mit der Ontologie eine gemeinsame Sprache als semantische Zwischenebene (Semantic Layer) geschaffen. Und diese Sprache kann auch in der Zusammenarbeit mit anderen Organisationen genutzt werden, wenn sie dieselbe Ontologie nutzen.

Mit Palantirs Ontologie wird ein digitaler Zwilling einer Organisation erstellt. Daten, Prozesse, Regeln und Nutzerinteraktionen werden in einem einheitlichen Modell strukturiert zentral zusammengeführt – dieses Wissen lässt sich maschinell verarbeiten, durchsuchen und logisch verknüpfen. Es lassen sich nicht nur Zusammenhänge verstehen und Rückschlüsse ziehen, sondern auch steuerbare Aktionen durchführen.

Diese Ontologie ist vollständig anpassbar und erweiterbar – sie bildet die Struktur, auf der alle Analysen, Datenflüsse und Benutzeroberflächen in Palantir-Produkten aufbauen. Über die Ontologie wird bestimmt, was sichtbar wird, was verknüpft wird, was als relevant gilt.

Im „Ontology Manager“ definiert man Entitäten – im Beispiel ein Passagierflugzeug – und weist ihnen Eigenschaften zu. Die Ontologie verknüpft diese mit (Echtzeit-)Daten, Prozessen, Regeln und führt sie in einem einheitlichen Modell strukturiert zentral zusammen.

(Bild: Screenshot/Palantir)

Die Kern-Komponenten der Palantir-Ontologie

- Object Types – definieren Entitäten wie zum Beispiel „Person“, „Sache“, „Ereignis“, „Vorfall“, „Produktionslinie“, „Konzept“

- Properties – beschreiben Eigenschaften/Attribute dieser Entitäten, etwa „Name“, „Kennzeichen“, „Ort“, „Datum“, „Zeitstempel“

- Shared Properties – beschreibt eine Eigenschaft, die auf mehreren Objekttypen verwendet wird, so lassen sich Eigenschaftsmetadaten zentral verwalten

- Link Types – repräsentieren Beziehungen zwischen Entitäten, zum Beispiel „enthält“, „war bei“, „kennt“, „verwendet“, „wohnt“, „Fahrer“, „Mitfahrer“, „ist Mitglied bei“, „Zeuge“, „Beschuldigter“, „Tatverdächtiger“

- Action Types – ermöglicht Änderungen an den Entitäten, ihren Eigenschaften und Beziehungen. Dabei können nach Durchführung der Aktion auch (automatisiert) weitere Aktionen folgen, die in den jeweiligen Aktions-Schemata hinterlegt sind.

- Functions – ermöglichen die Interaktion mit den Entitäten in Form von Logiken, die ausgeführt werden

- Object Views – Darstellung von Informationen und Arbeitsabläufen, die sich auf ein bestimmtes Objekt beziehen, es könnte etwa ein Steckbrief angezeigt werden oder eine detaillierte Darstellung aller mit einem Objekt zusammenhängenden Informationen

- Rollen – die direkte Anwendung von Rollen auf jede Ontologie-Ressource, unabhängig von den Berechtigungen auf die ursprüngliche Datenquelle

- Interfaces – abstraktes Schema für Schnittstellen ist ein Ontologietyp, der die Form eines Objekttyps und seine Funktionen beschreibt. Schnittstellen ermöglichen eine konsistente Modellierung und Interaktion mit Objekttypen, die eine gemeinsame Form haben.

Künstliche Intelligenz

Digital Markets Act: Apple baut App Store in der EU erneut um

Apple kommt der EU-Kommission entgegen und führt weitere Anpassungen im europäischen App Store durch, um dem Digital Markets Act (DMA) zu entsprechen. Dies hatte sich bereits abgezeichnet, da dem Konzern sonst hohe zusätzliche Strafen gedroht hätten. Auf Entwickler kommen erneut neue Tarife und vor allem Möglichkeiten zu, ihre Anwendungen über den Apple-Softwareladen und darüber hinaus zu vermarkten. Das Tarifdickicht ist allerdings nur schwer zu durchblicken – erst in den kommenden Tagen dürften weitere Details folgen.

CTF geht, CTC kommt

Laut Apple dürfen Entwickler künftig Angebote „über alle Kanäle“ bewerben, nicht nur ihre eigenen Websites. Das dürfen sowohl andere Apps, alternative App-Marketplaces (wie Apple alternative App-Läden nennt) und externe Websites sein. In-App-Inhalte dürfen eine native UI sowie In-App-Webansichten haben, um etwa für Käufe über das eigene Angebot zu werben. Entwickler können zudem beliebige URLs verwenden, nicht mehr nur eine statische – Tracking ist auch erlaubt, genauso wie Redirects. Links und Werbung dürfen „frei gestaltet“ werden, so Apple weiter. Auch die Dialoge, in denen Apple darauf hinweist, dass die Nutzer den App Store verlassen („Scare Sheets“), werden weniger – sie können zudem mittels Opt-out verborgen werden. Auch die Installation alternativer App-Marketplaces wird vereinfacht und für Nutzer weniger beschwerlich.

Apple verändert gleichzeitig auch seine Gebühren – teilweise jetzt und teilweise mit Stichtag 1. Januar 2026. Dies gilt für alle Entwickler, egal ob sie direkt vertreiben, den App Store für In-App-Verkäufe nutzen oder alternative App-Marketplaces verwenden. Die umstrittene „Core Technology Fee“ (CTF) für „digitale Güter und Dienste“ entfällt ab dem 1. Januar. Sie wird durch eine „Core Technology Commission“ (CTC) und eine „Initial Acquisition Fee“ ersetzt. Diese beträgt 2 Prozent auf Verkäufe von digitalen Gütern und Diensten „durch neue Nutzer“ innerhalb von sechs Monaten nach dem ersten Download einer App. Entwickler im Rahmen des „Small Business Program“ (unter einer Million US-Dollar Umsatz pro Jahr) müssen die CTC nicht entrichten. Auch für User, die bereits existieren, muss die CTC nicht entrichtet werden.

Sweeney: „Kommerziell verkrüppelt“

Weiterhin wird Apple zwei neue „Tiers“ als „Store Service Fee“ einführen. Für 5 Prozent Provision (Tier One) gibt es grundlegende Dienste wie „App-Vertrieb und App-Auslieferung“, Sicherheitsfunktionen sowie App Management. Für 13 Prozent (Tier Two) sind „alle Dienste aus dem heutigen App Store“ enthalten. Was das konkret bedeutet, muss sich noch zeigen. Verwirrenderweise gibt es laut Angaben von 9to5Mac auch noch eine weitere Tarifstufe der CTC, die allerdings offenbar dauerhaft anfällt, wenn über alternative Wege verkauft wird: Sie soll 5 Prozent betragen. Verwirrenderweise wird es anfangs noch CTC und CTF noch gleichzeitig geben, zudem hat Apple zwei verschiedene „Terms“ (Standard und Alternative), was Entwickler zusätzlich verwirrt.

In einer ersten Reaktion bekam Apple gleich wieder Kritik ab: Epic-Chef Tim Sweeney, der sich mit Apple seit Jahren im Rechtsstreit befindet, schrieb auf X, Apples Anpassungen seien „Malicious Compliance“, konkurrierende Bezahlverfahren würden nicht nur besteuert, sondern auch „kommerziell verkrüppelt“.

(bsc)

-

Online Marketing & SEOvor 2 Wochen

Online Marketing & SEOvor 2 WochenTikTok trackt CO₂ von Ads – und Mitarbeitende intern mit Ratings

-

Apps & Mobile Entwicklungvor 2 Wochen

Apps & Mobile Entwicklungvor 2 WochenMetal Gear Solid Δ: Snake Eater: Ein Multiplayer-Modus für Fans von Versteckenspielen

-

UX/UI & Webdesignvor 2 Wochen

UX/UI & Webdesignvor 2 WochenPhilip Bürli › PAGE online

-

Social Mediavor 2 Wochen

Social Mediavor 2 WochenLinkedIn Feature-Update 2025: Aktuelle Neuigkeiten

-

Social Mediavor 2 Wochen

Social Mediavor 2 WochenAktuelle Trends, Studien und Statistiken

-

Social Mediavor 2 Wochen

Social Mediavor 2 Wochen“Wir haben doch nichts zu erzählen…” – 3 Tricks für neue Social Media Content Ideen

-

Online Marketing & SEOvor 2 Wochen

Online Marketing & SEOvor 2 WochenAus Marketing, Medien, Agenturen & Tech: Diese 40 klugen Köpfe unter 40 müssen Sie kennen

-

Online Marketing & SEOvor 2 Wochen

Online Marketing & SEOvor 2 Wochen#WantaFanta: Warum Fanta und Nico Santos der Gen Z Wünsche erfüllen