Künstliche Intelligenz

DeepSeek-OCR: Bilder vereinfachen Texte für große Sprachmodelle

Viele Unternehmensdokumente liegen zwar als PDFs vor, sind aber häufig gescannt. Obwohl es simpel klingt, können diese Dokumente oftmals nur unter großen Mühen in Text gewandelt werden, insbesondere wenn die Struktur der Dokumente komplexer ist und erhalten bleiben soll. Auch Bilder, Tabellen und Grafiken sind häufige Fehlerquellen. In den letzten Monaten gab es daher eine wahre Flut von OCR-Software, die auf großen Sprachmodelle (LLMs) setzt.

Weiterlesen nach der Anzeige

Auch der chinesische KI-Entwickler DeepSeek steigt nun in diesen Bereich ein und veröffentlicht nach dem Reasoning-Modell R1 ein experimentelles OCR-Modell unter MIT-Lizenz. Auf den ersten Blick mag das verblüffen, denn OCR schien bisher nicht die Kernkompetenz von DeepSeek zu sein. Und tatsächlich ist das neue Modell erstmal eine Technikdemo für einen neuen Ansatz in der Dokumentenverarbeitung von großen Sprachmodellen.

Prof. Dr. Christian Winkler beschäftigt sich speziell mit der automatisierten Analyse natürlichsprachiger Texte (NLP). Als Professor an der TH Nürnberg konzentriert er sich bei seiner Forschung auf die Optimierung der User Experience.

DeepSeek versucht, lange Textkontexte in Bildern zu komprimieren, da sich hierdurch eine höhere Informationsdichte mit weniger Token darstellen lässt. DeepSeek legt die Messlatte für die Erwartungen hoch und berichtet, dass das Modell bei hohen Kompressionsraten (Faktor 10) noch eine Genauigkeit von 97 Prozent erreicht, bei einer noch stärkeren Kompression fällt zwar die Genauigkeit, bleibt dabei aber relativ hoch. Das alles soll schneller funktionieren als bei anderen OCR-Modellen und auf einer Nvidia A100-GPU bis zu 200.000 Seiten pro Tag verarbeiten.

Das Kontext-Problem

Large Language Models haben Speicherprobleme, wenn der Kontext von Prompts sehr groß wird. Das ist der Fall, wenn das Modell lange Texte oder mehrere Dokumente verarbeiten soll. Grund dafür ist der für effiziente Berechnungen wichtige Key-Value-Cache, der quadratisch mit der Kontextgröße wächst. Die Kosten der GPUs steigen stark mit dem Speicher, was dazu führt, dass lange Texte sehr teuer in der Verarbeitung sind. Auch das Training solcher Modelle ist aufwendig. Das liegt allerdings weniger am Speicherplatz, sondern auch an der quadratisch wachsenden Komplexität der Berechnungen. Daher forschen die LLM-Anbieter intensiv daran, wie sich man diesen Kontext effizienter darstellen kann.

Hier bringt DeepSeek die Idee ins Spiel, den Kontext als Bild darzustellen: Bilder haben eine hohe Informationsdichte und Vision Token zur optischen Kompression könnten einen langen Text durch weniger Token. Mit DeepSeek-OCR haben die Entwickler diese Grundidee überprüft – es ist also ein Experiment zu verstehen, das zeigen soll, wie gut die optische Kompression funktioniert.

Weiterlesen nach der Anzeige

Die Modellarchitektur

Der dazugehörige Preprint besteht aus drei Teilen: einer quantitativen Analyse, wie gut die optische Kompression funktioniert, einem neuen Encoder-Modell und dem eigentlichen OCR-Modell. Das Ergebnis der Analyse zeigt, dass kleine Sprachmodelle lernen können, wie sie komprimierte visuelle Darstellungen in Text umwandeln.

Dazu haben die Forscher mit DeepEncoder ein Modell entwickelt, das auch bei hochaufgelösten Bildern mit wenig Aktivierungen auskommt. Der Encoder nutzt eine Mischung aus Window und Global Attention verbunden mit einem Kompressor, der Konvolutionen einsetzt (Convolutional Compressor). Die schnellere Window Attention sieht nur einzelne Teile der Dokumente und bereitet die Daten vor, die langsamere Global Attention berücksichtigt den gesamten Kontext, arbeitet nur noch mit den komprimierten Daten. Die Konvolutionen reduzieren die Auflösung der Vision Token, wodurch sich der Speicherbedarf verringert.

DeepSeek-OCR kombiniert den DeepEncoder mit DeepSeek-3B-MoE. Dieses LLM setzt jeweils sechs von 64 Experten und zwei geteilte Experten ein, was sich zu 570 Millionen aktiven Parametern addiert. Im Gegensatz zu vielen anderen OCR-Modellen wie MinerU, docling, Nanonets, PaddleOCR kann DeepSeek-OCR auch Charts in Daten wandeln, chemische Formeln und geometrische Figuren erkennen. Mathematische Formeln beherrscht es ebenfalls, das funktioniert zum Teil aber auch mit den anderen Modellen.

Die DeepSeek-Entwickler betonen allerdings, dass es sich um eine vorläufige Analyse und um ebensolche Ergebnisse handelt. Es wird spannend, wie sich diese Technologie weiterentwickelt und wo sie überall zum Einsatz kommen kann. Das DeepSeek-OCR-Modell unterscheidet sich jedenfalls beträchtlich von allen anderen. Um zu wissen, wie gut und schnell es funktioniert, muss man das Modell jedoch selbst ausprobieren.

DeepSeek-OCR ausprobiert

Als Testobjekt dient eine Seite aus einer iX, die im JPEG-Format vorliegt. DeepSeek-OCR kann in unterschiedlichen Konfigurationen arbeiten: Gundam, Large und Tiny. Im Gundam-Modus findet ein automatisches Resizing statt. Im Moment funktioniert das noch etwas instabil, bringt man die Parameter durcheinander, produziert man CUDA-Kernel-Fehler und muss von vorne starten.

Möchte man den Text aus Dokumenten extrahieren, muss man das Modell geeignet prompten. DeepSeek empfiehlt dazu den Befehl

Im Gundam-Modus erkennt DeepSeek-OCR den gesamten Text und alle relevanten Elemente und kann auch Textfluss des Magazins rekonstruieren.

Den Text hat das Modell praktisch fehlerfrei erkannt und dazu auf einer RTX 4090 etwa 40 Sekunden benötigt. Das ist noch weit entfernt von den angepriesenen 200.000 Seiten pro Tag, allerdings verwendet Gundam auch nur ein Kompressionsfaktor von zwei: 791 Image Token entsprechen 1.580 Text Token. Immerhin erkennt das Modell den Textfluss im Artikel richtig. Das ist bei anderen Modellen ein gängiges Problem.

Mit etwa 50 Sekunden rechnet die Large-Variante nur wenig länger als Gundam, allerdings sind die Ergebnisse viel schlechter, was möglicherweise auch dem größeren Kompressionsfaktor geschuldet ist: 299 Image-Token entsprechen 2068 Text-Token. Im Bild verdeutlichen das die ungenauer erkannten Boxen um den Text – hier gibt es noch Optimierungsbedarf. Außerdem erkennt das Modell die Texte nicht sauber, teilweise erscheinen nur unleserliche Zeichen wie „¡ ¢“, was möglicherweise auf Kodierungsfehler und eigentlich chinesische Schriftzeichen hindeuten könnte.

Der Large-Modus komprimiert die Bilder stärker als Gundam, was zu einer ungenaueren Erkennung führt. Die Textboxen sind unschärfer abgegrenzt und es erscheinen unleserliche Zeichen, die auf eine fehlerhafte Kodierung hinweisen.

Fehler mit unleserlichen Zeichen gibt es beim Tiny-Modell nicht. Das rechnet mit einer Dauer von 40 Sekunden wieder etwas schneller und nutzt einen Kompressionsfaktor von 25,8 – 64 Image-Token entsprechen 1652 Text-Token. Durch die hohe Kompression halluziniert das Modell allerdings stark und erzeugt Text wie „Erweist, bei der Formulierung der Ab- fragen kann ein KI-Assistent helfen. Bis Start gilt es auf Caffès offiziell die Gewicht 50 Prozent der Früh-, der Prüfung und 50 Prozent für den Arzt- und NEUT und in Kürze folgen. (Spezielle)“. Das hat nichts mit dem Inhalt zu tun – auf diese Modellvariante kann man sich also nicht verlassen.

Die Tiny-Variante hat den höchsten Kompressionsfaktor für die Bilder und halluziniert bei der Text-Ausgabe stark. Hier sollte man sich also nicht auf die Ergebnisse verlassen.

Neben der Markdown-Konvertierung lässt DeepSeek-OCR auch ein Free OCR zu, das das Layout nicht berücksichtigt. Damit funktioniert das Modell sehr viel schneller und produziert auch in der Large-Version mit hoher Kompression noch gute Resultate. Diese Variante ist aber nur sinnvoll, wenn man weiß, dass es sich um Fließtexte ohne schwieriges Layout handelt.

Informationen aus Grafiken extrahieren

DeepSeek-OCR hat beim Parsing die im Artikel enthaltenen Bilder erkannt und separat abgelegt. Das Diagramm speichert das Modell dabei in einer schlecht lesbaren Auflösung.

Das mit Gundam extrahierte Diagramm ist verschwommen und lässt sich mit bloßem Auge nur noch schlecht entziffern.

Jetzt wird es spannend, denn DeepSeek-OCR soll aus diesem Diagramm auch Daten extrahieren können, das geht mit dem Prompt

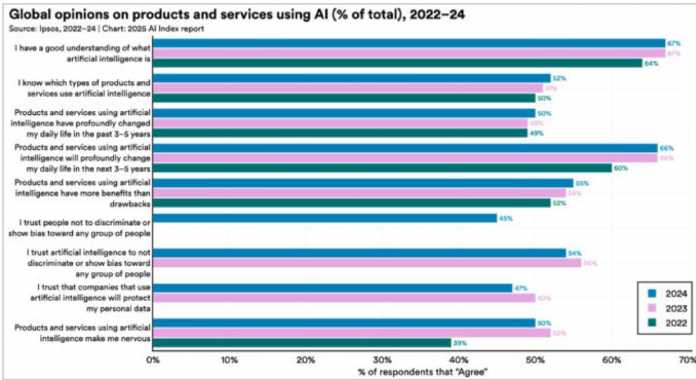

| 2024 | 2023 | 2022 | |

| I have a good understanding of what artificial intelligence is | 67% | 67% | 64% |

| I know which types of products and services use artificial intelligence | 52% | 51% | 50% |

| Products and services using artificial intelligence have profoundly changed my daily life in the past 3-5 years | 50% | 50% | 49% |

| Products and services using artificial intelligence will profoundly change my daily life in the next 3-5 years | 66% | 66% | 60% |

| Products and services using artificial intelligence have more benefits than drawbacks | 55% | 54% | 52% |

| I trust people not to discriminate or show bias toward any group of people | 45% | 45% | 44% |

| I trust artificial intelligence to not discriminate or show bias toward any group of people | 54% | 54% | 50% |

| I trust that companies that use artificial intelligence will protect my personal data | 47% | 50% | 50% |

| Products and services using artificial intelligence make me nervous | 39% | 39% | 39% |

Offenbar haben sich Fehler in die Tabelle eingeschlichen, aber zumindest hat das Modell den verwaschenen Text richtig erkannt. Hier zeigt sich die Stärke des Encoders, aber auch die englische Beschriftung vereinfacht den Prozess für das Modell. Die meisten Prozentwerte stimmen, ebenso die Struktur der Daten. Verwendet man eine höhere Auflösung, verbessern sich die Ergebnisse allerdings nur marginal.

Neben Diagrammen kann DeepSeek-OCR auch mathematische Formeln erkennen und sie in LaTeX-Syntax wandeln. Chemische Strukturformeln hat es auch im Repertoire und wandelt sie in das SMILES-Format.

Fazit

DeepSeek hat sich erneut einen spannenden technischen Ansatz ausgedacht und mit DeepSeek-OCR überzeugend demonstriert. Die Erkennung von Texten funktioniert besonders im Gundam-Modus schon gut, auch das Parsing der Diagramme ist überzeugend. Allerdings sind andere Modelle wie MinerU, Nanonets und PaddleOCR-VL besonders bei der reinen Texterkennung ebenfalls sehr gut und liefern teilweise sogar bessere Ergebnisse, da sie etwa getrennte Wörter zusammenführen. Besonders das ebenso nagelneue PaddleOCR-VL ist hervorzuheben, das Daten aus Diagrammen verlässlich extrahiert und in eigenen Tests sogar besser als DeepSeek-OCR funktionierte. Um OCR ist ein wahres Wettrennen entbrannt.

DeepSeek scheint mit dem Modell jedoch nicht nur auf OCR zu setzen, sondern möchte zeigen, dass die Vision Token eine gute Darstellung sind, um den Kontext in großen Sprachmodellen besonders kompakt zu speichern. Mit einer geringen Kompression funktioniert das schon gut, mit höherer Kompression leiden die Ergebnisse aber spürbar. Dieser Ansatz steht allerdings noch ganz am Anfang.

DeepSeek-OCR ist in allen Konfigurationen verhältnismäßig schnell. Experimente mit MinerU, Nanonets und PaddleOCR-VL waren alle mindestens 50 Prozent langsamer. Nanonets erzeugte immerhin eine Tabelle aus dem Diagramm, aber ohne die Jahreszahlen, dafür war der Fließtext sehr viel besser erkannt. Das nagelneue PaddleOCR-VL konnte das Diagramm sogar besser als DeepSeek-OCR erkennen, ist aber nicht auf chemische Strukturformeln und ähnliche Inhalte trainiert.

DeepSeek-OCR ist – wie von den Entwicklern deutlich vermerkt – eine Technologiedemonstration, die dafür schon äußerst gut funktioniert. Es bleibt abzuwarten, wie sich die Technologie in klassische LLMs integrieren lässt und dort zur effizienteren Verarbeitung von längeren Kontexten genutzt werden kann.

Weitere Informationen finden sich auf GitHub, Hugging Face und im arXiv-Preprint.

(pst)

Das könnte Ihnen gefallen

-

KI-Experte warnt Politiker: „Wir sind erst am Anfang der Dystopie“

-

Xbox App für Windows on Arm: 85 % der Game-Pass-Titel laufen mit Prism

-

Digitaler Befreiungsschlag: EU-Parlament fordert Loslösung von US-Tech-Riesen

-

Exklusiv-Auswertung: Stellenmarkt für Kommunikations- und Werbefachleute schwächelt weiter

-

Bundestrainer als Testimonial: Julian Nagelsmann wirbt für Lidl Plus

-

Amazon verkauft jetzt ein Ugreen-Gadget für weniger als 16 Euro

Künstliche Intelligenz

Top 10: Der beste Wischsauger im Test – mit Dampf & Schaum gegen den Schmutz

Mit Akku-Wischsaugern geht Wischen so einfach und schnell wie Saugen. Wir haben über 20 Modelle getestet und zeigen hier die 10 besten.

Die Müslischale mit Milch ist übergeschwappt und die Hälfte ist auf den Küchenfliesen gelandet? Der Hund ist nach dem Gassigehen im Regen schön durch Schlammpfützen und anschließend über den Laminatboden gejagt? Oder sieht der Flur im Eingangsbereich im Herbst und Winter dank eingetrockneter Schmutzreste mal wieder furchtbar aus? Dann ist wohl Wischen angesagt.

Also Eimer, Wischlappen und Schrubber herausholen, dann Wasser in den Eimer, den Lappen auswringen, über den Schrubberkopf legen und wischen, was das Zeug hält – da kommt man schon beim Lesen ins Schwitzen. Aber es gibt eine wesentlich einfachere und deutlich weniger anstrengende Alternative: den Wischsauger mit Akku. Dieser vereinfacht dank moderner Technik und nützlicher Funktionen die sonst sehr mühselige Arbeit ungemein und kombiniert Staubsaugen und Wischen in einem Arbeitsschritt. In unserer Bestenliste zeigen wir die Top-Modelle aus unseren Tests und erklären, worauf es bei Wischsaugern ankommt.

Welcher ist der beste Akku-Wischsauger?

Unser Testsieger ist der Dreame H15 Pro Heat für 499 Euro. Er überzeugt mit seiner Heißwasser-Bodenreinigung, seiner starken Saugkraft von 22.000 Pa und der Abziehlippe, die für eine perfekte Kantenreinigung sorgt.

Als neuer Technologiesieger hat sich der Roborock F25 Ace Pro für 549 Euro herauskristallisiert. Mit seiner Schaumdüse kann er auch mit äußerst hartnäckigen Flecken und Verschmutzungen umgehen.

Unser Preis-Leistungs-Sieger ist der Mova X4 Pro für 349 Euro aus dem Hause Dreame. Per Knopfdruck sprüht er im Heißwasser-Modus 80 °C heißes Wasser vor sich auf den Boden, um hartnäckige Flecken zu entfernen. Zudem liefert er eine grundsolide Saug- und Wischleistung zu einem angenehmen Preis.

Der Dreame H15 Pro Heat für 499 Euro bietet zwei Alleinstellungsmerkmale: Die automatische Abziehlippe reinigt Kanten und Ecken perfekt, während 85 °C heißes Wischwasser selbst hartnäckige Verschmutzungen löst. Die Saugkraft von 22.000 Pa und das Tangle-Cut-System gegen verhedderte Haare machen ihn zum Kraftpaket. Wer maximale Reinigungsleistung und innovative Technik sucht, findet hier das aktuell beste Gesamtpaket am Markt.

- Heißwasser-Bodenreinigung mit bis zu 100 °C

- automatische Abziehlippe für perfekte Kantenreinigung

- starke Saugkraft von 22.000 Pa

- Tangle-Cut-System mit Messereinsatz gegen Haare

- teilweise billig wirkende Kunststoffteile

- sehr laute Selbstreinigung mit 77 dB(A)

- holprige App-Einrichtung mit Update-Problemen

- hoher Preis

Der Roborock F25 Ace Pro kann dank einer Schaumdüse auf Knopfdruck Reinigungskonzentrat in dichten Schaum verwandeln, um so auch hartnäckigere Flecken gründlicher entfernen zu können. Er ist zwar keine Wunderwaffe, erleichtert das Wischen in unserem Test aber durchaus. Der Wischsauger kostet 549 Euro.

- Schaumdüse nützlich, um hartnäckigere Flecken zu lösen

- zuverlässige Saugleistung

- unkomplizierte Handhabung

- kaum Neuerungen zu Vorgängermodellen

- Schmutzwassersieb wirkt etwas fragil

Der Mova X4 Pro vereint schlaues und hochwertig wirkendes Design mit einer soliden Saug- und Wischleistung zu einem guten Preis. Funktionen wie der Heißwassermodus sind nützlich, um hartnäckige Flecken zu entfernen. Die 100 °C heiße Selbstreinigung mit anschließender Trocknung überzeugt ebenfalls. Im Alltag weiß der Mova X4 Pro für 349 Euro größtenteils zu überzeugen, während ein etwas schwächelnder Saugmodus sowie die Schmutzansammlung an den Walzenseiten den Eindruck etwas schmälern.

- Sprühfunktion nützlich, um härtere Verschmutzungen zu lösen

- 100 °C heiße Selbstreinigung

- schlaues Design erleichtert Reinigung des Schmutzwassertanks

- solide Verarbeitung

- Sauger hat Schwierigkeiten mit größeren Objekten

- Wischwalze hinterlässt manchmal Staubfäden am Boden

- kein separates Fach für Reinigungskonzentrat

Ratgeber

Was ist ein Wischsauger?

Grundsätzlich gibt es Wischsauger mit Kabel zum Anschluss an die 230-Volt-Steckdose und mit Akku. Sie ersetzen Wassereimer, Schrubber und Wischtuch. Mit Akku ähneln sie vom Aufbau her Akkusaugern wie dem Dyson V15 Detect oder dem Samsung Bespoke Jet, doch es gibt entscheidende Unterschiede.

Denn statt eines Schmutzbehälters für Krümel und Sandkörner gibt es einen Schmutz- und Abwassertank, in dem nicht nur diese festen Partikel, sondern auch Flüssigkeiten abgesaugt werden. Hinzu kommt außerdem ein integrierter Behälter für frisches Wischwasser, der Wischeimer ist also immer mit dabei. Aus dem Frischwassertank wird die weiche Rollenbürste im Bürstenkopf des Gerätes und/oder (selten) der Boden davor mit Wasser befeuchtet. Die Absaugfunktion entfernt im gleichen Arbeitsschritt das schmutzige Wasser, Krümel und Staub und zieht die so entstehende Plörre in den Abwassertank. Über zu feuchtes Wischen und Beschädigung von teuren Holzböden wie Parkett muss man sich keine Sorgen machen, denn der dünne Feuchtigkeitsfilm trocknet schnell wieder ab.

Was bringen Wischsauger?

Dadurch, dass Frischwasser normalerweise in einem Schritt auf den Boden gegeben und direkt wieder als Abwasser abgesaugt wird, entfällt das lästige, regelmäßige Auswaschen und anschließende Auswringen des Wischtuches, wie man es beim manuellen Wischen hat. Das schont den Rücken und spart Zeit. Gleiches gilt für die Wischvorbereitung: Einfach den Akku-Wischsauger von der Ladestation nehmen und loslegen.

Minimaler Reinigungsaufwand entsteht nur nach dem Wischen, hier sollte der Abwassertank ausgespült und der Frischwassertank wieder aufgefüllt werden. Manche Wischsauger verlangen zudem den Ausbau der Wischrolle zum Trocknen. Die meisten aktuellen Modelle nehmen diesen Arbeitsschritt ab. Die Selbstreinigung geht schnell und mit nur einem Knopfdruck. Eine dafür nötige Dockingstation ist bei vielen Wischsaugern im Lieferumfang enthalten. Ist das Gerät angedockt, erhitzt es das Wasser aus dem Frischwassertank, um die Wischwalze damit gründlich zu reinigen. Viele Wischsauger haben zudem eine Trocknungsfunktion, die die gereinigte Wischwalze anschließend mit heißer Luft trocknet.

Die schnell drehende Wischrolle eines Wischsaugers ersetzt das anstrengende Schrubben, das Wischen wird so zum Kinderspiel. Die meisten modernen Wischsauger haben außerdem motorisierte Räder, die durch ihren Antrieb automatisch vorwärtsfahren und einen dadurch zusätzlich entlasten.

Selbst eingetrockneter Schmutz stellt normalerweise kein Problem dar, eventuell muss man mehrfach oder besonders langsam über hartnäckigen Schmutz wischen. Was dem Wischsauger an Anpressdruck fehlt, macht er durch die schnelle Drehung der Wischrolle wett. Top-Modelle sind auch in der Lage, das Wasser zum Wischen zu erhitzen oder per Dampf noch gründlicher zu reinigen.

Alternative: Wischsauger mit Stromkabel

Sind Wischsauger zu empfehlen?

Wischsauger kosten deutlich mehr als die herkömmliche Eimer-Schrubber-Lappen-Kombi. Die Zeitersparnis und die deutlich geringere Anstrengung während der Vor- und Nachbereitung sowie während des Putzens lohnen sich aber allemal.

Wer schon einmal über die Anschaffung von Saugroboter (Bestenliste) oder Akkusauger (Bestenliste) nachgedacht hat, hat eigentlich bereits den ersten richtigen Schritt gemacht und denkt über eine Vereinfachung der täglichen Arbeiten nach. Denn sowohl Saugroboter als auch Akkusauger erledigen die Bodenreinigung nicht ganz so gut wie ein herkömmlicher, kabelgebundener Sauger; sie bieten für sich betrachtet dennoch deutliche Vorteile. Genauso ist das mit Wischsaugern: Sie lösen ein Problem nicht vollständig, aber sie vereinfachen es enorm. Wischen wird damit zum Kinderspiel. Eine tolle Ergänzung sind Saugroboter mit ordentlicher Wischfunktion. Die fahren regelmäßig, der Wischsauger kommt dann nur sporadisch zum Einsatz.

Was sind die Nachteile von Wischsaugern?

Neben dem bereits erwähnten höheren Preis ist hauptsächlich die relative Unhandlichkeit ein Problem bei Wischsaugern. Sie müssen ausreichend große Frisch- und Abwassertanks aufnehmen. Dadurch entfällt ein frei stehendes, schlankes Saugrohr wie beim Akkusauger, mit dem man bequem unter die Möbel käme.

Der vergleichsweise klobige Korpus eines Wischsaugers verhindert daher häufig einfaches Wischen unter Möbeln, zumal bei den meisten Modellen der Wischkopf nicht bis 180 Grad gestreckt werden kann, sondern eher bis 140 Grad. Geht man mit dem Griff doch weiter runter, um etwa unter die Couch zu kommen, hebt sich der Wischkopf einfach ab und verliert dann seine Reinigungswirkung. Im Extremfall kann bei manchem Modell Wasser aus den Tanks auslaufen und sogar den Motor zerstören, beim normalen Wischen muss man davor aber keine Sorge haben. Mittlerweile gibt es jedoch auch diverse Modelle wie den Roborock F25 Ace oder den Mova X4 Pro, die sich komplett waagerecht auf den Boden legen und so problem- und gefahrlos unter Möbeln wischen und saugen können.

Wischsauger wiegen größtenteils 4 bis 5 Kilogramm und fühlen sich beim ersten Ausprobieren viel steifer an als ein Schrubber. Daran gewöhnt man sich aber schnell. Das Gewicht ist dann auch darum kein Nachteil mehr, weil die meisten Geräte durch die Rollendrehung oder angetriebene Räder wie von allein nach vorn gezogen werden. Ein weiterer Nachteil von Wischsaugern: Sie sind laut wie ein Akkusauger und verbrauchen Strom. Beides ist beim manuellen Wischen anders.

Manche Modelle wie der Jashen F16 haben Wechselakkus, die bei Nichtgebrauch in der Ladestation geladen werden heise bestenlisten

Können Wischsauger bis zum Rand wischen?

Es gibt noch einen Nachteil: Aktuell können viele Wischsauger nicht ganz bis an den Rand wischen. Wegen der Aufhängevorrichtungen, der Wischrolle und der Kunststoffabdeckung des Wischkopfes bleiben dann normalerweise 1 bis 2 Zentimeter bis zum Rand ungewischt. Es gibt aber auch Modelle wie den Roborock Dyad Pro und andere, die bis auf wenige Millimeter am Rand wischen können.

Der Roborock Dyad (Pro) kann als eines von wenigen Modellen fast bis an den Rand wischen heise bestenlisten

Kann man mit einem Wischsauger auch Teppich saugen?

Wischsauger sind für die Reinigung von Hartboden wie Fliesen, Beton, Laminat oder Parkett ausgelegt. Wie bei manuellem Wischen mit Eimer, Schrubber und Wischlappen ist von einem Reinigungsversuch auf dem Teppich abzusehen. Wer Teppiche reinigen möchte, sollte zu speziellen Teppich-Nasssaugern oder herkömmlichen (Akku‑)Staubsaugern greifen. Generell gilt: Kleine Krümelansammlungen oder etwas Sand kann ein Wischsauger aufnehmen, er ersetzt aber keinen Sauger. Dafür kommt er aber auch mit dem Haferflocken-Müsli oder Joghurt klar.

Für mehr trockenen Schmutz gibt es Kombimodelle wie den Dreame H12 Dual. Diese Modelle erlauben den einfachen Umbau vom Wischsauger zum Akkusauger. Das funktioniert schnell und unkompliziert mit wenigen Handgriffen. Alle benötigten Komponenten dafür sind im Lieferumfang enthalten. Allerdings sind diese Modelle teils mangels echter Borstenbürste dann trotzdem nur bedingt etwas für hochflorige Teppiche. Inzwischen gibt es aber auch Geräte mit solchen Motorbürsten.

Wie hygienisch sind Wischsauger?

Wischsauger verfügen normalerweise über HEPA-Filter, die die aufgesaugte Luft reinigen. Zudem geben viele Hersteller ihren Produkten spezielle Reinigungszusätze mit, die nicht nur gut riechen, sondern auch antibakteriell wirken. Erste Modelle ermöglichen zudem eine Sterilisierung des Wischwassers per Elektrolyse. Da in den meisten Varianten aber nur kaltes oder leicht warmes Wasser eingesetzt wird, kann eine Keimbildung letztlich nicht ganz ausgeschlossen werden – wie beim normalen Wischen von Hand auch. Im Gegensatz dazu wird bei Wischsaugern allerdings schmutziges Wasser nicht mehrfach oder über einen längeren Zeitraum verwendet, da es sofort wieder in den Abwassertank abgesaugt wird. Das sorgt für einen gleichbleibend hohen Sauberkeitslevel.

Der Jashen F16 pustet Luft zum Trocknen auf die nasse Wischrolle – das minimiert Bakterien- und Geruchsbildung heise bestenlisten

Die größten Probleme sehen wir bei der Wischrolle. Dabei geht es nicht um die Sauberkeit nach dem Wischen, denn dank automatischer Selbstreinigung in der Lade- und Reinigungsstation, die inzwischen fast jedes Gerät beherrscht, ist die ausreichend gewährleistet. Gelegentlich sollten Nutzer dennoch darüber nachdenken, die Wischrolle einmal richtig per Hand zu säubern. Wird die Rolle hingegen bei einfachen Modellen nicht ausgebaut und getrocknet, können hier durch die langsame Trocknung Bakterien und unangenehme Gerüche entstehen. Wer schon einmal eine Waschmaschinenladung in der Trommel vergessen hat, kennt das.

Inzwischen gibt es aber immer mehr Varianten, die zur Selbstreinigung auch zur anschließenden Trocknung durch Heißluft in der Lage sind. Das verhindert unserer Erfahrung nach Geruchs- und Bakterienbildung effektiv. Beides geht aber nicht geräuschlos vonstatten, es ist ein kontinuierliches Lüftergeräusch bis zum Abschluss der Trocknung zu hören. Weiterer Schwerpunkt: Der Abwassertank sollte nach jeder Verwendung des Wischsaugers geleert und gereinigt werden, um üble Gerüche zu vermeiden. Wir machen das bei unseren Modellen aber nicht jedes Mal sofort und haben damit bislang keine negativen Erfahrungen gemacht.

Wie lange hält der Akku bei einem Wischsauger?

Die meisten Hersteller geben Wischzeiten von 30 Minuten mit einer Ladung bei Akku-Wischsaugern an. Durch die Zeitersparnis der Geräte reicht das unserer Erfahrung nach locker für eine Etage eines normalen Einfamilienhauses oder einer Wohnung. Wer mehr benötigt, sollte auf die Möglichkeit zum Akkuwechsel achten und darauf, ob ein Ersatzakku im Lieferumfang enthalten ist. Das hilft außerdem, wenn es später zu Ermüdungserscheinungen beim Akku oder gar zu einem Defekt kommen sollte. Dann können die Energiespender einfach ausgetauscht werden. Die Akkus selbst sollten dank Lithium-Ionen-Technologie mehrere Jahre ohne spürbar nachlassende Leistung halten.

Fazit

Wischsauger lösen das Problem Wischen nicht komplett. Sie machen die Arbeit aber deutlich einfacher. Mit ihnen geht Wischen fast so schnell und bequem wie Staubsaugen. Die Frage nach einem weiteren Gerät für mehrere hundert Euro ist dennoch berechtigt. Wer jedoch bereits über einen Saugroboter oder einen Akkusauger nachgedacht hat, kennt den Wunsch nach mehr Komfort.

Genau hier setzen Wischsauger an. Sie sorgen spürbar für Entlastung im Alltag. Die Unterschiede zwischen den Modellen liegen primär im Funktionsumfang sowie in der Saug- und Wischleistung. Selbstreinigungsstationen mit anschließender Trocknung werden zunehmend zum Standard. Geräte wie der Tineco Floor One S9 Artist, der Dreame H15 Pro Heat, der Mova X4 Pro oder der Roborock F25 Ace Pro reinigen inzwischen sogar mit heißem Wasser und Schaum für bessere Ergebnisse.

Dreame H15 Pro Heat

Der Dreame H15 Pro Heat reinigt mit bis zu 85 °C heißem Wasser und automatischer Abziehlippe. Ob die Innovationen den Preis rechtfertigen, zeigt der Test.

- Heißwasser-Bodenreinigung mit bis zu 100 °C

- automatische Abziehlippe für perfekte Kantenreinigung

- starke Saugkraft von 22.000 Pa

- Tangle-Cut-System mit Messereinsatz gegen Haare

- teilweise billig wirkende Kunststoffteile

- sehr laute Selbstreinigung mit 77 dB(A)

- holprige App-Einrichtung mit Update-Problemen

- hoher Preis

Dreame H15 Pro Heat im Test: Wischsauger reinigt klasse mit heißem Wasser

Der Dreame H15 Pro Heat reinigt mit bis zu 85 °C heißem Wasser und automatischer Abziehlippe. Ob die Innovationen den Preis rechtfertigen, zeigt der Test.

Dreame setzt beim H15 Pro Heat auf zwei echte Innovationen: Als einer der ersten Wischsauger erhitzt er das Wischwasser auf bis zu 85 °C und nutzt es direkt zur Bodenreinigung. Die Konkurrenz verwendet heißes Wasser nur zum Auswaschen der Walze in der Station. Noch spannender ist die automatische Abziehlippe. Sie hebt und senkt sich automatisch, um Kanten und Ecken besonders gründlich zu reinigen. Beim Zurückziehen verhindert sie, dass Schmutz zurückbleibt. Diese Technologie gibt es aktuell bei keinem anderen Gerät.

Mit 22.000 Pa Saugkraft und verbesserter Gewichtsverteilung verspricht der Nachfolger des hervorragenden H14 Pro (Testbericht) deutliche Verbesserungen. Ob die Neuerungen den Aufpreis rechtfertigen, zeigt unser Test.

Achtung: Nur der Dreame H15 Pro Heat erhitzt das Wasser so stark – das Modell H15 Pro hingegen bietet dieses Feature nicht.

Lieferumfang: Welches Zubehör liegt beim Dreame H15 Pro Heat bei?

Im Karton finden sich neben dem Wischsauger die Lade- und Reinigungsstation, eine Reinigungsbürste für die Wartung, ein Fläschchen Reinigungsmittel-Konzentrat, ein Ersatz-HEPA-Filter und eine Ersatzwalze. Die Verpackung ist durchdacht, alle Teile sind sicher verstaut. Eine bebilderte Anleitung führt durch die erste Inbetriebnahme. Für die optionale App-Steuerung gibt es einen QR-Code. Der Lieferumfang ist komplett, weitere Anschaffungen sind nicht nötig.

Design: Wie gut ist die Verarbeitung des Dreame H15 Heat Pro?

Die Verarbeitung des H15 Heat Pro zeigt sich zwiespältig. Während die Technik hochwertig ist, wirken manche Kunststoffteile etwas billig. Der zweiteilige Schmutzwassertank mit getrennten Kammern für Wasser und feste Partikel ist clever konstruiert, zusätzlich gibt es einen Luftfilter. Allerdings erweist sich die Handhabung als tückisch: Beim Auseinandernehmen muss man das untere Teil festhalten, sonst schüttet man sich voll – was uns im Test prompt passierte.

Dreame H15 Pro – Bilderstrecke

Die Gewichtsverteilung wurde verbessert: Der Frischwassertank sitzt jetzt im Bodenelement, was den Bedienwiderstand verringert. Mit 6,2 kg ist das Gerät schwer, liegt aber besser in der Hand als der Vorgänger. Die Station wirkt solide, nimmt aber mit ihren Maßen einigen Platz ein. Das schwarze Design ist zeitlos, allerdings auch unspektakulär. Die automatische Abziehlippe am Kopf ist das optische Highlight und macht einen robusten Eindruck. Im direkten Vergleich wirkt der Tineco Floor One S9 Artist (Testbericht) hochwertiger verarbeitet.

Einrichtung: Wie schnell ist der Dreame H15 Pro Heat betriebsbereit?

Die Inbetriebnahme des H15 Pro Heat gelingt insgesamt schnell: Haupteinheit und Griff werden zusammengesteckt, die Station mit Strom versorgt und der 800-ml-Frischwassertank befüllt sowie eingesetzt. Optional lässt sich die zugehörige App nutzen – sie ermöglicht Firmware-Updates und bietet zusätzliche Einstellungsmöglichkeiten, ist im Alltag jedoch nicht zwingend erforderlich. Viele Funktionen lassen sich direkt über die Tasten am Gerät steuern.

Zur Einrichtung der App dient ein versteckter Knopf auf der Rückseite des Wischsaugers, über den auch die Lautstärke der Sprachansagen angepasst werden kann. Die Dreamehome-App (Account erforderlich) erkennt das Gerät per Umgebungssuche. Nach Verbindung mit dem Geräte-Hotspot kann das WLAN eingerichtet werden.

Im Test war direkt ein App-Update verfügbar, dessen Installation jedoch auffällig lange dauerte und zunächst mit einer Fehlermeldung abbrach – obwohl es offenbar dennoch korrekt installiert wurde. Die App bietet weiterführende Optionen wie die Anpassung der Radunterstützung oder der Wasserzufuhr. Nach dem ersten Ladevorgang von etwa vier Stunden ist der H15 Pro vollständig einsatzbereit.

Steuerung: Wie ist das Handling des Dreame H15 Pro Heat?

Die Bedienung erfolgt über Tasten am Griff: Power, Modus-Wahl und Selbstreinigung. Die 4-stufige Leistungsregelung passt sich dem Verschmutzungsgrad an. Im Auto-Modus erkennt die Schmutzerkennung Verunreinigungen und regelt die Saugkraft sowie Wassermenge automatisch. Das Handling profitiert von der verbesserten Gewichtsverteilung, auch wenn der Tineco S9 Artist noch etwas besser in der Hand liegt.

Die angetriebenen Lenkrollen erleichtern die Bewegung trotz des hohen Gewichts. Das Flat-Reach-Design mit auf 180 Grad neigbarem Handteil ermöglicht flaches Wischen unter Möbeln. Die fehlende Front-LED des Vorgängers vermissen wir bei schlechten Lichtverhältnissen.

Reinigung: Wie gut saugt und wischt der Dreame H15 Pro Heat?

Die Reinigungsleistung des H15 Pro Heat überzeugt auf ganzer Linie. Das Thermo-Rinse-System mit bis zu 85 °C heißem Wischwasser ist ein echter Gamechanger. Während die Konkurrenz nur lauwarmes oder kaltes Wasser nutzt, löst der H15 Pro selbst hartnäckige Verschmutzungen. Im Test entfernte er eingetrocknete Kaffeeflecken, Ketchup und Cola meist mit einer Überfahrt. Die Saugkraft von 22.000 Pa (Unterdruck) packt groben Schmutz mühelos.

Das absolute Highlight ist die Gap-Free-Abziehlippe. Sie senkt sich automatisch an Kanten ab und reinigt bis in die Ecken. Beim Zurückziehen hebt sie sich und verhindert, dass Schmutz zurückbleibt. Auf Hartböden bleibt nichts zurück – genial!

Bei der Selbstreinigung in der Station arbeitet er mit 100 °C heißem Wasser statt der üblichen 60 °C. Das ist hygienischer und entfernt Bakterien zuverlässiger. Mit 77 dB(A) ist die Walzenwäsche sehr laut, die Heißlufttrocknung aber effektiv. Der zweiteilige Schmutzwassertank mit getrennten Kammern für Wasser und feste Partikel erleichtert die Reinigung. Dennoch sollte er schnell geleert werden – nach zwei Tagen entwickeln sich bereits unangenehme Gerüche. Die fehlende automatische Reinigungsmitteldosierung des Vorgängers vermissen wir nicht wirklich.

Akkulaufzeit: Wie lange arbeitet der Dreame H15 Pro?

Mit seinem 21,6V Li-Ionen-Akku (5.0Ah) schafft der H15 Pro bis zu 72 Minuten Laufzeit. Das reicht für etwa 200 m² Wohnfläche. Die tatsächliche Laufzeit hängt vom gewählten Modus ab: Im Auto-Modus mit variabler Leistung hält er länger durch als bei maximaler Stufe. Die Ladezeit von 4 Stunden ist marktüblich. Der Akkustand wird permanent am Display angezeigt. Für die meisten Haushalte reicht eine Akkuladung locker aus.

Preis

Der Dreame H15 Pro Heat kostet in der UVP 699 Euro. Seit dem Marktstart ist der Straßenpreis aber etwas gefallen und liegt inzwischen bei 499 Euro. Angesichts der einzigartigen Features wie Heißwasser-Bodenreinigung und automatischer Abziehlippe ist der Preis gerechtfertigt.

Vergleichbare Premiummodelle, wie etwa der Tineco Floor One S9 Artist (Testbericht), liegen in ähnlichen Preisregionen, bieten jedoch keine vergleichbaren Innovationen. Wer auf die Heißwasserfunktion verzichten kann, findet bereits günstigere Alternativen ab 400 Euro. Das Modell Dreame H15 Pro ohne Heizfunktion bekommt man bereits für 360 Euro.

Fazit

Der Dreame H15 Pro Heat setzt neue Maßstäbe im Bereich der Wischsauger. Die Heißwasser-Bodenreinigung mit bis zu 85 °C warmem Wasser sowie die automatische, lückenlose Abziehlippe („Gap-Free“) sind echte Alleinstellungsmerkmale. Die Reinigungsleistung überzeugt auf ganzer Linie: Auf Hartböden bleibt nichts zurück, selbst Kanten und Ecken werden gründlich gesäubert. Dazu kommen die gesteigerte Saugleistung von 22.000 Pa und das Tangle-Cut-System zur Vermeidung von Haarverwicklungen.

Schwächen zeigt das Gerät bei der Verarbeitung: Einige Kunststoffteile wirken wenig hochwertig, und der Schmutzwassertank ist trotz durchdachter Kammertrennung unpraktisch zu entleeren. Die App-Einrichtung verlief holprig – inklusive fehlschlagender Updates. Dass die LED-Beleuchtung und automatische Reinigungsmitteldosierung des Vorgängers fehlen, ist verschmerzbar. Mit 77 dB(A) fällt die Selbstreinigung allerdings sehr laut aus.

Dennoch: Wer maximale Reinigungsleistung und innovative Technik sucht, kommt am H15 Pro Heat kaum vorbei. Er rechtfertigt seinen Premium-Preis durch echte Alleinstellungsmerkmale.

Roborock F25 Ace Pro

Der F25 Ace Pro ist der neueste Wischsauger aus dem Hause Roborock. Er saugt mit 25.000 Pa und wischt mit Schaum.

- Schaumdüse nützlich, um hartnäckigere Flecken zu lösen

- zuverlässige Saugleistung

- unkomplizierte Handhabung

- kaum Neuerungen zu Vorgängermodellen

- Schmutzwassersieb wirkt etwas fragil

Roborock F25 Ace Pro im Test: Wischsauger, der auf Knopfdruck Schaum versprüht

Der F25 Ace Pro ist der neueste Wischsauger aus dem Hause Roborock. Er saugt mit 25.000 Pa und wischt mit Schaum.

Die neueste Iteration der Wischsauger aus dem Hause Roborock, der F25 Ace Pro, versprüht auf Knopfdruck gezielt Schaum für eine bessere Fleckenreinigung. Alles andere bleibt größtenteils beim Alten: Selbstreinigung und Trocknung per Ladestation, Einrichtung per App. Lohnt sich das Upgrade für den Schaum oder bleibt man besser beim Vorgängermodell? Wir haben den Roborock F25 Ace Pro getestet und klären auf. Das Testgerät hat uns der Hersteller zur Verfügung gestellt.

Lieferumfang

Zum Roborock F25 Ace Pro gibt es die Ladestation samt Stromkabel, die Wischwalze, ein Reinigungskonzentrat, einen Ersatz-HEPA-Filter und eine Handbürste für die Wartung. Selbstverständlich liegen auch ein Quick-Start-Guide sowie eine ausführlichere Betriebsanleitung bei. Alle Einzelteile sind dank Styroporeinlagen sicher verstaut. Der Quick-Start-Guide zeigt zudem visuell die Anordnung der einzelnen Komponenten innerhalb der Box, was für ein späteres Verstauen extrem hilfreich ist.

Design

Hier ändert sich nicht wirklich etwas. Wie bisher setzt Roborock mit dem F25 Ace Pro auf schlichtes Schwarz und viel Plastik. Der Wischsauger kommt mit den Maßen 265 x 1100 x 250 mm und wirkt äußerst robust. Alle Einzelteile klicken problemlos ineinander und sitzen fest. Das Auffangsieb aus Kunststoff wirkt allerdings etwas fragil. Das liegt hauptsächlich an den Verbindungsstücken, die sich durch Drücken an beiden Seiten vom Rest des Schmutzwasserfiltersystems lösen.

Roborock F25 Ace Pro – Bilder

Die Ladestation ist kompakt und ebenfalls in unspektakulärem Schwarz gehalten. Das Stromkabel ist hingegen grau und bricht mit der sonst sehr einheitlichen Optik. Auch hier wirkt alles top verarbeitet.

Einrichtung

Die Einrichtung des Wischsaugers ist gewohnt einfach und schnell erledigt. Für die erste Inbetriebnahme muss man sämtliche Schutzfolien vom Gehäuse entfernen, die Wischwalze anbringen und den Griff in die dafür vorgesehene Öffnung stecken, bis er einrastet. Anschließend stellt man den F25 Ace Pro an die angeschlossene Ladestation, um den Akku aufzuladen. Zeitgleich kann die Koppelung mit der Roborock-App starten. Hinter dem Schmutzwassertank ist ein QR-Code versteckt, den man mit der Roborock-App einscannt, anschließend verbindet das Gerät mit dem heimischen WLAN. Etwaige anstehende Firmware-Updates können jetzt gestartet werden.

Für den ersten Einsatz steht zum Schluss noch das Auffüllen des Frischwassertanks und des Reinigungsmittelfachs an. Alles in allem ist die Einrichtung auch beim F25 Ace Pro super schnell und einfach erledigt.

Steuerung

Die Steuerung per App funktioniert erneut super. Man wechselt schnell zwischen den einzelnen Modi hin und her, justiert die Saugstärke und Wassermenge oder passt die Stärke der motorisierten Räder an. Auch die anschließende Selbstreinigung und Trocknung startet man bequem per App. Selbstverständlich steuert sich der Wischsauger auch über die Knöpfe am Gerät selbst.

Das LCD gibt Aufschluss über den gerade aktiven Modus sowie den derzeitigen Akkustand, wobei die Prozentanzeige der App aufschlussreicher ist als die Batterieanzeige auf dem Display.

Fester Bestandteil des Roborock F25 Ace Pro ist die Ansagerstimme, die jeden Moduswechsel und generell jede Zustandsänderung des Wischsaugers vertont. Uns stört das während des Tests nicht, auch wenn sie relativ laut ist. Das relativiert sich jedoch, sobald der Wischsauger in Betrieb ist. Die vertonten Informationen beschränken sich wirklich nur auf das Nötigste. Etwa der Wechsel in einen anderen Modus, die Information, dass der Ladevorgang beginnt oder die Aufforderung, dass man die Selbstreinigung starten soll. Man kann sie aber, wenn gewünscht, jederzeit leiser stellen oder auch ganz verstummen lassen. Es stehen neben Englisch und Deutsch auch viele andere Sprachausgaben, wie etwa Japanisch, Spanisch und Polnisch zur Auswahl. Beim

Roborock F25 Ace Pro – Bilder App

Über den Trigger am Griffinneren aktiviert sich die Düse am Bürstenkopf und verwandelt einen Teil des Reinigungskonzentrats in Schaum, der vor dem Wischsauger verteilt wird. Die motorisierten Räder fahren mit einer angenehmen Beschleunigung, die in Kombination mit der 70-Grad-Schwenkung des Wischsaugers für eine super präzise und komfortable Steuerung sorgt.

Auch den Roborock F25 Ace Pro kann man für die Reinigung senkrecht auf den Boden legen. Die App dient dann als Fernbedienung, mit der man den Wischsauger auch unter Möbel fahren kann, ohne sich dabei verrenken zu müssen. Eine Kamera, um unter den Möbeln sehen zu können, wo der Sauger gerade lang fährt, fehlt leider. Generell bietet sich die Fernsteuerung per App nur für punktuelle Bewegungen an, da sie sehr verzögert und grob auf die Eingaben reagiert.

Reinigung

Bei der täglichen Reinigung macht der F25 Ace Pro eine durchaus gute Figur. Mit 25.000 Pa saugt er gröbere Schmutzpartikel problemlos auf, während die Wischfunktion im Automatikmodus ideal das Parkett befeuchtet. Wir beseitigen mit ihm problemlos eingetrocknete Kakaoflecken, aber auch Flüssigkeiten wie verschüttete Hafermilch sind keine Herausforderung.

Mit der Schaumfunktion bearbeiten wir hartnäckigere Flecken und zum Großteil bemerken wir, dass sich die Verschmutzung im Anschluss tatsächlich leichter löst. Ein Allheilmittel ist das allerdings nicht, denn auch der F25 Ace Pro kommt an seine Grenzen. Eine besonders hartnäckige und festgetretene Verschmutzung auf dem Parkettboden bekommt er auch mit Schaum und mehrmaligem Darüberfahren nicht ohne weiteres gelöst. Hier müssen wir von Hand reinigen.

Auf Fliesen kann er verhältnismäßig gut sauber machen, auch wenn er in erster Linie für Parkettböden gedacht ist. Er muss sich aber deutlich schneller mit Flecken geschlagen geben als auf dem Holzboden. Hier hilft ebenso der zusätzliche Schaum beim Lösen der Verschmutzungen. Mit dem Schaum die gewünschte Stelle zu treffen, erfordert ein, zwei Versuche, bis man den Sprühradius raus hat. Die Düse beginnt nämlich unmittelbar vor dem Bürstenkopf zu sprühen und verteilt den Schaum dann in etwa bis zu 15 cm nach vorne.

Die Selbstreinigung mit der Ladestation erfolgt mit 95 °C heißem Wasser und reinigt die Wischwalze während unseres Tests rundum zufriedenstellend innerhalb von fünf Minuten. Auch die anschließende Lufttrocknung findet bei 95 °C statt, wahlweise in fünfminütiger Schnelltrocknung oder in der deutlich entspannteren dreißigminütigen Trocknung. Wir entscheiden uns für letztere und begrüßen das leise, angenehme Surren während des Vorgangs.

Was die Lautstärke angeht, ist der Roborock F25 Ace Pro im Betrieb vollkommen in Ordnung. Im Automatik-Modus und Max-Modus arbeitet er mit 50 bis 60 dB(A), die wir per Smartphone-App direkt am Gerät messen. 60 dB(A) waren aber tatsächlich auch die Obergrenze, die wir hier feststellen konnten. Die Werte dienen selbstverständlich nur als Richtwert und sind nicht mit Messwerten von professionellem Equipment zu vergleichen.

Die Lautstärke der Selbstreinigung fährt ebenfalls bis auf 60 dB(A) hoch, bewegt sich aber überwiegend bei etwa 55 dB(A). Das leise Surren der dreißigminütigen Selbsttrocknung pegelt sich bei etwa 35 dB(A) unmittelbar an der Station ein, ist aber bei laufendem Fernseher oder Musik nicht mehr wirklich zu hören.

Die anschließende Reinigung des Schmutzwassertanks findet nach wie vor von Hand statt. Hier gibt es nichts zu beanstanden, denn das Auffangsieb löst sich mit nur einem Handgriff vom Tank und hinterlässt größtenteils nur Plörre. Der feste Schmutz bleibt am Sieb hängen und kann einfach in den Mülleimer verfrachtet werden. Anschließend noch den HEPA-Filter, das Sieb und den Tank durchspülen, abtrocknen und wieder einsetzen, und der F25 Ace Pro ist erneut einsatzbereit.

Akkulaufzeit

Roborock verspricht bis zu 60 Minuten Betrieb im Eco-Modus, 40 Minuten im Auto-Modus und 30 Minuten im Max-Modus mit dem F25 Ace Pro. Die Werte decken sich mit unseren Beobachtungen, denn nach etwa 15 Minuten im Auto-Modus mit mehrmaligem Wechsel in den Max-Modus verbleiben noch gut 60 Prozent Akkuladung. Das sollte ausreichen, um die meisten Wohnungen problemlos durchzuwischsaugen.

Preis

Die UVP des Roborock F25 Ace Pro liegt bei 649 Euro. Aktuell gibt es den Wischsauger für 549 Euro auf der Roborock-Website. Alternativ ist er zum gleichen Preis auch bei Amazon verfügbar.

Fazit

Für 549 Euro reinigt der Roborock F25 Ace Pro zuverlässig die meisten Verschmutzungen – sowohl durch Wischen als auch Saugen. Unterstützt wird er hierbei durch die neu hinzugekommene Schaumdüse, die in unserem Test einen guten Job macht und tatsächlich eine nützliche Ergänzung für die regelmäßige Putzaktion ist.

Mit 25.000 Pa hat er zwar auf dem Papier eine höhere Saugleistung als noch der F25 Ace, saugt für uns aber nicht merklich besser oder schlechter. Auch die restlichen Funktionen gleichen sich mehr oder weniger mit denen älterer Modelle. Für Besitzer eines aktuelleren Roborock-Saugwischers lohnt sich also ein Upgrade auf den F25 Ace Pro nicht wirklich, da hier die Schaumdüse die einzige tatsächliche Neuerung darstellt.

Wer noch keinen Wischsauger hat, bekommt mit dem Roborock F25 Ace Pro aber ein kompetentes Modell, das im Hinblick auf Reinigung, Verarbeitung und Handhabung überzeugt.

Dreame Mova X4 Pro

Der Wischsauger Mova X4 Pro versprüht heißes Wasser auf Knopfdruck und entfernt damit stärkere Verschmutzungen. Sich selbst reinigt er mit 100 °C heißem Wasser.

- Sprühfunktion nützlich, um härtere Verschmutzungen zu lösen

- 100 °C heiße Selbstreinigung

- schlaues Design erleichtert Reinigung des Schmutzwassertanks

- solide Verarbeitung

- Sauger hat Schwierigkeiten mit größeren Objekten

- Wischwalze hinterlässt manchmal Staubfäden am Boden

- kein separates Fach für Reinigungskonzentrat

Mova X4 Pro im Test: Wischsauger, der 80 °C heißes Wasser auf Knopfdruck sprüht

Der Wischsauger Mova X4 Pro versprüht heißes Wasser auf Knopfdruck und entfernt damit stärkere Verschmutzungen. Sich selbst reinigt er mit 100 °C heißem Wasser.

Der Wischsauger Mova X4 Pro liefert einen Heißwassermodus, mit dem man auf Knopfdruck zusätzlich Wasser versprühen kann, um hartnäckige Flecken zu entfernen. Außerdem erleichtert ein gut durchdachtes Design die Reinigung des Geräts ungemein. Wie es um seine Saug- und Wischleistung bestellt ist, zeigt der Test.

Lieferumfang

Zusammen mit dem Wischsauger erhält man eine Ersatzwischwalze, eine Flasche Reinigungskonzentrat, einen Ersatz-HEPA-Filter sowie eine Handbürste. Zudem liegt dem Paket auch eine Betriebsanleitung bei.

Design

Der Mova X4 Pro kommt im schlanken Design in silbern-schwarzer Optik daher. Das LCD ist zum Ende des Griffs hin platziert, wodurch eine einwandfreie Lesbarkeit während des Saugens garantiert ist. Es zeigt den Akkustand sowie den derzeit ausgewählten Modus an. An den Seiten des Rumpfs befinden sich zwei Lautsprecher, über die das Gerät verschiedene Statusmeldungen von sich gibt.

Der Wassertank ist unten am Fuß des Saugwischers auf der Rückseite angebracht. Diesen löst man durch Anheben eines Griffs. Schade: Der Wassertank ist nicht zweigeteilt. Das bedeutet, eine separate Zufuhr des Reinigungskonzentrats gibt es nicht. Stattdessen kippt man es zum Wischwasser dazu, wodurch etwa bei der Selbstreinigung auch das Konzentrat mit ausgeschüttet wird. Das lösen andere Hersteller besser und verzichten so auf eine unnötige Verschwendung.

Am Griff befinden sich mehrere Knöpfe. Ein An-/Aus-Schalter, ein Button, um den Reinigungsmodus zu wechseln, sowie ein Knopf auf der Innenseite des Griffs. Dieser sorgt für eine gezielte Zufuhr von heißem Wasser, wenn man den entsprechenden Modus verwendet. Die Öffnung dafür befindet sich vorn am Fuß. Unterstützend arbeitet hier eine grüne LED, die permanent leuchtet, wenn der Wischsauger in Betrieb ist. Sie zeigt den Bereich an, in welchem das heiße Wasser verteilt wird.

Der Schmutzwassertank löst sich problemlos vom Saugwischer und offenbart den runden HEPA-Filter, welcher oben auf dem Tank thront. Durch Hochziehen eines Griffs trennt man nun Auffangbehälter vom Schmutzwassertank. Das Ganze funktioniert unkompliziert und ist leicht verständlich. Das Herausnehmen des Filters erfordert jedoch etwas Kraft. Praktisch ist das herausfahrbare Sieb, welches die Reinigung im Anschluss an den Saugvorgang erheblich erleichtert.

Die Reinigungsstation ist so konzipiert, dass man mit dem Saugwischer einfach in sie hineinfährt und das Gerät dabei nicht anheben muss.

Einrichtung

Da es für den Mova X4 Pro keine App gibt, ist die Einrichtung superschnell erledigt. Nach dem Auspacken muss man die Plastikfolien am Gerät entfernen, den Griff mit dem Rumpf des X4 Pro verbinden sowie die Reinigungsstation mit der Steckdose verbinden. Während der Mova X4 Pro lädt, kann man schon einmal den Wassertank auffüllen und das Reinigungskonzentrat hinzugeben. Die Wischwalze ist bei der Lieferung bereits vorinstalliert.

Steuerung

Die Steuerung des Mova X4 Pro erfolgt ausschließlich über die Buttons am Saugwischer selbst. Das ist entspannt und unkompliziert. Man hat allerdings aufgrund einer fehlenden App keine Möglichkeit, das Saug- und Wischverhalten gezielt an die eigenen Bedürfnisse anzupassen. Hier müssen die vier vorprogrammierten Reinigungsmodi ausreichen.

Dank der motorisierten Räder fährt sich der Mova X4 Pro angenehm leicht und ohne großen Kraftaufwand. Da er um 60 Grad nach links und rechts schwenkbar ist, fährt er mit flüssigen Bewegungen um Gegenstände herum. Er ist zudem in der Lage, auch komplett flach auf dem Boden zu saugwischen und kommt somit gut unter Möbel. Hier muss man allerdings beachten, dass sich die maximale Füllmenge des Schmutzwassertanks ändert. Im Idealfall sollte man demnach zu Beginn der Putzaktion unter den Möbeln saugwischen.

Über einen Trigger auf der Innenseite des Griffs sprüht man im Heißwassermodus zusätzlich das auf 80 Grad aufgeheizte Wasser vor den Saugwischer auf den Boden. Der Trigger ist dabei gut verarbeitet und bietet genügend Widerstand, um nicht aus Versehen zu sprühen.

Reinigung

Der Mova X4 Pro arbeitet mit bis zu 20.000 Pa und hat vier verschiedene Reinigungsmodi zur Auswahl: Smart-, Ultra-, Suction- und Hot-Water-Mode. Im Smart-Mode reguliert das Gerät die Saugkraft von selbst in Abhängigkeit von der Verschmutzung am Boden. Der Modus ist für die tägliche Reinigung gedacht. Ultra-Mode dreht den X4 Pro komplett auf und ist für die Tiefenreinigung gedacht. Die hinzugeschaltete Leistung wirkt sich logischerweise auch stärker auf die Akkulaufzeit aus. Suction-Mode ist rein zum Aufsaugen von Wasser gedacht, da weder die Bürste vom Gerät befeuchtet noch frisches Wasser auf dem Boden verteilt wird. Der Hot-Water-Mode ist das für uns spannendste Reinigungsprofil. Das liegt primär daran, dass man punktuell durch die Düse am Bürstenkopf 80 °C heißes Wasser auf den Boden sprühen kann, um eingetrocknete Flecken besser zu beseitigen.

Während unseres Tests haben wir tatsächlich mit diesem Reinigungsprofil die beste Erfahrung gemacht, als es um die Entfernung hartnäckiger Flecken ging. Obwohl der Ultra-Mode auf dem Papier verspricht, die intensivste Reinigung hinzulegen, konnten die härtesten Flecken auf unserem Fliesenboden in der Küche nur durch den Hot-Water-Mode beseitigt werden. Im Laufe des Tests alternieren wir so zwischen Smart- und Heißwassermodus, um sowohl Parkett- als auch Fliesenböden zu säubern. Eine Möglichkeit, gänzlich ohne Wasser zu saugen, gibt es leider nicht.

Was die Saugleistung betrifft, überzeugt der Mova X4 Pro nicht auf ganzer Linie. Während er Haare, Krümel und Staub im Laufe des Tests problemlos aufsaugt, kämpft er mit größerem Dreck wie ungekochten Penne, die er nur nach mehrmaligem Drüberfahren aufsaugt.

Die anschließende Säuberung des Wischsaugers erfolgt über die Reinigungsstation. Dank der Auffahrrampe fährt man den Mova X4 Pro einfach in die Station, mit der er sich über die Kontakte auf der Unterseite des Rumpfs verbindet. Der Button oben am Griff startet den Reinigungsprozess. Drückt man ihn erneut unmittelbar nach der Sprachansage, startet indes der Intensivmodus. Dieser ist lauter, dafür aber auch deutlich schneller als der reguläre. Gereinigt wird mit 100 °C heißem Wasser. Die anschließende Trocknung findet mit 90 °C Heißluft statt. Das Ergebnis kann sich sehen lassen: Die Bürste ist frei von Haaren, Fusseln oder sonstigem Schmutz und zudem trocken.

Dank des schlau designten Auffangbehälters mit herausklappbarem Sieb ist auch die Reinigung des Schmutzwassertanks superschnell erledigt. Es gibt wenige Verwinkelungen und Spalten, in denen sich Schmutz festsetzen kann. So reicht ein einfaches Durchspülen mit heißem Wasser in unserem Fall aus, um sichtbaren Schmutz restlos zu entfernen. Mit Schwamm und Spüli schrubbt man einmal kurz drüber, um Gerüche zu vermeiden. Auch der Tank an sich ist schnell durchgespült und abgetrocknet.

Akkuleistung

Wie auch bei anderen Wischsaugern ist die Akkuleistung abhängig vom gewählten Modus. Am meisten holt man mit dem Smart-Mode heraus. Hier schafft der Akku bis zu 45 Minuten Laufzeit, bevor der X4 Pro wieder an die Station muss. Maximal 25 Minuten hält er im Hot-Water-Mode durch. Vorgesehen ist er für einen Einsatz auf bis zu 350 m². Während des Tests kommen wir mit der Akkukapazität gut aus, bemerken aber definitiv die unterschiedlich starke Beanspruchung der einzelnen Modi. Für die meisten täglichen Einsätze ist der Smart-Mode vollkommen ausreichend und bietet mit bis zu 45 Minuten genügend Ausdauer, um mehrere Räume zu saugwischen. Bedenkt man, dass der Hot-Water-Mode für den punktuellen Einsatz gedacht ist, sind auch die maximalen 25 Minuten Einsatzzeit komplett in Ordnung.

Preis

Die UVP des Mova X4 Pro liegt bei 499 Euro. Derzeit kostet er 349 Euro.

Fazit

Der Mova X4 Pro überzeugt durch einige gut durchdachte Funktionen in der Ausstattung und ein schickes Design. Neben nützlichen Funktionen wie dem Heißwassermodus mit Sprühfunktion und der 100 °C heißen Selbstreinigung stechen eine sinnvoll designte Ladestation und das praktische Auffangsieb hervor. Die Saug- und Wischleistung überzeugt größtenteils, weist aber auch Schwächen auf: Mit 20.000 Pa saugt der X4 Pro zwar kräftig, kämpft aber mit größeren Objekten. Die Wischwalze verteilt das Wasser gleichmäßig und größtenteils schlierenfrei, an den Seiten sammeln sich jedoch immer mal wieder Staubfäden. Diese lösen sich gelegentlich und bleiben dann auf dem ansonsten sauberen Boden liegen. Zusammenfassend bekommt man mit dem Mova X4 Pro einen soliden Wischsauger zu einem kompetitiven Preis, der im Alltag seinen Job gut erledigt, allerdings in bestimmten Situationen schwächelt.

Tineco Floor One S9 Artist

Der Tineco Floor One S9 Artist kombiniert Saugen und Wischen in einem eleganten Design. Wir haben getestet, ob der Premium-Wischsauger für 599 Euro sein Geld wert ist.

- hervorragende Saug- und Wischleistung

- angenehmes Handling

- automatische Selbstreinigung mit Warmwasser und Heißlufttrocknung

- hochwertig & ungewöhnliches Design mit Leuchteffekten

- relativ hoher Preis

- hohe Lautstärke bei Selbstreinigung

Gutes Handling und Top-Reinigung: Wischsauger Tineco Floor One S9 Artist im Test

Der Tineco Floor One S9 Artist kombiniert Saugen und Wischen in einem eleganten Design. Wir haben getestet, ob der Premium-Wischsauger für 599 Euro sein Geld wert ist.

Der Tineco Floor One S9 Artist spielt mit 499 Euro auf Ebay im oberen Preissegment der Wischsauger mit, bietet dafür aber auch einige Besonderheiten. Neben einer motorisierten Rollunterstützung für leichteres Handling verfügt er über eine Reinigungsstation, die die Wischwalze mit erwärmtem Wasser durchspült und anschließend mit heißer Luft trocknet. Wir haben getestet, wie gut der Wischsauger im Alltag funktioniert und ob er mit der Konkurrenz mithalten kann.

Lieferumfang: Welches Zubehör liegt dem Tineco Floor One S9 Artist bei?

Im Lieferumfang des Tineco Floor One S9 Artist befinden sich neben dem Wischsauger selbst die kombinierte Lade- und Reinigungsstation, ein Filter sowie zwei Bürstenrollen für die Wischfunktion. Zusätzlich liegt eine Flasche der wohlriechenden Reinigungslösung bei, die dem Frischwasser beigemischt werden kann. Zur einfachen Pflege des Geräts ist außerdem ein spezielles Reinigungswerkzeug enthalten, mit dem sich Haare und andere Verschmutzungen leicht aus der Bürstenrolle entfernen lassen. Die Ausstattung ist damit komplett und enthält alles, was für den sofortigen Einsatz und die regelmäßige Wartung des Wischsaugers benötigt wird.

Design: Wie gut ist die Verarbeitung des Tineco Floor One S9 Artist?

Der Tineco Floor One S9 Artist überzeugt mit einer hochwertigen Optik, die klar auf Design ausgerichtet ist. Besonders auffällig ist die schillernde Kunststofffront, über der je nach Betriebsstatus verschiedene Leuchteffekte erscheinen. Trotz der Verwendung von Kunststoff wirkt das Gerät hochwertig verarbeitet und macht einen soliden Eindruck. Die Optik ist dabei durchaus diskutabel und sorgt in der Redaktion für ein gespaltenes Meinungsbild.

Mit Abmessungen von 266 x 1100 x 233 mm und einem Gewicht von 5,3 kg ist der S9 Artist zwar kein Fliegengewicht. Der im Wischkopf integrierte Frischwassertank fasst 1 Liter und ermöglicht damit längere Reinigungszyklen ohne Nachfüllen. Besonders praktisch ist das Zwei-Kammer-System des Schmutzbehälters, das groben Schmutz und Schmutzwasser voneinander trennt. Das vereinfacht die Reinigung und verhindert Verstopfungen. Die Entleerung sollte allerdings zügig nach der Reinigung erfolgen, da sich sonst in Verbindung mit der Feuchtigkeit Gerüche und Schimmel bilden können.

Tineco Floor One S9 Artist – Bilderstrecke

Das hochauflösende Farbdisplay im Handgriff zeigt wichtige Informationen wie den Akkustand, den aktuell verwendeten Modus sowie Statusmeldungen übersichtlich an. Insgesamt präsentiert sich der Tineco Floor One S9 Artist als durchdachtes Gerät mit einem gelungenen Mix aus Funktionalität und ansprechendem Design.

Einrichtung: Wie schnell ist der Tineco Floor One S9 Artist betriebsbereit?

Die Inbetriebnahme des Tineco Floor One S9 Artist gestaltet sich unkompliziert. Nach dem Auspacken muss man lediglich den Handgriff in die Basiseinheit stecken und den Akku vollständig aufladen, wobei er in unserem Fall bereits fast vollständig aufgeladen kommt. Abschließend muss man noch den Frischwassertank mit Leitungswasser befüllen; bei Bedarf kann man die mitgelieferte Reinigungslösung hinzufügen.

Für die Nutzung der App ist eine Installation auf dem Smartphone erforderlich. Dazu lädt man die App Tineco Life herunter und meldet sich mit seinem Tineco-Account an oder erstellt einen neuen. Anschließend muss man der App einige Berechtigungen erteilen. Alsdann kann man nach dem Wischsauger suchen und ihn in der App hinzufügen. Nach Angabe des WLAN-Netzwerks mit Passwort ist die Einrichtung abgeschlossen. Hier gab es im Test zunächst Probleme mit Android-Geräten, wo sich die App beim Download der Produktressourcen aufhing. Ein aktuelles App-Update hat dieses Problem jedoch behoben. Unter iOS funktioniert die App von Anfang an einwandfrei. Die App-Nutzung ist abgesehen davon optional, da alle wichtigen Funktionen auch direkt am Gerät gesteuert werden können.

Die Lade- und Reinigungsstation sollte an einem gut zugänglichen Ort mit Stromanschluss platziert werden. Nach der Reinigung wird der S9 Artist dort abgestellt, wo er automatisch auflädt und bei Bedarf die Selbstreinigungsfunktion durchführt.

Steuerung: Wie ist das Handling des Tineco Floor One S9 Artist?

Das Handling des Tineco Floor One S9 Artist gestaltet sich im Test ausgesprochen angenehm und übertrifft in diesem Punkt nach unserem Gefühl sogar den Dreame H15 Pro (Test folgt in Kürze). Auch hier erweist sich die motorisierte Rollunterstützung als große Erleichterung, da sie das Schieben des 5,3 kg schweren Geräts deutlich angenehmer macht. Der Wischsauger gleitet fast von selbst über den Boden, was die Reinigung auch in größeren Räumen weniger anstrengend macht.

Die Bedienung erfolgt hauptsächlich über das hochauflösende Farbdisplay im Handgriff, das alle wichtigen Informationen übersichtlich anzeigt. Praktisch sind auch die Statusmeldungen, die auf dem Display angezeigt werden, wenn etwa der Frischwassertank leer ist oder der Schmutzbehälter geleert werden sollte. So behält man während der Reinigung stets den Überblick über den Zustand des Geräts.

Mit einem Knopfdruck kann zwischen den drei Reinigungsmodi Auto, Max und Leise (62 dB(A)) gewechselt werden. Der Auto-Modus passt die Saugleistung automatisch an den erkannten Verschmutzungsgrad an, was in den meisten Fällen die beste Wahl darstellt.

Die App bietet zwar zusätzliche Einstellungsmöglichkeiten, ist aber für den täglichen Gebrauch nicht zwingend erforderlich. Hier lassen sich neben den auch am Gerät wählbaren Betriebs-Modi auch die Selbstreinigung auslösen sowie die Laufgeschwindigkeit je nachdem, ob der Wischsauger gekippt ist oder flachliegt. Ebenso kann man seine Reinigungshäufigkeit sowie die durchschnittliche Verschmutzung der letzten sieben Tage einsehen.

Wen die durchaus penetranten Sprachansagen des S9 Artist stören, der kann diese sowohl per App als auch am Gerät selbst über einen eigens dafür vorhandenen Knopf deaktivieren. So ist insbesondere die Betonung der Aufforderung „Stellen Sie das Gerät auf die Ladestation“ in eindrücklicher Erinnerung geblieben.

Reinigung: Wie gut saugt und wischt der Tineco Floor One S9 Artist?

Der Tineco Floor One S9 Artist überzeugt im Test mit einer hohen Saugleistung von 22.000 Pa sowie einer guten Wischleistung durch die Wischwalze. Er bewältigt verschiedene Verschmutzungen wie Kaffeeflecken, Vogelfutter mit Haferflocken oder Mehl mühelos. Bei einem einzigen Durchgang werden bereits etwa 95 Prozent des Schmutzes entfernt – lediglich beim Mehl bleiben vereinzelt klumpig-klebrige Rückstände zurück, die einen zweiten Durchgang erfordern.

Die Lautstärke im Auto-Modus beträgt moderate 65 dB(A), in der höchsten Stufe erreicht sie 69 dB(A). Der leise Modus arbeitet mit angenehmeren 62 dB(A).

Nach der Reinigung empfiehlt sich die Nutzung der automatischen Selbstreinigungsfunktion in der Station. Dabei wird die Wischwalze mit erwärmtem Wasser durchgespült und anschließend mit 85 Grad heißer Luft getrocknet. Dieser Vorgang dauert etwa 5 Minuten und erreicht eine Lautstärke von 77 dB(A). Im Test zeigte sich, dass die Walze nach einem Durchgang noch nicht vollständig trocken war, weshalb ein zweiter Trocknungsvorgang sinnvoll sein kann. Ausgelöst wird die Selbstreinigung über einen eigens dafür im Handgriff integrierten Knopf.

Akkulaufzeit: Wie lange arbeitet der Tineco Floor One S9 Artist?

Der Tineco Floor One S9 Artist ist mit einem 3900-mAh-Akku ausgestattet. Damit erreicht er je nach Modus eine Betriebsdauer von bis zu 50 Minuten, was für die gründliche Reinigung auch größerer Wohnflächen ausreichend ist.

Das Aufladen des vollständig entleerten Akkus dauert etwa 4 bis 5 Stunden in der Ladestation. Eine praktische Ladezustandsanzeige im Display informiert jederzeit über die verbleibende Akkulaufzeit, sodass man die Reinigung entsprechend planen kann.

Preis: Was kostet der Tineco Floor One S9 Artist?

Der Tineco Floor One S9 Artist ist mit seinem Normalpreis von 699 Euro im oberen Preissegment der Wischsauger angesiedelt. Aktuell bekommt man den Premium-Wischsauger 100 Euro günstiger bei Ebay für 499 Euro.

Fazit: Lohnt sich der Kauf des Tineco Floor One S9 Artist?

Der Tineco Floor One S9 Artist überzeugt im Test als leistungsstarker und komfortabler Wischsauger. Mit seiner hervorragenden Saug- und Wischleistung entfernt er nahezu alle Arten von Verschmutzungen effektiv und gründlich. Besonders die motorisierte Rollunterstützung macht das Handling angenehm und hebt den S9 Artist positiv von manchen Konkurrenzprodukten ab.

Die Selbstreinigungsfunktion mit Warmwasser und Heißlufttrocknung sorgt für Hygiene und verlängert die Lebensdauer der Bürstenrollen, auch wenn ein zweiter Trocknungsvorgang manchmal notwendig sein kann. Das durchdachte Zwei-Kammer-System des Schmutzbehälters erleichtert die Entleerung und Reinigung.

Mit einer Akkulaufzeit von bis zu 50 Minuten ist der S9 Artist für die meisten Haushalte ausreichend dimensioniert. Die intuitive Bedienung direkt am Gerät macht die App zwar nicht zwingend erforderlich, bietet aber zusätzliche Einstellungsmöglichkeiten.

Zum Preis von 599 Euro ist der Tineco Floor One S9 Artist zwar kein Schnäppchen, bietet aber im Vergleich zur ähnlich positionierten Konkurrenz ein gutes Preis-Leistungs-Verhältnis. Für alle, die einen leistungsstarken Wischsauger mit komfortabler Handhabung und ansprechendem Design suchen, ist der S9 Artist eine empfehlenswerte Wahl.

Dreame H14 Pro

Der Dreame H14 Pro vereint alle Features, die bislang in einem Top-Saugwischer denkbar sind. Das prädestiniert ihn für den Titel „bester Saugwischer“ – aber ist er das auch wirklich? Wir haben das Modell ausführlich getestet.

- Elektrolyse zur Frischwasser-Desinfektion

- Heißwasserwäsche

- Schnelltrocknung

- sinnvolle App-Steuerung

- fast vollständige Randreinigung

- hervorragende Reinigungswirkung

- Auto-Dosierung von Reinigungskonzentrat

- angetriebene Räder

- recht teuer

- Schnelltrocknung sehr laut

Dreame H14 Pro im Test: Das ist der beste Saugwischer

Der Dreame H14 Pro vereint alle Features, die bislang in einem Top-Saugwischer denkbar sind. Das prädestiniert ihn für den Titel „bester Saugwischer“ – aber ist er das auch wirklich? Wir haben das Modell ausführlich getestet.

Dreame baut nicht nur tolle Saugroboter wie den L40 Ultra (Testbericht) oder gar den X40 Ultra (Testbericht), sondern auch hervorragende Wischsauger. Das zuletzt getestete Modell H13 Pro (Testbericht) überzeugte weitgehend, bei der neuesten H14-Generation will der Hersteller aber noch einmal eine Schippe nachlegen. So vereint der getestete H14 Pro alles, was derzeit in einem perfekten Saugwischer denkbar ist – zumindest auf dem Papier. Wir haben im Test überprüft, wie sich die überzeugenden technischen Daten auf den Alltag auswirken.

Highlights: Welche Stärken bietet der Dreame H14 Pro?

- beidseitige Kantenreinigung

- informatives Display

- starke Saugkraft von bis zu 18.000 Pa

- verschiedene Leistungsmodi inkl. DIY-Modus (per App)

- automatische Schmutzerkennung mit Leistungsanpassung

- bis auf den Boden absenkbar für Reinigung unter Möbeln

- automatische Reinigungsmitteldosierung

- Moppwäsche mit bis zu 60 °C heißem Wasser

- 5-minütige Schnelltrocknung der Wischwalze per Heißluft

- elektrolytische Desinfektion des Frischwassers

- praktische LED-Beleuchtung der Bodendüse

- angetriebene Räder für leichte Manövrierbarkeit

- App-Support

Aktuell ist der Dreame H14 Pro zum Bestpreis von 379 Euro erhältlich (UVP 699 Euro).

Lieferumfang: Was ist beim Dreame H14 Pro dabei?

Bereits beim Zusammenbau macht der Dreame H14 Pro einen robusten Eindruck. Das Gerät ist hochwertig verarbeitet, die einzelnen Komponenten lassen sich einfach zusammenstecken. Mit einem Gewicht von 5,7 kg ist der H14 Pro allerdings kein Leichtgewicht. Umso wichtiger, dass Dreame hier mit den angetriebenen „Glide-Wheel“-Rädern vorgesorgt hat.

Diese sorgen dank eines intelligenten Algorithmus für eine flüssige Vor- und Rückwärtsbewegung, sodass sich der H14 Pro trotz des hohen Gewichts überraschend leicht manövrieren lässt. Das macht die Reinigung wirklich komfortabel, zumal diese Unterstützung kaum merklich abläuft und sich daher nicht künstlich anfühlt. Auch die praktische Freistehfunktion erweist sich als sehr nützlich im Alltag, um den Sauger mal eben für eine kurze Pause abstellen zu können, ohne dass er umfällt. Dabei saugt der Wischer einige Sekunden lang noch einmal verstärkt Feuchtigkeit ab, um die Gefahr von Feuchtigkeitsschäden am Standort zu minimieren.

Eines der Highlights ist sicherlich die Möglichkeit, den H14 Pro so weit abzusenken, dass er komplett flach auf dem Boden liegt. Das können nur wenige Konkurrenten, da die Gefahr besteht, dass der Saugwischer ausläuft. Das sorgt dann unter Umständen nicht nur für eine ungebetene Sauerei, sondern kann auch zur Beschädigung der Technik führen. Mit einer Gesamthöhe von nur 14 cm im liegenden Zustand kommt man damit einwandfrei unter die meisten Möbelstücke und kann auch diese Bereiche mühelos reinigen. Damit der Korpus des Gerätes dabei nicht verkratzt und auch empfindliche Holzböden nicht beschädigt werden, verfügt der H14 Pro auf der Rückseite über eine kleine Laufrolle. So kratzt der Saugwischer nicht über den Boden, sondern rollt auch liegend.

Der Dreame H14 Pro kommt gut geschützt in einem Karton zum Kunden. Zum Lieferumfang gehören neben der Sauger-Haupteinheit mit Wischwalze eine Ersatzwalze, Ladestation, Netzteil, Reinigungsbürste, Ersatzfilter, Reinigungsmittel-Konzentrat und eine Bedienungsanleitung.

Steuerung: Wie ist das Handling des Dreame H14 Pro?

Gesteuert wird der Dreame H14 Pro über vier Tasten und einen Schalter am Griff: Power-Taste zum Ein- und Ausschalten, Modus-Taste zum Wechseln der Reinigungsmodi, Reinigungs-Taste für Walzenreinigung auf der Station und den Schalter für Reinigungsmittelzufuhr. Auf der Oberseite des Korpus befindet sich ein schickes Display, das neben dem Akkustand und dem gewählten Reinigungsmodus auch per Farbindikatoren Auskunft über den Verschmutzungsgrad des Bodens gibt. Der Inhalt des Screens dreht sich in Abhängigkeit davon, ob das Gerät ladend in der Station steht oder in Gebrauch ist. So müssen sich Nutzer nie den Hals verrenken, um den Inhalt richtig herum ablesen zu können.

Der Auto-Modus erkennt Verschmutzung und passt die Saugleistung automatisch an. Im Ultra-Modus wird die elektrolytische Desinfektion des Frischwassers aktiviert, um Bakterien weitestgehend zu eliminieren. Der Nur-Saugen-Modus stoppt den Wasserzufluss und saugt Flüssigkeiten auf – etwa, um die Dusche trocken zu bekommen. Der DIY-Modus ist in der App individuell einstellbar und erlaubt so direkten Eingriff auf Parameter wie Saugleistung, Wasserzuführung und Elektrolyse.

App: Was kann man alles einstellen?

Bislang waren Apps für Saugwischer eher nettes Gimmick als sinnvolles Feature. Beim Dreame H14 Pro ist das etwas anders. Eine tolle Neuerung ist etwa die automatische Dosierung des Reinigungsmittels. Über eine kleine Klappe auf der Vorderseite lässt sich der Dosierer mit jeglicher Art von Reinigungsflüssigkeit-Konzentrat befüllen. Diese wird dann je nach Verschmutzungsgrad des Bodens automatisch dem Wischwasser in einem Mischverhältnis von 1:200 bis 1:30 zugegeben. Eine wirklich praktische Funktion, die dem Nutzer Arbeit abnimmt und in der App auf „kraftvolle Fleckentfernung“ umgestellt werden kann.

Zudem darf der Nutzer in der App die Antriebsstärke der Räder wählen, das LED-Licht des Wischkopfes deaktivieren und die Sprache sowie Lautstärke bestimmen. Außerdem gibt es hier Einblick auf Reinigungsverläufe, den Zustand der Verbrauchsmaterialien und Firmware-Updates können angestoßen werden – sofern Updates nicht automatisch bezogen werden sollen. Auch gibt es Schnellzugriffe für Reinigung und Trocknung: Von 5 Minuten Schnelltrocknung können Nutzer auf die deutlich leisere 1-Stunden-Trocknung wechseln. Dann gibt es auch noch den bereits erwähnten DIY-Modus, der in der App eingerichtet werden kann. Auch wenn längst nicht alle Funktionen wirklich eine App rechtfertigen, sind doch einige dabei, die den Umgang mit dem Dreame H14 Pro erleichtern.

Reinigung: Wie gut wischt der Dreame H14 Pro?

Doch kommen wir zum wichtigsten Punkt: Wie gut reinigt der Dreame H14 Pro? Um das herauszufinden, haben wir ihn diversen Härtetests unterzogen – mit beeindruckenden Ergebnissen. In unserem Test entfernte der Saugwischer Kaffeeflecken, Ketchup, verschüttete Haferflocken mit Milch und eingetrocknetem Schlamm bereits nach wenigen, meist schon nach nur einer Überfahrt rückstandslos. Hartnäckige Verunreinigungen wie eingetrockneter Ketchup benötigen zwar mehrere Überfahrten, das ist aber bei der Konkurrenz genauso.

Auch hinsichtlich der Randreinigung macht der H14 Pro eine ausgezeichnete, wenn auch keine perfekte Figur. Mit der beidseitigen Kantenreinigung kommt er bis auf wenige Millimeter, aber eben nicht ganz an Sockelleisten und Ecken heran. Ein Nacharbeiten ist hier aber insgesamt kaum nötig.

Absolut überzeugend schneidet der Dreame H14 Pro auch beim Thema Wischwalzenreinigung ab. Mit bis zu 60 °C heißem Wasser und rotierenden Vor- und Rückwärtsbewegungen der Walze entfernt die Selbstreinigung der Basisstation selbst festsitzende Verschmutzungen effektiv. Nach der Reinigung wird die Walze dank eines speziellen Heißluftverfahrens innerhalb von nur 5 Minuten nahezu komplett getrocknet. Das ist allerdings sehr laut, wir haben in einem Meter Abstand satte 64 dB gemessen. Das entspricht in etwa dem Akkustaubsauger Dyson V15 Detect (Testbericht) im Normalbetrieb. Dafür ist das eben schnell wieder vorbei. Die deutlich leisere Trocknungsmethode kam im Test auf etwa 39 dB, dauert dafür aber eine Stunde.

Heißwasserwäsche, Heißlufttrocknung und die Elektrolyse des Frischwassers sind ein echter Komfort-, Hygiene- und Zeitgewinn. Damit hebt sich der Dreame H14 Pro positiv von der Konkurrenz ab, denn die meisten Modelle bieten eine oder zwei dieser Funktionen, selten aber alle drei.

Preis: Was kostet der Dreame H14 Pro?

Aktuell ist der Dreame H14 Pro zum Bestpreis von 349 Euro erhältlich (UVP 699 Euro).

Fazit: Lohnt sich der Kauf des Dreame H14 Pro?

Der Dreame H14 Pro bietet ein echtes Rundum-sorglos-Paket. Exzellente Reinigungsleistung, ausgereifte Funktionen zur Selbstreinigung und Trocknung der Walzen, hohe Flexibilität dank flachem Wischen und leichte Handhabung durch die angetriebenen Räder machen den H14 Pro zum neuen Spitzenreiter unter den Saugwischern. Das Gerät lässt kaum Wünsche offen und setzt in vielen Bereichen Maßstäbe. Das hat natürlich mit stolzen 699 Euro in der UVP des Herstellers seinen Preis, in Relation zu ähnlich teuren Modellen ist er das aber auch wert.

Dreame H12 Dual

Ein Saugwischer wischt primär, ein Akkusauger saugt – warum nicht beides in Einem? Geht – und zwar beim Dreame H12 Dual. Er ist beides: vollwertiger Wischer und Sauger. Wie das klappt, zeigt der Test.

- wischt sehr gut

- saugt auf Hartboden ebenfalls sehr gut

- Motorbürste bleibt auch auf Teppich nicht stehen

- 2 Geräte in einem: Saugwischer und Akkusauger

- Trocknung mit Warmluft

- Filter als Akkusauger umständlich zu entleeren

Dreame H12 Dual im Test: Sehr guter Saugwischer und Akkusauger in einem

Ein Saugwischer wischt primär, ein Akkusauger saugt – warum nicht beides in Einem? Geht – und zwar beim Dreame H12 Dual. Er ist beides: vollwertiger Wischer und Sauger. Wie das klappt, zeigt der Test.

Ein Saugwischer kostet locker 300 Euro, ein ordentlicher Akkusauger auch. Anschließend kann man zwar gut Wischen und Saugen, allerdings stehen auch immer zwei Geräte rum. Dreame findet das offenbar auch überflüssig und bringt mit dem Dreame H12 Dual ein Modell auf den Markt, das wie der Roborock Dyad pro Combo (Testbericht) beides in Einem ist: vollwertiger Saugwischer und Akkusauger. Wir haben im Test überprüft, wie gut das tatsächlich klappt. Alle Saugwischer-Tests findet man in unserer Themenwelt Saugwischer.

Lieferumfang

Der Lieferumfang fällt beim Dreame H12 Dual zwangsläufig etwas umfangreicher als bei einem „einfachen“ Saugwischer aus. Denn zusätzlich zum Gerät selbst und der passenden Lade- und Reinigungsstation befinden sich darin zusätzlich ein Aufbewahrungsständer sowie das darauf zu lagernde Zubehör, das aus dem Saugwischer einen reinrassigen Akkusauger macht. Dazu gehört ein zusätzlicher Staubbehälter, Saugrohr, Bürstenkopf, eine kleine Motorbürste für Polster und ein Reinigungszusatz zum Wischen. Hinzu kommen eine zweite Wischrolle mit Stoffbezug sowie eine Fugendüse, mit der man etwa in Sofaritzen kommt. Aufbewahrung für Saugwischer und Akkusauger-Zubehör sind nicht miteinander verbunden und können daher theoretisch auch separat aufgestellt werden.

Design

Beim Design setzt Dreame auf den nahezu gleichen monolithischen Korpus wie beim Dreame H11 Max (Testbericht) oder dem Nachfolger H12 Pro. Entsprechend wirkt der H12 Dual wieder ziemlich wuchtig und ist das genaue Gegenteil des filigranen Jimmy HW9 (Testbericht). Trotzdem hat das Design des Dreame-Modells seinen Reiz und uns gefällt der Mix aus grauem und schwarzem Kunststoff sowie durchsichtigen Elementen gut. Oben installiert der Hersteller wieder ein Display, das sich um 180 Grad dreht. So können Nutzer sowohl beim Laden in der Station als auch während des Betriebs Inhalte ablesen, ohne sich den Hals verrenken zu müssen. Abweichend vom Vorgänger verfügt der HW12 Dual nun über einen zusätzlichen Tragegriff am oberen Bereich des Korpus, direkt unter dem Display.

Er dient als Griff, wenn der Saugwischer zum reinen Akkusauger umgebaut wird. Dafür lässt sich dieser Teil samt Motor, Display und Akku abnehmen, der Staubbehälter für den Akkusauger andocken und Saugrohr samt Bürstenkopf anschließen. Praktisch: Das Zubehör findet zusammen wie bereits angedeutet auf einem eigenen Aufbewahrungsständer Platz, nur die Reinigungsflüssigkeit zum Wischen passt nirgendwo hin und muss daher komplett separat aufbewahrt werden. Gut gefallen hat uns übrigens auch die Verarbeitung des HW12 Dual, hier klappert oder wackelt nichts.

Im Betrieb