Künstliche Intelligenz

GUI-Frameworks für .NET – Teil 6: Uno Platform

Die Uno Platform ist ein weiteres Cross-Platform-GUI-Framework für .NET und der direkte Mitbewerber von Avalonia aus Teil 5. Sie existiert seit dem Jahr 2018 als Open-Source-Projekt (Apache-2.0-Lizenz) der gleichnamigen kanadischen Firma mit Sitz in Montréal, mit rund 30 Mitarbeitenden.

Dr. Holger Schwichtenberg ist Chief Technology Expert bei der MAXIMAGO-Softwareentwicklung. Mit dem Expertenteam bei www.IT-Visions.de bietet er zudem Beratung und Schulungen im Umfeld von Microsoft-, Java- und Webtechniken an. Er hält Vorträge auf Fachkonferenzen und ist Autor zahlreicher Fachbücher.

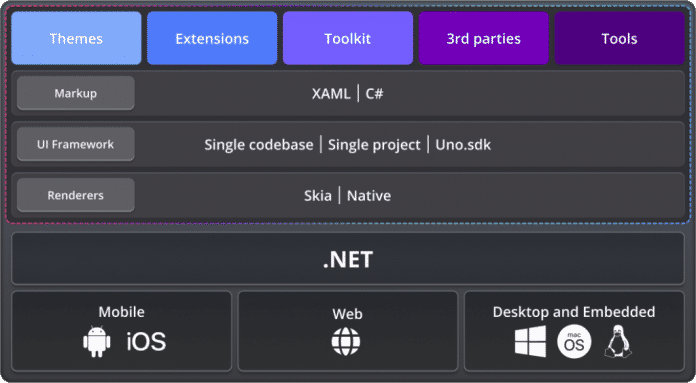

Uno-Anwendungen laufen auf Windows ab Windows 7, auf allen Linux-Distributionen, für die .NET 7.0 oder höher zur Verfügung steht, macOS (Desktop und Catalyst, ab Version 10.15), iOS ab Version 11, Android ab Version 5 und in allen WebAssembly-fähigen Browsern. Es gibt auch ein NuGet-Paket für Tizen, das aber weder in der Plattform-Liste auf GitHub noch in der Dokumentation erscheint, weil es nicht auf dem aktuellen Stand ist.

Uno basiert auf der eXtensible Application Markup Language (XAML), genauso wie die Windows Presentation Foundation (WPF), die Windows UI Library (WinUI), WinUI 3, .NET Multi-Platform App UI (MAUI) und Avalonia/Avalonia XPF. Die Syntax von XAML in Uno orientiert sich aber nicht an WPF-XAML, sondern an WinUI-XAML inklusive SVG-Rendering.

(Bild: coffeemill/123rf.com)

Verbesserte Klassen in .NET 10.0, Native AOT mit Entity Framework Core 10.0 und mehr: Darüber informieren Dr. Holger Schwichtenberg und weitere Speaker der Online-Konferenz betterCode() .NET 10.0 am 18. November 2025. Nachgelagert gibt es sechs ganztägige Workshops zu Themen wie C# 14.0, KI-Einsatz und Web-APIs.

Neue Möglichkeiten seit Uno Platform 6.0

Entwicklerinnen und Entwickler hatten vor dem Erscheinen von Uno in Version 6.0 am 7. Mai 2025 die Wahl zwischen der Kompatibilität zu UWP mit WinUI 2 im Namensraum Windows.UI.Xaml oder WinUI 3 im Namensraum Microsoft.UI.Xaml. Daher gibt es zwei Uno-Pakete: Uno.UI für UWP-XAML (hier gibt es keine Version 6.0 mehr) und Uno.WinUI für WinUI-3-XAML (hier gibt es eine Version 6.0). Da das Uno-Entwicklungsteam Uno.WinUI automatisiert aus Uno.UI erzeugt, sind die Funktionen beider Pakete nahezu identisch. Mit Version 6.0 empfiehlt Uno nun die Migration auf WinUI 3. Auch mit dem Hosting in einer GTK-Shell macht Uno in Version 6.0 Schluss.

Auf Windows bietet Uno aber in Version 6.0 immer noch vier Optionen für die Shell: WPF, Win32, Windows App SDK (dann läuft die Anwendung aber erst ab Windows 10 Version 19041) oder X11, wenn Windows Subsystem for Linux 2 mit einer entsprechenden Linux-Distribution vorhanden ist. Die Win32-Shell bietet im Gegensatz zur WPF-Shell Trimming (Tree Shaking) an, was die Anwendungsgröße beim Deployment verkleinert. Auch Self-Contained Apps, die die .NET-Laufzeitumgebung und alle benötigten Bibliotheken mitbringen und daher keine vorherige Installation der .NET Runtime voraussetzen, sind nur beim Win32-Hosting möglich. Eine Kompilierung mit dem Native-AOT-Compiler ist allerdings noch nicht möglich. „Native AOT compilation is on the roadmap“, sagte dazu Sasha Krsmanovic, Chief Marketing Officer bei Uno, im Interview. Ob es bei den vier Hosting-Optionen auf Windows bleiben wird, ist offen. „The future of WPF will depend on usage by our clients and community, which is the case for all the components of Uno Platform“, so Sasha Krsmanovic.

Seit Uno 6.0 gibt es die Steuerelemente Media Player und WebView2 zur Darstellung von HTML-Inhalten. Uno ist aber auch in Version 6.0 nicht zu 100 Prozent kompatibel zu Microsofts WinUI-Oberflächen. Es fehlen in Uno zum Beispiel die Steuerelemente ListBox, MapControl, Hub, SemanticZoom, RichTextBlock, VirtualizingStackPanel, ParallaxView und AnnotatedScrollBar.

Eine Liste von Abweichungen zwischen WinUI-Steuerelementen und Uno-Steuerelementen findet man in der Dokumentation. Auch bei der XAML-Syntax gibt es marginale Unterschiede. So ist der Typ DependencyObject in Uno eine Schnittstelle statt einer Klasse wie bei Microsoft. Auf Android, iOS und macOS weicht die Vererbungsfolge für die Basisklasse UIElement von der Implementierung von Microsoft ab.

Das Rendering in Uno Platform 6.0 basiert wie bei Avalonia auf der Skia Graphics Library von Google via SkiaSharp aus dem Mono-Projekt (siehe Abbildung 1) – außer beim Hosting in der Windows App auf Windows, wo die DirectX-12-basierte Rendering Engine des SDK zum Einsatz kommt (siehe auch Teil 2 der Serie). Vor Uno 6.0 wurden auf iOS und Android Native Renderer eingesetzt, die weiterhin als Optionen verfügbar sind.

Im Webbrowser wurde vor Uno 6.0 XAML immer nach HTML und CSS umgesetzt (mit sehr vielen

Aufbau der Uno Platform in Version 6.0 (Abb. 1)

(Bild: Uno Platform)

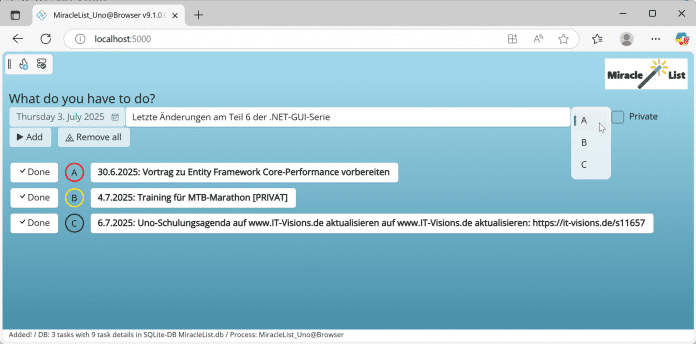

Die Beispielanwendung zur Aufgabenverwaltung läuft hier im Browser auf Basis von Uno, WebAssembly, HTML und einer lokalen SQLite-Datenbank im Browserspeicher (Abb. 2).

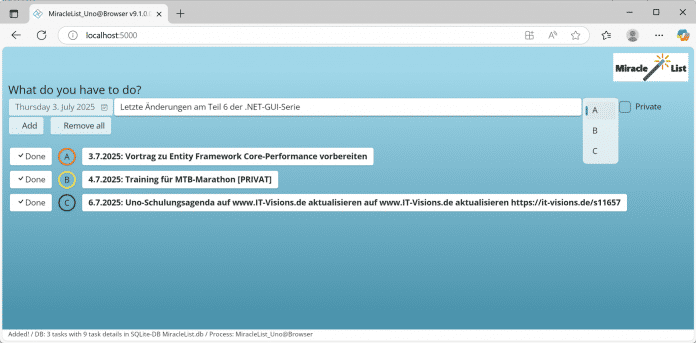

Beim Skia-Rendering statt HTML-Rendering in dieser Abbildung sind die Abstände leicht anders und zwei Symbole sind verschwunden (Abb. 3).

Künstliche Intelligenz

Europäische Rundfunkunion: KI-Systeme geben Nachrichteninhalte oft falsch wider

Eine Studie der Europäischen Rundfunkunion (EBU) zur News-Integrität von KI-Chatbots kommt zu dem alarmierenden Ergebnis, dass Künstliche Intelligenz weiterhin keine verlässliche Quelle für den Nachrichtenkonsum darstellt. Die großangelegte, marktübergreifende Untersuchung, bei der 22 öffentlich-rechtliche Medienanstalten aus 18 Ländern und in 14 Sprachen führende KI-Assistenten wie ChatGPT, Copilot, Perplexity und Gemini bewerteten, zeigt: Fehler im Umgang mit Nachrichten treten bei diesen nicht isoliert auf. Sie sind systemisch und erstrecken sich über alle Sprachen und Plattformen.

Weiterlesen nach der Anzeige

Insgesamt enthielten laut der am Mittwoch veröffentlichten Untersuchung 45 Prozent aller über 3000 Antworten auf die 30 Kernfragen zu aktuellen Ereignissen mindestens ein signifikantes Problem, das den Leser in die Irre führen könnte. Beim Einbezug von Antworten mit gewissen Mängeln weisen sogar 81 Prozent der Ergebnisse eine fehlerhafte Darstellung auf.

Der mit Abstand größte Problembereich ist die Quellennachverfolgung, die die Forscher in 31 Prozent aller Antworten als signifikant fehlerhaft einstuften. Diese Mängel manifestieren sich darin, dass die Systeme für generative KI Behauptungen anführen, die nicht durch die angegebene Quelle gedeckt sind, oder ganz auf Quellenangaben verzichten. Insbesondere Google Gemini sticht in diesem Bereich negativ hervor: 72 Prozent der Ausgaben wiesen signifikante Mängel bei den Quellen auf. Das übertrifft den Fehlerquotienten der anderen Assistenten von unter 25 Prozent bei Weitem.

Veraltete Angaben, erfundene Links

Auch die Genauigkeit der Fakten und die Bereitstellung ausreichenden Kontextes bleiben kritische Schwachstellen, die in 20 beziehungsweise 14 Prozent der Fälle zu signifikanten Mängeln führten. Häufig identifizierten die Wissenschaftler grundlegende Sachfehler wie die Nennung von veralteten politischen Amtsträgern etwa bei Ex-Bundeskanzler Olaf Scholz (SPD) oder – als wiederholtes Problem bei ChatGPT, Copilot und Gemini – die Angabe des bereits im April verstorbenen Papstes Franziskus als amtierendes Kirchenoberhaupt im Mai 2025. Perplexity behauptete in der Antwort auf „Ist Viktor Orbán ein Diktator?“, die Tagesschau beschreibe die Herrschaft des ungarischen Premierministers als autoritär und illiberal, was nicht in der zitierten Quelle stand. Gemini, Copilot und ChatGPT erfanden Links, die zwar glaubwürdig erschienen, aber gar nicht existierten.

Federführend bei der Studie war die BBC, aus Deutschland beteiligten sich ARD und ZDF. Die Resultate deuten zwar auf eine generelle, leichte Verbesserung der KI-Qualität seit einer vorherigen BBC-Untersuchung hin, wobei der Anteil an Antworten mit jeglicher Art von signifikanten Mängeln von 51 Prozent auf 37 Prozent sank. Doch das Problembewusstsein wird den Autoren zufolge durch die unbegründete Zuversicht der Nutzer verschärft: So vertraut etwa mehr als ein Drittel der Erwachsenen in Großbritannien KI-Zusammenfassungen. Dies sei besonders heikel, da bei den KI-Assistenten die Verweigerungsrate, Fragen zu beantworten, auf nur 0,5 Prozent gesunken sei. Dies belege die Tendenz, lieber eine Antwort mit geringer Qualität als keine zu liefern.

Ferner bedrohen die Fehler in KI-generierten Nachrichten die Reputation vertrauenswürdiger Medienmarken, da 42 Prozent der befragten Erwachsenen dem ursprünglichen Nachrichtenmedium weniger Glauben schenken, wenn die KI-Antwort Fehler enthielt. Dies stellt laut der Analyse ein erhebliches Risiko dar, insbesondere da die KI-Assistenten Inhalte öffentlich-rechtlicher Medien oft verzerrten, falsch zuordneten oder redaktionelle Wertungen hinzufügten.

Weiterlesen nach der Anzeige

Ruf nach Gesetzgeber und Regulierer

Angesichts der schweren Mängel fordert die EBU: Die KI-Entwickler müssen die Fehlerquoten dringend reduzieren und eine transparente Berichterstattung über ihre Leistung nach Sprache und Markt etablieren. Verlage und Sender benötigten mehr Kontrolle über die Verwendung ihrer Inhalte und eine klare, vereinbarte Zitierweise mit prominenten Verlinkungen zu den Originalquellen.

Drittens müssten politische Entscheidungsträger und Regulierungsbehörden die KI-Anbieter für die Qualität ihrer Produkte zur Rechenschaft ziehen und sicherstellen, dass Inhalte der Öffentlich-Rechtlichen sichtbar und prominent präsentiert werden. Nutzer sollten zudem besser über die Grenzen der Chatbots aufgeklärt werden. Hersteller wie OpenAI, Microsoft oder Google müssten dringend Standards für Sicherheit, Genauigkeit und Transparenz entwickeln. Das Forschungsteam hat dafür ein „Toolkit“ herausgegeben.

Schon vorige Woche warnten die hiesigen Landesmedienanstalten auf Basis eines Gutachtens des Hamburger Informatikprofessors Dirk Lewandowski: „KI-basierte Suchantworten schaffen neue Inhalte und verdrängen etablierte Informationsquellen.“ Das habe „weitreichende Folgen für die Sichtbarkeit journalistischer Angebote, die Refinanzierung von Medien und die Vielfalt der online zugänglichen Informationen“. Traffic-Verluste für Verleger und Sender bedrohten die Refinanzierung der Inhaltsproduktion, „die für eine vielfältige Informationslandschaft unerlässlich ist“.

(mki)

Künstliche Intelligenz

Kommentar zum Totalausfall bei AWS: Nichts gelernt in den letzten 30 Jahren

Vielleicht wollten Sie ja einem Kollegen eine Signal-Nachricht schreiben, bei Ring nachschauen, was gerade in Ihrer Garageneinfahrt los ist oder ein Meeting per Zoom veranstalten. Menschen im Vereinigten Königreich wollten womöglich ihre Steuererklärung abgeben oder ihre Sprachkenntnisse per Duolingo aufbessern. In allen Fällen war die Antwort dieselbe: „Leider nein“. Denn bei AWS hat es ordentlich gescheppert – und tatsächliche wie selbst ernannte Experten überschlagen sich seither mit Superlativen, was den technischen wie finanziellen Schaden angeht. Klar ist: Der Ausfall bei den Amazon Web Services (AWS), der eigentlich nur einzelne AWS-Regionen betraf, hat weltweit für riesiges Aufsehen und für große IT-Probleme gesorgt.

Weiterlesen nach der Anzeige

Martin Gerhard Loschwitz ist freier Journalist und beackert regelmäßig Themen wie OpenStack, Kubernetes und Ceph.

Dabei lässt sich die Situation eigentlich relativ nüchtern beschreiben. AWS ist ein normaler Anbieter von IT-Infrastruktur und mithin denselben Gesetzmäßigkeiten unterworfen, mit denen es jeder Administrator bei On-Premises-Setups genauso zu tun hat. Geht ein Standort offline, oder in diesem Falle eine AWS-Region, sind dessen Dienste nicht länger verfügbar. Dass gerade in größeren Umgebungen standortübergreifende Redundanz ein Thema ist, wissen Admins seit mindestens 30 Jahren. Dass gefühlt die halbe Welt offline geht, weil sich bei AWS Sand im Getriebe einzelner Regionen befindet, spricht insofern eher nicht für die Industrie. Offensichtlich hat man sich vielerorts viel zu sehr darauf verlassen, AWS würde schon nicht offline gehen.

Will man sich gegen ein solches Szenario absichern, braucht man Redundanz auf allen Ebenen seines Setups. AWS bietet diese Möglichkeit durchaus. Ihre technische Umsetzung allerdings ist komplex – und günstig ist der Spaß auch nicht gerade. Es ist legitim, bewusst auf diese Form der Redundanz zu verzichten und das Risiko eines Ausfalls zu tragen. Katzenjammer, wenn ebendieses Szenario dann tatsächlich mal eintritt, ist allerdings fehl am Platz.

Multi-Cloud-Szenarien helfen nicht

Mein LinkedIn-Stream ist seit vorgestern voll von Beiträgen findiger Consultants, die Kapital aus der Situation schlagen wollen und Multi-Cloud-Szenarien zur Conditio sine qua non moderner IT-Infrastruktur erklären. Der Ansatz ist also offensichtlich nicht ganz falsch: Denn unabhängig von einzelnen Anbietern ist man eben nur dann, wenn man die eigene IT in der Cloud auf verschiedene Säulen verteilt. Aber: Das Gros der Proponenten von Multi-Cloud-Setups springt als Tiger und landet als Bettvorleger. Denn als Alternative zu AWS preisen sie allen Ernstes Microsoft Azure oder die Google-Cloud an. Zumindest aus europäischer Sicht ist das nachgerade grotesk.

Man kann auf das AWS-Desaster nämlich auch durch eine andere Brille schauen: Das Ereignis war nicht weniger als ein Vorgeschmack auf das Unheil, das Europa droht, wenn Dienste von AWS, Azure oder Google noch mehr zum politischen Spielball verkommen als ohnehin schon. Kann ein Land wie das Vereinigte Königreich seine Steuern nicht mehr erheben, weil zentrale IT nicht mehr funktioniert, ist das für das Land nicht weniger als eine Gefährdung seiner Existenz.

Wenn in Krankenhäusern buchstäblich das Licht ausgeht, weil Energieversorger und Netzbetreiber von Diensten US-amerikanischer Anbieter abhängig sind und diese nicht mehr zur Verfügung stehen, ist das eine Katastrophe. Und wenn Behörden nicht länger kommunizieren können, weil die US-Regierung den Zugang zu Microsoft 365 aus politischen Gründen sperrt, ist das ein Debakel im Hinblick auf die öffentliche Ordnung und die Sicherheit. Sie brauchen einen Krankenwagen? Donald Trump sagt nein. Schade, Schokolade!

Weiterlesen nach der Anzeige

Alibi-Debatte

Der ganze Vorgang ist archetypisch für die seit Jahrzehnten völlig ohne Not stattfindende politische Selbstverzwergung Europas. Lächerliche Konstrukte wie „Datentreuhänderschaft“ und pseudo-souveräne Clouds der großen Anbieter lullen die Europäerinnen und Europäer in ein Gefühl von Sicherheit, wo de facto längst höchste Eile geboten ist, um wirklich souveräne europäische Alternativen zu schaffen. Noch jedes Versprechen, das Microsoft, Google & Co. im Hinblick auf die angebliche Sicherheit und Verfügbarkeit europäischer Daten auf Servern amerikanischer Anbieter in Europa gegeben haben, mussten sie irgendwann kleinlaut kassieren.

Hochnotpeinlich musste ein Repräsentant Microsofts vor einem Untersuchungsausschuss des französischen Parlaments zugeben, dass man letztlich gegen den langen Arm der US-Regierung nichts tun könne. Und wie weit her es mit der Sicherheit der deutschen Delos-Cloud mit Microsofts Software wirklich ist, hat erst kürzlich das Innenministerium Baden-Württembergs zu Protokoll gegeben: gar nicht nämlich. Das in Deutschland manchmal etwas überstrapazierte Thema des Datenschutzes spielt dabei wie beschrieben noch gar nicht die zentrale Rolle. Der AWS-Ausfall zeigt stattdessen, dass das plötzliche Wegfallen zentraler Dienste von US-Hyperscalern zum Zusammenbruch von Teilen der öffentlichen Infrastruktur führt. Da beruhigt es ungemein, dass die Bundeswehr sich in einem akuten Anfall völliger geistiger Umnachtung erst kürzlich dazu entschieden hat, ihre In-House-Cloud mit tatkräftiger Unterstützung Googles zu bauen. Es sind offensichtlich alle verrückt geworden.

Wer als Politiker dabei ernsthaft bezweifelt, die aktuelle US-Regierung könne AWS, Azure und Google als politisches Druckmittel einsetzen, belügt sich selbst und die Öffentlichkeit. Denn rote Linien gibt es für die zweite Trump-Administration ganz offensichtlich nicht. Erlaubt ist, was dem eigenen Vorteil dient, das hat Trump ein ums andere Mal klar unter Beweis gestellt. Längst ist es fünf nach zwölf aus europäischer Sicht, was souveräne Alternativen zu den großen US-Tech-Giganten betrifft. Kommt man in Europa nicht langsam aus dem Quark, war der AWS-Ausfall nur ein laues Lüftchen verglichen mit dem, was die alte Welt absehbar erwartet.

Sag mir, wo die Admins sind

Ach, und übrigens: „Ausschließlich on Premises“ ist nicht die Lösung des Problems, auch und gerade nicht für Europa. Bei aller Kritik am Prinzip des Cloud-Computings kommt man nämlich nicht umhin, dessen Vorteile anzuerkennen. Es ist objektiv hilfreich für Behörden und Firmen und Organisationen, wenn sie kritische IT-Infrastruktur nicht selbst betreiben müssen, sondern sich bei einem Anbieter dafür einmieten können.

Schließlich fehlt mindestens eine ganze Generation von Systemadministratoren. Denn die Industrie hat in den vergangenen 20 Jahren lieber vorrangig Entwickler ausgebildet, um das nächste europäische Einhorn zu schaffen. Und in völliger Ignoranz der Tatsache, dass dieses Einhorn dann auch jemand betreiben muss. Die „Economy of Scale“ der Cloud mit hohem Automationsgrad hilft dabei, IT (auch in Europa) in der Breite absehbar überhaupt betreibbar zu halten. Doch müssen die Europäer endlich lernen, digital auf eigenen Beinen zu stehen. Der perfekte Zeitpunkt dafür wäre vor 20 Jahren gewesen. Der nächstbessere Zeitpunkt ist genau jetzt.

()

Künstliche Intelligenz

Amateurfunk: Ein Einblick in das faszinierende Hobby

Ein Funkgerät, eine Antenne und die ganze Welt als Gesprächspartner: Das ist Amateurfunk. Während für die meisten Kommunikation heute über Smartphone oder Internet läuft, greifen Funkamateure noch immer zu Mikrofon, Morsetaste oder Rechner, um Signale in die Atmosphäre zu schicken.

In unserem Beitrag begleiten wir zwei Funkamateure, die zeigen, wie vielseitig dieses Hobby ist. Vom klassischen Sprechfunk bis hin zu digitalen Betriebsarten. Der Amateurfunk verbindet Technik, Physik und eine weltweite Community. Dabei geht es nicht nur ums Reden, sondern ums Experimentieren, Lernen und Entdecken.

Was treibt Menschen dazu, in ihrer Freizeit Funkwellen um die halbe Welt zu schicken? Und welche Technik steckt eigentlich dahinter? Wir werfen einen Blick in diese Welt in Form einer Reportage als Videobeitrag.

Das war die Leseprobe unseres heise-Plus-Artikels „Amateurfunk: Ein Einblick in das faszinierende Hobby“.

Mit einem heise-Plus-Abo können Sie den ganzen Artikel lesen.

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenAdobe Firefly Boards › PAGE online

-

Social Mediavor 2 Monaten

Social Mediavor 2 MonatenRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

UX/UI & Webdesignvor 1 Monat

UX/UI & Webdesignvor 1 MonatFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online

-

UX/UI & Webdesignvor 4 Tagen

UX/UI & Webdesignvor 4 TagenIllustrierte Reise nach New York City › PAGE online

-

Apps & Mobile Entwicklungvor 3 Monaten

Apps & Mobile Entwicklungvor 3 MonatenFirefox-Update 141.0: KI-gestützte Tab‑Gruppen und Einheitenumrechner kommen