Entwicklung & Code

IT-Gehälter: Engineering Manager erzielen in Deutschland das höchste Gehalt

Die Developer-Onlineplattform Stack Overflow hat in ihrer diesjährigen Entwicklerumfrage weltweit über 49.0000 Antworten erhalten. Dabei zeigt sich, dass die meisten Entwicklerinnen und Entwickler zwar künstliche Intelligenz nutzen, ihr Vertrauen in die Technologie aber sinkt. Bei den Gehältern liegen in Deutschland Engineering Manager, Projektmanager und Software- oder Solutions-Architekten ganz oben – mit jeweils über 100.000 US-Dollar pro Jahr.

IT-Gehälter in Deutschland und weltweit

Stack Overflow erhielt in Deutschland auf die Gehaltsfrage Antworten von über 2000 Personen. Angegeben sind diese in Form des jährlichen Brutto-Mediangehalts, umgerechnet in US-Dollar. Am meisten verdienen hierzulande Engineering Manager (118.000 US-Dollar), Projektmanager (110.000 US-Dollar), Architektinnen und Architekten in den Bereichen Software oder Solutions (109.000 US-Dollar), Cloud Infrastructure Engineers (99.000 US-Dollar) und Mobile Developer (94.000 US-Dollar).

Median-Jahresgehälter der Befragten in Deutschland

(Bild: Stack Overflow)

Weltweit zeigt sich ein etwas anderes Bild: Hier liegen Senior Executives (139.000 US-Dollar), Engineering Manager (130.000 US-Dollar) und Financial Analysts bzw. Engineers (104.000 US-Dollar) an der Spitze. Stack Overflow schlüsselt diese Werte weiter nach Erfahrung auf: Auch bei vergleichbarer Erfahrung von durchschnittlich rund zwanzig Jahren verdienen Senior Executives und Manager deutlich mehr als etwa Gründerinnen und Gründer oder Softwarearchitekten, wie die folgende Grafik zeigt:

Weltweite Median-Jahresgehälter der Befragten nach Erfahrung

(Bild: Stack Overflow)

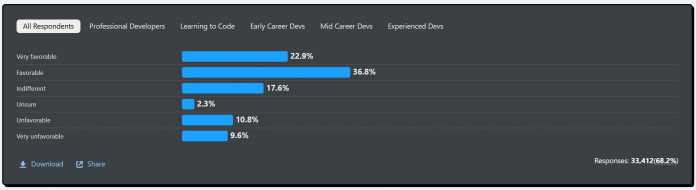

Die KI-Skepsis wächst

Im letzten Jahr gaben 76 Prozent der Befragten an, KI-Tools in ihren Projekten zu nutzen oder dies zu planen, und lediglich sechs Prozent waren bezüglich der KI-Ergebnisse negativ oder sehr negativ eingestellt. In diesem Jahr verzeichnen beide Werte einen Anstieg: 84 Prozent nutzen KI-Tools oder haben dies vor, während die Skepsis weiter wächst. Lediglich 60 Prozent stehen den KI-Tools positiv gegenüber, 20 Prozent dagegen negativ oder sehr negativ. Die weiteren Antworten verteilen sich auf „unsicher“ und „gleichgültig“.

Einstellung der Befragten gegenüber KI-Tools, von sehr positiv (very favorable) bis sehr negativ (very unfavorable)

(Bild: Stack Overflow)

Stack Exchange, der Betreiber von Stack Overflow, hat im Mai 2025 angekündigt, die Q&A-Plattform aufgrund des drohenden Bedeutungsverlusts durch den KI-Trend nach 16 Jahren umzubauen. In welche Richtung sich die Plattform entwickeln soll, hat Stack Exchange nicht bekannt gegeben.

Python legt deutlich zu, Rust bleibt am beliebtesten

Die Befragten setzen als Programmier-, Skripting- und Markup-Sprachen am häufigsten JavaScript, HTML/CSS, SQL, Python und Bash/Shell ein. Bemerkenswert ist dabei der Aufstieg von Python: Nach einem Jahrzehnt des stetigen Zuwachses macht die Sprache verglichen mit 2024 einen Sprung um sieben Prozentpunkte nach oben, von 51 auf 58 Prozent. Das begründet das Stack-Overflow-Team mit der Wichtigkeit von Python für KI, Data Science und die Backend-Entwicklung. Dennoch sinkt Python in der Wertung vom dritten auf den vierten Platz ab.

Bei den bewunderten („admired“) Programmiersprachen lässt sich Rust mit 72 Prozent den Spitzenplatz nicht streitig machen und ist seit 2016 die beliebteste Programmiersprache (teils noch mit der alten Fragestellung „loved“ vs. „dreaded“) – tatsächlich zum Einsatz kommt sie allerdings nur bei 15 Prozent aller Befragten. Auf Rust folgen der Neuzugang Gleam mit 70 Prozent, Elixir mit 66 Prozent und Zig mit 64 Prozent.

Bei den Entwicklungsumgebungen belegen Visual Studio Code und Visual Studio aus dem Hause Microsoft die ersten beiden Plätze. Dabei hat Visual Studio Code einen immensen Vorsprung: Drei Viertel der Befragten nutzen den freien Sourcecode-Editor, verglichen mit 29 Prozent an Visual-Studio-Usern (Mehrfachantworten möglich). Dahinter liegen der quelloffene Editor Notepad++ und JetBrains‘ IntelliJ IDEA mit jeweils 27 Prozent.

Zu den weiteren Funden der Studie zählt, dass Claude Sonnet das „am meisten bewunderte“ KI-Modell ist, dass fast ein Drittel der Developer in diesem Jahr remote arbeiten und dass YouTube als Community-Plattform insbesondere unter Programmier-Neulingen beliebt ist. Ein Viertel der befragten Entwicklerinnen und Entwickler ist im aktuellen Job glücklich – 28 Prozent sind dagegen unglücklich – und die meisten Befragten haben bereits mindestens zehn Jahre Coding-Erfahrung.

Methodologie

Jedes Jahr befragt Stack Overflow die globale Developer-Community im Rahmen des „Developer Survey“ – inzwischen mit der 15. Ausgabe. An der diesjährigen Online-Befragung nahmen 49.009 Personen aus 166 Ländern vom 29. Mai bis 23. Juni 2025 teil, vor allem aus den USA, Deutschland und Indien. Nach der Auswertung von Qualifizierungsfragen wurden rund 15.000 Personen von der Analyse ausgeschlossen. Für die Umrechnung der Gehälter in US-Dollar verwendete Stack Overflow den Wechselkurs vom 25. Juni 2025.

Alle Ergebnisse des „2025 Developer Survey“ lassen sich auf der Stack-Overflow-Website einsehen.

(mai)

Entwicklung & Code

Visual Studio Code 1.104: Agent Mode bittet um Bestätigung

Das August-Update für Visual Studio Code steht bereit. Unter der Versionsnummer 1.104 hat Microsofts freier Sourcecode-Editor einige KI-Neuerungen an Bord, darunter die automatische Modellauswahl im GitHub Copilot Chat, eine neue Sicherheitsebene für den Agent Mode und die automatische Verwendung von AGENTS.md-Dateien. Zu den weiteren Updates zählen unter anderem farblich hervorgehobene Fensterumrandungen unter Windows und eine Vorschau für Git-Worktree-Änderungen.

Automatische LLM-Auswahl im Copilot Chat

Im GitHub Copilot Chat können Entwicklerinnen und Entwickler nun als Preview-Feature dasjenige Large Language Model (LLM) auswählen lassen, das eine optimale Performance und eine Reduzierung der Rate Limits bieten soll – denn manche Modelle weisen eine stärkere Nutzung auf. Diese Funktion soll zunächst die User mit individuellen Copilot-Abos erreichen und im Verlauf der nächsten Wochen an alle Copilot-Nutzerinnen und -Nutzer ausgespielt werden.

Um die automatische Modellauswahl zu aktivieren, ist im Model Picker die Option Auto anzuklicken. Dann fällt VS Code die Entscheidung zwischen Claude Sonnet 4, GPT-5, GPT-5 mini und GPT-4.1 – sofern das Unternehmen der Entwicklerinnen und Entwickler keines dieser Modelle blockiert hat. Der Name des ausgewählten Modells erscheint beim Hovern über der Antwort in der Chatansicht.

Per „Auto“-Option wählt VS Code automatisch ein Large Language Model aus.

(Bild: Microsoft)

Änderungsbestätigung für Agent Mode

Der Agent Mode in GitHub Copilot erhält derweil eine neue Sicherheitsebene: Er erfordert nun eine explizite Bestätigung, bevor er Änderungen an sensiblen Dateien („sensitive files“) vornimmt. Welche das sind, können Entwicklerinnen und Entwickler mit der Einstellung chat.tools.edits.autoApprove festlegen. Einige Dateien, wie solche außerhalb des Workspace, werden standardmäßig als sensible Dateien behandelt.

Als experimentelles Feature verwendet der Agent Mode zudem automatisch eine AGENTS.md-Datei – sofern diese im Workspace-Root vorhanden ist – als Kontext für Chatanfragen. Mit einer AGENTS.md-Datei lassen sich einem Agenten Kontext und Anweisungen vermitteln.

Updates abseits der KI

Windows-Nutzer können dank der neuen Einstellung window.border ihre VS-Code-Fenster nun mit einem farblich hervorgehobenen Rahmen versehen. Die Farben lassen sich je nach Workspace anpassen, sodass auf einen Blick sichtbar ist, welcher Workspace in welchem Fenster geöffnet ist:

Bunte Rahmen für Workspaces – je nach Workspace können Developer andere Farben vergeben.

(Bild: Microsoft)

Eine weitere Neuerung betrifft die Versionskontrolle: Eine Vorschau zeigt nun die Änderungen zwischen Worktree-Dateien und dem aktuellen Workspace. Dazu dient ein Rechtsklick auf eine Worktree-Datei, um das Kontextmenü in der Ansicht Source Control Changes zu öffnen. Dort lässt sich dann Compare with Workspace auswählen.

Das Feature „Compare with Workspaces“ zeigt die Änderungen zwischen Worktree-Dateien und aktuellem Workspace.

(Bild: Microsoft)

Nach Review der Änderungen können Entwicklerinnen und Entwickler dann den Befehl Migrate Worktree Changes… aus der Befehlspalette verwenden, um alle Änderungen aus einem Worktree in den aktuellen Workspace zu mergen. Das soll es vereinfachen, mit mehreren Worktrees zu arbeiten und Änderungen selektiv in das Haupt-Repository zu übernehmen.

Weitere Informationen zu diesen und zahlreichen anderen neuen Features lassen sich der offiziellen Ankündigung entnehmen.

(mai)

Entwicklung & Code

Genkit Go 1.0: Google bringt stabiles KI-Framework ins Go-Ökosystem

Google hat mit Genkit Go 1.0 die erste stabile Version seines Open-Source-Frameworks für KI-Entwicklung im Go-Ökosystem veröffentlicht. Entwicklerinnen und Entwickler können damit ab sofort produktionsreife KI-Anwendungen erstellen und deployen. Gleichzeitig bringt Google mit dem neuen CLI-Befehl genkit init:ai-tools eine direkte Integration für gängige KI-Coding-Assistenten.

Typsichere KI-Flows erstellen

Eine der spannendsten Neuerungen in Genkit Go 1.0 ist die Möglichkeit, typensichere KI-Flows mit Go-Structs und JSON-Schema-Validierung zu erstellen. Dadurch lassen sich Modellantworten offenbar zuverlässig strukturieren und einfacher testen.

Im folgenden Beispiel aus dem Ankündigungsbeitrag generiert ein Flow ein strukturiertes Rezept:

package main

import (

"context"

"encoding/json"

"fmt"

"log"

"github.com/firebase/genkit/go/ai"

"github.com/firebase/genkit/go/genkit"

"github.com/firebase/genkit/go/plugins/googlegenai"

)

// Define your data structures

type RecipeInput struct {

Ingredient string `json:"ingredient" jsonschema:"description=Main ingredient or cuisine type"`

DietaryRestrictions string `json:"dietaryRestrictions,omitempty" jsonschema:"description=Any dietary restrictions"`

}

type Recipe struct {

Title string `json:"title"`

Description string `json:"description"`

PrepTime string `json:"prepTime"`

CookTime string `json:"cookTime"`

Servings int `json:"servings"`

Ingredients []string `json:"ingredients"`

Instructions []string `json:"instructions"`

Tips []string `json:"tips,omitempty"`

}

func main() {

ctx := context.Background()

// Initialize Genkit with plugins

g := genkit.Init(ctx,

genkit.WithPlugins(&googlegenai.GoogleAI{}),

genkit.WithDefaultModel("googleai/gemini-2.5-flash"),

)

// Define a type-safe flow

recipeFlow := genkit.DefineFlow(g, "recipeGeneratorFlow",

func(ctx context.Context, input *RecipeInput) (*Recipe, error) {

dietaryRestrictions := input.DietaryRestrictions

if dietaryRestrictions == "" {

dietaryRestrictions = "none"

}

prompt := fmt.Sprintf(`Create a recipe with the following requirements:

Main ingredient: %s

Dietary restrictions: %s`, input.Ingredient, dietaryRestrictions)

// Generate structured data with type safety

recipe, _, err := genkit.GenerateData[Recipe](ctx, g,

ai.WithPrompt(prompt),

)

if err != nil {

return nil, fmt.Errorf("failed to generate recipe: %w", err)

}

return recipe, nil

})

// Run the flow

recipe, err := recipeFlow.Run(ctx, &RecipeInput{

Ingredient: "avocado",

DietaryRestrictions: "vegetarian",

})

if err != nil {

log.Fatalf("could not generate recipe: %v", err)

}

// Print the structured recipe

recipeJSON, _ := json.MarshalIndent(recipe, "", " ")

fmt.Println("Sample recipe generated:")

fmt.Println(string(recipeJSON))

<-ctx.Done() // Used for local testing only

}

Hier wird ein Flow (recipeGeneratorFlow) definiert, der Rezepte auf Basis einer Hauptzutat und optionaler Ernährungsvorgaben wie „vegetarian“ generiert. Der Prompt wird dynamisch gebaut, ans KI-Modell (Google Gemini) übergeben und die Antwort in eine klar definierte Go-Datenstruktur (Recipe) zurückgeschrieben. Am Ende läuft der Flow mit der Eingabe „avocado, vegetarisch“ und gibt ein komplettes JSON-Rezept mit Zutaten, Kochzeit und Tipps zurück.

Anbindung an gängige Sprachmodelle

Darüber hinaus haben Developer mit Genkit Go 1.0 die Möglichkeit, externe APIs über Tool Calling einzubinden und Modelle von Google AI, Vertex AI, OpenAI, Anthropic und Ollama über eine einheitliche Schnittstelle zu nutzen. Die Bereitstellung soll unkompliziert als HTTP-Endpoint erfolgen. Eine Standalone-CLI sowie eine interaktive Developer UI unterstützen beim Schreiben von Tests, Debugging und Monitoring.

Der neue Befehl genkit init:ai-tools richtet automatisch KI-Assistenztools wie Gemini CLI, Firebase Studio, Claude Code und Cursor ein. Somit können Entwicklerinnen und Entwickler damit direkt die Genkit-Dokumentation durchsuchen, Flows testen, Debug-Traces ausführen und Go-Code nach Best Practices generieren.

(mdo)

Entwicklung & Code

Vorstellung Studie Cupra Tindaya: Betont unruhig

In den Weiten des Volkswagen-Konzerns darf sich kaum eine Marke optisch so weit vorwagen wie Cupra. Tatsächlich seriennah dürfte die Studie Tindaya kaum sein, und doch ist die spektakuläre Formgebung mehr als nur ein Blickfang auf der IAA. Der Name Tindaya, nach einem Vulkan auf der Insel Fuerteventura, ist dabei durchaus Programm.

Terramar, Tavascan, Formentor und auch noch der Ateca, dessen Produktion absehbar ausläuft: An SUVs mangelt es der Marke Cupra derzeit wahrlich nicht. Ist dort perspektivisch Platz für ein weiteres Modell mit rund 4,7 m Länge? Ja, befanden offenbar die Verantwortlichen. Die Studie Tindaya ist 4,72 m lang und ausschließlich auf batterieelektrische Antriebe ausgerichtet. Welche Plattform in einem Serienmodell genutzt werden würde, ist aktuell noch zweitrangig. Viel spricht dafür, dass es die Basis des kommenden VW ID.4 sein könnte.

23-Zoll-Felgen

Das kantig-faltige Design ist bewusst überzeichnet. Allein schon der gesetzliche Fußgängerschutz würde einem Serieneinsatz dieser Front vermutlich entgegenstehen. Riesige Radhäuser, in denen selbst 23-Zoll-Felgen samt Reifen mit geringer Flankenhöhe nicht übertrieben scheinen, haben da vermutlich bessere Chancen. Innen gibt es vier Einzelsitze, ein 24-Zoll-Display, ein Lenkrad im Gaming-Stil und eine Mittelkonsole, die an die 2023er-Studie des Lamborghini Lanzador erinnert. In der Mitte der bis in den Fond durchgehenden Konsole befindet sich ein Zentralknopf, mit dem sich verschiedene Funktionen ansteuern lassen.

250 kW Leistung im Spitzenmodell – mindestens

Ein aufregend gestaltetes Serienmodell würde sich bei den Antriebskomponenten vermutlich im Baukasten des Konzerns bedienen. Hinter- wie Allradantrieb wären damit möglich. Das Leistungsangebot dürfte sich zwischen 210 und 250 kW bewegen, wobei wir damit rechnen, dass sich Volkswagen irgendwann genötigt sehen könnte, in dieser Hinsicht nachzulegen. Ein Ende des Wettrüstens ist schließlich nicht abzusehen – ganz im Gegenteil: Der Umstieg auf Elektromobilität macht mehr Leistung vergleichsweise problemlos möglich, was eher Folgen für die Verkehrssicherheit haben wird als auf den Bedarf an Fahrenergie.

Cupra

)

Unter anderem Volkswagen hat mit dem E-Motor APP550 gezeigt, dass sich selbst 210 kW Spitzenleistung potenziell mitführen lassen, ohne beim Verbrauch dramatisch über dem zu liegen, was ein elektrischer Kleinwagen wie der Opel Corsa-e auch braucht. Auch in dieser Hinsicht unterscheiden sich Verbrenner und batterieelektrischer Antrieb enorm. Das Potenzial eines aufgeladenen V8 wird auch bei gemäßigter Fahrweise immer ein Stück weit zu füttern sein. Beim ungleich effizienteren E-Motor steigt der Verbrauch erst dann, wenn die Leistung abgerufen wird.

Ladeleistung: 200 kW plus X

Zweigeteilt ist die Welt bei Volkswagen hinsichtlich der Ladeleistung. Audi und Porsche haben schon Modelle mit 800 Volt Spannungsebene, was Ladeleistung von deutlich mehr als 200 kW an der gängigen, mit 500 Ampere abgesicherten Ladeinfrastruktur erlaubt. Marken wie Skoda, VW und eben auch Cupra nutzen derzeit ein 400-Volt-System. Damit ist an Ladesäulen mit 500 A bei 200 kW die Spitze erreicht. Mittelfristig werden auch andere Konzernmarken Elektroautos mit 800 Volt ins Sortiment aufnehmen. Ob ein Serienableger der Studie Tindaya dazu gehören könnte, ist ungewiss.

Lesen Sie mehr zur Marke Cupra

(mfz)

-

UX/UI & Webdesignvor 4 Wochen

UX/UI & Webdesignvor 4 WochenDer ultimative Guide für eine unvergessliche Customer Experience

-

Social Mediavor 4 Wochen

Social Mediavor 4 WochenRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

UX/UI & Webdesignvor 2 Wochen

UX/UI & Webdesignvor 2 WochenAdobe Firefly Boards › PAGE online

-

Entwicklung & Codevor 4 Wochen

Entwicklung & Codevor 4 WochenPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 2 Wochen

Entwicklung & Codevor 2 WochenEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

Digital Business & Startupsvor 2 Monaten

Digital Business & Startupsvor 2 Monaten10.000 Euro Tickets? Kann man machen – aber nur mit diesem Trick

-

Digital Business & Startupsvor 3 Monaten

Digital Business & Startupsvor 3 Monaten80 % günstiger dank KI – Startup vereinfacht Klinikstudien: Pitchdeck hier

-

Apps & Mobile Entwicklungvor 3 Monaten

Apps & Mobile Entwicklungvor 3 MonatenPatentstreit: Western Digital muss 1 US-Dollar Schadenersatz zahlen