Datenschutz & Sicherheit

Mexiko: Untersuchung wegen mutmaßlicher Schmiergeldzahlung beim Kauf von Pegasus

Mexikos Generalstaatsanwaltschaft (FGR) hat nach Berichten mehrerer mexikanischer Medien eine Untersuchung gegen Mexikos früheren Präsidenten Enrique Peña Nieto über die angebliche Entgegennahme von Bestechungsgeldern in Millionenhöhe eingeleitet. Dieser soll nach Angaben der israelischen Zeitung The Marker 25 Millionen US-Dollar von zwei israelischen Geschäftsleuten als Schmiergeldzahlung für den Erwerb der Spionagesoftware Pegasus des israelischen Unternehmens NSO Group erhalten haben.

„Wir werden die israelischen Behörden unverzüglich über das System der internationalen Rechtshilfe bitten, diese Informationen, die sie in den Medien veröffentlicht haben, in eine Akte aufzunehmen, damit wir vorankommen können“, erklärte der Leiter der FGR, Alejandro Gertz Manero, am Dienstag. Man werde die israelische Regierung formell um Rechtshilfe bitten, „damit diese Behauptungen innerhalb eines rechtlichen Rahmens aufgestellt werden und nicht in das gleiche Vakuum unbegründeter Anschuldigungen fallen“, so Gertz weiter. Angesichts der schwierigen Zusammenarbeit mit Israels Behörden in anderen Fällen zeigte sich Gertz allerdings nicht sehr optimistisch, was die Überstellung der erforderlichen Unterlagen betrifft.

Die Informationen, die Mexikos früheren Präsidenten mit den Sponsoren der Spionagesoftware in Verbindung bringen, wurden in der vergangenen Woche von der israelischen Zeitung The Marker veröffentlicht und von mexikanischen Medien breit aufgegriffen. Die Veröffentlichung ist Teil eines Rechtsstreits zwischen zwei israelischen Geschäftsleuten, die behaupten, eine gemeinsame „Investition“ in Höhe von 25 Millionen US-Dollar getätigt zu haben, um zwischen 2012 und 2018 Verträge mit der mexikanischen Regierung unter Peña Nieto zu erhalten. Unklar ist, ob der gesamte Betrag an den Ex-Präsidenten selbst geflossen sein soll oder ob andere Personen beteiligt waren.

Ex-Präsident bestreitet die Vorwürfe

Peña Nieto, der seit seinem Ausscheiden aus dem Amt zwischen Spanien und der Dominikanischen Republik lebt, hat die gegen ihn erhobenen Vorwürfe entschieden zurückgewiesen. Über seinen offiziellen X-Account, den er seit Monaten nicht mehr benutzt hatte, bezeichnete er den Marker-Artikel als „völlig falsch“ und versicherte, dass die Anschuldigungen unbegründet seien. „Ich bedaure, auf Artikel zu stoßen, die ohne ein Mindestmaß an journalistischer Sorgfalt leichtfertige und bösartige Behauptungen aufstellen“, schrieb er. Es handele sich um eine Unterstellung, „die jeglicher Grundlage entbehrt“. Er ließ die Frage offen, wer von einer solchen Veröffentlichung profitieren würde. Später erklärte Peña Nieto in einem Radiointerview, dass er nie an der Vergabe von Aufträgen an Lieferanten beteiligt war. Auch kenne er keinen der beiden betreffenden Geschäftsleute.

Die Regierung Peña Nieto (2012-2018) hatte das Spionagesystem Pegasus mutmaßlich für 32 Millionen US-Dollar offiziell für nachrichtendienstliche Zwecke und zur Bekämpfung des organisierten Verbrechens eingekauft. Aktivistengruppen und Journalisten deckten später auf, dass Regierungseinrichtungen die Malware zum Ausspähen von Journalisten, Menschenrechtsaktivisten und Korruptionsbekämpfern nutzten. Die US-Tageszeitung New York Times fand heraus, dass Mexikos damaliger Staatssekretär für Menschenrechte, Alejandro Encinas, mit Pegasus ausgespäht wurde, als er Verfehlungen des mexikanischen Militärs untersuchte.

Auch in der Amtszeit des linken Präsidenten López Obrador (2018–2024) sollen trotz gegenteiliger Behauptungen Aktivisten und Journalisten mit Pegasus ausgespäht worden sein. Anfang des Jahres 2023 verlangte die mexikanische Datenschutzbehörde INAI vom Verteidigungsministerium die Offenlegung der Verträge um die Spionagesoftware Pegasus.

(akn)

Datenschutz & Sicherheit

Google Chrome: Kritische Sicherheitslücke in Webbrowser

Im Webbrowser Google Chrome haben die Entwickler eine Sicherheitslücke geschlossen, die als kritisches Risiko eingestuft wurde. Wer den Browser einsetzt, sollte sicherstellen, die jüngste Version zu nutzen.

In der Versionsankündigung bleibt Google bekannt schmallippig zu den Details der Schwachstelle. Es handelt sich um einen „Use after free“-Fehler, bei dem der Programmcode auf Ressourcen zugreift, die bereits freigegeben wurden und somit undefinierte Inhalte aufweisen. Dieser Fehler findet sich im WebGL-Render-Backend Angle (CVE-2025-9478 / EUVD-2025-25822, noch kein CVSS, Risiko laut Google jedoch „kritisch„). Der CVE-Eintrag verrät immerhin, dass Angreifer aus dem Netz einen Speicherfehler auf dem Heap etwa mit sorgsam präparierten HTML-Webseiten missbrauchen können – oftmals gelingt darüber das Einschleusen und Ausführen von Schadcode, was aufgrund des Schweregrads auch hier anzunehmen ist.

In den Versionen Google Chrome 139.0.7258.158 für Android, 139.0.7258.154 für Linux sowie 139.0.7258.154/.155 für macOS und Windows haben die Entwickler die Schwachstelle ausgebessert. Das Update steht nun zum Download bereit.

Versionsprüfungen

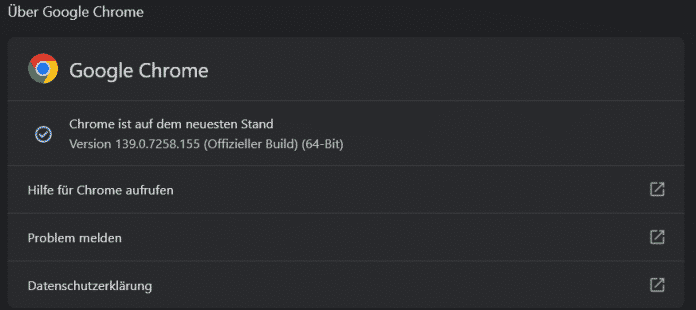

Ob die aktuelle Fassung des Webbrowsers läuft, verrät der Versionsdialog. Der öffnet sich nach Klick auf das Symbol mit drei aufgestapelten Punkten rechts von der Adressleiste. Dort geht es weiter über „Hilfe“ – „Über Google Chrome“.

Der Versionsdialog von Google Chrome zeigt den aktuell laufenden Softwarestand an. Gegebenenfalls startet er die Aktualisierung.

(Bild: heise medien)

Bei Verfügbarkeit von aktualisierter Software startet das auch den Update-Prozess. Unter Linux ist dafür die distributionseigene Softwareverwaltung zuständig. Unter Android steht die Aktualisierung im Google Play Store bereit – jedoch nicht sofort für alle Smartphones. Die Lücke betrifft das Chromium-Projekt und dürfte somit darauf fußende Software wie den Microsoft-Edge-Browser ebenfalls anfällig machen. Dafür dürfte in Kürze ebenfalls ein Update bereitstehen, das Nutzerinnen und Nutzer zeitnah installieren sollten.

Zuletzt musste Google Mitte Juli eine bereits attackierte Schwachstelle im Chrome-Webbrowser abdichten.

(dmk)

Datenschutz & Sicherheit

Elektronische Fußfesseln sollen Täter*innen auf Abstand halten

Künftig sollen Familiengerichte bundesweit elektronische Fußfesseln anordnen können, um gewaltsame Täter*innen auf Abstand zu halten. Auf das Vorhaben hatte sich die schwarz-rote Regierung bereits im Koalitionsvertrag geeinigt. Nun hat das Justizministerium einen Gesetzentwurf vorgelegt.

Die Fußfessel soll dabei helfen, Annäherungsverbote durchzusetzen, etwa bei häuslicher Gewalt. Die Geräte haben einen GPS-Sender und werden am Bein befestigt, beispielsweise bei einem gewaltsamen Ex-Partner. Sobald er sich etwa einer bedrohten Ex-Partnerin nähert, soll ein Alarm ausgelöst werden.

Eine solche Maßnahme gibt es bereits in einzelnen Bundesländern sowie in Spanien. Deshalb ist oft die Rede vom „spanischen Modell“. Die Ampel-Regierung hatte Ende 2024 eine bundesweite Regelung auf den Weg gebracht, aber nicht beschlossen. Fachleute lehnen die elektronische Fußfessel zwar nicht ab, verweisen aber auf den weitaus größeren Handlungsbedarf beim Gewaltschutz.

Elektronische Fußfesseln: So soll das ablaufen

Die Grundlage für elektronische Fußfesseln ist das Gewaltschutzgesetz. Es soll Menschen schützen, die bereits Gewalt erfahren haben, etwa Partner*innen oder Kinder. Demnach können Familiengerichte Täter*innen verbieten, sich einer Person erneut zu nähern. Die Fußfessel soll das nach Plänen des Justizministeriums kontrollieren und weitere Übergriffe durch einen Alarm verhindern.

Nicht nur Täter*innen sollen einen Peilsender bekommen. Auch zu schützende Personen können – auf eigenen Wunsch – ein Empfangsgerät tragen. Dann erhalten sie selbst eine Warnung, sobald der angeordnete Mindestabstand unterschritten wird.

Kommt es zu einem Alarm, landet er bei einer zentralen Anlaufstelle, etwa der HZD (Hessische Zentrale für Datenverarbeitung) oder der GÜL (Gemeinsame elektronische Überwachungsstelle der Länder). Dort müssen die Angestellten je nach Kontext eine Entscheidung treffen: Ist es ein technischer Fehlalarm? Sollten Täter*in oder Opfer kontaktiert werden? Muss die Polizei direkt vor Ort einschreiten?

Das Justizministerium rechnet damit, dass die Fußfesseln vor allem bei Partnerschaftsgewalt zum Einsatz kommen; also bei Menschen, die aktuell in einer Beziehung sind oder sich getrennt haben. Möglich sein sollen Fußfesseln allerdings auch im Eltern-Kind-Verhältnis, bei Stalking oder Konflikten unter Nachbar*innen.

Die Anordnung für elektronische Fußfesseln soll zunächst für sechs Monate gelten und sich danach beim Familiengericht um jeweils drei Monate verlängern lassen. Eine Strafandrohung soll verhindern, dass Täter*innen die Fußfessel ablehnen, entfernen oder zerstören. Das geplante Strafmaß ist eine Freiheitsstrafe bis zu drei Jahren oder eine Geldstrafe.

Kritik am begrenzten Nutzen

Die zentrale Kritik an elektronischen Fußfesseln ist ihr begrenzter Nutzen. So rechnet das Justizministerium selbst aufgrund bisheriger Erfahrungen damit, dass die elektronische Fußfessel bei jährlich 160 Fällen zum Einsatz kommt.

Allerdings gab es im Jahr 2023 rund 256.000 dokumentierte Fälle häuslicher Gewalt in Deutschland. Das entspricht in etwa einem neuen Fall alle zwei Minuten. Besonders betroffen sind Frauen. Sie machen mehr als zwei Drittel der Betroffenen aus. 155 Frauen sind 2023 durch ihren Partner oder Ex-Partner getötet worden.

Auf Anfrage von netzpolitik.org zeigt sich der Verein Frauenhauskoordinierung skeptisch zu den Plänen für Fußfesseln. Der Verein unterstützt die bundesweit 280 Frauenhäuser und mehr als 285 Fachberatungsstellen. „Bevor neue Maßnahmen eingeführt werden, sollten die bereits geltenden Rechtsinstrumente voll ausgeschöpft werden“, schreibt eine Sprecherin. So würden Richter*innen und Polizist*innen die Frauen nicht immer ernst nehmen; bei Verfahren würden gründliche Prüfungen fehlen.

Nur ein Bruchteil der Bewohnerinnen von Frauenhäusern (10 Prozent) würde überhaupt Anträge nach dem Gewaltschutzgesetz stellen. „Es bräuchte nicht nur mehr Personal, sondern vor allem intensiv und besser geschultes Personal – bei Polizei, Gerichten und Jugendämtern“, schreibt die Sprecherin.

Der oft zitierte Vergleich mit dem spanischen Modell greife zu kurz. „Dort werden gewaltbetroffene Frauen ganz anders begleitet – mit kontinuierlichen Kontrollanrufen, Polizeibesuchen und engmaschiger Überwachung der Gefährdungslage“, erklärt die Sprecherin. Diese Infrastruktur fehle in Deutschland vollständig.

Wir sind ein spendenfinanziertes Medium

Unterstütze auch Du unsere Arbeit mit einer Spende.

Ähnliche Kritik übte der Deutsche Juristinnenbund (djb) zu einem ähnlichen Gesetzentwurf der Union aus dem Jahr 2024. Der Einsatz der Fußfessel sei nur „eine situationsbezogene, kurzfristige Form der Prävention“, heißt es in einer 15-seitigen Stellungnahme. Weder würde die Maßnahme die Ursachen der Gewalt adressieren, noch langfristigen Schutz gewähren. Nur selten könnten von Gewalt betroffene Frauen und Kinder eine Wohnung alleine nutzen. Das heißt: Vielen fehlt die Möglichkeit, einfach so auf Abstand zum Täter zu gehen. Das Fazit der Jurist*innen: Der flächendeckende Ausbau von Beratungsstellen und Schutzunterkünften sei „unabdingbar“.

Wie viel Geld ist dem Staat der Gewaltschutz wert?

Dass elektronische Fußfesseln allein nicht genügen, ist dem Justizministerium offenbar bewusst. Der Gesetzentwurf sieht weitere Maßnahmen zum Gewaltschutz vor. So sollen Familiengerichte auch Täter*innen zu Anti-Gewalt-Trainings verpflichten können. Spätestens fünf Jahre nach Inkrafttreten soll das neue Gesetz zudem überprüft werden. Weitere Maßnahmen seien geplant, teilt das Ministerium mit, etwa im Sorge- und Mietrecht.

Zum Nutzen der Maßnahmen äußert sich das Justizministerium teils irreführend. In der Pressemitteilung zum Gesetzentwurf heißt es etwa: „Die Justiz soll häusliche Gewalt besser verhindern können“ und „Jeder Fall von häuslicher Gewalt ist einer zu viel.“ Aber die vorgeschlagenen Maßnahmen – Fußfesseln und Anti-Gewalt-Trainings – greifen erst, nachdem es bereits zu Gewalt gekommen ist. Nur wenn Betroffene die Ressourcen haben, Hilfe beim Familiengericht zu suchen, können die Neuerungen weitere Gewalt verhindern.

Der Knackpunkt beim Gewaltschutz sind die Kosten. Wie viel Geld ist es dem Staat wert, Menschen, insbesondere Frauen, vor Gewalt zu schützen? Immer wieder beklagen Fachleute: Es gebe nicht genug Hilfe für alle, die Hilfe benötigen; die Finanzierung sei unsicher. Schätzungen zufolge fließen ins Hilfesystem aus Schutzeinrichtungen und Beratungsstellen jährlich rund 270 Millionen Euro. Nötig seien allerdings 1,6 Milliarden Euro, wie der Verein Frauenhauskoordinierung festhält. Zum Vergleich: Für die neuen, elektronischen Fußfesseln rechnet das Justizministerium mit jährlich laufenden Kosten von rund 11 Millionen Euro.

Eine weitere konkrete Hochrechnung liefert der Verein Frauenhauskoordinierung in seiner bundesweiten Statistik für das Jahr 2023. Demnach gebe es in Deutschland rund 7.700 Plätze in Frauenhäusern; benötigt würden aber rund 21.000. Das heißt, der Bedarf ist nur zu rund einem Drittel gedeckt.

Im Februar hatten sich Bundestag und Bundesrat auf ein Gewalthilfegesetz geeinigt. Darin steht ein Rechtsanspruch auf Schutz und Beratung bei geschlechtsspezifischer und häuslicher Gewalt für Frauen und ihre Kinder. Für die Umsetzung wurde den Ländern viel Zeit eingeräumt: Der Anspruch soll erst 2032 in Kraft treten.

Datenschutz & Sicherheit

„Passwort“ Folge 39: Vielfältiges Versagen in Redmond und andere News

Die sommerliche Urlaubszeit ist vorbei und die Hosts des Passwort-Podcasts machen sich gut erholt an die nächsten Folgen. Vom berüchtigten Sommerloch bemerken sie wenig: Gleich drei Folgen könnten sie mit den gesammelten Inhalten auf einen Schlag füllen.

Zunächst widmen Sylvester und Christopher sich einer Studie, die kürzlich auf der Security-Konferenz Black Hat vorgestellt wurde. Die großangelegte Untersuchung an einem kalifornischen Universitätsklinikum mit fast 20.000 Mitarbeitenden ergab, dass jährliche Awareness-Schulungen und Phishing-Tests per E-Mail praktisch wirkungslos sind. Christopher hatte eine Vorabversion der Studie bereits im vergangenen November unter die Lupe genommen und berichtet von den ernüchternden Ergebnissen.

Die weltgrößte CA Let’s Encrypt kann es gar nicht erwarten, ihr Verfahren zur Zertifikatsdokumentation umzustellen. Sie möchte ihre „Certificate Transparency Logs“ so schnell wie möglich vollständig vom alten Verfahren nach RFC 6962 auf die neuen „Static Logs“ umbauen und überschlägt sich in ihrer Ankündigung förmlich. Der Zeitplan war zunächst so knapp gewählt, dass offenbar auch die Browserhersteller nicht hinterherkamen.

Und dann war da noch Microsoft. Der Softwarehersteller aus Redmond hatte in den Sommermonaten mit einer haarsträubenden Lücke in seiner Kollaborationsplattform Sharepoint zu kämpfen – und Nutzer wie Redakteure mit dem eigenwilligen Verhalten rund um die Fehlerbehebung. Da ließen sich Patches mit einem simplen „/“ aushebeln, notwendige Konfigurationsänderungen wurden nicht automatisch ausgeführt und zu allem Überfluss ist Microsofts Kommunikationsstrategie auch maximal verwirrend. Das war sie auch bei einem aktuellen KI-Fehler, der zu unvollständigen Compliance-Protokollen führte. Aus Sicht des meldenden Sicherheitsforschers und auch nach Meinung der Hosts Christopher und Sylvester gab es auch in diesem Fall an der Reaktion des Konzerns einiges auszusetzen.

Die neueste Folge von „Passwort – der heise security Podcast“ steht seit Mittwochmorgen auf allen Podcast-Plattformen zum Anhören bereit.

(cku)

-

Datenschutz & Sicherheitvor 2 Monaten

Datenschutz & Sicherheitvor 2 MonatenGeschichten aus dem DSC-Beirat: Einreisebeschränkungen und Zugriffsschranken

-

UX/UI & Webdesignvor 1 Woche

UX/UI & Webdesignvor 1 WocheDer ultimative Guide für eine unvergessliche Customer Experience

-

Apps & Mobile Entwicklungvor 3 Monaten

Apps & Mobile Entwicklungvor 3 MonatenMetal Gear Solid Δ: Snake Eater: Ein Multiplayer-Modus für Fans von Versteckenspielen

-

Online Marketing & SEOvor 3 Monaten

Online Marketing & SEOvor 3 MonatenTikTok trackt CO₂ von Ads – und Mitarbeitende intern mit Ratings

-

Digital Business & Startupsvor 2 Monaten

Digital Business & Startupsvor 2 Monaten10.000 Euro Tickets? Kann man machen – aber nur mit diesem Trick

-

Entwicklung & Codevor 1 Woche

Entwicklung & Codevor 1 WochePosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

UX/UI & Webdesignvor 3 Monaten

UX/UI & Webdesignvor 3 MonatenPhilip Bürli › PAGE online

-

Social Mediavor 1 Woche

Social Mediavor 1 WocheRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist