Künstliche Intelligenz

Microsoft zieht Bilanz: Windows-Treiberentwicklung mit Rust

Microsoft integriert Rust schrittweise in den Windows-Kernel und stellt auch die Windows-Treiber-Entwicklung schrittweise um. Microsoft zieht eine Zwischenbilanz.

Aufgrund der Komplexität der Windows-Kernel-API wird es zwar noch einige Zeit in Anspruch nehmen, bis der gesamte Rust-Designprozess abgeschlossen ist, so Microsoft in einem Blogpost des Surface-Entwicklerteams, der den aktuellen Stand der Windows-Treiberprogrammierung mit Rust zusammenfasst. Dranbleiben will die Firma aber auf jeden Fall, denn für Microsoft stellen speichersichere Sprachen wie Rust die Zukunft der sicheren Softwareentwicklung dar. Auch deshalb, weil die Sicherheitslandschaft Zuverlässigkeit und Sicherheitsgarantien auf jeder Ebene erfordere.

Gegenwärtig können Rust-Programmiererinnen und -Programmierer, die das von Microsoft bereitgestellte GitHub-Repository des Rust-Projekts (windows-drivers-rs) importieren, dieselben Bibliotheken und Header im Windows Driver Kit (WDK) nutzen wie C-Entwickler. Außerdem haben sie damit Zugriff auf alle Device Driver Interfaces (DDI), die es zum Erstellen eines Windows-Treibers im User- und Kernel-Mode braucht. Mit dem Tool cargo-wdk soll beides nun komfortabler funktionieren.

Visual Studio als Vorbild: cargo-wdk für Rust

In Microsoft Visual Studio stehen verschiedene Vorlagen bereit, um Windows-Treiber in C zu schreiben. Um die Entwicklung mit Rust ähnlich einfach zu machen, hat Microsoft jetzt die Cargo-Erweiterung cargo-wdk vorgestellt. Mit ihr lassen sich leere Treiberprojekte anlegen, die bereits alle erforderlichen Verknüpfungen, Build-Schritte und Abhängigkeiten mitbringen. Zudem kann cargo-wdk – ähnlich wie bei der Erstellung eines Treibers in C in Visual Studio – WDK-Tools wie InfVerif aufrufen.

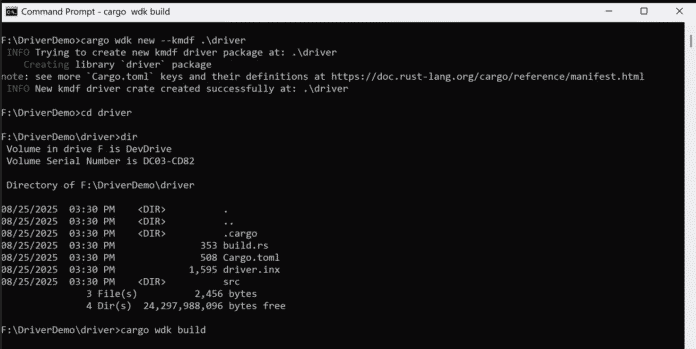

Die Cargo-Erweiterung cargo-wdk im Einsatz.

(Bild: Microsoft)

Wie cargo-wdk funktioniert, demonstriert Microsoft an einem Beispiel. Darin erstellen Entwicker mit cargo wdk new –kmdf eine KMDF-Treibervorlage. Mit Eingabe von cargo wdk build lässt cargo-wdk dann das InfVerif-Tool über die INF-Datei des Treibers laufen und zeigt dabei ähnlich wie in Visual Studio alle gefundenen Fehler an. Im Beispiel wird die INF-Datei schließlich korrigiert, cargo-wdk erneut ausgeführt und so sichergestellt, dass der Treiber mit den entsprechenden Zertifikaten versehen ist.

Mittelfristig will das Team cargo-wdk um Features wie automatische WDK-Installationen, die Unterstützung für NT_TARGET_VERSION, zusätzliche Treibervorlagen und eine volle ARM64-Unterstützung ergänzen. Langfristig plant Microsoft, Programmiererinnen und Programmierern in einer Cargo-Umgebung Zugriff auf dieselben Build-Tools und Konfigurationsoptionen zu bieten wie in Visual Studio.

Neben cargo-wdk enthält das Repo noch folgende Crates:

- wdk-build: Eine Bibliothek zum Konfigurieren eines Cargo-Build-Skripts, das Downstream-Linking des WDK durchführt und Rust-Bindings generiert.

- wdk-sys: Direkte FFI-Bindings zu APIs im WDK verfügbar sind.

- wdk: Sichere idiomatische Bindings zu APIs, die im WDK verfügbar sind.

- wdk-panic: Standardimplementierung von Panic-Handlern für mit dem WDK erstellte Programme

- wdk-alloc: Ein globaler Allocator für die Treiber.

- wdk-macros: Eine Sammlung von Makros, die die Interaktion mit den direkten Bindings von wdk-sys erleichtern.

Von unsicherem Rust zu sicherem Rust

Derzeit umfasst windows-drivers-rs zwar alle Bausteine, um Rust-Treiber für Windows zu programmieren, allerdings sind immer noch erhebliche Mengen an unsafe Rust-Code nötig. Auch unsicheres Rust bietet laut Blog Vorteile, wie starke eine Typprüfung, Zero Cost Abstractions und eine gute Kompatibilität durch das Foreign Function Interface (FFI). Auf lange Sicht soll es Entwicklern aber möglich sein, den Großteil eines Windows-Treibers sicher zu schreiben.

Dazu will Microsoft das Typsystem und den Borrow-Checker von Rust nutzen, um bestimmte Arten von Fehlern zu verhindern, die sich bisher nur durch zusätzliche statische Analysen erkennen lassen. Zudem soll der Umfang des Repositorys kontinuierlich weiter ausgebaut werden. Außerdem soll es sichere Abstraktionen für Kernel-Mode-Strukturen und DDIs geben, um die Anzahl der benötigten unsicheren Codeblöcke zu reduzieren und die Sicherheit schon während der Kompilierzeit zu erhöhen.

Neben dem Surface-Team sind auch andere Abteilungen bei Microsoft damit beschäftigt, sichere Strukturen und APIs zu entwickeln. Diese gehen über das Windows Driver Framework (WDF) hinaus und lassen sich sowohl in der Kernel-Entwicklung von Windows als auch von Drittanbietern in der Treiberentwicklung einsetzen. Einige dieser Arbeiten sind bereits heute im Windows-Kernel enthalten.

(who)

Künstliche Intelligenz

Apple Vision Pro M5 im Test: Doppelt hält besser

Es ist still geworden um die Vision Pro, die Apple vor über zwei Jahren noch mit so viel Tamtam vorgestellt hatte. Jetzt sorgt die erste Hardware-Revision für ein Lebenszeichen: Der nagelneue M5-Chip ersetzt den angestaubten M2 und katapultiert das kostspielige VR-Headset auf den aktuellen Stand bei Prozessor- und Grafikleistung, wie ihn auch MacBook Pro und iPad Pro bieten.

Am Design oder überflüssig scheinenden Elementen wie dem Außendisplay mit den gruseligen digitalen Augen hat Apple allerdings nichts geändert. Auch bei dem für die Sensorik verantwortlichen R1-Chip, den beiden hochaufgelösten Mikro-OLEDs, dem Kamerasystem, dem Arbeitsspeicher in Höhe von 16 GByte und dem Funkchip gibt es keinerlei Neuerungen zu verzeichnen. So bleibt die Vision Pro auf WLAN-6-Stand stecken und kann das aktuell meist komplett unbeeinträchtigte 6-GHz-Band von WLAN 6E und WLAN 7 nicht nutzen.

Da ist nur ehrlich, dass das Gerät nicht als „Vision Pro 2“ sondern schlicht als „Vision Pro (M5)“ firmiert. Den Europreis hat Apple in einer Wechselkursanpassung an den schwachen Dollar unter die 4000-Euro-Marke gedrückt, los geht es jetzt ab 3700 Euro.

Das war die Leseprobe unseres heise-Plus-Artikels „Apple Vision Pro M5 im Test: Doppelt hält besser“.

Mit einem heise-Plus-Abo können Sie den ganzen Artikel lesen.

Künstliche Intelligenz

Bericht: Apple fährt iPhone-Air-Produktion massiv herunter

Apple soll die Produktionsaufträge für das iPhone Air drastisch zusammengestrichen haben und die Fertigung ab November auf rund 10 Prozent des September-Volumens herunterfahren. Das berichtet Nikkei Asia unter Berufung auf mehrere mit der Angelegenheit vertraute Personen aus der Zuliefererkette. Gleichzeitig erhöht das US-Unternehmen die Bestellungen für das iPhone 17 und iPhone 17 Pro deutlich – die Gesamtprognose von 85 bis 90 Millionen Einheiten für die iPhone-17-Serie bleibe damit stabil. Zuvor hatte es schon ähnliche Berichte aus Südkorea gegeben.

Weiterlesen nach der Anzeige

Die Anpassung der Produktionspläne spiegelt die völlig unterschiedliche Marktreaktion auf die einzelnen Modelle wider. Während das iPhone Air außerhalb Chinas auf wenig Interesse stoßen soll, übertrifft die Nachfrage nach den Standard- und Pro-Varianten offenbar die Erwartungen. Apple habe die Produktionsaufträge für das Basismodell iPhone 17 um etwa 5 Millionen Einheiten erhöht und auch die Bestellungen für das iPhone 17 Pro aufgestockt, so die Quellen.

iPhone Air enttäuscht

Ursprünglich sollte das iPhone Air etwa 10 bis 15 Prozent der gesamten iPhone-Neuproduktion 2025 ausmachen. Nun haben laut dem Bericht mehrere Zulieferer von Apple die Anweisung erhalten, Komponenten- und Elektronikmodule für dieses Modell weitgehend zu reduzieren. Ein Manager aus der Zulieferkette beschreibt die aktuellen Produktionsaufträge als nahezu auf „End-of-Production“-Niveau, das normalerweise erst am Ende eines iPhone-Jahres erreicht wird – und das, obwohl das iPhone Air erst vergangene Woche in China in den Verkauf gegangen ist. Dort soll es auf hohe Nachfrage stoßen.

Die unterschiedliche Beliebtheit der Modelle zeigte sich bereits beim Bestellvorgang: Auf Apples offizieller US-Website beträgt die durchschnittliche Wartezeit für ein iPhone 17 mit 256 Gigabyte Speicher und kostenlosem Versand derzeit zwei bis drei Wochen, für das iPhone 17 Pro ein bis zwei Wochen. Für das iPhone Air gibt es dagegen keine Wartezeit. Ähnlich die Situation im deutschen Apple Online Store: iPhone 17 und 17 Pro haben dort Liefertermine zwischen Anfang und Mitte November, das iPhone Air ist sofort lieferbar.

China-Start verspätet wegen eSIM-Regulierung

In China kam das iPhone Air erst mit erheblicher Verzögerung auf den Markt. Grund waren Pekings Vorschriften zur eSIM-Technologie. Während Apple die iPhone-17-Serie am 9. September vorstellte und am 19. September mit dem Verkauf in den meisten Märkten begann, mussten chinesische Kunden auf das Air-Modell bis vergangene Woche warten. Die ersten Verkaufstage in China verliefen laut Nikkei allerdings durchaus positiv.

Weiterlesen nach der Anzeige

Insgesamt hat sich die iPhone-17-Serie in China und den USA – Apples zwei größten Märkten – in den ersten zehn Verkaufstagen um 14 Prozent besser verkauft als die iPhone-16-Reihe im Vorjahr. Haupttreiber dieses Wachstums ist das Basismodell iPhone 17. Die Verkaufszahlen für das Juli-bis-September-Quartal lagen über dem Vorjahreswert, obwohl der Smartphone-Markt insgesamt stagniert.

Wegbereiter für faltbares iPhone 2026

Strategisch sollte das iPhone Air den Weg für Apples erstes faltbares iPhone ebnen, das für 2026 erwartet wird. Drei mit der Angelegenheit vertraute Personen bestätigten diese Rolle des ultradünnen Modells. Apple setze große Hoffnungen in den Launch eines Foldables im kommenden Jahr.

Die Zulieferer zeigen sich insgesamt erleichtert, dass Apple seine Gesamtprognose einhalten kann. Andere Hersteller hätten für 2025 Rückgänge verzeichnet, was unter anderem auf die Zoll-Auseinandersetzungen und die globale Konjunkturentwicklung zurückgeführt wird.

(mki)

Künstliche Intelligenz

Google präsentiert neuen Quantenalgorithmus „Quantum Echoes“

Weiterlesen nach der Anzeige

Ein Forschungsteam von Google Quantum AI hat einen neuen Quantenalgorithmus entwickelt, der einen verifizierbaren Quantenvorteil gegenüber herkömmlicher Hardware ermöglichen soll. Der Algorithmus trägt den Spitznamen Quantum Echoes und soll auf Googles Quantenchip Willow 13.000-mal schneller laufen als der beste bekannte klassische Algorithmus auf den schnellsten Supercomputern.

Die Ergebnisse präsentiert die Gruppe in einer Publikation im Fachmagazin Nature. Ein zur gleichen Zeit erschienenes Manuskript auf dem Preprint-Server arXiv soll die erfolgreiche Anwendung von Quantum Echoes im Bereich der NMR demonstrieren.

Rezepte für Quantencomputer

Quantencomputer versprechen bei bestimmten Aufgaben einen enormen Rechenvorteil im Vergleich zu herkömmlichen oder auch Supercomputern. Damit die Quantenrechner aber einen Vorteil liefern, benötigen sie spezielle Quantenalgorithmen, die Quanteneffekte geschickt ausnutzen, um ein Problem effizient zu lösen. Verbreitet ist der Shor-Algorithmus, der das mathematische Problem löst, auf dem ein Großteil der heute etablierten Verschlüsselungsverfahren basiert. Damit könnte es Quantencomputern also eines Tages gelingen, in kürzester Zeit komplexe Verschlüsselung zu knacken.

Vergangenes Jahr präsentierte Google seinen neuesten Quantenchip „Willow“. Mit seinen aktuellen Ergebnissen demonstriert die Forschungsgruppe, dass sie nicht nur Quanten-Hardware, sondern auch Software weiterentwickelt.

(Bild: Google Quantum AI)

Das sogenannte Random Circuit Sampling (RCS) ist ein weiterer Quantenalgorithmus, den Unternehmen wie Google häufig nutzen, um die Leistungsfähigkeit ihrer Quantenchips zu demonstrieren. RCS wurde allerdings speziell dafür konstruiert, die Leistungsfähigkeit von Quantencomputern zu testen. Somit ist RCS als reiner Benchmark zu verstehen, da der Algorithmus kein Problem löst, das für reale Anwendungen nützlich wäre.

Nicht so Googles neuer Quantenalgorithmus Quantum Echoes. Dieser testet nicht einfach nur die Komplexität, sondern auch die Präzision einer Quantenrechnung. Das Team verkündet, dieser Algorithmus könne bei der Lösung von realen Problemen helfen, die etwa in der Medikamenten- oder Fusionsforschung eine Rolle spielen.

Weiterlesen nach der Anzeige

Quantum Echoes soll außerdem einen verifizierbaren Quantenvorteil liefern. Das bedeutet, dass andere Forschungsgruppen den Algorithmus auf ihren eigenen Quantenrechnern ausführen, das Ergebnis des Willow-Prozessors reproduzieren und so bestätigen können. Eigenen Angaben zufolge hat Google ein unabhängiges Team beauftragt, Schwachstellen in ihrem Algorithmus zu finden, um so die Performance zu bestätigen.

So funktioniert Quantum Echoes

Der technische Name von Quantum Echoes lautet eigentlich „Out-of-order Time Correlator (OTOC) Algorithm“. Vereinfacht gesagt ist Quantum Echoes ein Algorithmus, um die Zeit zurückzudrehen und so die Eigenschaften von Quantencomputern besser zu verstehen, Störungen nachzuverfolgen oder umzukehren.

Dafür führen die Wissenschaftler zuerst eine Reihe von Operationen auf dem Quantenchip aus. Dann stören sie eines der Qubits und diese Störung breitet sich im Quantencomputer aus. Anschließend kehren sie die Operationen um, sie führen also die Operationen aus dem ersten Schritt rückwärts in umgekehrter Reihenfolge durch – wie bei einem Echo, daher der Name des Algorithmus. Zuletzt lesen sie die Informationen aus.

Das Ergebnis verrät den Forschern, wie sich Quanteninformation und klassisches Rauschen im Quantencomputer ausbreiten. Üblicherweise sind diese beiden Effekte schwierig auseinanderzuhalten, weil alle Elemente des Quantencomputers miteinander verknüpft sind und sich verschiedene Effekte überlagern. Ihr Algorithmus verrät den Forschern, wie sich Quanteninformation in komplexen Systemen mit vielen Teilchen ausbreitet.

So können die Forscher Einblicke in mikroskopische Eigenschaften des Quantensystems gewinnen, die ein klassischer Computer nicht berechnen kann. Darin sieht das Team einen möglichen Baustein für künftige Beweise eines echten Quantenvorteils. Der Algorithmus selbst zeigt in der Nature-Publikation jedoch keinen Quantenvorteil und löst kein reales Problem.

Erste Anwendungen in der NMR

Eine tatsächliche Anwendung schlägt das Team in einem begleitenden Manuskript auf arXiv vor. Die Arbeit basiert auf einer Kollaboration mit Forschungsgruppen aus den USA, dem Vereinigten Königreich, Kanada und Australien. Die Anwendung stammt aus dem Bereich der Kernspinresonanz (NMR, für Nuclear Magnetic Resonance). NMR ist die Grundlage für die Magnetresonanztomografie (MRT), sowie viele weitere Präzisionsmessmethoden in der Chemie, Medizin oder Geophysik.

Im betrachteten Beispiel könne Quantum Echoes als „molekulares Lineal“ dienen, um Abstände sehr präzise zu messen und Informationen über chemische Strukturen zu gewinnen. Das Team untersuchte in ihrer Arbeit zwei Moleküle mit 15 beziehungsweise 28 Atomen. Die Berechnungen mit Googles Willow stimmten mit den Vorhersagen der klassischen NMR überein. Quantum Echo liefere jedoch zusätzliche Informationen, die NMR allein nicht liefern könne.

Bessere NMR ist für viele Bereiche relevant, wie die Pharmaforschung oder Materialentwicklung, um die molekulare Struktur in Medikamenten oder Baustoffen besser und schneller zu verstehen. Die Ergebnisse des arXiv-Manuskripts wurden noch nicht von unabhängigen Experten geprüft.

„Diese neue Arbeit präsentiert den Quantencomputer als Tool, um molekulare Strukturen aufzudecken, nicht nur in der NMR, sondern in der Zukunft vielleicht auch in der Quantensensorik“, sagt Michel Devoret während einer Vorab-Präsentation der Ergebnisse. Das Team nutzt den Begriff „Quantum-Scope“, um die Weiterentwicklung von Teleskopen und Mikroskopen anzudeuten.

Devoret gewann kürzlich den Physik-Nobelpreis für die physikalischen Grundlagenexperimente, die heute die Basis für supraleitende Qubits bilden. Dies sind die Bausteine, aus denen Unternehmen wie Google oder auch IBM und das europäische IQM Quantencomputer konstruieren. Devoret ist leitender Wissenschaftler für Quantenhardware bei Google Quantum AI.

Ein echter Quantenvorteil?

Bereits 2019 verkündete ein Forscherteam von Google, mit ihrem damaligen Quantenchip Sycamore einen Quantenvorteil demonstriert zu haben. Der Chip soll ein Problem in wenigen Minuten gelöst haben, für das ein herkömmlicher Supercomputer 10.000 Jahre gebraucht hätte. Kurz darauf wurde dieser Erfolg relativiert, als Forscher einen Weg fanden, die gleiche Rechnung mit einem effizienteren Algorithmus in wenigen Minuten auf einem herkömmlichen Computer zu lösen.

„Dieses Rennen zwischen klassischem und Quantencomputing ist ganz normal. All diese Geschwindigkeits-Vorhersagen sind Momentaufnahmen. Wir haben schon damals erwartet, dass Entwickler klassische Algorithmen beschleunigen“, sagt Hartmut Neven. „Wir erwarten, dass das auch in diesem Fall passieren wird. Aber auch die Quantentechnologie entwickelt sich weiter und die Leistungsfähigkeit von Quantencomputern wird weiter steigen.“

Ausblick

Google zeigt sich optimistisch, innerhalb von fünf Jahren relevante Probleme mithilfe Quantencomputern lösen zu können, die kein klassischer Computer lösen könne. Mit der Entwicklung größerer, fehlerkorrigierter Quantenrechner erwartet das Unternehmen auch, dass mehr reale Anwendungen für Quantencomputer entdeckt werden. Aktuell fokussiere sich das Team darauf, seinen dritten Meilenstein zu erreichen: ein langlebiges, logisches Qubit.

(spa)

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenAdobe Firefly Boards › PAGE online

-

Social Mediavor 2 Monaten

Social Mediavor 2 MonatenRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

UX/UI & Webdesignvor 1 Monat

UX/UI & Webdesignvor 1 MonatFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online

-

UX/UI & Webdesignvor 5 Tagen

UX/UI & Webdesignvor 5 TagenIllustrierte Reise nach New York City › PAGE online

-

Social Mediavor 4 Wochen

Social Mediavor 4 WochenSchluss mit FOMO im Social Media Marketing – Welche Trends und Features sind für Social Media Manager*innen wirklich relevant?