Künstliche Intelligenz

Missing Link: 20 Jahre WSIS – und (k)ein bisschen Multi-Stakeholder?

Vor 20 Jahren einigten sich die Mitgliedstaaten der Vereinten Nationen (UN) auf Grundsatzdokumente zum Aufbau der Informationsgesellschaft. Zu den Kernpunkten gehörte die Einsicht, dass Regierungen für die Vernetzung und Digitalisierung die Zusammenarbeit mit Wirtschaft, Zivilgesellschaft, Wissenschaft und technischer Community benötigen. Jetzt soll überprüft werden, wie weit man gekommen ist. Geopolitische Spannungen, autokratische Tendenzen und ein Wettbewerb innerhalb der UN-Institutionen trüben jedoch die Hoffnung auf echten Fortschritt.

Während der zwei Phasen des ersten UN-Weltgipfels für die Informationsgesellschaft (World Summit on the Information Society, WSIS) in den Jahren 2003 und 2005 verabredeten sich die Mitgliedsstaaten auf Grundzüge für eine Informationsgesellschaft. Diese sollte den Nutzer in den Mittelpunkt stellen. Zugang zum Internet, Teilhabe, Meinungsfreiheit und Menschenrechte generell fanden Eingang in die Tunis-Erklärung und die Tunis-Agenda für die Informationsgesellschaft.

Als neue Werkzeuge für Entwicklung und Demokratisierung wurden dabei Internet und Informationstechnologie verstanden. Die Hoffnungen auf deren positive Effekte waren riesig. Doch von den in der Erklärung formulierten hehren Zielen ist man noch weit entfernt.

Bilanzkonferenz: schweres Gepäck

Am 16. und 17. Dezember wird nun bei den Vereinten Nationen in New York Bilanz gezogen und darüber verhandelt, wie es mit den Nachfolgeprozessen des WISIS weitergehen soll. Die Prozesse ziehen sich als Netz von elf Aktionslinien quer durch die UN.

Soll das Internet Governance Forum (IGF), das vom 23. bis zum 27. Juni in Oslo/Lillestrøm tagte, ein erneutes Mandat erhalten? Sollen die WSIS-Aktionslinien, die Informationstechnologie an die UN-Entwicklungsziele koppeln, unverändert fortgeführt werden? Ist die wenig übersichtliche Aufgabenverteilung innerhalb der verschiedenen UN-Teilorganisationen angemessen? Und wie kann das IGF, das aufgrund seiner Debatten zwischen staatlichen und nichtstaatlichen Teilnehmern als das innovativste Produkt des Weltgipfels gilt, gestärkt und wie können die vielen UN-Prozesse zur Digitalpolitik koordiniert werden?

Was fehlt: In der rapiden Technikwelt häufig die Zeit, die vielen News und Hintergründe neu zu sortieren. Am Wochenende wollen wir sie uns nehmen, die Seitenwege abseits des Aktuellen verfolgen, andere Blickwinkel probieren und Zwischentöne hörbar machen.

UN-Kauderwelsch und digitalpolitische Unübersichtlichkeit stellen die Befürworter einer breiteren Teilhabe von Zivilgesellschaft und anderen Nicht-Regierungsvertretern vor ein gewaltiges Problem, erklärte Joyce Chen, Policy Expertin der IP-Adressvergabestelle APNIC in Oslo: „Die Masse an Gepäck, die die Internet-Community seit dem Start der Diskussionen vor 20 Jahren aufgesammelt hat, ist ein Einstiegshindernis“. Es brauche Stunden, um die Hintergründe zu erklären. Für Neulinge ziemlich abschreckend, sagte Chen in einer Runde mit Vertretern nationaler und regionaler Internet-Governance-Foren.

Zum Hintergrund gehört auch, dass der Begriff „Internet Governance“ ursprünglich vor allem den Streit über die Verwaltung von Domains und IP-Adressen umfasste. Beim WSIS liefen viele Länder des Globalen Südens Sturm, weil die Domainverwalterin ICANN unter Vertrag und Aufsicht der US-Regierung stand. Die erste Phase des Gipfels schlitterte, obwohl die geopolitischen Vorzeichen besser waren als heute. Mit der Aufsichtsrolle durch die US-Regierung im Jahr 2016 – eher befördert durch Snowdens Enthüllungen als durch den WSIS-Prozess – darf dieser Streitpunkt heute immerhin als erledigt gelten.

Mehr regionale IGF-Ableger für mehr Öffentlichkeit

Selbstverwalter, Regierungen und auch die Internationale Fernmeldeunion (ITU), die zeitweilig selbst an der Verwaltung der Internet-Ressourcen interessiert war, haben sich inzwischen verständigt. Die „technische Community“ beziehungsweise die Selbstverwaltungsorganisationen gehören heute zu den größten Sponsoren des Globalen IGF sowie mancher regionaler und nationaler Ableger (NRIs). Diese Verständigung darf man als Erfolg werten.

Als APNIC-Politikexpertin ist Chen auch Mitglied des Lenkungsausschusses des Asia Pacific Regional Internet Governance Forum (APrIGF), eines von rund 180 NRIs. „Storytelling“ sei eine der wichtigsten Aufgaben für die IGF-Ableger, sagte sie in Oslo. Sie bieten die Chance für ein globales „Bottom-up“-Konstrukt.

Die Entstehung der nationalen und regionalen IGFs gilt vielen als weiterer positiver Effekt des WSIS-Prozesses. Von der EuroDIG bis zum WestAfrica IGF, von „Oldtimern“ wie dem Bangladesh IGF bis zum deutschen IGF-D und zu „Newcomern“ wie dem gerade gegründeten irischen IGF wurden digitalpolitische Öffentlichkeiten geschaffen, die als „Stakeholder“ bei ihren Regierungen anklopfen. Im Vorfeld wollten die Internet Society (ISOC) und die Internet Corporation for Assigned Names and Numbers (ICANN) eine Geschichte ganz praktischer Erfolge liefern.

Digitale Kluft etwas kleiner, Netzkommunikation etwas sicherer

„Wir haben immer wieder gehört, dass wir nicht auf gute altbewährte Argumente zurückgreifen können. Vielmehr müssen wir Nachweise vorlegen, dass das Multi-Stakeholder-Modell funktioniert und auch Ergebnisse bringt“, sagte Sally Wentworth, Vorsitzende der ISOC, anlässlich der Veröffentlichung des Berichts „Spuren aus 20 Jahren WSIS Prozess“. Darin listen ISOC und ICANN auf, was aus ihrer Sicht in 20 Jahren erreicht wurde. Und so kurz ist die Liste gar nicht.

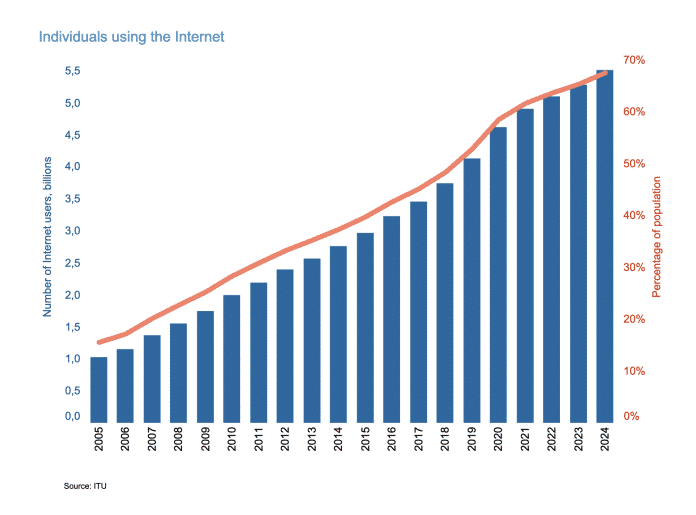

Einerseits wurde der Zugang zu den Netzen verbessert. Laut den Zahlen der International Telecommunication Union (ITU) hatten bis Ende 2024 rund 68 Prozent der Weltbevölkerung Zugang zum Internet. Beim Abschluss des WSIS im Jahr 2005 waren es nur rund 16 Prozent. Der größte Zuwachs ist in Afrika zu verzeichnen, wo mittlerweile statt zwei immerhin 37 Prozent Internetzugang haben. Ein Drittel der Weltbevölkerung hat jedoch noch keinen Zugang.

Für eine kostengünstige Internetkonnektivität hat die von der ISOC unterstützte „IGF Dynamic Coalition on Community Connectivity (D3C)“ gesorgt. Wie im „Spuren“-Bericht zu lesen ist, hat die D3C den Aufbau von Community-Netzen von El Cuy in Patagonien bis nach Tushetien in Georgien, von Ulukhaktok in der kanadischen Arktis bis ins Gebiet des Mount Everest maßgeblich unterstützt.

Insgesamt investierte die globale Mitgliederorganisation laut ISOC 3,1 Millionen US-Dollar in 85 lokale Netze, die in Zusammenarbeit mit Partnern wie der Association for Progressive Communication (APC) realisiert wurden.

Überdies hätten neue, über den Globus gespannte Partnerschaften zwischen 2011 und 2021 die Gründung von insgesamt 27 Internet Exchanges allein in Afrika ermöglicht. Die Effekte für die Nutzer sind spürbar: „Der Knotenpunkt in Kenia, der KIXP, verringerte die Zugriffszeit von 200 bis 600 Millisekunden auf zwei bis zehn Millisekunden und brachte Einsparungen von rund 1,5 Millionen US-Dollar pro Jahr für lokale Internet-Service-Provider.“

Die Weltweite Entwicklung der Anzahl von Internetnutzern und Anteil an der Weltbevölkerung in Prozent laut Statistiken des ITU.

(Bild: International Telecommunication Union)

Initiativen für Cybersicherheit

Das IGF Best Practice Forum on Cybersecurity, die Dynamic Coalition on Cybersecurity und andere IGF-Gruppen haben daran gearbeitet, die Aufmerksamkeit für die in den technischen Gremien entwickelten Sicherheitsnachbesserungen zu erhöhen. Laut dem ICANN/ISOC-Bericht lag die Zahl der mittels DNSSEC abgesicherten Top-Level-Domain-Zonen im April 2025 bei 93 Prozent, nationale TLDs eingeschlossen.

ISOC und ICANN erwähnen ebenfalls auf der Habenseite die Fortentwicklung von nicht-lateinischen Domains. Knapp sechs Millionen kyrillische, chinesische und mit deutschen Umlauten versehene Domains wurden vergeben. Linguistische Diversität gehörte zu den zentralen Forderungen bezüglich leichterer Zugänglichkeit zum Netz. Manche alteingesessene Internet-Netzwerker sahen darin jedoch auch einen Trend zur Fragmentierung. Die Forderung nach Multilingualität setzt sich heute im Bereich der großen, ausschließlich auf Englisch trainierten Large Language Models fort.

Fehlanzeigen: Lerneffekte, Demokratisierungsfortschritte

Viele Erwartungen blieben unerfüllt – sowohl ans Internet, das einst als „demokratischstes Medium aller Zeiten“ galt, als auch an die ausgefeilten Nachfolgeprozesse des WSIS. Auf die Frage, was „Multi-Stakeholder-Governance“ konkret bedeutet und wie sie in Deutschland umgesetzt wird, verweist das neue Bundesministerium für Digitales und Staatsmodernisierung (BMDS) auf die Offenheit und Globalität des Internets als Grundlage für sozioökonomische Entwicklung. Man setze sich für ein inklusives, menschenrechtsbasiertes Multi-Stakeholder-Modell ein und lehne staatliche Kontrolle oder Fragmentierung ab. Doch wie viel davon ist tatsächlich gelebte Praxis?

Zwar setzt man sich laut der schriftlich und mit etwas Verzögerung erteilten Antwort aus Berlin entschieden für die „Umsetzung der Leitlinien der NETmundial+10 ein, um eine inklusive Beteiligung, eine ausgewogene Vertretung und eine wirksame Zusammenarbeit der Interessenträger anzustoßen“ .

Die von Brasilien im ersten Ärger über die Snowden-Enthüllungen auf die Beine gestellte NETmundial – hier war Deutschland Mitorganisator – und die eine Dekade später nachgezogenen NETmundial+10 2024 haben die echte Beteiligung aller Stakeholder-Gruppen in eigene Erklärungen gefasst.

Echte Stakeholder-Beteiligung: Ein uneingelöstes Versprechen

Die UN haben ihr Versprechen bislang kaum eingelöst. Im Rahmen des von UN-Generalsekretär António Guterres angestoßenen Global Digital Compact (GDC) wurde scharfe Kritik an der mangelnden Beteiligung von Zivilgesellschaft und Community laut. Keine steile Lernkurve.

Der Sprecher des BMDS betont, man setze sich in den politischen Prozessen der Vereinten Nationen dafür ein, „dass Multi-Stakeholder-Governance als zentraler Grundsatz für die digitale Governance berücksichtigt wird“. Das Ministerium verweist zudem auf die Modelle von ICANN und der Internet Engineering Task Force (IETF) sowie auf das Internet Governance Forum Deutschland (IGF-D), das als wichtige Austauschplattform vom BMDS unterstützt wird. Über das IGF-D werden laufend Informationen zu globalen Prozessen mit allen Stakeholdern geteilt und deren Beiträge genutzt. „Besonders hervorheben wollen wir das Jugend IGF-D, welches sich aktiv in unterschiedliche Prozesse einbringt, Stellungnahmen schreibt und Bildungsarbeit bei jungen Menschen leistet, um neuen Generationen Stimme und Gehör in der Internet Gouvernance zu verschaffen.“

Widersprüchliche Positionen in puncto Überwachung

Die Idee der breiteren Teilhabe scheint sich nicht auf zentrale Normenprozesse im Parlament zu erstrecken. Wenn es um Multi-Stakeholder-Debatten zur erneut eingeführten Vorratsdatenspeicherung, zur Aufweichung der Verschlüsselung oder zur mehrfach vor dem Bundesverfassungsgericht gerügten Geheimdienstaufsicht geht, scheint Multi-Stakeholder kein Thema zu sein. Mit ProtectEU, Neuauflagen von Chatkontrolle und Ähnlichem fährt das konservativer und rechter gewordene Europa auch keinen grundrechtszentrierten Kurs.

Wie widersprüchlich europäische Positionen sind, darauf warf eine Veranstaltung beim IGF in Oslo ein Schlaglicht. Britische und US-Regierung setzen sich für eine Stärkung des IGF und WSIS-Prozesse ein. Im Panel zur Aufweichung von starker Verschlüsselung unter Beteiligung des FBI und britischer Regierungsberater, bleibt man lieber unter sich. Die Multi-Stakeholder im Publikum kritisieren die Runde, in der vom Einsatz von Datenschutz als Waffe die Rede ist, als vollkommen einseitig und rückwärtsgewandt.

Diskussion über Reformbedürfnis

„Gefährlich können der Internet-Selbstverwaltung in allererster Linie nationale Regierungen werden, primär die mit großen Märkten“, warnte im Anschluss an das IGF in Oslo der US-Wissenschaftler Milton Mueller. Mueller hatte die Diskussion darüber, ob die WSIS-Nachfolgeprozesse bei der UN noch notwendig sind, mit einer Diskussionsrunde „Sollte WSIS sterben?“ aufgemischt.

Für den Gründer des Internet Governance Project am Georgia Institute of Technolgy sind die Datenschutzgrundverordnung der EU, Exportbeschränkungen der US-Regierung oder die Auflagen der chinesischen Regierung zur Datenlokalisierung eine Bedrohung für ein globales, libertäres Netz. „ICANN sollte sich weniger darüber Gedanken machen, ob WSIS verlängert wird, als über die nächsten Schritte der Regierung des Landes, in dem sie ihr Hauptquartier haben.“ Das Hauptquartier befindet sich in den USA.

Muellers Kritik an der UN, obwohl US-typisch UN-skeptisch, stößt dabei nicht nur auf Ablehnung. Viele Beobachter – aus Regierungs- und Nicht-Regierungskreisen– fordern nämlich eine klarere Aufgabenverteilung in der UN. Denn anstelle einer Stärkung und Weiterentwicklung der bestehenden Prozesse hat Guterres in den vergangenen Jahren eher dazugebaut.

Neben dem neuen Office for Digital and Emerging Technologies (ODET) mit dem UN Tech Envoy, sozusagen dem Tech-Gesandten der Vereinten Nationen an der Spitze, will er die UN beim Thema KI und Data Governance ins Spiel bringen. Ein neues KI-Panel mit 20 Experten und ein KI-Beratungsgremium mit 40 von der UN-Vollversammlung zu wählenden Mitgliedern sollen sich um das Thema kümmern. Erstmals tagte im Mai auch zudem eine neue Arbeitsgruppe der Commission on Science and Technology for Development (CSTD) zum Thema „Data Governance on all Levels“.

Dabei wünschen sich vor allem Vertreter der Zivilgesellschaft und des Globalen Südens bereits jetzt eine Konsolidierung der Parallelveranstaltungen, etwa des IGF und des von der ITU organisierten WSIS-Forums. Letzteres ist stärker regierungsorientiert, startet kommende Woche in Genf und hat ein ähnliches Programm wie das IGF.

UN-interne Konkurrenz ist einer effektiven Fortentwicklung globaler Digitalpolitik kaum zuträglich. „Ohne Reform macht die Erneuerung des Mandats keinen Sinn“, schrieb Müller als Fazit nach Oslo und gab damit auch die Meinung einer anderen „alten“ Mitwirkenden des WSIS-Prozesses, der US-Wissenschaftlerin Avri Doria, wieder. Doria hatte in Oslo gesagt, wenn man WSIS sterben lassen wolle, sollte man es einfach nicht reformieren und weiterentwickeln. Dann würde es einen mehr oder weniger leisen Tod sterben.

Vorschläge für die nächste Dekade

Kein neues IGF und kein WSIS-Mandat insgesamt? Daran glaubt von den rund 9.000 Teilnehmern des IGF in Oslo niemand wirklich. Erfahrene UN-Diplomaten sind sich einig, dass es eigentlich nicht üblich ist, dass die UN einmal geschaffene Gremien wieder schließt.

Vorschläge für Reformen gibt es immerhin reichlich. Die Stärkung des IGF, ein möglichst auf Dauer erteiltes Mandat, eine solidere Finanzierung – und nicht nur freiwillige Spenden wie bislang – steht offenbar auf den Sprechzetteln aller Regierungen.

Auch Deutschland bekennt sich zum IGF

Auch das BMDS will nicht zurückstehen: „Die Bundesregierung setzt sich klar für eine Verlängerung des IGF-Mandats sowie für die Fortführung des WSIS-Prozesses als erstes globales Rahmenwerk für die digitale Kooperation ein,“ fasst der Sprecher zusammen. Zur Verlängerung und Stärkung gehöre „auch eine stabile und nachhaltige finanzielle Grundlage für das IGF zu schaffen.“

Die Rolle des UN-Hochkommissars für Menschenrechte in digitalen Fragen soll gestärkt werden. Außerdem müsse sichergestellt sein, „dass in jedem Schritt des Überprüfungsprozesses eine transparente und inklusive Einbindung von Stakeholdern sichergestellt ist“. Aus Berlin heißt es zudem, es sei wichtig, „eine sinnvolle Verbindung zwischen dem Prozess des Global Digital Compact und dem WSIS+20-Überprüfungsprozess zu schaffen“.

Zu den Forderungen gehören mehr Koordination und mehr Sichtbarkeit für Überlegungen und praktische Ergebnisse aus den WSIS-Prozessen und aus dem IGF. Die Mitgliedsstaaten, die ab Oktober in New York unter dem Vorsitz von Annalena Baerbock verhandeln, müssen sich noch darüber einigen, wie einschneidend die Reformen für das IGF und das WSIS sein sollten.

In einem ersten Vergleich der Positionen hält die Organisation Global Digital Partners fest, dass einige Mitgliedsstaaten, etwa Australien oder die Schweiz, stärkere Veränderungen fordern. Global Digital Partners liefert dem geneigten, aber nicht vollzeitengagierten „Netizen“ eine ganze Reihe von Tools, um den Überblick über die laufenden Debatten zu behalten. Ein Beispiel ist der Internet Governance Konferenzkalender. Der ist für 2025 prall gefüllt.

Zudem gehört Global Digital Partners wie auch die NRIs zu denen, die hörbar anklopfen bei Regierungen und UN und mehr echte Beteiligung verlangen. Auch bei den NRIs steht „Mehr Multistakeholder“ ganz oben auf der Liste gewünschter Verbesserungen.

Internet Governance oder Digitalpolitik?

Von den zahlreichen Vorschlägen für die nächsten Jahre der WSIS-Prozesse wird seit dem Abschluss des IGF in Oslo einer besonders heftig diskutiert: Ist es noch zeitgemäß, von „Internet Governance“ zu sprechen? Die Schweizer Delegation hat etwa angeregt, das IGF in „Digital Policy Forum“ oder „Digital Cooperation Forum“ umzubenennen. Dadurch könnte, so das Schweizer Bundesamt für Kommunikation, besser zum Ausdruck gebracht werden, dass es nicht nur um „Internet Governance“ im engeren Sinne, sondern um alle Aspekte der Digitalpolitik geht.

Tatsächlich werden beim IGF, nicht nur bei den jährlichen Konferenzen, sondern auch bei den permanent laufenden Policy Networks und dynamischen Koalitionen neue digitalpolitische Fragen oft schon lange aufgegriffen, bevor sie in Parlamenten und Regierungsetagen ankommen: von Blockchain über Plattformverantwortlichkeit bis zu KI. Beim EuroDIG 2025 wurden wirklich zuletzt Debatten zur Altersverifikation geführt, in denen auch datenschutzfreundliche Tokenlösungen zur Sprache kamen. Mit der Umfirmierung könnte das IGF aber vielleicht anecken, warnten viele in der auf einer der vielen Mailinglisten laufenden Debatte.

Der Versuch, ein solches umfassenderes Label fürs IGF zu finden, könnte angesichts der aktuellen geopolitischen Situation zum Desaster werden, warnte einer der Beobachter.

Der deutsche Internet-Governance-Experte und emeritierte Völkerrechtler Wolfgang Kleinwächter nennt die alten WSIS-Unterhändler – zu denen er selbst gehörte – weitsichtig. Er schlägt in klassisch-diplomatischer UN-Manier vor, dem IGF einfach einen Untertitel zu verleihen. IGF – Globales Forum für die Gestaltung von Digitalpolitik. Ob das der IGF mehr Durchschlagskraft verleiht?

(nen)

Künstliche Intelligenz

„Nicht der ideale Weg“: „Hyper Light Breaker“ stirbt im Early Access

Entwicklungsaus im Early Access: Das kann nicht nur unbekannte Spiele-Start-ups treffen, wie der aktuelle Fall von „Hyper Light Breaker“ zeigt. Das Spiel des 2013 gegründeten und bis dato erfolgreichen Indie-Studios Heart Machine wird nicht zur ursprünglichen Vision fertig entwickelt, gestand das Studio dem Branchenmagazin Game Informer.

Stattdessen muss Heart Machine Angestellte entlassen und die Arbeit an „Hyper Light Breaker“ noch während der Early-Access-Phase einstellen. „Das war nicht der Weg, den wir uns gewünscht hätten, aber der einzige, der unter den gegebenen Umständen möglich war“, sagte Heart Machine gegenüber Game Informer.

Letztes Update im Januar

Im Januar soll zumindest noch ein Update erscheinen: „Wir planen, etwas Bedeutungsvolles zu liefern, so ausgefeilt und vollständig, wie es unter unseren aktuellen Umständen möglich ist.“ Ziel sei es, die Entwicklung von „Hyper Light Breaker“ zu einem „zufriedenstellenden Schlusspunkt“ zu bringen. Es ist gut möglich, dass „Hyper Light Breaker“ mit diesem Update dann offiziell aus dem Early Access gehievt wird – die Aussagen der Entwickler lassen aber wenig Zweifel daran, dass ursprünglich mehr geplant war.

Zumindest die Timeline passt: „Hyper Light Breaker“ war im Januar 2024 in den Early Access bei Steam gestartet und sollte etwa ein Jahr bis zum fertigen Release brauchen. Beim Early-Access-Konzept können Spieler einen Steam-Titel schon während der aktiven Entwicklung kaufen, um die Arbeit des Teams finanziell zu unterstützen und mit Feedback auf den Prozess Einfluss zu nehmen.

Doch das Konzept birgt stets das Risiko, dass ein Titel nie wirklich fertig wird und man sein Geld für eine Dauer-Beta ausgibt. In solchen Fällen gibt es das Geld nicht zurück. Im Großen und Ganzen ist das Early-Access-Konzept erfolgreich: Zu den bekanntesten Titeln, die per Early Access entwickelt wurden, gehören „Baldur’s Gate 3“, „Satisfactory“ und jüngst „Hades 2“.

Heart Machine macht weiter

Heart Machine galt bislang als weitgehend sichere Bank in der Indie-Szene. „Hyper Light Drifter“ gehört zu den besseren Indie-Spielen des vergangenen Jahrzehnts, auch „Solar Ash“ wurde gut aufgenommen und galt als Erfolg. Doch bei „Hyper Light Breaker“ wollte der Funke nicht so richtig überspringen – schon bevor das Entwicklungsaus angekündigt wurde, hatte das Spiel durchwachsene Nutzerbewertungen.

Die Entscheidung für den Entwicklungsstopp sei auf „Kräfte außerhalb unserer Kontrolle“ zurückzuführen, sagte Heart Machine dem Game Informer. Dazu gehörten Veränderungen bei der Finanzierung, Konsolidierung von Spielefirmen und die allgemein unsichere Marktsituation der Spielebranche.

Wie viele Angestellte entlassen werden, ist unklar. Mit einem kleineren Team will Heart Machine weiterhin Videospiele entwickeln – nach dem unrühmlichen Ende von „Hyper Light Breaker“ wird das Team aber mit Misstrauen aus der Gaming-Community rechnen müssen.

(dahe)

Künstliche Intelligenz

Der „Minecraft“-Film bekommt eine Fortsetzung

Die Rückkehr der pinken Lederjacke? Warner hat einen Nachfolger des im Frühjahr erschienenen „Minecraft“-Kinofilms angekündigt. Der Film soll am 23. Juli 2027 in die Kinos kommen, erklärt Warner – auf einem Teaserbild sind lediglich zwei Spitzhacken auf einer Werkbank zu sehen.

„Ein Minecraft Film“ kam im April 2025 in die Kinos. Nachdem der erste Trailer bei „Minecraft“-Fans eher auf Entgeisterung gestoßen war, entwickelte sich der fertige Film zum Hit: Am Box Office spülte er fast eine Milliarde US-Dollar in die Kassen. Ein Nachfolger war angesichts dessen alternativlos. Dass ein zweiter Teil kommen sollte, war in Hollywood daher erwartet worden, berichtet das Branchenmagazin Variety.

Allzu viele Veränderungen sind im Vergleich zum ersten Teil wohl nicht zu erwarten: Jares Hess kehrt als Regisseur zurück, Jason Momoa wird Producer – ob er auch wieder eine Schauspielrolle übernehmen wird, ist noch offen. Mit weiteren Informationen hält sich Warner Bros. aktuell noch bedeckt.

Auch zweiter „Mario“-Film in Arbeit

Videospielfans können sich neben dem zweiten Teil von „Ein Minecraft Film“ auch auf die Fortsetzung eines weiteren Gaming-Kassenschlagers freuen: Vor wenigen Wochen hat Nintendo angekündigt, dass auch der „Mario“-Film einen zweiten Teil bekommen soll. Der „The Super Mario Galaxy Movie“ soll im April 2026 in die Kinos kommen, teilte Nintendo mit. „The Super Mario Galaxy Movie“ folgt auf den „Super Mario Bros.“-Film, den Nintendo 2023 in die Kinos gebracht hat. Das Animationsstudio Illumination produziert erneut Teil 2. Auch die Schauspieler aus dem ersten Teil sollen zurückkommen – dazu gehören in der englischsprachigen Fassung Chris Pratt als Mario und Anya Taylor-Joy als Prinzessin Peach.

Der „Mario“-Film von Nintendo war sogar noch etwas erfolgreicher als der „Minecraft“-Streifen: Er hat über eine Milliarde US-Dollar in die Kassen gespült.

(dahe)

Künstliche Intelligenz

iPhone 18: Bank glaubt an gut laufenden Upgrade-Zyklus

Die US-Bank Morgan Stanley hat ihr Kursziel für die Apple-Aktie, die am Donnerstag bei knapp 254 US-Dollar (ein Minus von 1,56 Prozent gegenüber dem Vortag) stand, auf fast 300 Dollar erhöht – und zwar nicht aufgrund des Verkaufserfolgs beim iPhone 17, sondern wegen eines „positiven Ausblicks“ auf die Nachfolgebaureihe, die erst im Herbst 2026 erwartet wird. Die jüngste Kurszielfestlegung der Analysten liegt nun bei 298 Dollar, wie es in einer Notiz an Investoren hieß. Dabei hatte Morgan Stanley im März 2025 ihr Kursziel noch auf 252 Dollar reduziert, da die Investmentbank damals schlechtere Verkäufe beim iPhone 17 vorhersagte.

Mehr Upgrader im kommenden Jahr?

Die jüngste Oktober-Prognose sieht das nun aber anders. Morgan Stanley ist nun in Sachen iPhone 17 positiver gestimmt und glaubt an ein Apple-Umsatzplus von vier Prozent für das Fiskaljahr 2026 auf dann 230,3 Milliarden Dollar. Der Durchschnittswert der Wall Street liegt hier bei nur 220 Milliarden. Neben möglichen Preiserhöhungen über die Produktlinie hinweg – das erste iPhone-Foldable soll mindestens 2000 Dollar kosten – rechnen die Banker auch mit mehr Verkäufen insgesamt.

Die Nachfrage nach dem iPhone 17 verspricht demnach einen besser als erhofften iPhone-18-Zyklus. Im kommenden Jahr sei zudem mit mehr Nutzern zu rechnen, die alte iPhones austauschen wollten, so Morgan Stanley. Die Bank geht von insgesamt sechs neuen iPhones im Apple-Fiskaljahr 2026 aus. Neben iPhone 18 (Standardmodell) seien iPhone 18 Pro, 18 Pro Max, ein zweites Air, ein Foldable und (wohl später) ein iPhone 18e als Einsteigermodell geplant.

Das „Bull-Szenario“

Im gesamten Fiskaljahr 2026 sei mit 243 Millionen verkauften iPhones zu rechnen. Sollte es Apple jedoch gelingen, bis zu 270 Millionen Einheiten zu verkaufen – das sogenannte „Bull-Szenario“ des Bankhauses, sei das Kursziel 376 statt 298 Dollar.

Beim iPhone 17 gibt es Analysten zufolge derzeit einen differenzierten Verkaufsmix. Demnach läuft insbesondere das Standardmodell gut – gefolgt von den Pro-Varianten. Beim Air sieht es angeblich schlechter aus. Das besonders dünne iPhone ist recht teuer und hat mit einigen Kompromissen – nur eine Kamera, kleinerer Akku – zu kämpfen, was offenbar die „Verkaufe“ erschwert. Tatsächlich sind die Geräte auch aktuell direkt in Apples deutschen Ladengeschäften abholbar, während man auf ein iPhone 17 mehrere Wochen warten muss.

(bsc)

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 1 Monat

UX/UI & Webdesignvor 1 MonatAdobe Firefly Boards › PAGE online

-

Social Mediavor 2 Monaten

Social Mediavor 2 MonatenRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 1 Monat

Entwicklung & Codevor 1 MonatEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

UX/UI & Webdesignvor 4 Wochen

UX/UI & Webdesignvor 4 WochenFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online

-

Apps & Mobile Entwicklungvor 3 Monaten

Apps & Mobile Entwicklungvor 3 MonatenFirefox-Update 141.0: KI-gestützte Tab‑Gruppen und Einheitenumrechner kommen

-

Online Marketing & SEOvor 2 Monaten

Online Marketing & SEOvor 2 MonatenSo baut Googles NotebookLM aus deinen Notizen KI‑Diashows