Apps & Mobile Entwicklung

Multiplayer-Benchmarks von Battlefield 6 – ComputerBase

Wie gut läuft der Multiplayer von Battlefield 6? ComputerBase hat 21 Grafikkarten von Nvidia, AMD und Intel im Test. Im Vergleich zur Kampagne (Benchmarks) zeigt der Multiplayer auch auf größeren Karten eine höhere Performance, zugleich verschieben sich die Verhältnisse zwischen den Grafikkarten etwas.

Multiplayer-Benchmarks von Battlefield 6 mit 21 Grafikkarten

Battlefield 6 (Kampagnen-Benchmarks) ist da und der Start ist nach einem enttäuschenden Vorgänger endlich wieder gelungen. Die Pressekritiken sind gut, der erste Eindruck der Spieler ist gut und die Spielerzahlen sind hoch. Auch die PC-Version hat im Test auf ComputerBase einen ordentlichen Eindruck hinterlassen, Probleme zum Launch gab es, wurden aber behoben. Auch die Grafik hat ihre Probleme, kann aber spektakulär sein, die Performance ist hoch, das Frame Pacing passt und größere technische Probleme haben sich nicht gezeigt.

Jetzt folgen Multiplayer-Benchmarks

Für das Launch-Review hat die Redaktion die Einzelspieler-Kampagne für die Benchmarks genutzt, denn der Mehrspieler-Modus war zu diesem Zeitpunkt nicht reproduzierbar zu testen und darüber hinaus zu 90 Prozent mit Bots gefüllt. Nach dem Start des Spiels ist das natürlich anders und da in Battlefield 6 den Fokus auf den Multiplayer legt, hat die Redaktion entsprechende Tests nun nachgeholt.

Der Artikel dreht sich rein um eben jene Multiplayer-Benchmarks, weitere Aspekte werden an dieser Stelle nicht untersucht. Für weitere Analysen kann ein Blick in das Launch-Review von Battlefield 6 (Test) geworfen werden.

Das Testsystem und die Benchmark-Szene

Alle Benchmarks werden auf einem AMD Ryzen 7 9800X3D (Test) durchgeführt, der mit den Standardeinstellungen betrieben wird. Als Mainboard ist das Asus ROG Crosshair X670E Hero (BIOS 2506) verbaut.

Die CPU wird von einem Noctua NH-D15S mit zentral installiertem 140-mm-Lüfter gekühlt. 48 GB Speicher (G.Skill TridentZ Neo, 2 × 24 GB, DDR5-6000, CL30-38-38-96) stehen dem Prozessor zur Verfügung. Windows 11 24H2 mit sämtlichen Updates und aktiviertem HVCI ist auf einer NVMe-M.2-SSD mit PCIe 4.0 installiert. Dasselbe gilt für das Spiel. Resizable BAR wird auf unterstützten Grafikkarten sowohl bei AMD als auch bei Nvidia sowie Intel genutzt.

Die 20 Sekunden lange Testsequenz findet im All-Out-Warfare-Modus mit 64 Spielern auf der großen Karte „Mirak-Tal“ statt. Bei großer Sichtweite sind einige Gebäude sowie viel Vegetation zu sehen. Die Performance ist verhältnismäßig niedrig, andere Multiplayer-Karten laufen etwas besser. In Gefechten kann die Framerate jedoch auch unter das Niveau der Benchmarks fallen.

Darüber hinaus gilt es zu bedenken, dass die Tests aufgrund der Natur des Multiplayers nicht völlig reproduzierbar sind. Entsprechend kann es zwischen einzelnen Läufen kleinere Schwankungen geben, jedoch sind diese ziemlich klein und haben keinen größeren Einfluss auf die Ergebnisse.

Wichtig: Unterschiede beim Upsampling-Ansatz!

DLSS 4, FSR 4, FSR 3 und XeSS im gleichen Preset in einen Topf zu werfen, ist inzwischen immer seltener ein fairer Vergleich. Denn auf Systemen, die DLSS 4 (alle GeForce RTX) oder FSR 4 (RX 9000) unterstützen, fällt die Bildqualität um Längen besser aus als mit FSR 3, das sogar schneller läuft – aber eben bei sichtbar schlechterer Bildqualität. Und es erscheinen immer mehr Spiele, die exklusiv mit DLSS 4 ausgestattet sind und auch FSR 4 unterstützen. Daher hat ComputerBase eine – im Podcast schon wiederholt besprochene – weitreichende Entscheidung getroffen:

Wenn DLSS 4 und FSR 4 unterstützt werden, dann …

Unterstützt ein Spiel DLSS 4 sowie FSR 4, wird auf älteren Radeons kein FSR 3.1 mit der gleichen Renderauflösung mehr genutzt, sondern stattdessen ein besseres Upsampling mit einer höheren Auflösung oder alternativ die native Auflösung mitsamt dem spieleigenen TAA – das ist davon abhängig, in welchem Leistungs-Modus mit DLSS 4 und FSR 4 getestet wird. So ist die Bildqualität eher vergleichbar und der unfaire Performance-Vorteil nicht mehr vorhanden.

Im Falle von Battlefield 6 bedeutet dies: DLSS 4 sowie FSR 4 laufen auf entsprechenden Grafikkarten im Quality-Modus (Skalierungsfaktor 1.5×), während ältere Radeons sowie Intel Arc mit XeSS Ultra Quality Plus laufen (Skalierungsfaktor 1.3×).

Benchmarks in WQHD, UWQHD und Ultra HD

- Die Performance ist auch auf großen Multiplayer-Karten deutlich besser als in der Kampagne

- Es verschieben sich die Verhältnisse im Multiplayer: AMD Radeon legt dabei mehr zu als Nvidia GeForce

- Der VRAM-bedarf ist höher als in der Kampagne, 8 GB in Verbindung mit PCIe ×8 sind zu wenig für maximale Texturdetails

- RDNA 4 ist stärker als in der Kampagne, in niedrigen Auflösungen etwas hinter GeForce, in hohen gleich auf

- Nvidia Blackwell ist etwas besser unterwegs als Nvidia Lovelace

- Die Intel Arc A770 ist leicht schneller als die Arc B580 – das ist selten

Und was ist mit dem Prozessor?

Auch im Multiplayer hat in Battlefield 6 die Grafikkarte das Kommando über die Performance, der Prozessor spielt nur eine untergeordnete Rolle. Bei einem ausgeglichenen System limitiert zuerst die GPU und dann erst die CPU, was in früheren Battlefield-Teilen durchaus auch schon einmal anders herum gewesen ist.

Der Prozessor ist nur in zwei verschiedenen Szenarien wichtig: Wenn das System unausgeglichen ist, also eine verhältnismäßig starke GPU mit einer verhältnismäßig schwachen CPU genutzt wird. Und wenn sehr hohe Frameraten erzielt werden sollen. Für 200 Bilder pro Sekunde benötigt es dann auch einen sehr schnellen Prozessor, dann hat auch ein Ryzen 7 9800X3D einiges zu tun.

8 GB VRAM ist zu wenig

Fazit

Battlefield 6 verhält sich im Multiplayer etwas anders als im Einzelspieler-Modus. Alle Grafikkarten laufen auch auf großen Maps mit durchweg höheren Frameraten als in der Kampagne, zumindest wenn der Grafikkartenspeicher ausreicht. Die Anforderungen an diesen sind auf den großen Karten etwas höher als in den kleineren Streaming-Abschnitten, 8 GB VRAM sind für maximale Grafikdetails nun definitiv zu wenig.

In den Benchmarks zeigt sich dann, dass Radeon-Grafikkarten im Multiplayer zulegen, sodass nun die aktuelle RX-9000-Riege in niedrigen Auflösungen zwar noch etwas langsamer als die RTX-5000-Produkte agiert, in höheren dagegen gleich schnell. Bei den Nvidia-Karten untereinander schneidet Blackwell dann leicht besser ab als Ada Lovelace, bei den Intel-Karten ist derweil die Arc A770 überraschenderweise geringfügig schneller als die Arc B580 – das passiert nicht häufig.

Der Prozessor ist (meistens) nicht so wichtig

Was nicht nur für die Kampagne, sondern auch für den Mehrspieler-Modus gilt ist, dass der Prozessor in Battlefield 6 keine sonderlich große Rolle spielt. Einzig bei unausgeglichenen Systemen oder wenn hohe Frameraten von um die 200 FPS erreicht werden sollen, bestimmt der Prozessor die Performance. Ansonsten ist es durchweg die Grafikkarte.

Die Technik von Battlefield 6 läuft auf dem PC im Multiplayer-Modus genauso gut wie in der Kampagne. Abstürze hat es während des Tests keine gegeben, Traversal-Stotterer zeigen sich anders als in der Kampagne ebenso wenig. Auch die Server halten der Belastung stand, auch wenn es manchmal eine kürzere Warteschlange gibt.

Dieser Artikel war interessant, hilfreich oder beides? Die Redaktion freut sich über jede Unterstützung durch ComputerBase Pro und deaktivierte Werbeblocker. Mehr zum Thema Anzeigen auf ComputerBase.

Apps & Mobile Entwicklung

Dieser Plug-in-Hybrid erobert Deutschland im Sturm!

Ihr habt bestimmt gedacht, dass VW oder vielleicht Volvo beim Thema Plug-in-Hybride das Rennen machen – aber weit gefehlt! Auf dem deutschen Automarkt sorgt gerade ein Modell aus China für ordentlich Wirbel. Und auch bei den beliebtesten E-Autos gibt es einen spannenden Wechsel an der Spitze.

Wenn es um vollelektrische Neuzulassungen geht, bleibt der Volkswagen ID.7 ganz klar eine feste Größe. Im November 2025 wurde die elegante Elektro-Limousine 3.340 Mal neu zugelassen – das entspricht satten sechs Prozent aller neuen E-Autos in diesem Monat. Damit holt sich der ID.7 erneut Platz eins, nachdem er unter anderem schon im Mai den Thron erklommen hatte. Für alle von Euch, die ein komfortables, leises und effizientes Elektroauto suchen, bleibt der ID.7 weiterhin eine der spannendsten Optionen im Markt.

BYD Seal U: Der neue Star unter den Plug-in-Hybriden

Richtig interessant wird es aber im Plug-in-Hybrid-Segment. Wie schon im September landet auch im November wieder ein Modell des chinesischen Herstellers BYD ganz oben: der BYD Seal U. Mit 1.552 Neuzulassungen – also 4,8 Prozent aller PHEVs – schnappt sich das Modell souverän den ersten Platz und verdrängt damit den Volvo XC60.

Und BYD hat sogar schon den nächsten PHEV im Köcher: Der BYD Seal 6 DM-i Touring (Test) steht bereits bereit und dürfte zukünftig für mindestens genauso viel Aufmerksamkeit sorgen. Für Euch bedeutet das: mehr Auswahl, bessere Preise und ein immer spannender werdender Markt für Plug-in-Hybride.

Boom bei Elektro- und Plug-in-Hybrid-Neuzulassungen

Insgesamt wurden im November 55.741 neue Elektroautos und 32.433 Plug-in-Hybride zugelassen. Das entspricht einem riesigen Plus gegenüber dem Vorjahresmonat:

- +58,5 % bei E-Autos

- +57,4 % bei Plug-in-Hybriden

Die Nachfrage nach elektrifizierten Fahrzeugen steigt also weiter kräftig – egal, ob ihr auf vollelektrisch oder auf einen flexiblen Hybrid setzt.

Die beliebtesten Autos in Deutschland – VW weiterhin stark

Damit ihr direkt seht, welche Modelle in den einzelnen Fahrzeugklassen aktuell ganz vorn stehen, haben wir Euch die wichtigsten Bestseller zusammengefasst. Perfekt, wenn ihr gerade überlegt, ein neues Auto anzuschaffen oder einfach neugierig seid, was in den deutschen Garagen landet.

- E-Autos: Mit dieser Entwicklung hat keiner gerechnet

Bei den Minis führt der Toyota Aygo mit 2.708 Neuzulassungen das Feld an. Während im Kleinwagenbereich der Opel Corsa mit 3.652 Zulassungen die Nase vorn hat. In der Kompaktklasse dominiert einmal mehr der VW Golf mit beeindruckenden 7.407 Neuzulassungen. Gefolgt vom VW Passat, der in der Mittelklasse mit 3.707 Zulassungen ebenfalls stark performt. Eine Klasse höher setzt der BMW 5er in der oberen Mittelklasse mit 3.896 Neuzulassungen ein deutliches Statement. Während der BMW 7er die Oberklasse mit 336 Zulassungen anführt. Im SUV-Segment bleibt der VW T-Roc mit 5.679 Neuzulassungen die erste Wahl, dicht gefolgt vom VW Tiguan, der bei den Geländewagen mit 5.334 Zulassungen an der Spitze steht.

Bei den Sportwagen lässt sich der Porsche 911 nicht die Butter vom Brot nehmen und kommt auf 551 Neuzulassungen. Im Bereich der Mini-Vans überzeugt der Peugeot 3008 mit 1.061 Zulassungen, während die Mercedes V-Klasse bei den Großraum-Vans mit 1.451 Neuzulassungen das Rennen macht. Dazu kommt der VW Transporter, der in der Kategorie Utilities mit 2.507 Neuzulassungen besonders stark vertreten ist. Für alle, die es eher auf Reisen zieht, bleibt der Fiat Ducato mit 1.514 Neuzulassungen das beliebteste Wohnmobil.

Apps & Mobile Entwicklung

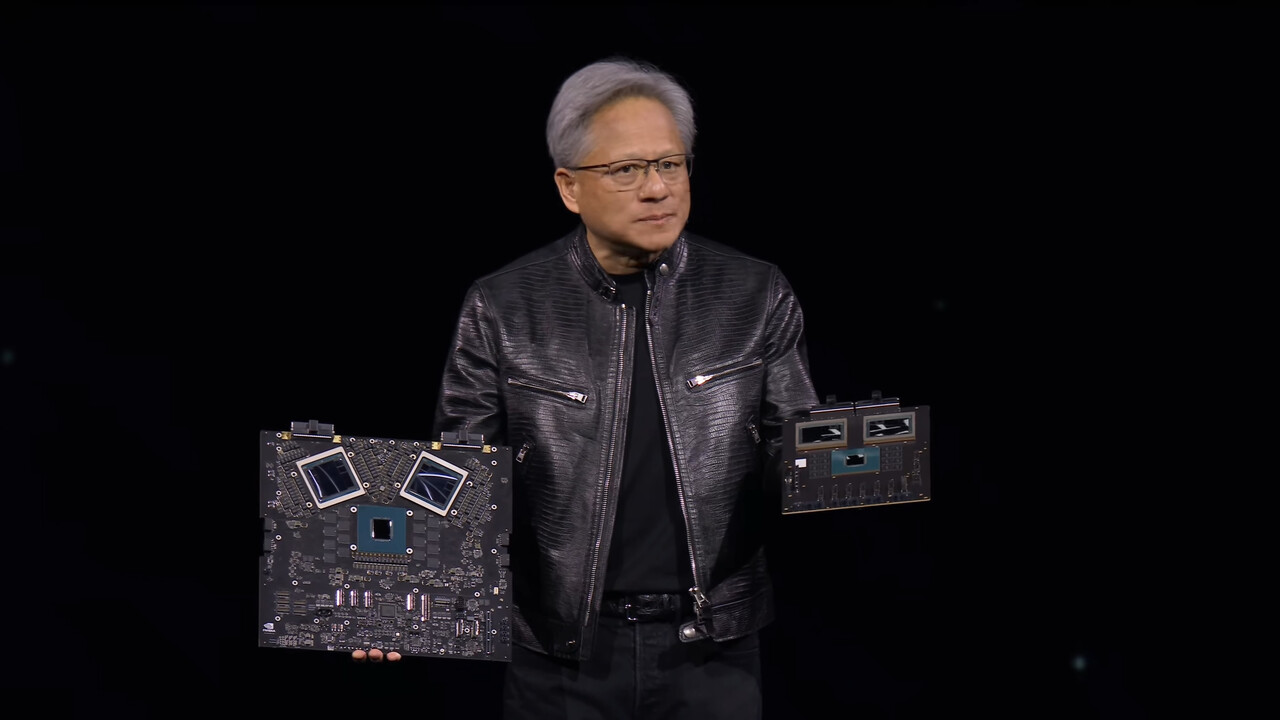

Per Software: Nvidia soll Chip-Tracking für Blackwell & Co umgesetzt haben

Nvidia soll über eine eingebaute Standortbestimmung aktuelle Blackwell-Chips jederzeit finden können. Dieser Schritt war erwartet worden, da neueste AI-Beschleuniger weiterhin nach China gelangt sind. Aktuell basiert diese Lösung wohl aber noch auf Software, die optional ist.

Offiziell ist die Software zur Überwachung des Chips gedacht. Sie sammelt Telemetriedaten, beispielsweise ob der Chip die gewünschte Performance bringt und was er dabei verbraucht, ob es Temperaturanomalien gibt oder Ähnliches. Vor allem bei umfangreicher Skalierung über viele Blades und Racks kann das helfen, Probleme frühzeitig zu entdecken und zu beheben.

Doch wie Reuters berichtet, kann die Software mehr, sofern dies vom Kunden gewünscht wird, wie es weiter heißt. Die Rücksprache der Software mit Nvidia-Servern könnte den Aufenthaltsort des Chips genauer bestimmen. Exakt beschrieben wird das Feature dabei nicht, Nvidia erwähnt es in ihrem Statement gegenüber der Nachrichtenagentur nicht.

We’re in the process of implementing a new software service that empowers data center operators to monitor the health and inventory of their entire AI GPU fleet. This customer-installed software agent leverages GPU telemetry to monitor fleet health, integrity and inventory.

Nvidia

Die offizielle Sprache spricht deshalb bisher stets noch von optionaler und vom Kunden installierter Software. Hinter den Kulissen könnte die Standortbestimmung aber durchaus weiterverfolgt werden, so wie es in Washington bereits seit Monaten gefordert wird. In den Fokus rückte Nvidia zu Jahresbeginn vor allem durch massive Auslieferungen an Singapur: Millionen Chips gingen in den Stadtstaat, der Rechenzentren in derart großem Stil eigentlich gar nicht hat oder bauen will. Vermutet wurde schnell, dass dies das Sprungbrett nach China war. Später gab es ein ähnliches Verhalten via Malaysia.

Für Nvidia ist dies jedoch ein heikles Thema und eine Gratwanderung. China warf ihnen zuletzt vor, dass der kastrierte H20(E)-Chip mit dem exklusiven Exportziel China mit Funktionen ausgestattet sein soll, die eine Deaktivierung oder gar Spionage ermöglichen würden. Diese Vorwürfe gelten bisher als unbestätigt, China warnt jedoch einheimische Firmen vor der Nutzung, auch nach der Freigabe des H200-Chips am gestrigen Tage. Nvidia selbst erklärte im August über einen Blogeintrag, ihre Chips hätten No Backdoors. No Kill Switches. No Spyware.

Apps & Mobile Entwicklung

Lohnt sich der Einstieg wirklich?

Mit dem Tesla Model 3 Standard bekommt ihr einen günstigen Einstieg in die Tesla-Welt – kompakt, effizient und alltagstauglich. Weniger Schnickschnack, aber volle Elektropower und eine Ausstattung, die Euch jeden Tag entspannt unterwegs sein lässt.

Wenn ihr Euch schon länger für das Tesla Model 3 interessiert, aber nie so richtig wusstet, welches Modell zu Euch passt, wird’s jetzt spannend. Tesla hat in Deutschland das neue Model 3 Standard an den Start gebracht – die günstigste Variante der beliebten E-Limousine. Und klar: Ein paar Abstriche gibt es im Vergleich zu den anderen Versionen. Aber viele von Euch könnten genau hier den perfekten Einstieg in die Tesla-Welt finden.

Tesla Model 3 Standard: Das steckt in der neuen Sportlimousie

Das Model 3 bleibt natürlich ein Model 3: 4,72 Meter lang, 2,09 Meter breit und angenehm flach mit 1,44 Metern Höhe. In der Standard-Version bekommt ihr allerdings die niedrigste WLTP-Reichweite der aktuellen Flotte: 534 Kilometer. Auch beim Sprint von 0 auf 100 km/h ist das Einstiegsmodell mit 6,2 Sekunden eher gemütlich unterwegs. Und statt wuchtigem Sound erwartet Euch ein vergleichsweise schlichtes 7-Lautsprecher-System.

Auch auf einen zweiten Touchscreen für die hinteren Passagiere müsst ihr verzichten. Der zentrale 15,4-Zoll-Touchscreen bleibt aber natürlich an Bord – und der ist wie immer der Mittelpunkt des gesamten Fahrzeugs.

Unterschiede zum Rest der Model-3-Familie

Tesla hat beim Model 3 Standard ein paar Features gestrichen, um den Preis zu drücken. Dazu gehören:

- Manuell einstellbares Lenkrad statt elektrischer Verstellung

- Keine Ambientebeleuchtung, die ihr farblich anpassen könnt

- Keine Abblendautomatik für die Außenspiegel

- Passive Stoßdämpfer statt adaptiver Technik

- Schnellladen nur noch mit bis zu 175 kW – reicht aber locker für rund 270 Kilometer Reichweite in nur 15 Minuten (bei optimalen Bedingungen)

Dafür überzeugt die Effizienz: Mit 13 kWh auf 100 Kilometer ist dieses Modell das sparsamste Model 3 überhaupt.

Serienausstattung: Das bekommt ihr ohne Aufpreis

Trotz aller Einsparungen müsst ihr nicht knausern. Tesla packt einiges an Ausstattung ins Standard-Modell:

- Schicke 18-Zoll-Felgen

- Großes Panorama-Glasdach

- Moderne LED-Scheinwerfer

- Acht Außenkameras für die Assistenzfunktionen

- Lenkradheizung und beheizte Frontscheibe – perfekt für den Winter

- Notbremsassistent, Spurhalteassistent und Totwinkelwarnung

- Elektrische Heckklappe

- Großer Kofferraum mit 549 Litern, erweiterbar auf bis zu 1.659 Liter

- Zusätzlich ein Frunk mit 88 Litern für alles, was schnell greifbar sein soll

Damit habt ihr ein Paket, das für den Alltag absolut solide ausgestattet ist.

Farben, Optionen und Performance

Die Höchstgeschwindigkeit liegt bei 201 km/h – vollkommen ausreichend für eine entspannte Langstrecke. Bei den Farben könnt ihr zwischen Weiß, Schwarz und Grau wählen, wobei Schwarz und Grau jeweils 1.300 Euro extra kosten.

Eine Anhängerkupplung gibt’s optional für 1.350 Euro und ermöglicht eine Anhängelast von 1.000 Kilogramm. Wenn ihr mehr Assistenzfunktionen wollt, könnt ihr vom Basic Autopilot upgraden. Je nach Funktionsumfang werden dafür 3.800 bis 7.500 Euro zusätzlich fällig.

Preis: Ab 36.990 Euro geht’s los

Und jetzt der entscheidende Punkt: Preislich startet das Model 3 Standard bei 36.990 Euro. Damit liegt es:

- rund 8.000 Euro unter dem Model 3 mit Hinterradantrieb

- etwa 22.000 Euro unter dem Performance-Modell

- sogar unter dem Tesla Model Y, das aktuell bei ca. 40.000 Euro beginnt

Für wen lohnt sich das Tesla Model 3 Standard?

Ob das Modell ein Erfolg wird, hängt am Ende davon ab, wie viele von Euch bereit sind, für einen günstigeren Einstieg auf ein paar Komfortfunktionen zu verzichten. Ein Schnäppchen ist das E-Auto nicht – aber im direkten Vergleich bietet Tesla damit einen der attraktivsten Einstiege in die E-Mobilität im Premium-Segment.

Für alle, die sich eine erschwinglichere Tesla-Erfahrung, niedrige Betriebskosten und ein zuverlässiges E-Auto wünschen, könnte dieses Modell genau das Richtige sein. Tesla selbst betont, dass das Standard-Modell besonders praktisch und effizient sein soll. Bestellen könnt ihr ab sofort – die ersten Auslieferungen sollen im Februar 2026 starten.

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenIllustrierte Reise nach New York City › PAGE online

-

Datenschutz & Sicherheitvor 3 Monaten

Datenschutz & Sicherheitvor 3 MonatenJetzt patchen! Erneut Attacken auf SonicWall-Firewalls beobachtet

-

Künstliche Intelligenzvor 2 Monaten

Künstliche Intelligenzvor 2 MonatenAus Softwarefehlern lernen – Teil 3: Eine Marssonde gerät außer Kontrolle

-

Künstliche Intelligenzvor 2 Monaten

Top 10: Die beste kabellose Überwachungskamera im Test

-

UX/UI & Webdesignvor 3 Monaten

UX/UI & Webdesignvor 3 MonatenFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenSK Rapid Wien erneuert visuelle Identität

-

Entwicklung & Codevor 3 Wochen

Entwicklung & Codevor 3 WochenKommandozeile adé: Praktische, grafische Git-Verwaltung für den Mac

-

Social Mediavor 3 Monaten

Social Mediavor 3 MonatenSchluss mit FOMO im Social Media Marketing – Welche Trends und Features sind für Social Media Manager*innen wirklich relevant?