Apps & Mobile Entwicklung

OLED-Monitore: LGs Meta 3.0 startet mit 280 Hz, später mit 540 Hz bis 720 Hz

LG Display schickt das erste OLED-Panel der 4. Generation für den Monitormarkt in die Serienfertigung. Der 27-Zoll-Bildschirm bringt es damit punktuell auf 1.500 cd/m² Helligkeit in der Spitze. Bald soll ein 540-Hz-OLED-Panel mit Option auf 720 Hz im Dual-Mode folgen.

Das erste Monitor-Panel der 4. OLED-Generation von LG

Mehr Helligkeit und Effizienz verspricht LG Display für seine vierte OLED-Generation mit 4-Layer-Struktur alias „Primary Tandem OLED“ alias „Meta 3.0“. Kommen bei der dritten Generation noch drei Schichten (Layer) zum Einsatz, zweimal blau und einmal rot, grün und gelb in einer Ebene, sind es nun vier: zweimal blau in Kombination mit rot und grün in jeweils einer eigenen Ebene.

Das sorgt für eine Steigerung der maximalen Helligkeit. Im Verbund mit Verbesserungen an der Panel-Struktur und dessen Stromversorgung steigt auch die Energieeffizienz.

Im Januar zunächst für den TV-Bereich mit satten 4.000 cd/m² beworben, sickerten im März Informationen zum ersten Monitor-Panel mit bis zu 1.500 cd/m² Leuchtstärke durch. Das gilt aber nur für einen sehr kleinen Bildbereich von 1,5 Prozent. Auf der gesamten Bildfläche sollen aber für OLED-Monitore ebenfalls hohe 335 cd/m² möglich werden, so der letzte Kenntnisstand.

Zum Vergleich: Für den aktuellen UltraGear OLED 27GX790A mit WQHD und 27 Zoll (3rd Gen OLED mit MLA) nennt LG eine Helligkeit von 275 cd/m² (Vollbild) und bis zu 1.300 cd/m² (Peak).

Serienfertigung für 27-Zoll-Monitore mit WQHD und 280 Hz gestartet

Am Freitag hat LG Display angekündigt, dass das besagte erste OLED-Panel für Monitore mit der neuen Technik der 4. Generation in die Serienfertigung gestartet ist. Das Display besitzt eine Diagonale von 27 Zoll, eine Auflösung von 2.560 × 1.440 Pixeln und eine Bildwiederholrate von 280 Hz.

Darüber hinaus spricht LG von hohen 99,5 Prozent bei der Farbwiedergabe, womit der Farbraum DCI-P3 gemeint sein dürfte, den OLED-Panels stets sehr gut abdecken. Dies sowie Zertifizierungen nach Standards wie „Perfect Black“, „Perfect Color“ und „100 % Color Fidelity“ soll dem Panel nicht nur Gaming-, sondern auch Profiambitionen verleihen. Reflexionen sollen deutlich gemindert werden, sodass auch bei hellem Umgebungslicht störungsfrei gearbeitet oder gespielt werden könne.

Wie TFT Central berichtet, wird der im Mai vorgestellte Gigabyte MO27Q28G zu den ersten Monitoren mit dem neuen LG-Panel zählen.

Mit dem jetzigen Start der Serienfertigung steht einem Marktstart im laufenden Jahr nichts mehr im Wege. Das Modell von Gigabyte wird bereits für den August erwartet. Weitere Hersteller, letztlich auch LG selbst als Mutterkonzern von LG Display, sind mit entsprechenden Pendants zu erwarten.

540 Hz kommen „bald“

Mit dem Konkurrenten Samsung Display (QD-OLED) liefert sich LG Display nicht nur bei der Helligkeit einen engen Schlagabtausch, sondern auch bei der maximalen Bildwiederholrate. Lag LG im letzten Punkt zunächst mit 480 Hz vorn, stellte Samsung jüngst sein erstes QD-OLED-Panel mit 500 Hz vor, das in der zweiten Jahreshälfte im Samsung Odyssey OLED G6 (G60SF) verfügbar sein soll. Diverse Partner haben ihrerseits Monitore mit QD-OLED und 500 Hz in Aussicht gestellt:

Der Konter von LG Display erhöht auf 540 Hz und setzt ebenfalls auf die WQHD-Auflösung. Ein neuer Algorithmus soll dabei helfen, dass die Bildqualität nicht unter der hohen Bildrate leidet, erklärt der Hersteller.

Exceeding a 500Hz refresh rate had been considered a virtually unbreakable threshold due to the associated steep drop in picture quality. LG Display has successfully overcome this limitation by developing and applying a new proprietary algorithm. The 540Hz refresh rate goes beyond even the highest standards envisioned by professional gamers for OLED gaming monitors.

LG Display

Das 540-Hz-OLED-Panel von LG Display sei nun fertig entwickelt und werde bald „enthüllt“, heißt es in der offiziellen Pressemitteilung nur. Erneut kann TFT Central weitere Details liefern: So soll das Panel die besagten 1.500 cd/m² und 99,5 % von DCI-P3 erreichen, was für die vierte OLED-Generation spricht. Zertifizierungen nach DisplayHDR 500 True Black und VESA ClearMR 21000 seien zu erwarten. Die Serienfertigung für das 540-Hz-OLED-Panel soll in der zweiten Jahreshälfte beginnen.

Dual-Mode bis 720 Hz bei 720p

Das 540-Hz-Panel soll im Dual-Mode mit reduzierter Auflösung von nur noch 1.280 × 720 Pixeln eine maximale Bildwiederholrate von sogar 720 Hz erreichen. Das wird zumindest anhand der angegebenen „HD Resolution“ vermutet.

Bisher ist allerdings üblich, dass im Dual-Mode die Auflösung auf ein Viertel reduziert wird und die Bildwiederholrate verdoppelt wird. 720 Hz würden aber nur 33 Prozent mehr als 540 Hz sein. Womöglich stößt die Display-Technik hier noch schlicht an ihre Grenzen, obgleich mit LCDs schon 1.000 Hz demonstriert wurden.

Apps & Mobile Entwicklung

Snapdragon X2 Elite Extreme im Benchmark

Qualcomm hat erste App- und 3D-Benchmarks des Snapdragon X2 Elite Extreme auf einem Referenzgerät des Herstellers ermöglicht. Wenig überraschend hängen die 18 Oryon-3-CPU-Kerne, von denen zwei mit bis zu 5 GHz takten können, und die neue Adreno-GPU den Wettbewerb von AMD, Intel und Apple vorerst teils deutlich ab.

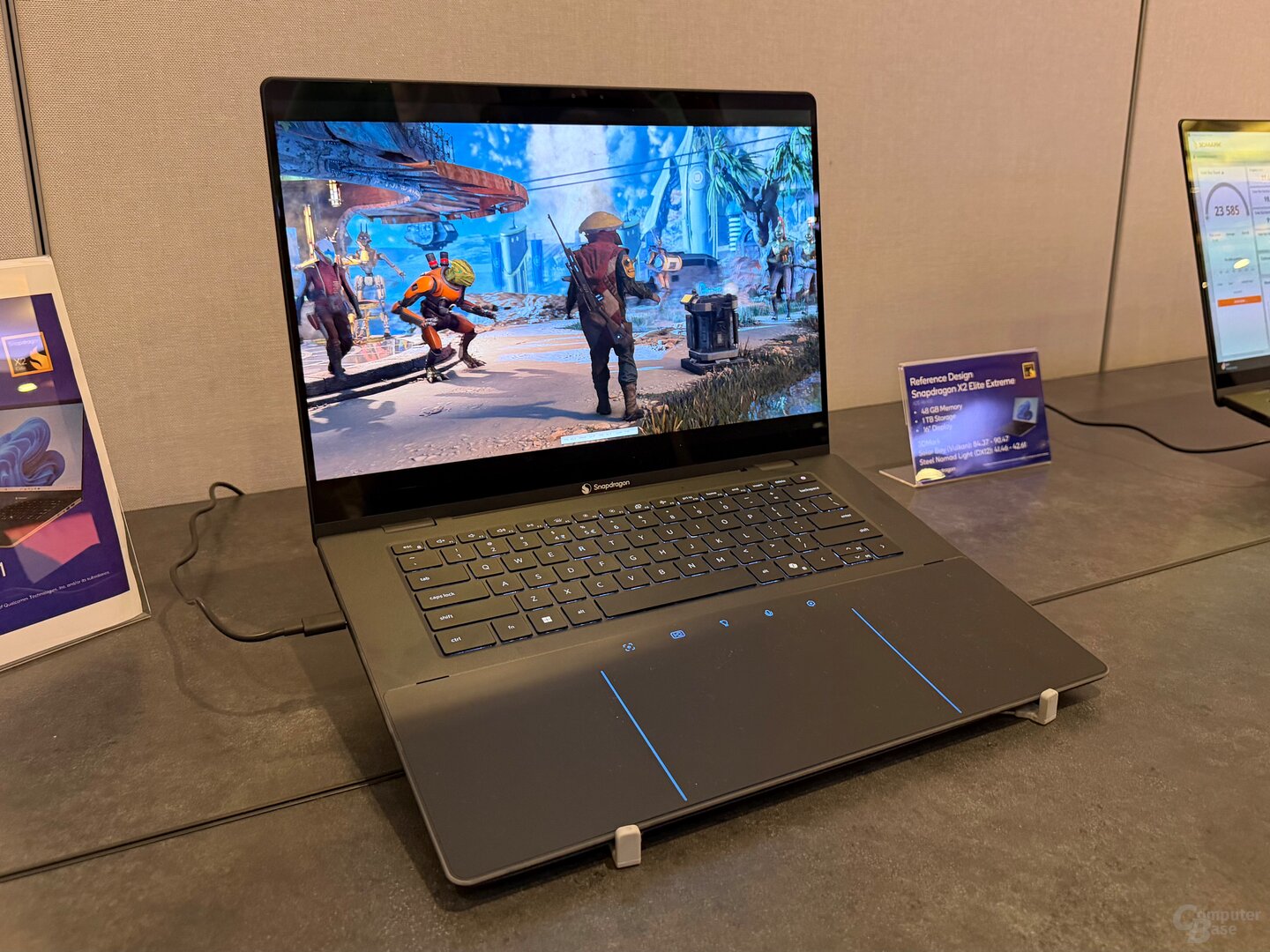

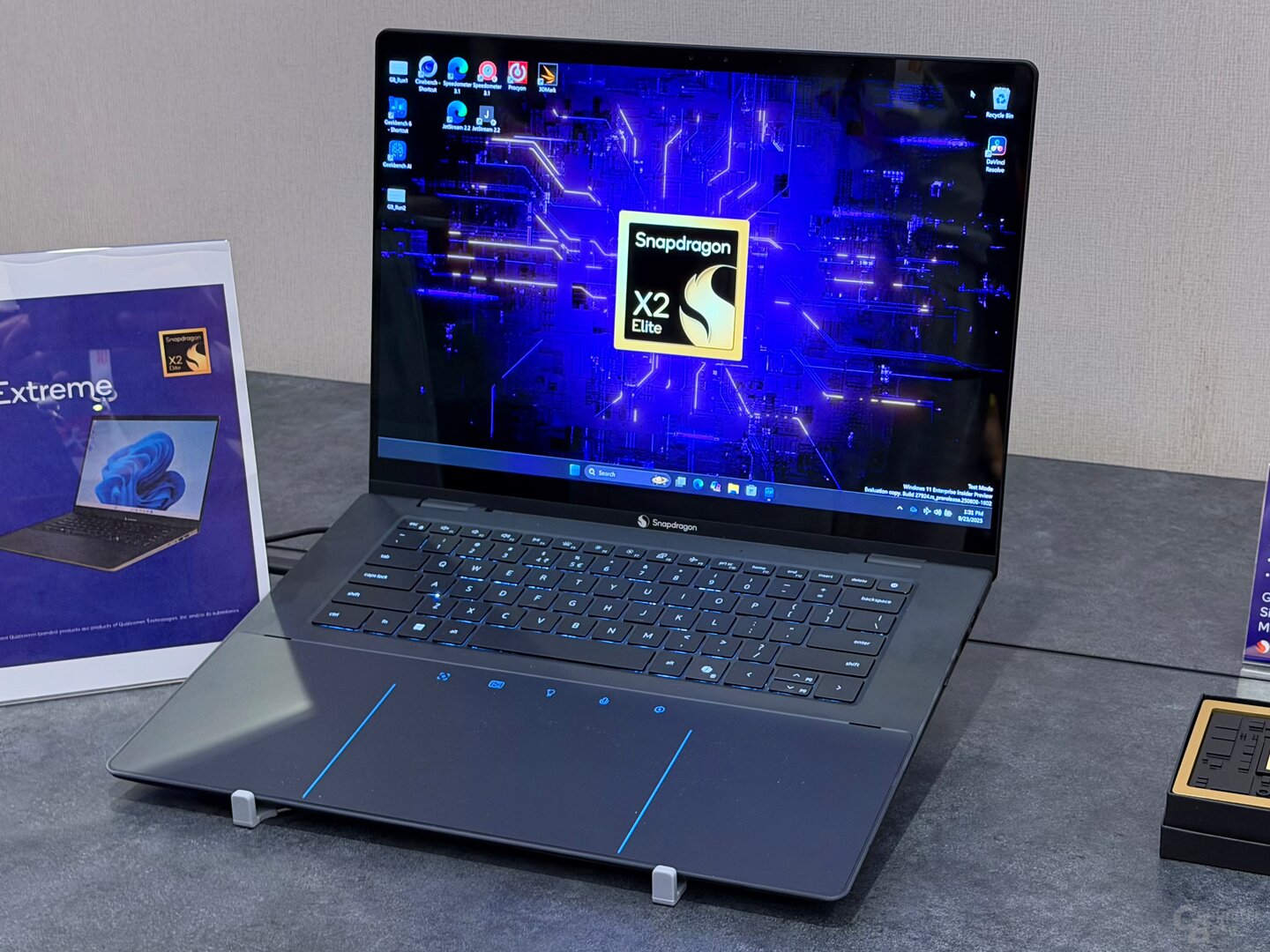

So wurde getestet

Die Benchmarks Cinebench 2024, Geekbench 6.5, Procyon AI Computer Vision sowie 3DMark Solar Bay und Steel Nomad Light ließen sich auf einem Referenzgerät von Qualcomm ausführen, bei dem es sich um ein seriennahes 16-Zoll-Notebook, ausgestattet mit dem größten Snapdragon X2 Elite Extreme und 48 GB LPDDR5X „Memory on Package“ handelte. Angaben zur konfigurierten TDP und zum jeweiligen Verbrauch in den einzelnen Tests lassen sich zum aktuellen Zeitpunkt noch nicht treffen. Soweit der Redaktion bekannt ist, lassen sich diese Werte mit Tools wie HWiNFO weiterhin nicht bei Snapdragon-Prozessoren auslesen.

Die nachfolgenden Ergebnisse geben einen weiteren Vorgeschmack auf die Leistung des Snapdragon X2 Elite Extreme, finale Notebooks oder PCs für Consumer können davon aber abweichen, weil die TDP unterschiedlich hoch ausfallen kann und somit in erster Linie das Kühlsystem und dann davon abgeleitet die Leistung gemessen wird. Generell ist davon auszugehen, dass Qualcomm auf dem eigenen Event Systeme in Konfigurationen bereitgestellt hat, die den eigenen Prozessor in besonders positivem Licht darstellen. Aber das macht die Konkurrenz nicht anders.

Die Testergebnisse im Überblick

Geekbench 6.5: der neue CPU-König

Im Geekbench 6.5 stellt der Snapdragon X2 Elite Extreme den erwarteten neuen Rekord bezogen auf die Single-Core-Leistung auf. Die Kombination aus neuer Oryon-3-Architektur und bis zu 5 GHz Spitzentakt sorgt für einen neuen Bestwert im Single-Core-Test von 4.072 Punkten, der 7 Prozent vor dem Apple M4 Pro liegt. Der Intel Core Ultra 9 285H wird mit 36 Prozent, der Snapdragon X1 Elite mit 39 Prozent, der Core Ultra 9 288V mit 43 Prozent und der Ryzen AI 9 HX 370 mit 44 Prozent Vorsprung geschlagen.

Die insgesamt 18 Kerne des Snapdragon X2 Elite Extreme sorgen auch im Multi-Core-Test für einen deutlichen Vorsprung von 35 Prozent zum Intel Core Ultra 9 285H. Zum Apple M4 Pro aus dem Mac mini besteht immerhin ein kleiner Abstand von 5 Prozent.

Cinebench 2024: Singe-Core bleibt bei Apple

Im Cinebench 2024 geht der Multi-Core-Test ebenfalls an den Neuzugang von Qualcomm, doch muss sich der Snapdragon X2 Elite Extreme im Single-Core-Test der M4-Familie geschlagen geben. Der M4 aus dem MacBook Air und MacBook Pro sowie der M4 Pro aus dem Mac mini schneiden jeweils 7 Prozent besser an.

NPU: 80 TOPS ist aktuell konkurrenzlos

Haushoch überlegen ist der Snapdragon X2 Elite Extreme dann allerdings wieder im Procyon AI Computer Vision, der die NPU-Leistung des Chips misst. In der neuesten Generation verbaut Qualcomm eine von ehemals 45 TOPS auf jetzt 80 TOPS (INT8) gesteigerte NPU, die damit den Modellen des Wettbewerbs mit maximal 50 TOPS weit überlegen ist.

Stärkere GPU mit Raytracing-Unterstützung

Qualcomm selbst attestiert dem Chip zudem eine bis zu 2,3-fache GPU-Leistung im Vergleich zum Vorgänger. Im 3DMark Steel Nomad Light legt der Snapdragon X2 Elite Extreme mit 139 Prozent Vorsprung zur bislang größten SKU der letzten Generation (X1E-84-100) annähernd eine Punktlandung hin. Qualcomms Chip landet damit zwischen Apple M4 und M4 Pro. Die iGPUs von AMD und Intel werden deutlich geschlagen.

Nachdem die GPU-Generation der Snapdragon X1 Elite noch den GPUs aus den Smartphone-Chips desselben Jahres hinterherhinkte und Features wie Hardware-Raytracing fehlten, unterstützt die bis zu 1,85 GHz schnelle Adreno-X2-90-GPU dieses Feature jetzt, sodass auch der 3DMark Solar Bay ausgeführt werden kann. Auch hier schneidet der Snapdragon X2 Elite Extreme zwischen dem Apple M4 und M4 Pro ab.

Technische Daten des Snapdragon X2 Elite Extreme im Vergleich

Mehr Informationen auch im Podcast

Mehr Informationen zum Snapdragon Summit 2025, auf dem der neue Snapdragon X2 Elite (Extreme) präsentiert wurde, gibt es auch in der aktuellen Episode von CB-Funk – der ComputerBase-Podcast.

ComputerBase hat Informationen zu diesem Artikel von Qualcomm im Vorfeld und im Rahmen einer Veranstaltung des Herstellers auf Maui unter NDA erhalten. Die Kosten für Anreise, Abreise und vier Hotelübernachtungen wurden von dem Unternehmen getragen. Eine Einflussnahme des Herstellers auf die oder eine Verpflichtung zur Berichterstattung bestand nicht. Die einzige Vorgabe war der frühestmögliche Veröffentlichungszeitpunkt.

Dieser Artikel war interessant, hilfreich oder beides? Die Redaktion freut sich über jede Unterstützung durch ComputerBase Pro und deaktivierte Werbeblocker. Mehr zum Thema Anzeigen auf ComputerBase.

Apps & Mobile Entwicklung

So holt Ihr Euer Geld nach Online-Betrug zurück

In Deutschland kommt Kontobetrug häufig vor. Perfide Methoden wie Phishing oder Malware können alle treffen. Die Folge: hohe finanzielle Schäden. Was viele jedoch nicht ahnen: Sie können das gestohlene Geld in zahlreichen Fällen wieder zurückerhalten.

Obwohl das Bundeskriminalamt (BKA) berichtet, dass die Anzahl bekannter Cybercrime-Fälle seit 2021 rückläufig ist, lag sie 2024 noch immer bei hohen 131.391 Fällen. Die Dunkelziffer dürfte deutlich darüber liegen. So haben laut einer aktuellen Bitkom-Umfrage nur 26 Prozent der Opfer eine Strafanzeige erstattet. Im Visier der Täter stehen in erster Linie gewöhnliche Bankkunden – häufig bei größeren Instituten wie ING, DKB, VR-Bank oder Sparkasse. Aber auch Nutzer:innen von PayPal, Amazon, Spotify, Kleinanzeigenportalen oder Streamingdiensten sind oft Ziel von Betrugsmaschen. Doch was könnt Ihr tun, wenn das Geld plötzlich weg ist? Stiftung Warentest liefert die Antwort.

Gestohlene Beträge zurückfordern

Wenn Ihr auf eine Online-Betrugsmasche hereinfallt und die Täter Zugriff auf Eure Bankkonten erhalten, drohen hohe Abbuchungen oder sogar komplett leere Konten. Die polizeiliche Aufklärungsquote bei Cybercrime liegt jedoch bei lediglich 32 Prozent. Bedeutet das, dass Opfer keine Chancen auf Rückerstattung haben? Keineswegs.

Wie aus der Oktober-Ausgabe der Zeitschrift Stiftung Warentest hervorgeht, wird der Schaden häufig von den Banken ersetzt. „Selbst einstehen müssen sie für die Schäden nur, wenn die Bank ihnen grobe Fahrlässigkeit nachweist“, so Stiftung Warentest. Die Gerichte entscheiden dann im Einzelfall, was genau darunter fällt. In der Praxis gelingt es Banken allerdings selten, grobe Fahrlässigkeit nachzuweisen. Paradoxerweise bleibt der Rechtsweg dennoch oft die einzige Möglichkeit, die eigenen Ansprüche geltend zu machen.

Um das entwendete Geld von der Bank zurückzuerhalten, solltet Ihr zunächst schriftlich eine Erstattung beantragen und dabei eine sinnvolle Frist setzen. Reagiert das Kreditinstitut nicht oder lehnt ab, rät Stiftung Warentest dazu, einen Fachanwalt für Bank- und Kapitalmarktrecht einzuschalten.

Schnell sein lohnt sich

Sobald Ihr einen Betrug bemerkt, steht an erster Stelle, weitere Abbuchungen zu verhindern. Hierfür ist die Sperr-Hotline (116 116) die erste Anlaufstelle. Dort könnt Ihr Eure Karten sofort und rund um die Uhr sperren lassen. Aus dem Ausland erreicht man den Service unter „+49 116 116“ oder „+49 30 4050 4050“. Danach sollten sich Betroffene so schnell wie möglich an ihren Kreditinstitut wenden. Gelegentlich lassen sich Abbuchungen nämlich stoppen oder zurückbuchen.

Darüber hinaus ist es wichtig, alle möglicherweise kompromittierten Passwörter zu ändern, Beweise wie betrügerische Nachrichten per Screenshot zu sichern und Anzeige zu erstatten. Ergänzend: Richtet, wenn möglich eine sogenannte Zwei-Faktor-Authentifizierung (2FA) ein. Diese zusätzliche Sicherheitsebene erschwert Cyberkriminellen das Vorgehen erheblich und ist bei vielen Anbietern wie Amazon oder PayPal in den Einstellungen zu finden.

Apps & Mobile Entwicklung

WD_Black SN7100X: Das „X“ steht für Xbox-Ally-Lizenz, sonst ändert sich nix

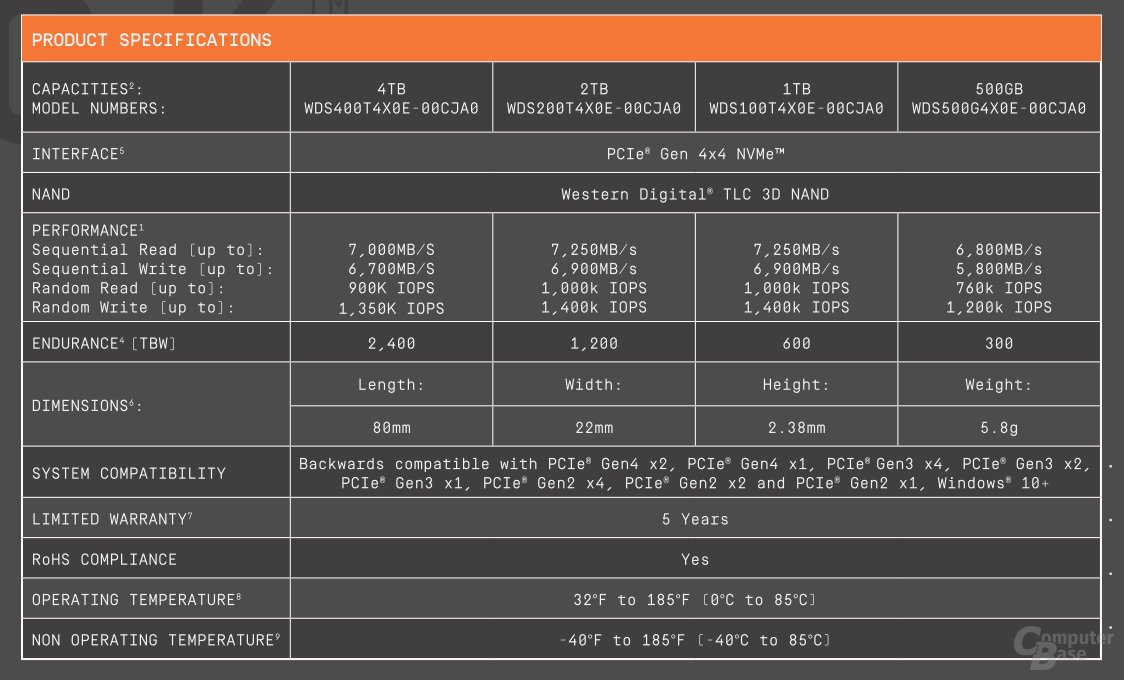

Gerade erst fiel der Startschuss für Vorbestellungen der Xbox-Handheld-Konsolen ROG Xbox Ally und ROG Xbox Ally X, schon folgen die ersten Speicherprodukte mit offizieller Lizenz. SanDisk verpasst der WD_Black SN7100 dafür einfach ein „X“ und so wird sie zur WD_Black SN7100X. Eine microSD-Karte gibt es obendrein.

Aus SN7100 wird SN7100X

Bei der heute vorgestellten WD_Black SN7100X handelt es sich um die bisherige WD_Black SN7100 wie der Vergleich der Datenblätter mit identischen Spezifikationen aufzeigt. Das „X“ steht lediglich für die offizielle Lizenzierung für den Einsatz in ROG Ally (X). Die Serie ist zudem auf Modelle mit 2 TB und 4 TB begrenzt.

Die Preise der SN7100X im Hersteller-Shop liegen zur Stunde bei 143 Euro für 2 TB und 275 Euro für 4 TB. Die SN7100 ohne Xbox-Lizenz liegt bei 134 Euro für 2 TB und 270 Euro für 4 TB.

Ob mit oder ohne „X“: Die PCIe-4.0-SSDs besitzen einen 4-Kanal-Controller ohne eigenen DRAM-Cache und setzen auf den schnellen und effizienten BiCS8-TLC-Flash von SanDisk.

Es spricht aber nichts dagegen, eine beliebige andere SSD im Formfaktor M.2 2280 im ROG Xbox Ally (X) einzusetzen, die PCIe und NVMe unterstützt.

Eine Speicherkarte gibt es auch

Außerdem legt SanDisk microSD-Karten mit Xbox-Ally-Lizenz neu auf. Diese sind mit 512 GB, 1 TB oder 2 TB Speichervolumen zu Preisen von 58 Euro, 120 Euro oder 240 Euro erhältlich. SanDisk verspricht bis zu 200 MB/s beim Lesen und 140 MB/s beim Schreiben.

Auch für Nintendo Switch lizenzierte Speicherkarten hat SanDisk im Programm. Technisch unterscheiden sich diese nicht vom herkömmlichen Portfolio. Zum kleinen Aufpreis erhält der Kunde auch hier nur die absolute Gewissheit, dass der Speicher mit der jeweiligen Spielkonsole funktioniert. Es können aber selbstverständlich auch kompatible Speicherkarten ohne Lizenz eingesetzt werden. Das bestätigt übrigens SanDisk selbst auf seinen Produktseiten.

-

UX/UI & Webdesignvor 1 Monat

UX/UI & Webdesignvor 1 MonatDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 1 Monat

UX/UI & Webdesignvor 1 MonatAdobe Firefly Boards › PAGE online

-

Social Mediavor 1 Monat

Social Mediavor 1 MonatRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

Entwicklung & Codevor 1 Monat

Entwicklung & Codevor 1 MonatPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 4 Wochen

Entwicklung & Codevor 4 WochenEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

UX/UI & Webdesignvor 2 Wochen

UX/UI & Webdesignvor 2 WochenFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online

-

Digital Business & Startupsvor 3 Monaten

Digital Business & Startupsvor 3 Monaten10.000 Euro Tickets? Kann man machen – aber nur mit diesem Trick

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenFirefox-Update 141.0: KI-gestützte Tab‑Gruppen und Einheitenumrechner kommen