Apps & Mobile Entwicklung

Tesla: Full Self-Driving (Supervised) Probefahrt in Deutschland

Tesla bietet Interessenten seit Anfang Dezember Mitfahrten in Modellen mit Full Self-Driving (Supervised) an. Damit kann das Fahrzeug weitgehend autonom durch die Stadt sowie über Landstraßen und Autobahnen navigieren. Eine erste Probefahrt in Berlin zeigt, dass Tesla Vision nur mit Kameras für eine souveräne Fahrt sorgen kann.

Der Termin bei Tesla in Schönefeld stand unter schlechten Vorzeichen: Zunächst wurde der Redaktion die ursprünglich gebuchte Probefahrt vom 2. auf den 4. Dezember verschoben. Und zum Termin wollte man von der ausgemachten Mitfahrt um 9 Uhr morgens zunächst einmal nichts mehr wissen, da Mitfahrten generell erst ab 10 Uhr möglich seien. Nach Rücksprache mit den Kollegen und rund 20 Minuten Verspätung ließ sich das Dilemma jedoch lösen und es konnte auf autonome Probefahrt zum 7,3 km entfernten Supercharger in Waltersdorf (und im Anschluss wieder zurück) gehen.

FSD-Mitfahrten bis Ende März verlängert

Tesla bietet Termine für Probefahrten mit Full Self-Driving (FSD) unter Aufsicht (Supervised) seit Ende November an mehreren Standortden in Deutschland an. Noch am selben Tag der Bekanntgabe waren in Berlin Schönefeld und weiteren Städten sämtliche Slots ausgebucht. Das hat Tesla zwischenzeitlich dazu veranlasst, weitere Termine bis Ende März anzubieten.

In Berlin ohne Betreuung durch Pressesprecher

Die Termine richten sich an Interessenten aller Couleur, es handelt sich demnach nicht um ein Angebot ausschließlich für die Presse. Ganz im Gegenteil: Bei Tesla in Berlin Schönefeld war im Gegensatz zur Probefahrt von Heise (Paywall) kein Tesla-Pressesprecher zur Fahrt anwesend. Aus rechtlichen Gründen durfte der Mitarbeiter in den Videoaufnahmen weder zu sehen noch zu hören sein. Deshalb musste der Ton im Video bei Gesprächen wiederholt entfernt werden.

Die komplette FSD-Mitfahrt im Video

Das nachfolgende Video zeigt die gesamte FSD-Mitfahrt annähernd ungeschnitten. Gekürzt wurde lediglich eine mehrminütige, ereignislose Parkphase am Supercharger.

Noch kein Termin für Full Self-Driving in Deutschland

Die aktuell angebotenen Probefahrten sind als Hinweis darauf zu werten, dass Tesla das Fahren mit Full Self-Driving (Supervised) auch in Deutschland anbieten möchte. Nach wie vor gibt es jedoch noch keine Zulassung durch das Kraftfahrtbundesamt und somit auch noch keinen offiziellen Termin für die Markteinführung von FSD Supervised in Deutschland. Der Marktstart könnte mit Blick auf die aktuell angebotenen Mitfahrten mittel- bis langfristig bevorstehen, offiziell ist daran bislang aber noch nichts.

Volles Potenzial für autonomes Fahren

Bekannt ist aber schon heute, dass aktuelle Fahrzeuge mit der perspektivischen Verfügbarkeit von FSD Supervised lediglich ein Software-Update benötigen, um entsprechend auf der Straße agieren zu können. Die Fähigkeit selbst haben Besitzer entweder bereits mit der Sonderausstattung „Volles Potenzial für autonomes Fahren“ für 7.500 Euro erworben oder können dieses Upgrade alternativ im Nachgang über die App erwerben.

Full Self-Driving entspricht Level 2+

FSD Supervised entspricht dem Fahren nach „Level 2+“, wobei es sich dabei um eine inoffizielle Bezeichnung für Level 2 handelt, das keine Hände mehr am Lenkrad voraussetzt. Das dauerhaft freihändige Fahren verlangt dennoch die volle Aufmerksamkeit des Fahrers, der permanent das Fahrgeschehen überwachen und gegebenenfalls sofort eingreifen können muss. Anders als bei Level 3 (Test) gibt es keine Übernahmefrist und die Fahraufgabe wird nicht vollständig an das Auto übergeben. Auch Nebentätigkeiten wie das Lesen oder Filme bleiben untersagt. Dafür steht das „Supervised“, also das autonome Fahren unter Aufsicht des Fahrers. Eine Innenraumkamera am Rückspiegel sorgt für das Einhalten dieser Vorgabe.

Vision Only setzt ausschließlich auf Kameras

Tesla verfolgt bei FSD einen Vision-Only-Ansatz. Seit 2022 werden im Model 3 und Model Y nur noch Kameras verbaut, seit 2023 gilt dies auch für das Model S und X.

Vision Only bedeutet, dass die Fahrzeuge ihre gesamte Umgebung ausschließlich über Kameras wahrnehmen. Statt zusätzliche Sensoren wie Radar oder Lidar zu nutzen, setzt Tesla auf ein System, das die Welt ähnlich wie ein Mensch mit den Augen erfasst. Ein neuronales Netzwerk verarbeitet die Videodaten, rekonstruiert dreidimensionale Szenen, erkennt Objekte und schätzt Entfernungen sowie Bewegungen. Dieses System wird kontinuierlich mit riesigen Mengen realer Fahrdaten trainiert, um die Wahrnehmungs- und Entscheidungsfähigkeiten zu verbessern.

Strategisch verfolgt Tesla damit das Ziel, Kosten, Komplexität und Sensor-Fusion-Probleme zu reduzieren. Wenn alle Fahrzeuge nur Kameras verwenden, kann Tesla Software-Updates schneller entwickeln und weltweit ausrollen, weil die Hardware in den Fahrzeugen einheitlich ist. Zudem glaubt Tesla, dass ein System, das „wie ein Mensch sieht“, langfristig besser skalierbar und effizienter für vollautonomes Fahren ist. Die deutschen Autohersteller sehen das bekanntlich anders.

Full Self-Driving (Supervised) Software v14.1.7

Die Probefahrt in Berlin Schönefeld erfolgte in einem nagelneuen Model 3 mit der Full Self-Driving (Supervised) Software v14.1.7. Das ist der Stand vom 12. November, zwischenzeitlich sind die Versionen 14.2 und 14.2.1 von Tesla veröffentlicht worden.

Souveräne Probefahrt gleich vom Start weg

Nach dem initial eher negativen Eindruck bedingt durch den verschobenen und dann zunächst nicht im System gefundenen Termin, erfolgte der Start in die Probefahrt selbst dann allerdings auf Anhieb in gleich mehrfacher Hinsicht mit positiven Überraschungen.

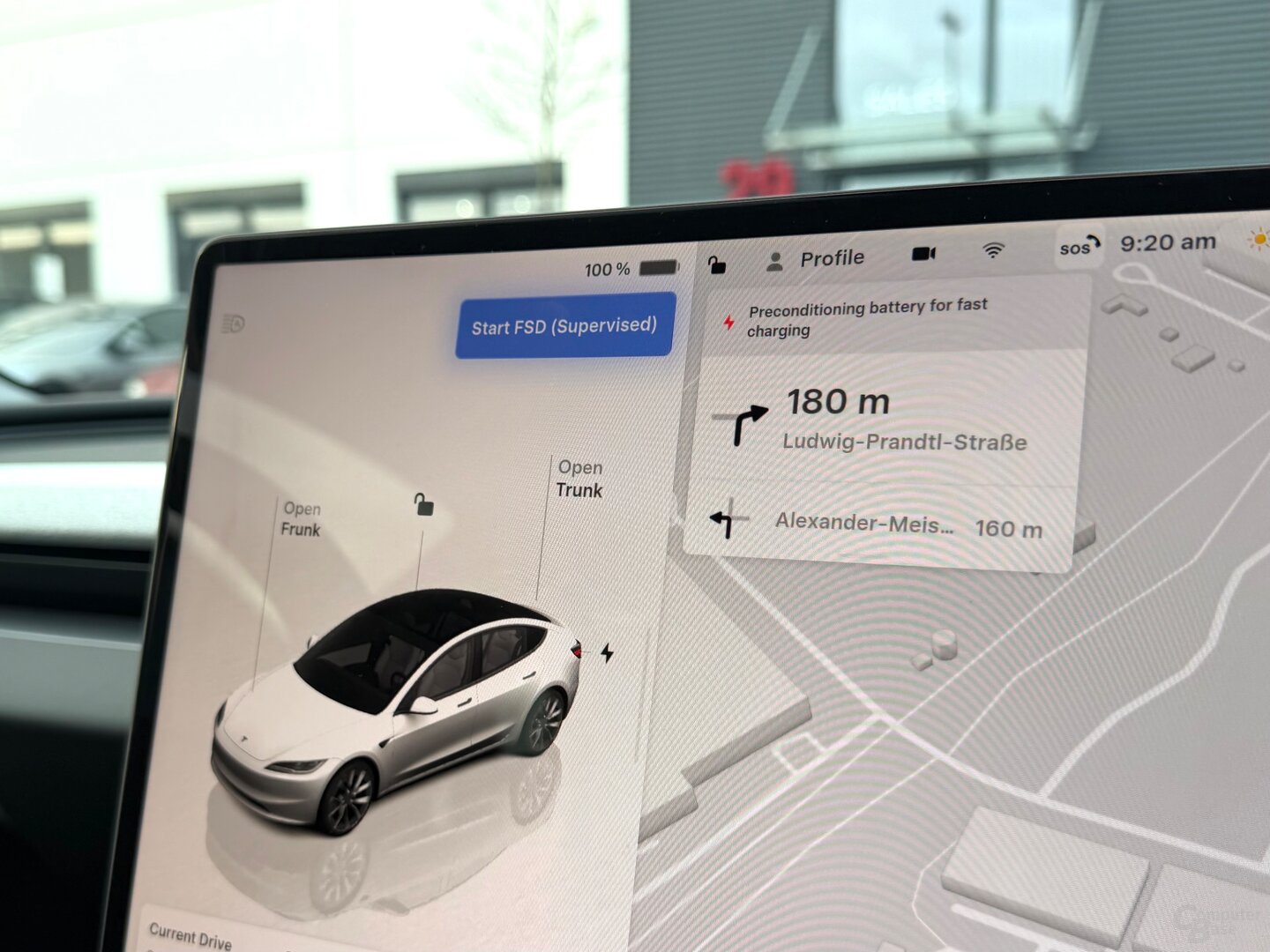

Zunächst einmal startete die FSD-Fahrt direkt vom Parkplatz des Tesla-Centers aus und nicht erst auf öffentlichen Straßen – FSD lässt sich bei aktiver Routenführung über eine entsprechend beschriftete, blaue Schaltfläche auf dem Zentraldisplay starten. Außerdem begann sie mit der Fahrt durch eine enge Ausfahrt, die vorsichtig, aber mit Bravour gemeistert wurde, bevor gleich darauf ein U-Turn um einen Mittelstreifen notwendig war, für den das Model 3 aufgrund eines geparkten Anhängers sogar einmal kurz zurücksetzen musste. Dieser Vorgang lief derart geschmeidig und präzise ab, dass man meine könnte, im Hintergrund hätte ein menschlicher Fahrer das Wendemanöver ausgeführt. Tatsächlich musste der Tesla-Mitarbeiter aber während der gesamten Hin- oder Rückfahrt kein einziges Mal in das Fahrgeschehen eingreifen.

Tesla meistert Stadt, Landstraßen und Autobahn

Im Gegensatz zum Autobahnassistenten von BMW (Level 2+) oder Drive Pilot von Mercedes-Benz (Level 3) ist Teslas FSD nicht auf einen spezifischen Straßentyp limitiert. Das System lässt sich in der Stadt und mit fließendem Übergang auf Landstraßen und Autobahnen nutzen. BMW will ab der zweiten Jahreshälfte 2026 einen City-Assistenten anbieten, der die Geschwindigkeit vor Kurven, Kreisverkehren und Abbiegungen anpasst. Der City-Assistent hilft beim Bremsen an erkannten roten Ampeln und fährt automatisch bei Grün an oder erinnert den Fahrer daran wieder anzufahren.

Bei Tesla funktionierte all das im Rahmen der Testfahrt schon jetzt auf allen Straßentypen. Die Mitfahrt erfolgte vom Tesla-Center in Schönefeld durch die umliegende Stadt, über Bundesstraßen und Autobahnen, und wieder durch die Stadt – sowie umgekehrt zum Tesla-Center. Das Fahrzeug sortierte sich dabei eigenständig in Spuren ein, durchfuhr Kreisel, wartete an roten Ampeln und fuhr bei Grün wieder los, navigierte auf Autobahnauffahrten und sortierte sich rechtzeitig wieder auf Abfahrten ein, ließ Fußgänger über einen Zebrastreifen laufen und parkte eigenständig. Kein einziges Mal war ein manueller Eingriff notwendig.

Vision Only funktioniert (bei gutem Wetter)

Die Probefahrt mit FSD Supervised lief erstaunlich souverän und verdeutlichte, dass Tesla mit dem Vision-Only-Ansatz – was das Endergebnis betrifft – durchaus einiges richtig macht. Zur Wahrheit gehört aber auch, dass im Südosten Berlins die Straßen gut ausgebaut sind, zum Testzeitpunkt wenig Verkehr und gutes, wenn auch kaltes Wetter herrschte, und die Probefahrt bei Tageslicht stattfand. In der Innenstadt Berlins, bei Dunkelheit, bei Regen oder Schnee könnte es schon wieder anders aussehen.

Erfolgreich durch die Baustelle

Eine (zugegebenermaßen übersichtliche) Baustelle meisterte das Fahrzeug hingegen einwandfrei, indem es sich an den gelben Fahrbahnmarkierungen orientierte. Auch an einen anschließenden Spurwechsel für das Rechtsfahrgebot wurde dabei gedacht.

An dem positiven Gesamteindruck der Probefahrt ändern diese theoretischen Wetterszenarien allerdings nichts. Die Fahrt verlief ohne manuelle Eingriffe und zu 99 Prozent fehlerfrei. Der letzte Prozentpunkt? Das nicht perfekt gerade Einparken am Supercharger und ein nach links gesetzter Blinker im Kreisverkehr – ein Überbleibsel eines kurz zuvor erfolgten Abbiegevorgangs. Der Blinker rechts aus dem Kreisel wurde aber korrekt gesetzt, das gilt auch für alle anderen Abbiegemanöver und Spurwechsel.

FSD weicht einem Koffer auf der Straße aus

Die Fahrt endete darüber hinaus mit zwei Höhepunkten. Zum einen wurde zum Abschluss der auf der Straße stehende Koffer einer an der Fußgängerampel wartenden Passantin geschickt umfahren, und zum anderen meisterte das Model 3 abschließend noch eine ziemlich enge Parklücke am Tesla-Center, die zwar breit genug für das Auto, aber kaum noch für die Mitfahrer war.

FSD Supervised überzeugt bei erster Probefahrt

Für Teslas Full Self-Driving (Supervised) lässt sich demnach ein positives und weitaus besseres Fazit ziehen, als es „Vison Only“ und die damit verbundenen Vorurteile zunächst vermuten ließ. Dass andere Autohersteller mit ihren multimodalen Sensoren falsch liegen oder Tesla nur mit Kameras komplett richtig liegt, ist damit allerdings nicht gesagt. Das Endergebnis ist das, was zählt. Zur Testfahrt überzeugte Teslas Lösung auf ganzer Linie.

ComputerBase hat den Termin zur Probefahrt wie jeder interessierte Privatnutzer über das öffentliche Portal gebucht. Ein Kontakt mit der Presseabteilung bestand weder im Vorfeld noch vor Ort.

Dieser Artikel war interessant, hilfreich oder beides? Die Redaktion freut sich über jede Unterstützung durch ComputerBase Pro und deaktivierte Werbeblocker. Mehr zum Thema Anzeigen auf ComputerBase.

Apps & Mobile Entwicklung

Dark Perk Ergo & Dark Perk Sym: Erste Mäuse von be quiet! sind für rechte und beide Hände

be quiet! entlässt zwei High-End-Mäuse für rechte und beide Hände in den Handel. Die beiden schon zur Computex gezeigten Geschwister-Produkte Dark Perk Ergo und Dark Perk Sym starten im Februar mit identischer technischer Basis und ergänzen das noch junge Peripherie-Segment des Unternehmens.

Dass be quiet! Mäuse baut, war im Grunde seit der Einführung von Tastaturen, der Dark Mount und Light Mount (Test), klar. Wer A sagt, muss auch B sagen, beide Geräteklassen gehören bei Herstellern wie zwei Hände eigentlich immer zusammen.

Weniger Silent als sonst

Während die für be quiet! markentypische Silent-Ausrichtung bei den Tastaturen über besondere Taster deutlich hervortritt, werden die Mäuse dezenter auf Ruhe getrimmt. Der Hersteller erklärt in einem Nebensatz lediglich, die verbauten optischen Switches vom Typ Omron D2FP-FN2 würden „ein leises und sanftes Auslösen“ erlauben. Um ausgesprochene Silent-Switches, wie sie etwa Logitech in Büromäusen verbaut, handelt es sich jedoch nicht.

Darüber hinaus verfügen die 55 Gramm schweren Mäuse über einen PixArt-PAW3950-Sensor, dessen Auflösung bei maximal 32.000 dpi liegt. Die Abtastrate erreicht mit maximal 8.000 Hz im kabelgebundenen und kabellosen Modus den üblichen Standard im gehobenen Segment. Kabellos sollen die Mäuse eine Laufzeit von 110 Stunden erreichen. Verwiesen wird in diesem Zusammenhang auf den Mikrocontroller Nordic nRF54H20, der energiesparend agieren soll. Das gilt allerdings nur, wenn das Polling bei 1.000 Hz liegt, Angaben für den Maximalwert macht be quiet! nicht. Normalerweise verringert sich die Ausdauer dann erheblich.

Die fünf Tasten sowie Sensor und Beleuchtung lassen sich entweder über die IO Center Software unter Windows oder plattformunabhängig im Browser konfigurieren. Änderungen werden direkt auf den Mäusen gespeichert.

Preis und Varianten

Im Handel starten Dark Perk Ergo und Dark Perk Sym ab dem 3. Februar, die Preisempfehlung liegt für beide Modelle bei rund 110 Euro. Unterschiede liegen nur in der Form. Die Dark Perk Ergo eignet sich aufgrund einer leichten Ausbuchtung nur für die rechte Hand, die Dark Perk Sym durch ihre symmetrische Form für beide Hände.

Apps & Mobile Entwicklung

Chrome 144: Google schließt schwerwiegende Schwachstelle in Browser

Google hat ein Update für Chrome 144 veröffentlicht, das eine mit hohem Gefahrenpotenzial versehene Sicherheitslücke schließt. Nutzer des Browsers werden dazu aufgerufen, das Update so schnell wie möglich einzuspielen.

Chrome schnellstmöglich aktualisieren

Die mit der neuen Version geschlossene Schwachstelle betrifft erneut die JavaScript-Engine V8 des Chrome-Browsers. Über eine Race Condition können Angreifer mithilfe präparierter Webseiten den Speicher manipulieren, was zu einer sogenannten Heap Corruption, also einer Beschädigung des Speichers, führen kann. Damit lässt sich schadhafter Code in die Anwendung einschleusen und dadurch sensible Daten abgreifen oder sogar das System übernehmen.

Wie üblich stellt Google keine weiteren technischen Details bereit – einerseits, um Nutzern ausreichend Zeit für die Installation des Updates zu geben, andererseits, um Angreifern keine zusätzlichen Informationen zu liefern, die sie für Angriffe nutzen könnten. Google empfiehlt ausdrücklich, die Aktualisierung umgehend durchzuführen.

Für Windows und macOS stehen dafür die Versionen 144.0.7559.96/.97 bereit, Linux-Nutzer erhalten hingegen die bereinigte Version 144.0.7559.96. Für Android wird im Play Store Version 144.0.7559.90 angeboten, während iOS-Nutzer Version 144.0.7559.95 im Apple App Store finden. Browser, die auf Chromium basieren – etwa Microsoft Edge –, dürften das Update erfahrungsgemäß in den kommenden Tagen erhalten.

Ab sofort verfügbar

Die neue Chrome-Ausgabe kann bei Desktop-Systemen über die integrierte Update-Funktion eingespielt werden. Alternativ lässt sich die korrigierte Fassung wie gewohnt über den Link am Ende dieser Meldung bequem aus dem Download-Bereich von ComputerBase beziehen.

Downloads

-

2,9 Sterne

Google Chrome ist der meistgenutzte Browser, bietet aber keinen nennenswerten Tracking-Schutz.

- Version 144.0.7559.96/.97 Deutsch

- Version 145.0.7632.18 Beta Deutsch

- Version 109.0.5414.120 Deutsch

Apps & Mobile Entwicklung

BGM-G31-GPU: „Big Battlemage“ kommt, aber nicht als Arc für Spieler?

Anfang 2025 schon tot geglaubt, schien Intel die Entwicklung einer Grafikkarte mit der großen Battlemage-GPU „BMG-G31“ im weiteren Jahresverlauf wieder aufgenommen zu haben – und kokettierte im September auf Social Media selbst mit einer „Arc B770“. Den Auftakt könnte jetzt aber B70 Pro und B65 Pro machen. Und dann?

Hinweise auf B70 Pro und B65 Pro

Leaker Jayhihn hat auf X die Bezeichnung „B70 Pro“ fallen lassen. Von VideoCardz darauf angesprochen, ob die „G31“-GPU dahinter steckt, lautete seine Antwort „ja“. 32 GB Speicher soll die Grafikkarte bieten.

Der ebenfalls für seine Leak bekannte Account Haze ergänzte: Eine B65 Pro kommt auch.

Startet „Big Battlemage“ also mit den bei Battlemage erst mit deutlicher Verzögerung nachgeschobenen Pro-Modellen?

Kommt Gaming überhaupt noch?

Dass die beiden Pro-Modelle jetzt den Anfang in der Gerüchteküche machen, muss nicht bedeuten, dass Intel mit größeren Arc-B-Series-Grafikkarten erst später oder gar nicht mehr plant. Doch mit Blick auf die explodierenden Speicherpreise dürfte sich die für Intel ohnehin schon komplizierte Platzierung größerer Gaming-Grafikkarten noch weiter verkompliziert haben: Viel Speicher für relativ wenig Geld, so wie es Arc bisher geliefert hat, werden von Tag zu Tag utopischer. Zur CES waren neue Desktop-Grafikkarten – egal ob Pro oder Gaming – kein Thema.

Auf einer Intel Arc Pro für professionelle (KI-)Anwendungen sind die höheren Kosten für viel Speicher hingegen besser zu verstecken respektive auf das Preisschild draufzuschlagen.

-

Ja

-

Nein

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenKommandozeile adé: Praktische, grafische Git-Verwaltung für den Mac

-

UX/UI & Webdesignvor 3 Monaten

UX/UI & Webdesignvor 3 MonatenArndt Benedikt rebranded GreatVita › PAGE online

-

Künstliche Intelligenzvor 3 Wochen

Künstliche Intelligenzvor 3 WochenSchnelles Boot statt Bus und Bahn: Was sich von London und New York lernen lässt

-

Entwicklung & Codevor 1 Monat

Entwicklung & Codevor 1 MonatKommentar: Anthropic verschenkt MCP – mit fragwürdigen Hintertüren

-

Künstliche Intelligenzvor 3 Monaten

Künstliche Intelligenzvor 3 MonatenGoogle „Broadwing“: 400-MW-Gaskraftwerk speichert CO₂ tief unter der Erde

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenHuawei Mate 80 Pro Max: Tandem-OLED mit 8.000 cd/m² für das Flaggschiff-Smartphone

-

Social Mediavor 1 Monat

Social Mediavor 1 MonatDie meistgehörten Gastfolgen 2025 im Feed & Fudder Podcast – Social Media, Recruiting und Karriere-Insights

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenFast 5 GB pro mm²: Sandisk und Kioxia kommen mit höchster Bitdichte zum ISSCC