Künstliche Intelligenz

Über den Chat hinaus: Mit LLMs echte Nutzerprobleme lösen

Seit dem Erscheinen von ChatGPT ist das Chat-Fenster das zentrale User-Interface für die Interaktion mit künstlicher Intelligenz. Doch ist ein Chat tatsächlich die optimale Möglichkeit zur Interaktion – oder gibt es möglicherweise besser geeignete Wege, KI in Anwendungen zu integrieren?

Sascha Lehmann war mit seinem ersten PC schon klar, in welche Richtung die Reise geht. Durch Desktop- und Backend-Entwicklung im .NET-Umfeld fand er über die Jahre hinweg zu seiner wahren Leidenschaft, der Webentwicklung. Als Experte im Angular- und im UI/UX-Umfeld hilft er bei der Thinktecture AG in Karlsruhe tagtäglich Kunden bei ihren Herausforderungen und Vorhaben.

In den vergangenen Jahren haben KI-Werkzeuge die Welt im Sturm erobert. KI-Funktionen hielten Einzug in alltäglich genutzte Software – sei es in Entwicklungsumgebungen (IDEs), Office-Programmen oder sogar bei der Erstellung der Steuererklärung. Und fast überall kann man mit der Software chatten. Doch warum eigentlich?

Warum Chat als Interface so gut funktioniert

Die Stärken großer Sprachmodelle liegen insbesondere darin, unterschiedlichste Arten von Informationen zu verarbeiten und in natürlicher Sprache mit Nutzerinnen und Nutzern zu kommunizieren. Dafür benötigen sie Eingaben – ebenfalls in natürlicher Sprache. Was läge also näher, als per Texteingabe mit ihnen zu interagieren?

Auch aus Sicht der User-Experience (UX) bietet sich der Chat als Interface zunächst an. Nahezu jede und jeder kennt dieses mentale Modell – also die grundsätzliche Funktionsweise und das Erscheinungsbild eines Chatfensters – und kann es intuitiv nutzen, ohne vorherige Schulung. Gerade diese Niedrigschwelligkeit war einer der entscheidenden Faktoren für den durchschlagenden Erfolg von ChatGPT und vergleichbaren Anwendungen.

Mehrwert statt Selbstzweck: Was gute KI-Features ausmacht

Bei genauerer Betrachtung kann das Interaktionsmodell „Chat“ jedoch nicht ohne Weiteres ebenso erfolgreich auf andere Einsatzbereiche übertragen werden. So hilfreich es sein kann, beliebige Fragestellungen in einem offenen Chat mit einer KI zu diskutieren, umso schneller verliert dieses Modell seinen Reiz, sobald es in einem klar definierten Anwendungskontext zum Einsatz kommt. Der Rahmen ist dort meist deutlich enger gesteckt, was neue Herausforderungen aufwirft – beispielsweise:

- Wie kann ein Chat sinnvoll in den Anwendungskontext integriert werden?

- Welchen konkreten Mehrwert bietet die KI-Funktion gegenüber etablierten Arbeitsabläufen?

- Wie können fachspezifische Informationen kontextbezogen eingebunden werden?

Ohne gezielte Unterstützung – etwa Hinweise zu möglichen Interaktionen oder zum verfügbaren Domänenwissen und dessen Nutzung im Chat – fühlen sich viele Nutzerinnen und Nutzer schnell überfordert. Bleiben erste Interaktionen zudem erfolglos, führt das häufig zu Frustration – und das beworbene KI-Feature wird nur noch zögerlich oder gar nicht mehr verwendet. Es entsteht der Eindruck, die neue Technologie sei lediglich um ihrer selbst willen integriert worden.

Ein solches Nutzungserlebnis gilt es unbedingt zu vermeiden. KI-Funktionen – wie auch alle anderen Features – müssen einen klaren Mehrwert bieten. Sei es durch eine Erweiterung des Funktionsumfangs oder durch die Vereinfachung zuvor mühsamer Aufgaben.

UX-Patterns gegen kognitive Überforderung

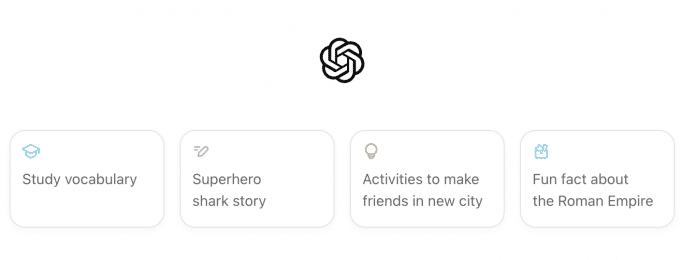

Ein blanker Chat erzeugt – ähnlich wie die berüchtigte leere Seite beim Schreiben einer Hausarbeit – eine zu hohe kognitive Last, also eine Art Überforderungs- oder Lähmungszustand. Um dem entgegenzuwirken, können Vorschläge (Suggestions), hilfreich sein: kleine Container mit konkreten Prompt-Hinweisen.

„Vorschlagskarten“ (hier für Chat-GPT) helfen, die anfängliche Überforderung zu reduzieren und Interaktionshinweise zu geben.

(Bild: Shape of AI)

Diese Suggestions sind Teil einer Sammlung von UX-Patterns (Shape of AI) rund um den Einsatz von KI- und Chat-Integrationen. Da künstliche Intelligenz nach wie vor ein junges Themenfeld ist, werden in den kommenden Jahren zunehmend weitere dieser Gestaltungsmuster entstehen, auf die Entwicklerinnen und Entwickler bei der Konzeption und Entwicklung zurückgreifen können. Dennoch empfiehlt es sich, bereits heute solche Patterns zu nutzen, um Usern einen einfachen und intuitiven Einstieg zu ermöglichen.

Tu, was ich will – nicht, was ich sage

Die kognitive Last ist nicht die einzige Schwachstelle von Chat-basierten Interfaces. Bei längeren Konversationen kann es dazu kommen, dass das Kontextfenster – sozusagen das Kurzzeitgedächtnis des LLM, um Informationen der Konversation zu halten – des aktuell verwendeten Sprachmodells ausgeschöpft ist. In solchen Fällen müssen User auf einen neuen Chat ausweichen. Da LLMs jedoch über kein dauerhaftes Gedächtnis verfügen, ist es notwendig, bei diesem Wechsel eine Zusammenfassung des bisher Gesagten mitzugeben – nur so kann an vorherige Ergebnisse angeknüpft werden.

Zudem neigen LLMs in Konversationen gelegentlich zu Halluzinationen oder verlieren sich bei unpräzisen Eingaben in einem ineffizienten Hin und Her. Besonders problematisch wird das, wenn die Nutzerin oder der Nutzer bereits eine klare Vorstellung vom gewünschten Ergebnis hat. Die Herausforderung liegt darin, die eigene Intention so klar zu formulieren, dass das Modell sie korrekt interpretiert – ganz nach dem Motto: „Tu, was ich will – nicht, was ich sage.“

Formulare automatisch verstehen und ausfüllen

Gibt es also jenseits des klassischen Chat-Interfaces klügere Wege, Nutzerinnen und Nutzern KI-Funktionen zugänglich zu machen – möglichst in kleinen, leicht verdaulichen Einheiten, sodass Überforderung gar nicht erst entsteht?

Ein genauer Blick auf die Stärken großer Sprachmodelle zeigt Fähigkeiten, die im Alltag besonders hilfreich sein können:

- Verständnis und Verarbeitung natürlicher Sprache

- umfangreiches Weltwissen

- vielfältige Einsatzgebiete und enorme Anpassbarkeit

- Multimodalität – Verarbeitung von Text-, Audio- und Bilddaten (ohne Modellwechsel)

- Echtzeitsprachverarbeitung

- Erkennung und Analyse von Patterns

Immer wieder gibt es Anwendungsszenarien, in denen Daten aus Dokumenten, Bildern oder Videos zu extrahieren und in strukturierter Form weiterzuverarbeiten sind – etwa bei Formularen. Das Ausfüllen langer Formulare zählt in der Regel nicht zu den beliebtesten Aufgaben im Alltag.

Gerade hier besteht deutliches Potenzial zur Verbesserung der User-Experience. Doch wie könnte ein optimierter „Befüllungs-Workflow“ konkret aussehen?

Von Text zu JSON: Daten intelligent befüllen

Für die Arbeit mit Formularen stehen im Web und in etablierten Frameworks umfangreiche Schnittstellen (Application Programming Interfaces, APIs) zur Verfügung. Die zugrunde liegende Struktur eines Formulars wird dabei häufig in Form eines JSON-Objekts (JavaScript Object Notation) definiert.

Das Listing zeigt eine exemplarische Deklaration einer FormGroup (inklusive Validatoren) innerhalb einer Angular-Anwendung.

personalData: this.fb.group({

firstName: ['', Validators.required],

lastName: ['', Validators.required],

street: ['', Validators.required],

zipCode: ['', Validators.required],

location: ['', Validators.required],

insuranceId: ['', Validators.required],

dateOfBirth: [null as Date | null, Validators.required],

telephone: ['', Validators.required],

email: ['', [Validators.required, Validators.email]],

licensePlate: ['', Validators.required],

}),

Dieses JSON-Objekt stellt den ersten Baustein des Workflows dar und definiert zugleich die Zielstruktur, in die das System die extrahierten Informationen überführt. Den zweiten Baustein bilden die Quelldaten in Form von Text, Bildern oder Audio. Zur vereinfachten Darstellung liegen sie im folgenden Szenario in Textform vor und sollen über die Zwischenablage in das System übertragen werden.

Bleibt noch ein dritter Aspekt: Entwicklerinnen und Entwickler müssen das Sprachmodell instruieren – sie müssen ihm eine präzise Aufgabenbeschreibung geben, um den gewünschten Verarbeitungsschritt korrekt durchzuführen. Diese Instruktion erfolgt im Hintergrund, vor dem User versteckt.

Versteckte Prompts: KI steuern ohne Chatfenster

Auch wenn Entwicklerinnen und Entwickler bewusst auf ein Chat-Interface verzichten, arbeiten Sprachmodelle weiterhin auf Basis von Instruktionen in natürlicher Sprache. Um Usern die Formulierungs- und Eingrenzungsarbeit abzunehmen, können diese Anweisungen vorab als sogenannte System-Messages oder System-Prompts im Programmcode hinterlegt werden.

Der Vorteil dieses Ansatzes liegt darin, dass die Befehle standardisiert und in konsistenter Qualität an das LLM übermittelt werden können. Zudem ist es möglich, diese Prompts mit Guards zu versehen – ergänzenden Anweisungen, die Halluzinationen vorbeugen oder potenziellem Missbrauch entgegenwirken sollen.

Nachfolgend eine exemplarische Darstellung eines System Prompt mit einer gezielten Aufgabe für das LLM:

Each response line must follow this format:

FIELD identifier^^^value

Provide a response consisting only of the following lines and values derived from USER_DATA:

${fieldString}END_RESPONSE

Do not explain how the values are determined.

For fields without corresponding information in USER_DATA, use the value NO_DATA.

For fields of type number, use only digits and an optional decimal separator.

In modernen Frontend-Applikationen ist es üblich, dass Schnittstellen ihre Antworten im JSON-Format liefern, da diese Datenstruktur leicht weiterverarbeitet werden kann.

Für möglichst präzise und verlässliche Ergebnisse kann die erwartete Zielstruktur mithilfe des JSON Mode definiert werden – in Form eines JSON-Schemas. Es beschreibt die Felder nicht nur strukturell, sondern auch mit genauen Typinformationen. Das erspart ausführliche textuelle Erläuterungen und erleichtert die Verarbeitung der Ergebnisse im Frontend.

Um Typsicherheit in der Anwendung sicherzustellen, kommt häufig Zod zum Einsatz – eine auf TypeScript ausgerichtete Validierungsbibliothek, mit der Datenstrukturen, von einfachen Strings bis hin zu komplexen geschachtelten Objekten, deklarativ definiert und zuverlässig geprüft werden können.

Das folgende Listing von OpenAI zeigt einen exemplarischen Aufruf der OpenAI-API, um Daten in einem bestimmten JSON Format zu extrahieren.

import OpenAI from "openai";

import { zodTextFormat } from "openai/helpers/zod";

import { z } from "zod";

const openai = new OpenAI();

// JSON-Schema-Definition mithilfe von Zod

const CalendarEvent = z.object({

name: z.string(),

date: z.string(),

participants: z.array(z.string()),

});

const response = await openai.responses.parse({

model: "gpt-4o-2024-08-06",

input: [

{ role: "system", content: "Extract the event information." },

{

role: "user",

content: "Alice and Bob are going to a science fair on Friday.",

},

],

text: {

format: zodTextFormat(CalendarEvent, "event"),

},

});

const event = response.output_parsed;

So kommunizieren Anwendungen mit dem LLM

Um System-Prompts und Quelldaten an ein LLM zu übermitteln, stehen je nach Anbieter verschiedene SDKs (Software Development Kits) zur Verfügung. Das obige Listing zeigt beispielsweise die Verwendung des OpenAI-SDK. Weitere Beispiele führender Anbieter sind Anthropic und Google. Sie bieten jeweils umfangreiche Funktionen, hohe Performance und eine benutzerfreundliche Developer-Experience, die den Einsatz der SDKs erleichtert.

Selbstverständlich ist die Nutzung von KI-Modellen nicht auf webbasierte Angebote großer Anbieter beschränkt. Wer mit kleineren Modellen für seine Aufgaben auskommt, kann ebenso lokal laufende Modelle verwenden oder auf im Browser integrierte Modelle wie WebLLM zurückgreifen.

Nach der erfolgreichen Implementierung und Abstraktion der SDK-Aufrufe genügt bereits ein Dreizeiler für das vollständige Parsing.

Es folgt eine exemplarische Darstellung des Ablaufs eines Extraktionsvorgangs anhand einer in Angular definierten FormGroup:

/* User Message – Datenquelle, aus der Daten zum Befüllen des Formulars extrahiert werden sollen. Diese werden in die Zwischenablage kopiert

Max Mustermann

77777 Musterstadt

Kfz-Kennzeichen: KA-SL-1234

Versicherungsnummer: VL-123456

*/

// Angular FormGroup zum Erfassen persönlicher Daten

personalData: this.fb.group({

firstName: ['', Validators.required],

lastName: ['', Validators.required],

street: ['', Validators.required],

zipCode: ['', Validators.required],

location: ['', Validators.required],

insuranceId: ['', Validators.required],

dateOfBirth: [null as Date | null, Validators.required],

telephone: ['', Validators.required],

email: ['', [Validators.required, Validators.email]],

licensePlate: ['', Validators.required],

}),

// JSON-Schema, das mit Zod anhand der FormGroup erstellt wurde

{

"firstName": {

"type": "string"

},

"lastName": {

"type": "string"

},

"street": {

"type": "string"

},

"zipCode": {

"type": "string"

},

"location": {

"type": "string"

},

"insuranceId": {

"type": "string"

},

"dateOfBirth": {

"type": "object"

},

"telephone": {

"type": "string"

},

"email": {

"type": "string"

},

"licensePlate": {

"type": "string"

}

}

// Antwort des LLM

[

{

"key": "firstName",

"value": "Max"

},

{

"key": "lastName",

"value": "Mustermann"

},

{

"key": "location",

"value": "Musterstadt"

},

{

"key": "zipCode",

"value": "77777"

},

{

"key": "licensePlate",

"value": "KA-SL-1234"

},

{

"key": "insuranceId",

"value": "VL-123456"

}

]

// Befüllen des Formulars mit den Ergebnissen (hier eine Angular FormGroup --> personalData)

try {

const text = await navigator.clipboard.readText();

const completions = await this.openAiBackend.getCompletions(fields, text);

completions.forEach(({ key, value }) => this.personalData.get(key)?.setValue(value));

} catch (err) {

console.error(err);

}

Aufwendige Ausfüllarbeiten gehören von nun an der Vergangenheit an und können dank geschickt eingesetzter KI-Unterstützung mühelos erledigt werden.

Dieses Beispiel zeigt einen ausgeführten Extraktionsvorgang: Zunächst wird der Text mit Informationen in die Zwischenablage kopiert, dann der Extraktionsvorgang gestartet, und schließlich stehen automatisch befüllte Formularfelder anhand der Textinformation bereit.

Darstellung des Ablaufs eines Extraktionsvorgangs aus Sicht der User (in drei Schritten, von oben nach unten).

Mehr Transparenz bei KI-generierten Inhalten

Diese Integration allein verbessert die UX enorm. Bei genauerer Betrachtung fallen aus UX-Designer-Sicht allerdings noch weitere Möglichkeiten auf:

Wie steht es etwa um die Nachvollziehbarkeit? Aktuell werden anhand des übermittelten Textes oder Bildes die Felder des Formulars automatisch befüllt. Zudem kann der Nutzer oder die Nutzerin das Formular nach Belieben selbst anpassen und editieren. Das mag in den meisten Fällen ausreichend und unproblematisch sein. Doch in bestimmten Kontexten reicht das allein nicht aus – beispielsweise bei rechtlich verbindlichen Themen wie Versicherungen oder Banking. Hier muss unter Umständen ersichtlich sein, welche Felder von einem Menschen und welche mithilfe von KI-Unterstützung befüllt wurden. Aus UX-Gründen ist es außerdem sinnvoll, Nutzern transparent zu vermitteln, wie einzelne Feldwerte zustande gekommen sind.

Nachvollziehbarkeit sichtbar machen

Ein Blick auf die großen Player zeigt: Wenn es um die Visualisierung von KI-generierten Inhalten geht, kommen oftmals Farbverläufe, Leucht- und Glitzereffekte zum Einsatz. Die folgenden Beispiele zeigen die visuelle Gestaltung von KI-Inhalten anhand der Designsprache von Apple und Google.

Beispiele für die Designsprachen von Apple (oben) und Google (unten) in Bezug auf deren AI-Produkte.

Warum also nicht dieses Pattern aufgreifen und für eigene Integrationen nutzen? Die großen Anbieter verfügen über UI/UX-Research-Budgets, von denen kleinere Unternehmen nur träumen können. Es liegt nahe, sich hier inspirieren zu lassen, zumal die hohe Reichweite bereits neue visuelle Standards prägt – Nutzer sind mit derartigen Darstellungen zunehmend vertraut.

Eine exemplarische Umsetzung im gezeigten Formularszenario könnte darin bestehen, automatisch befüllte Felder mit einem leuchtenden Rahmen (Glow-Effekt) zu versehen. Diese einfache Maßnahme schafft eine klare visuelle Unterscheidbarkeit – und verbessert gleichzeitig die User-Experience.

Automatisch befüllte Felder sind durch einen leuchtenden Rahmen (Glow-Effekt) hervorgehoben.

Um die Nachvollziehbarkeit weiter zu verbessern, können Entwickler eine History-Funktion einbauen: Sie zeigt, welche automatischen Extraktionen wann passiert sind – inklusive der genutzten Quellen (Texte, Sprache oder Bilder). So haben User jederzeit den Überblick und können bei Bedarf einfach per Undo/Redo zu einem früheren Zustand zurückspringen.

Künstliche Intelligenz

Apples Dienstechef: Deshalb wurde TV+ entplusst

Hinter Apples eher verwirrenden Umbenennung des Videostreamingdienstes in Apple TV steckt keine tiefere Strategie. Das räumt der mächtige Dienstechef des Konzerns, Eddy Cue, in einem Podcast-Interview ein. In der jüngsten „The Town“-Ausgabe, einer Show, die Apple-Music-Konkurrent Spotify bezahlt und die sich um die wirtschaftlichen Aspekte Hollywoods dreht, sagte der Manager, man habe „einfach so“ entschieden, aus Apple TV+ schlicht Apple TV zu machen.

Weiterlesen nach der Anzeige

Bei Apple ließen alle das Plus weg

Intern hätten „alle“ Apple TV+ bereits nur Apple TV genannt. „Und dann haben wir gesagt, angesichts der Position, in der wir heute sind: Es ist eine prima Zeit, das jetzt zu tun.“ Cue glaubt zudem nicht, dass es zu Verwechslungen mit dem Hardware-Produkt Apple TV kommen wird. „Unsere Hardware heißt Apple TV 4K für Ihren Fernseher. Ich denke, das ist gut so und die App heißt Apple TV.“ Apple TV werde sie auch in Third-Party-Geräten – etwa Fernsehern und Streamingboxen – genannt, „also denke ich nicht, dass das überhaupt ein Problem ist“.

Dass die Apple-TV-App allerdings nicht nur Zugriff auf Apples eigenen Streamingdienst gibt, sondern auch andere Angebote von Dritten umfasst, erwähnte Cue nicht. Doch seiner Ansicht nach handelt Apple nun konsistent. Man habe das „+“ bisher verwendet, weil auch andere kostenpflichtige Dienste wie iCloud+ und News+ im Angebot sind. „Aber bei denen haben wir einen kostenlosen Dienst und dann eine Bezahlversion.“

Apple TV allgemein etabliert

Cue geht auch davon aus, dass die Identität von Apple TV als Streamingdienst nun allgemein etabliert ist. Auch Kunden lassen seiner Ansicht nach das Plus weg. Nun muss allerdings noch Apple selbst tätig werden: Auf der Website wurde noch nicht an allen Stellen angepasst.

Dass die Apple-TV-Hardware nun umbenannt wird – aktuell wird auf neue Modelle des Streamingkästchens gewartet – ist laut Cues Aussagen unwahrscheinlich, der Konzern dürfte nun aber das „4K“ stärker herausstellen. Interessanterweise lässt das die Kundschaft normalerweise weg, spricht bei der Multimediabox schlicht von „Apple TV“. Und genau das ist ja nun der Streamingdienst. Die Verwirrung dürfte also durchaus noch etwas weitergehen. Das ist für Apple allerdings nicht völlig unnormal: Ein zentrales Beispiel wäre eine Benennung wie die des MacBook Pro M4 Pro.

Weiterlesen nach der Anzeige

(bsc)

Künstliche Intelligenz

Mikroelektronik-Strategie: Deutschland strebt nach Chip-Dominanz

Die schwarz-rote Bundesregierung hat sich eine neue Strategie zur Mikroelektronik gegeben. Nach dem Debakel um die gescheiterte Intel-Ansiedlung in Magdeburg und die Umverteilung eingeplanter Chipmilliarden in andere Bereiche will die Bundesregierung Deutschlands Rolle als Chipstandort verbessern.

Weiterlesen nach der Anzeige

Das Bundeskabinett verabschiedete daher eine Mikroelektronik-Strategie, die nach den großen, aber zum Großteil unerfüllt gebliebenen Plänen der Ampel vergleichsweise klein wirkt und sich auf Schlüsselbereiche konzentriert. Bundesforschungsministerin Dorothee Bär (CSU) sagte: „Wir wollen Deutschland zum europäischen Zentrum für Chipdesign machen und gezielt den Transfer von der Wissenschaft in die Wirtschaft stärken.“ Die Bundeswirtschaftsministerin Katherina Reiche (CDU) sieht als Ziel, „dass Deutschland nicht nur Anwender, sondern auch Entwickler und Hersteller bleibt“.

Transfer soll beschleunigt werden

Als Maßnahmen sieht die Strategie vor allem eine Stärkung der Chipdesign-Tätigkeiten vor, außerdem soll der Transfer aus der Halbleiter- und Mikroelektronikforschung hin zur Fertigung beschleunigt werden. So sollen etwa Pilotproduktionslinien für Quanten-Chips aufgebaut werden. Neben einer besseren Fachkräftegewinnung und anderen altbekannten Zielbeschreibungen hat die Bundesregierung vor allem die Finanzierungsseite der kapitalintensiven Branche im Blick: Hier sollen Vereinfachungen stattfinden, um etwa private Kapitalgeber zu Investitionen zu bewegen. Kleine Unternehmen sollen einfacher staatlich gestützte Finanzierungen in Anspruch nehmen können.

Passend dazu veröffentlichte der Branchenverband Bitkom eine Umfrage, laut der 92 Prozent der Unternehmen die Gefahr einer Eskalation zwischen der Volksrepublik China und Taiwans mit Sorgen sehen würden. Taiwan spielt eine wesentliche Rolle im globalen Chip-Ökosystem. Die Ausdifferenzierung der Chipmärkte sieht die Bundesregierung dabei als Chance. Der Bedarf solle möglichst aus EU-Produktion gedeckt werden, heißt es in dem Papier: „Einen entscheidenden Beitrag leisten Maßnahmen, die sich auf Schlüsselpositionen in der globalen Halbleiterwertschöpfung (vom Chipdesign bis zur Fertigung) konzentrieren und Abhängigkeiten in wichtigen Sektoren (Automobil, Kommunikation, Digitalisierung, Medizintechnik, KI, Verteidigung) verringern.“

Deutschland gehört dabei zu den EU-Staaten, die zuletzt öffentlich Abstand vom bisherigen und von Fachleuten von vornherein als unrealistisch eingeschätzten EU-Ziel „20 Prozent Marktanteil 2030“ genommen haben, wie es im European Chips Act hinterlegt war. Das zentrale rechtliche Förderinstrument für die Förderung von Chipfabriken und Halbleiter-Ökosystem soll 2026 überarbeitet werden – die Mikroelektronikstrategie der Bundesregierung nimmt hier die Prioritäten Berlins vorweg.

(dahe)

Künstliche Intelligenz

DLR-Studie analysiert 118 Drohnenstörfälle an Flughäfen

Nichts geht mehr: Flugzeuge werden umgeleitet, Flüge werden gestrichen, Warteschlangen an den Terminals. Wird ein unbemanntes Fluggerät (Unmanned Aerial Vehicle) in der Nähe eines Flugplatzes gesichtet, wird im schlimmsten Fall der Flugverkehr unterbrochen. Das Deutsche Zentrum für Luft- und Raumfahrt (DLR) hat die Auswirkung solcher Drohnenflüge an deutschen Flughäfen untersucht.

Weiterlesen nach der Anzeige

Für die Studie hat das Luftfahrt-Bundesamt (LBA) dem DLR Daten zu den Störfällen im vergangenen Jahr bereitgestellt. Danach wurden dem LBA 118 Störfälle gemeldet. Darunter seien neun, bei denen der Flugverkehr unterbrochen wurde, teilte das DLR mit. Der wirtschaftliche Schaden für diese neun Fälle lag demnach bei rund einer halben Million Euro.

Im Schnitt dauerten die Vollsperrungen 32 Minuten. Nach einer Drohnensichtung wurde der Flugverkehr jedoch für mehr als eine Stunde unterbrochen. Wegen der engen Taktung der Flüge kam es dabei zu einer Vielzahl von Verspätungen und entsprechenden Folgeeffekten im Streckennetz. In 56 Fällen kam es zu kleineren Beeinträchtigungen. Dazu gehörte etwa die Sperrung einzelner Pisten, die wiederum eine Änderung der Betriebsrichtung nach sich ziehen konnte.

Wirtschaftlicher Schaden für Fluggesellschaften

Leidtragende der Vorfälle waren die Fluggesellschaften, denen durch die Sperrungen wirtschaftliche Schäden entstanden: In zwei Fällen mussten Flugzeuge nach mehreren Warteschleifen über dem Zielflughafen auf einem Ausweichflughafen landen.

Diese Betriebsstörungen verursachten zusätzliche Kosten, etwa durch erhöhten Treibstoffverbrauch wegen längerer Flugzeiten, zusätzliche Landegebühren und Aufwendungen für Passagierverpflegung nach EU-Vorgaben. Schließlich seien Personal und Fluggerät höheren Belastungen ausgesetzt gewesen. Flugausfälle gab es aufgrund der Drohnenvorfälle nicht. Deshalb verzeichneten die Flughäfen auch keine nachweisbaren wirtschaftlichen Schäden.

„Auch wenn die wirtschaftlichen Auswirkungen der 2024 dokumentierten Fälle in Deutschland insgesamt begrenzt blieben, zeigen die DLR-Analysen, dass bereits vergleichsweise kurze Betriebseinschränkungen durch die starke Vernetzung des Luftverkehrssystems umfangreiche Folgewirkungen im Luftverkehr, operative Mehraufwände und wirtschaftliche Risiken nach sich ziehen können“, sagte Florian Linke, kommissarischer Direktor des DLR-Instituts für Luftverkehr. „Dies gilt insbesondere bei Sperrungen ab etwa einer Stunde, da bei solchen die Pufferkapazitäten des Lufttransportsystems aufgebraucht sind, was zu einem sprunghaften Ansteigen der Kosten führen kann.“

Weiterlesen nach der Anzeige

Drohnen verursachen Flughafensperrungen

Anfang Oktober fielen in München nach einer Drohnensichtung zahlreiche Flüge aus, 3000 Passagiere waren davon betroffen. In Dänemark und Norwegen gab es im September mehrere Drohnenvorfälle, die teilweise zu Flughafenschließungen führten. Der bedeutsamste Vorfall ereignete sich im Dezember 2018, als der Flughafen London-Gatwick 33 Stunden gesperrt blieb. Der Schaden betrug etwa 100 Millionen Euro.

Die Drohnenvorfälle verursachten jedoch nicht nur wirtschaftliche Schäden, sagte DLR-Chefin Anke Kaysser-Pyzalla. „Zudem bleiben Fragen der Sicherheit eine zentrale Herausforderung, die zusätzliche Investitionen erfordern.“

Ein Schluss, den das DLR aus der Studie zieht, ist die Notwendigkeit, Drohnensichtungen an Flughäfen genauer zu dokumentieren. Derzeit würden sie „im deutschen Luftraum mit uneinheitlicher Datenqualität“ erfasst. Durch eine präzisere Dokumentation ließen sich sich operative Folgen, wirtschaftliche Auswirkungen und Risiken frühzeitig erkennen. „Daraus resultierend können geeignete Maßnahmen abgeleitet werden“, sagte Kaysser-Pyzalla.

(wpl)

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenAdobe Firefly Boards › PAGE online

-

Social Mediavor 2 Monaten

Social Mediavor 2 MonatenRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

UX/UI & Webdesignvor 1 Monat

UX/UI & Webdesignvor 1 MonatFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online

-

Apps & Mobile Entwicklungvor 3 Monaten

Apps & Mobile Entwicklungvor 3 MonatenFirefox-Update 141.0: KI-gestützte Tab‑Gruppen und Einheitenumrechner kommen

-

Online Marketing & SEOvor 3 Monaten

Online Marketing & SEOvor 3 MonatenSo baut Googles NotebookLM aus deinen Notizen KI‑Diashows