Apps & Mobile Entwicklung

Was er kann – und was noch längst nicht

„Hallo ChatGPT, nutze den Agentenmodus und schreib mir einen Testbericht über den neuen Agentenmodus von ChatGPT“ – so oder so ähnlich könnte das vielleicht bald klingen, wenn ein Tech-Journalist einen Testbericht verfassen muss. Aber klappt das aktuell auch schon? Vermutlich nicht, da ich mich hier selbst mit dem Text abrackere. Aber dennoch soll der Agent aus dem Hause OpenAI schon einige interessante Tricks zu bieten haben.

Ich hab mich also mal ein wenig mit der Materie auseinandergesetzt und verrate Euch jetzt, was Ihr mit dem Agentenmodus bereits machen könnt – und was noch nicht. Für eine ausführlichere Erklärung zum Agentenmodus innerhalb von ChatGPT klickt einfach auf den Link. Dort habe ich mich nämlich an diesen Agentenmodus herangetastet.

Hier noch einmal das Allerwichtigste kurz zusammengefasst:

- Der Agentenmodus steht derzeit nur den Usern zur Verfügung, die mindestens das Plus-Abo für 23 Peitschen monatlich nutzen.

- Außerdem befindet sich der Agent noch in einem sehr frühen Stadium. Selbst OpenAI weist ausdrücklich darauf hin, dass er noch fehlerhaft ist.

- Der Agent beantwortet nicht nur Fragen, sondern recherchiert und erstellt selbstständig Inhalte, organisiert Daten oder nimmt Buchungen vor.

- Tools: Im Agentenmodus kann ChatGPT auf Werkzeuge wie einen Browser, einen Code Interpreter (Python), eine Dateiverwaltung und externe Dienste oder Plugins zugreifen.

ChatGPT Agentenmodus im Test

Experiment 1: Neue Hosen kaufen

Vor welche Aufgaben stelle ich ChatGPT nun? Ich lasse es leicht angehen. Links neben der Eingabezeile tippe ich auf die Tool-Box. Statt „Bild erstellen“ oder „Deep Research“ wähle ich also den Agentenmodus aus und es kann losgehen: Ich brauche neue Hosen. Also geht der Auftrag an meinen neuen Agenten: Informiere Dich über die Trends des Jahres, und bestell mir zwei Hosen in angesagten Farben. Maße: W38 / L32. Und ja, ich bin deutlich voluminöser, aber 1. wollte ich nicht, dass ChatGPT weiß, wie fett ich wirklich bin und 2. wollte ich eine Hosengröße nehmen, die man überall regulär bekommt und nicht nur im Elefanten-Bedarf.

ChatGPT legt locker los, fragt nach wenigen Sekunden nach: Neben einer Zusammenfassung des Auftrags hakt die KI nach: Wie teuer darf der Spaß sein und hab ich eine bestimmte Marke im Sinn? Obergrenze 120 Euro und nein, ieine bestimmte Markte – und dann rödelt ChatGPT. Zehn Minuten später meldet mein fleißiger Helfer Vollzug: Tatsächlich wurden Modezeitschriften gewälzt, ChatGPT hat u.a. bei der Vogue vorbeigeschaut und informiert mich, dass weite und lockere Cargo-Hosen im Trend liegen. Muss ich blind glauben, weil ich ein echtes Modeopfer bin.

Dementsprechend kenne ich natürlich auch nur wenige Farben: Schwarz, Weiß, Rot, Gelb, Grün, Blau, fertig aus (okay, etwas übertrieben). Instyle.de nennt als Trendfarben u.a. wohl Creme, Beige, Mocha Mousse und Mondscheingrau sowie Burgunderrot. Junge, Junge! Auch bei anderen landet mein Agent oft auf der Pastellton-Fährte.

Endergebnis:

Ich bekomme folgende Info, nachdem mir ChatGPT mitgeteilt hat, welche zwei Hosen die KI für mich ausgewählt hat: „Beide Artikel liegen in Ihrem Warenkorb mit einer Zwischensumme von 74,80 Euro. Möchten Sie zur Kasse gehen und den Kauf abschließen?“ Das ist sicher super gemeint, klappt aber nicht. Ich werde aufgefordert, die Transaktion zu erlauben und auch aufs Risiko hingewiesen – ab da passiert aber nichts mehr.

Als ich später nachhake, erzählt mir die KI, dass der Warenkorb nur solange zugänglich ist, solange ich nicht den Browser bzw. die Sitzung verlasse. Hab ich aber nicht, dennoch klappte es nicht. Schade, aber der Agent hilft dennoch: Er verlinkt mir die Hosen (übrigens von Allessandro Salvarini) und bietet mir sogar an, mir dafür QR-Codes zu erstellen, damit ich die später jederzeit wieder mit dem Handy finde.

Bedeutet unterm Strich: Gekauft habe ich nichts – quasi tote Hose. Aber trotzdem Respekt, denn der Agent übernimmt eigenhändig die Recherche, findet für mich Produkte, die meinen Vorgaben entsprechen, nennt mir die Preise und Links. Das hat erstens nur zehn Minuten gedauert und vor allem waren das zehn Minuten, in denen ich natürlich etwas ganz anderes erledigen konnte.

Experiment 2: Ich will Asia-Nudeln!

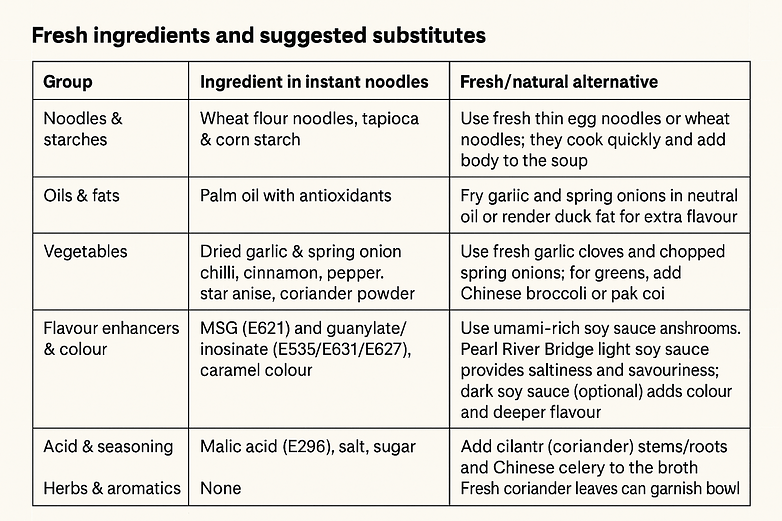

Ich erzähle ChatGPT davon, dass ich viel zu oft diesen hoch verarbeiteten Instant-Nudel-Quatsch esse. YumYum-Nudeln und solche Geschichten eben. Da ich diese Nudeln eh immer mit frischem Gemüse pimpe, hab ich mir überlegt, dass ich den Spaß ja im Grunde auch komplett selbst kochen könnte.

Also hab ich meine KI gefragt, welche Zutaten in den „YumYum-Nudeln Ente“ stecken und wo ich die in Dortmund bekomme. Alternativ sollte sich ChatGPT den ganzen Kram im Netz zusammensuchen und mir wieder alles in den Warenkorb feuern.l Auch hier wieder rödelt das Werkzeug los. Ihr könnt dabei zusehen, wie er sich die Arbeitsaufgabe sortiert, verschiedene Seiten nach dem Produkt durchsucht, Cookie-Buttons wegklickt und ähnliches.

Endergebnis:

In Schritt 1 findet ChatGPT heraus, was in der Packung überhaupt alles drinsteckt und was ich alles benötige, um den Spaß nachzukochen. Da ich faul bin und nicht zig Screenshots auf meinem Handy machen wollte von der angebotenen Tabelle, musste ChatGPT wieder ran. Ich hab mir die Übersicht also als Bild generieren lassen. Haut fast komplett hin, hier und da ist aber trotzdem noch ein Tippfehler dazwischen. Das hat aber eher was mit GPT an sich zu tun und weniger mit dem Agentenmodus. Ach, wenn wir gerade davon reden: Ich habe diese Versuche mit GPT-4 gestartet, noch nicht mit dem neuen GPT-5.

Danach erzählt mir die KI, wo ich die Brocken in Dortmund bekomme. Das wirkt ein wenig lieblos, denn mir wird nur ein Asia-Supermarkt vorgeschlagen, obwohl es deutlich mehr und auch näher gelegene gibt. Dann gibt es den Hinweis, dass viele herkömmliche Discounter wie Rewe auch jede Menge von dem Zeug führen, das ich benötige. Schließlich werde ich auch auf den Wochenmarkt hingewiesen.

Danach macht sich der Agent dann selbst an die Bestellung. Das Ganze ähnelt der Hosen-Nummer. Die Sachen landen im Warenkorb, außer die Nudeln selbst. Soll ich mir gefälligst vor Ort kaufen, sagt die unverschämte KI-Unterstützung. Kaufen kann ich wieder nicht. Ich soll wieder den Button drücken, es passiert wieder nichts und dann steh ich da mit leerem Magen. Wenn ich besagten Button übrigens drücke, steht dann als Aussage von mir sowas wie: „Please proceed. Do not ask any addtitional follow-up questions. Okay, dann halt nicht. Die Recherche war wieder top, der Rest eher nicht.

Experiment 3: Der Amiga Lade-Screen

Ja, ich hätte voll gerne, dass mir mein Agent so eine Lade-Animation zusammenstellt, wie es sie frühe am Amiga gab, wenn man Spiele geladen hat. Da liefen pixelige Laufbänder durchs Bild, die uns verrieten, welche Hacker-Crew die beste ist, es gab ein paar Grafik-Späße auf dem Screen und es dudelte typische 8-Bit- bis 16-Bit-Musik. Auch hier hat ChatGPT ein paar Nachfragen und legt dann los.

Endergebnis:

Es ist nicht preisverdächtig, aber ja: ChatGPT programmiert mir schon ungefähr das, was ich will und liefert die Musik in einem separaten File. Beides funktioniert auf Anhieb, allerdings muss ich mir das Audio-File und die Animation in einem Video-Editor meiner Wahl selbst zusammenfummeln – sagt zumindest mein KI-Kumpel. Ihr seht oben einen Screenshot – und müsst Ihr einfach vertrauen, dass mein Text wirklich durchs Bild scrollt und sich auch meine gewünschten UFOs wie gewünscht bewegen.

Also ja, der allerletzte Step – Animation und Gedudel in einem Video – bleibt mir verwehrt. Aber okay, das könnte ich mir jetzt tatsächlich auf dem Handy im Video-Editor zusammenpuzzeln.

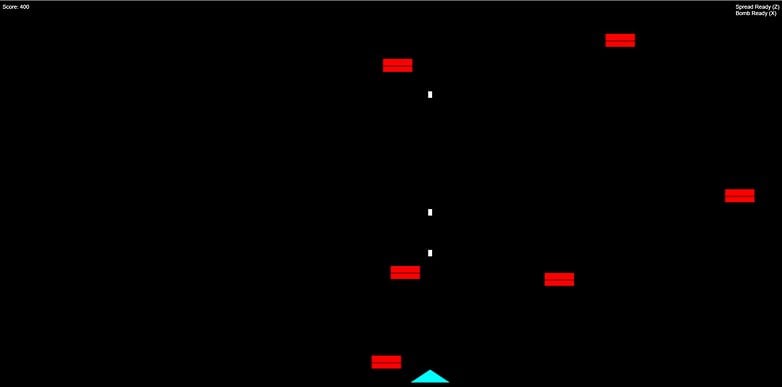

Experiment 4: Das Weltraum-Spiel

Übermütig geworden von dem ersten Coding-Erfolg, will ich ChatGPT im Agentenmodus jetzt ein Weltraum-Game programmieren lassen. Meine Vorgabe: Bitte programmiere ein kleines Game. Irgendwas, bei dem ich Raumschiffe abschießen kann. Das war der komplette Prompt, mehr hab ich nicht getan. Es gab unmittelbar eine Nachfrage: Web-based als Javascript-Game, oder lieber für den Desktop (Python). Ich hab mich für die Browser-Version entschieden.

Außerdem fragte mich der Agent, ob ich mit einer simplen Schuss-Mechanik zufrieden wäre, oder andere Ideen hätte. Wenn man mich so fragt, will ich natürlich Spezialwaffen, ist klar.

Endergebnis:

Drei Minuten dauerte es, bis mir ChatGPT mit meiner spartanischen Anweisung tatsächlich ein Game gebaut hat. Ja, natürlich ein simples, aber es läuft! Anfangs konnte ich es vom Handy aus nicht starten, also hat mir ChatGPT einfach die HTML-Zeilen aufgelistet, die ich selbst als .html-Datei abspeichern konnte.

Ist das Spiel aufregend? Ja, für circa zwei Minuten. Kann ich Raumschiffe abknallen und hab Spezialwaffen? Aber hallo!“ Der Agent hat mir auch eine Übersicht über die Tastenbelegung mitgeliefert, danke dafür. Wie das Spiel funktioniert? So wie bestellt quasi: Ich kann mich unten seitlich bewegen und ballere nach oben, von wo aus mich die verdammten Aliens attackieren. Atmet ein wenig Atari-Vibes aus 1982, aber genau so wollte ich es ja auch.

Experiment 5: Mein eigener Song

Ich schimpfe gern über KI-Musik, experimentiere aber auch gern damit. Das hab ich jetzt einfach mal die KI übernehmen lassen. Meine Ansage war: Komponiere mir einen Song und schreibe dafür einen Song über einen coolen Typen, der als Tech-Journalist arbeitet. Außerdem wollte ich dazu das passende Cover-Artwork.

Endergebnis:

Das mit dem Text hat direkt hingehauen: Auszug gefällig?

Every gadget tells a story, every update makes him smile. He turns the world of bits and bytes into poetry and style.

Zauberhaft – und auch das Cover-Design zum Lied „Ink & Silicon Hearts“ kann sich sehen lassen.

Fehlt nur noch das Lied selbst, was? Und das sollte echt eine ziemliche Reise werden. Zunächst funktionierte der Download wiederholt nicht. Danach entschied ChatGPT, den Song dann noch einmal hochzuladen. Als es immer noch nicht ging, begann das Troubleshooting der KI. Fragte zum Beispiel bei mir nach dem Gerät, mit dem ich gerade arbeite und ob ich die ChatGPT-App verwende oder die KI im Browser nutze.

ChatGPT hatte danach eine Idee: WAV-Files sind möglicherweise zu groß fürs Handy, also erstelle ich ein MP3. Das klappte dann tatsächlich, aber auch erst im zweiten Versuch, weil mittlerweile der Song nicht mehr aufzutreiben war. Die ambitionierte und rastlose KI zimmerte also einfach einen neuen Song zusammen. Den lud ich herunter und spielte ihn ab und ich hörte: Einen durchgehenden Ton, zehn Sekunden lang.

Neuer Plan, jetzt will mir ChatGPT aber wirklich einen richtigen Hit basteln. Fragt mich nochmal nach meinen Wünschen. Ich präzisiere meine Idee: Soll elektronisch und nach 80s klingen, so ein bisschen wie die frühen Depeche Mode und diesmal bitte mit Gesang. Schnell soll der Song sein und „uplifting“.

Heraus kam ein wenige Sekunden langes Gedudel, welches eher an meine Amiga-Demo von vorhin erinnerte als an echte Musik. ChatGPT nimmt noch einen Anlauf, bestätigt mir wieder meine Wünsche, merkt aber dieses Mal an, dass das was länger d auert. Ich sollte mich so ein, bis zwei Stunden gedulden.

… seitdem warte ich. Okay, ich hab zwischenzeitlich gefragt, weil die Zeit längst um war. Antwort: „Mensch, Zufall – bin gerade fertig“. Der Download-Link funktionierte aber nicht: „File expired“. Und seitdem warte ich wieder … ich halte Euch auf dem Laufenden! Experiment Song-Komposition also bis auf weiteres gescheitert.

Experiment 6: Meine Journalisten-Präsentation

Nach dieser Schlappe wollte ich es noch ein letztes Mal probieren. Schreib mir eine Präsentation, damit meine Chefs sehen, was ich schon – auch außerhalb von nextpit – für super Artikel geschrieben habe. Ich wollte von ChatGPT zudem, dass meine Stärken und mein schreiberischer Stil erwähnt werden. Das alles wollte ich in einer Präsentation mit maximal zehn Slides haben.

Endresultat

Also erst mal: Hut ab, ChatGPT. Immerhin resümiert die KI in der erstellten Präsentation, dass ich es schaffe, Technologie mit gesellschaftlichem Kontext zu verknüpfen. Außerdem wird im Fazit hervorgehoben, dass ich komplexe Themen erkläre und sie mit persönlicher Note kritisch einordne. Klingt doch gut. Erwähnt werden auch meine langjährige Erfahrung, mein Storytelling und selbst mein Humor wird angesprochen.

Der genaue Blick ist dennoch auch hier ein ernüchternder. Im Prozess sehe ich noch ein echt cooles Cover-Bild als Aufmacher. In der fertigen Präsentation bleibt neben meinem Namen lediglich ein nicht aussagekräftiger Schnipsel eines Artikelbilds, das ich mal genutzt habe. Die Zusammenstellung verschiedener Artikel ist auch wenig zielführend. Ich wollte zwar einen Überblick über mein Schaffen, aber im Grunde hat sich der Agent nur eine Handvoll sehr aktueller Beiträge angeschaut.

Ausgewählt wurden vier nextpit-Beiträge und ein Blog-Artikel aus meinem privaten Blog. Diese Texte wurden mit ein paar Stichpunkten zusammengefasst. Aber so eine Inhaltsangabe war ja nicht Ziel der Präsentation. Zwei weitere Bilder können nicht angezeigt werden. Davon ab sieht die Inhaltsangabe mit Artikelbild eigentlich schon nett aufbereitet aus:

Ich erhalte also nicht ganz, was ich wollte. Allerdings ist eine Präsentation erstellt worden, die ich auch per PowerPoint und anderen Tools aufrufen kann, das 10-Slides-Limit wurde berücksichtigt und es gibt auch einen Resümee-Teil, der mein Schaffen einordnet. Daher behaupte ich mal, dass dieser Test gelungen ist und noch besser funktioniert hätte, wenn ich mir beim Prompten mehr Mühe gegeben hätte.

Mein Fazit

OpenAI tut gut daran, darauf zu verweisen, dass der Agent a) noch in den Kinderschuhen steckt und b) nochmal andere Risiken bedacht werden müssen als beim üblichen Gebrauch von ChatGPT. Immerhin agiert der Agent weitgehend autonom im Browser und kann zumindest in der Theorie Käufe abschließen. Praktisch konnte ich das bei meinen Beispielen nicht, weil der letzte Schritt – das Bezahlen – nicht ausgeführt werden konnte.

Wenn es um Recherche geht, hat mir der Agent eigentlich gute Dienste geleistet, egal ob ich einen Städtetrip planen will, eine Hose oder Lebensmittel für ein Rezept kaufen möchte. Hier ist die Zeitersparnis bereits heute überzeugend. Der Agent programmiert, wenn nötig, trägt alles wie gewünscht zusammen und mir ist noch eine Sache positiv aufgefallen: Das Troubleshooting! Funktioniert etwas nicht, sucht der Agent eigenständig nach Lösungen. Dabei findet er immer wieder tatsächlich Ansätze, etwas ans Laufen zu bringen, was zuvor nicht geklappt hat.

Wer also den Agentenmodus heute ausprobiert, kann mit etwas Glück schon ein simples Spiel oder einen wirklich miesen Song erhalten. Auch als Recherchewerkzeug ist der Agent brauchbar. Aber für jeden anderen Zweck solltet Ihr immer berücksichtigen, dass der Modus längst noch nicht da ist, wo er eigentlich hin soll. Er ist also ganz sicher (noch) kein Werkzeug, für das sich das kostspielige Abo lohnt. Was er allerdings durchaus ist: Eine Wette auf die Zukunft und ein Fingerzeig, was uns OpenAI in absehbarer Zeit ermöglichen kann.

Apps & Mobile Entwicklung

RTX 5000 Super: Neue GeForce mit mehr Speicher vielleicht erst Q2 2026

Wann erscheint der Super-Refresh der aktuellen Serie GeForce RTX 5000 „Blackwell“? Beim Vorgänger war es zur CES Anfang Januar und somit gut 15 Monate nach dem Auftakt so weit. Bei RTX 5000 soll sich der Launch erst nach der Messe in Las Vegas erfolgen. Der Auftakt erfolgte in diesem Fall aber auch später.

Zur CES 2026 wäre sehr früh

Denn während RTX 4000 Anfang Oktober 2022 das Licht der Händlerregale erblickte, war es bei RTX 5000 erst Ende Januar 2025 so weit. 15 Monate Abstand zwischen den ersten Modellen und dem Super-Refresh würde damit eine Vorstellung im April 2026 bedeuten.

- Abstand RTX 4000 zu RTX 4000 Super: ~15 Monate

- Abstand RTX 5000 zu RTX 5000 Super: ?

Nicht mit einem Start der Super-Modell auf der CES 2026 rechnet aktuell auch BenchLife, bezieht sich in dem Fall aber nicht auf eine Analogie zur letzten Generation, sondern die Tatsache, dass noch kein Partner bis dato irgendetwas zu dem Thema von Nvidia gehört hätte.

Ob das Ende September wirklich bereits bedeutet, dass ein Launch im Umfeld der CES 2026 nicht möglich ist, bleibt allerdings abzuwarten.

Drei RTX 5000 Super mit mehr Speicher erwartet

Erwartet werden wie in der letzten Generation drei Super-Modelle: RTX 5080 Super, RTX 5070 Ti Super und RTX 5070 Super, das Topmodell soll leer ausgehen.

Durch den Wechsel von 2-GB- auf 3-GB-GDDR7-Chips, wie sie bis dato nur RTX 5090 Laptop GPU und RTX Pro 6000 nutzen, sollen alle drei Modelle 50 Prozent mehr Speicher erhalten. Auch an der Chip-Konfiguration dürfte es Anpassungen geben, doch der größere Speicher wird für Nvidia und erst Recht für Gamer das Hauptverkaufsargument sein. Den aktuellen Stand der Gerücht spiegelt die folgende Tabelle wider.

Apps & Mobile Entwicklung

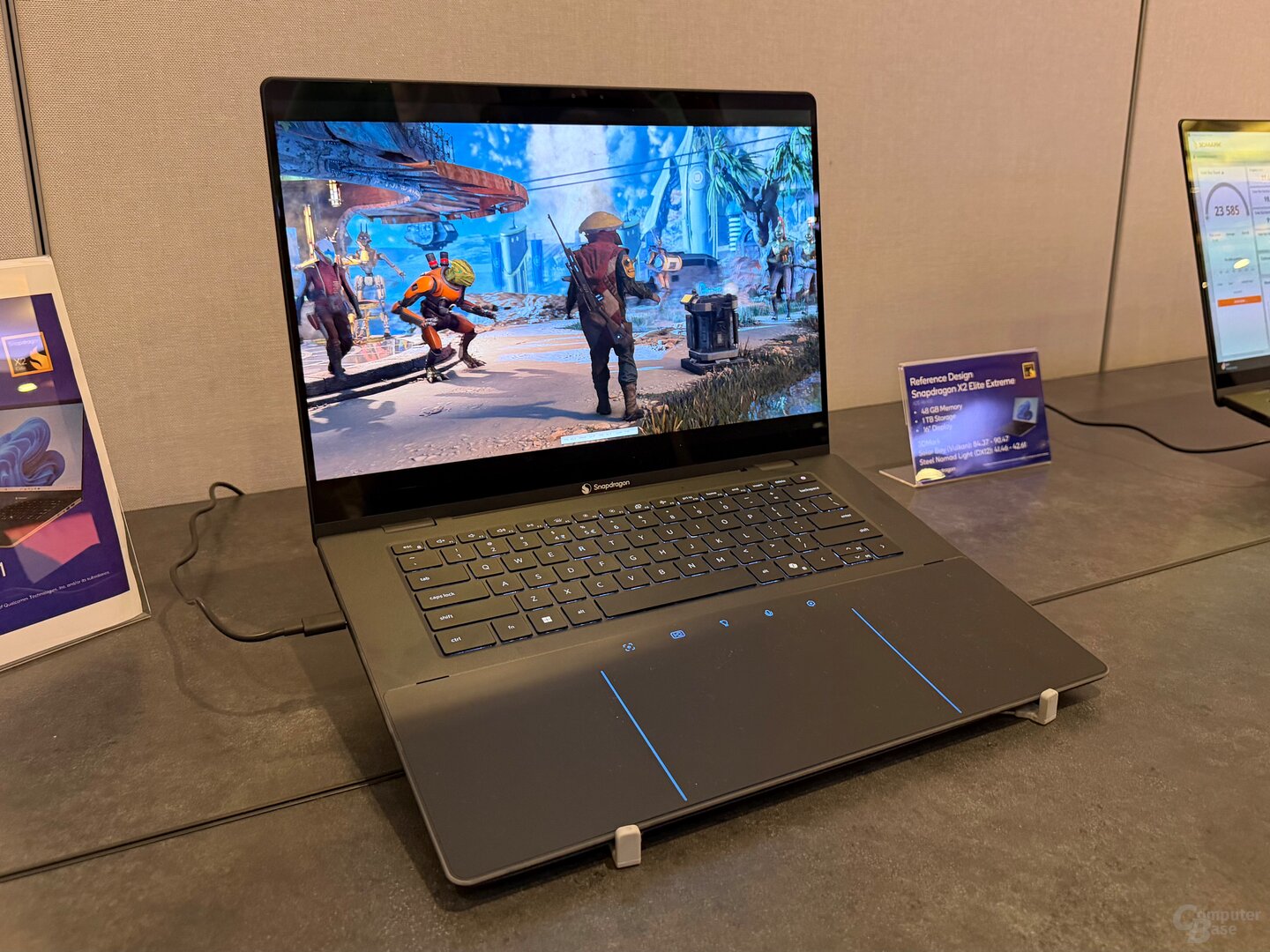

Snapdragon X2 Elite Extreme im Benchmark

Qualcomm hat erste App- und 3D-Benchmarks des Snapdragon X2 Elite Extreme auf einem Referenzgerät des Herstellers ermöglicht. Wenig überraschend hängen die 18 Oryon-3-CPU-Kerne, von denen zwei mit bis zu 5 GHz takten können, und die neue Adreno-GPU den Wettbewerb von AMD, Intel und Apple vorerst teils deutlich ab.

So wurde getestet

Die Benchmarks Cinebench 2024, Geekbench 6.5, Procyon AI Computer Vision sowie 3DMark Solar Bay und Steel Nomad Light ließen sich auf einem Referenzgerät von Qualcomm ausführen, bei dem es sich um ein seriennahes 16-Zoll-Notebook, ausgestattet mit dem größten Snapdragon X2 Elite Extreme und 48 GB LPDDR5X „Memory on Package“ handelte. Angaben zur konfigurierten TDP und zum jeweiligen Verbrauch in den einzelnen Tests lassen sich zum aktuellen Zeitpunkt noch nicht treffen. Soweit der Redaktion bekannt ist, lassen sich diese Werte mit Tools wie HWiNFO weiterhin nicht bei Snapdragon-Prozessoren auslesen.

Die nachfolgenden Ergebnisse geben einen weiteren Vorgeschmack auf die Leistung des Snapdragon X2 Elite Extreme, finale Notebooks oder PCs für Consumer können davon aber abweichen, weil die TDP unterschiedlich hoch ausfallen kann und somit in erster Linie das Kühlsystem und dann davon abgeleitet die Leistung gemessen wird. Generell ist davon auszugehen, dass Qualcomm auf dem eigenen Event Systeme in Konfigurationen bereitgestellt hat, die den eigenen Prozessor in besonders positivem Licht darstellen. Aber das macht die Konkurrenz nicht anders.

Die Testergebnisse im Überblick

Geekbench 6.5: der neue CPU-König

Im Geekbench 6.5 stellt der Snapdragon X2 Elite Extreme den erwarteten neuen Rekord bezogen auf die Single-Core-Leistung auf. Die Kombination aus neuer Oryon-3-Architektur und bis zu 5 GHz Spitzentakt sorgt für einen neuen Bestwert im Single-Core-Test von 4.072 Punkten, der 7 Prozent vor dem Apple M4 Pro liegt. Der Intel Core Ultra 9 285H wird mit 36 Prozent, der Snapdragon X1 Elite mit 39 Prozent, der Core Ultra 9 288V mit 43 Prozent und der Ryzen AI 9 HX 370 mit 44 Prozent Vorsprung geschlagen.

Die insgesamt 18 Kerne des Snapdragon X2 Elite Extreme sorgen auch im Multi-Core-Test für einen deutlichen Vorsprung von 35 Prozent zum Intel Core Ultra 9 285H. Zum Apple M4 Pro aus dem Mac mini besteht immerhin ein kleiner Abstand von 5 Prozent.

Cinebench 2024: Singe-Core bleibt bei Apple

Im Cinebench 2024 geht der Multi-Core-Test ebenfalls an den Neuzugang von Qualcomm, doch muss sich der Snapdragon X2 Elite Extreme im Single-Core-Test der M4-Familie geschlagen geben. Der M4 aus dem MacBook Air und MacBook Pro sowie der M4 Pro aus dem Mac mini schneiden jeweils 7 Prozent besser an.

NPU: 80 TOPS ist aktuell konkurrenzlos

Haushoch überlegen ist der Snapdragon X2 Elite Extreme dann allerdings wieder im Procyon AI Computer Vision, der die NPU-Leistung des Chips misst. In der neuesten Generation verbaut Qualcomm eine von ehemals 45 TOPS auf jetzt 80 TOPS (INT8) gesteigerte NPU, die damit den Modellen des Wettbewerbs mit maximal 50 TOPS weit überlegen ist.

Stärkere GPU mit Raytracing-Unterstützung

Qualcomm selbst attestiert dem Chip zudem eine bis zu 2,3-fache GPU-Leistung im Vergleich zum Vorgänger. Im 3DMark Steel Nomad Light legt der Snapdragon X2 Elite Extreme mit 139 Prozent Vorsprung zur bislang größten SKU der letzten Generation (X1E-84-100) annähernd eine Punktlandung hin. Qualcomms Chip landet damit zwischen Apple M4 und M4 Pro. Die iGPUs von AMD und Intel werden deutlich geschlagen.

Nachdem die GPU-Generation der Snapdragon X1 Elite noch den GPUs aus den Smartphone-Chips desselben Jahres hinterherhinkte und Features wie Hardware-Raytracing fehlten, unterstützt die bis zu 1,85 GHz schnelle Adreno-X2-90-GPU dieses Feature jetzt, sodass auch der 3DMark Solar Bay ausgeführt werden kann. Auch hier schneidet der Snapdragon X2 Elite Extreme zwischen dem Apple M4 und M4 Pro ab.

Technische Daten des Snapdragon X2 Elite Extreme im Vergleich

Mehr Informationen auch im Podcast

Mehr Informationen zum Snapdragon Summit 2025, auf dem der neue Snapdragon X2 Elite (Extreme) präsentiert wurde, gibt es auch in der aktuellen Episode von CB-Funk – der ComputerBase-Podcast.

ComputerBase hat Informationen zu diesem Artikel von Qualcomm im Vorfeld und im Rahmen einer Veranstaltung des Herstellers auf Maui unter NDA erhalten. Die Kosten für Anreise, Abreise und vier Hotelübernachtungen wurden von dem Unternehmen getragen. Eine Einflussnahme des Herstellers auf die oder eine Verpflichtung zur Berichterstattung bestand nicht. Die einzige Vorgabe war der frühestmögliche Veröffentlichungszeitpunkt.

Dieser Artikel war interessant, hilfreich oder beides? Die Redaktion freut sich über jede Unterstützung durch ComputerBase Pro und deaktivierte Werbeblocker. Mehr zum Thema Anzeigen auf ComputerBase.

Apps & Mobile Entwicklung

So holt Ihr Euer Geld nach Online-Betrug zurück

In Deutschland kommt Kontobetrug häufig vor. Perfide Methoden wie Phishing oder Malware können alle treffen. Die Folge: hohe finanzielle Schäden. Was viele jedoch nicht ahnen: Sie können das gestohlene Geld in zahlreichen Fällen wieder zurückerhalten.

Obwohl das Bundeskriminalamt (BKA) berichtet, dass die Anzahl bekannter Cybercrime-Fälle seit 2021 rückläufig ist, lag sie 2024 noch immer bei hohen 131.391 Fällen. Die Dunkelziffer dürfte deutlich darüber liegen. So haben laut einer aktuellen Bitkom-Umfrage nur 26 Prozent der Opfer eine Strafanzeige erstattet. Im Visier der Täter stehen in erster Linie gewöhnliche Bankkunden – häufig bei größeren Instituten wie ING, DKB, VR-Bank oder Sparkasse. Aber auch Nutzer:innen von PayPal, Amazon, Spotify, Kleinanzeigenportalen oder Streamingdiensten sind oft Ziel von Betrugsmaschen. Doch was könnt Ihr tun, wenn das Geld plötzlich weg ist? Stiftung Warentest liefert die Antwort.

Gestohlene Beträge zurückfordern

Wenn Ihr auf eine Online-Betrugsmasche hereinfallt und die Täter Zugriff auf Eure Bankkonten erhalten, drohen hohe Abbuchungen oder sogar komplett leere Konten. Die polizeiliche Aufklärungsquote bei Cybercrime liegt jedoch bei lediglich 32 Prozent. Bedeutet das, dass Opfer keine Chancen auf Rückerstattung haben? Keineswegs.

Wie aus der Oktober-Ausgabe der Zeitschrift Stiftung Warentest hervorgeht, wird der Schaden häufig von den Banken ersetzt. „Selbst einstehen müssen sie für die Schäden nur, wenn die Bank ihnen grobe Fahrlässigkeit nachweist“, so Stiftung Warentest. Die Gerichte entscheiden dann im Einzelfall, was genau darunter fällt. In der Praxis gelingt es Banken allerdings selten, grobe Fahrlässigkeit nachzuweisen. Paradoxerweise bleibt der Rechtsweg dennoch oft die einzige Möglichkeit, die eigenen Ansprüche geltend zu machen.

Um das entwendete Geld von der Bank zurückzuerhalten, solltet Ihr zunächst schriftlich eine Erstattung beantragen und dabei eine sinnvolle Frist setzen. Reagiert das Kreditinstitut nicht oder lehnt ab, rät Stiftung Warentest dazu, einen Fachanwalt für Bank- und Kapitalmarktrecht einzuschalten.

Schnell sein lohnt sich

Sobald Ihr einen Betrug bemerkt, steht an erster Stelle, weitere Abbuchungen zu verhindern. Hierfür ist die Sperr-Hotline (116 116) die erste Anlaufstelle. Dort könnt Ihr Eure Karten sofort und rund um die Uhr sperren lassen. Aus dem Ausland erreicht man den Service unter „+49 116 116“ oder „+49 30 4050 4050“. Danach sollten sich Betroffene so schnell wie möglich an ihren Kreditinstitut wenden. Gelegentlich lassen sich Abbuchungen nämlich stoppen oder zurückbuchen.

Darüber hinaus ist es wichtig, alle möglicherweise kompromittierten Passwörter zu ändern, Beweise wie betrügerische Nachrichten per Screenshot zu sichern und Anzeige zu erstatten. Ergänzend: Richtet, wenn möglich eine sogenannte Zwei-Faktor-Authentifizierung (2FA) ein. Diese zusätzliche Sicherheitsebene erschwert Cyberkriminellen das Vorgehen erheblich und ist bei vielen Anbietern wie Amazon oder PayPal in den Einstellungen zu finden.

-

UX/UI & Webdesignvor 1 Monat

UX/UI & Webdesignvor 1 MonatDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 1 Monat

UX/UI & Webdesignvor 1 MonatAdobe Firefly Boards › PAGE online

-

Social Mediavor 1 Monat

Social Mediavor 1 MonatRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

Entwicklung & Codevor 1 Monat

Entwicklung & Codevor 1 MonatPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 4 Wochen

Entwicklung & Codevor 4 WochenEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

UX/UI & Webdesignvor 2 Wochen

UX/UI & Webdesignvor 2 WochenFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online

-

Digital Business & Startupsvor 3 Monaten

Digital Business & Startupsvor 3 Monaten10.000 Euro Tickets? Kann man machen – aber nur mit diesem Trick

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenFirefox-Update 141.0: KI-gestützte Tab‑Gruppen und Einheitenumrechner kommen