Künstliche Intelligenz

Zahlen, bitte! 350 Inspektoren für globale Atomsicherheit: Die IAEA

Am 29. Juli 1957 wurde die Internationale Atomenergie Organisation (IAEA engl. /IAEO deutsch) unter dem Dach der Vereinten Nationen gegründet. Zuvor hatte in Genf im Jahre 1955 die „International Conference on the Peaceful Uses of Atomic Energy“ getagt, auf der die damaligen Atommächte USA, Sowjetunion, Großbritannien und Frankreich ihre Pläne für die zivile Nutzung der Kernenergie vorstellten.

Noch früher hatte US-Präsident Eisenhower in seiner Rede „Atoms for Peace“ versucht, die Welt auf eine friedliche Nutzung der Atomenergie einzuschwören. Damals glaubte man, dass die Uranvorräte äußerst knapp sind. Eisenhower schlug eine Art Bank vor, bei der sich Staaten nukleares Spaltmaterial für friedliche Zwecke ausleihen, und die somit die Menge der Nukleartechnik kontrolliert – nur wenige Staaten wollten dabei mitmachen.

In dieser Rubrik stellen wir immer dienstags verblüffende, beeindruckende, informative und witzige Zahlen aus den Bereichen IT, Wissenschaft, Kunst, Wirtschaft, Politik und natürlich der Mathematik vor.

Mit rund 2500 Bediensteten und einem Etat von 384 Millionen Euro ist die Organisation zur Überwachung der Atomenergie nicht nur die größte ihrer Art, sondern hat seit 1997 weitreichendere Vollmachten als ihr Pendant, die Organisation für das Verbot chemischer Waffen (OPCW). Mit der Gründung der IAEO war der richtige Schritt – mitten im Kalten Krieg – gelungen, eine internationale Institution zur Kontrolle der Nukleartechnik einzurichten.

Heute hat die IAEO 178 Mitgliedsstaaten. 350 Inspektoren überwachen weltweit die Anreicherung von Uran 235 auf ein Niveau von 20 Prozent für den Einsatz in Kernkraftwerken. Ein eigenes Forschungslabor in der Nähe von Wien, dem Hauptsitz der IAEO, ist darauf spezialisiert, Schmierproben zu analysieren, die in der Nähe von Atomanlagen gesichert wurden, und so Hinweise auf waffenfähiges Spaltmaterial zu prüfen. Die IAEO berichtet dabei direkt an die Vereinten Nationen (UN).

Das Logo der IAEA

(Bild: IAEA)

Förderung von friedlicher Nutzung von Kernenergie als Wohlstandsträger

Gemäß ihrer Satzung, „den Beitrag der Kernenergie zu Frieden, Gesundheit und Wohlstand weltweit zu beschleunigen und vergrößern“, hat sich das Aufgabengebiet der IAEO im Zuge ihrer Geschichte erheblich erweitert. Die ursprüngliche zentrale Aufgabe, die Nutzung der Kernenergie zu fördern, wurde unter dem Eindruck der Kubakrise 1962 geändert, denn der danach verabschiedete Nukleare Nichtverbreitungsvertrag von 1968 verlangte nach einer Kontrollbehörde. Denn der Vertrag verpflichtete alle Nichtkernwaffenstaaten, alles Spaltmaterial in ihrem Besitz den Verifikationsmaßnahmen (Safeguards) der IAEO zu unterstellen.

Sogenannte Inspektoren sollten die Anreicherung von Uran daraufhin prüfen, ob die Produktion von hoch angereichertem Uran für den Bau von Atombomben möglich wäre. Die nächste Erweiterung der Aufgaben geschah nach dem Reaktorunfall von Tschernobyl 1986, was die Überprüfung der technischen Sicherheit von Reaktoren durch die IAEO zur Folge hatte.

Das Jahr 1991 brachte eine drastische Zäsur in die Arbeit der IAEO-Inspektoren. Der Irak betrieb eben den von Inspektoren offiziell besuchten und nicht beanstandeten Nuklearanlagen heimlich weitere Anlangen zur Produktion bzw. Anreicherung von waffenfähigem Uran. Nach dem zweiten Golfkrieg fand man entsprechende Schmierspuren in der Kleidung von Menschen, die als Geiseln zu kerntechnischen Anlagen verschleppt worden waren.

Unangemeldete Inspektionen jederzeit möglich

Hastig wurden 35 Inspektoren zusammen mit einer eigens eingesetzten UN-Kommission in den Irak geschickt, diese Anlagen zu besuchen und gegebenenfalls zu zerstören (PDF-Datei). Als Reaktion auf diese Panne wurden die Verifikationsmaßnahmen der IAEO verschärft: Die Inspektoren können unangemeldet erscheinen, wenn ein Verdacht vorliegt, und auch Zutritt zu Anlagen verlangen, die noch im Bau sind. Zudem dürfen sie Schmierproben in der Umgebung der Anlagen sichern.

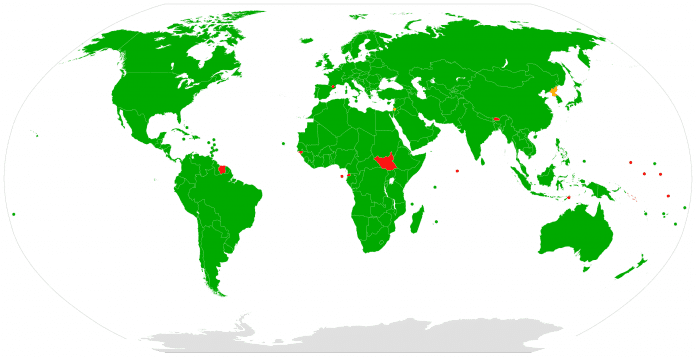

Die meisten Staaten der Erde haben den IAEA-Vertrag ratifiziert und sind auf dieser Karte grün unterlegt. Rot bedeutet nicht ratifizert, gelb Beobachterstatus und orange bedeutet, dass das das Vertragsverhältnis wieder gekündigt wurde. Das trifft auf Nordkorea zu.

(Bild: CC BY-SA 2.5, Blankmap-World6.svg)

Mit den Terrorangriffen auf das World Trade Center am 11. September 2001 weitete sich das Aufgabengebiet der IEAO noch einmal aus, als die Gefahr von „schmutzigen Bomben“ diskutiert wurde. Die IAEO legte ein Programm auf, wie Ländern bei der Sicherung von Radioisotopen-Quellen geholfen werden kann, sie zu sichern. „Mehrere tausend dieser Strahler sind in der ganzen Welt verteilt, in Forschungseinrichtungen, Krankenhäusern, Industrieanlagen oder einsamen Messstationen. Über Jahrzehnte völlig vernachlässigt, geraten sie jetzt als mögliche Quelle radiologischer Waffen für Terroristen in den Blick“, schrieb der Politologe Harald Müller in seinem Bericht über die Entwicklung der IAEO (PDF-Datei).

Friedensnobelpreis für die IAEA im Jahr 2005

Im Jahr 2005 erhielt die IAEO als Behörde zusammen mit ihrem damaligen Generaldirektor El Baradei den Friedensnobelpreis – dafür gab es weltweit großen Beifall. Es dauerte keine fünf Jahre, bis bekannt wurde, dass El Baradei von der damaligen Bush-Regierung abgehört wurde, weil sie seine Haltung gegenüber dem Iran und seinem Atomprogramm zu nachgiebig fand. Zur Erinnerung: damals sorgte die Stuxnet-Attacke gegen die Uran-Anreicherungszentrifugen des Iran für großes Aufsehen.

Im Jahre 2015 akzeptierte der Iran einen Atomvertrag und sagte zu, das iranische Nuklearprogramm so zu ändern, dass keine Atombomben gebaut werden können. Während der ersten Amtszeit von US-Präsident Donald Trump zogen sich die USA aus diesem Atomabkommen zurück und verhängten neue Sanktionen. Das wurde jetzt in der zweiten Amtszeit ausgeweitet. Nach Angriffen von Israel und den USA auf den Iran und seine Atomanreicherungsanlagen hat die iranische Regierung Anfang Juli 2025 die Zusammenarbeit mit der IAEO ausgesetzt.

Die Inspektoren mussten das Land verlassen und können erst dann wieder ihre Kontrollen aufnehmen, wenn die Sicherheit der Anlagen und die der iranischen Atomwissenschaftler garantiert ist. Der amtierende IAEO-Generaldirektor hatte die Angriffe klar verurteilt: „Ich habe wiederholt festgehalten, dass Atomanlagen nie angegriffen werden dürfen, egal in welchem Kontext oder unter welchen Umständen.“

In seinem Buch „Die Physik der unsichtbaren Dimensionen“ beschreibt der Physiker Michio Kaku die Uranbarriere. Sie geht von der Gefahr aus, wenn Typ-0-Zivilisationen nach der Kardaschow-Skala das Element 92 (Uran) und seine Sprengkraft entdecken.

„So liegt der Schluss nahe, dass in der fünf bis zehn Milliarden Jahre währenden Geschichte unserer Galaxie zahlreiche Typ-0-Zivilisationen entstanden sind, dass sie aber alle irgendwann das Element 92 entdeckt haben. Wenn die technischen Möglichkeiten einer solchen Zivilisation ihre gesellschaftliche Entwicklung weit hinter sich ließen, dann war die Wahrscheinlichkeit groß, dass die Zivilisation mit dem Aufstieg feindlicher Nationalstaaten in einem Atomkrieg selbst zerstörte. Sollten wir lange genug leben, um nahe Sterne in unserem Abschnitt der Milchstraße zu erreichen, so werden wir vielleicht die traurigen Überreste zahlreicher toter Zivilisationen entdecken, die ihre nationalen Leidenschaften, persönliche Eifersüchteleien und Rassenkonflikte mit Kernwaffen ausgetragen haben.“

(mawi)

Künstliche Intelligenz

Künstliche Neuronale Netze im Überblick 2: Schichten und Feed-Forward-Netzwerke

Neuronale Netze sind der Motor vieler Anwendungen in Künstlicher Intelligenz (KI) und GenAI. Diese Artikelserie gibt einen Einblick in die einzelnen Elemente. Nach der Vorstellung der Neuronen im ersten Teil widmet sich der zweite Teil den Schichten des Netzwerks.

Prof. Dr. Michael Stal arbeitet seit 1991 bei Siemens Technology. Seine Forschungsschwerpunkte umfassen Softwarearchitekturen für große komplexe Systeme (Verteilte Systeme, Cloud Computing, IIoT), Eingebettte Systeme und Künstliche Intelligenz.

Er berät Geschäftsbereiche in Softwarearchitekturfragen und ist für die Architekturausbildung der Senior-Software-Architekten bei Siemens verantwortlich.

Wenn mehrere künstliche Neuronen so gruppiert sind, dass sie alle denselben Satz von Eingaben erhalten und ihre Ausgaben parallel erzeugen, bezeichnen wir diese Sammlung als Schicht. In einer einzelnen Schicht wendet jedes Neuron seinen eigenen Gewichtsvektor und seinen eigenen Bias-Term auf das eingehende Signal an, aber alle Neuronen teilen sich dieselbe Eingabe. Durch die Anordnung von Schichten in einer Reihenfolge erstellen wir ein Netzwerk, das einfache numerische Eingaben in beliebig reichhaltige Darstellungen umwandeln kann.

Mathematisch ausgedrückt: Wenn wir die Aktivierungen der Schicht ℓ−1 durch den Spaltenvektor aℓ−1 und die Gewichte der Schicht ℓ durch eine Matrix Wℓ bezeichnen, deren Zeilen die Gewichtsvektoren der einzelnen Neuronen sind, dann ergibt sich der Präaktivierungsvektor zℓ der Schicht ℓ aus dem Matrix-Vektor-Produkt:

zℓ = Wℓ · aℓ−1 + bℓ

Wobei bℓ der Bias-Vektor für die Schicht ℓ ist. Anschließend wenden wir eine elementweise nicht lineare Aktivierungsfunktion σ an, um die Ausgabe der Schicht zu erhalten:

aℓ = σ(zℓ)

Wenn wir einen Stapel von Eingaben einspeisen, stapeln wir einfach jede Eingabe als Spalte (oder Zeile, je nach Konvention) einer Matrix X und ersetzen die Vektoroperationen durch Matrixmultiplikationen auf dem Stapel, was zu einer hocheffizienten vektorisierten Berechnung führt.

Im Code lassen sich mit PyTorch auf einfache Weise Schichten und ihre Verbindungen ausdrücken. Die integrierte Klasse torch.nn.Linear kapselt sowohl die Gewichtsmatrix als auch den Bias-Vektor und verbindet sie für die automatische Differenziation mit dem Berechnungsgrafen. Nachfolgend finden Sie ein minimales Beispiel für ein kleines Feed-Forward-Netzwerk mit einer versteckten Schicht. Jede Zeile wird ausführlich erklärt.

import torch

import torch.nn as nn

class SimpleMLP(nn.Module):

def __init__(self, input_dim, hidden_dim, output_dim):

super(SimpleMLP, self).__init__()

# Definieren Sie eine vollständig verbundene Schicht, die input_dim auf hidden_dim abbildet

self.fc1 = nn.Linear(input_dim, hidden_dim)

# Wählen Sie eine nichtlineare Aktivierungsfunktion für die versteckte Schicht

self.relu = nn.ReLU()

# Definieren Sie eine zweite vollständig verbundene Schicht, die hidden_dim auf output_dim abbildet

self.fc2 = nn.Linear(hidden_dim, output_dim)

def forward(self, x):

# Wende die erste lineare Transformation an

x = self.fc1(x)

# Wende die nichtlineare Aktivierungsfunktion elementweise an

x = self.relu(x)

# Wende die zweite lineare Transformation an, um die Ausgabe zu erzeugen

x = self.fc2(x)

return x

Die Import-Anweisungen laden torch für Tensoroperationen und torch.nn als Namespace für Bausteine neuronaler Netze. Die Klasse SimpleMLP erbt von nn.Module, der Basisklasse von PyTorch für alle Komponenten neuronaler Netze. Der Aufruf von super(SimpleMLP, self).init()stellt sicher, dass die interne Maschinerie von Module ordnungsgemäß initialisiert wird.

Innerhalb des Konstruktors sind self.fc1 und self.fc2 Instanzen von nn.Linear. Jede Linearschicht weist eine Gewichtungsmatrix der Form (output_features, input_features) und einen Bias-Vektor der Länge output_features zu. Durch das Speichern dieser Schichten als Attribute des Moduls registriert PyTorch automatisch ihre Parameter, sodass wir beim Aufruf von model.parameters() alle Gewichtungs- und Bias-Tensoren in einem einzigen iterierbaren Objekt zurückgeben können.

Die Wahl von ReLU für self.relu spiegelt dessen weitverbreitete Verwendung wider: Die rektifizierte lineare Einheit gibt für jede negative Eingabe Null zurück und für jede nicht negative Eingabe die Eingabe selbst. Diese einfache, nicht lineare Operation führt die Nichtlinearität ein, die das Netzwerk benötigt, um komplexe Funktionen zu approximieren.

Die Vorwärtsmethode definiert die Transformation des Eingabetensors x, während er durch das Netzwerk fließt. Wenn x die Form (batch_size, input_dim) hat, hat er nach self.fc1(x) die Form (batch_size, hidden_dim) und behält nach Anwendung von ReLU die gleiche Form, wobei sich negative Werte auf Null abbilden. Der letzte Aufruf von self.fc2 erzeugt eine Ausgabe der Form (batch_size, output_dim). Durch die Rückgabe von x am Ende von forward ermöglichen wir es, das Netzwerk wie eine Funktion aufzurufen:

model = SimpleMLP(input_dim=10, hidden_dim=50, output_dim=1)

batch_of_inputs = torch.randn(32, 10)

outputs = model(batch_of_inputs)

In diesem Beispiel ist batch_of_inputs ein Tensor der Form (32, 10), der zweiunddreißig Samples mit jeweils zehn Merkmalen darstellt. Der Aufruf model(batch_of_inputs) ruft im Hintergrund forward auf, und outputs hat die Form (32, 1), sodass wir pro Sample eine Vorhersage erhalten.

Im Hintergrund erstellt PyTorch einen Berechnungsgraphen, der jede Operation – Matrixmultiplikationen, Additionen und Nichtlinearitäten – aufzeichnet, sodass bei der Berechnung eines Verlusts auf der Grundlage der Outputs und dem anschließenden Aufruf von loss.backward() sich die Gradienten aller Parameter in fc1 und fc2 automatisch berechnen lassen. Diese Gradienten lassen sich dann von Optimierern verwenden, um die Gewichtungsmatrizen und Bias-Vektoren zu aktualisieren.

Durch das Stapeln weiterer Schichten – beispielsweise durch mehrmaliges Abwechseln von linearen und Aktivierungsschichten – und durch Variieren der versteckten Dimensionen lassen sich tiefere und breitere Netzwerke erstellen, die hochkomplexe Zuordnungen lernen können.

Der nächste Teil der Serie zeigt, wie die gebatchten, vektorisierten Operationen den Vorwärtslauf in seiner Allgemeinheit bilden und wie die Wahl der Aktivierungen mit der Netzwerktiefe zusammenwirkt.

(rme)

Künstliche Intelligenz

Video Overviews: Google bringt KI-Visualisierungen in NotebookLM

Googles Audio Overviews sind ein Recherche-Werkzeug, bei dem Informationen als eine Art Podcast aufbereitet werden. Nun wird das um visuelle Inhalte erweitert. Die Video Overviews kommen zunächst als Präsentationen, in denen Bilder, Diagramme, Illustrationen und mehr enthalten sind. Google spricht von kommentierten Folien.

Zu nutzen ist Video Overviews wie auch die Audio Overviews via NotebookLM – das ist Google Notiz-App. Die KI ist quasi ein Gastgeber, der Inhalte für den Nutzer aufbereitet. Wahlweise macht er das, indem er Informationen zu einem vorgegebenen Thema als Podcast aufbereitet oder nun eben als Präsentation. Grundlage sind eigens ausgewählte Quellen. Diese legt man in einem Notizbuch an. Daraufhin kann man auswählen, was die KI damit machen soll. Neben Audio und Video Overviews gibt es etwa auch Mindmaps, einen Zeitstrahl und FAQs, die erstellt werden können.

Video Overviews als Lernhilfe

Obwohl der neue Modus Video Overviews heißt, gibt es noch keine KI-generierten Videos. Auf KI-Dokus zum Binge-Watchen muss man also noch eine Weile verzichten. Google verspricht jedoch, dass die Präsentationen nur ein erster Schritt seien.

Auch die Video Overviews lassen sich wie die Audio Overviews anpassen. Themen können konkretisiert, Lernziele festgehalten werden. Es gibt die Möglichkeit, eine Zielgruppe zu bestimmen. Dazu gehört auch, dass man den eigenen Wissensstand vorgeben kann und die Inhalte sowie Erklärungen an diesen angepasst werden. Somit dienen die Overviews in der Regel als Lernhilfe. Erstellte Overviews können mittels eines öffentlichen Links geteilt werden. Nun kann man unterschiedliche Berechtigungen festlegen, um gemeinsam an einem Notizbuch zu arbeiten.

Lesen Sie auch

Neu ist auch, dass man mehrere Outputs derselben Art innerhalb eines Notizbuchs anlegen kann. Zudem lassen sich Audio Overviews anhören, während man an einem Projekt arbeitet. Bisher ging das nicht gleichzeitig.

Zunächst sind die Video Overviews nur auf Englisch verfügbar, weitere Sprachen sollen bald folgen, schreibt Google im Blogbeitrag.

(emw)

Künstliche Intelligenz

Samba: Mehr Sicherheit mit Authentication Silos

Seit der Veröffentlichung der Samba-Version 4.19 kann man Microsofts Windows Server 2016 Functional Level auf Linux-Domain-Controllern einrichten. Dieser Level führt einige zusätzliche Sicherheitsmechanismen wie das FAST-Protokoll ein und ermöglicht zudem den Einsatz von Authentication Policies und Authentication Silos.

Beide Funktionen sorgen für eine größere Sicherheit bei der Authentifizierung. Aber erst in der im Frühjahr freigegebenen Version 4.22 hat sie das Samba-Team vollständig umgesetzt, sodass sich deren Möglichkeiten jetzt auch in einer Samba-Domäne nutzen lassen.

- Samba 4.22 bietet mit dem Functional Level 2016 mehr Sicherheit bei der Authentifizierung von Usern und Systemen.

- Kerberos Armoring durch das FAST-Protokoll schützt unter anderem vor Offline-Wörterbuchattacken sowie Replay- und Machine-in-the-Middle-Angriffen.

- Mit Authentication Policies und Authentication Silos lassen sich über Kerberos Zugriffe komfortabler verwalten.

Das FAST-Protokoll (Flexible Authentication Secure Tunneling) ist auch als Kerberos Armoring bekannt. Es erweitert das Kerberos-Protokoll, indem es die Sicherheit des Kerberos-Authentication-Prozesses sowie die Abfrage von Servicetickets verbessert. Ohne FAST tauschen der Kerberos-Authentication-Prozess und der Service-Ticket-Request-Prozess ihre Nachrichten im Klartext aus.

Das war die Leseprobe unseres heise-Plus-Artikels „Samba: Mehr Sicherheit mit Authentication Silos“.

Mit einem heise-Plus-Abo können Sie den ganzen Artikel lesen.

-

Datenschutz & Sicherheitvor 2 Monaten

Datenschutz & Sicherheitvor 2 MonatenGeschichten aus dem DSC-Beirat: Einreisebeschränkungen und Zugriffsschranken

-

Online Marketing & SEOvor 2 Monaten

Online Marketing & SEOvor 2 MonatenTikTok trackt CO₂ von Ads – und Mitarbeitende intern mit Ratings

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenMetal Gear Solid Δ: Snake Eater: Ein Multiplayer-Modus für Fans von Versteckenspielen

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenPhilip Bürli › PAGE online

-

Digital Business & Startupsvor 1 Monat

Digital Business & Startupsvor 1 Monat80 % günstiger dank KI – Startup vereinfacht Klinikstudien: Pitchdeck hier

-

Apps & Mobile Entwicklungvor 1 Monat

Apps & Mobile Entwicklungvor 1 MonatPatentstreit: Western Digital muss 1 US-Dollar Schadenersatz zahlen

-

Social Mediavor 2 Monaten

Social Mediavor 2 MonatenLinkedIn Feature-Update 2025: Aktuelle Neuigkeiten

-

Social Mediavor 2 Monaten

Social Mediavor 2 MonatenAktuelle Trends, Studien und Statistiken