Apps & Mobile Entwicklung

Foundry-Gerüchte: Samsung verschiebt eigene 1,4-nm-Fertigung

Nach vielen Problemen bei 3 nm und einigen auch bei 2 nm verschiebt Samsung die übernächste Generation der 1,4-nm-Fertigung nach hinten. Immerhin wird nun ein Exynos-Chip endlich in 3-nm-GAA-Serienproduktion gefertigt, der Exynos 2500 wird die neuen Galaxy Z Fold 7 und Galaxy Z Flip 7 antreiben.

Samsung Semiconductor, wie die Halbleitersparte heißt, listet auf der eigenen Webseite, dass der Exynos 2500 in Massenproduktion sei. Die bereits im Januar dieses Jahres genannten Spezifikationen des 3-nm-Chips werden vollständig bestätigt: ein Cortex-X925 mit 3,3 GHz, zwei Cortex-A725 mit 2,75 GHz, fünf Cortex-A725 mit 2,36 GHz und zwei Cortex-A520 mit 1,8 GHz sind verbaut. Auch die AMD-RDNA3-basierte Grafiklösung ist mit dabei.

Der Exynos 2500 ist dabei unterm Strich letztlich der erste größere Chip, den Samsung nun in 3 nm baut und auch selbst nutzt. Zuvor war vor einem Jahr lediglich der Exynos W1000 für Wearables erschienen, ein kleinerer Chip mit weitaus weniger Möglichkeiten. Die Samsung-Fertigung für größere Chips war bisher nicht gut genug, Samsung musste bei der Galaxy-S25-Familie zum Start dieses Jahres vollends auf TSMC zurückgreifen. Erst nun ist 3 nm bei Samsung auch wirklich ein Serienprodukt mit entsprechenden Volumen – drei Jahre nach der Erfolgsmeldung durch Samsung, dass 3-nm-Chips nun produziert werden.

Das Drama bei 3 nm und dem Abspringen und eventuellem (Nicht-)Zurückkehren der Kundschaft setzt sich seitdem auch bei 2 nm fort und wird Auswirkungen auf den Schritt SF1.4 haben, wie Samsung die 1,4-nm-Fertigung nennt.

Laut Berichten aus Südkorea soll Samsung die Pilotlinien nun verzögern und vermutlich erst Anfang des nächsten Jahres aufbauen. Die Serienproduktion im Jahr 2027 galt bisher bereits als sehr ambitioniert, nun soll dies frühestens 2028 der Fall sein. Wie bei Samsung zuletzt aber üblich, dürften reale Produkte dann wohl frühestens ein wenn nicht gar zwei Jahre später damit verfügbar werden.

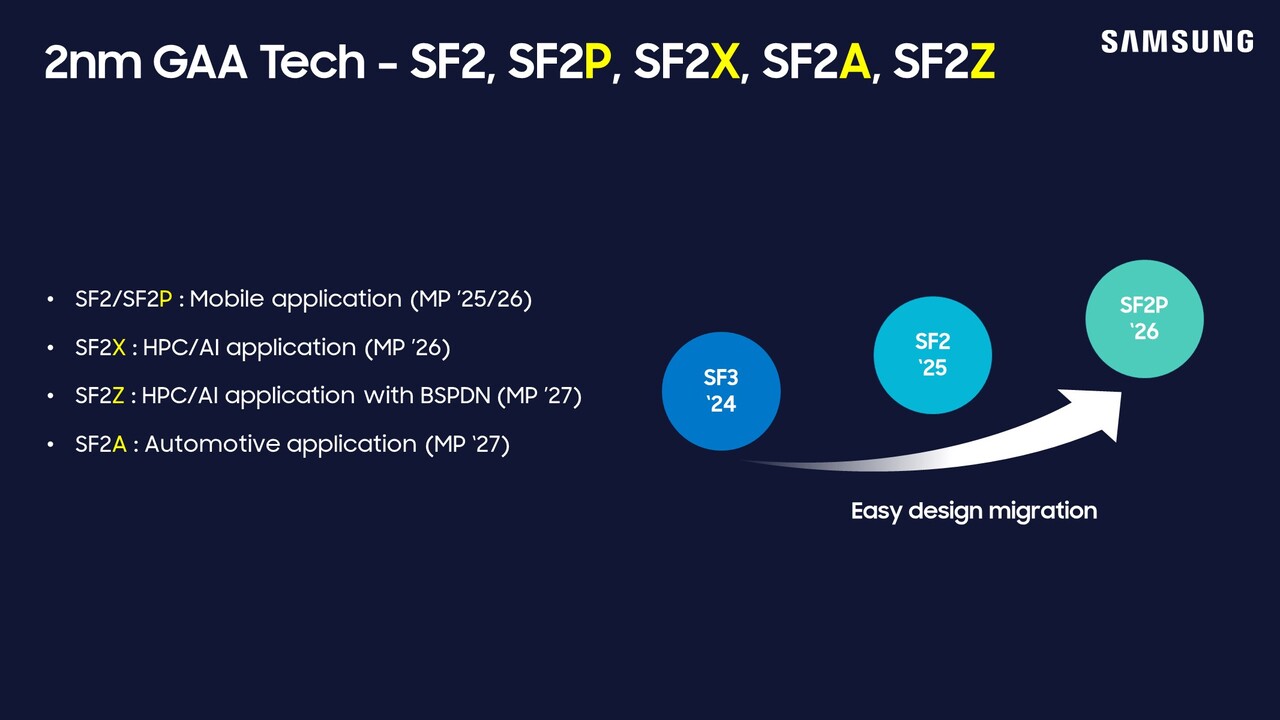

Bis dahin muss die 2-nm-Fertigung in ihren multiplen Ausbaustufen das Zepter übernehmen. Der geplante Exynos 2600 als Nachfolger des erwähnten Exynos 2500 soll aus der 2-nm-Fertigung im Galaxy S26 wieder seinen Platz finden und die Schmach dieses Jahres vergessen lassen. Die Serienproduktion für die SF2/SF2P-Chips war bisher für 2025/2026 geplant. Zuletzt gab es jedoch bereits kritische Stimmen, dass die Ausbeute wohl wieder ein Problem sein könnte, Gerüchte sprechen von lediglich 20 bis 30 Prozent Yield-Rate. Wie immer sind solche Angaben aber mit Vorsicht zu genießen, da die Parameter wie Chip-Größe, Packdichte und mehr nicht bekannt sind.

Am Ende geht es bei Samsung Foundry um ähnlich viel wie bei Intel Foundry. Ohne ein konkurrenzfähiges Produkt und den vielen Versprechen auch wirklich Taten folgen zu lassen, wird keine externe Kundschaft kommen. Erst einmal muss bekanntlich nun das eigene Haus überzeugt werden.

Apps & Mobile Entwicklung

Das könnte das Ende von Microsoft bedeuten

Microsoft hat sich durchaus aussichtsreich in einem Markt platziert, in dem ohne KI nichts mehr geht. Trotzdem hat CEO Satya Nadella seine Ängste geäußert, dass das Unternehmen schon bald genau wegen der künstlichen Intelligenz Geschichte sein könnte. Wieso blickt er so schwarz in die Zukunft?

Ja, Microsoft hat vieles richtig gemacht, was die KI-Entwicklung angeht. Durch den Partner OpenAI ist man bestens aufgestellt, konnte den eigenen Copilot mit GPT (der Technologie hinter ChatGPT) ausstatten. Dennoch schwant dem Firmen-Boss Satya Nadella derzeit nichts Gutes. Oder präziser gesagt: Er kann sich vorstellen, dass die künstliche Intelligenz eine jahrzehntelange Dominanz von Microsoft beendet.

Microsoft-CEO Satya Nadella warnt vor KI-Ära

Schon im Juli ließ Nadella durchblicken, dass sich Microsoft verändern muss, will das Unternehmen auch künftig noch die Relevanz haben, die wir von Microsoft seit 40 Jahren gewohnt sind. Wie „The Decoder“ berichtete, sei er der Meinung, dass das Bild einer reinen Software-Fabrik, wie sie Bill Gates einst erdachte, überholt sei.

Klar, Microsoft will nicht nur mitlaufen mit der KI-Entwicklung, sondern bestenfalls Treiber des Trends sein. Deswegen zündete Nadella jetzt die nächste Stufe, indem er sich an die Mitarbeitenden seines Konzerns wandte. Bezeichnenderweise berichtete er seinen Kolleg:innen von einem Unternehmen namens Digital Equipment Corporation.

Zwischen den 60er und 80er Jahren war dieses Unternehmen einer der größten Computerhersteller der Welt. Dass uns dieser Name heute so gut wie nicht mehr geläufig ist, sagt alles zur Entwicklung des Konzerns – und auch, wieso der Microsoft-Boss auf dieses Unternehmen verweist. Der Konzern hat sich strategisch seinerzeit schwer verhoben und konnte nur noch tatenlos zusehen, als Namen wie IBM an ihm vorbeischossen.

Deswegen ist es keine Panikmache, wenn Nadella heute sagt: „Alles, das wir vielleicht 40 Jahre lang geliebt haben, könnte keine Rolle mehr spielen“

Droht Gefahr hauptsächlich von OpenAI? Oder gar durch Elon Musk?

Microsoft will satte 80 Milliarden US-Dollar in KI-Rechenzentren stecken. Summen, bei denen selbst Meta und Google nicht mithalten können. Aber reicht das? Seinen Leuten gegenüber warnt Nadella davor, zu sehr in der Vergangenheit zu leben. Die notwendige Relevanz muss man sich heute wieder und wieder erkämpfen, und das auf einem KI-Markt, der nahezu täglich sein Gesicht wechselt.

Probleme könnten Microsoft ausgerechnet die Partner von OpenAI bereiten. Das KI-Schwergewicht, das mit ChatGPT die Tech-Welt komplett auf links krempelte, stellt nun seinerseits Forderungen. OpenAI möchte künftig selbst gewinnorientiert arbeiten wollen. Außerdem droht noch von anderer Seite Ungemach. Wie die Kolleg:innen von t3n berichten, will auch Elon Musk dem Platzhirsch der Betriebssysteme an die Wäsche, der immer noch über 70 Prozent Marktanteil hält.

Musk sagte, dass es prinzipiell möglich sein sollte, „ein Softwareunternehmen wie Microsoft vollständig mit KI zu simulieren“. Zusammen mit seiner spöttischen Ankündigung, sein nächstes KI-Unternehmen „Macrohard“ zu nennen, eine weitere Kampfansage Richtung Redmond. Ob das nur Dampfplauderei ist, wird sich in Zukunft zeigen müssen.

Microsoft ist sich also der Gefahr bewusst, investiert reichlich in die Zukunft und entlässt während des Umbaus zu einem zukunftsfähigen Unternehmen auch massenhaft Personal. 2023 mussten schon 10.000 Angestellte dran glauben, 2026 könnten – so berichtet Die Zeit – weitere round about 9.000 Jobs dran glauben müssen. Jeder, der seinen Gehaltsscheck von Microsoft bezieht, muss sich also nicht nur um die Zukunft des Unternehmens an sich, sondern kurzfristig auch um den eigenen Job sorgen.

Steht Microsoft wirklich vor dem Ende?

Es sieht so aus, als habe Microsoft die Zeichen der Zeit erkannt. Ob das rechtzeitig genug ist, um das mächtige Unternehmen am Leben zu halten, wird sich noch zeigen müssen. Was glaubt Ihr denn? Will der Microsoft sein Personal hier lediglich wachrütteln und für schwierige Zeiten sensibilisieren? Oder macht er sich ernsthafte Sorgen, dass Microsoft den gleichen Weg abwärts marschieren könnte, den vor ihm schon Unternehmen Nokia, Kodak oder BlackBerry gehen mussten?

Apps & Mobile Entwicklung

Erste iOS 26.1 Beta veröffentlicht: Mehr Liquid Glass und Sprachen für Apple Intelligence

Apple hat die erste Beta zu iOS 26.1 veröffentlicht. Das erste große Update nach iOS 26 baut Liquid Glass weiter aus, beginnt aber auch an einigen Stellen, den Glaseffekt zurückzuschrauben. Zudem werden bei Apple Intelligence und der Echtzeitübersetzung für die AirPods (Pro) neue Sprachen unterstützt.

Apple feilt an Liquid Glass

Mit dem Update überarbeitet Apple an einigen Stellen die neue Designsprache Liquid Glass, die mit iOS 26 debütiert ist. Heraussticht, dass Apple wohl an einigen Stellen weniger Liquid Glass und mehr frosted Glass verbaut. Die Änderungen beziehen sich aber vorerst auf die Fotos-App. Der Videoplayer erhält dadurch einen weißen Rand und einige UI-Elemente reagieren nicht mehr so empfindlich auf den Hintergrund. Dadurch verbessert sich die Lesbarkeit in einem Beispiel auf X deutlich. Im Browser Safari wurde zudem die Tab-Bar am unteren Bildschirmrand vergrößert.

Mehr Liquid Glass in einigen Apps

Zudem erhält die Telefon- und Kalender-App mehr Liquid Glass: Die Eingabetasten im Ziffernblock in der Telefon-App sind nun nicht mehr flach, sondern erhalten einen weichen Schlagschatten. Im Kalender werden Termine von mehrfarbigen Kalendern jetzt rund voll eingefärbt, anstelle, wie vor iOS 26 üblich, nur das Symbol einzufärben.

Problembehebungen notwendig

Ein beständiger Kritikpunkt in vielen Tests zum iPhone 17, 17 Pro und Air sind einige (grafische) Bugs in iOS 26, auch die Lesbarkeit wurde kritisiert. Ob das neue Update hier Schritte zu mehr Lesbarkeit und weniger grafischen Fehlern geht, wird sich erst noch zeigen müssen.

Weitere Sprachen für KI-Funktionen

Apple Intelligence erhält zwar keine neuen Funktionen, doch unterstützt es jetzt neben Englisch, Französisch, Deutsch, Italienisch, Portugiesisch (Brasilien), Spanisch, vereinfachtem Chinesisch, Japanisch und Koreanisch nun auch Dänisch, Schwedisch, Türkisch, traditionelles Chinesisch und Vietnamesisch.

Mehr Echtzeitübersetzung bei AirPods

Zudem fügt das Update auf iOS 26.1 auch neue Sprachen für die in Deutschland weiter nicht erhältliche Echtzeitübersetzung der AirPods (Pro) hinzu. Mit der Aktualisierung werden neben Englisch, Deutsch, Französisch, Portugiesisch und Spanisch auch Japanisch, Koreanisch, Italienisch, traditionelles Chinesisch und vereinfachtes Chinesisch unterstützt.

Update für Entwickler veröffentlicht

Das Update steht vorerst ausschließlich über den Entwickler-Kanal zur Verfügung, kann jedoch auch von normalen Nutzern bereits bezogen werden. Eine erste öffentliche Beta sollte für gewöhnlich jedoch in ein bis zwei Wochen folgen.

Zu beachten ist jedoch, dass, wenn in den kommenden Wochen ein Upgrade auf ein neues iPhone 17 ansteht, von einer Aktualisierung abgesehen werden sollte. Denn wenn geplant ist, ein Backup auf das neue Smartphone aufzuspielen, wird dieses auf iOS 26.1 generiert und kann nicht immer problemlos auf iOS 26 aufgespielt werden.

Apps & Mobile Entwicklung

Diese Funktion wird bei der Apple Watch vermisst

Die Venu-Serie ist die Smartwatch-Linie von Garmin, die sich an normale Nutzer richtet. Sie bietet weniger robuste Funktionen als die auf Abenteuer ausgerichteten Modelle der Marke, macht dies aber durch eine bessere Ästhetik und Tragbarkeit wieder wett. Diese Uhren haben sich bei bestimmten Bevölkerungsgruppen als beliebt erwiesen, und jetzt hat Garmin die Venu 4 vorgestellt, die dank sinnvoller Verbesserungen wie einer eingebauten Taschenlampe und einer EKG-Funktion mit Spannung erwartet wurde.

Wie die vorherige Generation ist auch die Venu 4 in zwei Größen erhältlich: 41 mm und 44 mm. Beide haben die bekannte runde Form und verfügen über ein berührungsempfindliches AMOLED-Display, das beim kleineren Modell 1,2 Zoll und beim größeren 1,4 Zoll groß ist. Garmin hat keine größeren Änderungen an den Display-Spezifikationen bekannt gegeben, sodass die Nutzer/innen die gleichen gut lesbaren und farbenfrohen Displays erwarten können. Jedes Display ist durch Gorilla Glass 3 geschützt und die Uhr ist bis zu 5 ATM wasserdicht.

Mehr Metall, weniger Knöpfe und eine Taschenlampe

Garmin hat subtile, aber bemerkenswerte Änderungen am Design vorgenommen. Die Venu 4 besteht jetzt aus Metall, hat aber weiterhin eine Lünette aus rostfreiem Stahl, wodurch sie sich hochwertiger anfühlt als die Venu 3 mit Polymerverkleidung. Die mittlere Taste auf der rechten Seite wurde entfernt, sodass nur noch zwei Tasten übrig sind. Damit setzt Garmin weiterhin auf Touchscreen-Navigation, insbesondere seit der Einführung von AMOLED-Displays in seiner gesamten Produktpalette.

Eine auffällige Neuerung ist die eingebaute LED-Taschenlampe, die sich am oberen Rand der Uhr befindet. Diese Funktion war bisher den auf Abenteuer ausgerichteten Modellen von Garmin vorbehalten und fehlt bei Premium-Konkurrenten wie der Apple Watch Ultra und der Galaxy Watch Ultra. Die Taschenlampe ist ein praktisches Tool für Outdoor-Enthusiasten, egal ob Ihr beim Trailrunning, beim Radfahren oder beim Navigieren in schwach beleuchteten Umgebungen unterwegs seid.

Neue Übungen und EKG

Garmin hat auch sein Fitnessangebot erweitert. Das Venu 4 enthält jetzt über 80 GPS- und Indoor-Workouts, die Triathlon-Training, Krafttraining und HIIT-Routinen umfassen. Es gibt 25 täglich vorgeschlagene Aktivitäten, die vom intelligenten Coaching-System von Garmin unterstützt werden. Outdoor-Nutzer profitieren von Multi-Band-GNSS für eine verbesserte Standortgenauigkeit.

Über die Fitness hinaus verfolgt das Venu 4 einen ganzheitlichen Ansatz für die Gesundheit. Es führt eine neue Gesundheitsstatus-Funktion ein, die Datentrends und Ausreißer analysiert, um mögliche Anzeichen von Krankheiten zu erkennen. Dies kann eine fundiertere Anleitung für Training und Erholung bieten.

Die Nutzer können jetzt auch Lifestyle-Faktoren wie Koffein- und Alkoholkonsum aufzeichnen, um zu sehen, wie diese Gewohnheiten das allgemeine Wohlbefinden beeinflussen. Auch das Schlaftracking wurde verbessert, mit neuen Ausrichtungswerkzeugen für bessere Konsistenz.

Zum ersten Mal in der Venu-Reihe verfügt die Uhr über EKG-Messungen auf Abruf, um Anzeichen von Vorhofflimmern zu erkennen – eine Funktion, die normalerweise teureren Modellen vorbehalten ist.

Die intelligenten Funktionen bleiben erhalten, darunter Sprachanrufe über Bluetooth, Unterstützung für den Sprachassistenten und Garmin Pay. Die Akkulaufzeit hat sich aufgrund der neuen Funktionen leicht verkürzt und beträgt 12 Tage im Smartwatch-Modus, 4 Tage bei aktiviertem Always-on-Display und bis zu 19 Stunden im GNSS-Modus.

Preise und Verfügbarkeit

Die Venu 4 ist teurer als ihr Vorgängermodell und kostet in den USA 549,99 US-Dollar mit einem Polymerband oder 599,99 US-Dollar mit einem Lederband. Sie ist in den Farben Gold, Silber und Schwarz erhältlich und wird ab heute ausgeliefert.

-

UX/UI & Webdesignvor 1 Monat

UX/UI & Webdesignvor 1 MonatDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 3 Wochen

UX/UI & Webdesignvor 3 WochenAdobe Firefly Boards › PAGE online

-

Social Mediavor 1 Monat

Social Mediavor 1 MonatRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

Entwicklung & Codevor 1 Monat

Entwicklung & Codevor 1 MonatPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 3 Wochen

Entwicklung & Codevor 3 WochenEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

UX/UI & Webdesignvor 1 Woche

UX/UI & Webdesignvor 1 WocheFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online

-

Digital Business & Startupsvor 3 Monaten

Digital Business & Startupsvor 3 Monaten10.000 Euro Tickets? Kann man machen – aber nur mit diesem Trick

-

Digital Business & Startupsvor 3 Monaten

Digital Business & Startupsvor 3 Monaten80 % günstiger dank KI – Startup vereinfacht Klinikstudien: Pitchdeck hier