Datenschutz & Sicherheit

Chrome: Google stopft attackierte Sicherheitslücke

Google verteilt ein ungeplantes Update für den Webbrowser Chrome – auf eigentlich allen unterstützten Plattformen. Ursache ist eine bereits aktiv im Internet angegriffene Sicherheitslücke im Browser.

In der Versionsankündigung schreiben die Chrome-Entwickler, dass die Aktualisierung lediglich einen Sicherheitsfix enthält. Es handelt sich um eine Schwachstelle vom Typ „Type Confusion“, bei dem unerwartete Datentypen an Programmcode-Teile übergeben werden. Das löst unerwartetes Verhalten aus und Angreifer können im konkreten Fall, der die JavaScrip-Engine V8 betrifft, das für beliebige Schreib- und Lesezugriffe durch sorgsam präparierte, bösartige Webseiten missbrauchen (CVE-2025-6554 / noch kein EUVD, kein CVSS, Risiko laut Google „hoch„).

Attackiertes Sicherheitsleck

Gegenmaßnahmen durch eine Konfigurationsänderung hat Google bereits am 26. Juni für alle Plattformen im Stable-Kanal verteilt. Die Lücke hatte am 25. Juni die Google Threat Analysis Group entdeckt. Die Schwachstelle schließen die Entwickler nun jedoch korrekt mit Code-Änderungen. „Google ist bekannt, dass ein Exploit für CVE-2025-6554 in freier Wildbahn existiert“, ergänzen die Entwickler zudem – die Sicherheitslücke wird also bereits von bösartigen Akteuren missbraucht.

Den Fehler bügeln die Versionen Chrome 138.0.7204.63 für Android, 138.0.7204.119 für iOS, 138.0.7204.96 für Linux, 138.0.7204.92/.93 für Mac und schließlich 138.0.7204.96/.97 für Windows aus. Die Extended-Stable-Fassungen hieven die Entwickler zudem auf die Versionen 138.0.7204.93 für macOS und 138.0.7204.97 für Windows.

Aktuellen Versionsstand prüfen

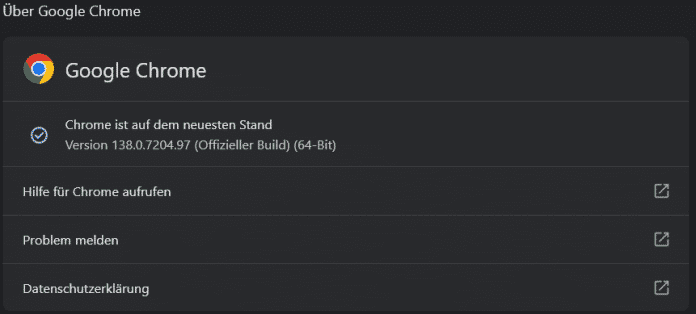

Um zu prüfen, ob Chrome bereits auf dem aktuellen Stand ist, können Nutzerinnen und Nutzer den Versionsdialog aufrufen. Den erreichen sie durch Klick auf das Symbol mit den drei aufgestapelten Punkten rechts von der Adressleiste und dort den weiteren Weg über „Hilfe“ hin zu „Über Google Chrome“. Das stößt gegebenenfalls auch den Update-Vorgang an, wenn der Browser veraltet ist.

Der Versionsdialog von Chrome zeigt den aktuell laufenden Softwarestand an. Gegebenenfalls bietet er zudem an, den Browser zu aktualisieren.

(Bild: Screenshot / dmk)

Auf anderen Plattformen sind die App-Stores oder etwa unter Linux die Distributions-spezifische Softwareverwaltung für die Aktualisierung zuständig. Da der Chromium-Code die Basis für andere Webbrowser wie Microsofts Edge darstellt, dürften auch diese in Kürze aktualisierte Fassungen verteilen. Nutzer sollten diese dann zügig installieren.

Zuletzt hatte Google Anfang Juni eine bereits angegriffene Schwachstelle in Chrome ausgebessert. Auch diese Sicherheitslücke haben die Entwickler zunächst durch das Verteilen einer Konfigurationsänderung abgemildert.

(dmk)

Datenschutz & Sicherheit

„Abkehr von der grundrechtsfreundlichen Politik“

Die Berliner schwarz-rote Koalition will ein neues Polizeigesetz beschließen, das in Berlin unter dem Namen Allgemeines Sicherheits- und Ordnungsgesetz (ASOG) firmiert. Berlin folgt damit einer ganzen Reihe von Bundesländern, die ihre Polizeigesetze in den letzten Jahren verschärft haben. An der Berliner Gesetzesnovelle gibt es breite Kritik sowohl von der demokratischen Opposition im Parlament wie auch von der Berliner Datenschutzbeauftragten und Menschenrechtsorganisationen wie der GFF.

Anlässlich der Sachverständigenanhörung am Montag protestieren vor dem Roten Rathaus Lilly und Kiki. Sie verteilen Flyer mit der Aufschrift „Nein zu Massenüberwachung und der Kriminalisierung von Protesten“. Sie sind Teil eines Bündnisses zivilgesellschaftlicher Gruppen wie Amnesty International oder dem Komitee für Grundrechte und Demokratie.

„Überall werden Gelder gekürzt, aber für Videoüberwachung ist dann plötzlich Geld da. Dabei verhindert die keine Straftaten, sondern kriminalisiert marginalisierte Gruppen und spaltet den öffentlichen Raum“, sagt Lilly. Dass die Unverletzlichkeit der Wohnung durch die Gesetzesnovelle eingeschränkt wird, sehen die beiden ebenso kritisch.

„Abkehr von der grundrechtsfreundlichen Politik“

Auch in der Sachverständigen-Anhörung hagelt es Kritik für den Entwurf. So sieht die Berliner Datenschutzbeauftragte Meike Kamp eine Vielzahl neuer Datenverarbeitungsermächtigungen und eine erhebliche Ausweitung der Befugnisse der Polizei. Aufgrund der Detailtiefe – die Gesetzesnovelle ist 700 Seiten stark – habe ihre Behörde nicht einmal alle Vorschriften analysieren können.

Das Volumen der geplanten Änderungen kritisiert auch Innenpolitiker Niklas Schrader von der Linken. Denn so umfangreich wie der Gesetzentwurf sei auch der Überarbeitungsbedarf: „Ich bin mir nicht sicher, ob das in dem kurzen Zeitplan, den Sie uns gegeben haben, schaffbar ist“, sagt er bei der Anhörung.

Eine „Abkehr von der grundrechtsfreundlichen Politik“ in Berlin beklagte der Jurist David Werdermann von der GFF sowohl in seiner Stellungnahme (PDF) wie auch in der Anhörung. Zwar versuche der Entwurf die Rechtsprechung des Bundesverfassungsgerichts nachzuzeichnen, das gelinge allerdings nicht immer.

Ein Hauptkritikfeld an dem Gesetz ist laut Werdermann das Festhalten am Konstrukt der „krininalitätsbelasteten Orte“. An diesen dürfen in Zukunft nicht nur anlasslose Kontrollen durchgeführt werden, sondern auch Videoüberwachungsmaßnahmen. Das Gesetz erlaube zudem die Videoüberwachung von öffentlichen Veranstaltungen und die Auswertung des Videomaterials mit sogenannter KI. Werdermann warnt hier vor einem höheren Überwachungsdruck auf Menschen mit atypischen Verhalten wie beispielsweise Wohnungslosen oder Personen mit körperlichen Einschränkungen.

Berliner Senat will Verhaltenscanner gegen Bevölkerung einsetzen

Kritik hat die GFF auch am Einsatz von Staatstrojanern und daran, dass die Polizeibehörden in Zukunft heimlich Wohnungen betreten dürfen, um diese zu installieren. „Ich habe da große Bauchschmerzen mit“, sagt Werdermann. Insgesamt wird durch das neue ASOG die Schwelle zum Einsatz der Staatstrojaner und zur Überwachung von Wohnungen deutlich herabgesetzt.

Ebenso kritisch sieht Werdermann den nachträglichen biometrischen Abgleich mit öffentlich zugänglichen Daten: „Jedes Foto, das möglicherweise ohne das Wissen und Einverständnis der betroffenen Person ins Netz gestellt wird, kann zu Überwachungszwecken genutzt werden“, sagt Werdermann. Es sei nach der neuen Gesetzeslage nicht mehr möglich, an einer Versammlung teilzunehmen, ohne damit rechnen zu müssen, dass Fotos, die beispielsweise von der Presse veröffentlicht werden, anschließend von der Polizei für einen Abgleich genutzt würden.

„Freifahrtschein für Massenüberwachung“

„Die Vorschrift schließt zudem weder den Aufbau einer biometrischen Referenzdatenbanken auf Vorrat noch die Nutzung von kommerziellen Datenbanken aus“, schreibt Werdermann in seiner Stellungnahme. Beides sei jedoch mit der KI-Verordnung und dem Recht auf informationelle Selbstbestimmung nicht vereinbar.

Werdermann verweist in der Stellungnahme darauf, dass der Aufbau einer umfassenden biometrischen Referenzdatenbank – bestehend aus öffentlich zugänglichen Lichtbildern, Videos und Tonaufnahmen aus dem Internet – unverhältnismäßig in Grundrechte eingreift. Das Bundesverfassungsgericht habe mehrfach herausgestellt, dass biometrische Daten besonders schutzwürdig seien. „Durch den Aufbau einer Datenbank, um biometrische Daten vorzuhalten, wären Grundrechte von Millionen, wenn nicht Milliarden von unbeteiligten Personen betroffen, die keinen Anlass für polizeiliche Überwachung gegeben haben“, so Werdermann weiter.

Statt konsequent gegen rechtswidrige Angebote wie PimEyes vorzugehen, schaffe der Senat mit dem Entwurf eine Grundlage für biometrische Massenüberwachung durch die Berliner Polizei, schreibt Werdermann. Diese kritisiert auch die grüne Innenpolitikerin Gollaleh Ahmadi. Sie sieht in der Gesetzesnovelle einen „Freifahrtschein für Massenüberwachung“.

Wir sind ein spendenfinanziertes Medium

Unterstütze auch Du unsere Arbeit mit einer Spende.

Berlins Datenschutzbeauftragte Meike Kamp kritisiert auch die Verarbeitung von Daten zum Training von KI-Systemen. Hier dürfe zuviel Material ohne Eingriffsschwelle und Löschfristen genutzt werden, sie gehe zudem davon aus, dass auch nicht-anonymisierte Klardaten verarbeitet würden. Daten, die einmal zum Training von Künstlicher Intelligenz genutzt wurden, ließen sich nicht mehr löschen, betont Kamp. Zudem vermute sie, dass solche Daten auch in automatisierten Analyseplattformen landen, deren Nutzung der Berliner Polizei künftig erlaubt sein soll. Zu solchen Plattformen gehört auch die Software „Gotham“ vom umstrittenen US-Unternehmen Palantir.

Präventive Funkzellenabfrage

Ebenso zu wenig geregelt seien die Funkzellenabfragen, wo die Eingriffsschwellen zu niedrig seien. Hier sei auch davon auszugehen, dass Funkzellendaten für KI-Training genutzt werden. „Durch die Verknüpfung der erhobenen Daten mit automatisierten Analyseplattformen lassen sich detaillierte Bewegungsprofile erstellen. Dies ermöglicht Rückschlüsse auf politische Aktivitäten, soziale Beziehungen und persönliche Gewohnheiten der Betroffenen“, schreibt die Berliner Datenschutzbeauftragte in ihrer Stellungnahme (PDF).

Der grüne Innenpolitiker Vasili Franco kritisiert, dass die Funkzellenabfragen in Zukunft auch gegen Personen gerichtet sein können, die nur vermutlich an einer Straftat teilnehmen werden. Damit verschiebt das neue Polizeigesetz die Funkzellenabfragen von der nachträglichen Ermittlung in den präventiven Raum.

Sowohl Sachverständige wie auch Oppositionspolitiker:innen verwiesen in der Anhörung darauf, dass man das verschärfte Polizeigesetz auch vor dem Hintergrund des Rechtsrucks sehen müsse – und dass man damit einer möglichen autoritären Regierung Werkzeuge in die Hand gebe.

Dokumente

Stellungnahmen von Sachverständigen zur Novelle des Berliner ASOG

Datenschutz & Sicherheit

Berliner Senat will Verhaltenscanner gegen Bevölkerung einsetzen

Diese Software erkennt, was du tust. Sie bestimmt anhand von Videobildern, was auf dem überwachten Areal gerade passiert. Sie untersucht, ob jemand steht, sitzt, kniet, läuft, rennt, tanzt, taumelt, liegt, kämpft, würgt, etwas trägt, zieht oder schiebt, Fahrrad- und Roller fährt, eine andere Person umarmt oder festhält. Und in Zukunft soll die Liste noch erweitert werden.

Die Technologie ist in Mannheim seit sieben Jahren und in Hamburg seit Anfang September im testweisen Einsatz und noch fern davon, wirklich praktischen Nutzen zu entfalten. Weiterhin müssen Menschen die Bildschirme kontrollieren und die Alarme der KI werden hauptsächlich zu ihrer Weiterentwicklung genutzt, so die Mannheimer Polizei auf netzpolitik.org-Anfrage.

Dennoch zieht das System deutschlandweit das Begehren zahlreicher Kommunen auf sich. Berlin will sich ebenfalls der Runde der testenden Städte anschließen, das bekannte der Senat gerade in einer Anhörung des Innenausschusses. Dort hieß es mit Bezug auf Mannheim und Hamburg: „Wir hoffen, in das Kooperationsprojekt einsteigen zu können, um das System mit den anderen Partnern zu entwickeln.“

KI-Kameras am Görlitzer Park

Dabei bieten die beteiligten Städte nur die Testumgebung und die Laborratten – meist arglose Passant*innen der Überwachungskameras. Entwickelt wird das System vom Fraunhofer-Institut für Optronik, Systemtechnik und Bildauswertung. Dieses hat auch das alleinige Recht zur kommerziellen Vermarktung der Verhaltenserkennungs-KI, sich allerdings dazu bereit erklärt, vorläufig noch darauf zu verzichten.

Wir sind ein spendenfinanziertes Medium

Unterstütze auch Du unsere Arbeit mit einer Spende.

Nach dem neuen Berliner Polizeigesetz, das unter anderem die rechtliche Grundlage für das KI-Training liefern und noch dieses Jahr im Abgeordnetenhaus beschlossen werden soll, kann die KI mit verschiedenen Arten von Videobildern gefüttert werden. Vor allem wären da Bilder von Überwachungskameras, die Berlin künftig an sogenannten kriminalitätsbelasteten Orten – wie zum Beispiel dem Görlitzer Park – erlauben will. Dazu können aber auch Videos von öffentlichen Veranstaltungen und Ansammlungen und Aufnahmen von gefährdeten Gebäuden und Objekten, sowie Übersichtsaufnahmen zur Vorbereitung, Lenkung und Leitung von Einsätzen, wie sie aktuell aus Hubschraubern und künftig auch aus Drohnen aufgenommen werden können, per Algorithmus nach bestimmten Verhaltensmustern durchsucht werden dürfen.

„Die Gefahr ist nicht von der Hand zu weisen, dass dann große Teile der Berliner Innenstadt nicht mehr unüberwacht passiert werden können“, sagte Meike Kamp, Berliner Datenschutzbeauftragte bei der Sachverständigenanhörung im Berliner Abgeordnetenhaus. David Werdermann, Jurist von der Gesellschaft für Freiheitsrechte (GFF) fügte hinzu: „Es ist zu befürchten, dass Menschen, die sich atypisch im öffentlichen Raum verhalten – wie wohnungslose oder körperlich eingeschränkte – von der Software als gefährlich erkannt werden und damit erhöhtem Überwachungsdruck ausgesetzt sind.“

„Lieber einmal zuviel“

Die Polizeipräsidentin Barbara Slowik Meisel verteidigte den geplanten KI-Einsatz. Ihr Hauptargument: Effizienz. Die Aufgaben der Polizei würden wachsen, während die Nachwuchsgewinnung schwierig sei. „Ohne technologische Unterstützung werden wir die Sicherheit der Stadt nur noch immer begrenzter gewährleisten können.“ Deshalb wünsche sie sich das „Mannheimer System“, „das bestimmte Szenarien erkennt um dann Internventionskräfte zu alarmieren. Das ist deutlich ressourcenschonender.“

Dabei übersieht Slowik Meisel, dass die Technologie in Mannheim aktuell keinerlei Arbeitserleichterung bringt, sondern eher Kräfte bindet. Slowik Meisel würde die KI zudem so kalibrieren, dass sie viele falschpositive Ergebnisse liefern, die dann gegebenenfalls zu erhöhtem Arbeitsaufwand und Überwachungsdruck auf Unschuldige führen. „Lieber kommen wir einmal zu viel, wenn das System zu schnell anschlägt, als einmal zu wenig“, sagte sie.

Datenschutz & Sicherheit

Cyberangriff: Milliardenkredit für Jaguar Land Rover

Die britische Regierung hilft dem durch einen Cyberangriff angeschlagenen Autobauer Jaguar Land Rover mit der Garantie für einen Milliardenkredit aus. Mit bis zu 1,5 Milliarden Pfund (umgerechnet 1,7 Mrd. Euro) solle die Lieferkette des Unternehmens abgesichert werden, teilte Wirtschaftsminister Peter Kyle mit. Der Kredit kommt von einer Geschäftsbank.

Am Montag wurde überdies bekannt, dass der Autobauer einen Kredit in Höhe von 2 Milliarden Pfund von globalen Banken aufnimmt. Die Citigroup, Mitsubishi UFJ Financial Group und Standard Chartered Bank haben sich laut der Economic Times (via Bloomberg) bereit erklärt, einen 18-monatigen, betragsmäßig Kreditrahmen zu gewähren, wie mit der Angelegenheit vertraute Personen mitteilten. Die Produktion wird sich voraussichtlich erst bis November normalisieren.

Der Autobauer war am 31. August Ziel einer Cyberattacke geworden, die Produktion in den Werken im Vereinigten Königreich steht noch bis mindestens zum 1. Oktober still. Es werde rund um die Uhr gemeinsam mit Spezialisten, dem Nationalen Zentrum für Cybersicherheit in Großbritannien und der Polizei zusammengearbeitet, um den Betrieb auf sichere Weise wieder aufzunehmen, hatte Jaguar Land Rover mitgeteilt.

„Dieser Cyberangriff war nicht nur ein Angriff auf eine ikonische britische Marke, sondern auch auf unseren weltweit führenden Automobilsektor und auf die Frauen und Männer, deren Lebensunterhalt davon abhängt“, sagte Kyle.

Wer hinter der Cyberattacke steckt, ist weiterhin unklar. Der in Großbritannien ansässige Autobauer, der zum indischen Tata-Konzern gehört, hatte mitgeteilt, es seien „einige Daten“ gestohlen worden, nannte aber keine Details.

Update

29.09.2025,

14:44

Uhr

Informationen zum zusätzlichen Kredit ergänzt.

(afl)

-

UX/UI & Webdesignvor 1 Monat

UX/UI & Webdesignvor 1 MonatDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 1 Monat

UX/UI & Webdesignvor 1 MonatAdobe Firefly Boards › PAGE online

-

Social Mediavor 1 Monat

Social Mediavor 1 MonatRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

Entwicklung & Codevor 1 Monat

Entwicklung & Codevor 1 MonatPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 4 Wochen

Entwicklung & Codevor 4 WochenEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

UX/UI & Webdesignvor 2 Wochen

UX/UI & Webdesignvor 2 WochenFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online

-

Digital Business & Startupsvor 3 Monaten

Digital Business & Startupsvor 3 Monaten10.000 Euro Tickets? Kann man machen – aber nur mit diesem Trick

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenFirefox-Update 141.0: KI-gestützte Tab‑Gruppen und Einheitenumrechner kommen