Künstliche Intelligenz

Wie Studierende KI an der Uni nutzen – und was Experten davon halten

Es ist 23 Uhr. Die Abgabefrist der Hausarbeit ist am nächsten Morgen. Im schlimmsten Fall bedeutet das eine mühselige Nachtschicht, um noch irgendwie zu bestehen. Für viel mehr ist keine Zeit.

Diese Erfahrungen machen einige Menschen während ihres Studiums. Doch vielleicht bekommen zukünftige Absolvent:innen mehr ruhige Nächte. Denn immer häufiger ist ChatGPT die Antwort auf die Forschungsfrage in der Hausarbeit. Ein nicht repräsentativer Forschungsbericht der Hochschule Darmstadt legt nahe, dass bereits 90 Prozent aller Studierenden in Deutschland KI-Tools für die Uni nutzen.

Einer von ihnen ist Alex (Name geändert). Er greift im Studium öfter auf ChatGPT zurück. Der 23-Jährige studiert Kindheitspädagogik in Hildesheim. „Ich habe mir tatsächlich auch schon unbenotete Arbeiten davon schreiben lassen“, erklärt er. Für ihn ist die generative KI eine Erleichterung. Die Universitäten stehen bei Studierenden wie Alex dagegen vor einer großen Aufgabe. Denn durch die großen Sprachmodelle verändert sich die Art, wie Wissen überprüft wird. Aber wie sollten Hochschulen damit umgehen?

Bitte nicht verbieten

Martin Wan beschäftigt sich mit Fragen wie diesen. Er ist Projektleiter für die Hochschulrektorenkonferenz (HRK) im Hochschulforum Digitalisierung (HFD). Das HFD unterstützt Hochschulen dabei, Fragen zum Einsatz von KI etwa im Studium und der Lehre zu meistern. Während es vereinzelte Stimmen gibt, die nach einem Verbot rufen, hält Wan solche Maßnahmen für falsch. „Die Technologie existiert nun mal. Dadurch ist ein reflektierter Umgang wichtig, der auch an Hochschulen eingeübt werden muss“, sagt er.

Dass es sich dabei um einen langwierigen Prozess handelt, zeigt sich anhand vieler Beispiele. Von einem reflektierten Umgang scheint man nämlich noch weit entfernt zu sein. Im Netz, etwa auf Reddit, berichtet ein Professor über die miserablen Prüfungsleistungen seiner Studierenden. Von zehn korrigierten Bachelorarbeiten seien vier durchgefallen. Alle Student:innen hätten entweder Quellen erfunden oder unpassende Quellen verwendet. Die Vermutung: Die KI hat bei der Literatur halluziniert und Inhalte erfunden. Es ist nicht die einzige Geschichte dieser Art. Das Magazin Rolling Stone berichtete etwa über einen texanischen Professor, der einen Großteil seines Kurses wegen der Verwendung von ChatGPT durchfallen lassen wollte.

In Deutschland gab es bislang nur in einem Fall ein rechtskräftiges Urteil. Die TU München lehnte einen Bewerber ab, der im Motivationsschreiben mutmaßlich KI eingesetzt haben soll. Das Verwaltungsgericht gab der Uni recht und der Bewerber wurde nicht zugelassen. Das Gericht traute den Professor:innen zu, KI-Arbeiten zu erkennen.

„Wenn Studierende die KI nicht kompetent beherrschen, dann kommt ein Bullshit-Bingo heraus“, sagt auch Bernhard Ertl, der an der Universität der Bundeswehr in München zum Lernen und Lehren mit Medien forscht. „Da weiß ich sofort: Diese Textstellen hat noch niemand zuvor gelesen, weil Teile davon einfach hanebüchen sind.“

Die KI als Werkzeug

Bei Maximilians Hausarbeiten wird wohl kein Bullshit-Bingo herauskommen. Der 24-Jährige studiert Data Science im Master an der TU Wien. Statt ChatGPT als Ghostwriter zu verwenden, nimmt er das Tool lieber als Startpunkt für seine Recherche. „Wenn ich am Anfang von einer Hausarbeit einen gewissen Überblick über den Themenbereich bekommen muss, dann eignet sich ChatGPT schon sehr gut“, erklärt er. „Ich kann quasi am Anfang, basierend auf der Forschungsfrage, direkt eine Idee bekommen, wie der aktuelle Stand der Wissenschaft da aussieht.“

Alex geht anders an die Aufgabe. Er recherchiere erst Literatur. „Dann lasse ich ChatGPT den Text so schreiben, dass meine Literatur dafür passt“, sagt er. Entdeckt er bei seiner Recherche Wörter, die er nicht versteht, lasse er sich diese von der KI erklären. Maximilian macht es ähnlich. „So kann ich komplexere Themen runterbrechen, falls ich mal wirklich nichts verstehe“, sagt der Wiener Student. „Oft kann ChatGPT das in eine verständlichere Sprache übersetzen.“

Bernhard Ertl hält den Ansatz für sinnvoll, ChatGPT als ergänzende Hilfe zu verwenden. „Die KI kann ein Werkzeug sein, mit dem die Studierenden zu besseren Ergebnissen kommen, wenn sie sich entsprechend in dieses Werkzeug reinarbeiten“, sagt er. Doch das ist nicht immer der Fall. „Dann wird es schlechter, weil sie einfach nur Prompts machen und was generiert wird, in die Arbeit einfügen, und das nicht verstehen“, ergänzt er.

KI oder keine KI

Alex glaubt, dass es für die Dozierenden kaum erkennbar sei, ob er oder die KI die Hausarbeit geschrieben hat. „Ich muss auch sagen, ich hatte immer Angst, wenn meine Arbeiten durch Plagiatsprüfer überprüft werden. Aber auch da muss ich sagen: Es hat bis jetzt jedes Mal funktioniert“, erzählt er.

Plagiatsprüfer überprüfen, ob die Autor:innen ihren Text abgeschrieben haben. Dabei vergleichen sie die Arbeit mit einer Datenbank aus wissenschaftlichen Texten. Am Ende kommt dabei eine Prozentzahl raus, die bestimmt, wie viel der eingereichte Text denen aus der Datenbank ähnelt. Oft braucht es allerdings eine genaue Überprüfung, um herauszufinden, ob es sich um Ähnlichkeiten oder um wirkliche Plagiate handelt.

Wer beim Abschreiben erwischt wird, fällt durch. Das gilt auch, wenn die KI zufällig dieselben Wörter verwendet. Mittlerweile gibt es auch KI-Detektoren. Die sollen erkennen, ob Studierende bei ihrer Arbeit Texte mit einem KI-Chatbot geschrieben haben. Eine Studie der British University Vietnam und der James Cook University in Singapur zeigt: Oft sind diese Tools sehr ungenau. Einrichtungen wie die Uni Hannover verwenden deswegen Tools dieser Art nicht. In einer Stellungnahme der Universität zur Verwendung von KI-Detektoren heißt es, dass „die Ressourcen der Hochschulen besser in die Anpassung der Prüfungskultur und -formate gesteckt werden sollten“.

Wer das als Freifahrtschein für die KI-Nutzung sieht, sollte trotzdem auf die KI-Richtlinien der jeweiligen Universität achten. So muss man etwa an der Universität zu Köln kenntlich machen, ob und wie KI bei einer Hausarbeit verwendet wurde. Das bereits erwähnte Gerichtsurteil aus München greift die Universität auch auf. „Bei Täuschungshandlungen kann dabei der sogenannte Anscheinsbeweis geführt werden“, heißt es auf der Webseite. Sollten Prüfer:innen mögliche Anzeichen wie erfundene Quellen für eine unrechtmäßige KI-Nutzung feststellen, zählt das in Köln als Täuschung.

Wissensabfragen für Fortgeschrittene

Eine Studie aus dem „International Journal of Educational Technology in Higher Education“ zeigt auch andere Beweggründe auf, ChatGPT in der Uni zu nutzen. Dabei decken die Forscher:innen auf, dass Studierende, die unter großem Druck stehen und einen hohen Workload haben, eher auf ChatGPT zurückgreifen. Besonders vorsichtige Studierende schrecken eher vor der Verwendung zurück – aus Angst vor Konsequenzen.

Wenn Studierende wie Alex Hausarbeiten mit ChatGPT schreiben, ist das für Wan ein Warnsignal. „Ist die Art und Weise, wie wir prüfen, sinnvoll? Fördern wir damit Kompetenzen?“, fragt er. Die Studie zeigt nämlich auch: Wer ChatGPT während des Studiums exzessiv nutzt, erzielt schlechtere Ergebnisse. Trotzdem oder vielleicht sogar deswegen sieht Wan in der KI eine Chance, eine moderne Prüfungskultur zu schaffen, die nicht stumpf Wissen abfragt und stattdessen die Anwendung in den Fokus stellt.

Einen offenen Umgang mit dem Thema gibt es laut Alex an seiner Hochschule nicht. „Ich habe da jetzt noch nicht wirklich viel mitbekommen“, erzählt er. Auf der Webseite der Universität finden sich hingegen viele Infos. Sogar einen kostenlosen Zugang zu ChatGPT 4o samt Handlungsempfehlungen für Studierende gibt es. Lehrende sind etwa angewiesen, Prüfungsaufgaben so zu stellen, dass eine KI nicht ausreicht, um sie zu beantworten.

KI verändert das Lernen

Wan und Ertl sind sich einig: Es braucht die passenden Strukturen für KI. Dafür hat die Hochschulrektorenkonferenz auf über 40 Seiten sieben Handlungsempfehlungen verfasst. Darunter fällt zum Beispiel, dass es ein größeres Verständnis über das Thema benötigt oder Hochschulen Räume für einen interdisziplinären Austausch fördern sollten. „Vor allem empfehlen wir auch nochmal ganz klassische Kompetenzen wie Quellen- und Ideologiekritik einzuüben“, so Wan.

Studierende sollten sich bewusst sein, dass KI-Tools halluzinieren und nicht belegbare Dinge als Fakten darstellen können. „Und das geht bis zu einer Ideologiekritik der Anbieter“, führt Wan fort. Beim Verwenden von Deepseek sollte man im Hinterkopf haben, dass das Tool eher Antworten liefert, die der ideologischen Linie der chinesischen Regierung entsprechen.

Bernhard Ertl arbeitet gerade an einem Projekt, bei dem interkulturelle Trainings mit einem KI-Avatar erleichtert werden sollen. „Das funktioniert ganz gut, wenn es etwa ein Englisch-Training ist, damit die Leute Übung bekommen, in der Sprache zu reden“, erklärt der Professor. Avatare dieser Art sollen aber auch als Lernpartner funktionieren, „der die Leute beim Lernen unterstützt, Fragen beantwortet oder Sachen zusammenfasst.“

Für Studierende wäre das wohl ein Segen. Zumindest erzählen sowohl Alex als auch Maximilian, dass Künstliche Intelligenz ihren Uni-Alltag enorm erleichtert – entweder als Recherche-Hilfe, als Erklär-Tool, aber auch als Ghostwriter. Wer KI falsch in der Uni einsetzt, lernt nicht nur weniger, sondern läuft auch Gefahr, eine schlechte Prüfungsleistung abzugeben. Das Studium wird durch die Sprachmodelle also nicht komplett abgeschafft.

Hochschulen stehen nun vor der Aufgabe, KI so in die Studiengänge zu integrieren, dass Studierende bewusst damit umgehen können. Dafür müssen sie auch überarbeiten, wie sie gelerntes Wissen prüfen, damit nicht mal eben ganze Hausarbeiten gepromptet werden können. Ertl geht davon aus, dass KI den Status von Computern oder Internet-Tools einnehmen wird, die Studierende durch ihren Alltag begleiten. „Das ist ähnlich wie mit einem Hammer“, sagt er. „Ich muss den Hammer so bedienen, dass ich mir nicht auf die Finger haue und dann der Nagel so in der Wand ist, damit das Bild hängen bleibt.“

Dieser Beitrag ist zuerst auf t3n.de erschienen.

(jle)

Künstliche Intelligenz

No-Code-Plattform SeaTable integriert KI-Automatisierung | heise online

Der deutsche Anbieter SeaTable hat Version 6.0 seiner No-Code-Plattform veröffentlicht. Die neue Version integriert erstmals KI-Funktionen direkt in die Automatisierungsregeln der Tabellen- und Workflowsoftware. Nutzer können mit der KI Texte analysieren, Dokumente auswerten oder Informationen extrahieren.

Weiterlesen nach der Anzeige

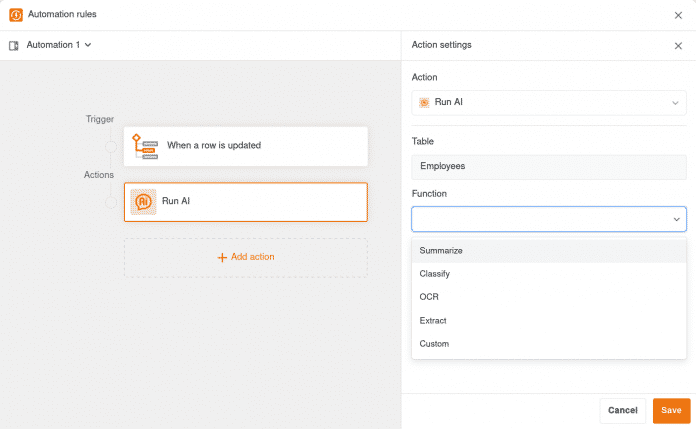

Die KI-Integration umfasst dedizierte Funktionen für Standardaufgaben: Summarize fasst Texte zusammen, OCR erkennt Text in Bildern, Extract zieht spezifische Informationen aus Dokumenten und Classify ordnet Inhalte in Kategorien ein. Für weitere Anwendungsfälle steht eine Custom-Funktion bereit, die ausschließlich auf Basis eigener Prompts arbeitet. Spalteninhalte lassen sich dabei durch Referenzierung in geschweiften Klammern direkt einbinden.

Die neuen KI-Funktionen in SeaTable für die Automatisierung, die Standardaufgaben übernehmen können.

(Bild: SeaTable)

Als KI-Modell setzt SeaTable Cloud auf Gemma 3 mit 12 Milliarden Parametern. Das multimodale Large Language Model von Google läuft auf Servern von Hetzner Online in Deutschland und wird von den SeaTable-Administratoren selbst betrieben. Der Datenaustausch erfolgt verschlüsselt, Informationen werden nicht an externe KI-Anbieter oder ins Ausland übertragen. Enterprise-Kunden erhalten 500 AI-Credits pro Teammitglied, die umfangreiche Tests ermöglichen; für produktive Workloads sind zusätzliche Credits erforderlich.

Allerdings können Nutzer, die SeaTable Server selbst betreiben, genauso eigene LLMs einsetzen oder die neue Komponente SeaTable AI nutzen. Letztere basiert auf LiteLLM und unterstützt viele Modelle und Anbieter, darunter alle LLM-Dienste mit OpenAI-kompatibler API. Die Bereitstellung erfolgt via Docker oder Docker Compose.

Überarbeiteter Editor und neue Ansichten

Neben den KI-Funktionen bringt Version 6.0 einen komplett überarbeiteten Editor für Automatisierungsregeln. Dieser erstreckt sich über die gesamte Bildschirmbreite und bietet eine workflow-orientierte Benutzeroberfläche. Zudem ersetzen die neuen Ansichtstypen Kalender, Kanban und Galerie die bisherigen Plug-ins gleichen Namens und unterstützen nun Features wie View-Sharing, private Ansichten und kollaborative Datenbearbeitung in Echtzeit.

Weiterlesen nach der Anzeige

Alle Informationen zum neuen Release finden sich im SeaTable-Blog. Die SeaTable Cloud wurde bereits auf Version 6.0 aktualisiert. Wer die Software selbst betreibt, kann das stabile Release aus dem Docker Repository herunterladen. Für die kommenden Updates plant SeaTable die Integration weiterer KI-Modelle von OpenAI, Anthropic, Meta, xAI und dem europäischen Anbieter Mistral sowie die Entwicklung eines KI-Assistenten und MCP-Servers.

(fo)

Künstliche Intelligenz

8. Product Owner Day: Jetzt noch Tickets für den 13. November sichern

Am 13. November 2025 findet bereits zum achten Mal der Product Owner Day statt – mit praxisnahen Inhalten zu aktuellen Themen in der Produktentwicklung. Die diesjährige Ausgabe der Online-Konferenz von dpunkt.verlag und iX in Kooperation mit it-agile befasst sich unter anderem mit Tools wie Jira und Nave sowie mit künstlicher Intelligenz, aber auch mit Hindernissen im Projekt. Zwei Online-Workshops rund um die Konferenz behandeln teamübergreifenden Flow und die Methodik OKR (Objectives and Key Results).

Weiterlesen nach der Anzeige

Begeisternde Produkte entwickeln – mit den geeigneten Tools und Methoden

Das Konferenzprogramm besteht aus sechs Fachvorträgen, die vielfältige Aspekte des modernen Produktmanagements beleuchten und praxisrelevante Einblicke bieten. Unter anderem wird Nadine Broß (Bitmarck) von ihren Erfahrungen mit einem realen Projekt voller Herausforderungen durch unklare Struktur und fehlende Planung berichten, während Andreas Havenstein (it-agile) in seinem Vortrag live demonstriert, wie Vibe Coding mit ChatGPT & Co. für Product Owner funktioniert. Real Progress statt Alibi Progress lautet das Motto in Tim Herbigs Vortrag, denn Strategy, OKRs und Discovery sind miteinander verknüpft.

Den Abschluss des Tages bildet eine Diskussionsrunde mit Sprecherinnen und Sprechern des Tages unter Moderation von Ralf Lethmate (it-agile).

Tickets und Gruppenrabatte für Kurzentschlossene

Der Preis für ein Konferenzticket beträgt 299 Euro (alle Preise zzgl. 19 % MwSt.). Teams ab drei Personen erhalten zusätzlich automatische Gruppenrabatte im Online-Shop. Der Ganztages-Workshop „Strategy Execution mit OKRs“ von Christina Lange lässt sich für 549 Euro, der Halbtages-Workshop „Teamübergreifenden Flow erleben“ von Sven Günther für 289 Euro buchen.

Weitere Informationen zum 8. Product Owner Day und anderen Angeboten der Dachmarke inside agile können Interessierte über den Newsletter erhalten, der auf der Konferenz-Website abonnierbar ist. Auf LinkedIn ist das Event ebenfalls vertreten, der Hashtag lautet #pod8.

Weiterlesen nach der Anzeige

(mai)

Künstliche Intelligenz

Trotz Kritik aus der Wirtschaft: Kabinett beschließt höhere Ausweisgebühr

Der Personalausweis soll teurer werden: Das Bundeskabinett hat am Mittwoch beschlossen, die Gebühr von 37 auf 46 Euro zu erhöhen. Hinzu soll unverändert eine Fotogebühr in Höhe von 6 Euro kommen, wenn man das Passbild von der Behörde anfertigen lässt. In Kraft treten die Änderungen, wenn nach dem Kabinett auch noch der Bundesrat zustimmt.

Weiterlesen nach der Anzeige

Wirtschaftsverbände kritisieren die geplante Gebührenerhöhung allerdings scharf und hoffen, sie noch verhindern zu können. Es handele sich um eine „unzulässige Quersubventionierung“, heißt es in einer aktuellen Stellungnahme der Deutschen Industrie- und Handelskammer (DIHK). Denn mit der Anhebung werde das Foto-Aufnahmesystem „PointID“ der staatlichen Bundesdruckerei finanziert, „zulasten des Einzelhandels und privater Automatenanbieter“.

Aufnahmesystem PointID: Kosten von geschätzt 171 Millionen Euro über fünf Jahre.

(Bild: Bundesdruckerei GmbH)

DIHK: Staat verschafft Bundesdruckerei ein Monopol

Hintergrund des Streits: Theoretisch können Kommunen frei wählen, ob sie das PointID-System der Bundesdruckerei oder Systeme privater Anbieter in ihren Bürgerämtern einsetzen. Im Frühjahr entschied das Bundesinnenminsterium (BMI) jedoch überraschend, dass die Kommunen PointID kostenlos nutzen können. Entwicklung, Produktion und Support der Geräte sollen nun laut BMI „nach dem Solidarprinzip“ über die allgemeine Ausweisgebühr finanziert werden.

„Es kann nicht sein, dass der Staat auf dem Rücken von Kunden und Privatwirtschaft die Bundesdruckerei subventioniert und ihr praktisch ein Monopol verschafft“, kritisiert Dirk Binding, Bereichsleiter Digitale Wirtschaft bei der DIHK. Der faktische Zwang zu PointID stelle nun Fotohändler, Drogerien und Automatenbetreiber vor existenzielle Herausforderungen. Für viele Fotofachgeschäfte mache die Passfotoerstellung bis zu 50 Prozent des Umsatzes aus, sagte Binding.

Den Vorwurf der Diskriminierung privater Anbieter weist das BMI zurück. Das kostenlose Angebot diene der Daseinsfürsorge und der Schaffung gleichwertiger Lebensverhältnisse im gesamten Bundesgebiet, argumentiert das Ministerium. Die Kosten für PointID wirken sich nach Darstellung des Ministierums zudem „eher geringfügig“ auf die geplante Gebührenerhöhung aus.

Weiterlesen nach der Anzeige

Aktuell kein gültiges Zertifikat für PointID

Unabhängig vom Streit um die Finanzierung gibt es mit PointID ein weiteres Problem: Aktuell besitzt das Bundesdruckerei-System laut einer Übersicht des Bundesamts für Sicherheit in der Informationstechnik (BSI) kein gültiges BSI-Zertifikat für den Einsatz. Das ursprüngliche Zertifikat war lediglich vom 30.4.2025 bis 31.10.2025 gültig. Es ist also mittlerweile abgelaufen. Anstatt wie sonst üblich fünf Jahre lang, galt es lediglich ein halbes Jahr.

„Das Zertifikat wurde unter Auflagen erteilt und ist daher auf ein halbes Jahr befristet“, erklärte ein BSI-Sprecher auf Anfrage. Laut dem Konformitätsreport, der c’t vorliegt, bestand PointID in den technischen Prüfungen 21 Testfälle und scheiterte an acht Fällen. Unter anderem funktionierte die Hintergrundersetzung schlecht: In mehreren Fällen waren Teile des Hintergrunds zu sehen und „im Kernbereich des Gesichtes (z. B. Augen) wurden größere Änderungen vorgenommen und/oder der Umriss der Frisur verändert“, heißt es im Report.

Außerdem übertraf die Dauer des Aufnahmeprozesses die geforderte maximale Zeit von 30 Sekunden und die Beleuchtung war so dunkel eingestellt, dass „der Nutzer gehäuft die Meldung erhält, dass er/sie die Augen offen halten soll“. Kurz gesagt: Die Software des Gerätes war offenbar zum Prüfzeitpunkt noch ziemlich unreif.

„Vorläufige Betriebserlaubnis“ erlaubt den Einsatz

Trotzdem dürfen die Kommunen weiterhin PointID für Passfotos nutzen. „Die Bundesdruckerei hat aktuell eine vorläufige Betriebserlaubnis für den Betrieb der PointID-Systeme, die den Betrieb auch ohne gültiges Zertifikat ermöglicht“, erklärte ein Sprecher des BMI auf Anfrage. Mit einer auflagenfreien Zertifizierung rechne man zeitnah.

Die Kosten für Entwicklung, Produktion und Support der staatlichen PointID-Systeme schätzte das BMI im Jahr 2020 auf 171 Millionen Euro über einen Zeitraum von fünf Jahren. Die nun vom Bundeskabinett beschlossene Gebührenerhöhung ist Teil zahlreicher weiterer Änderungen im Rahmen der „Verordnung zur Entlastung der Bundespolizei und der Verwaltung im Bereich des Pass- und Ausweiswesens sowie zur Änderung weiterer Vorschriften„.

(cwo)

-

UX/UI & Webdesignvor 3 Monaten

UX/UI & Webdesignvor 3 MonatenDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenAdobe Firefly Boards › PAGE online

-

Social Mediavor 3 Monaten

Social Mediavor 3 MonatenRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenGalaxy Tab S10 Lite: Günstiger Einstieg in Samsungs Premium-Tablets

-

UX/UI & Webdesignvor 3 Wochen

UX/UI & Webdesignvor 3 WochenIllustrierte Reise nach New York City › PAGE online

-

Entwicklung & Codevor 3 Monaten

Entwicklung & Codevor 3 MonatenPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online