Künstliche Intelligenz

GPT-5: OpenAI veröffentlicht neues Sprachmodell für ChatGPT

OpenAI veröffentlicht am Donnerstagabend sein neues Sprachmodell GPT-5. Das neue Modell soll zuverlässiger antworten und weniger halluzinieren als seine Vorgänger. Zudem könne es Fachfragen auf Expertenniveau beantworten, erklärt das Unternehmen. Als Beispiele nannte OpenAI unter anderem auch Aufgaben in Risikobereichen wie dem Finanz- und Gesundheitswesen.

Bei einem Videocall für die Presse demonstrierten OpenAI-Mitarbeiter bereits einige Fähigkeiten des neuen Modells. So ließen sie es auf einen Prompt eine Web-App programmieren. Wenn man den gleichen Prompt mehrfach eingab, kam jedes Mal eine andere App mit einer anderen Bedienoberfläche heraus.

Konsolidierung

Musste man bei GPT-4 noch je nach Aufgabe zwischen verschiedenen Modellvarianten wählen, so vereint GPT-5 alles unter einer Haube. ChatGPT gewährt Kunden ohne Bezahlabo Zugriff auf GPT5-5 inklusive der Reasoning-Funktionen. Allerdings werde die Zahl der Fragen limitiert, die man dem Modell stellen kann. Das Plus-Abo für 23 Euro im Monat gewährt ein deutlich höheres Kontingent. Pro-User, die monatlich das Zehnfache bezahlen, könnten dem Modell beliebig viele Fragen stellen und bekommen laut OpenAI exklusiven Zugriff auf eine Pro-Version von GPT-5. Daneben soll es auch abgespeckte Varianten namens mini und nano geben, die schneller und billiger antworten.

Das Kontextfenster gibt OpenAI mit 256.000 Token an. Nutzer, die längere Texte mit bis zu einer Million Token verarbeiten müssen, können weiterhin GPT-4.1 nutzen. Mit zwei neuen Parametern namens „reasoning“ und „verbosity“ könnten Entwickler steuern, wie gründlich GPT-5 über seine Antworten sinniert und wie ausführlich das Modell antwortet. Damit könne man den Umfang, Zeitbedarf und Preis der Ausgaben beschränken, die bei der API-Nutzung pro Token abgerechnet werden. Die Preise belaufen sich auf 1,25 US-Dollar für eine Million Input-Token und 10 US-Dollar für eine Million Output-Token. Zum Vergleich: Der europäische Anbieter Mistral verlangt lediglich 6 US-Dollar für eine Million Token seines größten Modells, der chinesische Anbieter Deepseek für R1 sogar nur 2,19 US-Dollar.

In den Antworten soll sich GPT-5 weniger anbiedern als GPT-4 und Themen, die die Content-Filter ausklammern, im Rahmen des Erlaubten beantworten. Laut OpenAI hätte ein externer Dienstleister das Modell 5000 Stunden auf Sicherheitsprobleme abgeklopft (Red Teaming) – eine Zahl, die angesichts der Komplexität eines Sprachmodells niedrig wirkt.

Einsatz in Risikobereichen

Verschiedene US-Firmen bekamen offenbar vorab Zugriff auf GPT-5. So berichtet OpenAI, dass die private Krankenversicherung Oscar Health bereits Anträge seiner Versicherten mit GPT-5 prüfe. Das Transportunternehmen Uber bediene sich GPT-5 beim Customer Support. GitLab, Windsurf und Cursor setzten GPT-5 bei der Software-Entwicklung ein und die spanische Bank BBVA nutze das neue Modell bereits für ihre Finanzanalysen. Als weitere Unternehmen, die GPT-5 vor Veröffentlichung im Einsatz hätten, zählte OpenAI das Biotechnik-Unternehmen Amgen, das Einzelhandelsunternehmen Lowe’s und den Software-Entwickler Notion auf.

Beachtlich ist, dass diese Firmen offenbar ein nagelneues, bislang unveröffentlichtes und ungeprüftes Modell auch in kritischen Bereichen wie der Gesundheitsversorgung und dem Finanzwesen einsetzen, für das noch keine unabhängige Evaluierung vorliegt. Laut OpenAI soll GPT-5 potenzielle Gesundheitsprobleme erkennen, Rückfragen stellen und bei seinen Antworten auch den Standort des Nutzers einbeziehen. In Europa wäre ein solcher Einsatz allein schon aus Datenschutzgründen problematisch, wenn Firmen Kundendaten mit OpenAI teilen. Denn anders als die kürzlich vorgestellten Open-Weight-Varianten von GPT-4 läuft GPT-5 nur auf den Servern von OpenAI. Vorsicht ist ebenfalls geboten, wenn man GPT-5 wie von OpenAI vorgesehen mit Google-Konten, inklusive GMail, Kontakten und Kalender verbindet.

In einem Werbestatement lobte Michael Turell, Chef des Programmier-Editors Cursor, das neue Sprachmodell: Es könne selbst tief versteckte Bugs in Code aufspüren. In einer zuvor von der Non-Profit-Organisation Model Evaluation & Threat Research (METR) veröffentlichten Studie kam noch heraus, dass Programmierer 20 Prozent langsamer arbeiteten, wenn sie mit Cursor und den LLMs Claude 3.5 und 3.7 Sonnet codeten. Von dem Code, den die Modelle von Anthropic generierten, war über die Hälfte unbrauchbar. Man muss unabhängige Studien abwarten, ob GPT-5 hier tatsächlich bessere Ergebnisse liefert.

Grundsätzliche Informationen, etwa zur Modellgröße, zum Trainingsaufwand und zum Energiebedarf von GPT-5 gab OpenAI vorab nicht bekannt. Fragen dazu sollen in Kürze in einem Livestream zu GPT-5 sowie einem Developer-Blog beantwortet werden, darunter auch die Modell-Karte von GPT-5.

(hag)

Künstliche Intelligenz

Apple stellt ganzen App Store ins Web – leakt aus Versehen Code

Schon seit Jahren ist es möglich, via Web Informationen zu Inhalten aus Apples verschiedenen App-Store-Varianten abzurufen. Doch dazu war stets die passende URL notwendig. Nun hat der Konzern seinen Softwareladen für iPhone, iPad, Mac, Vision (Pro), Apple Watch und Apple TV erstmals vollständig in den Browser verfrachtet – inklusive Suchfunktion, redaktionellen Inhalten und mehr. Beim Aufbau kam es allerdings zu einem Leak: Der Front-End-Quellcode entfleuchte und landete zwischenzeitlich auf GitHub. Mittlerweile hat ihn Apple via DMCA-Takedown-Request (anwaltliche Urheberrechtsmeldung) entfernen lassen.

Weiterlesen nach der Anzeige

Fast der ganze App Store im Browser

Mit Apples neuem Web-Interface lässt sich nun fast alles im App Store tun, was man aus der jeweiligen App auf iPhone, iPad, Mac & Co. kennt – mit Ausnahme der tatsächlichen Einkäufe samt Login und Account-Übersicht. Es ist also ein permanenter Gastmodus. Ob Apple daran etwas ändert, bleibt unklar – denkbar wäre beispielsweise, im Web eine App „vorzukaufen“, um sie dann auf dem eigentlichen Gerät herunterzuladen. So gibt es etwa seit Langem eine Web-Version von Apple Music, die zumindest ein Streaming der eigenen Bibliothek sowie weiterer Titel nach dem Einloggen ermöglicht.

Für die Vision Pro hatte Apple bereits die Möglichkeit geschaffen, über eine eigene iPhone-App Anwendungen auch aus der Ferne auf das Headset zu holen. Interessant im Bezug auf das Spatial-Computing-Gerät: Apple bezeichnet es im App Store als „Vision“ ohne „Pro“. Gerüchten zufolge soll Apple zumindest zwischenzeitlich an einer einfacheren Variante seines Headsets gearbeitet haben, zu der die Bezeichnung passen würde.

Sourcemaps-Funktion aktiv

Der auf GitHub entfleuchte Code, den der User rxliuli aufgefunden und dann publiziert hatte, war deshalb sichtbar, weil Apple die Sourcemaps-Funktion versehentlich aktiv gelassen hatte. Der Nutzer konnte dadurch dann mittels Chrome-Erweiterung alle auf Apples Servern zugänglichen Quellen extrahieren und herunterladen. Daraus wurde dann ein GitHub-Repository „zu Bildungszwecken“, wie die Person laut einem Bericht von 9to5Mac dort mitteilte, bevor GitHub die Sammlung herunternahm, vermutlich durch Apple selbst angestoßen.

Zu den verfügbaren Komponenten zählten der API-Integrationscode, Teile der UI, die State-Management-Logik sowie der vollständige Quellcode in Svelte beziehungsweise TypeScript. Auch die Routing-Konfiguration war sichtbar. Es ist verwunderlich, dass Apple vergaß, die Sourcemaps-Funktion zu deaktivieren – das ist üblicherweise einer der letzten Schritte vor dem Live-Gang eines neuen Dienstes. Ob sich aus dem Leak Sicherheitsprobleme für den App Store ergeben könnten, bleibt offen.

Weiterlesen nach der Anzeige

(bsc)

Künstliche Intelligenz

Schaeffler setzt humanoide Roboter von Neura Robotics ein und liefert Teile

Der deutsche Automobil- und Industriezulieferer Schaeffler wird künftig verstärkt Roboterteile an das deutsche Robotikunternehmen Neura Robotics liefern. Das teilte Schaeffler am Dienstag mit. Dazu haben die beiden Unternehmen eine Partnerschaft geschlossen, die zusätzlich vorsieht, dass Schaeffler bis 2035 eine „mittlere vierstellige Zahl“ an humanoiden Robotern in die eigene Produktion integriert.

Weiterlesen nach der Anzeige

Ein kompakter Planetenradaktor von Schaeffler.

(Bild: Schaeffler)

Gemeinsam wollen Schaeffler und Neura Robotics Schlüsselkomponenten für humanoide Roboter entwickeln und herstellen. Dazu gehören etwa Roboteraktuatoren, die die Gelenke der Roboter bewegen. Schaeffler verfügt bereits über einige Expertisen im Bereich der Planetenradaktoren, die präzise Drehbewegungen bei einem zugleich hohen Drehmoment ermöglichen. Zudem sind diese Aktuatoren leicht und robust und damit für einen Dauerbetrieb ausgelegt.

Schaeffler hat bereits Roboteraktuatoren verschiedener Leistungsklassen im Programm, die bis zu 250 Nm Drehmoment liefern können. Der aktuelle humanoide Roboter 4NE1 von Neura Robotics ist mit solchen Aktuatoren ausgerüstet, sodass er in der Lage ist, auch hohe Gewichte zu stemmen. In Zukunft will Neura Robotics seinen Bedarf an leichten und leistungsstarken Aktuatoren durch Schaeffler decken.

Neura-Roboter arbeiten bei Schaeffler

Die getroffene Vereinbarung sieht außerdem vor, dass Schaeffler eine größere Anzahl humanoider Roboter von Neura Robotics in der eigenen Produktion einsetzt. Über die genaue Anzahl haben beiden Unternehmen nichts verlautbart. In der Mitteilung von Schaeffler wird etwas kryptisch von einer mittleren vierstelligen Anzahl gesprochen. Auch zu den Kosten halten sich beide Firmen bedeckt. Aus Industriekreisen heißt es, dass der Auftragswert bei Neura Robotics 300 Millionen Euro betragen soll. Belegen lässt sich das jedoch zunächst nicht.

Während des Einsatzes der Roboter in realen Produktionsumgebungen werden Anwendungsdaten gesammelt, die dann wiederum für das KI-Training der humanoiden Roboter genutzt werden sollen. Das Ziel: Durch das kontinuierliche Lernen spezifischer Fertigkeiten sollen sich die Roboter weiterentwickeln.

Weiterlesen nach der Anzeige

(olb)

Künstliche Intelligenz

No-Code-Plattform SeaTable integriert KI-Automatisierung | heise online

Der deutsche Anbieter SeaTable hat Version 6.0 seiner No-Code-Plattform veröffentlicht. Die neue Version integriert erstmals KI-Funktionen direkt in die Automatisierungsregeln der Tabellen- und Workflowsoftware. Nutzer können mit der KI Texte analysieren, Dokumente auswerten oder Informationen extrahieren.

Weiterlesen nach der Anzeige

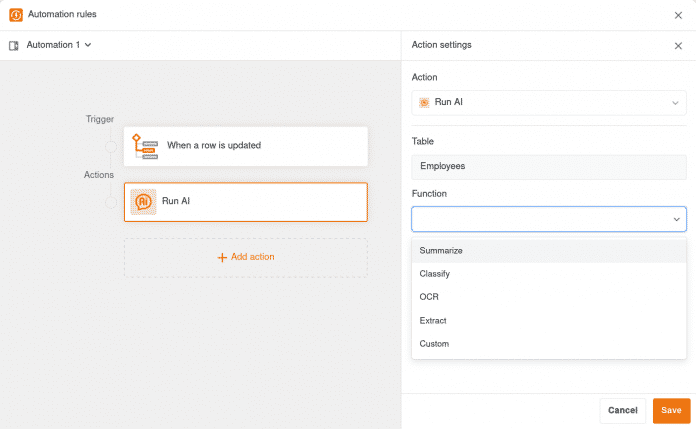

Die KI-Integration umfasst dedizierte Funktionen für Standardaufgaben: Summarize fasst Texte zusammen, OCR erkennt Text in Bildern, Extract zieht spezifische Informationen aus Dokumenten und Classify ordnet Inhalte in Kategorien ein. Für weitere Anwendungsfälle steht eine Custom-Funktion bereit, die ausschließlich auf Basis eigener Prompts arbeitet. Spalteninhalte lassen sich dabei durch Referenzierung in geschweiften Klammern direkt einbinden.

Die neuen KI-Funktionen in SeaTable für die Automatisierung, die Standardaufgaben übernehmen können.

(Bild: SeaTable)

Als KI-Modell setzt SeaTable Cloud auf Gemma 3 mit 12 Milliarden Parametern. Das multimodale Large Language Model von Google läuft auf Servern von Hetzner Online in Deutschland und wird von den SeaTable-Administratoren selbst betrieben. Der Datenaustausch erfolgt verschlüsselt, Informationen werden nicht an externe KI-Anbieter oder ins Ausland übertragen. Enterprise-Kunden erhalten 500 AI-Credits pro Teammitglied, die umfangreiche Tests ermöglichen; für produktive Workloads sind zusätzliche Credits erforderlich.

Allerdings können Nutzer, die SeaTable Server selbst betreiben, genauso eigene LLMs einsetzen oder die neue Komponente SeaTable AI nutzen. Letztere basiert auf LiteLLM und unterstützt viele Modelle und Anbieter, darunter alle LLM-Dienste mit OpenAI-kompatibler API. Die Bereitstellung erfolgt via Docker oder Docker Compose.

Überarbeiteter Editor und neue Ansichten

Neben den KI-Funktionen bringt Version 6.0 einen komplett überarbeiteten Editor für Automatisierungsregeln. Dieser erstreckt sich über die gesamte Bildschirmbreite und bietet eine workflow-orientierte Benutzeroberfläche. Zudem ersetzen die neuen Ansichtstypen Kalender, Kanban und Galerie die bisherigen Plug-ins gleichen Namens und unterstützen nun Features wie View-Sharing, private Ansichten und kollaborative Datenbearbeitung in Echtzeit.

Weiterlesen nach der Anzeige

Alle Informationen zum neuen Release finden sich im SeaTable-Blog. Die SeaTable Cloud wurde bereits auf Version 6.0 aktualisiert. Wer die Software selbst betreibt, kann das stabile Release aus dem Docker Repository herunterladen. Für die kommenden Updates plant SeaTable die Integration weiterer KI-Modelle von OpenAI, Anthropic, Meta, xAI und dem europäischen Anbieter Mistral sowie die Entwicklung eines KI-Assistenten und MCP-Servers.

(fo)

-

UX/UI & Webdesignvor 3 Monaten

UX/UI & Webdesignvor 3 MonatenDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenAdobe Firefly Boards › PAGE online

-

Social Mediavor 3 Monaten

Social Mediavor 3 MonatenRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenGalaxy Tab S10 Lite: Günstiger Einstieg in Samsungs Premium-Tablets

-

UX/UI & Webdesignvor 3 Wochen

UX/UI & Webdesignvor 3 WochenIllustrierte Reise nach New York City › PAGE online

-

Entwicklung & Codevor 3 Monaten

Entwicklung & Codevor 3 MonatenPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online