Datenschutz & Sicherheit

Tresorschlösser von SecuRam – so einfach haben es Panzerknacker

Dass man keine Post-its mit Passwörtern an Monitore klebt, sollte inzwischen jedem klar sein. Anders ist es bei der Firma SecuRam Systems Inc.: Obwohl die digitalen Safe-Schlösser als hochsicher gelten und für Geldtresore, Arzneimittel-, Drogen- oder Waffenschränke zugelassen sind, haben diese Schlösser die Sicherheit von einem Post-it mit dem Schlüssel. Die Schlösser von SecuRam werden ebenfalls in Europa eingesetzt.

Wie Mark Omo und James Rowley in ihrer Freizeit herausgefunden haben, speichern die digitalen Schlösser sowohl den symmetrischen Schlüssel als auch die verschlüsselten PINs und Master-PINs sowie die Recovery-Informationen nicht im unzugänglichen Schloss im Safe, sondern im Keypad, das von außen leicht zugänglich ist. Per Raspberry Pi haben die beiden IoT-Sicherheitsexperten ein Tool gebaut, das aus dem Keypad alle sicherheitsrelevanten Informationen auslesen kann. Praktisch war, dass der Controller im Keypad – ein Renesas RL78/G13 – auch in der Playstation 4 verbaut ist. Somit hatte die Gamehacker-Gruppe fail0verflow! schon alle Werkzeuge wie den Memory Dumper und die Tools rund um den Debug-Port erstellt.

Dabei ist der Debug-Port extrem einfach durch das Batteriefach von außen zugänglich. Auch hat der Hersteller vergessen, den Debug-Port zu fusen, also auf dem Chip unzugänglich zu machen, und hat keinen Debug-Unlock-Pin vergeben. Über ein einfaches 0000000000 erhielten die beiden den vollen Zugriff auf den Speicher.

Obwohl der Hersteller XXTEA als Cipher benutzt, bring es in diesem Fall nichts, da der Schlüssel ebenfalls im Keypad gespeichert ist. Laut Aussage von den Forschern ist diese katastrophale Situation auch darauf zurückzuführen, dass die Standards für elektronische physische Sicherheitsgeräte wie Safes absolut veraltet sind und nicht dem aktuellen Stand der Technik entsprechen.

(fo)

Datenschutz & Sicherheit

Die Woche, in der Trump die Antifa zur Terrorgruppe erklärte

Liebe Leser*innen,

jetzt bin ich also Terrorist. Zumindest laut Donald Trump. Der hat nämlich diese Woche „die Antifa“ in den USA als terroristische Organisation eingestuft. Ungarns Ministerpräsident Viktor Orbán hat bereits angekündigt, dass dies auch in seinem Land gelten soll. Das niederländische Parlament will auf Antrag von Geert Wilders eine entsprechende Einstufung prüfen. Die AfD-Co-Vorsitzende Alice Weidel forderte sie 2024 auch für Deutschland.

Trump schwadroniert davon, dass die Antifa eine Organisation sei. Aber Antifa ist keine Organisation, schon gar keine nationale. Antifa ist eine internationale Bewegung, die alle umfasst, die sich gegen Faschismus einsetzen – antifaschistisch eben. Faschismus bezeichnet etwa nationalistische Bewegungen, die autoritäre Regimes errichten wollen, die nach innen Minderheiten verfolgen und nach außen militaristische Strategien.

Trump, Orbán und Weidel eint mindestens die nationalistische Orientierung und der Kampf gegen Minderheiten. Wohl deshalb sehen sie „die Antifa“ als Feind. Anti-Demokrat*innen haben in der Vergangenheit immer wieder gezeigt, dass sie am liebsten alle aus dem Weg schaffen würden, die sich ihren autoritären Träumen in den Weg stellen.

Antifa, das sind nicht nur die schwarzvermummten Demospitzen. Jeder Mensch, der Demokratie und Rechtsstaat liebt, sollte Antifa sein und sich dem aufkeimenden Faschismus entgegenstellen. 1932, vor 93 Jahren, gründeten Menschen die Antifaschistische Aktion, weil sie die Gräuel der Nazis vor deren Machtergreifung vorausahnten. Sie wollten den Aufstieg des Faschismus verhindern.

Antifa, das waren die Geschwister Scholl, die US-amerikanischen Soldaten, die in der Normandie landeten, und die Menschen, die Verfolgte versteckten und unterstützten. Antifa ist heute das Bundesverfassungsgericht, wenn es Grundrechte hochhält. Antifa ist nach Selbstaussage auch der Verfassungsschutz Niedersachsen und Antifa sind alle Menschen, die auf Anti-Nazi-Demos gehen. Antifa bin auch ich – weil ich verhindern will, dass den Rechtsextremen, falls sie an die Macht kommen, ein hochentwickelter Überwachungsapparat schlüsselfertig ausgehändigt wird.

Ich kämpfe gegen Videoüberwachung, Netzsperren und all die anderen Kontrollwerkzeuge nicht zuletzt deshalb, weil ich autoritären und totalitären Bestrebungen die Waffen nehmen oder gar nicht in die Hand geben will, die diese zur Kontrolle und Gleichschaltung der Bevölkerung benötigen. Weil ich eine offene und freie Gesellschaft will.

Was die historischen Nazis an Leid über die Welt gebracht haben, ist unfassbar. Das darf sich niemals wiederholen. Deshalb bin ich Antifaschist, deshalb bin ich Antifa.

Martin

Wir sind ein spendenfinanziertes Medium

Unterstütze auch Du unsere Arbeit mit einer Spende.

Datenschutz & Sicherheit

Neues aus dem Fernsehrat (113): Hass und Zusammenhalt

Die letzte Sitzung des ZDF-Fernsehrats fand am Ende einer Woche statt, die für das ZDF besonders herausfordernd war: Dunja Hayali wurde für die Anmoderation eines Beitrags zur Ermordung Charlie Kirks tagelang mit Beleidigungen, Mord- und Vergewaltigungsdrohungen überzogen. Der ehemalige US-Botschafter in Deutschland, Richard Grenell, forderte aufgrund der journalistischen Einordnung Charlie Kirks durch Elmar Theveßen den Entzug seines US-Visums. Und die US-Regierung hat angekündigt, dass Visa für Journalist:innen zukünftig nur noch 240 Tage gelten sollen – üblich sind bisher fünf Jahre.

Es ist deshalb ein sehr wichtiges Zeichen, dass der Fernsehrat – mit all seiner politischen und gesellschaftlichen Vielfalt – die Angriffe auf Dunja Hayali und Elmar Theveßen in der Sitzung am vergangenen Freitag einstimmig verurteilt hat. In der gemeinsamen Erklärung betonte er außerdem, dass Pressefreiheit „für die Demokratie ein unverhandelbares Gut“ ist. Auch zu den kürzeren Visa-Laufzeiten äußerte sich der Rat deutlich. Er schloss sich dem Appell einer Reihe deutscher Intendanten (von ARD und ZDF bis zu ProSiebenSat.1) an: Die Bundesregierung soll sich auf diplomatischem Weg gegen die geplanten Änderungen aussprechen.

Es war für mich eine ereignisreiche erste Sitzung. Denn ab jetzt darf ich – entsandt vom Chaos Computer Club, D64 – Zentrum für Digitalen Fortschritt, eco – Verband der Internetwirtschaft und media berlinbrandenburg – den Bereich „Internet“ im ZDF-Fernsehrat vertreten. Ich trete damit die Nachfolge von Leonhard Dobusch (Juli 2016 bis Juni 2022, danach noch bis Mai 2025 im ZDF-Verwaltungsrat) und Laura Kristine Krause (Juli 2022 bis Juli 2025) an, die in der Vergangenheit auch diese Kolumne verantwortet haben.

Anonymität als Schutz für marginalisierte Gruppen

Mich beschäftigen ganz besonders der Hass und die Gewaltandrohungen, die Dunja Hayali in den großen sozialen Online-Plattformen entgegenschlagen. Gleichzeitig ist die breite Solidarität von weiten Teilen der Bevölkerung, der Politik und von Kolleg:innen ein Zeichen der Hoffnung.

Wir setzen uns bei D64 seit langem dafür ein, dass der digitale öffentliche Raum, in dem für unsere Demokratie zentrale Debatten ausgetragen werden, sicherer gestaltet werden muss. Zur Verbesserung der Strafverfolgung im Internet, auch der Anzeigemöglichkeiten für Betroffene, haben wir schon vor Jahren das Konzept der Login-Falle entwickelt. Das wurde sogar in den Koalitionsvertrag der früheren Ampel-Regierung aufgenommen, dann aber mangels politischem Willen nie umgesetzt.

Stattdessen werden immer wieder Forderungen nach autoritären Maßnahmen laut – sei es die anlasslose Vorratsdatenspeicherung von IP-Adressen oder Identifizierungspflichten für soziale Netzwerke. Dabei profitieren von der grundsätzlichen Möglichkeit der Anonymität im Internet ganz besonders Personen aus marginalisierten Gruppen, die sonst Hass und Repressalien befürchten müssen.

Auch eine Studie der Universität Zürich aus dem Jahr 2016 fand keine Belege dafür, dass Anonymität im Internet zu mehr Hass führt – im Gegenteil. Als besonders aggressiv stellten sich in der Datenanalyse Nutzerkonten heraus, die unter ihrem bürgerlichen Namen agieren.

Demokratische Alternativen für digitale öffentliche Räume

Was wir stattdessen brauchen, sind Alternativen zu den Big-Tech-Plattformen „gütiger Diktatoren“ des Silicon Valleys, die gemeinsam mit der Trump-Regierung derzeit eine Regierungsform aufbauen, die unter anderem vom Philosophen Rainer Mühlhoff als „neuer Faschismus“ bezeichnet wird. Diese Alternativen sollten der Konzentration von Macht durch einen dezentralen Aufbau strukturell entgegenwirken, staatsfern organisiert sowie gemeinwohlorientiert sein und die Vielfalt unserer Gesellschaft abbilden.

Vielversprechende Ansätze wie das Fediverse mit seinem bekanntesten Vertreter Mastodon gibt es bereits. Damit sich solche Alternativen durchsetzen können, braucht es aber noch deutlich mehr – ideelle wie finanzielle – Unterstützung durch relevante Akteure, die hohe gesellschaftliche Akzeptanz besitzen. Akteure wie der öffentlich-rechtliche Rundfunk.

Das sehen nicht nur Forschende beispielsweise mit den „Digital Open Public Spaces“ in der Digital-Public-Value-Studie und Aktivist:innen so, sondern breite Teile der Bevölkerung.

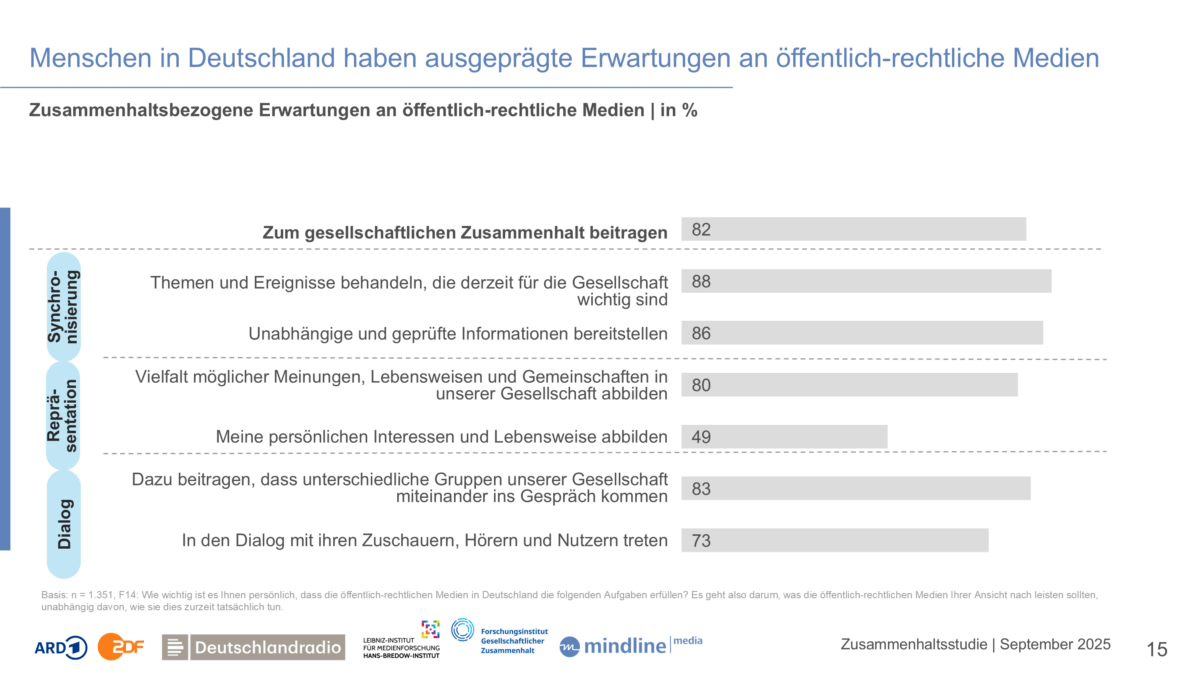

Dazu ist die „Zusammenhaltsstudie“ interessant, die ARD, ZDF und Deutschlandradio gemeinsam mit wissenschaftlichen Partnerinstitutionen durchgeführt und am vergangenen Mittwoch in Frankfurt vorgestellt haben. Laut der Erhebung äußern 83 Prozent der Befragten die Erwartung, dass öffentlich-rechtliche Medien dazu beitragen sollen, dass unterschiedliche Gruppen unserer Gesellschaft ins Gespräch kommen. 73 Prozent finden, dass öffentlich-rechtliche Medien im Dialog mit Nutzenden treten sollen.

Wir sind ein spendenfinanziertes Medium

Unterstütze auch Du unsere Arbeit mit einer Spende.

Vorbei sind also die Zeiten, in denen der öffentliche-rechtliche Rundfunk sich auf seine Rolle als „Sender“ beschränken kann. Menschen erwarten vielmehr, dass er Interaktion von Menschen untereinander und mit den Medien selbst ermöglicht.

Mit großem Vertrauen kommt große Verantwortung

Die besondere Verantwortung der Öffentlich-Rechtlichen ergibt sich auch aus mangelhaftem Vertrauen in andere Institutionen. So nehmen lediglich ein knappes Drittel der befragten Personen einen positiven Beitrag von kommerziellen Social-Media-Plattformen zum gesellschaftlichen Zusammenhalt wahr.

Besonders bitter ist die Umfrage für zwei traditionelle Massenorganisationen: Von allen genannten Einrichtungen ist der Beitrag von Parteien und Kirchen zum gesellschaftlichen Zusammenhalt laut der Umfrage am geringsten. Der Beitrag der Öffentlich-Rechtlichen zum gesellschaftlichen Zusammenhalt wird dagegen nach Sportvereinen, der Wissenschaft und dem Bundesverfassungsgericht als am höchsten eingeschätzt.

Das ZDF hat sich bereits auf den Weg gemacht, den digitalen Diskurs zu fördern: Der Public Spaces Incubator ist das zentrale Projekt, um sich gemeinsam mit internationalen Partnern vom reinen Sender zu einer Plattform des konstruktiven Austauschs zu entwickeln, ganz ohne Überwachungskapitalismus, Engagement-Farming und süchtig-machenden Algorithmen.

Diesen Sommer gab es im Rahmen der Frauen-Fußball-Europameisterschaft einen ersten Testlauf der ZDFspaces, ab Oktober ist die Ausweitung auf weitere Formate geplant. Die Ereignisse der letzten Wochen zeigen die Dringlichkeit, dass dieser Weg engagiert von den öffentlich-rechtlichen Medien weiterverfolgt wird. Er ist unsere beste Chance für eine demokratische Diskussionskultur im Netz.

Datenschutz & Sicherheit

Kritische Lücke in Fortra GoAnywhere MFT wurde wohl von Angreifern ausgenutzt

Im Lizenz-Servlet von GoAnywhere MFT, einem Dateitransfer-Werkzeug für Unternehmen, klafft eine kritische Sicherheitslücke. Der Hersteller informierte Kunden vor einer Woche über das Leck und stellte Patches bereit. Nun meldet ein Security-Unternehmen, dass wohl seit über zwei Wochen Angriffsversuche laufen – das macht den Sicherheitsfehler zu einem „Zero Day“.

In mehreren Schritten lässt sich der Lizenzmanager von GoAnywhere MFT austricksen, um Schadcode des Angreifers auszuführen – derlei Fehler in Deserialisierungsroutinen sind altbekannt, werden jedoch immer wieder in aktueller Software gefunden. Zuletzt hatte sich Microsoft Sharepoint mit einem ähnlichen Problem hervorgetan. Jetzt hat es GoAnywhere MFT erneut erwischt: Die Sicherheitslücke CVE-2025-10035 wird als kritisch eingestuft und hat eine CVSS-Wertung von 10 Punkten. Das bedeutet: Angreifer können ohne vorherige Anmeldung Schadcode auf dem Server ausführen.

Fortra bringt Patches, andere haben nützliche IOCs

Der Hersteller hat bereits Flicken für den Fehler herausgegeben und empfiehlt seinen Kunden dringend, auf Version 7.8.4 oder die „Sustain Release“, also LTS-Version 7.6.3 zu aktualisieren. Zudem sollte die GoAnywhere Admin Console keinesfalls über das Internet erreichbar sein. Als Indiz eines erfolgreichen Angriffs (Indicator of Compromise, IoC) liefert Fortra hingegen nur den Auszug eines Java-Stacktrace.

Andere sind da redefreudiger: Die Analysefirma WatchTowr Labs hat immerhin noch verdächtige Dateinamen, eine IP-Adresse vom schwedischen VPN-Dienst Mullvad, das verdächtige Konto „admin-go“ und ein paar von Angreifern ausgeführte Kommandos parat, die Verteidigern bei der Suche nach ungebetenen Gästen helfen sollen. Die IoCs veröffentlichte das Unternehmen im zweiten Teil einer detaillierten Analyse der Sicherheitslücke, die WatchTowr allerdings nicht komplett nachstellen konnte.

Es hat Angriffe gegeben

WatchTowr zeigt in der Analyse zudem Nachweise für erfolgreiche Angriffe, die bereits am 10. September 2025, mithin acht Tage vor der Sicherheitswarnung des Herstellers, stattgefunden hätten. Fortra selber gibt an, die Sicherheitslücke bei einer Überprüfung am 11. September entdeckt und unmittelbar gehandelt zu haben.

In jedem Fall sollten Kunden, die GoAnywhere MFT einsetzen, die entsprechenden Server als kompromittiert betrachten und Gegenmaßnahmen einleiten. Sie dürften Kummer gewohnt sein: Vor zweieinhalb Jahren, im Februar 2023, führte eine Schwachstelle in GoAnywhere bereits zu einer umfangreichen Kampagne mit der cl0p-Ransomware, die insgesamt über 130 Firmen betroffen habe. Und auch die aktuelle Sicherheitslücke dürfte im Untergrund schnell waffenfähig gemacht werden.

(cku)

-

UX/UI & Webdesignvor 1 Monat

UX/UI & Webdesignvor 1 MonatDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 4 Wochen

UX/UI & Webdesignvor 4 WochenAdobe Firefly Boards › PAGE online

-

Social Mediavor 1 Monat

Social Mediavor 1 MonatRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

Entwicklung & Codevor 1 Monat

Entwicklung & Codevor 1 MonatPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 4 Wochen

Entwicklung & Codevor 4 WochenEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

UX/UI & Webdesignvor 2 Wochen

UX/UI & Webdesignvor 2 WochenFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online

-

Digital Business & Startupsvor 3 Monaten

Digital Business & Startupsvor 3 Monaten10.000 Euro Tickets? Kann man machen – aber nur mit diesem Trick

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenFirefox-Update 141.0: KI-gestützte Tab‑Gruppen und Einheitenumrechner kommen