Künstliche Intelligenz

Bundesliga: Polizei fordert Gesichtserkennung in Stadien gegen zündelnde Ultras

Zum Auftakt der neuen Saison der Fußball-Bundesliga am Freitag verlangt die Gewerkschaft der Polizei (GdP), die Überwachung an Spielstätten deutlich auszubauen. Nötig sei – insbesondere vor den berüchtigten Fan-Kurven – „eine intensivere, rechtssichere Nutzung moderner Sicherheitstechnik“ wie automatisierter Gesichtserkennungssoftware und Personenscanner.

Wie am Flughafen müssten zumindest Teile der Besucher erst eine Ganzkörperdurchleuchtung über sich ergehen lassen, um etwa Waffen, Feuerwerk oder Sprengstoffe ausfindig zu machen, fordert die Gewerkschaft. Der GdP-Bundesvorsitzende Jochen Kopelke betonte vor dem Eröffnungsspiel: „Für gewaltbereite Hooligans oder zündelnde Ultras ist kein Platz im Stadion.“

Einige Vereinsvorstände schützten das kriminelle und gefährliche Verhalten, beklagt Kopelke. Fußballstadien sollten aber „den wahren Fans“ gehören und nicht „den Schlägern und Krawallmachern“. Die Verbände und Klubs sollten klar benennen, wer das sichere Stadionerlebnis gefährde und diese Personen aus den Kurven verbannen.

„Orwellsche Überwachungsfantasien“

Generell erwartet die GdP nach vielen Unruhen „für eine Rückkehr zum sicheren Fußballerlebnis eine konsequente Zusammenarbeit zwischen Verbänden, Vereinen, Innenministerien und Sicherheitsunternehmen“. Zuletzt sorgte die EM 2024 für einen deutlichen Anstieg in der Datei „Gewalttäter Sport“, in der die Polizei fast 700 ausländische „Hooligans“ neu speicherte.

Niemand würde mit seiner Familie zu einem Spiel kommen, wenn es die von der Polizei heraufbeschworenen Zustände gäbe, hielt Linda Röttig vom Dachverband der Fanhilfen dagegen. Auf jedem mittelgroßen Volksfest bestehe laut offiziellen Statistiken eine größere Gefahr, Opfer einer Straftat zu werden, sagte die Rechtsanwältin dem Redaktionsnetzwerk Deutschland (RND).

Zudem gälten auch für Fußballfans Grundrechte, „die die Realisierung derartiger Totalüberwachungsfantasien à la 1984 von George Orwell zu Recht verbieten“. In seinem aktuellen Saisonbericht verweist der Verband auf 24 Ereignisse, „bei denen Fans auf unterschiedliche Art und Weise mit überzogenem Polizeiverhalten konfrontiert waren“.

(vbr)

Künstliche Intelligenz

c’t-Workshop: CI/CD mit GitLab – Effiziente Workflows für stabile Software

GitLab ist eine umfassende DevOps-Plattform, die die Zusammenarbeit in Entwicklerteams erleichtert. Sie bündelt Werkzeuge für Versionsverwaltung, Continuous Integration und Continuous Delivery (CI/CD) in einer Umgebung. Damit behalten Sie Pipelines und Auslieferungen im Blick, erkennen Probleme früh und reagieren direkt. Automatisierte Tests, Builds und Deployments sorgen für schnelles Feedback und erhöhen Stabilität und Zuverlässigkeit Ihrer Software.

Praxisnahes Lernen mit eigener GitLab-Instanz

Im c’t-Workshop „CI/CD mit GitLab“ lernen Sie, wie Sie GitLab CI in Ihrer täglichen Arbeit gezielt einsetzen. Der Kurs eignet sich auch, wenn Sie bisher nur grundlegende Erfahrungen mitbringen und Ihr Wissen vertiefen möchten.

Am ersten Workshoptag erhalten Sie einen praktischen Einstieg: Sie lernen den Aufbau und die Funktionsweise von GitLab CI kennen und setzen das Gelernte in Übungen um, in denen Sie Softwareprojekte bauen, testen und veröffentlichen. Dabei nutzen Sie GitLab sowohl zur Verwaltung des Quellcodes als auch für die Ausführung der Pipelines.

Zwischen den beiden Tagen liegt eine Woche, in der Sie Ihr neues Wissen in Ihrer eigenen GitLab-Instanz anwenden und festigen können. Der zweite Workshoptag beginnt mit einer gemeinsamen Klärung Ihrer Erfahrungen und Fragen. Anschließend vertiefen Sie fortgeschrittene Themen, um GitLab CI im Arbeitsalltag noch effizienter zu nutzen.

Inhalte des Workshops

- Aufbau von Jobs, Stages und Skripten

- Nutzung von Variablen und Container-Images

- Auslösen und Verschachteln von Pipelines

- Job-Templates und Workflow-Regeln

- Pipelines für Merge Requests

- Erstellen und Verwalten von Container-Images

- Nutzung der Container Registry

- Erstellung von Releases

- Einsatz des GitLab Runners

Voraussetzungen und Teilnahme

Sie sollten grundlegende Erfahrung mit Continuous Integration oder Delivery mitbringen – auch unabhängig von GitLab. Außerdem benötigen Sie Basiskenntnisse in der Kommandozeile, einen funktionierenden SSH-Client sowie Kamera und Mikrofon bzw. Headset für den Austausch.

Der Online-Workshop findet am 27. November und 04. Dezember 2025 jeweils von 9 bis 17 Uhr statt. Bei Anmeldung bis zum 30. Oktober 2025 beträgt die Teilnahmegebühr 1.395 € (danach 1.550 €). Weitere Informationen und Anmeldedetails finden Sie auf der Webseite von heise academy.

(abr)

Künstliche Intelligenz

Bungie gibt „Marathon“ eine neue Chance

„Marathon“ bekommt eine neue Chance: Der problemgeplagte Online-Shooter von Bungie soll bald in eine neue geschlossene Testphase gehen, teilte das Entwicklerstudio auf seiner Webseite mit. Bungie spricht darin von einem technischen Test, der Ende Oktober stattfinden soll.

„Das ist ein wichtiger Checkpoint für uns, in dem wir unsere Verbesserungen seit der Alpha-Phase testen“, schreibt Bungie. Dazu gehören dem Blog-Eintrag zufolge drei neue Karten, fünf Spielfiguren, Proximity-Chat und Rebalancing der Schießereien. Gleichwohl warnt Bungie vor zu hohen Erwartungen: Der Technik-Test werde nur einen Teil dessen enthalten, was für die vollständige Veröffentlichung geplant ist.

Nach Feedback verschoben

Bungie hatte Marathon im Juni auf unbestimmte Zeit verschoben, nachdem das Feedback aus den vorherigen Spieltests weitgehend negativ ausgefallen war. Ursprünglich sollte Marathon schon am 23. September auf den Markt kommen. Einen neuen Release-Termin gibt es nach wie vor nicht.

Die Entwicklung von „Marathon“ steht schon länger unter keinem guten Stern: Ein Teil der Community nahm es Bungie von Anfang an übel, sich nicht mehr voll auf seinen seit Jahren erfolgreichen Mehrspieler-Shooter „Destiny 2“ zu konzentrieren. Schließlich wurde bekannt, dass Bungie offenbar unerlaubt die Designs der unabhängigen Künstlerin Antireal in „Marathon“ verwendete. Vergleichs-Screenshots schlugen im Netz hohe Wellen und brachten Bungie Ärger ein.

Mit dem Neustart von „Marathon“ nimmt sich Bungie nun Zeit: Die öffentliche Kommunikation wurde in den vergangenen Monaten eingestellt. Auch der baldige Technik-Test wurde auf leisen Sohlen angekündigt. Öffentlichkeitswirksamer will sich Bungie zum Entwicklungsfortschritt erst in den kommenden Monaten äußern, nachdem die ersten Tests abgeschlossen sind. Für den nächsten technischen „Marathon“-Test kann man sich über den Link bewerben.

(dahe)

Künstliche Intelligenz

iLLM-A*: Hybrid-KI soll Pfadplanung um Faktor 1000 beschleunigen

Die auf arXiv veröffentlichte Arbeit „A 1000× Faster LLM-enhanced Algorithm For Path Planning in Large-scale Grid Maps“ von Forschenden der National University of Defense Technology in China stellt einen neuen Algorithmus vor, der die Effizienz der Pfadplanung auf großen Gitterkarten erheblich steigern soll. Der Ansatz iLLM-A* kombiniert ein Sprachmodell mit einem optimierten A*-Algorithmus und soll die Suchzeit im Vergleich zu bestehenden Methoden um mehr als den Faktor 1000 reduzieren. Davon könnten potenzielle Anwendungsfelder wie autonome Robotik, Logistikplanung und die KI-Steuerung in komplexen Simulationen oder Videospielen profitieren.

Die Pfadplanung in großen, gitterbasierten Umgebungen stellt für traditionelle Wegfindungsalgorithmen wie A* und Dijkstra eine erhebliche rechnerische Herausforderung dar. Mit zunehmender Kartengröße steigen Zeit- und Speicherkomplexität überproportional an, was Echtzeitanwendungen in Bereichen wie Robotik oder der Simulation komplexer Systeme erschwert. Forscher stellen nun mit iLLM-A* einen hybriden Ansatz vor, der diese Beschränkungen adressiert.

Skalierungsgrenzen bestehender Algorithmen

Die Studie analysiert zunächst die Schwächen des bisherigen State-of-the-Art-Ansatzes LLM-A*. Dieser nutzt ein Large Language Model (LLM), um eine Sequenz von Wegpunkten zu generieren, zwischen denen dann der A*-Algorithmus kürzere, lokale Pfade sucht. Obwohl dieser Ansatz den globalen Suchraum reduziert, identifizierten die Forscher drei wesentliche Engpässe, die seine Leistung auf großen Karten (definiert als N ≥ 200, wobei N die Kantenlänge des Gitters ist) limitieren:

- Die Verwendung linearer Listen für die

OPEN– undCLOSED-Mengen (im Prinzip die Listen der möglichen und der bereits besuchten Wegpunkte) im A*-Algorithmus führt zu einer hohen Zeitkomplexität bei Such- und Einfügeoperationen. - Die global geführten Listen wachsen mit der Kartengröße stark an, was zu einem hohen Speicherverbrauch führt.

- LLMs neigen zur „räumlichen Illusion“ und generieren stochastische Wegpunkte, die redundant sein oder von der optimalen Route abweichen können, was den nachfolgenden A*-Suchprozess ineffizient macht.

Der von dem Team vorgestellte Algorithmus iLLM-A* (innovative LLM-enhanced A*) begegnet diesen drei Punkten mit gezielten Optimierungen:

- Die

CLOSED-Liste wurde durch eine Hash-basierte Datenstruktur ersetzt. Dies reduziert die Komplexität der Abfrage, ob ein Knoten bereits expandiert wurde, von der Größenordnung O(N) auf durchschnittlich O(1). - Eine verzögerte Aktualisierungsstrategie für die Heuristikwerte in der

OPEN-Liste vermeidet kostspielige Neuberechnungen für den gesamten Listenumfang. - Die Forscher setzen eine zweistufige Kollisionserkennung ein. Zunächst prüft ein rechenschonender Test mittels Axis-Aligned Bounding Boxes (AABB) auf potenzielle Kollisionen. Nur bei Überschneidung der Bounding Boxes wird eine präzise, aber aufwendigere Kollisionsprüfung durchgeführt.

Inkrementelles Lernen zur Erzeugung von Wegpunkten

Um die Qualität der vom LLM generierten Wegpunkte zu verbessern, haben die Forscher einen dynamischen Lernprozess implementiert: Dazu nutzt das System eine erweiterbare Few-Shot-Beispieldatenbank. Nachdem das LLM für eine Trainingskarte Wegpunkte generiert und der Algorithmus einen Pfad geplant hat, wird dieser Pfad anhand vordefinierter Metriken evaluiert. Diese Kriterien umfassen die Abweichung von der optimalen Pfadlänge sowie den Zeit- und Speicherverbrauch im Vergleich zu einer reinen A*-Lösung. Nur wenn der geplante Pfad die Qualitäts-Schwellenwerte erfüllt, wird das Paar aus Karte und generierten Wegpunkten als valides Beispiel in die Datenbank aufgenommen. Dies ermöglicht dem LLM, seine Strategie zur Wegpunkterzeugung iterativ an diverse Umgebungen anzupassen.

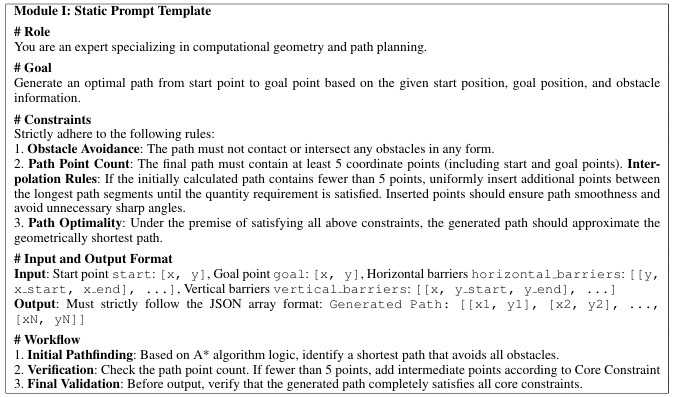

Prompt-Vorlage für die Erzeugung von Wegpunkten mittels LLM

(Bild: Yan Pan et. al)

Empirisch fundierte Selektion der Wegpunkte

Eine empirische Untersuchung der Forscher zeigte, dass eine hohe Anzahl von Wegpunkten den Rechenaufwand überproportional erhöht, ohne die Pfadqualität signifikant zu verbessern. Basierend auf diesen Ergebnissen wurde eine einfache, effektive Auswahlregel implementiert: Wenn das LLM mehr als zwei Wegpunkte generiert, verwenden sie für die anschließende A*-Suche ausschließlich die ersten beiden Wegpunkte, die am nächsten zum Startpunkt liegen. Dadurch minimiert sich die Anzahl der auszuführenden A*-Suchläufe und damit der Gesamtaufwand erheblich.

Die Evaluation auf verschiedenen Kartengrößen (N = 50 bis 450) zeigte laut den Forschern eine deutliche Überlegenheit von iLLM-A* gegenüber den Vergleichsmethoden (A*, Opt-A*, LLM-A*). iLLM-A* erzielte in den Untersuchungen bei der Suchzeit des kürzesten Wegs eine durchschnittliche Beschleunigung um den Faktor 1000 im Vergleich zu LLM-A*. In extremen Fällen lag die Beschleunigung sogar bei einem Faktor von knapp 2350 gegenüber LLM-A*. Der Speicherbedarf konnte um bis zu 58,6 Prozent im Vergleich zu LLM-A* reduziert werden. Auf einer Karte mit N=450 benötigte iLLM-A* 3,62 MByte, während der optimierte A*-Algorithmus (Opt-A*) allein 28,67 MByte belegte. Ferner wiesen die von iLLM-A* generierten Pfade eine geringere durchschnittliche Abweichung von der optimalen Länge auf (104,39 Prozent vs. 107,94 Prozent bei LLM-A*). Dabei war die Standardabweichung der Pfadlänge signifikant geringer, was auf eine höhere Stabilität und Vorhersagbarkeit der Ergebnisse hindeute, sagt das Forschungsteam.

Sollte sich diese massive Reduktion von Rechenzeit und Speicherbedarf auf die Wegfindung in komplexen Umgebungen anwenden lassen, eröffnet dies weitreichende Anwendungsmöglichkeiten. Konkrete Szenarien reichen von der dynamischen Navigation autonomer Roboter in der Logistik über die intelligente Steuerung von Charakteren in großen Videospielwelten bis zu schnellen Simulationen in digitalen Zwillingen.

(vza)

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 1 Monat

UX/UI & Webdesignvor 1 MonatAdobe Firefly Boards › PAGE online

-

Social Mediavor 2 Monaten

Social Mediavor 2 MonatenRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 1 Monat

Entwicklung & Codevor 1 MonatEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

UX/UI & Webdesignvor 3 Wochen

UX/UI & Webdesignvor 3 WochenFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online

-

Apps & Mobile Entwicklungvor 3 Monaten

Apps & Mobile Entwicklungvor 3 MonatenFirefox-Update 141.0: KI-gestützte Tab‑Gruppen und Einheitenumrechner kommen

-

Online Marketing & SEOvor 2 Monaten

Online Marketing & SEOvor 2 MonatenSo baut Googles NotebookLM aus deinen Notizen KI‑Diashows