Künstliche Intelligenz

iLLM-A*: Hybrid-KI soll Pfadplanung um Faktor 1000 beschleunigen

Die auf arXiv veröffentlichte Arbeit „A 1000× Faster LLM-enhanced Algorithm For Path Planning in Large-scale Grid Maps“ von Forschenden der National University of Defense Technology in China stellt einen neuen Algorithmus vor, der die Effizienz der Pfadplanung auf großen Gitterkarten erheblich steigern soll. Der Ansatz iLLM-A* kombiniert ein Sprachmodell mit einem optimierten A*-Algorithmus und soll die Suchzeit im Vergleich zu bestehenden Methoden um mehr als den Faktor 1000 reduzieren. Davon könnten potenzielle Anwendungsfelder wie autonome Robotik, Logistikplanung und die KI-Steuerung in komplexen Simulationen oder Videospielen profitieren.

Die Pfadplanung in großen, gitterbasierten Umgebungen stellt für traditionelle Wegfindungsalgorithmen wie A* und Dijkstra eine erhebliche rechnerische Herausforderung dar. Mit zunehmender Kartengröße steigen Zeit- und Speicherkomplexität überproportional an, was Echtzeitanwendungen in Bereichen wie Robotik oder der Simulation komplexer Systeme erschwert. Forscher stellen nun mit iLLM-A* einen hybriden Ansatz vor, der diese Beschränkungen adressiert.

Skalierungsgrenzen bestehender Algorithmen

Die Studie analysiert zunächst die Schwächen des bisherigen State-of-the-Art-Ansatzes LLM-A*. Dieser nutzt ein Large Language Model (LLM), um eine Sequenz von Wegpunkten zu generieren, zwischen denen dann der A*-Algorithmus kürzere, lokale Pfade sucht. Obwohl dieser Ansatz den globalen Suchraum reduziert, identifizierten die Forscher drei wesentliche Engpässe, die seine Leistung auf großen Karten (definiert als N ≥ 200, wobei N die Kantenlänge des Gitters ist) limitieren:

- Die Verwendung linearer Listen für die

OPEN– undCLOSED-Mengen (im Prinzip die Listen der möglichen und der bereits besuchten Wegpunkte) im A*-Algorithmus führt zu einer hohen Zeitkomplexität bei Such- und Einfügeoperationen. - Die global geführten Listen wachsen mit der Kartengröße stark an, was zu einem hohen Speicherverbrauch führt.

- LLMs neigen zur „räumlichen Illusion“ und generieren stochastische Wegpunkte, die redundant sein oder von der optimalen Route abweichen können, was den nachfolgenden A*-Suchprozess ineffizient macht.

Der von dem Team vorgestellte Algorithmus iLLM-A* (innovative LLM-enhanced A*) begegnet diesen drei Punkten mit gezielten Optimierungen:

- Die

CLOSED-Liste wurde durch eine Hash-basierte Datenstruktur ersetzt. Dies reduziert die Komplexität der Abfrage, ob ein Knoten bereits expandiert wurde, von der Größenordnung O(N) auf durchschnittlich O(1). - Eine verzögerte Aktualisierungsstrategie für die Heuristikwerte in der

OPEN-Liste vermeidet kostspielige Neuberechnungen für den gesamten Listenumfang. - Die Forscher setzen eine zweistufige Kollisionserkennung ein. Zunächst prüft ein rechenschonender Test mittels Axis-Aligned Bounding Boxes (AABB) auf potenzielle Kollisionen. Nur bei Überschneidung der Bounding Boxes wird eine präzise, aber aufwendigere Kollisionsprüfung durchgeführt.

Inkrementelles Lernen zur Erzeugung von Wegpunkten

Um die Qualität der vom LLM generierten Wegpunkte zu verbessern, haben die Forscher einen dynamischen Lernprozess implementiert: Dazu nutzt das System eine erweiterbare Few-Shot-Beispieldatenbank. Nachdem das LLM für eine Trainingskarte Wegpunkte generiert und der Algorithmus einen Pfad geplant hat, wird dieser Pfad anhand vordefinierter Metriken evaluiert. Diese Kriterien umfassen die Abweichung von der optimalen Pfadlänge sowie den Zeit- und Speicherverbrauch im Vergleich zu einer reinen A*-Lösung. Nur wenn der geplante Pfad die Qualitäts-Schwellenwerte erfüllt, wird das Paar aus Karte und generierten Wegpunkten als valides Beispiel in die Datenbank aufgenommen. Dies ermöglicht dem LLM, seine Strategie zur Wegpunkterzeugung iterativ an diverse Umgebungen anzupassen.

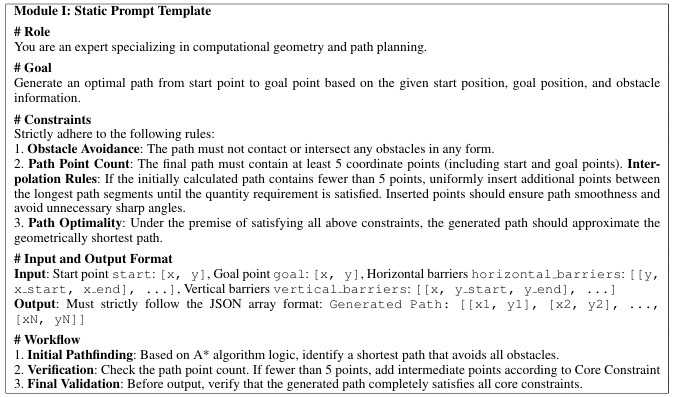

Prompt-Vorlage für die Erzeugung von Wegpunkten mittels LLM

(Bild: Yan Pan et. al)

Empirisch fundierte Selektion der Wegpunkte

Eine empirische Untersuchung der Forscher zeigte, dass eine hohe Anzahl von Wegpunkten den Rechenaufwand überproportional erhöht, ohne die Pfadqualität signifikant zu verbessern. Basierend auf diesen Ergebnissen wurde eine einfache, effektive Auswahlregel implementiert: Wenn das LLM mehr als zwei Wegpunkte generiert, verwenden sie für die anschließende A*-Suche ausschließlich die ersten beiden Wegpunkte, die am nächsten zum Startpunkt liegen. Dadurch minimiert sich die Anzahl der auszuführenden A*-Suchläufe und damit der Gesamtaufwand erheblich.

Die Evaluation auf verschiedenen Kartengrößen (N = 50 bis 450) zeigte laut den Forschern eine deutliche Überlegenheit von iLLM-A* gegenüber den Vergleichsmethoden (A*, Opt-A*, LLM-A*). iLLM-A* erzielte in den Untersuchungen bei der Suchzeit des kürzesten Wegs eine durchschnittliche Beschleunigung um den Faktor 1000 im Vergleich zu LLM-A*. In extremen Fällen lag die Beschleunigung sogar bei einem Faktor von knapp 2350 gegenüber LLM-A*. Der Speicherbedarf konnte um bis zu 58,6 Prozent im Vergleich zu LLM-A* reduziert werden. Auf einer Karte mit N=450 benötigte iLLM-A* 3,62 MByte, während der optimierte A*-Algorithmus (Opt-A*) allein 28,67 MByte belegte. Ferner wiesen die von iLLM-A* generierten Pfade eine geringere durchschnittliche Abweichung von der optimalen Länge auf (104,39 Prozent vs. 107,94 Prozent bei LLM-A*). Dabei war die Standardabweichung der Pfadlänge signifikant geringer, was auf eine höhere Stabilität und Vorhersagbarkeit der Ergebnisse hindeute, sagt das Forschungsteam.

Sollte sich diese massive Reduktion von Rechenzeit und Speicherbedarf auf die Wegfindung in komplexen Umgebungen anwenden lassen, eröffnet dies weitreichende Anwendungsmöglichkeiten. Konkrete Szenarien reichen von der dynamischen Navigation autonomer Roboter in der Logistik über die intelligente Steuerung von Charakteren in großen Videospielwelten bis zu schnellen Simulationen in digitalen Zwillingen.

(vza)

Künstliche Intelligenz

Wie ein französischer Richter von den USA digital abgeklemmt wurde

Über digitale Souveränität ist in den vergangenen Wochen in Europa viel diskutiert worden, zuletzt während eines deutsch-französischen Gipfeltreffens in Berlin. Wie stark die Abhängigkeit von den USA im Digitalbereich tatsächlich ist, bekommt aktuell ein französischer Richter zu spüren. Nicolas Guillou ist als einer von sechs Richtern und drei Staatsanwälten des Internationalen Strafgerichtshofs (International Criminal Court, ICC) von den USA im August mit Sanktionen belegt worden. Seine aktuelle Situation sei wie eine digitale Zeitreise zurück in die 1990er, vor dem Internet-Zeitalter, schilderte er jetzt in einem Interview.

Weiterlesen nach der Anzeige

Grund für die US-Sanktionen sind die Haftbefehle gegen den israelischen Premierminister Benjamin Netanjahu und den Verteidigungsminister Yoav Gallant. Sie wurden wegen Kriegsverbrechen und Verbrechen gegen die Menschlichkeit im Kontext der Zerstörung des Gazastreifens angeklagt. Die USA verurteilten diese Entscheidung des Gerichtshofs, woraufhin das US-Finanzministerium sechs Richter und drei Staatsanwälte mit Sanktionen belegte.

Digital von fast allem ausgeschlossen

Im Alltag von Guillou bedeutet das, dass er vom digitalen Leben und vielem, was heute als Standard gilt, ausgeschlossen ist, schilderte er der französischen Zeitung Le Monde. All seine Konten bei US-Unternehmen wie Amazon, Airbnb oder PayPal wurden von den Anbietern sofort geschlossen. Online-Buchungen, wie über Expedia, werden sofort storniert, selbst wenn es um Hotels in Frankreich geht. Auch die Teilnahme am E-Commerce sei ihm praktisch nicht mehr möglich, da US-Unternehmen auf die eine oder andere Weise immer eine Rolle spielen, und es diesen strikt untersagt ist, mit Sanktionierten in irgendeine Handelsbeziehung zu treten.

Als drastisch beschreibt er auch die Auswirkungen, am Bankenwesen teilzunehmen. Zahlungssysteme seien für ihn blockiert, da US-Unternehmen wie American Express, Visa und Mastercard quasi über ein Monopol in Europa verfügten. Auch das restliche Banking beschreibt er als stark eingeschränkt. So seien auch Konten bei nicht-amerikanischen Banken teilweise geschlossen worden. Transaktionen in US-Dollar oder über Dollar-Konversion sind ihm verboten.

Richter: EU sollte Sanktionen blockieren

Guillous Fall zeigt auf, wie stark der Einfluss der USA auf den Tech-Bereich ist, und wie wenige Möglichkeiten er hat, auszuweichen. Und dies in einer Zeit, in der an immer mehr Stellen ein Account bei einem US-Tech-Unternehmen als selbstverständlich angesehen wird.

Weiterlesen nach der Anzeige

Der französische Richter plädiert dafür, dass Europa mehr Souveränität im Digital- und Bankensektor gewinnen sollte. Ohne diese Souveränität könne der Rechtsstaat nicht garantiert werden, warnt er. Zugleich fordert er von der EU, für den Internationalen Strafgerichtshof eine bestehende Blocking-Regelung (Verordnung EG Nr. 2271/96) zu aktivieren, die Drittstaaten wie die USA daran hindert, Sanktionen in der EU durchzusetzen. EU-Unternehmen dürften dann US-Sanktionen nicht mehr befolgen, wenn diese EU-Interessen verletzen. Unternehmen, die dagegen verstoßen, wären dann schadensersatzpflichtig.

(mki)

Künstliche Intelligenz

Auracast für Kopfhörer- und Hörgeräteträger im Test

Auracast, eine Erweiterung des Bluetooth-Protokolls, mit der Audioquellen an unlimitierte Zahl von Empfängern senden können, kommt endlich in den Endgeräten an: Smartphones, aber auch Fernseher übertragen den Ton mit der Bluetooth-Streamingerweiterung vorwiegend an drahtlose Kopf- und Ohrhörer, aber auch drahtlose Lautsprecherboxen sowie an Hörgeräte. Damit kann ein gutes Stück Inklusion von Hörgeschädigten gelingen, sind sie doch nicht länger auf proprietäre drahtlose Übertragungssysteme oder die gute alte Telefonspule mit all ihren Störungen angewiesen.

- Auracast wurde als allgemeine Übertragungsspezifikation für drahtlose Kopfhörer, Ohrhörer und Lautsprecher entwickelt.

- Mit Auracast-fähigen Hörgeräten haben Hörbehinderte grundsätzlich die Möglichkeit, ohne spezielle Hardware an Audio-Streams bei Freunden, im Kino oder auch bei Konzerten teilzuhaben.

- Während im Bereich der Hörhilfen 24 kHz Sampling-Rate Standard sind, verwenden Hi-Fi-Geräte Bitraten von 48 kHz und mehr, um einen größeren Frequenzbereich übertragen zu können. Hörgeräte können das jedoch nicht leisten.

In einer idealen Welt, in der jeder via Auracast statt dem heute üblichen Bluetooth LE Musik hört oder Videos anschaut, sollten sich Hörbehinderte ganz selbstverständlich mit ihren Hörgeräten in den Audiostream einklinken und mithören können. Genau wie Freunde oder die Familie, jeder mit seinen eigenen, natürlich Auracast-fähigen Kopfhörern – vorausgesetzt man ist eingeladen und hat das nötige Passwort zum Stream erhalten. So bleibt die Privatsphäre gewahrt.

Wir haben uns mit Hörgeräten, Ohrhörern, Smartphones, Auracast-Streamern und einem TV angesehen, wie der aktuelle Entwicklungsstand bei Auracast aussieht und ob Hörgeräteträger in Zukunft tatsächlich ohne Mehraufwand in der Lage sind, die verschiedenen Auracast Broadcasts zu empfangen. Als Sender haben wir das aktuelle Samsung Galaxy S25 Ultra verwendet, dessen Vorgänger S24 bereits Auracast Broadcasts beherrschte, außerdem den OLED-Fernseher Samsung Neo QN990F 8K. Mit von der Partie waren zudem die bereits zuvor getesteten Auracast-Streamer Creative BT-W6, GN ReSound TV-Streamer+ und Humantechnik earisMAX HT-01, mit denen sich Computer, Fernseher oder andere Hi-Fi-Geräte nachträglich um Auracast erweitern lassen. Als Empfänger benutzten wir die Ohrhörer Earfun Air Pro 4 aus unserem In-Ear-Kopfhörertest und die ebenfalls Auracast-fähigen Hörgeräte ReSound Enzo IA 998.

Das war die Leseprobe unseres heise-Plus-Artikels „Auracast für Kopfhörer- und Hörgeräteträger im Test“.

Mit einem heise-Plus-Abo können Sie den ganzen Artikel lesen.

Künstliche Intelligenz

Münchner Robotik-Unternehmen Agile Robots zeigt seinen ersten humanoiden Roboter

Das Robotik-Unternehmen Agile Robots mit Hauptsitz in München hat mit dem Agile One seinen ersten humanoiden Roboter vorgestellt. Der Roboter ist dafür konzipiert, um in strukturierten industriellen Arbeitsumgebungen zusammen mit Menschen zu arbeiten. Die Produktion des Agile One soll bereits Anfang 2026 beginnen – in Deutschland.

Weiterlesen nach der Anzeige

Der humanoide Roboter Agile One ist 174 cm groß, wiegt 69 kg und ist in der Lage, Gewichte bis zu 20 kg zu tragen. Seine Gehgeschwindigkeit gibt Agile Robots mit 2 m/s an. Das sind 7,2 km/h – liegt also in etwa auf dem Niveau eines zügig gehenden Menschen. Mehr technische Informationen zu dem Roboter verrät Agile Robots zunächst nicht. So ist unklar, welche Aktuatoren im Roboter eingebaut sind und wie lange er durchschnittlich pro Tag mit einer Batteriefüllung im Einsatz sein kann.

Festzustehen scheint, dass der humanoide Agile One mit Händen mit fünf beweglichen Fingern ausgestattet ist, wie verschiedene Videos zeigen. Integriert sind Fingerspitzensensoren und Kraft-Drehmoment-Sensoren in den Gelenken, sodass die Maschine je nach Aufgabe feinfühlig oder kraftvoll zupacken kann. In Videos ist etwa zu sehen, dass sie damit kleine Gegenstände wie Schrauben greifen kann. Ob der Agile One damit in der Lage ist, auch filigranere Montagearbeiten in der Industrie durchzuführen, muss sich noch zeigen. Agile Robots spricht in einer Mitteilung aber davon, dass der Roboter für „präzise Manipulationsaufgaben“ geeignet sei. Ferner soll er hauptsächlich Transport- und Pick-and-Place-Aufgaben übernehmen sowie Maschinen und Werkzeuge nutzen können, erklärt Agile Robots.

Kollaborativer Roboter für die Industrie

Ein Schwerpunkt des Agile One liegt auf der Zusammenarbeit mit Menschen. Dazu hat Agile Robots ihn mit diversen Näherungssensoren ausgestattet, die einen sicheren Betrieb des Roboters in Menschennähe ermöglichen sollen. Das Design des Agile One bezeichnet das Unternehmen selbst als „klar und farbenfroh“, seine Augen als „reaktionsfreudig“, sodass er nicht so leblos wirkt wie andere humanoide Roboter. Menschen sollen mit ihm per Sprache und über ein Info-Display kommunizieren können.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externes YouTube-Video (Google Ireland Limited) geladen.

Das Werbevideo zeigt den humanoiden Roboter Agile One.

Die Künstliche Intelligenz (KI) des Roboters wurde mit einem der größten industriellen Datensätze Europas und mit menschlich erfassten Daten trainiert. Der Roboter soll sich durch weiteres anwendungsspezifisches Training auf neue Aufgaben in der Industrie anpassen lassen. Agile Robots realisiert die humanoide Intelligenz über eine mehrschichtige KI-Architektur. Jede dieser Schichten ist auf eine spezifische Ebene von Kognition und Steuerung spezialisiert. Das können etwa strategisches Denken, Aufgabenplanung, schnelle Reaktionsfähigkeit und feinmotorische Präzision sein. Dadurch soll der Roboter an viele verschiedene Aufgaben anpassbar sein.

Das Training des KI-Modells des Agile One erfolgt laut Agile Robots in der Industrial AI Cloud der Deutschen Telekom und von Nvidia. Die Industrial AI Cloud basiert auf rund 10.000 Nvidia-GPUs und wird neben dem KI-Training auch dafür genutzt, um etwa neue Daten für Simulationen zu generieren. Agile Robots betont, dass sich die Rechenzentren der Cloud in Deutschland befinden und europäischen Datenschutzstandards entsprechen.

Weiterlesen nach der Anzeige

Das 2018 vom heutigen CEO Zhaopeng Chen und Mitarbeitern des Deutschen Zentrums für Luft- und Raumfahrt (DLR) gegründete Unternehmen Agile Robots beabsichtigt, den Agile One bereits ab Anfang 2026 in einem eigenen Werk in Bayern zu produzieren. In welchen Stückzahlen das erfolgen wird, teilte das Unternehmen nicht mit.

(olb)

-

UX/UI & Webdesignvor 3 Monaten

UX/UI & Webdesignvor 3 MonatenAdobe Firefly Boards › PAGE online

-

UX/UI & Webdesignvor 1 Monat

UX/UI & Webdesignvor 1 MonatIllustrierte Reise nach New York City › PAGE online

-

Apps & Mobile Entwicklungvor 3 Monaten

Apps & Mobile Entwicklungvor 3 MonatenGalaxy Tab S10 Lite: Günstiger Einstieg in Samsungs Premium-Tablets

-

Datenschutz & Sicherheitvor 3 Monaten

Datenschutz & Sicherheitvor 3 MonatenHarte Zeiten für den demokratischen Rechtsstaat

-

Datenschutz & Sicherheitvor 2 Monaten

Datenschutz & Sicherheitvor 2 MonatenJetzt patchen! Erneut Attacken auf SonicWall-Firewalls beobachtet

-

Online Marketing & SEOvor 3 Monaten

Online Marketing & SEOvor 3 Monaten„Buongiorno Brad“: Warum Brad Pitt für seinen Werbejob bei De’Longhi Italienisch büffeln muss

-

Online Marketing & SEOvor 3 Monaten

Online Marketing & SEOvor 3 MonatenCreator und Communities: Das plant der neue Threads-Chef

-

Entwicklung & Codevor 3 Monaten

Entwicklung & Codevor 3 MonatenEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events