Künstliche Intelligenz

Kinderarzt zur ePA und Co.: Warum Eltern nicht alles wissen dürfen

Elektronische Patientenakten, E-Rezepte, Apps und Künstliche Intelligenz sollen die medizinische Versorgung moderner und effizienter machen. Gleichzeitig wächst die Sorge um Datenschutz und Vertraulichkeit – auch bei sensiblen Gesundheitsdaten von Kindern und Jugendlichen.

Weiterlesen nach der Anzeige

Nach Kritik aus der Praxis wurden inzwischen erste Verbesserungen auf den Weg gebracht: So müssen Kinderärzte besonders heikle Informationen, etwa aus psychotherapeutischen oder sexualmedizinischen Behandlungen, künftig nicht mehr verpflichtend in die elektronische Patientenakte eintragen, „sofern dem erhebliche therapeutische Gründe entgegenstehen“ oder „gewichtige Anhaltspunkte für die Gefährdung des Wohles eines Kindes oder eines Jugendlichen vorliegen und die Befüllung der elektronischen Patientenakte den wirksamen Schutz des Kindes oder Jugendlichen in Frage stellen würde“.

Und auch die Abrechnungsdaten sollen mit Änderungen am Gesetz zur Befugniserweiterung und Entbürokratisierung in der Pflege nicht mehr automatisch für alle am Behandlungsprozess Beteiligten sichtbar sein.

Michael Achenbach ist Kinderarzt und Vorstandsmitglied im Landesverband der Kinder- und Jugendärzt*innen (BVKJ) Westfalen Lippe und hat unter anderem Technik in der Medizin studiert.

(Bild: BVKJ)

Warum das so wichtig ist und über Chancen, Grenzen und offene Fragen bei der Digitalisierung spricht Dr. Achenbach mit heise online. Er ist Kinder- und Jugendarzt sowie langjährig engagierter Experte für digitale Gesundheitsanwendungen.

Besteht die Sorge zu Recht, dass sensible Daten in der elektronischen Patientenakte (ePA) zu leicht und unkontrolliert zur Verfügung stehen?

Ja, und das gilt besonders bei Jugendlichen. Viele denken, Eltern dürften alles wissen, was ihre jugendlichen Kinder betrifft. Dem ist aber nicht so. Sobald man einsichtsfähig ist – und das kann schon vor dem 15. Geburtstag sein –, gilt die ärztliche Schweigepflicht auch gegenüber den Eltern. Wenn dann sensible Daten, etwa aus psychotherapeutischen Behandlungen oder welche, die die sexuelle Gesundheit betreffen, automatisch in der ePA landen, kann das fatale Folgen haben. Dann sehen Eltern mit Zugriff Dinge, die vertraulich bleiben müssten. Ärztliche Schweigepflicht bedeutet eben auch, den Kindern Schutz gegenüber den Eltern zu ermöglichen, sobald das Kind reif genug ist, eigenständig über Behandlungen zu entscheiden.

Die Patienten sollen ihre Gesundheitsinformationen dank der ePA selbst verwalten können. Ist das Ihrer Meinung nach realistisch?

Grundsätzlich ja, aber nur, wenn die Rahmenbedingungen stimmen. Momentan fehlt die Möglichkeit, alte oder überholte Daten wirklich zu löschen. Das sogenannte Recht auf Vergessenwerden existiert für die ePA bislang nur sehr eingeschränkt. Wenn beispielsweise ein Kind wegen einer psychischen oder sozialen Auffälligkeit behandelt wurde – sagen wir, einer Störung des Sozialverhaltens – bleibt diese Diagnose in der Akte stehen, selbst wenn sie Jahre später keinerlei Relevanz mehr hat – sofern sie niemand selbst löscht oder löschen lässt. Solche Einträge können später bei Versicherungen oder Bewerbungen problematisch werden. Da braucht es klare, rechtlich abgesicherte Löschmechanismen – auch für Kinder, deren Eltern das vielleicht gar nicht bedenken. Wer sich selbst um seine Akte oder im Bedarfsfall die seiner Angehörigen kümmert, den betrifft das selbstverständlich nicht.

Weiterlesen nach der Anzeige

Die Versicherungen können unter bestimmten Umständen aber auch Daten austauschen?

Versicherungen tauschen Daten aber nicht über die ePA untereinander aus, das ist ein Trugschluss. Die Krankenkassen haben nämlich gar keinen direkten Zugriff auf die Inhalte der ePA; sie können zwar Dokumente einstellen, sie aber nicht betrachten. Ein eventueller Datenaustausch unter den Kassen läuft an der ePA vorbei, ist also davon gar nicht betroffen.

Ärzte sind gesetzlich zur Befüllung der ePA, aber auch zur Dokumentation verpflichtet. Gibt es da Herausforderungen?

Die ePA ersetzt die herkömmlichen Patientenakten nicht, sondern ist lediglich aus Informationen aus den herkömmlichen Patientenakten, die Ärztinnen führen müssen, gespeist. Daher eignet sich die ePA nicht, um gesetzliche Aufbewahrungserfordernisse der Ärzte zu erfüllen. Diese haben gesetzliche Aufbewahrungspflichten, Patienten dagegen ein Löschrecht in ihrer ePA – das passt schlicht nicht zusammen. Wenn Behandlungsunterlagen vom Patienten gelöscht werden können, kann die Ärztin ihre Dokumentationspflicht nicht mehr erfüllen. Die ePA ist daher nur ein zusätzliches Instrument, um Informationen abzubilden, nicht aber dazu geeignet, die originäre ärztliche Dokumentation zu ersetzen oder aufzubewahren.

Die Aufbewahrungspflichten sind umfangreich: Sie betragen meist zehn, teils bis zu 30 Jahre, bei Minderjährigen oft noch länger. Die Archive dürfen zwar elektronisch geführt werden, doch wer garantiert, dass Daten auch nach Jahrzehnten noch zugänglich sind? Die sichere elektronische Langzeitarchivierung ist bisher kaum etabliert. Eine Herausforderung dabei ist auch die Findbarkeit der Daten, die entsprechend – je nach Archivierungszeitraum – gekennzeichnet sein müssen, damit diese auch ordnungsgemäß gelöscht werden können.

Die ärztliche Dokumentation ist ein rechtsverbindlicher Teil des Behandlungsvertrags und dient im Streitfall auch der Beweissicherung – etwa wenn Jahre später Behandlungsfehler behauptet werden. Patientinnen und Patienten hingegen sollen in ihrer ePA frei entscheiden dürfen, welche Daten sie behalten oder löschen. Deshalb brauchen wir zwei getrennte Systeme: eines für die rechtssichere medizinische Dokumentation und ein zweites, flexibles für den patientengesteuerten Informationsaustausch.

Hinzu kommen gesetzliche Regelungen wie im Gendiagnostikgesetz, das nach zehn Jahren sogar eine Vernichtungspflicht vorsieht. Das zeigt, wie widersprüchlich und komplex der Umgang mit medizinischen Daten in der Praxis geworden ist. Wie man Daten aus Backups tatsächlich löscht oder durch Schlüsselvernichtung unzugänglich macht, ist technisch und organisatorisch noch wenig durchdacht – sowohl in vielen Praxen als auch bei den Softwareanbietern.

Besonders diskutiert werden regelmäßig die sogenannten F-Diagnosen, also Diagnosen aus dem psychiatrischen ICD-Kapitel. Dies betrifft uns Kinder- und Jugendärzte ebenfalls, denn in diesem Kapitel finden sich auch die kindlichen Entwicklungsstörungen. Also nicht nur die eben schon genannte Störung des Sozialverhaltens, sondern zum Beispiel auch die Entwicklungsstörung der Fein- und Graphomotorik, die Artikulationsstörung und so weiter. Diagnosen, die also bei Kindern oft über Jahre – korrekterweise – in der arztgeführten Patientenakte dokumentiert sind, somit klassische Dauerdiagnosen. Wenn aber Patienten die Problematik überwunden haben, bleiben die Diagnosen dennoch in der Akte – denn sie wirken sich oftmals auf die weitere Betreuung aus. Viele Studien zu Entwicklungsstörungen zeigen longitudinale Zusammenhänge zwischen Problemen im frühen Kindesalter und späteren Problemstellungen, zum Beispiel im Jugendalter.

Ist die ePA rechtlich genauso geschützt wie die klassische Patientenakte?

Nein. Die ePA ist eine patientengeführte Akte und fällt damit nicht unter den ärztlichen Beschlagnahmeschutz. Man kann sie sich wie einen privaten Ordner vorstellen – auch der darf von Ermittlungsbehörden beschlagnahmt werden. Eine arztgeführte Fallakte dagegen wäre vor dem Zugriff durch Behörden geschützt. Das ist ein gravierender Unterschied, über den viele gar nicht Bescheid wissen.

Wie erleben Sie die Technik im Alltag?

Das E-Rezept funktioniert inzwischen halbwegs zuverlässig. Die Einlösung über die Versichertenkarte hat sich durchgesetzt. Aber die dazugehörige App spielt in der Praxis kaum eine Rolle. Die meisten nutzen sie gar nicht – sie gehen einfach mit der Karte in die Apotheke. Das bedeutet aber auch, dass sie oft nicht wissen, was auf dem Rezept steht, zum Beispiel oder wie das Medikament dosiert werden soll. Der Informationsvorteil für die Patientinnen und Patienten, den man sich mit der Einführung des E-Rezepts erhofft hatte, ist also ausgeblieben.

Die Systeme, sowohl für das E-Rezept als auch für die ePA, sind allerdings immer noch nicht stabil. Wenn man sieht, wie selten Kartenterminals im Supermarkt ausfallen, ist der Unterschied frappierend. In der Medizin tragen die Praxen die finanziellen Auswirkungen der durch Dritte ausgelösten Ausfälle selbst, obwohl sie die Technik nicht einmal frei wählen konnten. Das ist teuer, frustrierend und innovationsfeindlich. Ein konkretes Beispiel ist unser Kartenlesegerät in der Praxis. Ich habe noch keine einzige Arbeitswoche erlebt, in der es ohne Absturz durchgelaufen wäre.

Dabei haben Sie sich in der Vergangenheit immer sehr begeistert für die Digitalisierung gezeigt, beispielsweise für die App „Meine pädiatrische Praxis“. Was macht diese Anwendung anders?

Diese App ist tatsächlich ein gutes Beispiel dafür, wie Digitalisierung im Arzt-Patienten-Alltag funktionieren kann, wenn sie sinnvoll umgesetzt wird. Sie wurde vom Berufsverband der Kinder- und Jugendärzt*innen e.V. herausgegeben und dient als direkter Kommunikationskanal zwischen Praxis und Familien. Eltern können darüber Termine buchen, Erinnerungen an Vorsorgeuntersuchungen oder Impfungen erhalten und sogar Videosprechstunden starten. Ich kann Push-Nachrichten an bestimmte Altersgruppen oder Patientinnen und Patienten schicken, zum Beispiel, um über Grippeimpfungen zu informieren oder geänderte Sprechzeiten weiterzugeben.

Das System ist bewusst geschlossen und datensparsam aufgebaut – keine Cloud, keine unnötigen Drittanbieter. Die Nutzenden entscheiden selbst, welche Funktionen sie nutzen. So habe ich ein digitales Werkzeug, das zur Versorgung beiträgt, ohne den Datenschutz zu gefährden. Für mich ist das ein Schritt in die richtige Richtung: Digitalisierung nahe am praktischen Nutzen, nicht als bürokratische Pflichtübung.

Sie experimentieren außerdem mit KI-Modellen. Was genau testen Sie da?

Ich probiere zurzeit an Dummy-Daten aus, ob eine KI Dokumenttypen automatisch erkennen kann – also ob sie unterscheiden kann, ob ein Schreiben ein Arztbrief, ein Therapiebericht oder etwa ein Versicherungsnachweis ist. Das alles geschieht lokal, auf eigenen Servern, ohne Patientendaten im Netz. Ich nutze aktuelle Modelle, wie zum Beispiel „Qwen 3“ von Alibaba oder „gpt-oss“ von OpenAI. Sie arbeiten verhältnismäßig effizient und kommen mit wenig Rechenleistung aus, also ideal für den lokalen Einsatz. Wichtig ist mir dabei nämlich vor allem, dass ich die volle Kontrolle über die Daten habe und sie nicht an unbekannte Dritte weitergebe. Deshalb kommt Cloud-Computing für medizinische Informationen aktuell für mich nicht infrage.

Ist KI Ihrer Einschätzung nach reif für den Einsatz in Praxen?

Ja, mit Einschränkungen. In kritischen Bereichen – etwa bei Diagnosen oder Therapieentscheidungen – darf sie keine autonome Rolle spielen. Aber sie kann Prozesse erleichtern: zum Beispiel Arztbriefe vorsortieren oder Gesprächsnotizen zusammenfassen. Wichtig ist, dass ich als Arzt jederzeit kontrollieren kann, was die KI macht. Wenn ich selbst im Gespräch dabei bin, erkenne ich sofort, ob eine Zusammenfassung richtig ist. Wenn die KI dagegen fremde Texte auswertet, verliere ich diese Kontrolle. Dann wird’s riskant.

Ein anderes Thema, das beschäftigt, sind medizinische Register, wozu ein Registergesetz geplant ist. Warum ist das in Deutschland eine Herausforderung?

Wir haben über 400 verschiedene Register, aber alle sind freiwillig und voneinander isoliert. Länder wie Dänemark oder Schweden machen das besser – dort gibt es eine einheitliche Identifikationsnummer, über die Gesundheitsdaten pseudonymisiert zusammengeführt werden können. So konnten sie – die Dänen, nicht die Deutschen – zum Beispiel nachweisen, dass die Masernimpfung kein Autismusrisiko verursacht. Solche Erkenntnisse sind bei uns in Deutschland kaum möglich, weil die Datenbasis fehlt.

Würden Sie also sagen, ein zentrales Gesundheitsregister wäre der ePA vorzuziehen?

Für Forschungszwecke: ja, sofern der Datenschutz stimmt. Für die individuelle Versorgung: nein, da sollte alles freiwillig sein. Ich halte nichts von einer automatischen Befüllung der Patientenakte. Gesundheitsdaten sind persönlichstes Eigentum. Wenn jemand sie speichern will – gerne. Wenn nicht, dann eben nicht.

Sehen Sie bei seltenen Krankheiten Chancen in der Mustererkennung?

Ja, absolut. Wir Ärztinnen und Ärzte erkennen im besten Fall ein paar Hundert Krankheitsmuster, vielleicht 500. Es gibt aber mehrere Tausende seltener Erkrankungen. Eine gut trainierte KI kann helfen, Muster zu finden, die wir übersehen würden. Das erweitert unseren Blick. Ich habe das in meiner eigenen Familie erlebt. Eine nahe Verwandte litt jahrelang an Schmerzen, bis ich – durch Zufall – erkannte, dass sie an einer seltenen Bindegewebsschwäche erkrankt ist. Eine KI mit entsprechender Datenbasis hätte diesen Zusammenhang vielleicht früher erkannt.

Wie sehen Sie persönlich die digitale Zukunft der Medizin?

Ich finde die Zeit unglaublich spannend. Wir haben gewaltige Chancen – etwa durch offene KI-Modelle oder smarte Praxislösungen. Aber wir müssen sie sicher und verantwortungsvoll nutzen. Die ärztliche Schweigepflicht muss auch im digitalen Zeitalter gelten und die Daten der Patientinnen und Patienten dürfen nie heimlich zum Rohstoff für Dritte werden. Heimlichkeit umgeht das Recht auf selbstbestimmte Entscheidungen. Wenn Digitalisierung den Alltag wirklich erleichtert und die Versorgung verbessert, bin ich sofort dabei. Aber sie darf kein Selbstzweck sein.

(mack)

Das könnte Ihnen gefallen

-

Deutsche eID-Karte als Geldwäsche-Hilfe kritisiert

-

Gerüchte zu Studio Display 2: Neuer Monitor von Apple mit 120Hz, Mini-LED und A19-Chip

-

Reboot der Werbehelden: Wie KI Brand Characters zur kreativsten Marketingwaffe macht

-

Huawei-Neuheiten: FreeClip 2, MatePad 11.5 S, Mate X7 und Mesh X3 Pro kommen nach Deutschland

-

ChatGPT wird Nummer-1-App und integriert Adobes Kreativ-Suite

-

software-architektur.tv: Modelle und Modularisierung mit Alistair Cockburn

Künstliche Intelligenz

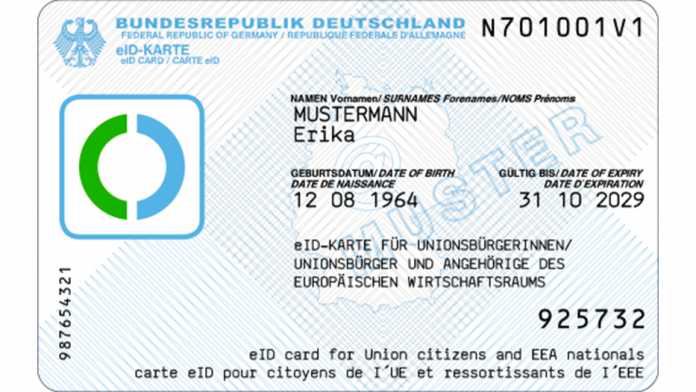

Deutsche eID-Karte als Geldwäsche-Hilfe kritisiert

Seit 2021 gibt es in Deutschland eID-Karten, die zum Online-Nachweis der eigenen Identität und Adresse gereichen. Sie kosten 37 Euro, gelten zehn Jahre und können von nicht-deutschen EWR-Bürgern ab 16 Jahren bei Einwohnermeldeämtern gelöst werden. Ein Bericht der Süddeutschen Zeitung (SZ) übt nun Kritik an der Handhabe der Ausstellung: Viele Ämter prüfen demnach die Identität der Antragsteller unzureichend, sodass sich Geldwäscher und anderen Kriminelle mit gefälschten oder gestohlenen ausländischen Ausweisen eID-Karten lösen könnten.

Weiterlesen nach der Anzeige

Muster einer eID-Karte

(Bild: Bundesministerium des Innern)

Antragsteller müssen für eine deutsche eID-Karte persönlich auf einem Einwohnermeldeamt vorsprechen und sich ausweisen. Allerdings hätten viele Meldeämter keine Prüfgeräte, um die Echtheit des vorgelegten Ausweises zu prüfen, weil diese Geräte teuer sind. Auch biometrische Abgleiche oder die Überprüfung, ob der vorgelegte Ausweis als gestohlen gemeldet ist, gehören nicht zum notwendigen Prüfregime, schließlich handelt es sich nicht um ein Reisedokument.

Der SZ-Bericht zitiert als Beispiel die Polizei Berlins: „Ein Abgleich biometrischer Daten oder ein Abgleich mit dem europäischen Dokumenten-Fahndungsbestand findet nicht statt. Nicht alle Meldebehörden sind mit Dokumentenprüfgeräten ausgestattet.“ Das Bundesinnenministerium hat die Zeitung darauf hingewiesen, dass diese Regelungen Aufgabe der Länder seien, die das sicherlich gewissenhaft erledigen würden.

Unzulässige Einsatzszenarien

Ist die Karte einmal ausgestellt, kann sie beispielsweise zur Online-Eröffnung von Bankkonten genutzt werden. Einfache Kriminelle würden mit gefälschten oder gestohlenen Dokumenten eID-Karten unter falscher Identität lösen, um damit Bankkonten mit Überziehungsrahmen zu eröffnen. Der Rahmen wird ausgereizt, dann verschwindet der virtuelle Kunde, die Bank bleibt auf dem Schaden sitzen.

Fortgeschrittenere Kriminelle würden unter fremder Identität Bankkonten und Firmengeflechte für Geldwäsche oder komplexere Betrugsmodelle hochziehen. Da die eID-Karten für den Online-Einsatz konzipiert sind, können sie einfach weitergegeben werden. Foto oder biometrische Daten sind nicht enthalten, zumal deren Abgleich online schwierig ist.

Der Inhalt der eID-Karte:

Weiterlesen nach der Anzeige

Auf der eID-Karte werden folgende Daten sowohl aufgedruckt als auch auf dem enthaltenen Chip gespeichert: Kartennummern, Familienname, Geburtsname, Vornamen, etwaige Doktorgrade, Tag und Ort der Geburt, Anschrift, oder, falls zutreffend, die Angabe „keine Wohnung in Deutschland“, Staatsangehörigkeit, gegebenenfalls Ordensname oder Künstlername, die Art des vorgelegten Ausweisdokuments sowie das Ablaufdatum der eID-Karte.

Die Ausstellung an Personen ohne deutschen Wohnsitz ist gewollt, weil gerade diese mithilfe der eID-Karte deutsche Behördenwege bewältigen können sollen. Der Chip kann mittels Lesegerät oder NFC-fähigem Smartphone ausgelesen werden, wobei eine sechsstelligen Nummer (PIN) eingegeben werden muss.

(ds)

Künstliche Intelligenz

Generative KI: Disney wirft Google massive Copyright-Verletzung vor

Der Disney-Konzern setzt auf OpenAI und lizenziert für drei Jahre mehr als 200 Charaktere für die Nutzung mit dem KI-Videogenerator Sora. Andere generative Künstliche Intelligenzen sollen hingegen die Finger von copyrightgeschützten Disney-Charakteren lassen. Dahingehende Gespräche mit Google hätten nichts gebracht, sagt Disney-Chef Bob Iger. Daher hat er Google jetzt ein geharnischtes Unterlassungsbegehren zugemittelt.

Weiterlesen nach der Anzeige

„Wir waren im Gespräch mit Google, haben unsere Bedenken geäußert”, berichtet Iger in einem Fernsehinterview, „Letztendlich, weil wir keine Fortschritte gemacht und unsere Gespräche keinen Erfolg gezeigt haben, haben wir das Gefühlt bekommen, dass wir keine andere Wahl haben, als eine Unterlassungsaufforderungen zu schicken.” Es ist nicht der erste solche Fall: „Wir haben andere Firmen verfolgt, die unsere Rechte nicht geachtet haben”, sagte der Disney-CEO zu CNBC. Tatsächlich hat sein Konzern bereits ähnliche Unterlassungsbegehren an Meta Platforms und Character.AI geschickt. Zudem Disney, gemeinsam mit anderen Rechteinhabern, Klage gegen die KI-Firmen Midjourney und Minimax.

„Google verletzt Disneys Copyright in massivem Ausmaß, indem es einen großen Korpus aus Disneys copyrightgeschützten Werken ohne Genehmigung für Training und Entwicklung von KI-Modellen und Diensten kopiert hat”, heißt es laut Variety in dem Anwaltsschreiben, „und indem es KI-Modelle und -Dienste kommerziell verwertet sowie Kopien geschützter Werke an Verbraucher verbreitet”. Erschwerend komme hinzu, dass viele der rechtsverletzenden Bilder mit Google-Logos gekennzeichnet werden, was den falschen Eindruck vermittle, Disney habe das genehmigt und unterstützt.

Disney verlangt, dass Google sofort aufhört, weitere Kopien von oder derivative Werke mit geschützten Disney-Charakteren anzufertigen, aufzuführen oder zu verbreiten. Das bezieht sich ausdrücklich auch auf Youtube. Zudem verlangt Disney, dass Google sofort technische Maßnahmen ergreift, um sicherzustellen, dass Google-Produkte mit KI-Integration nicht länger zur Erzeugung von Disney-Inhalten genutzt werden.

heise online hat Google zu einer Stellungnahme eingeladen.

(ds)

Künstliche Intelligenz

Top 10: Das beste Mittelklasse-Smartphone mit guter Kamera im Vergleich

Ein Flaggschiff sprengt das Budget? Dann lohnt sich ein Mittelklasse-Smartphone. Wir zeigen die besten Handys bis 600 Euro mit Top-Kamera und starker Hardware.

Die Top-Smartphones namhafter Hersteller stehen im Rampenlicht. Modelle wie das Samsung Galaxy S25 Ultra oder iPhone 17 Pro wecken Begehrlichkeiten, schließlich vereinen sie aktuelle Spitzen-Technik in edlem Design. Der Preis sorgt jedoch schnell für Ernüchterung: Über 1000 Euro für ein Mobilgerät, das meist nur wenige Jahre hält, ist für viele keine Option.

Zum Glück geht es günstiger. Mit etwas Recherche finden sich gehobene Mittelklasse-Smartphones, die technisch nah an Flaggschiff-Modelle herankommen – und dabei oft nur die Hälfte kosten.

Der Begriff Mittelklasse ist weit gefasst. In dieser Bestenliste konzentrieren wir uns daher auf aktuelle Smartphones, die wir selbst getestet haben, die technisch nah an der Oberklasse liegen und preislich etwa zwischen 400 und etwas über 600 Euro angesiedelt sind. Modelle, die älter als zwei Jahre sind, berücksichtigen wir nicht. Auch aktuelle iPhones sucht man in diesem Preissegment vergeblich – deshalb liegt der Fokus hier ausschließlich auf Android-Geräten.

Welches ist aktuell das beste Mittelklasse-Smartphone?

Testsieger der Mittelklasse-Smartphones ist das Xiaomi 15T Pro für aktuell nur 497 Euro (inklusive Versand). Es überzeugt mit einem starken Gesamtpaket und insbesondere mit seiner hervorragenden Kamera samt leistungsstarker Telelinse.

Technologiesieger ist das Poco F8 Pro von Xiaomi ab 524 Euro (inklusive Versand). Auch dieses Modell bietet ein überzeugendes Gesamtpaket zu einem fairen Preis. Mit an Bord sind eine gute Kamera mit Teleobjektiv sowie der leistungsstärkste Prozessor im Testfeld.

Den Titel Preis-Leistungs-Sieger sichert sich das Motorola Edge 60 Pro ab 399 Euro (inklusive Versand). Es punktet mit einer starken Telekamera, einem robusten Gehäuse und einer ausdauernden Akkulaufzeit.

Hinweis: Wie all unsere Bestenlisten sind die genannten Preise immer Momentaufnahmen.

Das Xiaomi 15T Pro überzeugt mit einer tollen Kamera, besonders die Telelinse sticht hervor. Leistung, Display und Verarbeitung liegen nahe am Flaggschiff-Niveau, und der Akku bietet lange Laufzeiten und 90-W-Schnellladen. Auch die Software-Pflege mit fünf Android-Upgrades und sechs Jahren Sicherheits-Updates ist vorbildlich.

- exzellente Kamera mit optischem 5-fach-Zoom

- schickes Design

- starke Performance

- lange Akkulaufzeit

- USB-C 2.0

- Display ohne LTPO

Technologiesieger ist das Poco F8 Pro. Es bietet ein exzellentes Preis-Leistungs-Verhältnis mit der besten Performance dieser Bestenliste. Dazu kommt eine richtig gute Kamera samt Telezoom, ein brillantes Display und ein besonders ausdauernder Akku.

- starke Performance

- gute Kamera mit Telelinse

- schickes und hochwertiges Design

- schnelles Laden

- kein kabelloses Laden

- eher schwache Ultraweitwinkellinse

Das Motorola Edge 60 Pro bietet ein elegantes Design mit exzellenter Verarbeitung und hochwertiger Haptik. Ausgestattet mit einem hellen OLED‑Display, einer leistungsstarken Triple-Kamera, 12 GB RAM und großzügigen 512 GB Speicher zeigt es sich rundum modern und alltagstauglich.

Der 6000‑mAh‑Akku sorgt für lange Laufzeiten und lädt wahlweise schnell per Kabel oder kabellos. Mit 396 Euro hat es auch noch hervorragendes Preis-Leistungs-Verhältnis.

- tolles Display

- schickes Design

- IP69 und MIL-STD-810H

- gute Kamera mit Telelinse

- starker Akku

- nur USB 2.0

- kein microSD-Slot

- Software-Updates nur bis 2029

Ratgeber

Günstige Alternativen

Bei begrenztem Budget empfehlen wir aus dieser Bestenliste den Preis-Leistungs-Sieger Motorola Edge 60 Pro sowie das Xiaomi 14T Pro als eines der besten Smartphone bis 500 Euro.

So testen wir

Die Hersteller stellen uns die Geräte für einen begrenzten Zeitraum kostenfrei zur Verfügung. Während dieser Zeit nutzen wir die Mobilgeräte im Alltag mit einer Zweit-SIM-Karte für einen Zeitraum von mehreren Wochen. Ergänzend fließt unsere Praxiserfahrung in die Bewertung ein. Wir schießen Fotos unter verschiedenen Lichtbedingungen an möglichst gleichen Orten, um vergleichbare Ergebnisse zu erhalten.

Die Display-Helligkeit messen wir in Nits (cd/m²) und probieren das dann auch bei Sonnenschein – sofern das Wetter mitspielt – im Freien aus. Spitzenwerte oberhalb von rund 2000 Nits lassen sich mit unseren Messmethoden nur eingeschränkt erfassen. Die Performance ermitteln wir mit PCMark Work sowie 3DMark Wild Life und Wild Life Extreme.

Für die Akkulaufzeit stellen wir die Helligkeit auf 200 cd/m² ein und verwenden den simulierten Battery Test von PCMark. Das Tool führt verschiedene Aufgaben in einer Endlosschleife aus, bis der Akkustand auf 20 Prozent fällt. Daraus ergibt sich eine durchschnittliche Laufzeit – kein absoluter, aber ein gut vergleichbarer Richtwert. Zusätzlich tauschen wir uns regelmäßig mit den Kolleginnen und Kollegen der c’t aus, die eigene Akkutests durchführen.

Display-Technologie

In der Preisklasse bis 600 Euro sind Auflösungen mit weniger als FHD+ nicht mehr zu finden. Bei durchschnittlichen Diagonalen von etwa 6,5 Zoll ergibt FHD+ etwas mehr als 400 Pixel pro Zoll (PPI), was entsprechend für eine scharfe Darstellung sorgt. Die höchste Auflösung im Vergleich hat das Poco F7 mit beeindruckenden 3200 × 1440 Pixeln.

Als Technologie steht ein AMOLED-Display ganz oben auf der Wunschliste – das bedeutet nicht, dass IPS-LCDs schlecht wären. AMOLED bietet aber deutlich bessere Schwarzwerte, Kontraste sowie Farbintensität und höhere Blickwinkelstabilität. Zudem ist ein OLED-Display bei Smartphones auch für unter 600 Euro inzwischen richtig hell und mittlerweile in diesem Preisrahmen auch der Standard, abgesehen von Outdoor-Handys (Bestenliste).

Inzwischen schaffen die Panels in dieser Preisklasse üblicherweise eine Bildwiederholrate von 120 Hz oder sogar 144 Hz für flüssigere Darstellung von Inhalten. Einige Geräte bieten sogar LTPO-Technik (Low-Temperature Polycrystalline Oxide) mit variablen Bildwiederholraten von 1 bis 120 Hz, was für mehr Effizienz sorgt. Stellenweise gibt es auch Geräte mit 144 Hz. Mindestens 120 Hz bieten alle Modelle in dieser Bestenliste.

Mit 60 Hz sollte sich bei so viel Geld niemand mehr zufriedengeben. Wer einmal das flüssigere Erlebnis beim Scrollen in Menüs oder Browser erlebt hat, will nicht mehr zurück auf 60 Hz.

Leistung & Prozessoren

In der Mittelklasse steckt heute deutlich mehr Power als noch vor wenigen Jahren. Viele Modelle unserer Bestenliste nutzen Chipsätze der oberen Mittelklasse wie den Qualcomm Snapdragon 7 Gen 3 oder Snapdragon 7s Gen 3. Im Alltag macht das kaum einen Unterschied zu teureren High-End-Prozessoren – für alltägliche Aufgaben wie Surfen, Messaging oder Videostreaming reicht die Leistung locker aus.

Besonders für Gaming sind aus dieser Bestenliste Geräte mit Snapdragon 8 Gen 3 sowie Mediatek Dimensity 9400+ empfehlenswert. Die stärkste Leistungsfähigkeit bietet das Poco F8 Pro mit Snapdragon 8 Elite Gen 4.

Einige Hersteller verbauen leicht abgespeckte Spitzenchips, wie den Snapdragon 8s Gen 3, der in puncto Performance bereits nahe an die Flaggschiff-Serie heranreicht. Dazu kommen Alternativen wie der Samsung Exynos 2400. Die Chips von Mediatek der Reihe Dimensity 8300‑Ultra oder 9300+ bieten ein hervorragendes Verhältnis aus Leistung und Effizienz.

Wer hauptsächlich anspruchsvolle 3D-Spiele spielt, ist mit echten Oberklasse-Chips der Snapdragon-8-Serie besser bedient – sie liefern die höchste CPU- und GPU-Leistung. Für den Alltag und gelegentliches Gaming reicht die Rechenleistung der hier gelisteten Smartphones jedoch vollkommen aus.

Kamera

Viele Hersteller sparen bei der Kamera. In der gehobenen Mittelklasse bieten aber inzwischen fast alle Smartphones einen optischen Bildstabilisator (OIS). Immer mehr Modelle verfügen zudem über eine leistungsstarke Telelinse – teils sogar mit Periskop-Technik.

In dieser Top 10 nutzen acht von zehn Geräten eine Telelinse. Das Xiaomi 15T Pro bringt eine Periskop-Telelinse mit starkem Zoom mit. Es gibt Modelle mit OIS für Haupt- und Telelinse, entsprechend sind die Aufnahmen damit besser – teils auch bei Nacht.

Bei Videos gibt es zwar 4K-Aufnahmen, allerdings ist meistens bei 30 Bildern pro Sekunde Schluss. Das führt dazu, dass Schwenks etwas ruckelig wirken, weil die Bildwiederholungsrate zu niedrig ist. 4K mit 60 FPS behebt dieses Problem. Frontkameras bieten heute fast immer hohe Auflösungen, haben aber oft Schwierigkeiten mit der Bilddynamik. Für Videochats und Social Media reicht das allemal.

Speicher & RAM

Bei Android-Smartphones gelten 4 bis 6 GB RAM inzwischen als absolute Untergrenze. Empfehlenswert sind mindestens 8 GB – das ist mittlerweile auch der Standard in der Mittelklasse. Immer häufiger tauchen sogar Modelle mit 12 GB RAM auf – ein Wert, der bis in jüngster Vergangenheit der Oberklasse vorbehalten war.

Beim Speicher sieht es ähnlich aus: 128 GB sind das Minimum, 256 GB die sinnvollere Wahl. Selbst 512 GB sind längst keine Exoten mehr. Wir empfehlen klar 256 GB als Untergrenze, denn microSD-Steckplätze verschwinden zusehends. In dieser Bestenliste berücksichtigen wir daher nur Modelle mit mindestens 256 GB. Technisch ist ansonsten alles an Bord, was ein modernes Smartphone auszeichnet – von 5G bis NFC.

Langsamer interner Speicher macht sich anders bemerkbar. Wenn man „eben schnell“ das neueste Foto aus dem Speicher des Mittelklasse-Smartphones herunterladen möchte und schon Hunderte im Speicher hat, dauert es anfangs lange, bis alle Bilder angezeigt werden. Inzwischen verwenden aber alle Modelle in dieser Bestenliste schnellen UFS-Speicher – je höher die Version, desto besser.

Akku & Laden

Ein wichtiges Kriterium beim Kauf sollte der Akku sein. Die Spanne reicht im Testfeld von 4500 mAh bis 5500 mAh. Bei gewöhnlicher Nutzung, bestehend aus gelegentlicher Nutzung von Chat-Apps, Social Media oder dem Lesen von Artikeln, halten alle hier gezeigten Geräte gut einen Tag lang durch. Wer jedoch damit für längere Zeit Spiele zockt, navigiert oder Videos streamt, muss damit leben, dass das Smartphone nicht ganz bis zum Abend durchhält. Im Zweifel raten wir hier zu kompakten Powerbanks fürs Smartphone (Bestenliste).

Die Ladegeschwindigkeit variiert stark, von gemächlichen 25 Watt bis zu flotten 90 Watt. Interessant sind auch Schnellladen sowie kabelloses Laden, das in dieser Preisklasse noch selten zu finden ist.

Software

Bei der Aktualität der Android-Version steht es bei den meisten Geräten in unserer Top 10 gut. Das Xiaomi 15T Pro erhält fünf Android-Updates sowie Sicherheits-Patches für sechs Jahre. Honor bietet drei große Updates und vier Jahre Software-Support. Beim Samsung Galaxy S25 FE gibt es sieben Jahre lang Android-Updates. Der Zeitraum gilt allerdings nicht ab dem Kaufdatum, sondern ab der Veröffentlichung des Geräts.

Wie wichtig sind KI-Funktionen? Tatsächlich ziehen die immer mehr in den Alltag und damit auch in Smartphones bis 600 Euro ein. Aufwändige KI-Funktionen wie intelligente Bildbearbeitung, die etwa Gegenstände oder Personen virtuell hinzugefügt oder entfernt, sind derzeit noch hochpreisigen Modellen vorbehalten.

Konnektivität & Schnittstellen

5G gehört in dieser Preisklasse inzwischen zum Standard – überwiegend im Sub-6-GHz-Bereich, seltener im besonders flotten mmWave-Spektrum. Auch Dual-SIM-Support ist selbstverständlich, häufig in Kombination mit eSIM-Unterstützung, die immer mehr Geräte bietet.

Mangels flächendeckenden Netzausbaus ist 5G in Deutschland jedoch bisher nicht überall verfügbar. In Städten bringt der Standard klare Vorteile bei Datendurchsatz und Latenz, während er auf dem Land oft Lücken im 4G‑Netz schließt. Für die Zukunftssicherheit lohnt sich der 5G‑Support aber in jedem Fall.

Neben Mobilfunk spielt die WLAN‑Leistung eine wachsende Rolle: Moderne Geräte setzen auf Wi-Fi 6 oder Wi-Fi 6E, teils sogar schon auf Wi-Fi 7. Das sorgt für stabilere Verbindungen und höhere Geschwindigkeiten – etwa beim Streamen oder bei Cloud‑Gaming.

Auch Bluetooth 5.3 ist mittlerweile die Regel, was niedrigere Latenzen und Energieverbrauch bedeutet. Für Musikfans sind unterstützte Audio‑Codecs wie aptX HD, LDAC oder AAC entscheidend – sie ermöglichen kabellosen Sound in Hi‑Res-Qualität.

Beim USB‑Anschluss sparen einige Hersteller leider weiterhin: Viele Modelle setzen noch auf USB 2.0, was beim Übertragen großer Dateien oder bei der Nutzung im Desktop‑Modus (etwa Samsung DeX) zum Flaschenhals werden kann. Geräte mit USB‑C 3.1 oder USB‑C 3.2 punkten hier deutlich, da sie schnellere Datenraten und bessere Kompatibilität bieten.

Ein gutes Mittelklasse‑Smartphone sollte heute 5G, Wi-Fi 6 oder 6E, Bluetooth 5.3 und eSIM‑Support bieten. Wer häufig Daten überträgt oder externe Geräte anschließt, sollte zudem auf USB 3.x achten – das steigert Komfort und Zukunftssicherheit spürbar.

Schutz vor Wasser & Staub

Eine IP-Zertifizierung gibt Aufschluss darüber, wie gut ein Smartphone gegen Staub und Wasser geschützt ist. Je höher die zweite Ziffer, desto besser der Schutz. IP54 bedeutet Spritzwasserschutz – etwa gegen Regen. IP68 hingegen schützt das Gerät auch für kurzes Untertauchen bis zu 30 Minuten in maximal 1,5 Meter Tiefe, was aber nur für Süßwasser gilt. In der Mittelklasse sind wasserdichte Smartphones nicht selbstverständlich, aber immer häufiger.

In der Mittelklasse schützt meist Gorilla Glass 5, 7 oder Victus 2 das Display vor Kratzern und Stürzen – gänzlich bruchsicher ist aber kein Glas. Besonders flache Displays ohne starke Krümmung gelten als widerstandsfähiger. Nur das Motorola Edge 60 Pro bietet in dieser Preisklasse eine MIL-STD-810H-Zertifizierung, die dessen hohe Robustheit bescheinigt.

Sonstige Ausstattung

Alle Smartphones in dieser Bestenliste bieten eine Entsperrung per Fingerabdrucksensor, der überwiegend unter dem Display sitzt, seltener seitlich im Power-Button. Alternativ steht eine Gesichtserkennung über die Frontkamera zur Verfügung, die jedoch nur auf 2D-Technik basiert und daher weniger sicher gegen Täuschungsversuche ist.

Der Klang der Geräte ist für Videos, Social Media oder Spiele vollkommen ausreichend – klar, laut und teilweise sogar mit Dolby Atmos. Für längeres Musikhören fehlt den Lautsprechern allerdings häufig die Balance: Der Sound wirkt leicht schrill und höhenlastig, was im Alltag aber kaum stört.

Fazit

Beachtlich, was man für unter 600 Euro an Technik bekommt. Groß ist der Unterschied zur absoluten Spitze teilweise nicht mehr, sofern man den Preis in Relation zum Mehrwert setzt. Ansonsten sind die neuesten Spitzenmodelle etablierter Hersteller natürlich doch noch einmal besser – allein schon, weil dort fast immer optische Teleobjektive angeboten werden. Dazu kommen Merkmale wie USB-C 3.0, kabelloses Laden und meistens auch Wasserdichtigkeit. Bei der Leistung sind aber bei einigen Smartphones bis 600 Euro – primär im „normalen“ Alltag – so gut wie keine Unterschiede mehr zu spüren.

Wer mit anderen Preisklassen vergleichen möchte, sollte einen Blick in unsere weiteren Top 10 der besten Smartphones werfen, die regelmäßig aktualisiert werden:

Übrigens: Wer zu seinem neuen Smartphone einen passenden Tarif sucht, wird vielleicht im Tarifrechner von heise.de fündig. Hier gibt es verschiedene Vergleichsrechner für Prepaid, monatlich kündbare und sogar kostenlose Tarife. Der Rechner umfasst dabei übergreifend alle Angebote, die derzeit in Deutschland verfügbar sind.

Xiaomi 15T Pro

Das Xiaomi 15T Pro vereint Top-Kamera, starke Performance und lange Akkulaufzeit zum fairen Preis. Ist das der neue Underdog unter den Smartphones?

- exzellente Kamera mit optischem 5-fach-Zoom

- schickes Design

- starke Performance

- lange Akkulaufzeit

- USB-C 2.0

- Display ohne LTPO

Xiaomi 15T Pro im Test: Dieses Smartphone ist der Geheimtipp des Jahres

Das Xiaomi 15T Pro vereint Top-Kamera, starke Performance und lange Akkulaufzeit zum fairen Preis. Ist das der neue Underdog unter den Smartphones?

Wer sagt denn, dass man über 1000 Euro auf den Tisch legen muss, um ein schnelles, stilvolles Smartphone mit Top-Kamera und ordentlichem Zoom zu bekommen? Xiaomi zeigt mit seiner T‑Serie regelmäßig, dass es auch eine Nummer bodenständiger geht – ohne langweilig zu sein.

Das neue Xiaomi 15T Pro demonstriert eindrucksvoll, wie das klappt: Im Prinzip ist es eine clever abgestimmte Mischung aus dem Xiaomi 15 und dem Ultra-Modell, behält dabei aber einen eigenständigen Charakter. Der Star ist die Kamera mit fünffachem optischem Zoom und starken Ergebnissen – und das zu einem fairen Preis. Damit stiehlt das T‑Modell der großen Ultra‑Serie fast ein wenig die Show.

Auch sonst gibt es wenig zu meckern: Der Prozessor liefert reichlich Power, auch wenn dieses Mal kein Snapdragon verbaut ist, und der Akku hält beeindruckend lange durch. Warum das Xiaomi 15T Pro vielleicht die spannendste Oberklasse-Alternative des Jahres 2025 ist, klären wir im Detail im Testbericht.

Design

Beim Design geht Xiaomi beim 15T Pro seinen eigenen Weg. Mit dem Vorgänger oder den Schwestermodellen 15 und 15 Ultra hat es stilistisch nur wenig gemeinsam. Auffälligstes Merkmal ist das große Kameraelement, das in einem Rechteck mit stark abgerundeten Ecken sitzt. Es ragt deutlich hervor und beherbergt drei Linsen plus LED-Blitz.

Das Gehäuse wirkt hochwertig und ist mit seinem Metallrahmen und der griffigen Rückseite aus Glasfaserverbundstoff wie aus einem Guss gefertigt. Anders als bei vielen Top-Smartphones verzichtet Xiaomi hier also auf eine Glasrückseite. Die Oberfläche ist dabei erfreulich unempfindlich gegenüber Fingerabdrücken. Die Ecken sind deutlich abgerundet, das Format wirkt insgesamt wuchtig. Mit 162,7 × 77,9 × 8 mm übertrifft es in der Breite sogar das Ultra-Modell. Für die Einhandbedienung und kleine Hände ist es also weniger geeignet, liegt dank der sanften Form aber trotzdem gut in der Hand.

Die Verarbeitung ist erstklassig, klar auf Flaggschiff-Niveau. Xiaomi bietet drei Farben an: Schwarz, Grau und ein edles Dunkelbraun, das der Hersteller „Mocha Gold“ nennt. Dazu kommt IP68-Schutz gegen Staub und Wasser. Mit 210 g bleibt das Gewicht für diese Größe absolut im Rahmen. Das Xiaomi 15T Pro hat Stil – und eine ordentliche Portion Eleganz gleich dazu.

Display

Der Bildschirm des Xiaomi 15T Pro ist mit einer Diagonale von 6,83 Zoll riesig bei einem Seitenverhältnis von 19,5:9. Es zeigt eine messerscharfe Auflösung von 2772 × 1280 Pixeln und erreicht damit eine hohe Pixeldichte von 447 PPI. Das AMOLED-Panel liefert eine hervorragende Bildqualität. Mit einer Bildwiederholrate von bis zu 144 Hz wirkt das Bild beim Spielen und Scrollen besonders flüssig.

Gorilla Glass 7i schützt den Bildschirm und soll Stürze aus etwa einem Meter Höhe abfedern – wir haben es aber nicht übers Herz gebracht, das auszuprobieren. Die Anzeige leuchtet zudem äußerst hell und bleibt bei Sonnenlicht stets ablesbar. Laut Hersteller erreicht das Display bis zu 3200 Nits. Die Abtastrate von 480 Hz und die Touch-Abtastrate von 2560 Hz sind ebenfalls hoch. Eine hohe Abtastrate lässt Eingaben schneller erkennen, was die Bedienung flüssiger und direkter macht. Ein Always-On-Display steht ebenfalls zur Verfügung.

Einziger Nachteil: Das Display nutzt keine LTPO-Technologie. Diese Technik passt die Bildwiederholrate in 1-Hz-Schritten automatisch an, um Energie zu sparen. Das Xiaomi 15T Pro kann die Frequenz zwar auch anpassen, wechselt aber nur zwischen 144, 120 und 60 Hz. Am Ende ist das aber Jammern auf hohem Niveau.

Kamera

Der Star des Xiaomi 15T Pro ist die Kamera – vorrangig die Telelinse. Die Zusammenarbeit mit Leica zahlt sich erneut aus. Xiaomi verbaut ein Hauptobjektiv mit 50 Megapixeln (f/1.62) und optischer Bildstabilisierung (OIS), dazu eine Periskop-Telelinse mit ebenfalls 50 Megapixeln (f/3.0), OIS und fünffachem optischen Zoom. Ergänzt wird das Setup durch ein Ultraweitwinkelobjektiv mit 12 Megapixeln. Für Selfies gibt es eine Frontkamera mit 32 Megapixeln.

Bei Tageslicht liefert die Kamera ausgezeichnete Fotos mit hohem Detailgrad, großem Dynamikumfang und kräftigen Kontrasten. Auch bei wenig Licht entstehen richtig gute Aufnahmen mit geringem Bildrauschen, die fast an das Level des Xiaomi 15 Ultra heranreichen. Das Ultraweitwinkelobjektiv fällt bei Details und Dynamik leicht ab, bleibt aber farblich sehr nah an den übrigen Linsen.

Besonders stark ist die Telelinse mit fünffachem optischem Zoom. Selbst bei zehnfacher Vergrößerung entstehen detailreiche und verlustfreie Aufnahmen. Auch 30-fach gezoomte Bilder bleiben brauchbar. Der digitale Zoom reicht bis 100-fach, dann nimmt die Schärfe trotz KI-Unterstützung sichtbar ab – diese Stufe hat aber eher experimentellen Charakter. Kleine Schwäche: Für Zoomstufen unter dem Faktor fünf kommt nur die Hauptkamera zum Einsatz.

Nutzer können zwischen zwei Farbmodi wählen: Leica Vibrant („lebendig“) liefert kräftige Farben und starke Kontraste, während Leica Authentic („authentisch“) dezenter wirkt und eine etwas dunklere Stimmung erzeugt. Im Alltag überzeugt der lebendige Modus am meisten, auch wenn Farben oft etwas intensiv wirken. Der authentische Stil eignet sich dagegen gut für stimmungsvolle, leicht düstere Szenen.

Auch Selfies gelingen scharf und farblich ausgewogen, das Bokeh im Porträtmodus wirkt natürlich und sauber. Videos überzeugen ebenfalls mit hoher Schärfe und guter Stabilisierung. Möglich sind Aufnahmen in 4K mit bis zu 120 FPS oder sogar in 8K mit 30 FPS. Insgesamt bietet das Xiaomi 15T Pro eine hervorragende Kamera, die fast das Niveau des 15 Ultra erreicht und den Fokus klar auf die starke Telelinse legt.

Xiaomi 15T Pro – Originalaufnahmen

Ausstattung

Statt eines Snapdragon-Chips wie in den Top-Modellen setzt Xiaomi beim 15T Pro auf den Mediatek Dimensity 9400+. Er ist zwar etwas schwächer als Qualcomms aktuelles Elite-Modell, bietet aber ebenfalls enorme Leistungsreserven. Im Alltag läuft das Smartphone sehr flüssig und reagiert ohne spürbare Verzögerungen.

Beim Benchmark PCMark Work erreichten wir starke 16.500 Punkte, und auch die Grafikleistung überzeugt mit 6000 Punkten im 3DMark Wild Life Extreme – damit eignet sich das Xiaomi 15T Pro auch zum Spielen grafisch aufwendiger Titel. Unter Volllast im Stresstest wird das Gerät allerdings recht warm. Aufgrund der Wärmedrosselung erreicht es lediglich eine Effizienz von rund 60 Prozent. Das Xiaomi 15 Ultra kommt hier auf über 70 Prozent.

Der Arbeitsspeicher ist mit 12 GB RAM großzügig bemessen, dazu kommen 256 GB, 512 GB oder sogar 1 TB Speicher nach schnellem UFS-4.1-Standard. Bei den kabellosen Schnittstellen ist das Gerät auf neuestem Stand: 5G, Wi-Fi 7, Bluetooth 6.0, NFC und der typische Infrarot-Port von Xiaomi sind vorhanden. Auf UWB verzichtet Xiaomi allerdings.

Einen großen Schwachpunkt gibt es aber: Der USB-C-Anschluss unterstützt nur USB 2.0 – bei diesem Preis wäre USB 3.2 angemessen gewesen, da kabelgebundene Datenübertragungen so recht langsam ausfallen. Das ist schon frech für den Preis.

Die Ortung über GPS, Glonass, Beidou, Galileo, QZSS und Navic arbeitet sehr präzise. Im Test erreichten wir eine Genauigkeit von rund zwei Metern. Das Smartphone kann zwei physische SIM-Karten aufnehmen und zusätzlich bis zu zwei eSIMs unterstützen. Die Telefonqualität überzeugt, und auch das 5G im E-Netz wurde vollständig ausgereizt.

Eine Besonderheit bringt das Xiaomi 15T Pro mit: die Offline-Walkie-Talkie-Funktion „Xiaomi Astral Communication“. Sie ermöglicht Kommunikation ohne Mobilfunknetz über eine optimierte Bluetooth-Direktverbindung mit einer Reichweite von knapp 2 km zwischen zwei kompatiblen Geräten – praktisch etwa beim Wandern oder in Gebieten mit schlechtem Empfang. Aktuell unterstützen nur das Xiaomi 15T und 15T Pro die Funktion, weitere Modelle sollen folgen.

Die Stereo-Lautsprecher klingen klar und bleiben auch bei hoher Lautstärke verzerrungsfrei. Der Bass ist etwas zurückhaltend, was in dieser Klasse normal ist. Über die Dolby-Atmos-Software lässt sich der Klang leicht anpassen. Der Fingerabdruckscanner unter dem Display arbeitet zuverlässig und schnell.

Software

Das Xiaomi 15T Pro läuft mit Android 15 und der Bedienoberfläche Hyper OS 2. Der Sicherheits-Patch stammt zum Testzeitpunkt aus August, was noch in Ordnung ist. Ein Update auf Hyper OS 3 auf Basis von Android 16 soll bald folgen.

Xiaomi hat zudem seine Update-Politik verbessert: Das 15T Pro soll insgesamt fünf große Android-Upgrades und sechs Jahre Sicherheits-Updates erhalten. Das ist zwar nicht ganz auf dem Niveau von Samsung oder Google, geht aber in die richtige Richtung und dürfte für die meisten Nutzer ausreichen.

Hyper OS wirkt im Vergleich zu früheren Versionen deutlich aufgeräumter und übersichtlicher. Künstliche Intelligenz spielt hier eine geringere Rolle als bei der Konkurrenz – Xiaomi setzt hier vorwiegend auf Google Gemini.

Akku

Der Akku bietet eine stattliche Kapazität von 5500 mAh. Das ergibt in Kombination mit dem effizienten Prozessor eine lange Akkulaufzeit. Im PCMark Battery Test erreichte das Xiaomi 15T Pro einen guten Wert von 15,5 Stunden – damit liegt es fast auf Augenhöhe mit vielen anderen Top-Smartphones, auch wenn einige Geräte noch länger durchhalten. Regelt man das Display fest auf 60 Hz, hält das Smartphone gut drei Stunden länger durch.

Einen vollen Tag übersteht das Smartphone problemlos, bei sparsamer Nutzung sogar zwei. Es lässt sich mit bis zu 90 W schnell laden und ist in etwa einer halben Stunde vollständig aufgeladen – vorausgesetzt, man besitzt ein entsprechendes Ladegerät, denn ein Netzteil liegt nicht bei. Kabelloses Laden ist ebenfalls möglich. Das passende Ladegerät Xiaomi 90W Hypercharge Combo kostet rund 25 Euro.

Preis

Die UVP des Xiaomi 15T Pro liegt bei 800 Euro für die Version mit 256 GB, bei 900 Euro für 512 GB und bei 1000 Euro für 1 TB Speicher. Das ist ziemlich hoch, womit das Gerät den Preisrahmen der Mittelklasse eigentlich sprengt. Aber schon kurz nach dem Marktstart sind die Preise spürbar gefallen.

Aktuell kostet die Variante mit 256 GB nur 491 Euro. Das Modell mit 512 GB liegt bei knapp 541 Euro. Die Version mit 1 TB kostet etwa 674 Euro.

Fazit

Das Xiaomi 15T Pro zeigt eindrucksvoll, wie gut ein Smartphone für rund 600 Euro sein kann. Die Kamera überzeugt auf ganzer Linie, besonders die starke Telelinse hat uns begeistert. Auch die Leistung ist hoch, wenn auch nicht ganz auf Flaggschiff-Niveau eines Snapdragon 8 Elite. Für den Alltag bietet das Gerät jedoch reichlich Reserven für viele Jahre. Das edle Design gefällt und verleiht dem 15T Pro einen eigenständigen Charakter. Xiaomi bietet jetzt sechs Jahre Sicherheits-Updates und fünf große Android-Upgrades, was ein klarer Fortschritt ist.

Schwächen gibt es nur wenige: LTPO wäre schön gewesen für eine noch längere Akkulaufzeit. Ärgerlich ist der veraltete USB‑2.0‑Standard des Anschlusses, obwohl die restliche Ausstattung auf Top-Niveau liegt. Bei Nachtaufnahmen erreicht die Kamera nicht ganz das Niveau von Top-Modellen wie dem Xiaomi 15 Ultra oder dem Google Pixel 10 Pro – dennoch liefert sie hervorragende Ergebnisse.

Wer ein leistungsstarkes Smartphone mit Fokus auf Fotografie sucht und sich nicht an der Größe stört, bekommt mit dem Xiaomi 15T Pro ein rundum gelungenes Paket. Man muss also nicht zum Flaggschiff für über 1000 Euro greifen, um starke Fotos und hohe Qualität zu bekommen.

Poco F8 Pro

Das Poco F8 Pro bietet Flaggschiff-Leistung mit starker Kamera samt Telelinse – und das für knapp über 500 Euro. Ist das zu gut, um wahr zu sein?

- starke Performance

- gute Kamera mit Telelinse

- schickes und hochwertiges Design

- schnelles Laden

- kein kabelloses Laden

- eher schwache Ultraweitwinkellinse

Xiaomi Poco F8 Pro im Test: High-End-Smartphone zum Mittelklasse-Preis

Das Poco F8 Pro bietet Flaggschiff-Leistung mit starker Kamera samt Telelinse – und das für knapp über 500 Euro. Ist das zu gut, um wahr zu sein?

Mit der F-Reihe bietet Poco von Xiaomi vergleichsweise günstige Smartphones aus der Mittelklasse an, die mit High-End-Features aufwarten – allen voran einem starken Prozessor. Mit dem F8 Pro geht Xiaomi in diesem Jahr jedoch einen Schritt weiter. Im Kern handelt es sich um eine an den europäischen Markt angepasste Version des in Asien erhältlichen Redmi K90.

Das Smartphone bietet eine Ausstattung, die man sonst nur in der Oberklasse findet – inklusive einer Telekamera. Diese war im Vorjahr noch dem F7 Ultra vorbehalten, nun erhält auch das Pro-Modell ein echtes Zoom-Objektiv. Das Poco F8 Pro verspricht dementsprechend Top-Leistung zu einem exzellenten Preis-Leistungs-Verhältnis – ob es dennoch einen Haken gibt, klärt unser Test.

Design

Verglichen mit anderen Smartphones der oberen Mittel- und Oberklasse fällt das Poco F8 Pro relativ kompakt aus. Es positioniert sich zwischen handlichen Geräten und großen High-End-Modellen. Mit Abmessungen von 157,5 × 75,3 × 8 mm passt es problemlos in die Hosentasche, und auch die einhändige Bedienung ist – zumindest für Nutzer mit größeren Händen – gut machbar. Das Gewicht von 199 g wirkt moderat. Der Formfaktor ist für uns ein idealer Kompromiss.

Optisch erinnert das Modell an das Xiaomi 14T Pro aus dem Vorjahr – mit einem Schuss aktueller iPhone-Ästhetik. Vier runde Linsen mit Metallringen sitzen quadratisch angeordnet auf einem quaderförmigen Modul aus Kunststoff mit abgerundeten Ecken. Dort findet sich auch der Schriftzug „Sound by Bose“. Der Audio-Spezialist war an der Optimierung der Lautsprecher beteiligt.

Bei der Materialwahl zeigt sich das Poco F8 Pro erwachsen: Ein Metallrahmen und eine Glasrückseite verleihen dem Smartphone eine hochwertige Haptik. Zudem ist es nach IP68 staub- und wasserdicht. Die Verarbeitungsqualität liegt insgesamt auf Premium-Niveau.

Display

Das Poco F8 Pro setzt auf ein 6,59-Zoll-Display und liegt damit größenmäßig zwischen kompakten Geräten wie dem Xiaomi 15 und größeren Ultra-Modellen des Herstellers. Das OLED-Display überzeugt mit hervorragender Bildqualität: starke Kontraste, tiefes Schwarz und lebendige, aber nicht übertrieben gesättigte Farben. Auch die Blickwinkelstabilität ist einwandfrei.

Mit einer Auflösung von 2510 × 1156 Pixeln erreicht das Panel eine hohe Schärfe von 419 PPI. Die Bildwiederholrate passt sich automatisch zwischen 60 und 120 Hz an, was flüssige Animationen ermöglicht. Die Touch-Abtastrate von 2560 Hz erlaubt zudem äußerst präzise Eingaben.

Auch die Helligkeit liegt auf Spitzenniveau. Selbst bei direkter Sonneneinstrahlung bleibt die Anzeige gut ablesbar. Im HDR-Modus erreicht es laut Hersteller bis zu 3200 Nits – ein beeindruckender Wert für diese Preisklasse.

Kamera

Musste sich das Vorgänger-Modell Poco F7 Pro noch mit einer Dual-Kamera begnügen, bietet das Poco F8 Pro jetzt ein echtes Triple-Kamerasystem. Es besteht aus einer Hauptkamera mit 50 Megapixeln (f/1.88) und optischer Bildstabilisierung, einer 8-Megapixel-Ultraweitwinkelkamera sowie einer Telelinse mit 50 Megapixeln. In der Punch-Hole-Notch auf der Front sitzt eine 20-Megapixel-Selfiekamera.

Im Test überzeugte die Hauptkamera mit detailreichen Aufnahmen und einem hohen Dynamikumfang. Farben wirken kräftig, aber natürlich. Auch bei Dunkelheit hellt die Kamera Szenen effektiv auf – das Bildrauschen ist zwar sichtbar, bleibt aber gut kontrolliert.

Die Telelinse liefert einen 2,5-fachen optischen Zoom und sorgt auch bei fünffacher Vergrößerung noch für ordentliche Ergebnisse. Bis zu 30-fach ist möglich, dann wird es allerdings sichtbar pixelig. Bei Nachtaufnahmen steigt das Rauschen, bleibt bei 2,5-fachem Zoom jedoch auf akzeptablem Niveau.

Etwas schwächer schneidet die Ultraweitwinkelkamera ab. Sie bringt es nur auf 8 Megapixel, liefert bei Tageslicht aber brauchbare Ergebnisse. Die Detailtiefe ist geringer als bei der Hauptkamera, farblich stimmt das Bild jedoch gut überein. Auf Leica-Farbmodi müssen Nutzer verzichten – sie gibt es beim Poco F8 Pro nicht.

Der Supermakromodus nutzt die Telelinse, verlangt jedoch einen Abstand von etwa 50 cm. Die Ergebnisse wirken oft etwas unscharf und weniger überzeugend. Bessere Resultate können erzielt werden, wenn man näher an das Motiv herangeht und manuell fokussiert. Bei der Schärfe ist insgesamt noch etwas Luft nach oben.

Selfies gelingen solide, setzen aber keine neuen Maßstäbe. Videos nimmt das Poco F8 Pro dank des leistungsstarken Prozessors in bis zu 8K mit 30 FPS oder in 4K mit 60 FPS auf. Die Frontkamera schafft Aufnahmen in Full-HD mit 60 FPS.

Poco F8 Pro – Originalaufnahmen

Ausstattung

Das Poco F8 Pro bietet viel Leistung. Unter der Haube arbeitet der Snapdragon 8 Elite Gen 4, einer der stärksten Qualcomm-Chips des Jahres. Der Prozessor sorgt für eine spürbare Leistungssteigerung – egal ob beim Gaming, Surfen oder Medienkonsum. Der absolute Top-Chip bleibt zwar dem Poco F8 Ultra vorbehalten, doch das Pro-Modell liefert trotzdem Oberklasse-Power.

Im Benchmark 3DMark Wild Life Extreme erreicht das F8 Pro rund 6400 Punkte und liegt damit leicht unter Geräten wie dem Galaxy S25 Ultra. Eine Schwachstelle zeigt sich bei der Effizienz: Im Stresstest von Wild Life Extreme hält das Gerät nur etwa 50 Prozent seiner Leistung dauerhaft und wird dabei spürbar warm. Bei PCMark stehen rund 20.000 Punkte zu Buche.

Zur Ausstattung gehören je nach Version 256 oder 512 GB UFS-4.1-Speicher und stets 12 GB RAM, was auch bei Multitasking für flüssige Performance sorgt. Bei der Konnektivität ist alles auf dem neuesten Stand: Wi-Fi 7, Bluetooth 5.4 (mit aptX Adaptive, LDAC, LHDC, AAC, SBC und LC3), NFC, Infrarot-Port und 5G.

Die Ortung erfolgt über GPS, Glonass, Beidou, Galileo, QZSS und Navic – mit einer Genauigkeit von etwa drei Metern. Einziger Wermutstropfen: Der USB-C-Anschluss unterstützt nur den USB-2.0-Standard und bremst damit kabelgebundene Datenübertragungen – ein häufiges Manko in dieser Preisklasse.

Die Stereo-Lautsprecher liefern soliden Klang für Videos und Spiele. Trotz Bose-Unterstützung ist der Unterschied zu anderen Xiaomi-Modellen gering. Der Fingerabdrucksensor unter dem Display arbeitet schnell und zuverlässig.

Software

Das Poco F8 Pro läuft ab Werk bereits mit Hyper OS 3 auf Basis von Android 16. Zum Testzeitpunkt Mitte Dezember war der Sicherheitspatch von November installiert – noch ausreichend aktuell. Xiaomi verspricht vier große Android-Upgrades, also Updates bis Android 20. Überdies sind sechs Jahre Sicherheitsupdates geplant, voraussichtlich bis 2031. Das ist solide, liegt aber leicht unter dem Niveau von Samsung oder Google, die inzwischen rund sieben Jahre Software-Support bieten.

Die Oberfläche wirkt aufgeräumt. Ob man einen App-Drawer nutzt oder nicht, lässt sich frei wählen. Xiaomi installiert allerdings etwas mehr Bloatware als bei seinen Geräten der Zahlenreihe, diese lässt sich jedoch problemlos entfernen. Etwas lästig ist der integrierte Xiaomi-App-Store: Beim ersten Start schlägt er zahlreiche zusätzliche Apps zur Installation vor, die man manuell abwählen muss. Auch Werbung ist im Store sehr präsent.

Akku

Trotz der vergleichsweise kompakten Bauform verbaut Poco im F8 Pro einen üppigen 6210-mAh-Akku. Möglich wird das durch moderne Carbon-Silizium-Technologie. In Kombination mit dem effizienten Snapdragon-Chip liefert das Smartphone eine beeindruckende Ausdauer. Im PCMark Battery Test erreichten wir rund 17 Stunden Laufzeit – das ist ein starker Wert in dieser Geräteklasse.

Im Alltag hält das Poco F8 Pro problemlos einen vollen Tag durch, selbst bei intensiver Nutzung. Bei moderatem Gebrauch sind auch zwei Tage ohne Nachladen realistisch. Aufgeladen wird der Akku mit bis zu 100 W, sofern man ein Xiaomi-Netzteil hat (Hypercharge). Nach etwa 45 Minuten ist der Energiespeicher wieder voll. Andere Geräte lädt das Smartphone wie eine Powerbank mit 22,5 W. Auf kabelloses Laden verzichtet Xiaomi beim Poco F8 Pro allerdings. Für dieses Feature müssen Interessenten schon zum Poco F8 Ultra greifen.

Preis

Das Poco F8 Pro startet bei rund 520 Euro für die Version mit 256 GB Speicher. Empfehlenswerter ist das Modell mit 512 GB, das ab etwa 540 Euro erhältlich ist. Angesichts der Ausstattung ist das ein fairer Preis – und es dürfte nur eine Frage der Zeit sein, bis das Gerät unter die 500-Euro-Marke fällt.

Fazit

Das Poco F8 Pro bietet ein beeindruckendes Preis-Leistungs-Verhältnis. Wer kein teures Flaggschiff benötigt, aber trotzdem Wert auf Leistung und Ausstattung legt – etwa auf einen schnellen Prozessor oder eine starke Kamera mit Telezoom – bekommt hier für etwas über 500 Euro ein rundum überzeugendes Paket. Das Display überzeugt, der mittelgroße Formfaktor gefällt, und die Akkulaufzeit ist hervorragend.

Größere Schwächen leistet sich das Gerät kaum – und die vorhandenen sind für den Preis leicht zu verschmerzen. Die Telelinse verliert bei hohen Zoomstufen und schwachem Licht etwas an Schärfe, Weitwinkel- und Selfiekamera erreichen solides Mittelklasse-Niveau. Beim Software-Support liegt Xiaomi im guten Mittelfeld, die Konkurrenz ist hier jedoch mittlerweile etwas weiter.

Insgesamt ist das Poco F8 Pro eines der besten Smartphones seiner Preisklasse – ein stimmiger Kompromiss aus Leistung, Ausstattung und Kamera zum fairen Preis.

Motorola Edge 60 Pro

Helles OLED, schickes Design, vielseitige Kamera und massenhaft Speicher: Das Motorola Edge 60 Pro bringt Premium-Flair zum fairen Preis.

- tolles Display

- schickes Design

- IP69 und MIL-STD-810H

- gute Kamera mit Telelinse

- starker Akku

- nur USB 2.0

- kein microSD-Slot

- Software-Updates nur bis 2029

Motorola Edge 60 Pro im Test: Die Smartphone-Überraschung

Helles OLED, schickes Design, vielseitige Kamera und massenhaft Speicher: Das Motorola Edge 60 Pro bringt Premium-Flair zum fairen Preis.

Das Motorola Edge 60 Pro will Oberklasse-Features zum Mittelklasse-Preis bieten. Es punktet mit einem strahlend hellen OLED-Display mit 120 Hz, einem trotz des schlanken Gehäuses großzügigen 6000‑mAh‑Akku, 12 GB RAM und 512 GB internem Speicher. Hinzu kommt eine Hauptkamera mit 50 Megapixeln sowie optischer Bildstabilisierung (OIS) und eine Weitwinkelkamera mit ebenfalls 50 Megapixeln. Dazu kommt ein Teleobjektiv mit 10 Megapixeln sowie 3-fachem optischen Zoom.

Gegenüber dem Edge 50 Pro (Testbericht) steigt auf dem Papier die Ausdauer deutlich, die maximale Bildwiederholrate sinkt hingegen moderat. Wir haben im Test überprüft, wie sich das hübsche Gerät abseits der Theorie in der Praxis schlägt.

Design

Eines kann Motorola: Design. Das Gehäuse des Edge 60 Pro ist extrem dünn und wirkt hochwertig sowie elegant. Mit kaum mehr als 8 mm Bautiefe ist das Gerät fast schon das Leichtgewicht unter den Oberklasse-Smartphones. Auch das Gewicht von 186 g sorgt dafür, dass es angenehm in der Hand liegt und den fast schon filigranen Eindruck verstärkt.

Sorgen müssen sich Nutzer jedoch nicht machen: Das Gerät wirkt zwar auf den ersten Blick zerbrechlich, liegt aber solide und stabil in der Hand. Die Verarbeitung ist hervorragend – die Spaltmaße stimmen, nichts knarzt. Die Tasten im Metallrahmen sitzen fest und bieten einen festen Druckpunkt. Insgesamt wirkt alles hochwertig, und wer sein Smartphone gerne einhändig bedient, profitiert von der schmalen Bauform und der griffigen Rückseite.

Ein Highlight: Das Chassis ist gegen Staub und sogar Strahlwasser abgedichtet. Motorola verweist auf Prüfungen nach IP69 und MIL-STD-810H. Das ist ungewöhnlich für ein Smartphone ohne den Zusatz „Outdoor“ – zumal es so grazil daherkommt. Allerdings ist beim Militärstandard nicht exakt festgelegt, welche Tests für die Zertifizierung tatsächlich absolviert werden müssen. Einen freiwilligen Härtetest würden wir diesem schicken Gerät daher dennoch besser nicht zumuten.

Die Rückseite ist entweder Lederoptik („veganes Leder“) oder mit texturierter Oberfläche erhältlich. Beide Varianten sehen edel aus, sorgen für guten Halt und verhindern weitgehend Fingerabdrücke. Wie gewohnt arbeitet Motorola dabei mit dem Farbspezialisten Pantone zusammen, was sich in auffälligen, aber nicht aufdringlichen Farbvarianten bemerkbar macht.

Die drei Kameralinsen sowie der LED-Blitz sitzen in einer dezenten, minimal erhöhten Fläche in der oberen linken Ecke der Rückseite. Ihre gleich großen, runden Einfassungen betonen das modulare Design, stehen leicht hervor und erinnern entfernt an einen klassischen Herd. Durch die Symmetrie und die feine Ausarbeitung wirkt das Ganze aber modern und ansprechend statt altmodisch.

Die Ränder des Displays sind sanft gekrümmt und verstärken den hochwertigen Gesamteindruck des Geräts zusätzlich. Gleichzeitig lässt das die Front schmaler wirken und verbessert die Ergonomie. Geschützt wird der Bildschirm von Corning Gorilla Glas 7i der aktuellen Generation. Zwar handelt es sich nicht um das Topglas des Herstellers, doch bietet auch 7i einen ordentlichen Schutz vor Kratzern und bei Stürzen.

Display

Das knapp 6,7 Zoll große POLED-Display des Motorola Edge 60 Pro bietet eine Auflösung von 2712 × 1220 Pixeln. Damit kommt es auf knackig-scharfe 446 Pixel pro Zoll (PPI) – mehr ist in Kombination mit den tollen Kontrasten, dem hervorragenden Schwarzwert und der Pantone-getreuen Farbwiedergabe für eine herausragende Darstellung definitiv nicht nötig.

Farben wirken satt, aber im Modus „natürlich“ nicht zu knallig. Wer es kräftiger mag, stellt auf „leuchtend“ um. Weiß bleibt neutral, Hauttöne wirken stimmig. Bemerkenswert ist die Spitzenhelligkeit: Laut Hersteller sind partiell bis zu 4500 cd/m² bei HDR-Inhalten möglich, im Alltag haben wir exzellente 1480 cd/m² gemessen – das ist stark! Inhalte bleiben damit selbst im direkten Sonnenlicht einwandfrei ablesbar.

Einen Rückschritt – zumindest auf dem Papier – stellt die Bildwiederholrate von jetzt „nur noch“ 120 Hz dar. Zwar konnte der Vorgänger Edge 50 Pro mit 144 Hz noch mehr, aber nicht erst bei dem haben wir angemerkt, dass der Unterschied von 120 zu 144 Hz kaum sichtbar, stattdessen aber eher unnötig energieintensiv ist. Das sieht Motorola jetzt offenbar ähnlich.

Die seitlichen Krümmungen sehen edel aus und eventuelle Spiegelungen stören im Alltag kaum. Motorolas Palm-Rejection, also die Erkennung von versehentlichen Berührungen des Touchscreens mit den Fingerspitzen oder dem Handballen beim Halten des Geräts, arbeitet zuverlässig, sodass es bei der Nutzung nicht zu Fehlbedienungen kommt. Schade: Ein echtes Always-on-Display gibt es weiterhin nicht. Dennoch ist das Display ein Highlight des Edge 60 Pro.

Kamera

Motorola setzt beim Edge 60 Pro auf eine Triple-Cam und technische Finesse. Als Hauptkamera verwendet der Hersteller ein Modul von Sony (Lytia 700 C, basiert auf IMX896 ) mit 50 Megapixeln und lichtstarker f/1.8-Blende samt optischer Stabilisierung (OIS). Dazu kommt eine Kamera von Samsung mit 50 Megapixeln als Weitwinkel und Makro mit Autofokus. Abgerundet wird das Set von einer Tele-Kamera mit 10 Megapixeln, 3-fachem optischem Zoom und OIS, die ebenfalls von Samsung stammt. Vorn steckt eine Kamera mit 50 Megapixeln und f/2.0, erneut von Samsung.

Bei Tageslicht liefert die Hauptkamera detailreiche, scharfe Fotos mit ausgeprägter Bilddynamik, guten Kontrasten und natürlichen, aber intensiven Farben. Bei wenig Licht hellt die Software nur dezent und damit natürlich auf. Dadurch wirken entsprechende Aufnahmen natürlich und bei ausreichender Beleuchtung dennoch hell genug. Bildrauschen tritt wie bei der Konkurrenz dann trotzdem etwas stärker auf. Feine Texturen und Details leiden entsprechend eher als bei den Klassenbesten, insgesamt sind aber auch Nachtaufnahmen richtig gut. Das gilt auch für das Teleobjektiv.

Schwierige Lichtsituationen wie Gegenlicht meistert die Hauptkamera ebenfalls solide, die Zusatzobjektive – vorrangig das Weitwinkel – etwas schwächer. Die Weitwinkeloptik hält dafür bei gutem Licht bei Schärfe und generellem Eindruck ordentlich mit und punktet dank Autofokus auch im Nahbereich. Das Teleobjektiv sorgt bei 3-facher Vergrößerung für stimmige Porträts und gelungene Tiefenwirkung. Die Bildqualität ist mit ausreichendem Licht ebenfalls klasse. Bis zum 5-fachen Zoom ist das Ergebnis gut nutzbar, darüber sieht man zunehmend den Eingriff der Software.

Als störend empfanden wir während des Fotografierens den zu hektischen Wechsel zwischen den Objektiven bei nahen Motiven. Kaum hat man gerade ein Objekt im Fokus, springt auch schon die Ansicht um und selbst auf dem Display ist dabei häufig die Bildqualität schlechter als zuvor. Das nervt. Abhilfe schafft zum Glück das Deaktivieren der Funktion „automatisches Makro“ in den Kamera-Einstellungen.

Die Videoauflösung endet bei 4K mit 30 FPS – eine echte Enttäuschung, da Kameraschwenks so immer ruckelig wirken. Das passt nicht zur restlichen Qualität von aufgenommenen Videos, bei denen die Stabilisierung zuverlässig, wenn auch nicht spektakulär arbeitet. Auch Tonaufnahmen sind klar verständlich, der Windfilter verrichtet seine Arbeit ordentlich.

Motorola Edge 60 Pro – Originalaufnahmen

Ausstattung

Im Inneren steckt ein Mediatek Dimensity 8350, der für die obere Mittelklasse gedacht ist. Zielsetzung bei seiner Entwicklung war in erster Linie Energieeffizienz, Leistung stand erst an zweiter Stelle. Entsprechend bleibt das Edge 60 Pro in Benchmarks hinter aktuellen Spitzen-Chips wie einem Snapdragon 8 Elite deutlich zurück, liegt aber spürbar vor Geräten mit Snapdragon 7 Gen 4. In 3Dmark Wild Life Extreme erreicht das Handy etwa 3000 Punkte, in PCmark Work 3.0 knapp 20.000 Punkte.

Im Alltag geht alles flott von der Hand. Apps starten schnell, auch bei vielen offenen Apps im Hintergrund ist Multitasking dank 12 GB LPDDR5X-RAM kein Problem und selbst anfordernde Spiele laufen stabil mit hohen Details. Bei langen Sessions wird das Gerät dabei allerdings spürbar warm. Auch große Spiele und speicherintensive Dateien finden im internen Speicher problemlos Platz. 512 GB UFS-4.0-Speicher sind üppig, schnell und damit zukunftssicher.

Bluetooth 5.4, NFC, Wi-Fi 6E und 5G sind natürlich ebenfalls mit dabei. Dank Dual-SIM-Fähigkeit dürfen Nutzer zwei Nano-SIMs einlegen, hinzu kommt eSIM-Support. Eine microSD-Erweiterung gibt es nicht. Schade: Motorola verbaut beim Edge 60 Pro lediglich USB‑C 2.0. Der Standard erlaubt nur eine langsame Datenübertragung und gilt längst als nicht mehr zeitgemäß.

Die Stereo-Lautsprecher mit Dolby Atmos liefern dafür klare Stimmen und ordentlichen Druck für solch ein dünnes Handy. Der In-Display-Fingerabdrucksensor reagiert zügig und zuverlässig, ist für unseren Geschmack allerdings etwas zu weit nach unten an den Display-Rand gewandert.

Software

Ab Werk läuft Android 15 mit schlanker Motorola-Oberfläche. Das System wirkt aufgeräumt. Bloatware ist kaum vorhanden und lässt sich bei Bedarf deinstallieren. Die bekannten Moto-Gesten bleiben ein praktisches Plus: Die Taschenlampe lässt sich per doppelter Hackbewegung aktivieren, die Kamera per Drehbewegung öffnen und Screenshots per Drei-Finger-Touch aufnehmen.

Neu ist eine dedizierte AI-Taste. Sie startet Motor AI mit Funktionen wie Transkription, Zusammenfassung und Bildwerkzeugen. Notizen lassen sich automatisiert strukturieren, Googles Circle to Search zur Bildsuche ist ebenfalls integriert. Smart Connect bindet PC, Tablet und TV ein und erlaubt schnelle Übergaben von Inhalten untereinander, Benachrichtigungsspiegelung und Drag-and-drop. Für manche AI-Dienste ist ein Motorola-Konto nötig.

Das Update-Versprechen bleibt eher konservativ. Motorola nennt drei große Android-Versionen und vier Jahre Sicherheits-Patches. Damit reicht der Support nach heutigem Stand bis 2029. Das ist in Ordnung, mancher Konkurrent verspricht inzwischen aber bis zu sieben Jahre.

Akku

Trotz der schlanken Bauform des Motorola Edge 60 Pro verbaut der Hersteller einen großzügigen Akku mit 6000 mAh. Offizielle Details zur Technologie gibt es zwar nicht, doch wahrscheinlich handelt es sich um einen Lithium-Ionen-Akku mit spezieller Silizium-Kohlenstoff-Anode. Diese ermöglicht eine höhere Energiedichte als herkömmliche Grafit-Anoden – und erklärt die für ein so dünnes Smartphone beachtliche Kapazität.

Im Alltag schlägt sich das Gerät dank des großen Akkus überdurchschnittlich gut: Ein Tag intensiver Nutzung ist problemlos möglich, bei moderatem Betrieb hält es meist zwei bis drei Tage durch. Das kann sich sehen lassen – zumal man dies einem so schlanken Smartphone kaum zutrauen würde.

Aufgeladen wird kabelgebunden mit bis zu 90 W, sofern ein kompatibles Motorola-Netzteil oder ein Ladegerät mit USB Power Delivery 3.0 zur Verfügung steht. Im Lieferumfang liegt allerdings keines bei. Bereits nach rund 15 Minuten ist der Akku etwa zur Hälfte gefüllt, nach etwa 50 Minuten vollständig. Kabelloses Laden wird mit bis zu 15 W unterstützt, kabelgebundenes Reverse Charging mit bis zu 5 W.

Preis

Die unverbindliche Preisempfehlung liegt bei 600 Euro. Bei Drittanbietern gibt es das Gerät bereits für knapp über 396 Euro. Als Farben stehen Grau, Blau und Violett zur Wahl.

Fazit

Das Motorola Edge 60 Pro überzeugt mit hochwertiger Haptik, exzellenter Verarbeitung und einem Auftritt, der an ein echtes High-End-Smartphone erinnert. Dazu passen die Ausstattungspunkte wie Schutz nach IP69 und MIL‑STD‑810H, das starke OLED‑Display, eine Kamera, die fast auf Augenhöhe mit der Smartphone-Elite agiert, sowie der großzügige Speicher. Auch der Akku weiß zu gefallen: Er hält lange durch und lässt sich schnell laden – auf Wunsch sogar kabellos. Ebenso macht die Alltags‑Performance einen rundum überzeugenden Eindruck.

Dennoch gibt es Punkte, die den vergleichsweise niedrigen Preis erklären: Software‑Updates könnten länger garantiert sein, USB 2.0 ist nicht mehr zeitgemäß, und reine Benchmark-Enthusiasten werden mit dem Edge 60 Pro kaum glücklich. Letztlich bietet das Gerät jedoch viel Oberklasse-Feeling zum fairen Preis – mit Kompromissen, die im Alltag leicht zu verschmerzen sind.

Xiaomi 15

Klein, stark, edel: Das Xiaomi 15 ist ein kompaktes High-End-Smartphone mit Spitzen-Kamera, hoher Leistung und exzellenter Verarbeitung.

- Top-Performance

- hervorragende Kamera

- lange Akkulaufzeit & schnelles Laden

- handlich & hochwertig

- Leica-Profile wirken teils unnatürlich

- kürzerer Update-Support als bei Google, Samsung und Honor

Xiaomi 15 im Test: Das beste kleine Android-Smartphone 2025

Klein, stark, edel: Das Xiaomi 15 ist ein kompaktes High-End-Smartphone mit Spitzen-Kamera, hoher Leistung und exzellenter Verarbeitung.

Mit dem Xiaomi 15 bringt der Hersteller ein kompaktes, aber vollwertiges Flaggschiff-Handy auf den Markt. Trotz seiner handlichen Abmessungen bietet das Gerät starke Performance, eine hochwertige Kamera-Ausstattung und eine erstklassige Verarbeitung.

Während Modelle wie das Xiaomi 15 Ultra (Testbericht) oder das Samsung Galaxy S25 Ultra (Testbericht) mit riesigen Displays und üppigen Gehäusen punkten, richtet sich das Xiaomi 15 an Nutzerinnen und Nutzer, die ein leistungsstarkes, aber kompaktes Premium-Smartphone suchen. Trotz der geringen Größe macht Xiaomi keine technischen Kompromisse – es bietet einen High-End-SoC, ein hochauflösendes AMOLED-Display mit LTPO-Technologie, schnelle Ladeleistung sowie eine überzeugende Leica-Kamera.

Wie gut das kompakte Flaggschiff im Alltag tatsächlich abschneidet, klären wir im ausführlichen Praxistest des Xiaomi 15.

Design

Mit seinem kantigen Design wirkt das Xiaomi 15 modern, edel und zugleich elegant. Das Gehäuse folgt einer klaren, geometrischen Formsprache. Auf der Rückseite befindet sich ein quadratisches Kameramodul mit leicht abgerundeten Ecken – im selben Designstil wie das Gerät selbst. Darin sind drei Linsen und ein LED-Blitz symmetrisch angeordnet.

Mit Abmessungen von 152,3 × 71,2 × 8,1 mm und einem Gewicht von 191 g liegt das Xiaomi 15 angenehm in der Hand und lässt sich auch mit einer Hand bedienen. Es passt so problemlos in eine Hosentasche und bleibt dabei handlich. Neben klassischem Schwarz und Weiß gibt es eine Variante in hellem Grün.

Die matte Glasrückseite ist weitgehend unempfindlich gegenüber Fingerabdrücken, allerdings etwas rutschig, weshalb sich eine Schutzhülle empfiehlt. Der Rahmen besteht aus Metall und vermittelt zusammen mit der Glasrückseite ein hochwertiges Flaggschiff-Gefühl. Auch die Tasten bieten einen präzisen, angenehmen Druckpunkt. Das Xiaomi 15 ist nach IP68 gegen Wasser und Staub geschützt.

Display

Das Xiaomi 15 ist mit einem 6,36 Zoll großen AMOLED-Display mit LTPO-Technologie ausgestattet, das mit 2670 × 1200 Pixeln eine hohe Pixeldichte von 460 PPI erreicht. Der Bildschirm ist flach gestaltet, verfügt über ein mittig angeordnetes Kameraloch und bietet eine hervorragende Screen-to-Body-Ratio von rund 90 Prozent. Dank einer adaptiven Bildwiederholrate von 1 bis 120 Hz wirkt die Darstellung stets flüssig, während die Touch-Abtastrate von 300 Hz Eingaben präzise umsetzt.

Mit einer Spitzenhelligkeit von bis zu 3200 Nits ist das Display auch bei direktem Sonnenlicht einwandfrei ablesbar. Unterstützung für HDR10+ und Dolby Vision sorgt zudem für intensive Farben und starken Kontrast – ideal zum Streamen oder Fotografieren. In der Praxis überzeugt der Bildschirm mit exzellenter Bildqualität, stabilen Blickwinkeln und natürlichen Farben, was ihn zu einem der besten Panels seiner Größenklasse macht.

Kamera

Das Xiaomi 15 setzt auf eine vielseitige Triple-Kamera mit durchweg 50-Megapixel-Sensoren. Die Hauptkamera (f/1.62) verfügt über einen optischen Bildstabilisator (OIS) und liefert detailreiche, scharfe Aufnahmen mit hohem Dynamikumfang. Dazu kommt eine Ultraweitwinkelkamera (f/2.2), die auch für Makroaufnahmen genutzt wird, sowie eine Telelinse mit OIS und 2,6-fachem optischem Zoom (f/2.6). Für Selbstporträts ist eine 32-Megapixel-Frontkamera integriert.

Wie schon bei früheren Modellen wurde das Kamerasystem in Kooperation mit Leica entwickelt. Die Traditionsmarke war erneut für die Optimierung von Optik und Bildsoftware verantwortlich. Nutzer können zwischen zwei Leica-Farbmodi wählen: Vibrant liefert kräftige, kontrastreiche Farben, während Authentic auf eine natürlichere, etwas gedämpfte Darstellung setzt. Im Alltag wirken Aufnahmen mit Vibrant teils etwas übersättigt, Authentic hingegen leicht düster – beide Varianten verleihen den Bildern jedoch einen charakteristischen, aber nicht immer ganz natürlichen Leica-Look.

Bei Tageslicht überzeugt das Xiaomi 15 mit sehr detailreichen, scharfen Fotos, natürlicher Farbwiedergabe und ausgewogenem Kontrast. Auch bei zweifachem Zoom bleiben die Aufnahmen klar und weitgehend rauschfrei. Im Nachtmodus sorgt die Kamera für gut belichtete, aufgehellte Szenen, muss jedoch bei Detailtiefe und Dynamik leichte Abstriche hinnehmen.

Die Ultraweitwinkelkamera stimmt farblich gut mit der Hauptlinse überein und liefert ähnlich scharfe, detailreiche Aufnahmen. Lediglich bei Dunkelheit zeigt sie leichte Schwächen. Die Telekamera überzeugt mit verlustfreiem 2,6-fach-Zoom, und selbst bei fünffacher Vergrößerung bleiben die Bilder erstaunlich scharf. Bis zu einer 30-fachen Vergrößerung sind die Ergebnisse noch akzeptabel, darüber hinaus – bis zum maximalen 60-fach-Zoom – nimmt die Schärfe deutlich ab.

Selfies gelingen mit hoher Bildschärfe, natürlicher Farbwiedergabe und präziser Belichtung. Auch Videos überzeugen: Sie wirken scharf, farbecht und hervorragend stabilisiert – in 4K sind bis zu 60 FPS, in 8K maximal 30 FPS möglich.

Xiaomi 15 – Originalaufnahmen

Ausstattung

Mit dem Qualcomm Snapdragon 8 Elite liefert das Xiaomi 15 reichlich Leistung – genug, um auch in den kommenden Jahren problemlos mitzuhalten. Ob im Alltag oder bei anspruchsvollen Spielen, Rechen- und Grafikleistung sind stets im Überfluss vorhanden. Das belegen auch die starken Benchmark-Ergebnisse: rund 17.000 Punkte im PCMark und 6.500 Punkte im 3DMark Wild Life Extreme.

Unterstützt wird der SoC von 12 GB RAM sowie schneller UFS-4.0-Speicher mit wahlweise 256 oder 512 GB Kapazität. Eine Erweiterung per microSD-Karte ist nicht vorgesehen. Die Stereo-Lautsprecher liefern einen ordentlichen, klaren Klang – ideal für Videos oder Streams, weniger bei Musik.

Bei der Konnektivität zeigt sich das Gerät auf aktuellem Stand: Wi-Fi 7, 5G, Bluetooth 6.0 (inklusive aptX Adaptive, LDAC, LHDC, AAC, SBC und LC3), USB-C 3.2 mit DisplayPort, NFC und Infrarot sind an Bord. Dual-SIM wird ebenso unterstützt wie der gleichzeitige Betrieb von bis zu zwei eSIMs.

Der im Display integrierte Ultraschall-Fingerabdrucksensor reagiert flott und präzise. Bei der Ortung greift das Xiaomi 15 auf alle relevanten Satellitensysteme zurück – GPS, Glonass, Beidou, Galileo, QZSS und Navic – mit einer Genauigkeit von etwa drei Metern laut GPS-Test.

Software

Ausgeliefert wird das Xiaomi 15 mit Hyper OS 2 auf Basis von Android 15. Mittlerweile steht ein Update auf Hyper OS 3 mit Android 16 zur Verfügung. Die Oberfläche erinnert optisch eher an iOS als an klassisches Android und bietet zahlreiche Möglichkeiten zur Anpassung – von Hintergründen über App-Icons bis zu Schriftarten. Themes gibt es teils kostenlos, teils gegen Gebühr, der App-Drawer lässt sich je nach Geschmack aktivieren oder ausblenden.

Die Update-Politik hat Xiaomi deutlich verbessert: Sechs Jahre Sicherheitsupdates (bis 2031) und vier große Android-Versionen (bis 2029) sind zugesagt. Das ist gut, aber Samsung, Google und Honor machen das besser, mit garantierten Updates und Patches für sieben Jahre. Zum Testzeitpunkt im November war der Sicherheitspatch noch recht aktuell und stammte aus Oktober 2025.

Neben den Google-Apps installiert Xiaomi viele eigene Anwendungen sowie den alternativen App-Store App Mall. Das vergrößert die Auswahl, führt aber teilweise zu doppelten Funktionen, auch wenn viele dieser Apps deinstalliert werden können. Immerhin hält sich die Zahl der vorinstallierten Drittanbieter-Apps mittlerweile in Grenzen.

Bei den KI-Funktionen setzt Xiaomi vorrangig auf Google Gemini, ergänzt durch eigene Features unter dem Namen Hyper AI. Dazu gehören dynamische Hintergrundbilder, ein Schreibassistent, Textzusammenfassungen und ein Sprachrekorder mit Übersetzungsfunktion. In der Galerie lassen sich – ähnlich wie bei Google oder Samsung – Objekte und Spiegelungen entfernen.

Akku

Eine typische Schwachstelle kleiner Smartphones ist oft der begrenzte Akku – nicht so beim Xiaomi 15. Dank Silizium-Karbon-Technologie bringt der kompakte und leichte Bolide eine beachtliche Kapazität von 5240 mAh mit. Zum Vergleich: Das ähnlich kleine Samsung Galaxy S25 begnügt sich mit 4000 mAh.