Apps & Mobile Entwicklung

(G)B300 vs. (G)B200: Blackwell Ultra nimmt Steroide und beherrscht PCIe 6.0

Als Nvidia GB300 auf Basis von Blackwell Ultra zur GTC im März 2025 präsentierte, blieben viele technische Fragen zum Blackwell-Refresh als Brückenschlag zum echten Nachfolger Nvidia Rubin mit Vera noch offen. Zur Konferenz Hot Chips 2025 hat der Konzern jetzt einige geklärt – Überraschung inklusive.

Blackwell Ultra übernimmt wohl den Blackwell-Dual-Die

Eine wesentliche Frage betraf die nach der zugrundeliegenden GPU. Nutzt Blackwell Ultra eine neue, oder die 208 Milliarden schwere Blackwell-GPU mit zwei in einem Chip verbundenen Dies? Dass es die gleiche GPU sein wird, lag nahe, doch erst Nvidias Developer Blog stellt jetzt fest: „Blackwell Ultra is manufactured using TSMC 4NP and features 208B transistors.“

Identische Anzahl Transistoren, identischer Fertigungsprozess – Blackwell Ultra sollte damit auf Chip-Ebene 1:1 Blackwell entsprechen (auch wenn das Blackwell White Paper (PDF) die 208 Mrd. Transistoren explizit nur in Bezug auf Blackwell nennt). Die teils doch gravierenden Unterschiede zwischen Blackwell und Blackwell Ultra erscheinen vor diesem Hintergrund in einem ganz anderen Licht.

Blackwell Ultra bietet mehr

Denn rückblickend war Blackwell als B100, B200 oder GB200 damit sehr stark beschnitten. GB300 nutzt in Zukunft 160 Streaming Multiprocessors mit je 128 Cuda-Kernen, B100, B200 und GB200 griffen hingegen nur auf 144 zurück. Der Vollausbau des Chips dürfte sogar noch mehr Einheiten bieten.

Der breitere Chip darf darüber hinaus noch etwas mehr elektrische Leistung aufnehmen: 1.400 statt 1.200 Watt sind es für das Dual-GPU-CPU-Konstrukt „Grace Blackwell“ (GB300 vs. GB200), 1.200 statt 1.000 Watt für eine separate GPU (B300 vs. B200). Statt 186 GB HBM3e sind 288 GB HBM3e angebunden – dabei bleibt es bei acht Stapeln („Stacks“).

50 Prozent mehr FP4-Leistung

Mehr Ausführungseinheiten, mehr TDP, dadurch mehr Takt und mehr HBM3e – klar, dass Blackwell Ultra schneller ist als Blackwell. Doch schon im März ließ aufhorchen, dass die neue Version bis zu 50 Prozent schneller sein soll. Das Unternehmen sprach von 15 PetaFLOPS für FP4 Dense, also ohne die Sparsity-Beschleunigung, mit der 30 PetaFLOPS möglich sind. Für die ursprüngliche Blackwell-GPU lag diese Angabe noch bei 10 PetaFLOPS. Im Juni dieses Jahres führte Nvidia das weiter aus.

Die überproportional höhere FP4-Leistung von Blackwell Ultra kommt allerdings mit einem Haken: Die INT8, aber insbesondere die FP64-Leistung fällt deutlich. Insbesondere FP64 ist für das Hauptanwendungsgebiet der GPUs, AI Training und Inferencing allerdings so gut wie irrelevant, während FP4 für AI-Anwendungen von immer größerer Bedeutung ist.

Sofern der Chip wirklich der gleiche geblieben ist, hat Nvidia diese Anpassungen allein per „Firmware“ vorgenommen.

PCI Express 6.0

Eine weitere Anpassung von Blackwell Ultra gegenüber Blackwell müsste das ebenso betreffen: Das PCI-Express-Interface beherrscht jetzt PCIe 6.0 mit bis zu 256 GB/s statt vormals PCIe 5.0 mit bis zu 128 GB/s. Die Hardware dafür muss der Blackwell-Chip also ebenfalls schon geboten haben, nur freigegeben wurde die im Jahr 2022 verabschiedete PCIe-Version 6.0 erst jetzt.

Apps & Mobile Entwicklung

Datenschutzbeauftragte: Nein von der Bundesregierung zur Chatkontrolle gefordert

Auch wenn die Bundesregierung durch ihre bislang unklare Haltung eine Zustimmung des EU-Rats zur Chatkontrolle verhindert hat, fordern Datenschutzbeauftragte von Bund und Ländern sowie die VPN Trust Initiative eine endgültige Abkehr von den Plänen zur anlasslosen Überwachung von EU-Bürgern in Messenger-Diensten.

Datenschützer gegen Ausspähung

Die Konferenz der unabhängigen Datenschutzbehörden von Bund und Ländern (DSK) hat sich in einem gestern veröffentlichten Positionspapier gegen die Pläne der dänischen EU-Ratspräsidentschaft gestellt und die Bundesregierung aufgefordert, an ihrem Nein zur Chatkontrolle festzuhalten. Die Ratspräsidentschaft hatte die Abstimmung über den Gesetzesentwurf für den 14. Oktober angesetzt, der erneut die verpflichtende Möglichkeit zur Massenüberwachung privater Chats sowie das flächendeckende Scannen privater Nachrichten auf Endgeräten mittels „Client-Side-Scanning“ wieder vorsieht.

In dem gemeinsamen Schreiben fordert die diesjährige Vorsitzende der DSK, die Berliner Beauftragte für Datenschutz und Informationsfreiheit (BlnBDI), Meike Kamp, die Bundesregierung auf, weiter für sichere und vertrauenswürdige Kommunikation einzutreten und den Entwurf in dieser Fassung abzulehnen. Durch die Chatkontrolle würden nach Einschätzung der DSK „rechtsstaatliche Grenzen überschritten“, erklärte Kamp. Die anlasslose Massenüberwachung stelle Millionen Bürger in der Europäischen Union unter Generalverdacht und sei daher unverhältnismäßig. Das Aufbrechen von Verschlüsselung gefährde „die sichere Kommunikation in unserer offenen Gesellschaft“ und „wäre das Ende der Privatsphäre, wie wir sie kennen“, so Kamp weiter.

Zwar sei sich der DSK dem Papier nach bewusst, dass Sicherheitsbehörden wirksame Werkzeuge und rechtliche Möglichkeiten benötigen, um sexuellen Missbrauch von Kindern bekämpfen und verhindern zu können, dieses Ziel dürfe jedoch nicht auf Kosten der Privatsphäre von Millionen Menschen verfolgt werden.

Immer mehr Kritiker

Mit dieser Erklärung erhält die bereits jetzt schon lange Liste der Kritiker der Chatkontrolle ein weiteres prominentes Mitglied, womit die Forderungen nach einer endgültigen Ablehnung lauter werden. Zuletzt hatte sich auch der Kinderschutzbund erneut gegen das Vorhaben ausgesprochen, da der vermeintliche Schutz durch die Chatkontrolle die Privatsphäre von Kindern selbst gefährden könne. Der Vorstand des IT-Branchenverbands eco, Klaus Landefeld, bezeichnete das Vorhaben zudem als „total unausgegoren und technisch nicht tragfähig“. Der Digitalrechtsaktivist und ehemalige EU-Abgeordnete der Piratenpartei Deutschland, Patrick Breyer, warnte, die Ermittlungsbehörden seien bereits heute an ihrer Belastungsgrenze angekommen, das Bundeskriminalamt (BKA) „ertrinke“ seiner Aussage nach bereits regelrecht in Falschmeldungen. Erstmals äußerte sich zudem auch die Unionsfraktion von CDU/CSU kritisch zu dem Thema.

VTI lehnt anlasslose Überwachung ebenfalls ab

Nun positioniert sich auch die VPN Trust Initiative (VTI), zu der unter anderem Anbieter wie NordVPN gehören, in einem Positionspapier (PDF) klar gegen das geplante Gesetz. Zwar unterstütze der Zusammenschluss die Strafverfolgung bei Gefährdung von Kindern uneingeschränkt, nicht jedoch um den Preis, die Sicherheit aller zu schwächen – insbesondere dann, wenn die Wirksamkeit der Maßnahmen ungewiss sei. Die Initiative fordert politische Entscheidungsträger auf, Maßnahmen zu vermeiden, die Verschlüsselung aushöhlen und die Sicherheit der Nutzer gefährden.

Darüber hinaus verweist die VTI auf einen seit den ersten Plänen zur Chatkontrolle offenen Widerspruch: Während die geplante EU-Verordnung Behörden zu Ermittlungsanordnungen ermächtigen würde, die wahllose Durchsuchungen privater Kommunikation – auch Ende-zu-Ende-verschlüsselter Dienste – erlauben, betone die EU-Strategie für innere Sicherheit zugleich immer wieder die Wichtigkeit verschlüsselter Kommunikation. Welche Folgen ein solcher Ansatz haben könnte, zeigte sich im Februar 2025, als die britische Regierung auf Grundlage des Investigatory Powers Act Apple verpflichtete, Ende-zu-Ende-verschlüsselte iCloud-Backups für Nutzer in Großbritannien zu deaktivieren.

Aus diesem Grund fordert die VTI die Bundesregierung nachdrücklich auf, alle Maßnahmen abzulehnen, die Verschlüsselungs-Hintertüren vorschreiben, Standards abschwächen oder unsichere technische Anforderungen auferlegen, und stattdessen starke Verschlüsselung ohne Ausnahmen für alle Unternehmen, die mit Nutzerdaten arbeiten, beizubehalten. Gleichzeitig solle die Politik gezielte und verhältnismäßige Ermittlungsmöglichkeiten stärken, die keine Schwächung der Verschlüsselung erfordern.

Für die VTI ist Verschlüsselung ein nicht verhandelbarer Schutz für die Rechte auf Privatsphäre und Meinungsfreiheit. Ihre Schwächung würde personenbezogene Daten aller Nutzer dem Abfangen, der Überwachung und dem Missbrauch aussetzen. Der Verbund verweist zudem darauf, dass der Europäische Gerichtshof für Menschenrechte bereits im Februar 2024 bekräftigt habe, dass Verschlüsselung für den Schutz privater Kommunikation von grundlegender Bedeutung und ihre Schwächung daher rechtswidrig sei. Dies dürfte somit auch auf die Chatkontrolle zutreffen.

Umsetzung immer fraglicher

Ob sich die EU-Kommission angesichts der zunehmenden Kritik von ihrem Vorhaben abringen lässt, dürfte fraglich sein. Es dürfte vielmehr nur eine Frage der Zeit sein, bis ein neuer Vorschlag unterbreitet wird, um die dem Gesetzesentwurf kritisch gegenüberstehenden Staaten zu einem Einlenken zu bewegen. Eigentlich wollte das Gremium bereits bis spätestens Juni 2024 eine Einigung erzielen. Selbst wenn diese zu einem späteren Zeitpunkt gelingen sollte, bleibt die Umsetzung des Vorhabens weiterhin unsicher: Im nächsten Schritt müsste der EU-Rat in die Trilog-Verhandlungen mit der EU-Kommission und dem EU-Parlament treten. Das Parlament hatte sich jedoch bereits im November 2023 auf eine gemeinsame Linie geeinigt, in der die anlasslose Überwachung keine Rolle mehr spielt.

Apps & Mobile Entwicklung

Watch SE 3 im Test

Vor der Keynote im September mussten sparsame Apple-Fans noch echt viele Abstriche machen! Das iPhone 16 hatte nur 60 Hz und die SE 2 kam im Jahr 2022 ohne 5G, Gesten und ohne Energiesparmodus auf den Markt. Diese und weitere Eigenschaften fügt Apple der Watch SE 3 im Jahr 2025 hinzu. Und produziert damit eine wirklich alltagstaugliche Smartwatch. Dabei profitiert die Watch besonders von – Ihr ahnt es – Apples Ökosystem!

Pro

- Mal wieder toll eingebunden ins Apple-Ökosystem

- Stromsparmodus macht wirklich Sinn

- 5G-Modul und Gestensteuerung bekommen

- Zuverlässiges Tracking

Contra

- Akkulaufzeit noch immer zu kurz

- Ohne EKG oder Blutdruck-Funktionen

Apple Watch SE 3: Alle Angebote

Preis und Verfügbarkeit

Beim Kauf der Apple Watch SE 3 habt Ihr sechs Möglichkeiten: Mitternacht oder Polarstern als Farben – 40 mm oder 44 mm als Gehäusegrößen – 5G oder lieber WiFi-only. Die Preise sehen wie folgt aus:

Apple Watch SE 3 Preisgestaltung

| WiFi / GPS | 5G | |

|---|---|---|

| 40 mm | 269 € | 319 € |

| 44 mm | 299 € | 349 € |

Je nach Gusto könnt Ihr Euch dann noch Armbänder dazubuchen, die aus verschiedenen Materialien bestehen. Standardmäßig ist ein Band aus Gummi im Lieferumfang enthalten. Nutzt Ihr schon eine ältere Apple-Smartwatch, könnt Ihr diese natürlich auch eintauschen.

Design & Verarbeitung der Watch SE 3

Okay, auf den ersten Blick ist die Watch SE 3 nicht vom Vorgängermodell zu unterscheiden. Wer mit einer Apple Watch im Jahr 2025 protzen will, der greift zur riesigen Apple Watch Ultra 3, die Wearable-Expertin Camila schon für nextpit getestet hat! Die SE 3 gibt’s hingegen in den Größen 40 mm und 44 mm, für unseren Test schickte Apple uns das Modell mit 44 mm. Der Hersteller meint dabei aber nicht den Durchmesser der Uhr, sondern die vertikale Länge beim Draufschauen.

Das Gehäuse besteht dabei stets aus Aluminium, lackiert wird es in den Farben „Polarstern“ und „Mitternacht“. Viel bekommt man vom Gehäuse der Smartwatch aber nicht mit. Denn es wird jeweils komplett von einer Glasscheibe bedeckt, unter der zwei hochwertige OLED-Panels sitzen. Je nach Gehäusegröße unterscheiden sich natürlich auch die Displaygrößen. Schön zu sehen ist dabei aber, dass die Displayränder bei beiden Uhren schmal sind und die Pixeldichte jeweils bei 226 ppi liegt.

Einzelne Pixel lassen sich so nicht erkennen. Die LTPO-fähigen OLED-Panels erreichen zudem bis zu 1.000 Nits und lassen sich auch im Sonnenschein gut ablesen. Dank LTPO sinkt die Bildwiederholrate bei Nichtbenutzung so weit herunter, dass Apple einen Always-on-Modus anbietet. Dieser zeigt meist permanent die Uhrzeit, was im Alltag echt praktisch ist.

Diese Eigenschaften kennen wir aber soweit schon vom Vorgängermodell. Neu ist jedoch, dass Apple ein besonders hartes Ion-X Glas verwendet, das laut Herstellerangaben eine viermal bessere Bruchsicherheit bietet. Getestet haben wir das nicht – sonst gibt’s Ärger vom Hersteller.

Wenig Ärger gibt’s hingegen beim Bedienkonzept der Uhr. Denn wir haben eine ganz neue Art, mit der Smartwatch zu interagieren. Bestehen bleibt die digitale Krone, die wirklich wunderbar präzise ist. Clever ist jedoch, dass auch die günstigste Apple Watch nun zwei Gesten erkennen kann. Tippen wir Daumen und Mittelfinger zusammen, können wir Karten auf der Uhr durchschalten (dazu gleich mehr). Schütteln wir das Handgelenk, löschen wir Benachrichtigungen. Das geht bei Apple gut genug, als dass man die Funktion nutzt. Ein Mehrwert, bei der Xiaomi Watch S4 (zum Test) habe ich die Funktion weniger häufig genutzt.

Mit einem Gewicht von nur etwa 33 bzw. knapp 26 g sind beide Gehäusegrößen übrigens wunderbar leicht. Ich trage sonst eine 132 g schwere Scanwatch Nova von Withings und habe die Apple Watch beim Tragen sehr häufig vergessen. Standardmäßig legt Apple ein Armband aus Gummi dabei, das einen eher unkonventionellen Verschluss bietet. Dabei drückt man erst einen Pin durch ein Loch und schiebt das restliche Band durch eine Schnalle. Mir sind konventionelle Armbänder lieber – gibt’s aber für die Watch SE 3 auch zu kaufen.

Noch ein großes Lob an Apple: Der Vibrationsmotor der Watch SE 3 ist wirklich genial. Nach einiger Zeit erkennt man an der jeweiligen Vibration, welches Ereignis die Watch einem signalisieren will. Insgesamt ist und bleibt die SE 3 eine hochwertige und vor allem unauffällige Smartwatch. Die Bedienung wird im Jahr 2025 noch besser und Nachteile lassen sich nach mehreren Tagen im Test nicht verzeichnen. Klasse!

Apple Ökosystem-Ass

Wirklich einzigartig in der Welt der Smartwatch ist Apples Verbindung zwischen iPhone, Apple Watch, MacBook und Co. Denn Apple findet immer wieder kleine Kniffe, wie das Ökosystem aus Geräten miteinander kommunizieren kann. So kann Face-ID im iPhone etwa die Apple Watch entsperren oder alle Geräte schalten sich stumm, wenn man den Fokus-Modus auf dem MacBook aktiviert.

Die Apple Watch SE der dritten Generation profitiert zudem von WatchOS 26. Das neue Apple-Watch-Betriebssystem erstrahlt ebenfalls im Liquid-Glass-Design, das modern und durchaus mutig daherkommt. Apple schafft hier aber eine bessere Lesbarkeit als auf dem iPhone, da nicht ganz so viele Elemente in den Menüs durchsichtig sind.

Die Bedienung der Apple Watch wird zudem maßgeblich von Apps und den „Smart Stapeln“ bestimmt, die man jeweils an die eigenen Bedürfnisse anpassen kann. Apples neue „Smart Stapel“ verstehen ein wenig, welche Informationen man am Handgelenk gerade benötigt. Bin ich etwa unterwegs, zeigt mir die Watch automatisch die zurückgelegte Strecke via Google Maps an. Oder die Watch schlägt die Kamerafernbedienung vor, wenn ich mit meinem iPhone ein Foto mache.

Bevor ich nochmal kurz auf die Apps eingehe, empfehle ich Camillas Artikel mit den 10 Top-Features in WatchOS 26! Und nun zu den Apps: Es gibt meiner Erfahrung nach keine andere Smartwatch, die noch so viele Funktionen dazulernen kann. So finde ich Spotify als native App auf der Uhr, kann QR-Codes für Pakete in der DHL-App anzeigen lassen, meine Reiseroute im DB-Navigator checken und vieles mehr. Damit, und dank Smartphone-Unabhängigkeit dank 5G-Modul, wird die Apple Watch im Alltag wirklich nützlich. Das schaffen andere etablierte Hersteller längst nicht so gut.

Technik & Tracking

Überraschung: Die Watch SE 3 bekommt dasselbe SoC wie die Watch Ultra 3 (zum Test) und die Watch Series 11. Damit liegt sie leistungstechnisch mit den teureren Modellen aus diesem Jahr gleichauf. Im Vergleich zum Vorgängermodell erhöht Apple zudem die Speicherkapazität um das Doppelte. Wir bekommen 64 GB statt 32 GB. Speicher für Offline-Musik, Apps und Co. sollte uns also erstmal nicht ausgehen.

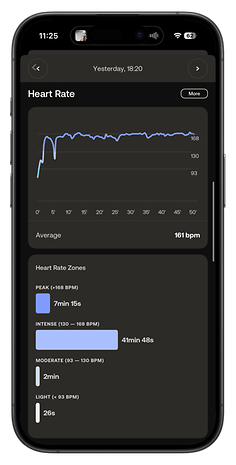

Weniger beeindruckend, aber solide, ist der Funktionsumfang der Watch. Wir bekommen den Herzfrequenzsensor der 2. Generation mit Temperaturmessung, dafür aber ohne EKG und Blutsauerstoffmessung. Dazu die Unfall- und Sturzerkennung, Apples Lärmüberwachung sowie über 25 native Trainingsmodi. Diese können wir via GPS tracken und bekommen Gesundheits-Features wie Zyklus-Tracking, Achtsamkeit, Atemübungen sowie eine bessere Schlafüberwachung inklusive Mitteilungen zu Schlafapnoe.

Die SE 3 liegt damit technisch hinter einigen Konkurrenten und auch hinter den Series 11 und dem Ultra-Modell. Gerade die Messung des Blutsauerstoffgehalts würde das Schlaf-Tracking unterstützen. Denn so muss Apple zur Erkennung von Schlafapnoe auf Mikrofone zurückgreifen – das sorgt für ein mulmiges Gefühl beim Schlafen. Aber schauen wir uns die drei zentralen Messpunkte „Herz“, „Schlaf“ und „Tracking“ nochmal genauer an.

Herzfrequenz und -gesundheit

Apple konnte ich in den USA eine Zulassung als medizinisches Produkt für die Apple Watch sichern. Das ist für viele Menschen ein Grund, sich Apple Watches für den Notfall – also Vorhofflimmern oder auffällige Veränderungen der Herzfrequenz – zuzulegen. Die Apple Watch warnt dann rechtzeitig und rät Nutzenden dazu, einen Arzt aufzusuchen. Die „großen“ Watch Modelle ab Series 9 und die Ultra 2 können diese Warnungen nun auch bei erhöhtem Blutdruck ausgeben. Ganz ohne anschwellende Manschette, wie sie etwa in der Huawei Watch D zu finden ist.

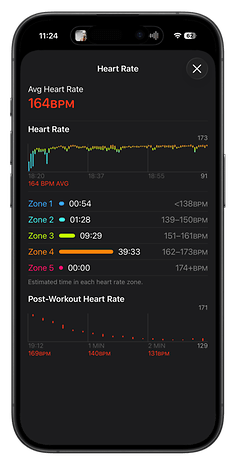

Zusammen mit der EKG-Funktion und einer Messung für den Blutsauerstoffgehalt fehlen der SE 3 also drei nützliche Funktionen für die Ermittlung der Herzgesundheit. Die aktuell günstigste Apple Watch zeigte sich bei der Überwachung der Herzfrequenz trotzdem sehr zuverlässig:

Hier seht Ihr den Vergleich zur Withings Scanwatch Nova, die in meinem Test sehr nah an einen angelegten Brustgurt beim Joggen heranreichen konnte. Leichte Abweichungen sind hier normal – für die meisten Menschen relevante Orientierung an den Herzfrequenzzonen taugt die günstigste Apple Watch auf jeden Fall aus.

Ganz interessant ist im Bereich „Herzgesundheit“ noch, dass Apple bisher keinen großen Fokus auf die HRV legt. Die Herzfrequenzvariabilität wird von Trackern wie dem Whoop 5.0 (zum Test) als zentrale Orientierung für die Erholung und für die Belastung beim Sport genutzt. Auch Withings hat die HRV über ein Update im Sommer 2025 nachgeliefert. Apple zeichnet die HRV ebenfalls auf, man muss in der Health-App allerdings ein wenig danach suchen. Wer mag, kann den Wert dann aber auf der Startseite der Health-App anpinnen.

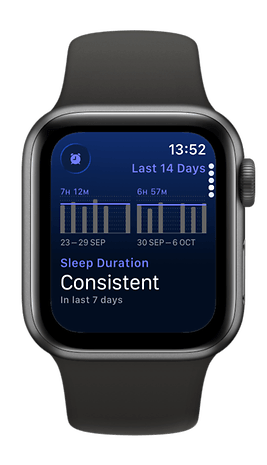

Schlaf-Tracking

Ganz schön anstrengend, so viele Fachwörter! Lasst uns einen kleinen Mittagsschlaf machen und dabei die SE 3 zum Schlaf-Tracking nutzen. Erstmal positiv: Durch ihre Größe und das geringe Gewicht fällt die Watch SE 3 beim Schlafen kaum auf. Sie kann uns zudem auch über Vibrationen und Töne wecken, wodurch das Smartphone nicht mehr unbedingt im Schlafzimmer liegen muss. Die SE 3 beim Schlafen am Handgelenk zu tragen, hat zudem weitere Vorteile.

Denn die Smartwatch überwacht unseren Schlaf und erkennt Schlafphasen, gefährliche Schlafapnoe sowie die Ruheherzfrequenz. Dabei darf die SE 3 allerdings nicht im Batteriesparmodus sein, sonst zeichnet sie keine Schlafdaten auf. Mir bestätigte sie eine exzellente Schlafqualität, was noch vor wenigen Wochen mit den Ergebnissen meiner Scanwatch Nova übereinstimmte. Nach der Integration der HRV findet die Scanwatch meinen Schlaf allerdings nicht mehr so gut – ein Vergleich zur Apple Watch ist daher schwierig.

Tracking

Was mir bei der Watch SE 3 wirklich gut gefällt, ist, wie die Smartwatch mit sportlichen Aktivitäten umgeht. Beim Radfahren oder beim schnellen Laufen fragt mich die Uhr, ob ich aktuell trainiere und die Aktivität tracken möchte. Mit einem Tipp aufs Handgelenk kann ich so ein Training starten oder die Benachrichtigungen für den Rest des Tages stummschalten. Finde ich angenehmer als automatisches Tracking, da dabei sehr viel Nonsens in Fitness-Apps aufgezeichnet wird.

Beim Tracking zeigt mir die Uhr die aktuelle Herzfrequenz, die zurückgelegte Strecke beim Laufen und Radfahren sowie die aktuelle Herzfrequenzzone an. Zusätzlich sehe ich diese Info als Live-Benachrichtigung auf meinem iPhone und bekomme aktuelle Statistiken über meine Kopfhörer durchgesagt. Hier bleiben für mich keine Wünsche offen!

Insgesamt ist die Watch SE 3 zwar ein guter Begleiter beim Sport und im Alltag – der Smartwatch fehlen aber Tracking-Funktionen, die ich zu einem Preis von über 200 € erwarten würde. Apple will hier wohl Platz zu den teureren Modellen lassen. Hier gibt’s daher leider die größten Abstriche bei der „Special Edition“.

Wie lange hält die Watch SE 3 durch?

Im Alltag nutze ich eine Hybrid-Smartwatch, da ich sehr schlecht im Aufladen meiner Devices bin. Dementsprechend war ich ein wenig skeptisch, wie nervig ich die ein wenig berüchtigte Akkulaufzeit der Apple Watch finde. Apple gibt diese recht realistisch mit 18 Stunden an und bietet eine Schnellladefunktion an, wenn die Watch vor Workouts oder vorm Schlafen leer ist. Insgesamt würde ich die Batterie der SE 3 aber als „alltagstauglich, aber pflegeintensiv“ bezeichnen.

Denn bei einem aktiven Lebensstil – wir gehen mal von 1-2 Workouts am Tag aus, bei denen auch Radfahren zur Arbeit dazu gehören – müssen wir die Watch auf jeden Fall einmal am Tag aufladen. Dabei nimmt ein vollständiges Aufladen der Smartwatch ziemlich genau eine Stunde in Anspruch (Tabelle gibt’s weiter unten) und so lange kann man die Uhr eben nicht tragen. Wer die Uhr beim Schlafen lädt, muss auf das gute Schlaf-Tracking verzichten. Wer die Uhr tagsüber lädt, sollte sehr lange duschen oder einen Bürojob haben.

Ladezeiten Apple Watch SE 3

| Akkustand | Dauer |

|---|---|

| 0 % | 5:02 m |

| 10 % | 12:30 m |

| 30 % | 21:21 m |

| 50 % |

35:47 m |

| 75 % | 43:20 m |

| 85 % | 43:20 m |

| 100 % | 1h 04m |

Das ist weniger eine Kritik an der SE 3, es ist eher ein Kompromiss, den man bei einer derart funktionsfähigen und leichten Smartwatch in Kauf nehmen muss. Andere Smartwatches mit Display halten länger durch, sie sind aber meist schwerer, können weniger und sind nicht so aktiv mit dem Smartphone und anderen Devices verbunden. Um sich ein wenig näher an andere Smartwatches anzunähern, integriert Apple zudem einen Stromsparmodus.

In diesem reduziert sich der Funktionsumfang der Uhr deutlich. Die Uhr schränkt dabei die Messung der Herzfrequenz im Hintergrund ein, erkennt keine Gesten mehr, deaktiviert das Always-on-Display und limitiert auch den Mobilfunk sowie das WLAN.

Auffällig: Nutzung der Apple Watch reduziert Laufzeit des iPhones

Kleine Sidenote will ich noch mit aufnehmen: Die ständige Verbindung zwischen der Apple Watch und meinem iPhone scheint dessen Akkulaufzeit deutlich zu reduzieren. Normalerweise komme ich mit meinem iPhone 16 Pro, dessen Ladekapazität ich auf 80 % begrenzt habe, den ganzen Tag aus. Seitdem ich die Watch SE 3 nutze, muss ich da aber häufiger gegen Abend nachladen. Nur, dass Ihr’s mal gehört habt!

Lohnt sich der Kauf der Watch SE 3?

Leistung auf Niveau der Watch Ultra 3, gleich die doppelte Speichermenge und Handgesten. Die Watch SE 3 ist im Jahr 2025 ein fettes Upgrade. Apple verbessert die Smartwatch dabei so sehr, dass fraglich wird, ob sie überhaupt noch ein Kompromiss ist. Wem dünnere Displayränder oder der Rugged-Look der Ultra nicht gefallen, findet hier eine fast gleichwertige Apple Watch mit nahezu allen Möglichkeiten.

Die anderen Modelle bieten allerdings immer ein bisschen mehr. Und für mich sind es vor allem die erweiterten Tracking-Funktionen, die ich bei einer Smartwatch im Jahr 2025 nicht missen will. Das liegt nicht unbedingt daran, dass Werte wie die Sauerstoffsättigung des Blutes essenziell im Alltag sind, es sind eher schlichtweg Standard-Features, die selbst günstige Fitness-Tracker bieten.

Das macht die Watch SE 3 aber keineswegs zu einem schlechteren Begleiter im Alltag. Die SE 3 ist definitiv ein Kauftipp, der aber auch Lust auf mehr macht. Und dann kauft man sich einige Wochen später die Series 11 – und dann die Ultra 3, weil die ja noch ein bisschen mehr kann. Einstiegsdroge, Ihr versteht?

Apple Watch SE 3

Zur Geräte-Datenbank

Apps & Mobile Entwicklung

Möbel für Kreative: Elgatos erster Stuhl Embrace ist für „Creator und Profis“

Einfache Bürostühle für den eigenen Arbeitsplatz, egal ob im Büro oder Zuhause, waren vorgestern; Gaming-Stühle gestern. Jetzt geraten die Creatoren in den Fokus. Nach Gaming-Stühlen der Mutter Corsair gibt es von Elgato mit Embrace jetzt einen ersten Stuhl „für Creator und Profis“ für knapp 500 Euro.

Elgato erweitert das Geschäftsfeld

Elgato hat sich in den letzten Jahren auf das Geschäft mit Content-Creatoren, besonders im Bereich des Streaming, spezialisiert und biete verschiedene Lösungen für den Arbeitsalltag. Es ist daher nur konsequent, dass Elgato – mittlerweile eine Marke von Corsair – nun neben Gadgets auch Möbel für Kreativschaffende anbietet und das erste Produkt ist der ab Weihnachten erhältliche Stuhl „Embrace“.

Für Straming, Meetings, Arbeit und Gaming

Der Alltag vieler Kreativen ist vom langen Sitzen geprägt, entsprechend hebt Elgato die Vorzüge des neuen Studiostuhls Embrace hervor. Der Stuhl soll dabei viele ergonomische Einstellmöglichkeiten aus dem Premiumsegment zu einem fairen Preis von 499,99 Euro bieten. 4D-Armlehnen, Sitztiefenverstellung und eine abgerundete Vorderkante, um Druck von den Beinen zu nehmen, gehören ebenso dazu wie Lendenwirbelstütze, Neigungsbegrenzer oder eine atmungsaktive Rückenlehne aus einem Mesh-Material.

Neben den umfangreichen Ergonomiefunktionen wird der einfache Aufbau des Stuhls hervorgehoben, der innerhalb von 5 Minuten erfolgen soll. Dazu müssen nur vier Schrauben festgezogen werden und der passende Inbusschlüssel liegt natürlich bei.

Zurückhaltendes Aussehen

Während Gaming-Möbel in der Regel mit auffälligen Designs und prominent platzierte Logos Aufmerksamkeit erzeugen sollen, geht Elgato einen dezenteren Weg. Der Embrace erinnert an einen normalen Bürostuhl, ein Branding ist vorhanden, jedoch ist dieses „dezent auf der Rückseite der Kopfstütze platziert – außerhalb des Sichtfeldes“. Auch wird die Eignung für einen „geteilten Arbeitsbereich“ in der FAQ hervorgehoben, da alle Mechanismen leise arbeiten sollen.

Natürlich ist der Stuhl für alle entwickelt, die lange am Schreibtisch arbeiten, „unabhängig von ihrer Aufgabe“. Darüber hinaus ist der Stuhl für kleine und großen Personen durch die vielfältigen Einstellmöglichkeiten geeignet. Die maximale Belastung gibt Elgato mit 125 Kilogramm an, der Stuhl selbst kommt auf knapp 24 Kilogramm. Ein konkretes Datum für den Release nennt Elgato noch nicht, „Weihnachtssaison“ heißt es.

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 1 Monat

UX/UI & Webdesignvor 1 MonatAdobe Firefly Boards › PAGE online

-

Social Mediavor 2 Monaten

Social Mediavor 2 MonatenRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 1 Monat

Entwicklung & Codevor 1 MonatEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

UX/UI & Webdesignvor 4 Wochen

UX/UI & Webdesignvor 4 WochenFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online

-

Apps & Mobile Entwicklungvor 3 Monaten

Apps & Mobile Entwicklungvor 3 MonatenFirefox-Update 141.0: KI-gestützte Tab‑Gruppen und Einheitenumrechner kommen

-

Online Marketing & SEOvor 2 Monaten

Online Marketing & SEOvor 2 MonatenSo baut Googles NotebookLM aus deinen Notizen KI‑Diashows