Künstliche Intelligenz

iLLM-A*: Hybrid-KI soll Pfadplanung um Faktor 1000 beschleunigen

Die auf arXiv veröffentlichte Arbeit „A 1000× Faster LLM-enhanced Algorithm For Path Planning in Large-scale Grid Maps“ von Forschenden der National University of Defense Technology in China stellt einen neuen Algorithmus vor, der die Effizienz der Pfadplanung auf großen Gitterkarten erheblich steigern soll. Der Ansatz iLLM-A* kombiniert ein Sprachmodell mit einem optimierten A*-Algorithmus und soll die Suchzeit im Vergleich zu bestehenden Methoden um mehr als den Faktor 1000 reduzieren. Davon könnten potenzielle Anwendungsfelder wie autonome Robotik, Logistikplanung und die KI-Steuerung in komplexen Simulationen oder Videospielen profitieren.

Die Pfadplanung in großen, gitterbasierten Umgebungen stellt für traditionelle Wegfindungsalgorithmen wie A* und Dijkstra eine erhebliche rechnerische Herausforderung dar. Mit zunehmender Kartengröße steigen Zeit- und Speicherkomplexität überproportional an, was Echtzeitanwendungen in Bereichen wie Robotik oder der Simulation komplexer Systeme erschwert. Forscher stellen nun mit iLLM-A* einen hybriden Ansatz vor, der diese Beschränkungen adressiert.

Skalierungsgrenzen bestehender Algorithmen

Die Studie analysiert zunächst die Schwächen des bisherigen State-of-the-Art-Ansatzes LLM-A*. Dieser nutzt ein Large Language Model (LLM), um eine Sequenz von Wegpunkten zu generieren, zwischen denen dann der A*-Algorithmus kürzere, lokale Pfade sucht. Obwohl dieser Ansatz den globalen Suchraum reduziert, identifizierten die Forscher drei wesentliche Engpässe, die seine Leistung auf großen Karten (definiert als N ≥ 200, wobei N die Kantenlänge des Gitters ist) limitieren:

- Die Verwendung linearer Listen für die

OPEN– undCLOSED-Mengen (im Prinzip die Listen der möglichen und der bereits besuchten Wegpunkte) im A*-Algorithmus führt zu einer hohen Zeitkomplexität bei Such- und Einfügeoperationen. - Die global geführten Listen wachsen mit der Kartengröße stark an, was zu einem hohen Speicherverbrauch führt.

- LLMs neigen zur „räumlichen Illusion“ und generieren stochastische Wegpunkte, die redundant sein oder von der optimalen Route abweichen können, was den nachfolgenden A*-Suchprozess ineffizient macht.

Der von dem Team vorgestellte Algorithmus iLLM-A* (innovative LLM-enhanced A*) begegnet diesen drei Punkten mit gezielten Optimierungen:

- Die

CLOSED-Liste wurde durch eine Hash-basierte Datenstruktur ersetzt. Dies reduziert die Komplexität der Abfrage, ob ein Knoten bereits expandiert wurde, von der Größenordnung O(N) auf durchschnittlich O(1). - Eine verzögerte Aktualisierungsstrategie für die Heuristikwerte in der

OPEN-Liste vermeidet kostspielige Neuberechnungen für den gesamten Listenumfang. - Die Forscher setzen eine zweistufige Kollisionserkennung ein. Zunächst prüft ein rechenschonender Test mittels Axis-Aligned Bounding Boxes (AABB) auf potenzielle Kollisionen. Nur bei Überschneidung der Bounding Boxes wird eine präzise, aber aufwendigere Kollisionsprüfung durchgeführt.

Inkrementelles Lernen zur Erzeugung von Wegpunkten

Um die Qualität der vom LLM generierten Wegpunkte zu verbessern, haben die Forscher einen dynamischen Lernprozess implementiert: Dazu nutzt das System eine erweiterbare Few-Shot-Beispieldatenbank. Nachdem das LLM für eine Trainingskarte Wegpunkte generiert und der Algorithmus einen Pfad geplant hat, wird dieser Pfad anhand vordefinierter Metriken evaluiert. Diese Kriterien umfassen die Abweichung von der optimalen Pfadlänge sowie den Zeit- und Speicherverbrauch im Vergleich zu einer reinen A*-Lösung. Nur wenn der geplante Pfad die Qualitäts-Schwellenwerte erfüllt, wird das Paar aus Karte und generierten Wegpunkten als valides Beispiel in die Datenbank aufgenommen. Dies ermöglicht dem LLM, seine Strategie zur Wegpunkterzeugung iterativ an diverse Umgebungen anzupassen.

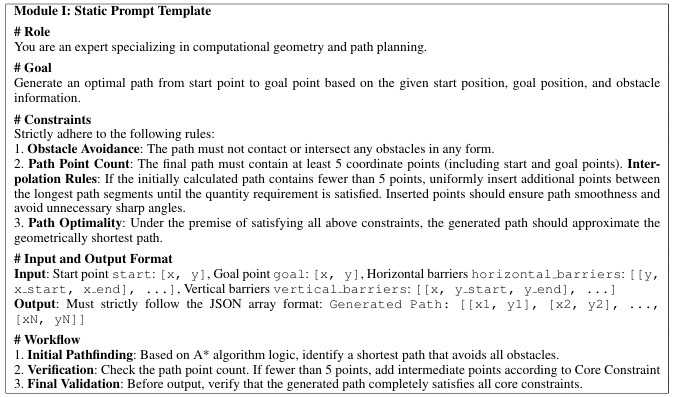

Prompt-Vorlage für die Erzeugung von Wegpunkten mittels LLM

(Bild: Yan Pan et. al)

Empirisch fundierte Selektion der Wegpunkte

Eine empirische Untersuchung der Forscher zeigte, dass eine hohe Anzahl von Wegpunkten den Rechenaufwand überproportional erhöht, ohne die Pfadqualität signifikant zu verbessern. Basierend auf diesen Ergebnissen wurde eine einfache, effektive Auswahlregel implementiert: Wenn das LLM mehr als zwei Wegpunkte generiert, verwenden sie für die anschließende A*-Suche ausschließlich die ersten beiden Wegpunkte, die am nächsten zum Startpunkt liegen. Dadurch minimiert sich die Anzahl der auszuführenden A*-Suchläufe und damit der Gesamtaufwand erheblich.

Die Evaluation auf verschiedenen Kartengrößen (N = 50 bis 450) zeigte laut den Forschern eine deutliche Überlegenheit von iLLM-A* gegenüber den Vergleichsmethoden (A*, Opt-A*, LLM-A*). iLLM-A* erzielte in den Untersuchungen bei der Suchzeit des kürzesten Wegs eine durchschnittliche Beschleunigung um den Faktor 1000 im Vergleich zu LLM-A*. In extremen Fällen lag die Beschleunigung sogar bei einem Faktor von knapp 2350 gegenüber LLM-A*. Der Speicherbedarf konnte um bis zu 58,6 Prozent im Vergleich zu LLM-A* reduziert werden. Auf einer Karte mit N=450 benötigte iLLM-A* 3,62 MByte, während der optimierte A*-Algorithmus (Opt-A*) allein 28,67 MByte belegte. Ferner wiesen die von iLLM-A* generierten Pfade eine geringere durchschnittliche Abweichung von der optimalen Länge auf (104,39 Prozent vs. 107,94 Prozent bei LLM-A*). Dabei war die Standardabweichung der Pfadlänge signifikant geringer, was auf eine höhere Stabilität und Vorhersagbarkeit der Ergebnisse hindeute, sagt das Forschungsteam.

Sollte sich diese massive Reduktion von Rechenzeit und Speicherbedarf auf die Wegfindung in komplexen Umgebungen anwenden lassen, eröffnet dies weitreichende Anwendungsmöglichkeiten. Konkrete Szenarien reichen von der dynamischen Navigation autonomer Roboter in der Logistik über die intelligente Steuerung von Charakteren in großen Videospielwelten bis zu schnellen Simulationen in digitalen Zwillingen.

(vza)

Künstliche Intelligenz

Ausprobiert: Live-Übersetzung mit iOS 26 und AirPods 4 ANC, Pro 2 und Pro 3

Schon seit Monaten gab es Gerüchte, dass Apple sein KI-System Apple Intelligence um eine Live-Übersetzungsfunktion ergänzen würde. Mit iOS 26 und den neuen AirPods 3 war es dann im September tatsächlich so weit: Bei seiner iPhone-17-Keynote stellte der Konzern „Live Translation“ vor. Sie funktioniert nicht nur mit den AirPods Pro 3, sondern auch mit älteren Modellen nach einem Firmware-Update.

In der Praxis heißt das, dass man auch AirPods 4 mit ANC (aber nicht das günstigere Standardmodell ohne aktive Geräuschunterdrückung) und AirPods Pro 2 (egal ob Lightning- oder USB-C-Version) einsetzen kann. Zur Einordnung: Die AirPods Pro 2 sind bereits seit September 2022 auf dem Markt, erhielten ein Jahr später eine USB-C-Variante. Die AirPods 4 ANC folgten im September 2024.

Daneben ist für die Live-Übersetzung auch ein zu Apple Intelligence kompatibles iPhone notwendig (ab iPhone 15 Pro / iPhone 16). Also eines von insgesamt elf Modellen aus der Zeit seit Herbst 2023 – iPhone 14 und früher sowie iPhone 15 und 15 Plus fallen heraus. Apple-Intelligence-fähige iPads mit M-Chip unterstützt Apple leider bislang nicht für die Live-Übersetzung.

Das war die Leseprobe unseres heise-Plus-Artikels „Ausprobiert: Live-Übersetzung mit iOS 26 und AirPods 4 ANC, Pro 2 und Pro 3“.

Mit einem heise-Plus-Abo können Sie den ganzen Artikel lesen.

Künstliche Intelligenz

Rust für unternehmenskritische Anwendungen: Online-Konferenz betterCode() Rust

Am 10. November findet die betterCode() Rust 2025 statt. Die fünfte Auflage der von iX und dpunkt.verlag ausgerichteten Online-Konferenz hat industrielle Anwendungen mit Rust im Fokus.

Die Programmiersprache kommt immer häufiger für unternehmenskritische Software zum Einsatz. Rust punktet in industriellen Anwendungen vor allem bei Speichersicherheit, Performance und Ressourcenbedarf. Bis zum 13. Oktober gibt es Tickets zum vergünstigten Frühbucherpreis.

Die betterCode() Rust 2025 zeigt, wie man die Performance der Anwendungen optimiert, was man für die Embedded-Entwicklung mit Rust benötigt, wie asynchrones Rust funktioniert und wie das Zusammenspiel mit C++ reibungslos gelingt.

Ein Praxisbeitrag aus dem Automotive-Sektor eröffnet die Konferenz, und ein weiterer Vortrag zeigt, wie KI beim Schreiben von Rust-Code hilft.

Praxis, Performance, async Rust und KI-Hilfen

Das Programm der Konferenz bietet folgende Vorträge:

- Rust in the automotive industry at Volvo

- Performante Programmierung mit Rust

- Asynchrones Rust: Alle Konzepte für den Start

- Mit Rust auf Heldenreise

- KI für die Rust-Entwicklung

- Zusammenspiel von Rust mit C++

Ein zusätzlicher Online-Workshop zeigt am 25. November, wie gutes Softwaredesign für Embedded Rust aussieht.

Bis zum 13. Oktober sind die Tickets für die betterCode() Rust 2025 zum Frühbucherpreis von 249 Euro (zzgl. 19 % MwSt.) erhältlich. Teams ab drei Personen erhalten im Online-Ticketshop automatisch einen Gruppenrabatt.

Wer über den Verlauf der betterCode()-Konferenz auf dem Laufenden bleiben möchte, kann sich für den Newsletter eintragen oder die LinkedIn-Seite des Events besuchen.

(rme)

Künstliche Intelligenz

iOS 26.1 Beta 2: Apple erschwert versehentliches Ausschalten von Weckern

Apple hat in der zweiten Beta-Version von iOS 26.1 eine weitere Änderung an der Wecker-Bedienung vorgenommen. Wie 9to5Mac berichtet, müssen Nutzer den Alarm künftig durch eine „Slide to Stop“-Geste ausschalten – ein einfaches Antippen auf einen Button reicht nicht mehr aus. Die Änderung soll ein versehentliches Deaktivieren des Weckers verhindern.

Mit iOS 26 hatte Apple im September die Bedienung des Weckers grundlegend überarbeitet und deutlich größere Buttons für die Schlummerfunktion und das Ausschalten eingeführt. Diese Designänderung führte jedoch zu unerwarteten Problemen: Nutzer berichteten, dass die großen Schaltflächen zu leicht versehentlich betätigt werden könnten – etwa beim Griff zum Smartphone auf dem Nachttisch.

Die neue Wisch-Geste erinnert an das klassische „Slide to Unlock“ (zum Entsperren schieben) des iPhones, mit dem langjährige iOS-Nutzer vertraut sein dürften. Statt eines einfachen Tipps muss der Finger über den Bildschirm gezogen werden, um den Alarm zu beenden. Diese zusätzliche Hürde soll sicherstellen, dass der Wecker nur bewusst ausgeschaltet wird.

Interessanterweise wendet Apple die neue Bedienung auch auf Timer an, obwohl bei diesen das Problem versehentlicher Deaktivierung weniger relevant erscheint. Vermutlich legt Apple hier aber einfach Wert auf Einheitlichkeit.

Finale Version noch ungewiss

Da es sich bei iOS 26.1 derzeit noch um eine Beta-Version handelt, ist nicht garantiert, dass die Änderung in der finalen Version enthalten sein wird. Apple könnte die neue Geste zunächst testen, um Nutzerfeedback einzuholen, bevor eine endgültige Entscheidung getroffen wird. iOS 26.1 wird voraussichtlich Ende Oktober veröffentlicht, wie sich aus Apples bisherigem Update-Muster ableiten lässt.

Die zweite Beta-Version von iOS 26.1 wurde kürzlich für Entwickler freigegeben. Neben der Alarm-Änderung soll Apple in iOS 26.1 auch an verbesserter Unterstützung für Drittanbieter-Smartwatches arbeiten, insbesondere bei der Weiterleitung von Benachrichtigungen – eine Anforderung der EU-Kommission im Rahmen des Digital Markets Act.

(mki)

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenDer ultimative Guide für eine unvergessliche Customer Experience

-

UX/UI & Webdesignvor 1 Monat

UX/UI & Webdesignvor 1 MonatAdobe Firefly Boards › PAGE online

-

Social Mediavor 2 Monaten

Social Mediavor 2 MonatenRelatable, relevant, viral? Wer heute auf Social Media zum Vorbild wird – und warum das für Marken (k)eine gute Nachricht ist

-

Entwicklung & Codevor 2 Monaten

Entwicklung & Codevor 2 MonatenPosit stellt Positron vor: Neue IDE für Data Science mit Python und R

-

Entwicklung & Codevor 1 Monat

Entwicklung & Codevor 1 MonatEventSourcingDB 1.1 bietet flexiblere Konsistenzsteuerung und signierte Events

-

UX/UI & Webdesignvor 3 Wochen

UX/UI & Webdesignvor 3 WochenFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online

-

Apps & Mobile Entwicklungvor 3 Monaten

Apps & Mobile Entwicklungvor 3 MonatenFirefox-Update 141.0: KI-gestützte Tab‑Gruppen und Einheitenumrechner kommen

-

Online Marketing & SEOvor 2 Monaten

Online Marketing & SEOvor 2 MonatenSo baut Googles NotebookLM aus deinen Notizen KI‑Diashows