Künstliche Intelligenz

Instinct MI350X/MI355X: AMD opfert Compute- für KI-Rechenleistung

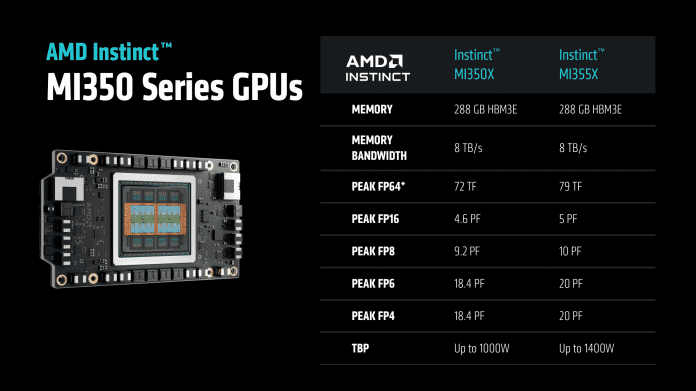

AMD hat am 12. Juni 2025 auf seiner Hausveranstaltung Advancing AI im kalifornischen San José die kommenden Instinct-Beschleuniger MI350X und MI355X offiziell vorgestellt und einen Ausblick auf MI400 im nächsten Jahr gegeben. Die beiden MI35xer-Modelle kommen mit bis zu 288 GByte HBM3e-Stapelspeicher (High-Bandwidth Memory) und nehmen im Fall der MI355X mit direkter Flüssigkühlung 1,4 bis 1,5 Kilowatt Leistung auf. Laut AMD sollen Sie gegenüber den MI300X-Vorgängern beim KI-Inferencing rund 2,6 bis 4,2 Mal so schnell sein. Nvidias CPU-GPU-Kombi GB200 sollen sie beim KI-Training Paroli bieten oder im Vergleich zum B200-Beschleuniger bis zu 30 Prozent Vorsprung bieten.

Damit will AMD sich einen Anteil am riesigen KI-Geldtopf sichern, an dem sich Nvidia seit Jahren finanziell labt und in den Börsenberichten ein Rekordquartal nach dem anderen meldet. AMD wirbt mit einer bis zu 40 Prozent höheren Durchsatzrate pro Dollar (Tokens/$), die sich aus den maximal 30 Prozent höheren Durchsatz nur zum Teil speist – zusätzlich muss AMD die MI355X auch billiger anbieten als Nvidias B200-Systeme.

AMDs Instinct-Reihe sind massiv parallele Beschleuniger, die speziell für den Einsatz in Rechenzentren vorgesehen sind; die MI350X und MI355X verwenden mit CDNA4 die vierte Generation dieser Rechenbeschleuniger. Beide haben eine Speichertransferrate von bis zu 8 TByte/s und unterscheiden sich hauptsächlich in Sachen Taktrate und Leistungsaufnahme. Die MI350X ist mit 1 kW vergleichsweise zahm. Sie ist mit einem Durchsatz von 72 zu 79 Billionen Rechenschritten bei doppeltgenauen Gleitkommazahlen (FP64-TFLOPS) auf dem Papier aber nur knapp 9 Prozent langsamer als die wesentlich stromdurstigere MI355X. Letztere soll bis zu 1,4 kW, also 40 Prozent mehr als die kleinere Schwester aufnehmen. In einer Vorschau nannte ein AMD-Sprecher sogar bis zu 1,5 kW.

Übersicht AMD Instinct MI350X und MI355X.

(Bild: AMD)

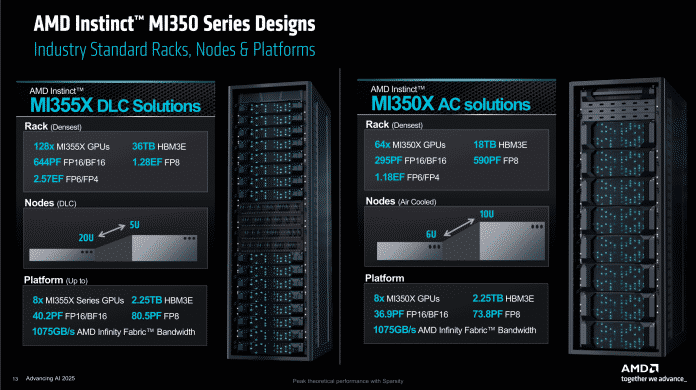

AMD sieht die MI350X für den Einsatz in luftgekühlten Serverschränken mit bis zu 64 GPUs vor. Die MI355X soll in hochdichten Racks mit bis zu 128 GPUs unterkommen, benötigt dann aber direkte Flüssigkühlung (DLC), um nicht zu überhitzen.

Dass AMD weitere Schritte in Richtung KI-Optimierung geht, überrascht indes nicht. Einerseits liegt dort gerade das große Investorengeld, andererseits hatte AMDs Technikchef Mark Papermaster auf der ISC25 in Hamburg erst vor zwei Tagen die Wichtigkeit von Berechnungen mit gemischter Präzision hervorgehoben. Eine Version mit integrierten CPU-Chiplets analog zum MI300A hat AMD vom MI350 bisher nicht erwähnt.

Ein Schritt vor, ein Schritt zurück

Der Fokus lag bei den Vorgängern aus der MI300/325-Reihe noch auf der Verwendung in Supercomputern und Rechenzentren gleichermaßen. Das hat AMD bei der MI355X geändert. Die Rechenwerke sind für den Einsatz bei KI-Aufgaben weiter optimiert, müssen dafür aber Federn bei klassischen Aufgaben lassen. Pro Takt und Rechenwerk gibt es sogar Rückschritte.

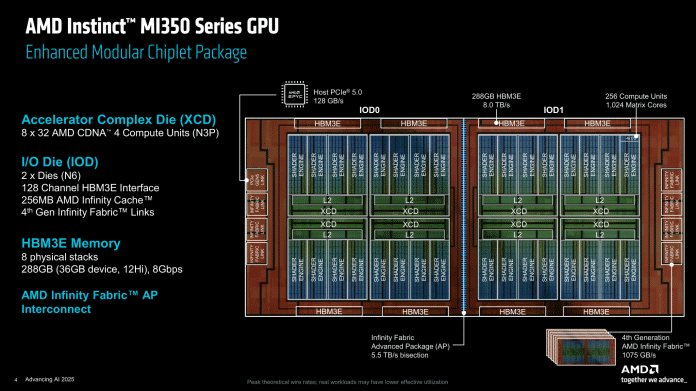

Wie schon bei den älteren Instinct-MI-Modellen verwenden die AMD-Ingenieure bei der MI355X auch 3D-Chiplets. Als Basis kommen zwei IO-Dies zum Einsatz, die in bewährter 6-Nanometer-Technik gefertigt werden. Darin sind insgesamt 256 MByte Infinity-Cache enthalten, aufgeteilt in 2-MByte-Blöcke, sowie die sieben Infinity-Fabric-Links (IF) der vierten Generation, die pro Stück jetzt 153,6 GByte/s übertragen und mit insgesamt 1075 GByte pro Sekunde bis zu acht MI35xX verbinden. Auch die 5,5 TByte/s schnelle Verbindung der beiden IO-Dies hat AMD überarbeitet: Sie ist jetzt breiter, taktet dafür aber niedriger. Dadurch lässt sich die nötige Spannung als Haupttreiber der Leistungsaufnahme senken. AMD nennt diese Verbindung der beiden IO-Dies Infinity Fabric Advanced Package (IF-AP).

Chiplet-Technik mit 3D-Stacking: Zwei IO-Dies in 6- und acht XCDs in 3-nm-Technik.

(Bild: AMD)

Auf den beiden IO-Dies sitzen die acht Accelerator Compute Dies (XCDs), die TSMC im moderneren N3P-Prozess herstellt. In jedem davon sind 32 aktive Compute-Units enthalten – vier sind zur Verbesserung der Chipausbeute deaktiviert. Wer sich gut Zahlen merken kann, dem fällt auf, dass der Vorgänger mit 304 CUs noch 48 Einheiten mehr hatte. Auch dadurch ist die Versorgung mit Daten aus dem HBM3e-Speicher nun um Faktor 1,5 besser als zuvor: 16 Prozent weniger CUs, 30 Prozent mehr Transferrate.

Das geht laut AMD auf Erfahrungen aus der Praxis zurück, die den präferierten KI-Anwendungen einen hohen Bandbreitenhunger attestieren. Ein weiterer Eingriff an der Architektur ist ein größerer schneller Zwischenspeicher innerhalb der CUs (Local Data Share, LDS) auf 160 KByte. Mit dem größeren HBM-Speicher und der Überarbeitung der Speichervirtualisierung einher geht auch die Anpassung der sogenannten Universal Translation Caches, die ähnliche Aufgaben übernehmen wie die Translation Lookaside Buffer (TLBs) in Prozessoren. Der TLB enthält oft benutzte Zuordnungen von virtuellen zu physikalischen Adressen. Bei einem Speicherzugriff wird die Zuordnung zunächst im TLB gesucht, bevor Page Directory/Table konsultiert werden. Ist sie im Cache vorhanden, spricht man von einem „Hit“, ansonsten von einem „Miss“. Die Suche im TLB ist erheblich schneller als ein Zugriff auf die Page Table.

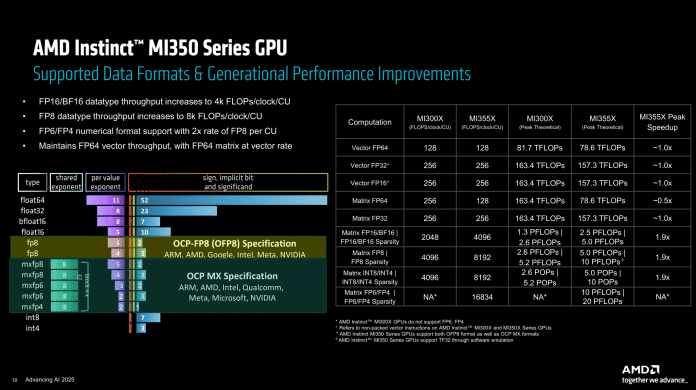

Der größte Unterschied ist aber der Aufbau der einzelnen Rechenwerke in den Compute Units. Denen hat AMD neue Datenformate spendiert, sodass die Matrixeinheiten jetzt außer FP8 (sowohl nach OCP-FP8- als auch OCP-MX-Spezifikation wie bei Nvidia) auch FP6 und FP4 beherrschen. Der Durchsatz der beiden neuen Formate ist dabei doppelt so hoch wie der des bekannten FP8 – bei Nvidias B200 erreicht FP6 nur FP8-Geschwindigkeit.

Dafür mussten speziell die dicken Multiplizierer der Matrixeinheiten bluten. Der Durchsatz mit FP64-Datenformaten, wie sie in KI-Anwendungen allerdings nicht vorkommen, wurde gegenüber den Vorgängerbeschleunigern halbiert. Damit folgt AMD auch hier Nvidias Marschrichtung, der FP64 schon länger bedeutend niedriger priorisiert. Die Vektoreinheiten, die den klassischen Shader-SIMDs in Grafikkarten ähneln, wurden beim MI350X/MI355X allerdings nicht angetastet.

Durchsatz bei verschiedenen Datenformaten: Mit FP6 und FP4 läuft der MI350 zur Hochform auf.

(Bild: AMD)

Die kompletten Chips schaffen laut AMD daher nun einen Durchsatz von bis zu 20.000 TFLOPS bei dünn besetzten Matrizen („Sparsity“) mit FP6- oder FP4-Genauigkeit. Mit FP8 oder INT8 ist es noch die Hälfte, ebenso wie bei regulär besetzten Matrizen.

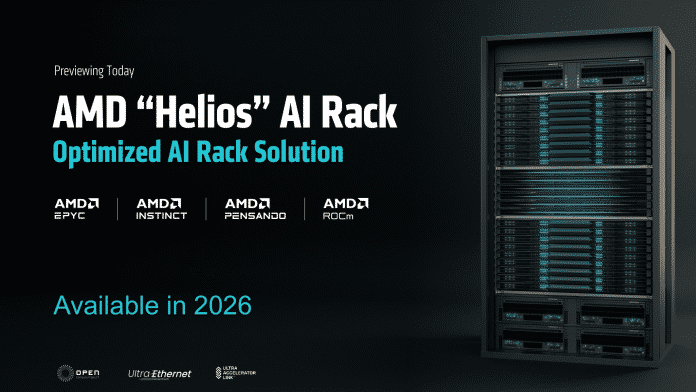

AMD will auch Racks mit MI350X anbieten.

(Bild: AMD)

„Helios“-KI-Racks und Ausblick auf MI400

AMD will mit MI355X und MI350X erstmals auch eigene KI-Racks spezifizieren. Die Basis bilden weiterhin UBB8-Formate, Universal Base Boards für acht Beschleunigermodule, die es von Partnern auch weiterhin geben wird. Neu sind die KI-Serverschränke mit bis zu 128 MI355X-Beschleunigern und Direct Liquid Cooling. Ein solcher Schrank soll dann 2,57 Exaflops an KI-Rechenleistung im FP6/FP4-Format schaffen und 36 TByte HBM3e-Speicher beherbergen. AMD betonte zudem erneut, dass die hauseigene Lösung komplett auf offene Standards wie OCP-UBBs oder Ethernet des Ultra-Ethernet-Consortiums setzt. Die Firma will sich damit von Nvidias proprietären Server-Racks mit NVLink differenzieren.

Der Nachfolger MI400 soll 2026 erscheinen und es mit dem dann erwarteten Vera Rubin von Nvidia aufnehmen, auch als Komplettlösung in neu entwickelten Helios-Racks analog zu Nvidias NVL72. AMD stellt für 72 MI400 rund 50 Prozent mehr HBM4-Speicherkapazität (31 TByte, addiert) und -Transferrate (1,4 PByte/s, addiert) sowie Scale-Out-Bandbreite (also der ins Netzwerk) in Aussicht. Einen Gleichstand erwartet die Firma bei FP4/FP8-Rechenleistung sowie bei der Scale-Up-Bandbreite der lokalen HBM-Kanäle.

Helios heißen die Rack-Designs für die 2026 erwarteten Nvidia-Rubin-Konkurrenten MI400.

(Bild: AMD)

Ein einzelner MI400 soll die FP4-Leistung gegenüber MI355X auf 40 Petaflops (40.000 Teraflops, inkl. Sparsity) verdoppeln und 432 GByte HBM4-Stapelspeicher mit bis zu 19,6 TByte/s anbinden. Jede GPU wird mit 300 GByte nach außen doppelt so schnell kommunizieren können wie MI350X/355X. Wie hoch die Leistungsaufnahme dann sein wird, hat AMD nicht verraten, wohl aber in einem irreführenden Diagramm einen enormen Performancevorsprung suggeriert. Der wurde laut der Fußnoten offenbar auf Plattformbasis errechnet: 72 MI400 gegen acht MI355X, darum geben wir ihn hier auch nicht grafisch wieder.

(csp)

Künstliche Intelligenz

Reddit auf Erfolgskurs: Von der Plattform zur Suchmaschine

In einem Schreiben an die Investoren spricht Reddit-CEO Steve Huffman davon, Reddit zu einer „go-to search engine“ zu machen. Das Unternehmen ist sich dem Wert seiner Inhalte und der Community bewusst. Gerade in Zeiten von AI-Slop, Fake-News und KI-Antworten mit ungewisser Herkunft sind die Beiträge der Menschen auf der Plattform umso wertvoller.

Die Beiträge haben Reddit bereits lukrative Verträge mit KI-Unternehmen wie OpenAI und Google eingebracht. Beide haben Inhalte der Plattform für ihr KI-Training lizenziert. Reddit möchte nun aber die Suche im eigenen Dienst verbessern. Es ist laut Huffman eines der „dringensten Bedürfnisse“, Reddit zur Suchmaschine der ersten Wahl zu machen. Hunderte Millionen Menschen kämen jede Woche zu Reddit, um nach Ratschlägen zu suchen. Ihnen soll geholfen werden.

Reddit setzt auf menschliche Beiträge

Die Suche innerhalb der Plattform hat etwa 70 Millionen aktive Nutzer pro Woche. Auf der gesamten Plattform sind etwa 416 Millionen Menschen in der Woche aktiv, 108 Millionen sind es am Tag. Reddit Answers, die bisherige KI-Suche der Plattform, hat bereits mehr als 6 Millionen Nutzer in der Woche. Diese Funktion soll nun besser in der bisherigen Suche verankert werden.

Auch Reddit dürfte davon betroffen sein, dass Google mit der KI-Übersicht und dem AI Mode Inhalte anderer Plattformen via KI verarbeitet und an Suchende direkt weitergibt. Der Klick auf eine Webseite ist oftmals nicht mehr nötig, wenn in einer KI-Zusammenfassung bei Google bereits die Antwort auf eine gesuchte Frage steht. Das führt dazu, dass auch Reddit weniger Geld mit Werbung einnehmen kann, da weniger Menschen via Google auf die Plattform kommen.

Dager versucht Reddit nun, die eigene Suche zu einer Art Konkurrenz zu machen, damit Inhalte besser über Reddit direkt gefunden werden können. Den eigenen Vorteil sieht Reddit in den Beiträgen der Community, die bisher keinem AI-Slop ausgesetzt sind. Gemeint ist damit eine KI-Schwemme von SEO-gerechten Beiträgen, die Googles Suchergebnisse beeinflussen, sowie KI-Inhalte, die in sozialen Netzwerken gepostet werden, um damit etwa an Monetarisierungsprogrammen teilzunehmen oder den politischen Diskurs zu lenken.

Lesen Sie auch

Laut Reddit gibt es allerdings bereits den Trend, dass Menschen das Wort Reddit in einer Suchanfrage bei Google unterbringen, um explizit von Menschen geschriebene Beiträge zu finden. Beim OMR Festival in Hamburg sagte Jen Wong, Chief Operating Officer von Reddit etwa: Man kann keine Künstliche Intelligenz haben, ohne eine tatsächliche Intelligenz.“ KI habe nur Meinungen, die von Menschen kommen. Nur wenn Menschen einen Autositz für Kinder bewertet haben, könne KI das wiedergeben. „KI hat nichts selbst erlebt.“ Menschen bei Reddit schreiben, was sie erlebt haben.

Neben der verbesserten Suche möchte Reddit dadurch auch ein besseres Werbeumfeld für Werbetreibende bieten. Huffman berichtet in dem Schreiben auch von seinem Trip nach Cannes, wo er Werbetreibende getroffen habe, was „ein gutes Barometer war, wie Marken Reddit sehen“. „Sie wollen mit uns arbeiten, sie verstehen unsere außergewöhnliche Rolle im Internet und sie erkennen, dass wir ihnen echten Mehrwert bieten können.“ Laut der aktuellen Quartalszahlen lagen die Werbeeinnahmen bei 465 Millionen US-Dollar – im Jahresvergleich ein Anstieg um 84 Prozent. Sonstige Einnahmen lagen bei 35 Millionen US-Dollar – hierzu sollten die Lizenzverträge zählen.

(emw)

Künstliche Intelligenz

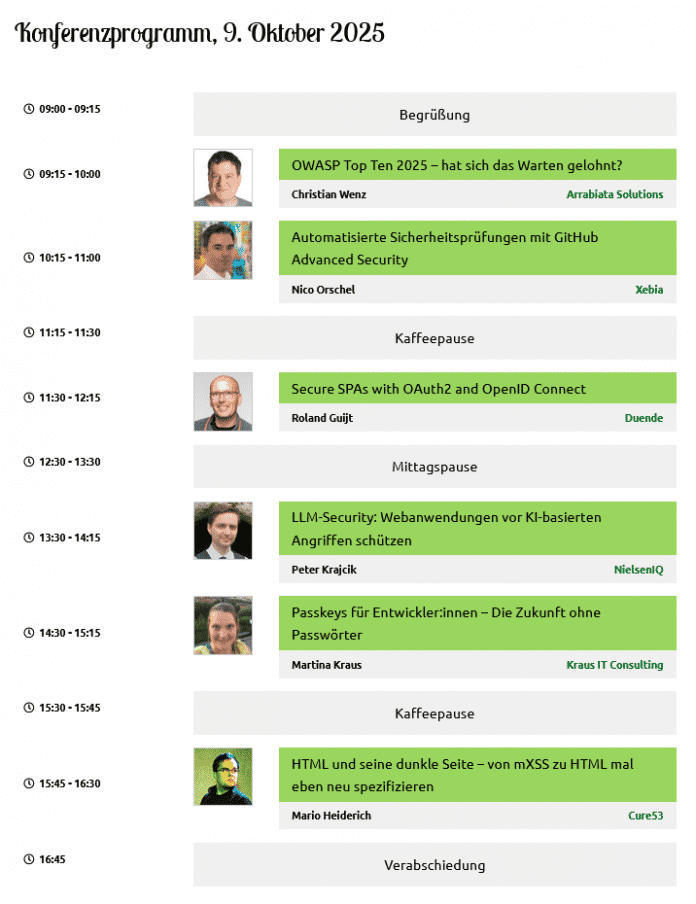

enterJS Web Security Day: Praxis-Workshop für sichere Webanwendungen

Neun von zehn Webanwendungen haben Sicherheitslücken – Grund genug, dass die Veranstalter der JavaScript-Konferenz enterJS diesem Problem mit dem neuen Online-Thementag Web Security Day auf den Grund gehen. Ausgerichtet von dpunkt.verlag und iX in Kooperation mit dem Security-Experten Christian Wenz, vermittelt die Konferenz am 9. Oktober 2025 aktuelles Know-how zur Absicherung von Webanwendungen. Doch damit nicht genug – denn bereits am 7. Oktober können Interessierte in einem ganztägigen Workshop erfahren, wie sie ihre Webanwendungen sicher entwickeln und vor Angriffen schützen können.

Der enterJS Web Security Day richtet sich an JavaScript-, Frontend- und Backend-Entwicklerinnen und -Entwickler sowie DevOps Engineers.

Praxis-Workshop: Gefahren für Webanwendungen erkennen und abwehren

Christian Wenz ist Softwarearchitekt, Berater und Autor mit Schwerpunkt Cybersicherheit. Er ist seit 2004 Microsoft MVP und ein Fixpunkt bei Konferenzen zur Softwareentwicklung und Web Application Security im In- und Ausland. Seit 1998 publiziert er regelmäßig zu allen relevanten Themen aus den Bereichen Webentwicklung und Security.

(Bild: Christian Wenz/Arrabiata Solutions)

Am 7. Oktober bietet Christian Wenz den ganztägigen Online-Workshop „Web Security in der Praxis: Gefahren erkennen und abwehren“ an. Von 9 bis 16 Uhr vermittelt der Softwarearchitekt, Berater und Autor mit Schwerpunkt Cybersicherheit den Teilnehmerinnen und Teilnehmern, wie sie die wichtigsten Sicherheitsrisiken aufspüren können. Er zeigt zudem auf, welche geeigneten Gegenmaßnahmen sie ergreifen können, um ihre Anwendungen abzusichern. Dabei kommt der praktische Aspekt nicht zu kurz: Unter anderem wird eine präparierte Webanwendung zum Einsatz kommen, in der Sicherheitslücken aufgedeckt werden.

Teilnehmende benötigen Grundkenntnisse im Web-Frontend (HTML, CSS, JavaScript) und in einer beliebigen Backend-Technologie. Die technischen Voraussetzungen bestehen lediglich aus einem Webbrowser und „Spaß am Kaputtmachen“, wie der Workshop-Trainer mit einem Augenzwinkern verkündet.

Ein Workshop-Ticket lässt sich für 549 Euro (zzgl. 19 % MwSt.) im Online-Ticketshop der enterJS buchen – gemeinsam mit dem Konferenztag oder unabhängig davon.

Konferenztag mit sechs Security-Vorträgen

Das Konferenzprogramm am 9. Oktober besteht aus sechs 45-minütigen Vorträgen. Darin behandeln die Sicherheitsexpertinnen und -experten Christian Wenz, Nico Orschel, Roland Guijt, Peter Krajcik, Martina Kraus und Mario Heiderich aktuelle Themen aus dem Bereich der Web Security: Welche Vorteile bringen Passkeys für Developer (siehe auch iX-Fachartikel von Martina Kraus), wie kann man seine Anwendung vor KI-basierten Angriffen schützen und was gibt es Neues in den OWASP Top Ten 2025?

Im Anschluss an die Vorträge haben die Teilnehmenden die Gelegenheit, in jeweils 15-minütigen, interaktiven Q&A-Sessions direkt mit den Speakern in den Austausch zu treten. Wahlweise können sie sich per Bild und Ton zuschalten oder im Chat die Gelegenheit nutzen, Fragen an die Experten zu richten.

Tickets zum Frühbucherpreis

Derzeit sind Frühbuchertickets für den Thementag erhältlich. Ein Tagesticket kostet 249 Euro (alle Preise zzgl. 19 % MwSt.), nach Ablauf des Rabatts 299 Euro. Teams ab drei Personen erhalten einen Gruppenrabatt, den der Online-Ticketshop automatisch berechnet. Der Eintages-Workshop lässt sich für 549 Euro buchen.

Weitere Informationen zum Programm sowie den Referentinnen und Referenten bietet die Konferenz-Website. Dort können Interessierte auch den enterJS-Newsletter abonnieren, um über die jährlich stattfindende Vor-Ort-Konferenz und ihre Online-Thementage auf dem Laufenden zu bleiben. Der Web Security Day ist auch auf LinkedIn vertreten, der Hashtag lautet #ejs25.

(mai)

Künstliche Intelligenz

UniFi OS: Ubiquiti bringt Netzwerkbetriebssystem für den eigenen Server

Mit UniFi OS Server stellt Ubiquiti eine neue Version seines Netzwerkbetriebssystems zur Verfügung. Es lässt sich erstmals komplett auf eigener Hardware betreiben, womit der gesamte UniFi-Netzwerk-Stack lokal bleiben kann. Eine Verbindung mit der Cloud des Anbieters ist möglich, aber explizit optional. UniFi OS Server richtet sich primär an Managed-Service-Provider (MSPs) und Unternehmen, nicht an Endanwender.

Installieren lässt sich das System als Container auf x86- oder ARM64-Servern oder virtuellen Maschinen, auch für Edge-Appliances ist es laut Ubiquiti geeignet. Zu den Hardwarevoraussetzungen macht der Anbieter ansonsten keine genauen Angaben. Administratoren sollen CPU, Arbeitsspeicher und Massenspeicher den eigenen Anforderungen entsprechend auswählen. Zur Hochverfügbarkeit lässt sich UniFi OS Server in Virtualisierungs-Clustern betreiben.

Explizit keine funktionellen Einschränkungen

Ubiquiti betont, dass auch das lokale System den kompletten Applikations-Stack von UniFi OS umfasst. Unter anderem sind bereits die jüngsten Updates mit an Bord, darunter InnerSpace, das die Netzwerkinfrastruktur in Gebäuden visualisiert, und RF Analytics, um die Funkumgebung zu überwachen, Interferenzen zu erkennen und das WLAN auf Basis dieser Informationen gezielt zu optimieren. Auch SiteMagic SD-WAN ist bereits enthalten, hiermit lassen sich in UniFi Gateways automatisiert Site-to-Site VPNs einrichten.

Administratoren können UniFi OS Server zentral betreiben und von hier aus mehrere Standorte verwalten. Auch ein zentrales Update-Management über den eigenen Server ist enthalten. Hinzu kommt UniFi Identity, eine Zero-Trust-Zugriffs- und Identitätssteuerung für Nutzer und Geräte. Ubiquiti betont, dass sich UniFi OS Server mit existierenden Backup-, Monitoring- und Compliance-Workflows integrieren würde, macht hierzu aber keine genaueren Angaben.

Auf Wunsch geschieht das Management über den UniFi Site Manager, mit dem sich jegliche Netzwerke und Geräte verwalten lassen – wobei Verantwortliche je nach Rolle alle administrativen Aufgaben an einer Stelle erledigen können, unabhängig vom tatsächlichen Standort der Geräte und Netze. Beim UniFi Site Manager handelt es sich um einen Hybrid-Cloud-Dienst, der parallel zu den lokalen Admin-Konsolen eingesetzt werden kann.

Digitale Souveränität des Netzwerks

Ubiquiti stellt UniFi OS Server kostenlos zur Verfügung. Noch befindet sich das System allerdings in einer Early-Access-Phase, zur allgemeinen Verfügbarkeit gibt es noch keine Informationen. In der Ankündigung von UniFi OS Server gibt Ubiquiti an, dass man sich „schon immer für den Besitz von eigener Hardware und Software eingesetzt habe“. Da es sich bei dem Netzwerkanbieter um ein US-Unternehmen handelt, dürfte der Schritt aber genauso mit den aktuellen Diskussionen rund um die Abhängigkeit Europas von US-Techkonzernen in Zusammenhang stehen.

(fo)

-

Datenschutz & Sicherheitvor 2 Monaten

Datenschutz & Sicherheitvor 2 MonatenGeschichten aus dem DSC-Beirat: Einreisebeschränkungen und Zugriffsschranken

-

Online Marketing & SEOvor 2 Monaten

Online Marketing & SEOvor 2 MonatenTikTok trackt CO₂ von Ads – und Mitarbeitende intern mit Ratings

-

Apps & Mobile Entwicklungvor 2 Monaten

Apps & Mobile Entwicklungvor 2 MonatenMetal Gear Solid Δ: Snake Eater: Ein Multiplayer-Modus für Fans von Versteckenspielen

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenPhilip Bürli › PAGE online

-

Digital Business & Startupsvor 1 Monat

Digital Business & Startupsvor 1 Monat80 % günstiger dank KI – Startup vereinfacht Klinikstudien: Pitchdeck hier

-

Digital Business & Startupsvor 1 Monat

Digital Business & Startupsvor 1 Monat10.000 Euro Tickets? Kann man machen – aber nur mit diesem Trick

-

Apps & Mobile Entwicklungvor 1 Monat

Apps & Mobile Entwicklungvor 1 MonatPatentstreit: Western Digital muss 1 US-Dollar Schadenersatz zahlen

-

Social Mediavor 2 Monaten

Social Mediavor 2 MonatenLinkedIn Feature-Update 2025: Aktuelle Neuigkeiten