Künstliche Intelligenz

LaunchAngels: Was sich hinter Apples neuen Start-„Engeln“ verbirgt

In macOS 26 alias Tahoe ist eine neue Kategorie von Launch-Arten hinzugekommen, über die Apple bislang schweigt: Auf LaunchDaemons und LaunchAgents treffen die sogenannten LaunchAngels. Ein entsprechendes Verzeichnis findet sich im Ordner /System/Library, wie Mac & i-Autor und macOS-Experte Howard Oakley entdeckt hat. Es ist noch nicht viel darüber bekannt, was es damit auf sich hat. Klar ist nur, dass die Technik aktuell für drei Apple-eigene Routinen zum Einsatz kommt.

Drei LaunchAngels entdeckt

Während Daemons Hintergrundprozesse sind, die unabhängig agieren, als root bereits vor dem Login laufen, indirekt mit Nutzerprozessen interagieren und von launchd verwaltet werden, laufen Agents zwar unter der Kontrolle von launchd, werden aber vom Nutzer angefordert und interagieren mit Prozessen und Daemons direkt. Die Verwaltung erfolgt über plist-Dateien. Das ist bei Angels genauso.

Aktuell gibt es im System (macOS 26.0.1) drei LaunchAngels: GameOverlayUI, Posterboard und AccessibilityUIServer. Letzteres hilft bei Eingabehilfen und ist direkt mit dem Prozess Accessibility verbunden. GameOverlayUI hat mit dem neuen Game-Overlay-System zu tun, das Apple nun Spielen gönnt. PosterBoard scheint mit der Konfiguration des Lockscreen zu tun zu haben, etwa um dort Kurzbefehle zu platzieren – allerdings scheint es sich dabei noch um einen Test zu enthalten. Der Key „_ExperimentalNonLaunching“ ist hierfür gesetzt.

Geschütztes Verzeichnis

Oakley entdeckte auch, dass alle drei LaunchAngels Referenzen zu RunningBoard haben, einem Life-Cycle-Management-Werkzeug. Diese gibt es für Agents und Daemons bislang nicht. Es bleibt abzuwarten, was Apple mit den LaunchAngels künftig plant – und warum der Hersteller dafür eine neue Kategorie der Startwerkzeuge eingeführt hat. Es gibt derzeit keinen Weg, eigene Angels zu definieren, das Verzeichnis ist geschützt.

Unklar ist auch noch, ob LaunchAngels im Library-Ordner des Nutzers funktionieren oder eben nur systemweit. Letzteres müsste implementiert werden, sofern Apple die Technik für Drittanbieter-Apps als neue Form von Diensten öffnet. Welche Vorteile dies für Entwickler hätte, ist ebenfalls noch nicht gesagt. Durch den Schutz können Angels jedenfalls bislang nicht missbraucht werden.

(bsc)

Künstliche Intelligenz

Zeitungs-Simulation „News Tower“: Journalismus am Limit

Das war eine Early-Access-Phase, die sich gelohnt hat. Seit Februar 2024 konnten Spieler als angehende Zeitungsverleger in „News Tower“ schon mal ihre Finger in die Druckertinte tauchen, bis das Spiel im November 2025 offiziell veröffentlicht wurde. Alles dreht sich um die Kunst, Zeitungen zu verkaufen und Personalkosten erfolgreich zu managen. Wer schon immer mal sein eigenes Zeitungsimperium aufbauen wollte, ist hier genau richtig.

Weiterlesen nach der Anzeige

Harte Zeiten, pralle Schlagzeilen

Wir schreiben das Jahr 1930. Die Welt ist im Umbruch und in den USA geht es nach der Wirtschaftskrise von vorne los. In „News Tower“ werden die Spieler zum Erben einer kleinen Zeitung, die sie aus dem Nichts an die Spitze bringen sollen. Doof nur, dass sie hier nicht nur Personal bezahlen und Storys finden, sondern auch mit der Mafia, der Polizei und der feinen New Yorker Gesellschaft auskommen müssen. So ein Job als Zeitungsverleger ist stressig. Aber wer hat gesagt, dass sich ein Imperium mal eben so errichten lässt?

Eigentlich sieht alles doch so niedlich aus? Entspannte Swing-Musik im Hintergrund, ein paar Großstadtgeräusche und Reporter, die im Bilderbuch-Look durch das Gebäude laufen. Die Komplexität dieses Management-Spiels versteckt sich im Kleingedruckten. Die Spieler müssen den richtigen Riecher haben, um Geschichten aufzuspüren und die Zeitung zu verkaufen. Sie müssen Personal anheuern, vom Reporter bis zur Reinigungskraft. Für gutes Arbeitsklima sorgen, Werbung schalten, sich an den Geschmack ihrer Abonnenten anpassen und vieles mehr. „News Tower“ ist ein Spielebrocken, der sich hinter einer knuddeligen Hülle verbirgt.

Journalismus am Limit

Über den Telegrafenmast landen die Nachrichten in der Redaktion. Mord im Hinterhof? Regierungskrise? Oder vielleicht doch nur die lokale Baseball-Meisterschaft? Die Reporter haben eine Woche Zeit für ihren Artikel. Oft schaltet die erste Stufe der Recherche eine weitere Spur frei. Tiefer zu wühlen, braucht aber Zeit. Das Risiko, die Deadline zu verpassen, wächst. Am Ende wird es aber in der Regel mit höheren Absatzzahlen belohnt.

Das Gute: Alles funktioniert hier auf Knopfdruck. Stadtkarte anklicken, Reporter losschicken und dann beginnt das Warten. Wer es ganz eilig hat, kann vorspulen und beobachten, wie der Reporter mit seiner Story zurückkommt und sie dem Setzer übergibt, bevor die Druckmaschinen anrollen. Allerdings gibt es neben der Story genug zu tun: Papiernachschub ordern, neue Büro-Ausstattung kaufen oder mit einem Blumentopf das Arbeitsklima verbessern. Wenn der Platz nicht mehr reicht, wird einfach noch ein Stock draufgesetzt.

Weiterlesen nach der Anzeige

Deadline-Stress

Immer gibt es etwas zu tun. Auf der Stadtbezirksübersicht können sich die Spieler ganz auf den Geschmack der Leser konzentrieren, um Bonuspunkte zu sammeln. Es gibt Bezirke, die lieber Sportnachrichten lesen oder sich über ein bisschen Klatsch amüsieren. Praktisch, dass jede Story mit Schlagworten versehen ist, bei denen sie mit der richtigen Kombination auch noch ein paar Dollar herausquetschen können.

„News Tower“ angespielt

(Bild:

Heise Medien

)

Später wird der Aufwand nicht nur mit höheren Einnahmen belohnt, sondern auch mit der Erfahrung der Mitarbeiter. Die steigen wie in einem Rollenspiel langsam auf. Alternativ können wir auch besseres Personal engagieren. Reporter sind dann stresserprobte Profis oder schalten neue Fachgebiete frei. Daneben müssen sich die Spieler mit verschiedenen Fraktionen wie Polizei oder Mafia arrangieren. Alles hat Vor- und Nachteile. Wenn gar nichts mehr geht, hilft ein Kredit oder ein Anwalt.

„News Tower“ schaltet nach und nach neue Spielmechaniken frei. Wie in jedem Management-Spiel können die Spieler dennoch den Überblick verlieren. Deshalb gilt es, kühlen Kopf zu bewahren und einfach mal das Spiel pausieren. Dankenswerterweise gibt es zahlreiche Tipps, die beim Aufbau des Zeitungsimperiums helfen. Trotzdem braucht „News Tower“ Eingewöhnungszeit. Der Arbeitsaufwand wird mit einem der originellsten Management-Spiele des Jahres belohnt. Wer noch zweifelt, kann sich die kostenlose Spieldemo herunterladen.

Zwischenfazit

Mit „News Tower“ gelingt Entwicklungsstudio Sparrow Night ein echter Überraschungshit. Das Szenario ist originell und das Spielprinzip abwechslungsreich. Nie herrscht Stillstand, immer gibt es etwas zu tun. Das wird Genre-Kenner freuen, kann aber Neueinsteiger frustrieren. Wenn gleichzeitig die Story nicht fertig wird, das Papier fehlt und die Angestellten murren, wächst das den Spielern schnell über den Kopf. „News Tower“ ist ein Spiel für Fans, die sich von der hübschen Hülle nicht täuschen lassen und sich gerne stundenlang in die spannende wie komplexe Spielmechanik vertiefen wollen.

„News Tower“ ist für Windows inkl. einer kostenlosen Spieldemo erschienen. Es kostet ca. 25 €. USK nicht geprüft.

(dahe)

Künstliche Intelligenz

Arbeitsmarktanforderungen 2030: Menschliche Kompetenzen vor KI-Skills

Menschliche Fähigkeiten wie Kreativität, kritisches Denken und Empathie verlieren auf dem Arbeitsmarkt keinen Wert, sondern sollen laut dem Weltwirtschaftsforum (World Economic Forum, WEF) im Jahr 2030 sogar an erster Stelle stehen – noch vor KI-Kompetenzen. Das geht aus einem aktuellen Whitepaper hervor, das Teil der Serie „New Economy Skills“ des WEF ist. In dieser werden fünf vom WEF identifizierte Kernkompetenzen für das Jahr 2030 beleuchtet, die von Unternehmen und Volkswirtschaften zur Aus- und Weiterbildung ihrer Fachkräfte priorisiert werden sollten.

Weiterlesen nach der Anzeige

Nicht automatisierbare Kompetenzen

Auf Platz zwei der fünf Kernkompetenzen im Jahr 2030 stehen KI-, Daten- und Digitalkompetenzen. Auf Platz drei folgen Umwelt- und Nachhaltigkeitskompetenzen, auf Platz vier fachliche und berufliche Kompetenzen und auf Platz fünf betriebswirtschaftliche Kompetenzen.

Die menschlichen Kompetenzen umfassen unter anderem kreative und problemlösende Fähigkeiten wie kritisches, analytisches, systemisches sowie mathematisches Denken, um komplexe Herausforderungen zu bewältigen und neue Ideen zu entwickeln. Auch Motivation und Selbstwahrnehmung, lebenslanges Lernen, Coaching, Neugier, Detailgenauigkeit, Resilienz, Flexibilität und Agilität sowie emotionale Intelligenz werden zu ihnen gezählt. Laut Bericht befähigen sie Menschen, sich selbst zu managen, weiterzubilden, zwischenmenschliche Beziehungen zu gestalten und ihr Wohlbefinden zu erhalten. Zudem wird prognostiziert, dass Kompetenzen wie Empathie, Resilienz, Führungsqualitäten und Lehrfähigkeit sowie höhere kognitive Fähigkeiten, wie analytisches und kreatives Denken und Neugierde, „nur ein 13-prozentiges Potenzial für eine KI-Transformation [haben], da sie auf menschlichem – nicht maschinellem – Urteilsvermögen, Kontext und Lebenserfahrung beruhen.“

Vier Kategorien menschlicher Kompetenzen weist der Bericht aus: Kreativität und Problemlösung, emotionale Intelligenz, Lernen und Wachstum, Kollaboration und Kommunikation.

(Bild: WEF)

Im Gegensatz dazu unterlägen mathematisches und statistisches Denken, Systemdenken, Sprechen, Schreiben und Sprachen sowie Zuverlässigkeit und Detailgenauigkeit einer fast sechsmal höheren Wahrscheinlichkeit einer hybriden oder vollständigen Transformation. Hier könne generative KI einen Großteil der Routinearbeit übernehmen. Eine menschliche Aufsicht bleibe aber weiterhin unerlässlich. Insgesamt gebe es nur wenige Fähigkeiten mit Potenzial für eine vollständige Transformation, bei der KI ganze Aufgaben mit minimaler menschlicher Interaktion bewältigen könne. Menschenzentrierte Kompetenzen blieben also „die Brücke zwischen technologischem Fortschritt und sinnvollen organisatorischen und gesellschaftlichen Ergebnissen.“

Aktuelle Kompetenztransformationskapazität von generativer KI (%) nach Kompetenzgruppe.

(Bild: WEF)

Nicht qua Geburt ausgebildet oder beständig

Weiterlesen nach der Anzeige

Auch macht der Bericht darauf aufmerksam, dass für den Arbeitsmarkt benötigte menschliche Kompetenzen weder ab Geburt ausreichend entwickelt, noch unbeeinflusst von äußeren Bedingungen vorhanden sind. So wird zum einen unterstrichen, dass menschliche Kompetenzen wie etwa Zusammenarbeit, kritisches Denken, Anpassungsfähigkeit, Neugier und emotionale Intelligenz in Bildungssystemen bisher zu wenig gefördert werden. Zum anderen werden die menschenzentrierten Fähigkeiten als „unsichtbar“ und „fragil“ beschrieben. Unsichtbar, weil sie oft als gegeben gesehen und somit ihre Ausprägungen nicht wie andere Fähigkeiten gemessen oder gewürdigt werden. Fragil, weil etwa wirtschaftliche Abschwünge, Krisen und soziale Umbrüche Menschen belasten und damit auch ihre gut entwickelten Fähigkeiten negativ beeinflussen. Dementsprechend müssten menschliche Kompetenzen für zukünftigen wirtschaftlichen und gesellschaftlichen Erfolg als wertvoll und zusätzliches Bildungsziel mit aussagekräftigen Qualifikationen anerkannt werden und Menschen möglichst Stabilität und Sicherheit erleben, um sie auch abrufen zu können.

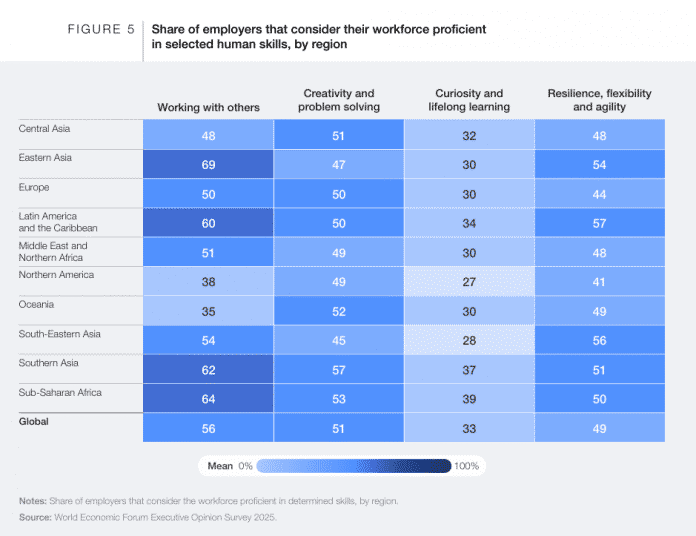

Unternehmen haben für das Jahr 2025 eingeschätzt, wie stark die vier Kategorien der menschlichen Kompetenzen in ihrer Arbeitnehmerschaft entwickelt sind, aufgeteilt nach Weltregionen.

(Bild: WEF)

Welche Kompetenzen global wie ausgebildet sind, sei kulturell unterschiedlich und auch Geschlechterrollen in den jeweiligen Kulturen spielten eine Rolle. Dies habe etwa die PISA-Studie von 2022 gezeigt. Nur die Hälfte der Schülerinnen und Schüler in OECD-Ländern war in der Lage, in vertrauten Kontexten originelle Ideen zu entwickeln, und in über 20 Ländern erreichten sie meist kein grundlegendes Niveau an kreativer Kompetenz. Überdies zeigte die Erhebung, dass Schüler aus höheren sozioökonomischen Schichten durchweg besser abschnitten und Mädchen besser als Jungen.

Dem Bericht zufolge besteht bei Unternehmen schon heute eine Nachfrage nach qualifzierten menschlichen Kompetenzen in ihrer Belegschaft, während das Angebot nicht mithalten kann. Das gehe etwa aus dem „Executive Opinion Survey 2025“ des WEF hervor, das zeige, dass nur jeder zweite Arbeitgeber seine Mitarbeiter als kompetent in den Bereichen Zusammenarbeit und Kreativität einschätzt, und noch weniger in den Bereichen Resilienz, Neugier und lebenslanges Lernen. Dies deute darauf hin, dass Teamarbeit und Zusammenarbeit zwar relative Stärken darstellen, die Denkweisen und Gewohnheiten, die kontinuierliches Wachstum und selbstgesteuertes Lernen fördern, jedoch weltweit weiterhin schwach ausgebildet seien. Nicht alle Beschäftigten seien in dieser Hinsicht aber untätig. Laut Daten des Weiterbildungsanbieters Coursera sei ein stetiger Anstieg der Lernstunden für menschenzentrierte Kompetenzen von 2020 bis 2025 zu erkennen. Seit 2022 sei ein starkes Wachstum im analytischen und systemischen Denken zu verzeichnen, und seit 2024 auch für Lerneinheiten zu kreativem Denken, Resilienz, Empathie, Neugier und dem lebenslangen Lernen.

Das US-Unternehmen Coursera hat Daten zu Lernstunden für menschliche Kompetenzen von 2020-2025 bereitgestellt.

(Bild: WEF)

(kbe)

Künstliche Intelligenz

Sonys neue Ober-Alpha und Sonys Firmware-Problem – Fotonews der Woche 49/2025

Machen wir´s auch in dieser Woche kurz, denn zur neuen Sony Alpha 7 V ist schon fast alles gesagt – aber eben auch nur fast. Wir konnten die Kamera bereits kurz ausprobieren, wenn auch ohne Labormessungen und nicht mit Fremdobjektiven, das wird gleich noch wichtig. Das vorläufige Fazit des Kolumnisten lautet: Sony hat da genau an den richtigen Schrauben gedreht.

Weiterlesen nach der Anzeige

Die neue Alpha ist nicht nur fast so schnell wie manche Sportboliden (30 fps mit elektronischem Verschluss, 10 mit mechanischem), was der neue teilweise gestapelte Sensor mit 33 Megapixeln Auflösung ermöglicht. Solche Bildwandler mit Logik und RAM darauf lassen sich schneller auslesen, und mildern auch Rolling-Shutter-Effekte. Ganz ohne diese kommt nur ein Sensor mit Global Shutter aus – den behält Sony weiterhin seinem Tempomonster A9 III vor.

Aber die spielt auch in einer anderen Preisklasse, für die A7 V sind „nur“ 3000 Euro gefordert. Das ist eben die neue Oberklasse, Sony hat hat die Kamera ebenfalls „nur“ 200 Euro teurer als den Vorgänger vor vier Jahren gemacht. Unsere ausführliche Meldung verrät mehr, auch, was bei den Videofunktionen alles fehlt. Das schaffen andere, wie Canon mit der R6 III, in dieser Preisklasse inzwischen besser.

Sony zieht Firmware für A7 IV zurück

Nämlicher Vorgänger, die A7 IV von Ende 2021, hat kurz vor der Vorstellung des neuen Modells ein großes Firmware-Update erhalten, auf Version 6.00. Selbst definierbare Fokusfelder, dauerhafte Anzeige des Audiopegels beim Filmen und weitere Funktionen lockten. Doch darauf muss man nun weiter warten, denn Sony hat das Update zurückgezogen, wie ein aktueller Hinweis auf der Downloadseite erklärt. Zuvor gab es unter anderem bei Reddit Berichte über „Bricks“ nach dem Update – also funktionslose Kameras, die in die Werkstatt müssen.

Das bestätigt wieder einmal, dass man gerade bei Firmware-Updates für Kameras nicht jede neue Version sofort einspielen sollte. Zu sehr häufen sich in der letzten Zeit die teils schwerwiegenden Bugs, hier nur eine Auswahl: Sony bei der A1 vor anderthalb Jahren, Canon und Nikon bei mehreren Kameras Mitte 2025. Ebenso darf man nicht mehr erwarten, dass altes Zubehör bei einer brandneuen Kamera sofort funktioniert.

Neue Alpha vorerst nicht für Fremdobjektive

Weiterlesen nach der Anzeige

Das führt dann zurück zur neuen A7 V, denn die ist nicht unbedingt mit jedem Objektiv von Drittherstellern kompatibel, wie ein YouTube-Video samt Statement von Sony zeigt. Das ist dann auch unsere Empfehlung für einen Long Watch zum Sonntagabend oder dem Start in die neue Woche. Und, trotz all der Ärgernisse in dieser Ausgabe der Fotonews: Firmware lässt sich fixen. Bleibt nur zu hoffen, dass Sony das auch gründlich tut.

(nie)

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenIllustrierte Reise nach New York City › PAGE online

-

Datenschutz & Sicherheitvor 3 Monaten

Datenschutz & Sicherheitvor 3 MonatenJetzt patchen! Erneut Attacken auf SonicWall-Firewalls beobachtet

-

Künstliche Intelligenzvor 2 Monaten

Künstliche Intelligenzvor 2 MonatenAus Softwarefehlern lernen – Teil 3: Eine Marssonde gerät außer Kontrolle

-

Künstliche Intelligenzvor 2 Monaten

Top 10: Die beste kabellose Überwachungskamera im Test

-

UX/UI & Webdesignvor 3 Monaten

UX/UI & Webdesignvor 3 MonatenFake It Untlil You Make It? Trifft diese Kampagne den Nerv der Zeit? › PAGE online

-

UX/UI & Webdesignvor 2 Monaten

UX/UI & Webdesignvor 2 MonatenSK Rapid Wien erneuert visuelle Identität

-

Entwicklung & Codevor 3 Wochen

Entwicklung & Codevor 3 WochenKommandozeile adé: Praktische, grafische Git-Verwaltung für den Mac

-

Social Mediavor 3 Monaten

Social Mediavor 3 MonatenSchluss mit FOMO im Social Media Marketing – Welche Trends und Features sind für Social Media Manager*innen wirklich relevant?